2. 中国甘肃 730000 中国地震局兰州地震研究所

2. Lanzhou Institute of Seismology, China Earthquake Administration, Gansu Province 730000, China

近年来,中国高性能计算机的发展世界瞩目,其中代表性的国产高性能计算机有神威蓝光、天河1号、天河2号、联想6800和曙光星云等(袁国兴等,2015)。高性能计算技术被广泛应用于天气预报、石油勘探与油藏模拟、分子模拟、基因测序等领域。国内外利用高性能计算平台,在对地震地质和地震动力学等方面的研究取得了大量成果。高性能计算系统在三维地震波模拟、地震数据反演、地震资料处理等领域获得广泛应用(任骏声等,2015;李志才等,2016;付庆华等,2016),在中国地震地磁场的动态演化模型建立过程中也发挥了重要作用(张建国等,2016)。从地震数据特征看,地震资料需要海量数据存储和高速度、大容量、高精度计算处理能力,高性能计算系统是开展此类研究必不可少的技术支撑平台。本文从高性能计算需求及现状、系统构建、技术特点以及高性能计算发展等方面进行分析,对了解高性能集群计算系统以及提高系统在地震科学领域的应用效率具有现实意义。

1 高性能计算在地震科学领域发展现状中国是世界上地震活动强烈国家之一。随着地震科学研究的深入,观测精度的提高,产出了海量观测数据;地震模拟、分析、反演中也需要大量高强度、高精度的计算,从而使得完成地震资料处理所需的计算量和存储量增加,对大规模的并行数据处理要求越来越迫切,高性能计算在地震科学领域的应用日趋普及。中国地震局工程力学研究所在Linux平台上,利用开源软件OSCAR(Open Source Cluster Application Resources),实现了简易高性能计算系统的手工搭建,给出了利用普通PC机和交换机搭建Beowulf集群的过程和方法(马新生等,2009)。中国地震局地震预测研究所于2009年建成一套DELL PowerEdge M600高性能计算系统,主要由192个计算节点、4个I/O节点及登录节点等组成。采用双路20 GB Infiniband网卡,实现4个I/O节点和盘阵之间的物理连接(李圣强等,2012)。中国地震局地质研究所也构建了高性能计算地震动力学仿真平台,采用惠普高性能刀片架构,共7个机柜,包括2台管理节点、2台I/O节点和128个计算节点(廖凯宁等,2015)。上述系统在海量地震波数据的反演计算、震后形变研究及震后模型计算、形变场时空演化模拟研究、地震震源机制的研究等方面均有良好表现。但这些高性能系统主要是以国外产品为主,在信息安全、运行维护、用户使用习惯等方面存在一定不足。

2 甘肃省地震局高性能计算系统构成甘肃省地震局于2011年构建一套曙光TC5000高性能计算系统。与地震科学领域内已有几套高性能系统相比较,曙光TC5000是国产系统,具有可自由伸缩、高集成度、高性能价格比等优点。在系统硬件构成方面TC5000共3个机柜,占用空间少,能源消耗低,同时增加1台A950r-F SMP架构服务器(俗称胖节点),在计算量不大时无需开启刀片服务器,胖节点即可满足应用需求,节约电能和其他资源,使用灵活;节点之间以40 GB QDR Infiniband连接,可以提供所有节点之间40 GB的线速无阻塞通信。在系统软件构成上,本套系统在配置丰富的地震领域科学计算软件的同时,安装Gridview大型机综合监控管理系统和PowerConf智能功耗控制系统软件,充分降低了电能消耗,对各种软硬件资源的分配、调度和管理更为合理易用,相关设备的安装、配置和维护更加简便。

甘肃省地震局构建的TC5000高性能计算集群硬件系统包括高性能计算节点、存储和I/O系统、管理节点、高速集群系统互连网络等部分。系统整体设计结构见图 1。

|

图 1 高性能计算系统结构 Fig.1 Structure of high performance computing system |

高性能计算节点部分主要包括6套曙光TC3600刀片集群服务器、1台A950r-F SMP (Symmetric Multi-Processor)架构服务器、4台I/O节点、2台登录管理节点;所有节点之间以40 GB的QDR Infiniband网络相连,同时采用千兆以太网络作为管理网络,形成双网冗余、互为备份;存储系统采用主流的FC-SAN架构,提供40 TB的光纤接口存储,通过4个I/O节点,组成并行文件存储系统,为计算节点提供数据共享。

集群服务器为曙光TC3600刀片系统,包括60个曙光CB65-G刀片服务器,每台服务器配置2颗AMD公司8核处理器Opteron 6134和32 GB DDR3 1 333 MHz ECC共享内存,内置ConnectX高速Infiniband网卡和1 000 Mbps以太网卡。单节点峰值2×8×4×2.3 G =147.2 G FLOPS,计算刀片系统总峰值达到8.832 T FLOPS。SMP节点为1台A950r-F八路服务器,配置8颗AMD Opteron 8425HE处理器,共48个CPU核心和96 GB共享内存,SMP节点浮点峰值超过400 G FLOPS。

存储和I/O系统基于全局集群存储并行I/O架构,包括4个数据服务器和并行存储系统,共提供40 TB的存储空间。存储系统采用最新的4 GB FC-SAN交换技术,能为系统提供最优化的存储性能。并行存储系统实现了海量数据的高效管理、高效检索、高性能访问、全局共享和高可靠服务,I/O节点和计算节点之间以40 GB QDR Infiniband连接。

计算系统总峰值超过9.2 T FLOPS(每秒9.2万亿次),总功耗峰值不超过35 kW。通过曙光PowerConf集群节能技术,可以在不影响整个集群系统正常运转的情况下,实现10%—25%的电力节省。曙光5000服务器节点内置独立于操作系统的硬件维护单元,通过RJ45接口接入Force10以太网交换机,管理诊断网络,配合Gridview管理软件,实现对全部硬件资源的统一监控和管理。

3 软件环境与系统管理甘肃省地震局高性能计算机配置丰富的软件系统,包括操作系统、编译器、调试器、函数库、并行通信库、全局共享并行文件系统等基础软件,以及曙光公司专门为业内高级用户开发的Gridview综合监控管理系统与PowerConf智能功耗控制系统软件。

采用Redhat Linux企业版64位操作系统,编译器支持Fortran77/Fortran95/C/C++等,并支持OpenMPI以及MPI程序编译。此外,提供并行程序调试及调优工具,以帮助用户更好地完成程序开发。TC5000配置丰富的数学函数库和并行环境供用户选用,包括GotoBLAS2、blacs、scalapack、Lapack、FFTW2、Intel MKL等。TC5000配置集群并行存储系统,为全部计算节点提供统一的文件系统视图,并提供高性能的并行I/O访问。

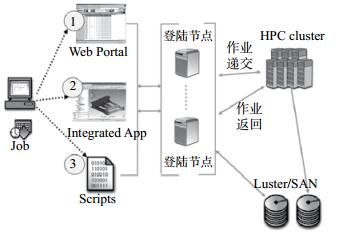

高性能计算用户可以利用Web、应用集成GUI及Scripts方式连接到集群登录节点,向计算资源池提交作业,并通过全局共享的并行存储资源池,存储应用程序的输入文件和输出结果。作业提交方式见图 2。

|

图 2 HPC用户作业提交方式示意 Fig.2 Schematic diagram for HPC user job submission |

Gridview服务器综合管理系统采用模块化设计,提供机群部署恢复中心、综合监控管理系统、统一告警平台、统计报表系统、作业调度调度中间件、IPMI管理等多种机群管理功能。用户不必关系底层的硬件、驱动、通信与网络等,不需要繁杂的命令行操作,通过简单的Web操作即可完成以前复杂、多样的参数设置,消除与业务无关的学习成本,降低高性能计算的使用门槛。对于高性能计算平台管理员来说,简化了集群的应用流程日常管理,提高了工作效率。系统硬件机柜内安装界面见图 3。

|

图 3 系统硬件机柜内安装界面 Fig.3 System hardware installation interface of cabinet interior |

集群系统服务器节点内置独立于操作系统的硬件维护单元,通过RJ45接口接入Force10以太网交换机,管理诊断网络,配合Gridview管理软件,实现对全部硬件资源的统一监控和管理。Gridview大型机综合监控管理系统和PowerConf智能功耗控制系统软件,功能涵盖系统部署、资源监控、系统管理、综合告警、性能报表以及电源管理等高性能计算涉及的几乎全部内容,支持对集群进行多个逻辑分区,支持不同类型用户,提供作业调度系统。

4 系统应用 4.1 系统管理系统管理水平是影响高性能计算设备能否充分发挥其性能的关键因素之一。甘肃省地震局高性能计算系统管理日常工作内容包括:检查机器运行情况并作记录、软硬件维护、用户管理、查看用户作业的提交、运行状态等。因为大型计算集群的复杂性,系统管理人员必须具备一定编程能力,需要对地球物理、地球动力学等与并行计算相关的学科知识有一定了解,熟练掌握1—2个学科的大型科学计算软件,以便为用户提供更好的服务。

4.2 系统应用甘肃省地震局通过资源整合建成的本套高性能集群计算系统,获得了较高的性能价格比,实现了系统设计的预期目标。在安装系统运行和并行计算所需基础软件的同时,安装的应用软件主要有数值模拟软件ANSYS15、有限元计算分析软件ABAQUS、数据计算软件Matlab、结构和岩土方面地震反应模拟软件OpenSees等。建成的高性能计算平台主要为本单位科研团队或职工提供服务。目前主要开展的计算应用有:基于陆态网络连续GPS观测站数据处理计算地壳形变、进行海量地震波数据反演计算、黄土土壤中颗粒的相互作用及力学行为模拟、地震震源机制研究等,支持包括国家自然科学基金项目、地震行业专项等在内的多个科研项目科学计算任务与数据存储工作,完成部分数值模拟和分析计算任务。

5 结束语当前大数据、云计算等技术的发展给高性能计算带来巨大影响。云计算和高性能计算是大数据进行存储和处理的基础计算平台,大数据也为云计算和高性能计算找到具体应用,如何与大数据、云计算技术相结合,提升本套系统实际工作性能,是下一步工作的重要方向。高性能计算集群系统在甘肃省地震科研工作中发挥着重要作用,但同时存在一些问题:系统运行节点故障概率比较大;作业并行调度的任务粒度划分无统一标准;部署的各领域专业计算软件较少;对并行计算编程熟悉的人员较少,不能充分开展应用等。需要我们在跟踪国内外高性能计算技术发展的基础上加强研究,进一步拓宽应用领域,在满足内部需求的前提下,考虑面向社会,为不同类型的用户提供灵活高效的服务,最大限度地挖掘其计算能力,避免资源闲置和浪费。

| 付庆华, 王贤, 秦泽波, 等. InfiniBand网络下的地震资料处理系统性能分析[J]. 信息系统工程, 2016, 11061106(1): 92-93. | |

| 李圣强, 李闽峰, 刘桂平, 等. 高性能计算系统的构建[J]. 地震, 2012, 32(1): 144-149. | |

| 李志才, 张鹏, 丁开华, 等. 应用GPS速度场和地震数据反演中国大陆构造应变场[J]. 测绘科学, 2016, 41(1): 60-64. | |

| 廖凯宁, 郝永伟. 地震数据处理和地震动力学仿真平台的优化研究[J]. 计算机工程与科学, 2015, 37(4): 663-669. | |

| 马新生, 谢志南, 王延伟, 等. 高性能集群系统在地震波数值模拟中的应用[J]. 地震工程与工程振动, 2010, 30(6): 43-48. | |

| 任骏声, 沈旭章. 基于接收函数和邻域算法的地壳各向异性结构反演[J]. 地球物理学进展, 2015, 30(5): 2043-2054. DOI:10.6038/pg20150507 | |

| 袁国兴, 姚继锋. 2015年中国高性能集群计算机发展现状分析[J]. 计算机工程与科学, 2015, 37(12): 2195-2199. DOI:10.3969/j.issn.1007-130X.2015.12.001 | |

| 张建国, 张明东, 康健. 基于并行计算地震地磁场动态演化特征[C]//中国地震学会地震电磁技术专业委员会地震电磁新技术新方法研讨活动论文摘要集. 西宁: 中国地震学会地震电磁学专业委员会, 2016. http://cpfd.cnki.com.cn/Article/CPFDTOTAL-DZDC201609001035.htm |

2018, Vol. 39

2018, Vol. 39