2. 同济大学附属上海市肺科医院超声科, 上海 200433;

3. 海军军医大学(第二军医大学)长海医院病理科, 上海 200433;

4. 上海恪熠信息科技有限公司, 上海 200434

2. Department of Ultrasound, Shanghai Pulmonary Hospital, Tongji University, Shanghai 200433, China;

3. Department of Pathology, Changhai Hospital, Naval Medical University(Second Military Medical University), Shanghai 200433, China;

4. Shanghai Keyi Information Technology Co., Ltd, Shanghai 200434, China

肺癌的发病率和死亡率均居癌症首位,仅中国每年就有近百万的新发病例[1-2]。随着医疗技术的发展,外科手术的适应证不断扩大,免疫治疗、靶向治疗也逐渐普及,而这些治疗都离不开准确的病理诊断[3-4]。传统病理诊断需要在显微镜下全面、仔细地观察切片,工作难度大、效率低、易疲劳,亟待开发一种能够辅助医师阅读切片的工具,缓解病理科工作压力[5-6]。基于深度学习算法的人工智能(artificial intelligence,AI)模型可以完成图像特征提取、内容分类、目标区域分割等工作,在病理图像的识别中具有极大的应用潜力[7-10]。本研究对肺部病变H-E染色切片进行研究,拟开发一种能够分析显微镜下图像并实时给出辅助诊断的AI模型。

1 资料和方法 1.1 资料采集回顾性收集2019年7月至2020年2月同济大学附属同济医院胸外科和呼吸科及上海市肺科医院超声科通过手术或超声/CT引导下穿刺活检获得的952例患者的肺部组织标本。对应的H-E切片共4 238张,选择每例患者质量最好、最具代表性的切片用于本研究。排除标准:(1)转移性肿瘤等非肺部原发性疾病;(2)病变标本中含有非典型成分,且经病理科至少2名主治医师和1名主任医师仅依据H-E染色的组织形态特征不能达成诊断共识者;(3)在制片过程中组织切割过厚、留有大量刀痕、细胞挤压变形、染色不满意等造成视觉效果受影响,不适用于明确诊断的切片。

重新评估所有病例,结合临床资料、免疫组织化学和基因检测结果确定病灶的最终类型,包括鳞状细胞癌、腺癌、其他恶性肿瘤和良性病变。以疾病类型为分层依据,使用分层随机采样方法将最终纳入的病例分入训练集、验证集和测试集,数量比例为5:3:2。

使用Motic EasyScanner高清病理切片扫描仪(中国麦克奥迪实业集团有限公司,同济大学附属同济医院切片使用)和CX22显微镜(日本奥林巴斯公司,同济大学附属上海市肺科医院切片使用)及其配备的图像采集器,在放大400倍条件下随机在训练集和验证集的每张切片中获取10张单视野图像。要求图像之间不能重叠,每张图像空白区域不得超过90%。最终获得的图像大小为600像素×600像素,每个像素实际长度为0.5 μm。然后使用Visual Geometry Group Image Annotator工具(http://www.robots.ox.ac.uk/~vgg/software/via/)分割恶性病变区域。

以上的病理评估过程由2名具有5年以上肺部疾病诊断经验的病理科主治医师共同完成,若出现争议,则与第3位病理科高年资主任医师讨论决定,最终结果为金标准。

1.2 分割模块训练分割模块是基于YOLO(you only look once)v3网络开发的,该网络已经在包含数百万张自然图像的公共数据库中进行了预训练。基于迁移学习的思想,使用训练集的单视野图像对该网络进一步训练,使其将其他领域的分割能力转化为对肺部病变病理图像良恶性病变区域的分割能力,并调整参数,尽量降低假阴性率(即恶性病变区域未被检出的情况)。

1.3 分类模块训练分类模块采用了Google Inception v3网络,该网络接受了与YOLO v3网络相似的预训练。使用训练集的单视野图像进一步训练该网络的分类能力,实现对病理亚型的分类,具体为鳞状细胞癌、腺癌、其他恶性肿瘤和良性病变。

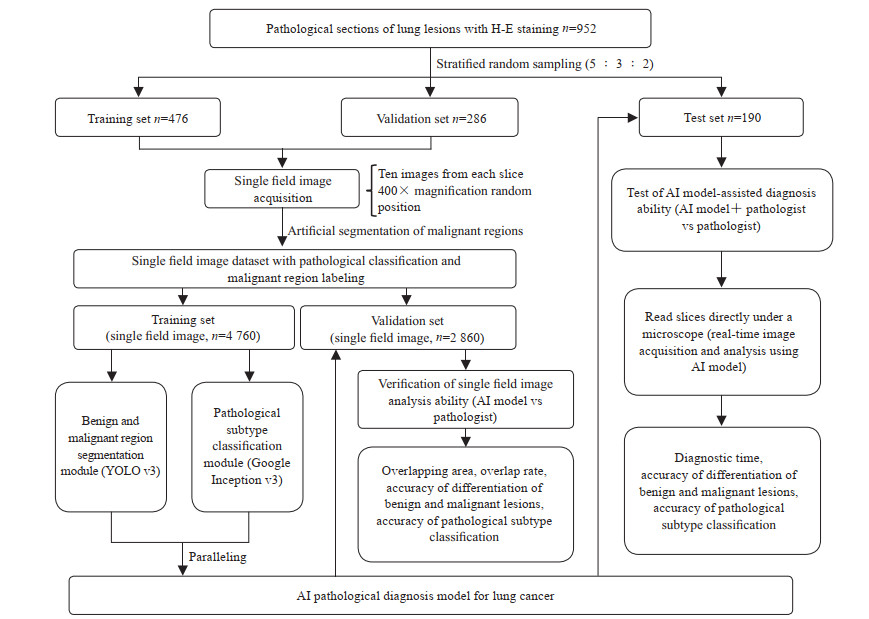

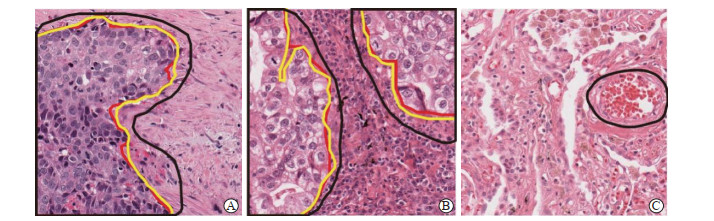

1.4 最终模型的构建与性能评估将上述训练的分割和分类模块并联,并为每个模块设计独立的开关和结果输出通道,构建AI肺癌病理诊断模型。使用时,AI模型会在显微镜端实时采集病理切片图像并自动输入,2个模块可以独立或同时运行并输出结果给使用者,其中分割模块将会在良恶性病变区域之间形成分割线,并标注出良性或恶性病变区域,而分类模型则以文字形式输出最终结果(图 1)。使用验证集的单视野图像评估AI模型与病理医师的诊断能力。将图像随机分配至5名病理医师(其中主治医师3名,副主任医师2名),每张图像被诊断1次,汇总整体结果并与AI模型诊断结果对比。病理金标准、AI模型和病理医师的鳞状细胞癌、腺癌与良性病变的单视野图像分割结果示例见图 2。评估参数包括AI模型和病理医师分割的恶性病变区域与金标准的重叠面积和重叠率[重叠率=2×重叠面积/(分割面积+金标准面积)×100%]、良恶性病变鉴别准确度、病理亚型分类准确度和单视野图像诊断用时。

|

图 1 AI肺癌病理诊断模型的构建和性能评估流程 Fig 1 Construction and performance evaluation of an AI pathological diagnosis model for lung cancer AI: Artificial intelligence; YOLO: You only look once |

|

图 2 病理金标准、AI模型和病理医师分割的恶性病变区域 Fig 2 Gold standard, AI model and pathologist for malignant segmentation A: Lung squamous cell carcinoma; B: Lung adenocarcinoma; C: Normal vessel region (the area circled by the black curve is the area misdiagnosed as malignant by AI model). Red curve: Gold standard; Black curve: AI model; Yellow curve: Pathologist. AI: Artificial intelligence. H-E staining. Original magnification: ×400 |

为测试模型在现实工作环境中的性能,由2名教育和工作经历相似的、经过统一培训的病理科住院医师分别使用AI模型和传统方法诊断测试集中的病理切片。使用AI模型诊断的医师会额外获得模型分析的实时结果作为诊断参考。评估参数包括良恶性病变鉴别准确度、病理亚型分类准确度和全切片诊断用时。

1.5 统计学处理应用SPSS 20.0软件进行统计学分析。计量资料以x±s表示,重叠面积和重叠率的比较采用独立样本t检验,诊断用时比较采用配对样本t检验,AI模型、病理医师和金标准分割的恶性病变面积比较采用单因素方差分析(两两比较采用最小显著性差异法);计数资料以例数和百分数表示,性别和病变类型的比较采用Pearson χ2检验,灵敏度、特异度、准确度的比较采用McNemar检验。检验水准(α)为0.05。

2 结果 2.1 患者特征共收集952例患者资料(上海市同济医院365例、上海市肺科医院587例),患者年龄为15~87岁,平均年龄为(58.9±15.6)岁;男631例(66.28%)、女321例(33.72%);鳞状细胞癌254例(26.68%)、腺癌278例(29.20%)、其他恶性肿瘤47例(4.94%)、良性病变373例(39.18%)。按5:3:2分配为训练集、验证集和测试集。训练集共有患者476例(单视野图像4 760张),年龄为15~86岁,平均年龄为(59.51±15.58)岁;男317例(66.60%)、女159例(33.40%);鳞状细胞癌130例(单视野图像1 300张,27.31%)、腺癌141例(单视野图像1 410张,29.62%)、其他恶性肿瘤21例(单视野图像210张,4.41%)、良性病变184例(单视野图像1 840张,38.66%)。验证集共有患者286例(单视野图像2 860张),年龄为17~87岁,平均年龄为(59.35±15.07)岁;男189例(60.08%)、女97例(33.92%);鳞状细胞癌74例(单视野图像740张,25.87%)、腺癌82例(单视野图像820张,28.67%)、其他恶性肿瘤14例(单视野图像140张,4.90%)、良性病变116例(单视野图像1 160张,40.56%)。测试集共有患者190例(病理切片190张),年龄为19~87岁,平均年龄为(56.7±16.13)岁;男125例(65.79%)、女65例(34.21%);鳞状细胞癌50例(26.32%)、腺癌55例(28.95%)、其他恶性肿瘤12例(6.32%)、良性病变73例(38.42%)。

2.2 AI模型的构建和性能评估训练集共包含4 760张单视野图像,其中恶性病变图像2 920张(61.34%),良性病变图像1 840张(38.66%),全部用于AI模型的构建。

验证集共有2 860张单视野图像,其中恶性病变图像1 700张(59.44%),良性病变图像1 160张(40.56%)。恶性病变图像中金标准恶性病变区域面积为(206 691.59±93 095.68)像素,病理医师分割的恶性病变区域面积为(207 057.05±93 418.31)像素,AI模型分割的恶性病变区域面积为(222 575.33±94 134.53)像素,三者比较差异有统计学意义(F=16.139,P<0.01);两两比较结果显示,金标准与病理医师分割的恶性病变区域面积比较差异无统计学意义(P=0.909),但AI模型分割的恶性病变区域面积大于前两者(P均<0.01)。另外AI模型的重叠面积与病理医师相比差异无统计学意义[(203 417.43±95 853.49)像素vs(199 324.28±92 555.93)像素,t=1.272,P=0.204],但重叠率低于病理医师[(92.72±12.75)% vs (95.42±6.99)%,t=7.628,P=0.001]。由表 1可见,在良恶性病变鉴别方面,AI模型的灵敏度为100.00%(1 700/1 700),优于病理医师(99.65%,1 694/1 700;χ2=4.167,P=0.031),但特异度和准确度均低于病理医师[97.67%(1 133/1 160)vs 99.31%(1 152/1 160),χ2=12.000,P=0.001;99.06%(2 833/2 860)vs 99.51%(2 846/2 860),χ2=4.364,P=0.037];在病理亚型分类准确度方面,AI模型和病理医师之间差异无统计学意义[95.52%(2 732/2 860)vs 94.30%(2 697/2 860),χ2=3.422,P=0.064]。另外,AI模型的单视野图像诊断用时也短于病理医师[(0.03±0.01)s vs(7.96±2.4)s,t=177.714,P<0.01]。

|

|

表 1 AI模型和病理医师验证集单视野图像中病变诊断能力的比较 Tab 1 Comparison of diagnostic ability between AI model and pathologist in single field images of the validation set |

测试集共包含190张病理切片,其中恶性病变图像117张,良性病变图像73张。由表 2可见,使用AI模型辅助和使用传统方法的病理医师在良恶性病变鉴别准确度[100.00%(190/190)vs 99.47%(189/190)]和病理亚型分类准确度[96.84%(184/190)vs 93.68%(178/190)]方面差异均无统计学意义,但使用AI模型辅助的病理医师诊断用时短于使用传统方法的病理医师[(12.53±10.93)s vs(79.95±40.02)s,t=28.939,P<0.01]。

|

|

表 2 使用AI模型辅助和传统方法的病理医师测试集全切片图像中病变诊断能力的比较 Tab 2 Comparison of diagnostic ability between pathologists using AI model-assisited and conventional methods in the whole sections of the test set |

3 讨论

传统的病理学诊断依赖病理医师在显微镜下仔细观察切片,根据自己的经验进行分析,存在工作量大、主观性强等缺点[11]。随着计算机技术的发展,基于深度学习算法的AI模型在图像分析领域越来越具有优势,其处理速度快、准确性高、稳定性强等优点已在众多情景中得到验证[12-14]。AI病理学诊断模型在肝癌、乳腺癌、膀胱癌等的识别中都已有初步报道,但多数局限于对扫描获得的全切片数字化图像进行识别,由于扫描过程缓慢,应用其进行诊断反而降低了工作效率,实用性有待提高[10, 15-20]。本研究开发了一种在病理医师工作过程中能实时采集显微镜图像并计算分析的AI快速诊断模型,具有良好的应用效果。

与既往研究不同,我们摒弃了复杂的切片扫描过程,直接从显微镜图像采集器中获取单视野图像并实时反馈分析结果,适用于快节奏的工作环境。本研究中AI模型对每个视野的平均诊断用时仅为(0.03±0.01)s,对应的刷新率为33帧/秒,而一般电影的刷新率为24~30帧/秒,可见该AI模型在实际应用中将较少造成计算机卡顿。但快速的分析速度也依赖于良好的计算机性能,针对多数医院低性能的办公计算机,我们采用了并联模块的解决方案。

并联的2个模块分别为分割和分类模块,前者仅用于鉴别良恶性病变区域并提示使用者,起到引导医师查找恶性病变目标的作用;后者进一步区分病理亚型,达到精准诊断的目的。并联模块的方法充分考虑了工作环境的多样性,2个模块可以独立使用,在快速查找恶性病变目标时可以仅使用分割模块,在仔细观察时启动分类模块获得诊断参考。独立使用2个模块可以减少分析步骤,可有效减少低性能计算机的卡顿情况,提高诊断效率。

在恶性病变区域分割方面,我们使用了YOLO网络。相较于传统的基于区域的卷积神经网络(region-based convolutional neural network,R-CNN)系列,YOLO网络具有更快的分析速度,适合显微镜下运动的图像,并且该网络对小目标的识别效果较好,有利于提高灵敏度,这也与辅助查找恶性病变的目的相一致。在验证集中,医师漏诊了6例恶性病变单视野图像,这些图像中的恶性病变区域面积均不超过全切片的5%,且漏诊事件均发生在长时间的图像阅读后,此时医师的视觉疲劳可能是导致漏诊的主要因素,而AI模型持续工作能力强、稳定性好,不会出现漏诊的情况。AI模型的高灵敏度也导致了特异度的降低,主要体现在2个方面:一是假阳性病例较多,聚集重叠的血细胞或制片过程中造成的组织破碎和异常排列常被误判为恶性病变;二是AI模型分割获得的恶性病变区域面积较大,包含了部分良性区域,造成重叠率较低。但分割模块的目的即辅助使用者更灵敏地检出恶性病变,所以牺牲少许特异度是可以接受的。

在病理亚型分类方面,我们使用了Google Inception网络,这是一种最经典的卷积神经网络。与其他网络相比,Google Inception网络最大的优点是为开发者省略了参数探索的过程,自动的最优化调节使其使用方便且可靠。在验证集中,AI模型的准确度与病理医师相当。由于单视野图像的限制,医师很难全面地掌握病变的形态特征,病理亚型分类的准确度有所降低,AI模型可以更深层次地挖掘图像的亚视觉信息,超越了传统意义上的形态学特点,能更准确地进行病理亚型分类,获得了良好的诊断结果。

在评估AI模型在现实工作中的应用时,病理医师借助AI模型诊断明显快于传统病理诊断,且两者的良恶性病变鉴别和病理亚型分类准确度差异均无统计学意义,再次证明了该模型有较高的辅助诊断价值。

本研究有以下局限性:(1)排除了有争议的和制片质量差的切片,而这些特征不显著的病例更需要AI模型的辅助诊断。(2)小细胞肺癌等其他类型恶性病变的样本量较小,需要进一步补充。(3)可用于良性病变分类的AI模型仍需探索。

综上所述,构建的肺癌AI辅助诊断模型可以有效辅助病理医师,提高工作效率,降低工作强度,在低年资医师的教学训练中也有一定的辅助作用。尽管我们的AI模型还有待完善、诊断准确度有待进一步提高,但本研究结果无疑增加了本领域的研究信心,可为进一步探索提供借鉴。

| [1] |

SIEGEL R L, MILLER K D, JEMAL A. Cancer statistics, 2020[J]. CA Cancer J Clin, 2020, 70: 7-30. DOI:10.3322/caac.21590 |

| [2] |

孙可欣, 郑荣寿, 张思维, 曾红梅, 邹小农, 陈茹, 等. 2015年中国分地区恶性肿瘤发病和死亡分析[J]. 中国肿瘤, 2019, 28: 1-11. |

| [3] |

SHIN J Y, YOON J K, MARWAHA G. Progress in the treatment and outcomes for early-stage non-small cell lung cancer[J]. Lung, 2018, 196: 351-358. DOI:10.1007/s00408-018-0110-1 |

| [4] |

CLARK J W, LONGO D L. Recent progress in systemic treatment for lung cancer[J]. Curr Opin Pulm Med, 2018, 24: 355-366. DOI:10.1097/MCP.0000000000000493 |

| [5] |

卞修武, 平轶芳. 我国病理学科发展面临的挑战和机遇[J]. 第三军医大学学报, 2019, 41: 1815-1817. |

| [6] |

陈军芳. 二级以上医院病理技术人员现状及需求分析[J]. 中国现代医药杂志, 2017, 19: 104-105. DOI:10.3969/j.issn.1672-9463.2017.12.029 |

| [7] |

SRIVASTAVA A, KULKARNI C, HUANG K, PARWANI A, MALLICK P, MACHIRAJU R. Imitating pathologist based assessment with interpretable and context based neural network modeling of histology images[J/OL]. Biomed Inform Insights, 2018, 10: 1178222618807481. doi: 10.1177/1178222618807481.

|

| [8] |

KÄLLÉN H, MOLIN J, HEYDEN A, LUNDSTRÖM C, ÅSTRÖM K. Towards grading gleason score using generically trained deep convolutional neural networks[C]//2016 IEEE 13th International Symposium on Biomedical Imaging (ISBI). Prague, 2016: 1163-1167.

|

| [9] |

SONG Y, ZHANG L, CHEN S, NI D, LI B, ZHOU Y, et al. A deep learning based framework for accurate segmentation of cervical cytoplasm and nuclei[C]//2014 36th Annual International Conference of the IEEE Engineering in Medicine and Biology Society. Chicago, IL, 2014: 2903-2906.

|

| [10] |

EHTESHAMI BEJNORDI B, VETA M, JOHANNES VAN DIEST P, VAN GINNEKEN B, KARSSEMEIJER N, LITJENS G, et al. Diagnostic assessment of deep learning algorithms for detection of lymph node metastases in women with breast cancer[J]. JAMA, 2017, 318: 2199-2210. DOI:10.1001/jama.2017.14585 |

| [11] |

唐仲平, 崔权哲, 杨李波, 包骥, 赵春. 全切片图像扫描技术在临床病理诊断工作中的应用[J]. 河北医科大学学报, 2018, 39: 1205-1209. DOI:10.3969/j.issn.1007-3205.2018.10.021 |

| [12] |

FAZAL M I, PATEL M E, TYE J, GUPTA Y. The past, present and future role of artificial intelligence in imaging[J]. Eur J Radiol, 2018, 105: 246-250. DOI:10.1016/j.ejrad.2018.06.020 |

| [13] |

杨文武, 普园媛, 赵征鹏, 徐丹, 钱文华, 阿曼. 基于多层特征描述及关系学习的智能图像情感识别[J]. 陕西师范大学学报(自然科学版), 2019, 47: 40-48. |

| [14] |

张昱欣, 季薇, 李云. 基于条件投影的无配对数据跨域图像翻译方法[J]. 陕西师范大学学报(自然科学版), 2019, 47: 34-39. |

| [15] |

陈颖, 魏培莲, 潘军, 周洁, 董昌盛, 于观贞. 数字化全玻片助力人工智能病理图像决策[J]. 第二军医大学学报, 2018, 39: 840-845. CHEN Y, WEI P L, PAN J, ZHOU J, DONG C S, YU G Z. Digital whole slide helps artificial intelligence in pathological imaging strategies[J]. Acad J Sec Mil Med Univ, 2018, 39: 840-845. |

| [16] |

于观贞, 魏培莲, 陈颖, 朱明华. 人工智能在肿瘤病理诊断和评估中的应用与思考[J]. 第二军医大学学报, 2017, 38: 1349-1354. YU G Z, WEI P L, CHEN Y, ZHU M H. Artificial intelligence in pathological diagnosis and assessment of human solid tumor:application and thinking[J]. Acad J Sec Mil Med Univ, 2017, 38: 1349-1354. |

| [17] |

梁桥康, 南洋, 项韶, 梅丽, 孙炜, 于观贞. 深度学习图像分割算法在胃癌病理切片中的可行性分析[J]. 第二军医大学学报, 2018, 39: 903-908. LIANG Q K, NAN Y, XIANG S, MEI L, SUN W, YU G Z. Feasibility of deep learning image-based segmentation algorithm in pathological section of gastric cancer[J]. Acad J Sec Mil Med Univ, 2018, 39: 903-908. |

| [18] |

KHOSRAVI P, KAZEMI E, IMIELINSKI M, ELEMENTO O, HAJIRASOULIHA I. Deep convolutional neural networks enable discrimination of heterogeneous digital pathology images[J]. EbioMedicine, 2018, 27: 317-328. DOI:10.1016/j.ebiom.2017.12.026 |

| [19] |

MADABHUSHI A, LEE G. Image analysis and machine learning in digital pathology:challenges and opportunities[J]. Med Image Anal, 2016, 33: 170-175. DOI:10.1016/j.media.2016.06.037 |

| [20] |

HAMILTON P W, WANG Y, BOYD C, JAMES J A, LOUGHREY M B, HOUGTON J P, et al. Automated tumor analysis for molecular profiling in lung cancer[J]. Oncotarget, 2015, 6: 27938-27952. DOI:10.18632/oncotarget.4391 |

2020, Vol. 41

2020, Vol. 41