2. 山东省网络环境智能计算技术重点实验室(济南大学), 济南 250022;

3. 山东省"十三五"高校智能信息处理与感知重点实验室, 济南 250022;

4. 北京邮电大学 自动化学院, 北京 100876;

5. 滨州渤海活塞有限公司, 山东 滨州 256602

为了使交互式工件分割算法满足实时性的要求,提出了一种将工件形态特征与图像分割算法相结合的工件自动分割方法.利用MeanShift算法分割图像提取目标区域;利用形态学开运算消除目标区域的噪声,进而分离相连的目标区域;对目标区域进行边缘检测,计算完整的工件轮廓信息,然后根据外轮廓的面积确定工件区域;利用工件区域的最小外接矩形在图像中标出前景和背景区域,再利用GrabCut算法分别对前景和背景建立高斯混合模型,然后通过mincut/maxflow算法分割前景与背景区域,最终实现工件目标的提取.实验结果表明,对于制造商提供的样本,该方法分割工件的召回率和准确率分别为94.97%和88.48%,具有较强的实用性和良好的实时性.

2. Shandong Provincial Key Laboratory of Network Based Intelligent Computing(University of Jinan), Jinan 250022, China;

3. Shandong College and University Key Laboratory of Information Processing and Cognitive Computing in 13thFive-Year, Jinan 250022, China;

4. School of Automation, Beijing University of Posts and Telecommunications, Beijing 100876, China;

5. Binzhou Bohai Piston Company Limited, Shandong Binzhou 250022, China

Since many enterprises produce a huge number of workpiece images every day, and the existing interactive workpiece segmentation algorithm can not meet the real-time requirements, a workpiece segmentation method combining workpiece morphological features and image segmentation algorithm is proposed. This method consists of four steps:firstly, the image is segmented by use of MeanShift algorithm to extract the target region; secondly, the noise in the target region is eliminated using morphological open operation, and then the connected target region can be separated; thirdly, the edge detection of the target region is carried out to calculate the complete workpiece contour information, and then the workpiece region is determined according to the size of the outer contour area; fourthly, the foreground and background regions are labeled by using the minimal contour rectangle of the workpiece area and the Gaussian mixture model is established using GrabCut algorithm for foreground and background respectively, then the foreground and background regions can be segmented by use of mincut/maxflow algorithm, and finally the workpiece object can be extracted. The experimental results show that, for the samples provided by the manufacturer, the recall and accuracy of the proposed method are 94.97% and 88.48% respectively, and the method has strong practicability and good real-time performance.

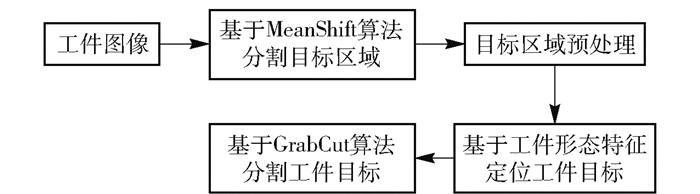

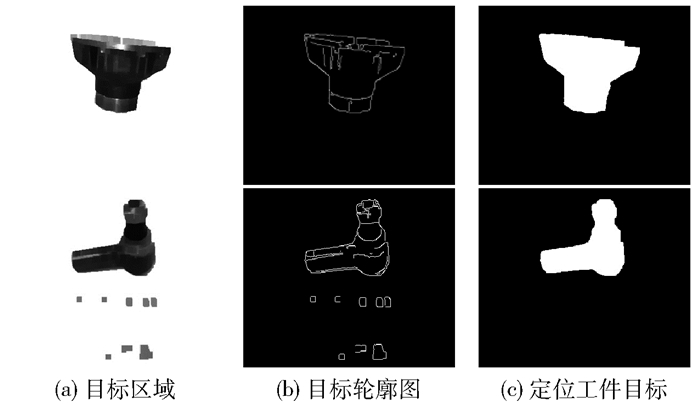

制造商在制造工件时,为了对工件批次信息以及生产工艺问题进行有效管控,采用制件简图的方式记录工件.由于制件现场比较复杂,难以提供背景单一的标准化拍摄简图,企业仍然以人工拍摄为主(见图 1),并以人工的方式从拍摄的大量图像中提取工件目标,获得制件简图.这种方式的优点是能够在图像中准确地找到工件位置,精确地提取工件边缘信息,保证工件的完整性.缺点是工件图像数量巨大,人工提取方式不但主观性强,而且成本高、效率低下.因此,十分有必要使用图像处理技术对工件图像分割目标,从而克服人工方式的缺点.

|

图 1 不同类型的工件图像 |

为了解决工件目标分割的问题,开展了基于图像的工件目标自动分割技术研究.调研发现,国内外学者及企业在使用图像处理技术分割工件图像目标方面的工作尚少,而与图像目标分割相关的研究很多.目前,基于图像处理的目标分割方法主要分为基于深度学习的目标分割方法、传统的目标自动分割方法以及交互式目标分割方法3类.

第1类是基于深度学习的目标分割方法[1].近年来,深度学习获得了快速发展,涌现出一些有效实用的分割方法,如全卷积网络(FCN, fully convolutional networks)[2]、基于区域掩模的卷积神经网络(Mask R-CNN, mask region-based convolutional neural network)[3]等方法,并且目标分割的精度不断提高.但是若想得到较好的分割效果,需要在大量数据集上进行较长时间的训练.而制造商提供的工件种类繁多,并且样本较少,因此现阶段深度学习难以解决工件图像分割问题.

第2类是传统的自动目标分割方法.频率调谐法(FT, frequency-tuned)是一种基于空间频率分析的分割算法[4],基本思想是利用颜色和亮度特征获得显著图,再依据显著图实现目标分割的方法.程明明等[5]提出了区域对比度(RC, region contrast)算法,将图像划分成多个区域,计算区域间的颜色对比度和空间信息,得到显著图,再应用GrabCut算法对显著图像进行目标分割.但是上述方法多数没有考虑到人眼在观察图像时特殊的处理过程[6],在拍摄环境不确定、工件背景杂乱以及工件种类繁多且结构复杂的图像中,工件分割的结果很难满足实际需求.

第3类是交互式目标分割方法,如图割(Graph Cut)[7]、随机游走[8]、活动轮廓模型[9]等分割算法.以人工方式标注图像的部分区域,粗略记为前景和背景,对标定的像素根据某些规则进行训练,实现目标分割.交互式目标分割算法通过人工交互的方式获得了较多的前景信息,分割结果较为精确,但是需要人工干预,不适用于分割大规模的工件图像[10].

上述3类方法主要是针对非工件图像的目标分割方法.这些方法都没有充分考虑工件的形态特征,难以进行直接移植.一般来说,工件具有结构复杂、种类繁多的特点.通过对图像的大量观察,这些特点具体表现为:1)图像分为目标区域和背景区域,而目标区域不仅包括工件目标,还包括非工件目标. 2)在整幅图像中,背景区域面积往往大于目标区域面积. 3)在目标区域中,工件目标整体性强,不容易被分散,工件目标面积往往大于非工件目标面积.

根据上述特点,并参考上述3类目标分割算法,提出了将工件形态特征与目标分割算法相结合的解决方案:1)依据背景区域面积远大于目标区域面积的特点,对图像进行分割后,消除背景区域. 2)针对工件目标整体性强,不容易打散的特点,对目标区域的形态学开运算,不但能够将部分相连的非工件目标分离,还能够消除目标区域的噪声. 3)利用工件目标在目标区域中所占比重大的特点,统计各目标完整的轮廓信息,将最大外轮廓的目标区域视为工件目标. 4)依据工件目标轮廓的最小外接矩形在图像中标注前景和背景,并结合基于图割理论的GrabCut算法对前景和背景进行分割,实现工件目标的分割.

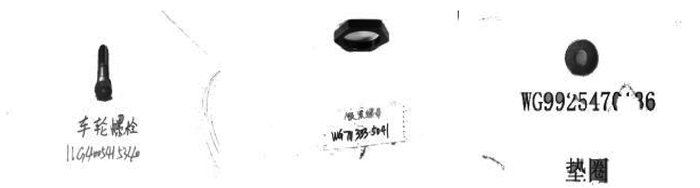

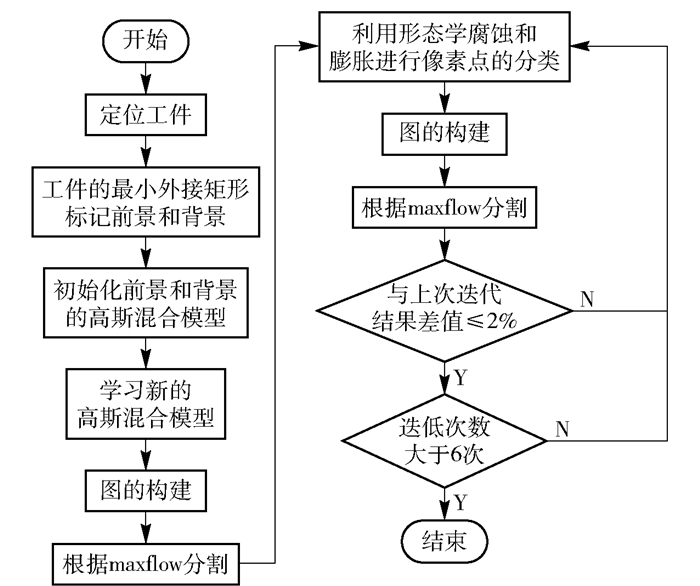

1 算法分析将工件形态特征与目标分割算法相结合的工件自动分割算法主要考虑到了工件结构复杂、种类繁多以及图像背景杂乱的特点,其具体流程如图 2所示.首先,运用MeanShift算法分割图像的目标和背景区域,依据区域面积特点,消除背景区域;其次,针对工件目标整体性强,不容易打散的特点,对目标区域进行形态学开运算,不仅能够分离出部分相连的非工件目标,还可以消除目标区域的噪声;然后,采用Canny算子对目标区域进行边缘检测和形态学闭运算,统计各目标完整的轮廓信息,将最大外轮廓区域视为工件目标;最后,利用工件目标的最小外接矩形标记前景和背景区域,结合GrabCut算法实现工件目标的精确分割.

|

图 2 算法流程 |

由图 1可以看出,工件图像可分为目标区域和背景区域,而目标区域不仅包括工件目标,还包括非工件目标,如标签、螺丝等.在提取工件目标之前,先对图像进行区域分割,排除背景对定位工件目标的干扰.工件图像包含丰富的结构和纹理信息,而MeanShift分割算法对图像平滑区域和纹理区域不敏感,能够避免目标和背景区域的过分割现象,提高图像的分割精度,因此选用MeanShift算法分割工件图像[11].

MeanShift算法的基本思想是依据图像像素的坐标信息和颜色信息构建联合特征空间.对联合特征空间的样本点进行聚类,沿梯度的上升方向收敛到密度梯度为零的类中心点.将样本点的像素颜色改变为类中心点的颜色,从而达到图像平滑的效果[12].

MeanShift的可扩展形式为

| $ {M_h}\left( x \right) = \frac{{\sum\limits_{i = 1}^n G \left( {\frac{{{x_i} - x}}{h}} \right)w\left( {{x_i}} \right){x_i}}}{{\sum\limits_{i = 1}^n G \left( {\frac{{{x_i} - x}}{h}} \right)w\left( {{x_i}} \right)}} - x $ | (1) |

其中:h为常系数,G(x)为单位核函数,w(xi)≥0为采样点xi的权重.

在MeanShift算法应用于工件目标分割时,为了综合考虑工件的空间信息和颜色信息,采用多元化核函数Ks, r来估计x的分布,Ks, r表示为

| $ {K_{s,r}}\left( x \right) = \frac{C}{{{s^2}{r^2}}}K\left( {{{\left\| {\frac{{{x^s} - x_i^s}}{s}} \right\|}^2}} \right)K\left( {{{\left\| {\frac{{{x^r} - x_i^r}}{r}} \right\|}^2}} \right) $ | (2) |

其中:s和r为控制图像分割的速度和质量,C为归一化系数.此时,MeanShift的收敛点表示为

| $ \begin{array}{*{20}{c}} {{y_{i,j + 1}} = }\\ {\frac{{\sum\limits_{k = 1}^n {{x_k}} g\left( {{{\left\| {\frac{{y_{i,j}^s - x_k^s}}{s}} \right\|}^2}} \right)g\left( {{{\left\| {\frac{{y_{i,j}^r - x_k^r}}{r}} \right\|}^2}} \right)}}{{\sum\limits_{k = 1}^n g \left( {{{\left\| {\frac{{y_{i,j}^s - x_k^s}}{s}} \right\|}^2}} \right)g\left( {{{\left\| {\frac{{y_{i,j}^r - x_k^r}}{r}} \right\|}^2}} \right)}}} \end{array} $ | (3) |

在MeanShift算法分割的后处理中,为了防止因工件结构复杂而导致的过分割现象,提出了区域相似性合并规则对工件图像进行分割后的区域合并.具体步骤如下.

1) 兼并面积细小的区域.计算各区域像素的数量,将像素数量少的区域合并到相邻像素数量较多的区域,不仅能够消除分割后遗留下的噪声,还可以减少后续步骤的计算量.通过这种数量阈值筛选的规则,将像素数量小于某一阈值的小区域与其相邻的、颜色特征平均值相近的大区域合并,使得分割更加均匀,不同区域的区分更加明显.

2) 合并相似区域.为了确定相邻的分割区域是否相似,采用各区域的平均光谱矢量C代表该区域的光谱特征,如

| $ C = \frac{1}{M}\sum\limits_{i = 1}^M {{f_i}} \left( {x,y} \right) $ | (4) |

其中:M为区域内像素的数量,fi(x, y)为区域内灰度矢量.

计算2个相邻区域的平均光谱矢量的欧式距离D(Ci-Cj),如

| $ D\left( {{C_i},{C_j}} \right) = \left\| {{C_i} - {C_j}} \right\| = {\left[ {\sum\limits_{l = 1}^L {{{\left( {{C_{il}} - {C_{jl}}} \right)}^2}} } \right]^{\frac{1}{2}}} $ | (5) |

其中:L为波段数(L, U, V),C为区域的光谱特征矢量值.

如果2个相邻区域的平均光谱矢量的欧氏距离D(Ci-Cj)小于给定的阈值T,则将合并2个区域,得到最终的分割图像.

图 3所示为工件图像区域分割的3个实例.将MeanShift算法和区域合并准则相结合进行区域分割,在背景不平整的工件图像上仍然能够分割出较为完整的背景区域,如图 3(b)所示.

|

图 3 区域分割效果图 |

通过对工件图像的观察可知,背景区域面积往往大于目标区域面积.因此,统计分割后各区域的面积,将最大面积的区域视为背景区域进行消除,最终实现目标区域分割.由图 3(c)可以看出,在多种拍摄场景下,依据目标和背景区域的面积特点,能够有效消除背景区域,实现目标区域分割.

1.2 目标区域预处理由于部分图像的背景过于复杂,区域分割容易产生噪声点,导致目标之间存在狭窄的连接,如图 4所示.为了防止噪声点对工件目标分割的干扰,需要运用形态学运算消除噪声点,进而分离相连的目标.

|

图 4 目标区域图像 |

数字形态学包括膨胀、腐蚀、开运算、闭运算等操作[13].由式(6)可知,开运算是对图像先腐蚀再膨胀,能够断开图像中某些狭窄的连接,消除小的孤立对象,同时对较大的对象具有平滑作用.

| $ I \circ Y = \left( {I \ominus Y} \right) \oplus Y $ | (6) |

其中:I表示图像集合,Y为结构元素,⊖表示为腐蚀操作,⊕表示为膨胀操作.

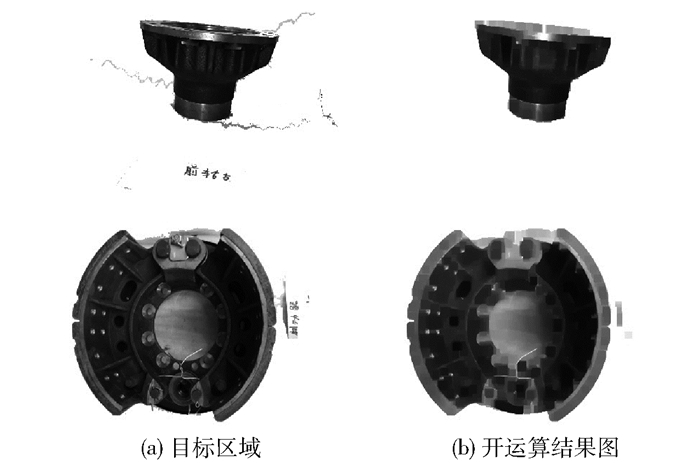

由图 4可知,工件目标具有整体强,不容易被打散的特点,并且噪声主要表现为细小、不连续的像素块.依据上述特点,选取以中心点为原点,大小为9×9的矩形结构元素对目标区域做开运算.如图 5所示,经过开运算处理,不仅能够消除各目标周围的噪声点,还能分离部分目标存在的狭窄连接,消除后续对定位工件目标的干扰.

|

图 5 目标区域预处理 |

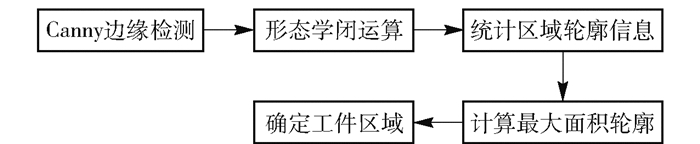

依据目标区域具有工件目标整体性强,工件目标面积往往大于非工件目标面积的特点,计算区域中目标的边缘,统计每个目标的外轮廓信息,选取最大外轮廓区域作为工件目标,流程如图 6所示.

|

图 6 确定工件目标流程 |

由于Canny算子采用双阈值法”和“非极值抑制”的方法,能够抑制噪声对边缘检测的干扰[14],故选择Canny算子作为边缘检测的算子.同时,为了防止目标边缘断裂,对统计目标外轮廓带来误差,在目标边缘图的基础上做形态学闭运算,弥合狭窄的边缘间断,如图 7(b)所示.

|

图 7 工件区域图像 |

依据目标的边缘信息,统计每个目标的外轮廓面积,再利用目标面积特点,依次比较目标的外轮廓面积,选取最大外轮廓区域定位为工件目标,如图 7(c)所示.

1.4 工件目标分割单纯利用轮廓信息分割工件目标,容易造成边缘信息分割不够精准,导致工件目标掺杂噪声,因此需要对工件目标做进一步精确分割. GrabCut算法是一种高效的前背景分割方法[15],通过人工选取前景和背景的方式能够得到精确的目标提取结果,故选用GrabCut算法作为工件目标精确分割的方法.

1.4.1 GrabCut算法基本原理1) 在RGB空间,运用K个高斯分量的高斯混合模型(GMM, Gaussian mixture model)对目标和背景进行建模[16].整个图像的Gibbs能量表示为

| $ E\left( {\alpha ,k,\theta ,z} \right) = U\left( {\alpha ,k,\theta ,z} \right) + V\left( {\alpha ,z} \right) $ | (7) |

其中:E为Gibbs能量,U为数据项,V为平滑项;α为不透明度,α∈[0, 1],0为背景,1为前景目标;θ为图像前景和背景的灰度直方图;z为图像灰度值数组,z=(z1, …, zn, …, zN).

2) 数据项U定义为

| $ U\left( {\alpha ,k,\theta ,z} \right) = \sum\limits_n {D\left( {{\alpha _n},k,\theta ,{z_n}} \right)} $ | (8) |

| $ D\left( {{\alpha _n},k,\theta ,{z_n}} \right) = - \log \pi \left( {{\alpha _n},{k_n}} \right) - \log p\left( {{z_n},{\alpha _n},{k_n},\theta } \right) $ | (9) |

其中:π(·)为高斯模型的样本数在总样本中的权值,p (·)为高斯概率分布.

高斯混合模型的参数模型为

| $ \theta = \{ \pi (\alpha ,k),\mu (\alpha ,k),\alpha = 0,1,k = 1,2, \cdots ,k\} $ | (10) |

其中:π(a, k)为每个高斯概率分布的样本数在总样本数中的权值,μ(a, k)为高斯模型的均值,∑(a, k)为协方差,a为不透明Alpha值,k为高斯混合模型参数.

3) 平滑项V用RGB空间的欧几里德距离求得

| $ V(\alpha ,z) = \gamma \sum\limits_{m,n \in c} {\left[ {{\alpha _n} \ne {a_m}} \right]} \exp - \beta {\left\| {{z_m} - {z_n}} \right\|^2} $ | (11) |

4) 通过迭代执行mincut/maxflow算法,不断优化更新高斯混合模型的参数,使得分割能量E逐渐减少,最终收敛于最小值,从而实现前景和背景的分割[17].

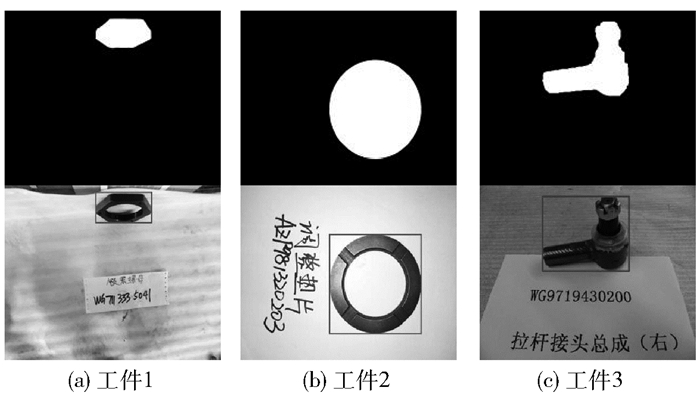

1.4.2 基于GrabCut的工件目标分割经过工件目标定位后,把定位区域作为先验信息,并结合GrabCut算法分割工件目标,分割流程如图 8所示.首先利用已定位的工件目标的最小外接矩形替代传统GrabCut算法的人工标注矩形区域,实现工件目标和背景区域的初始化.如图 9所示,图 9(a)~(c)上方是工件目标定位区域图像,下方是利用定位区域的最小外接矩形标注的图像.

|

图 8 分割流程 |

|

图 9 最小外接矩标注图 |

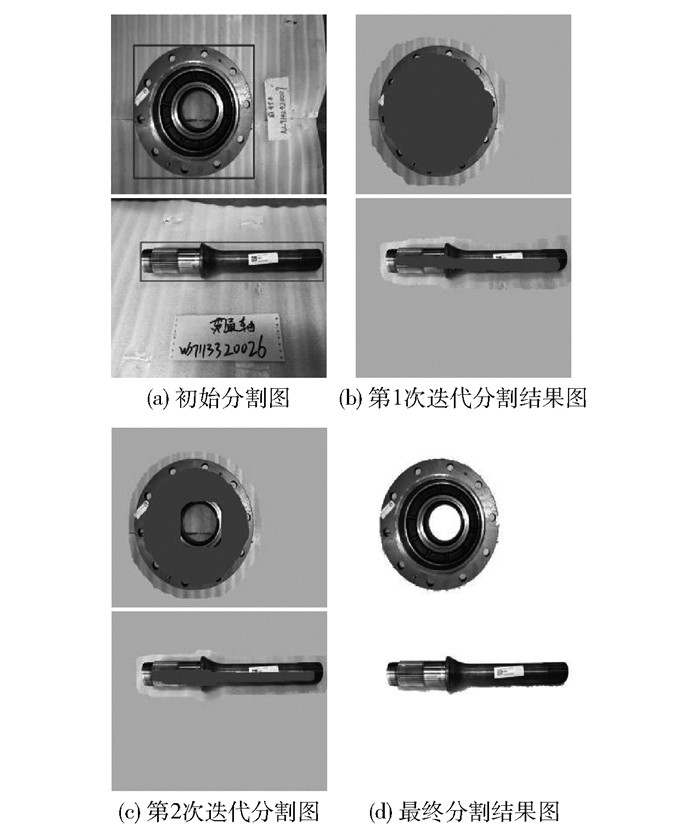

对图像的目标和背景区域初始化后,迭代运行GrabCut算法分割工件目标.为了保证分割的精度,在每次迭代后,利用形态学膨胀和腐蚀操作得到新图像,进行下次迭代.如图 10(b)和(c),将膨胀后仍然在目标外面的区域设置为背景,将腐蚀后的目标设置为前景,剩下的区域设置为未知区域.其中,迭代分割结果如图 10(b)和(c),在工件内部涂抹的同一灰度值区域代表前景,在工件外部涂抹的同一灰度值区域代表背景,未知区域为原图颜色.

|

图 10 GrabCut迭代分割图 |

在算法迭代的过程中,还需要对迭代结果是否收敛进行判断.由于每次迭代过程都需要对高斯混合模型重新进行初始化,使得算法的迭代次数过多而导致算法效率的下降.因此,在每次迭代时,将本次迭代结果与上次迭代结果进行差值比较.如果与上次迭代结果的差值小于2%,则迭代结束;否则,对迭代结果做膨胀和腐蚀后继续下次迭代.同时,在实验过程中发现算法在迭代到4~6次时,超过90%的工件图像分割能量E的数值变动可以忽略不计.因此,将迭代次数的最大上限定为6次,以保证算法的分割效率.由图 10可以看出,在迭代过程中,背景区域逐步被正确消除,最终获得工件目标图像.

2 实验结果及分析本算法以Microsoft Visual Studio 2017为实验平台,在CPU为Intel i5-3230M,RAM为8 GB的计算机上进行实验.为了全面测试算法的准确性,分别从视觉效果和性能测试对该算法进行分析验证.

2.1 视觉效果本实验采用的测试集来自制造商提供的现场图像.此测试集是由3 000幅工件图像组成,包含400种工件类型.为了验证本文方法对工件图像目标分割的有效性,将本文方法与其他2个主流方法进行比较,分别是FT算法和RC算法. FT算法对图像的纹理和噪声产生的高频信息具有较强的抗干扰能力,在质量较差的图像上仍然能够确定目标位置,实现目标分割,具有简单、高效的特点. RC算法能够获得高质量的显著图,对自然图像的目标分割具有较高的准确率.

将本文方法和其他2种算法应用在工件测试集上测试,得到工件目标分割的结果图,如图 11所示.

|

图 11 工件目标分割结果 |

图 11(c)所示为FT算法的实验结果.可以看到,工件目标的提取存在冗余信息,原因是图像中非工件目标因素的干扰性大,显著区域被弱化,背景对比度较差,显著区域中心像素受抑制,不显著区域被突出,导致了工件目标冗余分割.

图 11(d)为RC算法的实验结果,可以看到,工件目标存在误分割情况.原因是该算法依据区域的颜色对比度和空间信息确定显著目标,当图像的工件目标颜色和背景相近,并且非工件目标的颜色对比度大时,该算法会将非工件目标作为显著目标进行分割.

图 11(e)为本文方法的实验结果,可以看出,在背景复杂的工件图像中,本文方法消除了背景因素对工件目标提取的干扰,依据工件形态特征排除非目标区域,有效地避免了工件目标的误分割.同时结合GrabCut算法精确分割工件目标,防止了工件目标冗余分割和信息缺失的情况发生,所以本文方法在工件目标的提取准确度方面明显比其他算法准确.

2.2 性能测试为了进一步验证本文方法具有较好的分割质量,通过误分割率E和F度量对图像分割结果进行定量分析与对比[18].如式(12)、式(13)所示,误分割率E表示算法分割结果与人工分割结果的差异性,F度量表示算法分割结果的准确度.误分割率E越小,图像分割错误的区域越小;度量F越大,分割结果越准确.

| $ E = \frac{{{S_{{\rm{seg}}}} \cup {S_{{\rm{GT}}}} - {S_{{\rm{Seg}}}} \cap {S_{{\rm{GT}}}}}}{S} $ | (12) |

其中:SGT为人工分割的目标区域,SSeg为算法分割的目标区域,S表示图像的尺寸.

| $ F = \frac{{PR}}{{\xi R + \left( {1 - \xi } \right)P}} $ | (13) |

其中:ζ为常数,通常取值为0.5;P为准确率,表示算法的正确分割区域占算法总分割区域的比例;R为召回率,表示算法的正确分割区域占人工分割区域的比例,如式(14)、式(15)所示.

| $ P = \frac{{{S_{{\rm{Seg}}}} \cap {S_{{\rm{GT}}}}}}{{{S_{{\rm{Seg}}}}}} $ | (14) |

| $ R = \frac{{{S_{{\rm{Seg}}}} \cap {S_{{\rm{GT}}}}}}{{{S_{{\rm{GT}}}}}} $ | (15) |

在工件数据集上分别使用FT算法、RC算法和本文方法进行测试,各算法分割结果的准确率和召回率如图 12所示.本文方法的准确率P和召回率R分别是88.48%和94.97%,误分割率E和度量F分别是1.31%和91.62%.与其他2种算法相比,本文方法在工件目标的提取准确度明显比其他2种算法准确,性能更优,能够较好地应用于工件图像分割.

|

图 12 算法准确率和召回率柱状图 |

针对现有分割方法难以对工件图像进行有效分割的不足,根据工件的形态特征,提出了将工件形态特征与图像分割算法相结合的工件自动分割方法.先在工件图像上预分割出目标区域,再利用工件形态特征以及形态学运算在目标区域上定位工件目标,并结合GrabCut算法进一步精确分割工件目标.实验结果表明,本文方法的准确率和召回率都优于其他方法,并且实现简单,运行效率高,能够满足供应商记录制件简图的实际需求.

但是,该算法还存在一定的不足.由于算法依据工件形态特征,通过目标最大外轮廓定位工件目标时,容易包含工件的阴影部分而导致冗余分割.因此,如何避免阴影对工件分割的影响将是下一步的研究方向.

| [1] |

Wang W, Shen J, Yang R, et al. Saliency-aware video object segmentation[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2018, 40(1): 20-33. |

| [2] |

Long J, Shelhamer E, Darrell T. Fully convolutional networks for semantic segmentation[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2014, 39(4): 640-651. |

| [3] |

He K, Gkioxari G, Dollár P, et al. Mask R-CNN[C]//IEEE International Conference on Computer Vision. Venice: IEEE Computer Society Press, 2017: 2980-2988.

|

| [4] |

Achanta R, Hemami S, Estrada F, et al. Frequency-tuned salient region detection[C]//IEEE Conference on Computer Vision and Pattern Recognition.Florida: IEEE Press, 2009: 1597-1604.

|

| [5] |

Cheng M M, Mitra N J, Huang X, et al. Global contrast based salient region detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3): 569-582. DOI:10.1109/TPAMI.2014.2345401 |

| [6] |

Arbeláez P, Maire M, Fowlkes C, et al. Contour detection and hierarchical image segmentation[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2011, 33(5): 898-916. |

| [7] |

Gulshan V, Rother C, Criminisi A, et al. Geodesic star convexity for interactive image segmentation[C]//IEEE Conference on Computer Vision and Pattern Recognition. San Francisco: IEEE Press, 2010: 3129-3136.

|

| [8] |

王富治, 秦付军, 蒋代君, 等. 基于视觉注意的随机游走图像分割[J]. 仪器仪表学报, 2017, 38(7): 1772-1781. Wang Fuzhi, Qin Fujun, Jiang Daijun, et al. Random walks for image segmentation based on visual attention[J]. Chinese Journal of Scientific Instrument, 2017, 38(7): 1772-1781. DOI:10.3969/j.issn.0254-3087.2017.07.026 |

| [9] |

陈学灵, 王美清. 结合动态亮度的活动轮廓模型分割相似图像组[J]. 电子设计工程, 2016, 24(7): 164-167. Chen Xueling, Wang Meiqing. Active contours with the dynamic brightness for segmenting the groups of similar images[J]. Electronic Design Engineering, 2016, 24(7): 164-167. DOI:10.3969/j.issn.1674-6236.2016.07.050 |

| [10] |

Ning J, Zhang L, Zhang D, et al. Interactive image segmentation by maximal similarity based region merging[J]. Pattern Recognition, 2010, 43(2): 445-456. |

| [11] |

张宇洋, 刘满华, 韩韬. 基于MeanShift图像分割和支持向量机判决的候梯人数视觉检测系统[J]. 光学精密工程, 2013, 21(4): 1079-1085. Zhang Yuyang, Liu Manhua, Han Tao. Elevator waiting people counting system based on MeanShift segmentation and SVM classification[J]. Optics and Precision Engineering, 2013, 21(4): 1079-1085. |

| [12] |

柯佳宏, 吴安东, 李勇, 等. 基于LBP改进的MeanShift高分辨率遥感影像分割方法[J]. 矿山测量, 2017, 45(06): 64-68. Ke Jiahong, Wu Andong, Li Yong, et al. Segmentation method of improved MeanShift high resolution remote sensing image based on LBP[J]. Mine Surveying, 2017, 45(06): 64-68. DOI:10.3969/j.issn.1001-358X.2017.06.015 |

| [13] |

王树文, 闫成新, 张天序, 等. 数学形态学在图像处理中的应用[J]. 计算机工程与应用, 2004, 40(32): 18-20. Wang Shuwen, Yan Chengxin, Zhang Tianxu, et al. Application of mathematical morphology in image processing[J]. Computer Engineering and Applications, 2004, 40(32): 18-20. DOI:10.3321/j.issn:1002-8331.2004.32.006 |

| [14] |

丁文, 李勃, 陈启美. Canny色彩边缘检测及分类新方法[J]. 北京邮电大学学报, 2012, 35(1): 115-119. Ding Wen, Li Bo, Chen Qimei. A new approach of Canny edge detection and classification for color images[J]. Journal of Beijing University of Posts and Telecommunications, 2012, 35(1): 115-119. DOI:10.3969/j.issn.1007-5321.2012.01.027 |

| [15] |

Rother C, Kolmogorov V, Blake A. "GrabCut": interactive foreground extraction using iterated graph cuts[C]//ACM Transactions on Graphics. New York: ACM Press, 2004: 309-314.

|

| [16] |

王超, 李静, 李东民. 一种协同显著目标自动分割方法[J]. 小型微型计算机系统, 2018, 39(4): 830-835. Wang Chao, Li Jing, Li Dongmin. Co-saliency object automatic segmentation method[J]. Journal of Chinese Computer Systems, 2018, 39(4): 830-835. DOI:10.3969/j.issn.1000-1220.2018.04.037 |

| [17] |

李昀峰, 周东, 阮雅端. 抑制船尾拖纹的船舶显著性视频检测方法[J]. 北京邮电大学学报, 2017, 40(1): 75-79. Li Yunfeng, Zhou Dong, Ruan Yaduan. Ships saliency detection algorithm for inhibiting stern ripples based on video sequence[J]. Journal of Beijing University of Posts and Telecommunications, 2017, 40(1): 75-79. |

| [18] |

王刚, 王晓东, 陈超, 等. 一种多尺度超像素显著性检测算法[J]. 计算机工程, 2016, 42(7): 257-260. Wang Gang, Wang Xiaodong, Chen Chao, et al. A multi-scale superpixels saliency detection algorithm[J]. Computer Engineering, 2016, 42(7): 257-260. DOI:10.3969/j.issn.1000-3428.2016.07.043 |