提出了一种基于流行度的概率存入校验机制(PCS-CP),根据接收内容的流行度,概率抽取内容校验,并只存入校验通过内容,确保节点的有限计算资源尽可能服务于用户关注内容,无须校验网内命中内容,降低了校验开销.由于PCS-CP机制只有与特定缓存策略配合才能最大化效用,进而提出了一种基于缓存更新时间的网内缓存策略,对网内副本冗余进行优化控制,有效提升了PCS-CP机制的校验效果.数值结果表明,与命中校验机制相比,PCS-CP可有效降低网内校验次数,有效防御内容污染攻击.

This article proposed a checking mechanism, named as probabilistic checking before storing based on content popularity (PCS-CP). The design of PCS-CP includes two aspects, one is the node which should check the received content randomly according to its popularity, and the other is the node only stores the legitimate content. On the one hand, PCS-CP can ensure the limited computing resource of node to serve the high popularity content as much as possible. On the other hand, PCS-CP guarantees the authenticity of cached content, and then reduces the computation overhead of node. Because only cooperating with certain caching policy, PCS-CP can maximize its effectiveness. The in-network caching strategy based on cache update time (ICS-CUT) was further proposed to optimize the copy redundancy in network. It is shown that, comparing with checking on hit mechanism, PCS-CP can effectively reduce the average amount of checking in network and well defense the content pollution attack.

命名数据网络(NDN,named data networking)[1]是未来互联网架构的典型代表. NDN通过发布者对内容签名,用户(或节点)校验签名的方式保证内容完整性和安全性,提供一种基于内容本身的安全机制.理论上说,这种安全机制能有效保证网内数据安全,但实际部署中,由于节点计算资源有限,无法对所有接收内容进行签名验证,所以节点不强制内容签名的验证,因此无法保证网内缓存内容的安全性,导致内容污染成为NDN的严重安全隐患[2-4].因此如何有效进行内容校验、降低内容污染对NDN性能的影响,成为当前NDN研究的关键问题之一.

目前,对NDN内容校验机制的改进主要有2种方案:1) 概率校验[5],通过降低缓存概率来降低内容校验计算量.这一思路虽然可取,但Bianchi等[5]未作具体设计,未深入考虑概率存入的内容校验量与节点处理能力关系. 2) 命中校验(COH,check on hit)[6-7],内容存入缓存时不校验,仅当出现缓存命中事件时才对命中内容校验.该方案虽然降低了计算消耗,但是内容存入缓存时未经过校验,缓存中存在污染内容.

合理选择转发路由是抑制内容污染攻击的另一种思路,DiBenedetto等[8]提出通过检测可疑内容来源,尽量把兴趣包转发至真实内容来源.不过该方案仍需与有效的校验机制联合实施,才保证网内传输内容的安全性.

鉴于有效的内容校验是保证NDN可靠的关键所在,设计了一种基于流行度的概率存入校验机制(PCS-CP,probabilistic checking before storing based on content popularity),通过按流行度概率抽取内容校验并只存入校验通过内容,构建可信网络,在保障网络可靠性的同时,降低校验开销.考虑到PCS-CP机制只有与特定缓存策略配合,才能最大化工作效率,从控制网内副本冗余的角度[9],进而建议了一种基于缓存更新时间的网内缓存策略(ICS-CUT,in-network caching strategy based on cache update time),最大化NDN的网络存储效率,有效配合PCS-CP机制的工作.

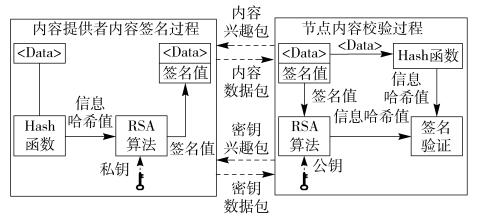

1 NDN内容签名与校验原理NDN中的内容签名与校验原理如图 1所示.内容提供者接收到请求兴趣包后,将对所请求内容以Hash函数计算出内容的哈希值,进而以RSA(Rivest-Shamir-Adleman)加密算法对生成的信息哈希值进行加密运算,计算出内容签名值,完成内容的签名过程.当带有签名的数据包返回到请求节点时,节点首先向内容提供者请求公钥,这里公钥获取过程也等同于一次内容请求,之后用RSA算法对数据包中的签名值进行解密,还原出信息哈希值,并与本地用哈希函数对数据包内容计算出的哈希值进行对比,完成签名验证过程.如果验证通过,则进一步执行缓存存入以及转发操作;如果验证失败,则直接丢弃数据包.

|

图 1 NDN内容签名与校验原理图 |

目前RSA算法是NDN中常用的内容签名与验证算法,这种非对称的加密算法对内容的保护能力依赖密钥长度,密钥越长则安全性越强,但带来的负面效应就是签名验证时需要消耗大量的计算资源.由于路由节点的计算资源有限,当接收数据流量较大时,节点无法完成所有接收数据包的校验,导致现有NDN签名校验机制形同虚设,因此对校验机制进行改善,设计一种可行的NDN校验机制迫在眉睫.

2 PCS-CP校验机制 2.1 条件设定后续机制描述以及理论分析将基于以下条件设定:1) 参考文献[10]的网络拓扑,笔者采用N层级联NDN网络;2) 节点的极限校验计算处理能力为CP(数据包/秒);3) 源服务器提供M个不同的内容,根据内容流行度均匀划分为K个不同类别,即每一类包含m=M/K个内容文件,每个内容的大小相同;4) 用户请求以泊松分布到达[10],λi为第i层节点的请求到达率,

结合Bianchi等[5, 7]所给出的现有校验机制,NDN校验问题中同样存在有效性与可靠性的矛盾,校验量与网络污染内容比例(校验结果)之间互相矛盾,而校验机制的设计目标正是致力于约束网络污染内容的同时,降低校验量.目前NDN节点校验开销过高,其根本原因为网内节点之间的不信任,从而导致节点之间出现重复校验,浪费了大量的计算资源.如果能构建一个可信NDN网络,并尽可能最大化网络的存储效率,必然可以显著提升校验机制的运行效果,这就是本研究设计出发点.所提出PCS-CP机制的具体设计如下:对于网内第i层节点,当接收到来自源服务器的数据包时,根据该内容所属流行度进行概率抽取校验,即对于接收到的来自源服务器的第k类内容,以概率Pverf(k, i)进行校验.

| $ {P_{{\rm{verf}}}}\left( {k,i} \right) = \frac{c}{{{k^\alpha }}} \times \min \left\{ {\frac{{{C_{\rm{p}}}}}{{\sum\limits_{k = 1}^K {\lambda _k^i\left[ {1 - P_{{\rm{PCS - CP}}}^i\left( k \right)} \right]} }},1} \right\} $ | (1) |

其中:Cp为节点的最大校验能力,

结合可信网络的设计,为了进一步降低节点校验压力,必须有效减少网内存储副本的冗余,尽可能扩大NDN的网内存储效率,提高网内命中率.因此,PCS-CP机制只有配合特定的网内缓存(Innetwork caching)策略,才能发挥应有的作用.从降低最小化网内副本冗余的角度出发,建议了ICS-CUT,该策略优点在于不仅可约束网内副本,同时平衡每个节点的数据包存入压力(数据包校验压力).

ICS-CUT策略要求网内每个节点定期统计自身的缓存更新时间,这里缓存更新时间定义为:内容在缓存队列中的平均驻留时间.以最近最少使用策略(LRU,least recently used)为例,该策略下的缓存更新时间即为某一内容从缓存队列首部移动到缓存队列尾部所需的平均时间.由Wang等[11]的分析可知:在实际网络中,节点到达的请求流量越多,需要存入缓存的数据也越多,导致缓存中的内容更替频繁,节点缓存更新时间变快.因此,缓存更新时间越长,代表该节点存入的数据流量压力越小.在此基础上,用户发出的请求兴趣包新增一个字段,用于记录经过节点的缓存更新时间.当出现不命中事件时,节点就在兴趣包的该字段中添加自身的缓存更新时间,再转发出去.基于传输路径上所有缓存更新时间的记录信息,若兴趣包在源服务器命中,回传的数据包将存入反向路径上具有最大缓存更新时间的节点;若兴趣包在网内某一节点命中,回传的数据包将移动至反向路径上具有最大缓存更新时间的节点(从命中节点删除).

ICS-CUT策略保证了任意内容,在网内只会存在一个副本,从而最大化了NDN的网络存储效率;此外,由于缓存更新时间代表了缓存的数据包存入压力,因此动态选择具有最大缓存更新时间的节点作为存入目标,有助于平衡回传路径上各个节点的存入数据量,便于充分利用每个节点的计算能力进行数据校验.

需要说明的是,设计的ICS-CUT策略,用于配合PCS-CP校验机制,提升校验工作的有效性.但是配合PCS-CP校验机制的缓存策略设计,不是唯一的,存在多种设计方案,只要能有效控制网内副本冗余、平衡缓存存入压力的缓存策略,都可以配合PCS-CP机制实施.

3 校验机制性能分析本节针对N层级联的NDN网络,选择网络真实内容命中率和网内平均校验次数作为校验机制性能评估指标,网络拓扑如图 2所示.为了对比说明PCS-CP机制的性能,选择基于LRU策略的COH机制作为对比策略,对2个校验机制同时给出理论分析结果,这里定义TPCS-CP为PCS-CP机制下网内平均校验次数,TCOH为COH机制下网内平均校验次数,

|

图 2 N层NDN级联拓扑图 |

由PCS-CP及ICS-CUT策略设计可见,该联合设计等效于概率缓存机制.考虑到当网络处于稳态时,由ICS-CUT策略,该级联路径上每个节点将近似等概被选择;进而选中节点按概率Pverf(k, i)选择第k类内容进行校验,并将校验结果为真的内容存入缓存.若设

| $ \beta _k^i \ge \frac{{{r_{\rm{T}}}{P_{{\rm{verf}}}}\left( {k,i} \right)}}{N} $ | (2) |

其中rT为源服务器真实内容比例.式(2) 表明,由于PCS-CP机制下,网内节点均可信,仅校验在源服务器命中的内容,因此源服务器的真实内容比例即为网内节点接收数据流中最小可能的真实内容比例(经过上游节点概率校验后,转发至下游节点的真实内容比例会提高),则存入概率至少为节点选择概率、校验概率、源服务器真实内容比例三者的乘积.

由文献[12]可知,对于概率缓存机制,以相继出现的2次请求为分析对象,命中事件的出现有2种可能:

1) 目标内容已存在于缓存中,第1次请求命中,2次请求的间隔小于缓存更新时间τi,则第2次请求命中;

2) 目标内容不存在于缓存中,第1次请求不命中,内容以概率

由于节点处于稳态时,相继出现请求的命中概率视为相同,均为

| $ \begin{array}{*{20}{c}} {P_{{\rm{PCS - CP}}}^i\left( k \right)P\left\{ {\tau _k^i \le {\tau _i}} \right\} + }\\ {\left( {1 - P_{{\rm{PCS - CP}}}^i\left( k \right)\beta _i^kP\left\{ {\tau _k^i \le {\tau _i}} \right\}} \right) = }\\ {P_{{\rm{PCS - CP}}}^i\left( k \right)} \end{array} $ | (3) |

这里,

| $ P_{{\rm{PCS - CP}}}^i\left( k \right) = \frac{{\beta _k^i\left( {1 - {e^{\frac{{\lambda _k^i}}{m}{\tau _i}}}} \right)}}{{1 + \left( {\beta _k^i-1} \right)\left( {1 - {e^{\frac{{\lambda _k^i}}{m}{\tau _i}}}} \right)}} $ | (4) |

PCS-CP机制下,网内命中内容均为真实内容,因此

| $ \begin{array}{*{20}{c}} {m\sigma \sum\limits_{k = 1}^K {\left[ {P\left\{ {\tau _k^i \le {\tau _i}} \right\}\left( {\beta _k^i - \beta _k^iP_{{\rm{PCS - CP}}}^i\left( k \right) + } \right.} \right.} }\\ {\left. {\left. {P_{{\rm{PCS - CP}}}^i\left( k \right)} \right)} \right] = C} \end{array} $ | (5) |

其中:m为每一类的文件个数,σ为每个文件的大小.式(5) 表明,在τi时间内,若插入缓存队列首部的所有类别内容数量总和,恰好等于缓存队列长度C,则原本处于缓存队列首部的内容将会移至队列尾部,因此τi即为任意内容在缓存中的平均驻留时间,即缓存更新时间.

3.1.2 COH真实内容命中率COH机制未对缓存策略做任何调整,接收到的内容直接存入缓存,仅在命中时加以校验,若选择LRU策略作为置换策略,由文献[7],第i层节点的第k类内容命中率应如式(6).

| $ P_{{\rm{COH}}}^i\left( k \right) = P\left\{ {\tau _k^i \le {\tau _i}} \right\} = \sum\limits_{i = k}^K {\left( {1 - {e^{\frac{{\lambda _k^i}}{m}{\tau _i}}}} \right)} $ | (6) |

由于COH校验机制下,网内节点缓存的内容不完全可靠,则真实命中率PiCOH-T(k)应近似等于实际内容命中率PiCOH(k)与源服务器真实内容比例rT的乘积.

| $ P_{{\rm{COH}}}^i\left( k \right) = P_{{\rm{COH}}}^i\left( k \right){r_{\rm{T}}} $ | (7) |

PCS-CP机制下网内节点存储内容均为可靠内容,网内命中无须校验,只有源服务器命中的内容需要校验,因此PCS-CP机制下第k类内容的网内总校验量仅取决于该类别内容的源服务器的内容命中率、单位时间内网络接收到的该类别内容到达请求次数,即边缘接入的请求到达率以及节点的校验概率.现定义Tpcs-cp(k)为PCS-CP机制下第k类内容的网内平均校验次数,则

| $ \begin{array}{*{20}{c}} {{T_{{\rm{PCS - CP}}}}\left( k \right) = }\\ {\lambda _k^1\left[ {1 - \sum\limits_{i = 1}^N {P_{{\rm{PCS - CP}}}^i\left( k \right)} } \right]\frac{1}{N}\sum\limits_{i = 1}^N {{P_{{\rm{verf}}}}\left( {k,i} \right)} } \end{array} $ | (8) |

其中:1-

显然,PCS-CP机制下所有类别的网内平均校验次数应为

| $ {T_{{\rm{PCS - CP}}}} = \sum\limits_{k = 1}^K {\left[ {\frac{c}{{{k^\alpha }}}{T_{{\rm{PCS - CP}}}}\left( k \right)} \right]} $ | (9) |

其中c为Zipf分布的约束参数,

对于COH校验机制,节点仅在命中事件发生时进行校验,全网校验次数即为各节点校验次数之和.对于第i层节点,其校验次数受路由自身的处理能力影响:当命中次数小于或等于处理能力时,命中内容将被全部校验;当命中次数大于处理能力时,节点尽力校验,校验量最大为处理能力CP.因此,COH机制下所有类别的网内平均校验次数TCOH应为

| $ {T_{{\rm{COH}}}} = \sum\limits_{i = 1}^N {\left\{ {\min \left[ {{C_{\rm{P}}},\sum\limits_{k = 1}^K {\lambda _k^iP_{{\rm{PCS - CP}}}^i\left( k \right)} } \right]} \right\}} $ | (10) |

其中

利用Matlab对PCS-CP与COH校验机制下的真实内容命中率和网内平均校验次数分别进行了数值计算与分析,数值计算结果根据式(4)、式(7)、式(9)、式(10) 得出,分析中设定源服务器存在一定比例的内容污染.

参考文献[10],分析参数设置如下:网络拓扑采用N=4层级联的结构,网络提供内容根据流行度分为K=40个类别,每一类包含m=200个内容文件,网络接入内容请求服从参数为λ1=105文件/s的泊松分布,选取Zipf分布参数值α=1.2,节点每秒处理能力CP=1.25×104个数据包(路由器条件[5]:Intel Core 2 Duo 2.53 GHz处理器,每个文件大小为1.5 KB、RSA加密算法).

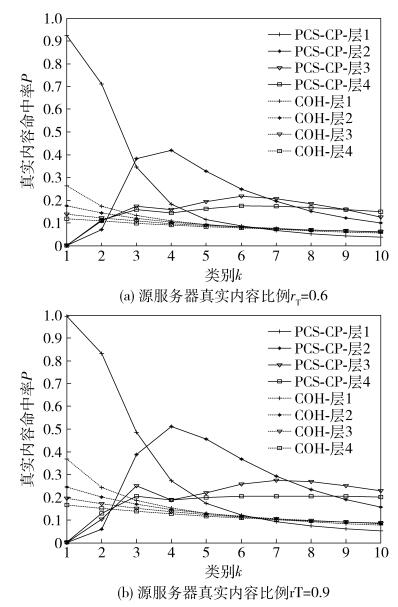

4.1 源服务器污染程度影响现分析2种校验机制在不同源服务器真实内容比例rT下的性能,计算中设定缓存大小与网络内容总量的比值(C/M)固定为0.1,真实内容比例rT改变,图 3、图 4分别给出了rT对节点真实内容命中率和平均校验次数的影响.

|

图 3 源污染对真实内容命中率的影响(C/M=0.1) |

|

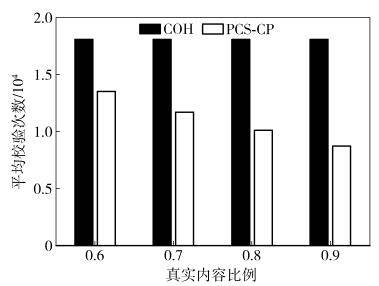

图 4 源污染平均校验次数的影响(C/M=0.1) |

如图 3所示,当源服务器真实内容比例rT从0.9降低至0.6,PCS-CP与COH机制下的命中率均有所下降,但PCS-CP机制的网内总体命中率较高. PCS-CP机制下,各层节点的真实内容命中率明显优于COH机制.即使源服务器存在40%的虚假内容,PCS-CP机制下第10类内容的4层真实内容命中率也分别为0.06、0.15、0.17、0.20,累计58%,而COH机制的第10类内容网内真实内容命中率不到40%. PCS-CP机制对内容污染的防御优势源自于可信网络的设计,由于网内节点全部无污染,网内命中内容均为真实;此外,通过采用基于流行度的概率校验与ICS-CUT缓存策略,网内不存在副本冗余且大概率存储高流行度内容,这些设计也保障了高流行度内容的网内缓存比例与命中率.而COH机制下节点缓存存在较严重内容污染,仅通过命中后再校验出虚假内容,对内容污染基本没有效防御.

图 4给出了源服务器污染下,PCS-CP机制与COH机制的校验负载.由图可见,当源服务器污染程度提升,COH机制平均校验次数基本不变,这是因为COH机制的校验次数仅取决于命中率(不是真实内容命中率),而命中率并不受虚假内容影响. PCS-CP的平均校验次数随着内容污染程度加深有所增加,但明显低于COH机制.这一结果也表明,相比较COH机制,PCS-CP机制有效控制了校验计算量,更易于实施,尤其在网络相对良好时,仅需要较小的校验计算开销就可以维持优质的网络内容安全状态.如rT=0.9时,PCS-CP机制的计算开销仅为COH机制的一半,但是命中率超过COH机制的一倍.

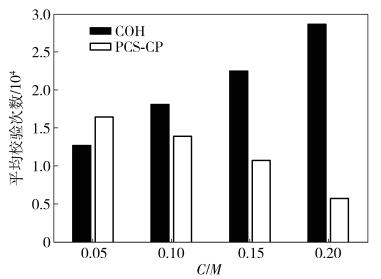

4.2 C/M的影响C/M本质上指向缓存大小,若固定网络内容总量不变,则C/M增大(减小)代表缓存容量增大(减小),而由于缓存容量直接影响节点命中率,因此对校验计算量及校验效果产生重要影响.计算中固定源服务器真实内容比例rT为0.7. 图 5给出了缓存大小变化对命中率的影响,如图计算结果,当C/M从0.15降至0.05,2种校验机制下真实内容的命中率均明显下降,这是由于缓存空间减小,NDN网内可存储副本降低.但PCS-CP机制相比较COH机制依然维持明显优势. 图 6给出了缓存大小变化对校验负载的影响,随着C/M从0.05增至0.2,COH机制由于网内命中率提高,其校验计算开销越来越大;而PCS-CP机制由于网内可容纳的副本越来越多,源服务器命中率降低,需要校验的内容越来越少,平均校验次数变得更低,这一趋势也充分说明了PCS-CP机制对校验开销的有效控制.

|

图 5 缓存大小对真实内容命中率的影响(rT=0.7) |

|

图 6 缓存大小对平均校验次数的影响(rT=0.7) |

如何设计有效的校验机制,解决计算开销问题,降低内容污染对NDN网络性能影响,保证网络内容的完整性与安全性,已经成为当前NDN研究的重点.未来的研究中,将进一步探讨如何改进校验算法,从算法设计本身去提高内容校验的可行性,同时关注如何改进NDN节点间的信任关系,设计更为健壮的可信网络,从信任角度抑制内容污染的影响.

| [1] | Jacobson V, Smetters D K, Thornton J D, et al. Networking named content[C]//ACM Conference on Emerging Networking Experiments and Technology, CONEXT 2009. Rome:ACM, 2012:117-124. |

| [2] | Lauinger T. Security & scalability of content-centric networking[D]. Darmstadt:TU Darmstadt, 2010. |

| [3] | Ribeiro I, Rocha A, Albuquerque C, et al. On the possibility of mitigating content pollution in content-centric networking[C]//2014 IEEE 39th Conference on Local Computer Networks. Edmonton:IEEE, 2014:498-501. |

| [4] | Gasti P, Tsudik G, Uzun E, et al. DoS and DDoS in named data networking[C]//201322nd International Conference on Computer Communication and Networks (ICCCN). Nassau:IEEE, 2013:1-7. |

| [5] | Bianchi G, Detti A, Caponi A, et al. Check before storing:what is the performance price of content integrity verification in LRU caching[J]. ACM SIGCOMM Computer Communication Review, 2013, 43(3): 59–67. doi: 10.1145/2500098 |

| [6] | Nam S W, Kim D, Yeom I. Content verification in named data networking[C]//2015International Conference on Information Networking. Cambodia:IEEE, 2015:414-415. |

| [7] | Kim D, Nam S, Bi J, et al. Efficient content verification in named data networking[C]//Proceedings of the 2nd ACM Conference on Information-Centric Networking. New York:ACM, 2015:109-116. |

| [8] | DiBenedetto S, Papadopoulos C. Mitigating poisoned content with forwarding strategy[C]//Computer Communications Workshops (INFOCOM WKSHPS). San Francisco:IEEE, 2016:164-169. |

| [9] | Li Yun, Zhao Ling, Liu Zhanjun, et al. N-Drop:congestion control strategy under epidemic routing in DTN[C]//International Conference on Wireless Communications and Mobile Computing:Connecting the World Wirelessly. Leipzig:ACM, 2009:457-460. |

| [10] | Wang Guoqing, Huang Tao, Liu Jiang, et al. Modeling in-network caching and bandwidth sharing performance in information-centric networking[J]. The Journal of China Universities of Posts and Telecommunications, 2013, 20(2): 99–105. doi: 10.1016/S1005-8885(13)60035-7 |

| [11] | 崔现东, 刘江, 黄韬, 等. 基于节点介数和替换率的内容中心网络网内缓存策略[J]. 电子与信息学报, 2014, 36(1): 1–7. |

| [12] | Zhu Yi, Mi Zhengkun, Wang Wennai. A probability caching decision policy with evicted copy up in content centric networking[J]. Journal of Internet Technology, 2017, 18(1): 33–43. |