2. 福建星网锐捷通讯股份有限公司 通讯产品研究院, 福州 350002 ;

3. 北京邮电大学 多媒体中心, 北京 100876

针对视频中的视觉感知冗余,提出一种面向视频编码的基于结构分析的感知信号处理模型——结构显著性最小可觉察失真模型.先分策略获取视频帧的有序/无序结构分量和纹理分量进行最小可觉察失真(JND)建模;使用无序结构分量的结构不确定性调节视频帧的显著性区域和JND的对比度掩蔽效应;最后,基于该模型的感知滤波模块被嵌入HEVC中.实验结果表明,在主观视觉感知没有明显损失的情况下,所提出方法的平均码率比HEVC的编码软件HM16.0减少了10.3%.

2. Fujian STAR-NET Communications Company, Ltd, Fuzhou 350007, China ;

3. Multimedia Center, Beijing University of Posts and Telecommunication, Beijing 100876, China

In order to remove the visual perceptual redundancy, a new perceptual video signal processing model based on structure analysis combined with saliency just noticeable distortion (SSJ) was proposed. First, the order structure component, disorderly structure component and texture component can be estimated by some method, which are used to just noticeable distortion (JND) model. Then the disorderly structure uncertainty of disorderly structure component is available to adjust saliency regions of frames and contrast masking. Finally, The SSJ model is incorporated into HEVC software HM 16.0 via the adaptive perception signal process. Experiments show that 10.3% bitrate reduction is achieved in the proposed system compared with HM 16.0 without jeopardizing the perceptual quality.

混合视频编码技术(H.264/AVC、H.265/HEVC、AVS)主要针对空间冗余、时间冗余以及统计冗余进行信息压缩,主要通过大幅增加计算复杂度来提高其压缩性能,并没有深入研究人类视觉系统(HVS,human visual system)对视频信号的理解机理,因此不可能充分地压缩视觉冗余. 若能将HVS的特性充分融入现有的视频编码框架中,压缩性能可以进一步提高. 因此,结合最小可觉察失真模型(JND,just noticeable distortion)和视觉显著性模型的感知视频压缩方法也成为当前视频编码领域的研究热点.

JND模型揭示了人眼对图像中像素值改变的容忍度. JND阈值越小,图像失真越容易被人眼所觉察. 因此,在视频编码过程中若将容易察觉出数据失真的区域分配更多的比特,对人眼不易察觉失真的区域分配更少的比特,那么在保持视频主观质量基本不变的情况下可以极大地降低码率. Yang等[1]提出了将亮度掩蔽和纹理融合在一起用于信号处理和运动估计等内容的JND模型. Zheng等[2]提出分割图像得到更精确的纹理块、边界和平坦块来建模离散余弦变换(DCT,discrete cosine transform)域JND模型. 上述JND模型依然未能完全挖掘人眼的视觉冗余. 显著性模型广泛用于甄选视觉场景中的相关内容作为人眼视觉注意力区域. Fang等[3]提出一种时空域结合的显著性检测方法,并围绕压缩域提出了新的计算模型. Wang等[4]提出了像素域JND和视觉注意模型进行简单的结合来压缩码率,但没有考虑视频的时域信息以及帧内结构信息. HVS能够自适应提取场景中的主要结构信息[5]. 结构信息分为有序结构和无序结构,人类视觉对有序结构更敏感,对无序结构敏感程度较低. 这一视觉特性可以用于JND和显著性建模.

基于上述的分析,提出一种基于结构分析的感知视频信号压缩算法. 该算法提取视频帧的结构信息构造具有显著性和JND特性的感知视频信号处理模型(SSJ,structure saliency JND). SSJ模型将人眼不敏感的无序结构用于对比度掩蔽效应的估计. 同时,本算法利用无序结构中的结构不确定性来矫正显著性区域. 建模后的SSJ模型应用在视频残差信号处理,验证其在视频压缩中的有效性.

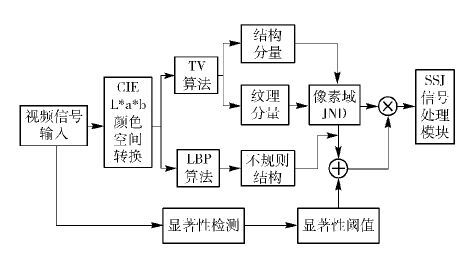

1 提出的SSJ模型基于文献[4],提出的SSJ模型实现框图如图 1所示. 输入的YUV视频信号通过局部二值模式(LBP,local binary patterns)算法[5]和整体变分(TV,total variation)算法[6]计算得到不规则结构因子、结构分量和纹理分量并建模像素域JND模型. 采用时空域的显著性算法检测视频的显著性,并利用无序结构分量调节显著性,最后融合JND模型(利用式(1))可得SSJ阈值.

|

图 1 SSJ模型实现框图 |

为了更好地描述HVS可见的所有颜色,使用CIE L*a*b*颜色空间. 估计像素域的JND阈值时,起主导作用的是对比度掩蔽效应因子. 因此,提出的SSJ模型在对比度掩蔽效应中加入结构不确定性用于提高JND估计的精确度. 另一方面,用显著性检测得到HVS的感兴趣区域,对不感兴趣的区域适当增加JND阈值,从而能够引导JND阈值的分配. 图 2中,越亮的区域为结构不确定性,而暗的区域为结构确定性区域. 图 2(a)的背景树叶是属于结构不确定性的,但是在图 3(b)中树叶部分亮度较高属于强显著性. 图 2(b)和图 3(d)在树叶和人头发等区域存在显著性和结构不确定性重叠的问题. 考虑到人类视觉对场景中的无序结构不敏感[3],使用无序结构状态调节显著性区域. 基于上述分析,提出SSJ模型如式(1)所示. 对亮度、色度分量进行SSJ建模.

| $\begin{align} & \Upsilon \left( x,y,p \right)={{J}^{t}}\left( x,y,p \right) \\ & (\alpha -{{S}^{st}}\left( x,y,p \right)+e{{T}_{su}}\left( x,y,p \right)) \\ \end{align}$ | (1) |

其中:(x,y)为像素坐标,p为视频帧序号. Sst(x,y,p)为显著性阈值(s和t分别表示空域和时域,见式(8));Tsu(x,y,p)为无序结构分量(包含结构不确定性因子,见式(3));α和e分别设置为1.62和0.2;Jt为JND值(见式(5)).

2 面向视频的像素域JND建模像素域的JND模型主要由亮度自适应因子和对比度掩蔽效应组成,公式为

| $\begin{align} & {{J}_{V}}\left( x,y \right)={{T}^{l}}\left( x,y \right)+{{T}^{t}}\left( x,y \right)- \\ & {{E}_{v}}min\text{ }\{{{T}^{l}}\left( x,y \right),{{T}^{t}}\left( x,y \right)\} \\ \end{align}$ | (2) |

其中:参数Tl(x,y)和Tt(x,y)分别代表背景亮度和对比度掩蔽效应[1]. 在V颜色通道下,Ev=0.3表示重叠效应.

如图 1所示,首先使用LBP算法和TV-L1算法[6]对输入的视频帧进行建模. 通过LBP值来衡量结构信息,对于一个像素值x,通过在x周围映射LBP值可以获得2C-1位的直方图[5]. 结构信息可通过香农熵定义[5]得到

| ${{T}_{su}}\left( x,y \right)=\underset{c=1}{\overset{{{2}^{c}}}{\mathop{\sum }}}\,-{{p}_{c}}(x)lb{{p}_{c}}(x)~$ | (3) |

其中:pc(x)为像素x的局部区域以c位表示的概率. 视频帧的有序结构和纹理由TV-L1算法得到,而结构不确定性用式(3)计算,无序结构分量效果如图 2所示. 改进的对比度掩蔽效应公式为

| ${{T}^{t}}\left( x,y \right)={{w}_{e}}{{M}^{s}}\left( x,y \right)b+{{w}_{t}}{{M}^{t}}\left( x,y \right)b+{{M}_{su}}\left( x,y \right)a$ | (4) |

其中:Ms(x,y)、Mt(x,y)和Tsu(x,y)分别为有序结构掩蔽、纹理掩蔽[6]和结构不确定性;we、wt、b和a在实验中分别设置为1、3、0.117和0.5. 视频场景下的JND建模还需要考虑时域效应[1]. 综合上述因素,最后可得

| ${{J}^{t}}\left( x,y,t \right)={{F}^{t}}\left( x,y,t \right){{({{J}_{V}}\left( x,y,t \right))}^{s}}~$ | (5) |

其中:s表示空域,Ft(x,y,t)表示t帧和t-1帧之间的平均亮度差异,JV(x,y,t)可由式(2)得到.

|

图 2 亮区域代表高不确定性 |

空域显著性检测考虑4个特征:亮度Y、2个色度c1和c2、纹理w. 每个图像块使用r个特征对比度的方法[3]计算空域显著性为

| ${{S}^{(s)}}=\underset{r\in [Y,c1,c2,w]}{\mathop{\sum }}\,N({{S}^{(r)}}){{r}^{-1}}$ | (6) |

其中:N为归一化[0, 1]函数,S(r)为特征对比度. 视频中物体运动的剧烈程度与人类视觉注意力高度相关. 这里采用基于运动速度v的感知先验概率p(v)来衡量运动视觉注意力[3],公式为

| ${{S}^{(t)}}=-lbp(v)=\text{ }albv+b$ | (7) |

其中a和b为常量.

结合以上因素,时空域显著性公式如式(8)所示,p(s)和p(t)分别为空域/时域不确定性因子[3],检测效果如图 3所示.

| ${{S}^{st}}=\frac{{{p}^{(t)}}{{S}^{(s)}}+{{p}^{(s)}}{{S}^{(t)}}}{{{p}^{(t)}}+{{p}^{(s)}}}$ | (8) |

|

图 3 时空域显著检测效果图 |

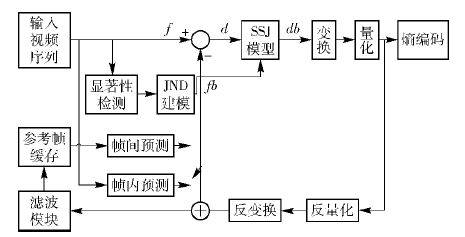

嵌入了SSJ模型的HEVC[7]视频编码框架如图 4所示,图 4中黑色粗体部分描述了提出的基于SSJ的感知滤波处理流程. 视频帧进行显著性检测和JND建模后再导入到SSJ自适应感知滤波模块. 该模块主要处理视频残差数据,并获得优化后的残差滤波结果. 式(9)中f、fb、db和d分别表示原视频序列帧、帧内预测后的视频帧、滤波处理的残差数据和还没滤波处理的数据,γ(x,y)通过式(1)获得.

|

图 4 基于SSJ模型的视频框架 |

| $\eqalign{ & R\left( {x,y} \right) = \cr & \left\{ \matrix{ r\left| {D\left( {x,y} \right) - r} \right|{\rm{ < }}\Upsilon \left( {x,y} \right) \hfill \cr D\left( {x,y} \right) + \Upsilon \left( {x,y} \right)D\left( {x,y} \right) - r{\rm{ < }} - \left( {\Upsilon \left( {x,y} \right)} \right) \hfill \cr D\left( {x,y} \right) - \Upsilon \left( {x,y} \right)D\left( {x,y} \right) - r > \Upsilon \left( {x,y} \right) \hfill \cr} \right. \cr} $ | (9) |

其中:参数r表示平均残差值,D(x,y)表示视频残差数据.

5 实验结果和讨论 5.1 空域JND模型的主观与客观评价为了评估提出的空域JND模型,将JND值作为噪声加入到原始图像中,Jo(x,y)表示加入了噪声的像素值.

| ${{J}_{o}}\left( x,y \right)=f\left( x,y \right)+rand{{J}_{V}}\left( x,y \right)$ | (10) |

其中:f(x,y)为原图,JV(x,y)见式(2),rand随机取±1.

表 1描述了提出的空域JND模型和文献[6]的模型的图像主客观测试结果. 分数为正说明前者比后者的好,接近0说明主观质量相似. 提出的算法结果平均峰值信噪比(PSNR,peak signal to noise ratio)值比文献[6]低了0.951 dB,也说明提出的模型能容忍更多的噪声.

|

|

表 1 PSNR和MOS对比 |

下面评估嵌入SSJ模型后的HEVC视频编码框架系统性能. 主观测试采用双刺激连续质量标度(DSCQS,double stimulus continuous quality scale)[8]方法,并使用差异平均主观评分值(DMOS,different mean objective score):将2个视频序列分别经过HM16.0解码和添加提出的算法解码进行对比. 演示的4个标准视频序列的分辨率包括832×480、2 560×1 600、1 920×1 080、1 280×720,编码60帧,配置文件为Encoderintramain.cfg.

如表 2所示,SSJ模型比HM16.0参考软件码率平均节省10.3%. 与Wang等[4]提出的感知模型相比,提出的模型平均节省了2%的码率. 主要原因在于SSJ模型不仅考虑空域信息还加入时域信息,更去除了视觉冗余.

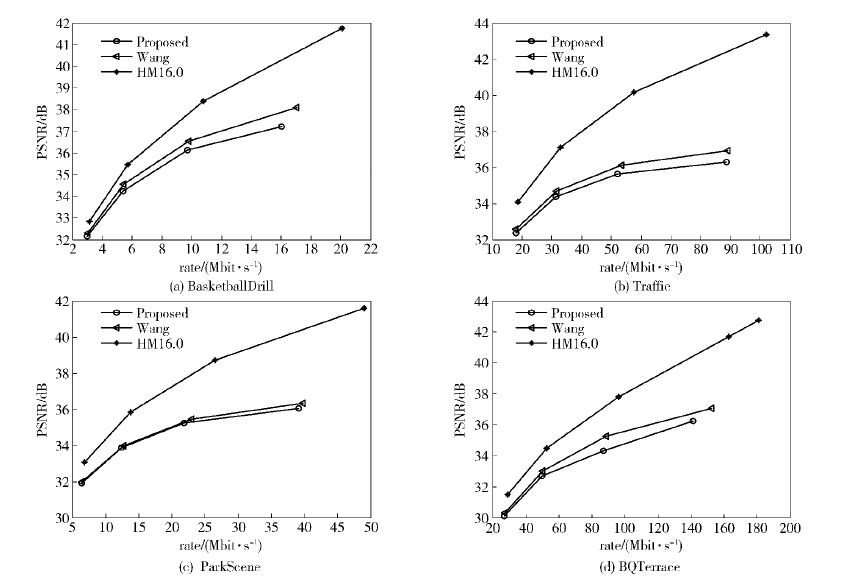

表 3显示了测试的PSNR与DMOS结果. 提出模型的码率与文献[4]比较,在平均DMOS分数差异较小的情况下,由表 2、表 3中的平均DMOS和平均码率可以看出,平均码率减少2%,这说明提出的模型在主观差异小的情况下,压缩比提高了. 结合表 2、表 3可以发现,提出的模型比文献[5]的方法平均下降了0.396 6 dB,差异很小. 同时,从图 5的率失真(RD,rate distortion)曲线图也可以看出,提出的算法拥有更低的PSNR,即能容忍数据失真而感知视觉质量没有明显的下降. 其中,红色、绿色和蓝色线分别代表提出的算法、文献[4]和HM16.0. 图 6(b)为量化参数QP为37的解码效果图,中间红色部分是JND损失区域,可以看出,损失区域主要在树木、远景(结构不确定性或不显著区域). 表 4采用序列每帧的平均编码时间来评估提出模型的编码算法复杂度. 与HM16.0相比,编码时间平均增加4.223 s,与文献[4]时间消耗差不多,增加的计算时间主要消耗在SSJ建模上.

|

|

表 2 视频的码率对比 |

|

图 5 视频的RD曲线对比 |

|

图 6 视频解码质量对比 |

|

|

表 3 模型的PSNR对比和DMOS对比 |

|

|

表 4 HM16.0、文献[4]和本文编码算法复杂度对比 |

提出了一种改进的感知压缩算法. 该算法利用视频帧的结构信息,使用分解算法得到多种特征信息,进行JND建模;同时改善视频的显著性区域提取. 最后融合生成SSJ模型嵌入到视频编码框架中进行残差信号处理. 从实验结果可以得出,主观感知没有明显损失的情况下,该模型与现有模型对比有更好的压缩性能.

| [1] | Yang X K, Lin W S, Lu Z, et al. Just noticeable distortion model and its applications in video coding[J]. Signal Processing: Image Communication , 2005, 20 (7) :662–680. doi:10.1016/j.image.2005.04.001 |

| [2] | Zheng Mingkui, Su Kaixiong, Wang Weixing, et al. Enhanced subband jnd model with textural image[C]//Signal Processing, Communication and Computing (ICSPCC), 2013 IEEE International Conference on, Kunming. IEEE, 2013: 1-4. |

| [3] | Fang Yuming, Wang Zhou, Lin Weisi, et al. Video saliency incorporating spatio temporal cues and uncertainty weighting[J]. IEEE Transactions on Image Processing , 2014, 23 (9) :3910–3921. doi:10.1109/TIP.2014.2336549 |

| [4] | Wang Huiqi, Wang Lin, Hu Xuelin, et al. Perceptual video coding based on saliency and just noticeable distortion for H.265/HEVC[C]//WPMC 2014. Sydney, Australia: IEEE, 2014: 106-111. |

| [5] | Wu Jinjian, Lin Weisi. Pattern masking estimation in image with structural uncertainty[J]. IEEE Transactions on Image Processing , 2013, 22 (12) :4892–4904. doi:10.1109/TIP.2013.2279934 |

| [6] | Liu A M, Lin W S, Paul M, et al. Just noticeable difference for images with decomposition model for separating edge and textured regions[J]. Circuits and Systems for Video Technology, IEEE Transactions on , 2010, 20 (11) :1648–1652. doi:10.1109/TCSVT.2010.2087432 |

| [7] | Sullivan G J, Ohm J, Han W J, et al. Overview of the high efficiency video coding (HEVC) standard[J]. Circuits and Systems for Video Technology, IEEE Transactions on , 2012, 22 (12) :1649–1668. doi:10.1109/TCSVT.2012.2221191 |

| [8] | Recommendation I. 500-11, methodology for the subjective assessment of the quality of television pictures[J]. Geneva, Switzerland: International Telecommunication Union , 2002 :32–33. |