提出了一种无缓存光分组交换机搭建的平坦型数据中心网络架构--架顶平坦互联,并在OMNeT++仿真平台上对架顶平坦互联架构进行仿真实验,得到架顶平坦互联架构在不同业务分布、不同业务模式和不同缓存容量条件下的系统平均时延、分组丢失率和吞吐率的仿真结果.结果表明,基于端口无缓存光交换机的架顶平坦互联架构数据中心网络具有良好的时延特性、网络吞吐率、可扩展性和成本效益.

The performance of a new flat data center network(DCN) architecture top of rack(ToR) connected flatten(TCF) was investigated based on distributed buffer-less optical switches and fast flow control. Scalability of DCN is assessed by numerical simulation with objective modular network testbed in C++(OMNeT++) discrete event simulator, while the average latency, packet loss and throughput of the system are obtained under different traffic patterns, different traffic distributions and various buffer sizes. It demonstrates that TCF based on distributed buffer-less optical switches not only has good latency characteristic and system throughput, but also has fine scalability and cost efficiency.

受云计算和数据丰富型应用程序的驱动,全球数据中心流量预计在2012-2017年期间增加3倍[1].数据中心流量的迅速增加需要数据中心互连架构和技术的改变以适应通信节点数目的增加和数据链路速率的提高导致所需带宽的增加.

建造一个支撑扩展服务器数量(>10 000)和高数据链路速率(>10 Gbit/s)的数据中心需要端口数目巨大的电交换机来避免层级结构导致的带宽瓶颈、大的端到端时延和高的成本.光交换技术能透明交换高速率数据信号,减少所需要的交换机端口数,且可避免多级交换中使用的昂贵光/电/光转换收发器.现有光互联架构可分为如下4大类:1)混合光/电架构[2];2)采用无源光器件的互联方案[3];3)基于光分组交换机(OPS,optical packet switch)的互联架构[4];4)采用OPS和光电路交换机(OCS,optical circuit switch)的互联架构[5].然而,现有重新配置时间在亚微秒,允许低时延交换的光交换机只有有限的端口数.光缓存器的缺乏阻碍了多级高端口数目光交换机的发展,限制了高速光交换技术在数据中心网络的应用.

笔者提出了一种平坦型数据中心网络架构--架顶平坦互联(TCF,top of rack connected flatten).采用OMNeT++(objective modular network testbed in C++)仿真平台建立了包括地址解析和基本路由算法的TCF仿真模型,给出了仿真结果和分析.

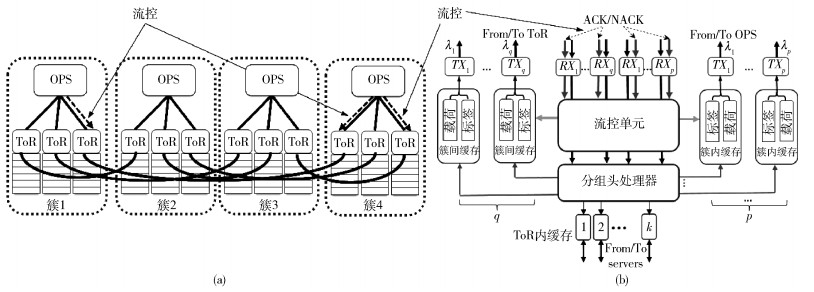

1 系统运行TCF架构包含N+1个簇,每个簇包含N个机架顶(ToR,top of rack)交换机(N为光交换机端口数),每个ToR交换机互连40个服务器,且有2条光链路,一条链路聚合p个收发器连接簇内光交换机,另一条聚合q个收发器连接簇间ToR交换机.第n个簇的第m个ToR交换机(ToR[n, m])连接第m+1个簇的第n个ToR交换机(ToR[m+1, n]). 图 1(a)给出了N=3时的TCF架构互联实例,ToR交换机机理图如图 1(b)所示.记src和dest分别为源端和目的端服务器编号,则TCF网络架构地址解析和路由算法如下.

|

图 1 TCF数据中心架构和带有快速流控制ToR机理图 |

Address(src, dest):

n1=src/N m1=src%N

n2=dest/N m2=dest%N

ToR[n1, m1] to ToR[n2, m2]

TCF Routing(ToR[n1, m1], ToR[n2, m2]):

if(n1==n2)

ToR[n1, m1]→OPS[n1]→ToR[n2, m2]

else if(n2==m1+1&&m2==n1)

ToR[n1, m1]→ToR[n2, m2]

else if(n2==m1+1)

ToR[n1, m1]→ToR[n2, n1]→OPS[n2]→

ToR[n2, m2]

else if(m2==n1)

ToR[n1, m1]→OPS[n1]→ToR[m2, n2-1]→

ToR[n2, m2]

else

ToR[n1, m1]→OPS[n1]→ToR[n1, n2-1]→

ToR[n2, n1]→OPS[n2]→ToR[n2, m2]

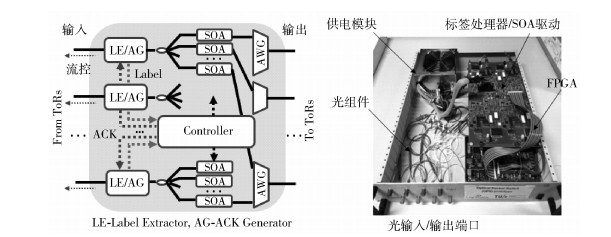

当分组到达ToR交换机时,头处理器检查其目的地址.如果分组去往簇内或簇间服务器,此分组将被送往相应的光交换机或ToR交换机.分组带有决定ToR交换机目的地址的光学标签,传输前在ToR交换机缓存保留1份副本以防由于光交换机竞争而引起的重传.光交换机结构图和实物图如图 2所示,Miao等[6]详尽讨论了光分组交换机运行和光分组交换机端口数目扩展性.

|

图 2 OPS原理和实物图 |

与其他采用OCS、无源器件和混合光电技术的架构不同,TCF仅采用OPS实现架构互联,2个OPS之间存在1个ToR来完成分组的存储,避免了分组竞争失败后需要从源端进行重新传输.与其他基于OPS的架构相比,TCF具有如下特点. 1)互连的ToR以N×(N+1)的速率扩展. 2)光交换机数据速率和格式透明性允许在不改变结构和增加交换机端口数的前提下提高链路的数据速率. 3)光交换机亚微秒重新配置时间可交换采用统计多路复用的长业务流和短业务流. 4)光交换机的分布式互连允许ToR交换机使用电缓存器和光流量控制以有效解决分组竞争. 5)多种连接路径能提高数据中心网络的适应能力.

2 仿真实验仿真中选择了OMNeT++对TCF架构数据中心网络特性进行了具体的研究.采用基于12×12端口无缓存光交换机互连的TCF架构数据中心网络,此网络含有156个ToR交换机,每个ToR交换机连接40个服务器,从而此网络含有6 240个服务器.分组的长度设置为1 000 B,光分组交换机的链路速率设置为200 Gbit/s(5×40 Gbit/s波分复用信道).往返时间为560 ns,包括处理标签的时延、控制交换机(60 ns)和通过光链路(2×50=100 m)的时延(500 ns).

系统同步运行,仿真时间设置为1×108个时隙.在每个时隙,服务器根据固定负载的二项分布产生一个分组,每个服务器产生分组的概率是确定的.所有的服务器独立运行,且负载相同.考虑到大部分业务在ToR内和簇内进行交换,研究了3种业务取不同比例的2种情形,如表 1所示.经过大量仿真,200 Gbit/s光链路端口的缓存容量选取为40 KB和60 KB,连接服务器电端口的缓存容量设置为10 KB.

|

|

表 1 业务模式和业务分布 |

下面给出了TCF架构数据中心网络平均时延、分组丢失率和吞吐率的仿真结果,并对此仿真结果进行了讨论.

图 3描述了系统的平均时延随负载增加的变化情况.对于业务分布A,负载为0.3时端到端平均时延小于10 μs,负载大于0.3时分组的平均时延急剧增加,在负载较大时系统饱和.对于业务分布B,负载为0.3时端到端平均时延为6 μs,负载大于0.38时分组的平均时延急剧增加,在负载较大时系统饱和.在负载较大时,缓存容量对系统平均时延的影响效果明显.当负载接近于1时,业务分布B的平均时延增长迅速,超过业务分布A的平均时延.原因是业务分布A的分组丢失率比业务分布B的要高,因而业务分布B有更多的分组经过簇间,这将贡献更大的时延.

|

图 3 端到端平均时延随负载变化 |

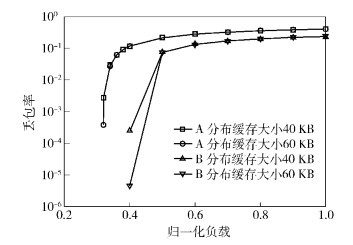

图 4描述了系统的分组丢失率随负载增加的变化情况,与平均时延的变化情况相一致,系统的分组丢失随着负载的增加而增大.对于业务分布A,负载为0.3时,系统的分组丢失小于10-6.对于业务分布B,缓存容量对分组丢失的影响效果明显,缓存容量为60 KB,负载为0.4时,系统的分组丢失小于10-5.

|

图 4 分组丢失率随负载变化 |

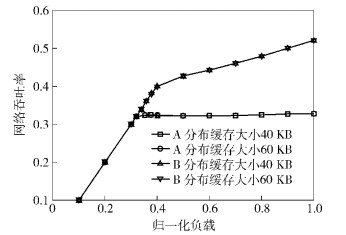

图 5描述了系统的归一化吞吐率随负载增加的变化情况,与图 3和图 4的结果一致,系统的吞吐率随着负载的增加而下降,由于业务分布A有接近一半的簇间业务,导致网络内链路超负载,从而在负载为0.4时系统吞吐率饱和;而业务分布为B时,系统可容忍更高的负载,当负载超过0.4时,网络吐吞率依旧随着负载缓慢增加.

|

图 5 归一化网络吞吐率随负载变化 |

Benson等[7]研究发现,在95%的时间内,数据中心的业务负载不超过归一化负载0.1;且在99%的时间里,业务负载不超过0.3.因此,与数据中广泛采用的电交换架构Fattree相比,TCF的低时延和丢包率可有效地满足当前数据中心要求,TCF通过提高光链路传输速率可很好地支持数据中心规模的扩展.由于TCF仅采用OPS,如图 3所示,其时延仅为数十μs,相比其他架构的时延低.且在付出增加2倍接收器的代价时,TCF架构可在负载为0.8时获得 < 10-5的丢包率性能.

4 成本及功耗在对数据中心架构的成本和功耗分析中,仅考虑用来进行网络互连组件的成本和功耗. Fattree是当前数据中心最常见的架构,因此将其TCF功耗、成本和Fattree作对比.

表 2列出了分析中所用网络组件的成本和功耗,服务器和ToR之间的链路长度为5 m电缆,ToR和光分组交换机之间用30 m的光纤互连.

|

|

表 2 数据中心网络组件功耗和成本 |

基于磷化铟(InP,indium phosphide)的光分组交换机的成本由器件和电路光电集成欧洲联合平台(JePPIX,joint european platform for inp-based photonic integrated components and circuits)路线图给出[8],预测InP芯片随着产量从1万个增加到10万个,相应的成本从100美元/mm2下降到10美元/mm2.据估计8×8的光分组交换机和16×16的光分组交换机芯片面积分别为50 mm2和200 mm2.而32×32的光分组交换机需要800 mm2.因此,保守估计8×8、16×16和32×32光分组交换机的成本分别为5 000美元、2万美元和8万美元.在计算8×8光分组交换机的功率时,考虑了所有的分立器件,包括现场可编程门阵列(FPGA,field-programmable gate array)板(25 W)、半导体放大器(SOA,semiconductor optical amplifier)驱动板(64 W)、标签生成器(64 W)和在ToR交换机运行的激光器驱动(48 W).这些数值均是保守的估计,集成InP光分组交换机的功耗将会更低. 16×16和32×32光分组交换机的功耗采用同样的方法计算得到.基为其他数值的通过线性插值得到,如表 2所示.

Fattree通过使用5k2/4个k端口的交换机可互连k3/4个服务器,其链路数目和交换端口数分别为3k3/4和5k3/4,因此Fattree的功耗为

| $ {P_{{\rm{Fattree}}}} = 5{k^3}{P_{{\rm{Switchport}}}}/4 + {k^3}{P_{{\rm{Transceiver}}}} $ | (1) |

其中:PSwitchport为电交换端口的功耗,PTransceiver为收发器的功耗.

Fattree网络的成本CFattree为

| $ \begin{array}{l} {C_{{\rm{Fattree}}}} = 5{k^2}{C_{{\rm{Switchport}}}}/4 + {k^2}{C_{{\rm{Transceiver}}}} + {k^3}{C_{{\rm{elink}}}}/4 + \\ \;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;{k^3}{C_{{\rm{olink}}}}/2 \end{array} $ | (2) |

TCF架构中ToR交换机的基为65,其中40连接到服务器,5个聚为50 Gbit/s连接其他ToR,20个聚为4×50 Gbit/s连接到光分组交换机,对于基为K的光分组交换机,与Fattree相似,TCF的功耗为

| $ \begin{array}{l} {P_{{\rm{TCF}}}} = 65\left( {{K^2} + K} \right){P_{{\rm{Switchport}}}} + \left( {K + 1} \right){{\tilde P}_{{\rm{OPS}}}} + \\ \;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;5\left( {{K^2} + K} \right){P_{{\rm{OEO}}}} \end{array} $ | (3) |

其中:

| $ \begin{array}{l} {C_{{\rm{TCF}}}} = \left( {{K^2} + K} \right){C_{{\rm{Switch}}}} + \left( {K + 1} \right){{\tilde C}_{{\rm{OPS}}}} + 5\left( {{K^2} + K} \right){{\tilde C}_{{\rm{OEO}}}} + \\ \;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;\;2\left( {{K^2} + K} \right){C_{{\rm{elink}}}} + 40\left( {{K^2} + K} \right){C_{{\rm{olink}}}} \end{array} $ | (4) |

其中:

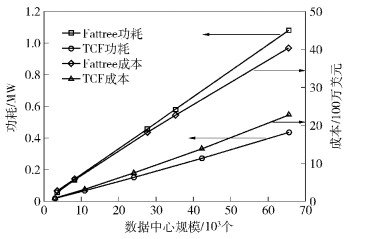

如图 6所示,Fattree的功耗比TCF的大,且当数据中心网络规模增大时,与TCF相比,Fattree的功耗增加速度更快.在数据中心网络互连60 000服务器时,TCF比Fattree的功耗改善60%. 2个数据中心架构的成本增加趋势与功耗一致.对于10 000和60 000服务器规模的数据中心,TCF成本比Fattree分别少65%和47%.

|

图 6 数据中心规模扩展功耗和成本对比 |

基于分布式无缓存光分组交换机,提出了一种新型平坦数据中心网络架构TCF,并在OMNeT++仿真平台上进行仿真实验评估了此系统的性能.仿真结果显示,对于包含6 000多个服务器的TCF架构数据中心网络,在负载为0.3时,允许端到端平均时延为10 μs,分组丢失率小于10-6.结果表明,采用TCF架构可硬件实现的光交换机能建立可扩展的数据中心网络,且分析显示,TCF架构的成本和功耗均优于Fattree.

| [1] | Benson T, Akella A, Maltz D A. Network traffic characteristics of data centers in the wild[C]//Proceedings of the 10th ACM SIGCOMM Conference on Internet Measurement. 2010:267-280. |

| [2] | Wang Guohui, Andersen D G, Kaminsky M, et al. C-through:part-time optics in data centers[J]. ACM SIGCOMM Computer Communication Review , 2011, 41 (4) :327–338. |

| [3] | Gravey P, Morel P, Moulinard M L, et al. 112-Gbit/s passive optical pod interconnect for small data centers using pulse amplitude modulation[C]//International Conference on Optical Network Design and Modeling(ONDM).[s.l.]:IEEE, 2016:1-6. |

| [4] | Proietti R, Cao Zheng, Nitta C J, et al. A scalable, low-latency, high-throughput, optical interconnect architecture based on arrayed waveguide grating routers[J]. Journal of Lightwave Technology , 2015, 33 (4) :911–920. doi:10.1109/JLT.2015.2395352 |

| [5] | Fiorani M, Casoni M, Aleksic S. Performance and power consumption analysis of a hybrid optical core node[J]. Journal of Optical Communications and Networking , 2011, 3 (6) :502–513. doi:10.1364/JOCN.3.000502 |

| [6] | Miao Wang, Luo Jun, Di L S, et al. Novel flat datacenter network architecture based on scalable and flow-controlled optical switch system[J]. Optics Express , 2014, 22 (3) :2465–2472. doi:10.1364/OE.22.002465 |

| [7] | Benson T, Anand A, Akella A, et al. Understanding data center traffic characteristics[J]. ACM SIGCOMM Computer Communication Review , 2010, 40 (1) :92–99. doi:10.1145/1672308 |

| [8] | Smit M, Williams K, Lawniczuk K, et al. JePPIX ROADMAP 2015:the road to a multi-billion euro market in integrated photonics[EB/OL]. http://www.jeppix.eu/documentstore/JePPI×Roadmap2015.pdf, 2015. |