2. 山东省计算中心 国家超级计算济南中心, 济南 250014;

3. 山东省计算机网络重点实验室, 济南 250014

卷积神经网络(CNN)是当前图像识别领域的研究热点, 利用预训练的CNN网络提取的图像特征展示出了较强的图像识别能力.主要对比分析了传统视觉特征和CNN视觉特征在基于内容图像检索任务中的性能表现, 并指出了一些可以值得深入研究的方向.在两个公开数据库(Pascal Sentence和Pascal VOC 2007) 的实验尝试表明CNN视觉特征比传统的视觉特征更适用于图像检索.

2. National Supercomputing Center in Jinan, Shandong Computer Science Center, Jinan 250014, China;

3. Shandong Provincial Key Laboratory of Computer Network, Jinan 250014, China

Convolutional neural network (CNN) currently becomes research focus for image recognition. The visual features extracted from the pre-trained CNN demonstrate powerful ability for various recognition tasks. The performance of traditional visual features and CNN visual features for content-based image retrieval was mainly compared. Experiments on the two public available datasets of Pascal Sentence and Pascal VOC 2007 show that, a sufficient performance of CNN visual features used in image retrieval when compared with traditional visual features.

基于内容的图像检索技术(CBIR, content-based image retrieval)[1](如图 1所示)指的是用于搜索的对象本身就是一幅图像,或者是对于图像内容的特征描述. CBIR进行检索的方式是通过提取图像底层特征,计算比较这些特征和搜索对象之间的距离,来度量两个图片的相似程度.人们通常提取颜色(RGB,LAB或HSV)、纹理、GIST[2]、尺度不变特性转换描述子[3](SIFT,scale-invariant feature transform)和F方向梯度直方图特征[4](HoG, histogram of oriented gradients)等手工设计的特征对图像内容进行表示.虽然CBIR在过去的十几年中取得了大量的科研成果并建立起了一些研究型或商用型的图像检索系统,但大多数的图像检索性能还不能满足人们的要求.究其原因,主要是底层特征和高层语义理解之间的差异,即语义鸿沟[5](SG, semantic gap),也就是底层视觉特征并不能完全反映和匹配用户的查询意图.

|

图 1 CBIR示例 |

最近,随着深度学习[6]的发展,卷积神经网络[7](CNN, convolutional neural network)在图像识别领域取得了重要进展,如图像分类和物体检测.特别是,Krizhevsky等[8]提出的CNN架构在ILSVRC 2012 [9](imagenet large scale visual recognition challenge)中取得了巨大突破(在图像分类任务中,性能比传统手工设计特征的架构提升了10%).随后,Razavian等[10]工作指出,通过在大规模图像库上预训练得到的CNN模型可以用来提取图像的视觉特征(CNN visual features),并应用于各类图像识别任务,如场景分类和多标签分类等.虽然CNN在图像识别领域取得了长足进步,但基于CNN视觉特征的图像检索方面的工作还很少.主要对比分析了传统视觉特征和CNN视觉特征在CBIR中的性能表现,并提出了一些值得深入研究的方向.贡献主要包含以下几个方面:

1) 在大规模图像数据集(ImageNet)上利用开源的Caffe CNN库[11]预训练了与文献[8]一致的CNN模型.利用预训练的CNN模型提取目标图像库的CNN视觉特征,用于图像检索.

2) 利用目标图像库对预训练的CNN模型参数进行微调,并利用微调的CNN模型提取目标图像库CNN视觉特征,用于图像检索.

3) 在两个公开图像库,即Pascal Sentence [12]和Pascal VOC 2007 [13],对比分析了传统视觉特征和CNN视觉特征在图像检索任务中的性能表现.实验结果表明CNN视觉特征比传统视觉特征更适用于CBIR.

1 CNN视觉特征提取CNN视觉特征主要通过预训练的CNN模型和微调的CNN模型提取.

1.1 预训练CNN模型利用ILSVRC2012图像分类任务中的训练数据集(120万张图像,1 000类)对CNN模型进行预训练.采用了与文献[8]一致的网络架构,即CNN模型包含5个卷积层(cov1~cov5) 和3个全连接层(fc6~fc8).整个预训练过程如下:

步骤1 将每张训练图像都调整到256×256大小.为防止过拟合,在训练过程中随机提取了该图片227×227的子块或其镜像作为CNN的输入.

步骤2 与文献[8]相似,首先对所有的网络参数进行高斯分布G(μ, σ)(μ=0, σ=0.01) 的随机初始化,继而采用随机梯度下降(SGD, stochastic gradient descent)来对整个网络的参数进行调整.在训练过程中,将输入网络的图像数量设置为256,动量设置为0.9,权重衰减系数设置为0.000 5.对于所有层,采用修正线性单元[9](ReLUs, rectified linear units)作为非线性激活函数.由于整个网络的参数过多,为防止过拟合,在训练过程中,将每层参数丢弃概率设置为0.5.同文献[8]一致,利用Softmax将最后一层全连接1 000维的输出转化为在1 000类上的概率分布,并利用相对熵作为损失函数,计算图像实际标签之间的损失值.

步骤3 整个训练过程经历90轮(所有图片训练一遍为一轮)的迭代.学习速率的初始值设为0.01,每经过20轮就将学习速率减小为原来的1/10.

1.2 微调CNN模型通常情况下,目标任务的图像集与预训练图像集无论是类别数量还是图像样式都存在很大的差别,在目标图像集的检索任务中,直接用预训练的CNN模型提取图像的视觉特征往往难以达到最优的性能.因此,为了使预训练的CNN模型参数更好地适用于目标图像集的特征提取,利用目标图像集的图像对预训练的CNN模型参数进行微调.整个微调过程如下:

步骤1 与预训练过程相同,每张来自目标图像库的图像首先被调整到256×256,进而随机提取该图227×227的子块或其镜像作为CNN的输入.

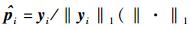

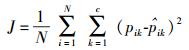

步骤2 假设目标图像集的类别数量为c,将CNN模型最后一层全连接的神经元数量从1 000改为c, 并对最后一层的网络参数进行具有高斯分布G(μ, σ)(μ=0, σ=0.01) 的随机初始化.对于第1到7层,即cov1~fc7,利用在预训练过程中获得的参数对其进行初始化.微调过程中,采用同预训练步骤2中类似的参数设置.不同点在于损失函数.微调过程中采用的是平方损失函数.假设在目标数据集中有N幅图像,yi=[yi1, yi2, …, yic]是第i幅图像的标注向量,其中当图像属于第j类时,yij=1(j=1, 2, …, c),否则yij=0.利用L1范数对图像的标注向量进行归一化,即

|

(1) |

步骤3 整个微调过程经历60轮的迭代.与预训练过程的差异在于对不同的网络层采用了不同的学习速率.具体来说,cov1~fc7的初始学习速率为0.001,fc8的初始学习速率为0.01.对于前7层设置较小的学习速率,可以保证通过预训练CNN模型得到的参数在微调过程中不被破坏.对于最后一层设置较高的学习速率,可以保证整个网络在目标图像集上快速收敛到新的最优点.与预训练过程相似,每经过20轮的微调就将每层的学习速率减小为原来的1/10.

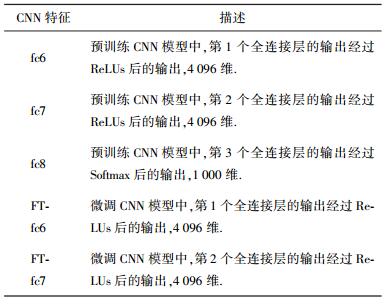

1.3 特征提取一共对比分析了5种CNN视觉特征在图像检索任务中的性能表现.利用预训练的CNN模型提取了目标图像集在最后3个全连接层的输出作为图像的特征表示,即fc6,fc7和fc8.同时,利用微调的CNN模型提取了目标图像集在前两个全连接层的输出作为图像的特征表示,即FT-fc6和FT-fc7. 表 1对这5种CNN视觉特征进行了详细描述.

|

|

表 1 CNN视觉特征描述 |

在两个公开图像库对比分析了CNN视觉特征和传统的视觉特征在图像检索任务中的性能表现.

Pascal Sentence[13]属于单标签图像库,即一张图片只属于一个类别.此图像库共包含20个类以及1 000张图片.其中每一类包含50张图像样本,随机从每一类中选取30张图片用于对预训练的CNN模型参数微调,剩下的20张图片用于测试.在Pascal Sentence上基于SIFT提取1 024维的视觉词包(BoVW,bag-of-visual-words)特征用于对比CNN视觉特征.

Pascal VOC 2007 [11]属于多标签图像库,即一张图片属于一个或多个类别.此图像库共包含20个类以及9 963张图片.此图像库共分为训练、校验和测试3个子集,利用训练和校验集(共5 011张图片)对预训练的CNN模型参数进行微调,并在测试集(4 952张图片)上进行测试.在此图像库上,共对比了由文献[14]提供的4种传统的视觉特征,即512维的GIST特征,64维的HSV特征,200维的BoVW特征以及776维的三者融合的特征(简称GHB).

利用平均精度均值(mAP, mean average precision)作为不同的视觉特征在图像检索任务中的评价指标,利用欧式距离度量图像之间的相似性.

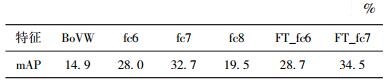

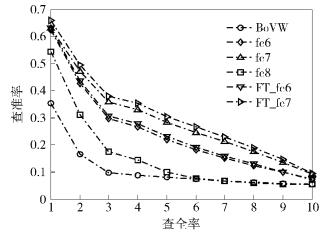

2.2 实验结果表 2给出了不同的视觉特征在Pascal Sentence图像库上的检索性能.由表 2可以看出,通过预训练的CNN模型提取的视觉特征,即fc6,fc7和fc8,比传统的BoVW特征分别高出了13.1%,17.8%和4.6%.利用微调的CNN模型提取视觉特征,即FT-fc6和FT-fc7,比相应的fc6和fc7进一步提高了0.7%和1.8%. 图 2给出了这6种视觉特征的查准-查全(Precision-Recall)曲线对比,可以看出对于图像检索,CNN视觉特征比传统视觉特征有着明显的优势.

|

|

表 2 不同视觉特征在Pascal Sentence上的mAP对比 |

|

图 2 在Pascal Sentence上查准-查全曲线比较 |

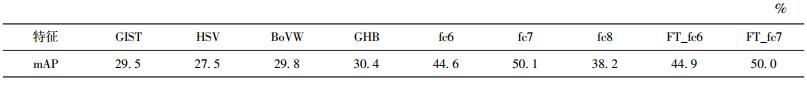

表 3给出了不同的视觉特征在Pascal VOC 2007图像库上的检索性能.由表 3可以看出,融合了GIST, HSV和BoVW 3种传统视觉特征的GHB在基于传统视觉特征的图像检索中达到了最高(30.4%).而利用CNN模型抽取的视觉特征比GHB分别高出了14.2%(fc6),19.7%(fc7),7.8%(fc8),14.5%(FT-fc6) 和19.6%(FT-fc7).

|

|

表 3 不同视觉特征在Pascal VOC 2007上的mAP对比 |

与Pascal Sentence不同,利用微调的CNN模型的视觉特征相对于利用预训练CNN模型的视觉特征在图像检索任务中并没有明显提高,即0.3%(fc6 vs. FT-fc6) 和-0.1%(fc7 vs. FT-fc7).主要原因可能在于多标签的图像检索任务比单标签检索任务更复杂,以及用于预训练CNN模型的图像同目标数据集的图像比较接近.但从实验结果可以看出,对于多标签的图像检索任务,CNN视觉特征同样比传统视觉特征具有明显优势.

3 结束语主要对比分析了传统视觉特征和CNN视觉特征在CBIR任务中的性能表现.实验结果表明,CNN视觉特征比传统的视觉特征在图像检索任务中具有明显优势.同时,对于特定的图像集,通过对预训练的CNN模型进行微调,可以进一步提升CNN视觉特征的表征能力.

深度CNN已经在图像识别领域展现了其强大的优势.利用深度CNN或CNN视觉特征的图像/视频分类、图像/视频检索、物体识别、行为估计等一系列的计算机视觉问题已经成为将来值得深入研究的方向.

| [1] | Edkins J, Graham M. Content-based image retrieval [R]. University of Northumbria at Newcastle: Technical Report, 1999. |

| [2] | Oliva A, Antonio T. Modeling the shape of the scene: a holistic representation of the spatial envelope[J].International Journal of Computer Vision, 2001, 42(3): 145–175. doi: 10.1023/A:1011139631724 |

| [3] | Lowe D G. Distinctive image features from scale-invariant keypoints[J].International Journal of Computer Vision, 2004, 60(2): 91–110. doi: 10.1023/B:VISI.0000029664.99615.94 |

| [4] | Dalal N, Bill T. Histograms of oriented gradients for human detection [C]//CVPR. San Diego, USA: IEEE, 2005: 886-893. |

| [5] | Datta R, Joshi D. Image retrieval: ideas, influences, and trends of the new age[J].ACM Computing Surveys (CSUR), 2008, 40(2): 5. |

| [6] | Hinton G E, Ruslan R S. Reducing the dimensionality of data with neural networks[J].Science, 2006, 313(5786): 504–507. doi: 10.1126/science.1127647 |

| [7] | Cun L, Boser B. Handwritten digit recognition with a back-propagation network [C]//Advances in Neural Information Processing Systems. Denver, Colorado, USA: MIT, 1990: 396-404. |

| [8] | Alex K, Ilya S. Imagenet classification with deep convolutional neural networks [C]//Advances in Neural Information Processing Systems. Lake Tahoe, Nevada, USA: MIT, 2012: 1097-1105. |

| [9] | Deng Jia, Dong Wei. Imagenet: a large-scale hierarchical image database [C]//CVPR. Miami, USA: IEEE, 2009: 248-255. |

| [10] | Ali S R, Hossein A, Josephine S, et al. Cnn features off-the-shelf: an astounding baseline for recognition [C]//CVPRW. Columbus, USA: IEEE, 2014: 512-519. |

| [11] | Jia Yangqing, Shelhamer E. Caffe: convolutional architecture for fast feature embedding [C]//Proceedings of the ACM International Conference on Multimedia. Orlando, USA: ACM, 2014: 675-678. |

| [12] | Rashtchian C, Peter Y. Collecting image annotations using Amazon's mechanical turk [C]//Proceedings of the NAACL HLT Workshop on Creating Speech and Language Data with Amazon's Mechanical Turk. Los Angeles, USA: MIT, 2010: 139-147. |

| [13] | Everingham M, Gool V L. The pascal visual object classes (voc) challenge[J].International Journal of Computer Vision, 2010, 88(2): 303–338. doi: 10.1007/s11263-009-0275-4 |

| [14] | Hwang S J, Grauman K. Accounting for the relative importance of objects in image retrieval [C]//BMVC. Aberystwyth, UK: BMVA, 2010: 1-12. |