2. 华为软件技术有限公司, 南京 210012

提出一种基于神经网络预测信道质量指示(CQI)的长期演进下行调度方法,设计了基于神经网络的CQI预测模型,使用系统中已获得的CQI历史值来预测调度时刻的当前CQI值,调度器使用此预测值进行调度.仿真结果表明,该方法对由CQI延迟所导致的系统性能下降有明显改善.

2. Huawei Software Technologies Company Limited, Nanjing 210012, China

Using the available outdated channel quality indicator (CQI), an optimized long term evolution downlink resource allocation method is proposed. The key is a neural network based on CQI prediction model and algorithm, which can predict the current CQI from the outdated CQIs. The scheduler uses the predicted CQI to allocate radio resources and decide on proper modulation and coding scheme. Simulation shows that the proposed prediction model and algorithm have practical effects on solving the degradation of scheduling efficiency due to the outdated CQI.

3GPP长期演进(LTE,long term evolution)系统根据用户CQI分配资源块(RB,resource block)并采取自适应调制编码(AMC,adaptive modulation and coding),这要求无线资源调度器能准确地获知实时CQI.Piro等[1-2]对近年LTE系统下行链路的无线资源调度算法进行了总结,总结的调度算法及结论都建立在接收到理想CQI的假设之上,没有考虑CQI生成和反馈导致的时延.但调度器实际使用的是延迟CQI[3],CQI的时延会导致系统性能的明显下降[4-7].文献[3, 8]中给出了延迟信道信息概率分布的前提下,在多载波系统中使用延迟的信道信息进行资源分配的方法.在实际应用系统中,这一前提不易实现.

提出一种基于神经网络[9]预测CQI的LTE下行调度方法,使用基于神经网络的CQI预测模型,根据实际系统中的CQI历史值来预测调度时刻的CQI值,以供调度器调度RB和AMC.

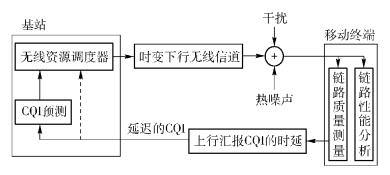

1 系统模型图 1所示为用于分析延迟CQI影响的LTE下行调度系统模型.链路质量测量模块测量下行信道中各RB接受信号的信干噪比(SINR,signal to interference and noise ratio),并换算成CQI[10],通过上行信道反馈给基站.

|

图 1 系统模型 |

无线资源调度器根据反馈的CQI值执行调度算法,决定哪些终端在该传输时间间隔(TTI,transmission time interval)使用哪些RB,再计算这些RB的等效SINR(ESINR,effective SINR)[10],得出调制编码方式(MCS,modulation and coding scheme)和误块率(BLER,block error rate).理想状况(CQI反馈时延为0) 下,小区内t时刻的吞吐率为

|

(1) |

其中:l是终端个数,Mi, t是第i个终端t时刻根据相应ESINR Ei, t得到的MCS,r(Mi, t)是获得的传输速率,Bi, t是传输块的误块率.

链路性能分析模块根据调度决策和链路的当前状况分析链路的实际性能.如图 1虚线所示,由于CQI生成和反馈所导致的时延τ,调度器在第t个TTI调度时实际上使用第t-τ个TTI时的CQI值.这样调度决策的Mi, t-τ就与调度时刻的Ei, t不一致.根据BLER门限值[10],终端i在t时刻的实际误块率为

|

(2) |

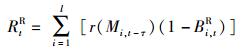

整个小区第t时刻的实际吞吐率为

|

(3) |

如果Ei, t比Ei, t-τ恶化,高效率的Mi, t-τ引起误块率增加,导致吞吐率下降;反之,Mi, t-τ偏保守,导致吞吐率偏低.同时,由于使用不准确的CQI,调度RB的合理性会降低.

CQI预测模块是本研究的核心,利用基站侧获取的各终端每个RB的CQI历史值来预测调度时刻的实时CQI值,供无线资源调度器进行调度和AMC.

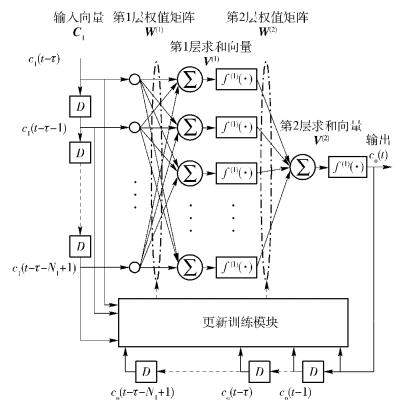

2 CQI神经网络预测算法 2.1 CQI预测模型CQI预测模型使用多层感知器神经网络[9],如图 2所示,由输入层(第0层)、隐含层(第1层)、输出层(第2层)和更新训练模块构成. D表示延迟,W(l)、V(l)、f(l)(·)为对应层的权值矩阵、求和向量、激活函数,l=1, 2.其中输入层向量长度是NI(取NI个历史值),第1层和第2层神经元的个数分别是NH, 1.

|

图 2 CQI预测模型 |

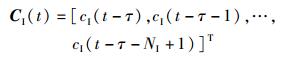

在t时刻,由于CQI的延迟,调度器获得的CQI值实际上是t-τ时刻的值,经过训练的CQI预测模型使用接收到的CQI序列作为输入向量

|

(4) |

来预测t时刻的CQI值,输出cO(t)

|

(5) |

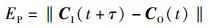

由于无线信道的时变特性,训练后的网络具有时效性.更新训练模块实时统计平均误差,并在误差超出阈值后重新训练网络.设统计周期等于输入层向量长度NI,在t+τ时刻可以记录到由于时延造成的实际误差

|

(6) |

和预测值的误差

|

(7) |

其中

|

(8) |

当EP≥αER时重新训练网络,0 < α≤1.

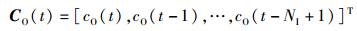

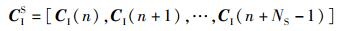

2.2 预测模型的训练预测模型在预测CQI之前,选取最近的Ns组训练样本作为训练集合进行训练,输入CQI向量矩阵

|

(9) |

期望输出

|

(10) |

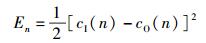

预测模型在训练时采用误差反传算法[9]调整权值W(l),目标是最小化期望输出与实际输出的误差.上述样本中的n时刻,期望输出d=cI(n);输出cO(n),则目标函数为

|

(11) |

其中

|

(12) |

采用最速下降梯度法来求解ΔW(2)和ΔW(1)

|

(13) |

|

(14) |

得

|

(15) |

其中:wi, j(l)是连接第l-1层第i节点到第l层第j节点的权值,μ(l)是对应层的学习率参数,vj(l)是第l-1层第j节点中求和后的值,k是指迭代次数,cOk(n)是预测模型在第k次迭代时以CI(n)为输入的输出.

2.3 CQI预测算法步骤1 根据图 2建立CQI预测模型.

步骤2 使用Nguyen算法[9]初始化W(l).

步骤3 取系统中最新的训练集合,见式(9)、(10).

步骤4 采用批量训练方法[9],根据式(11)、式(13)~(15) 训练网络,直到预测模型对于训练集合中的所有响应都到达预先设定的精度水平ξ.其中μ(l)使用Darken算法[9]确定.

步骤5 根据式(5),使用训练出的网络预测CQI;同时统计误差,如误差大于阈值(见式(6)~(8)),则返回步骤3.

3 仿真分析仿真使用LTE系统级仿真平台[10],系统参数如表 1所示. CQI预测模型中,隐含层神经元的个数由试错法决定[9],经比较取NH=9,f(l)(·)取Log-Sigmoid传输函数,精度水平ξ=10-3. NI、NS的取值与终端移动速度成反比,取100~200之间.迭代次数在46~55之间.

|

|

表 1 LTE系统仿真主要参数 |

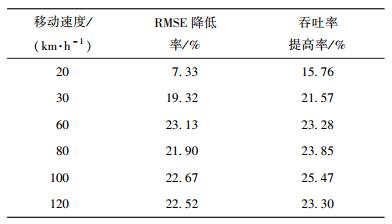

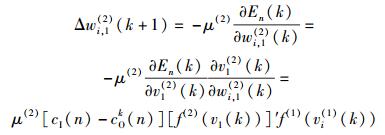

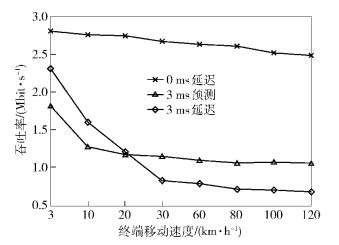

图 3和图 4所示为小区中只有1个终端时,基站使用实际反馈的延迟CQI、预测CQI和理想的无延迟CQI进行调度的吞吐率比较. 表 2和表 3给出了具体统计结果,包括吞吐率提高率和实际反馈CQI和预测CQI在仿真时间内分别与理想CQI的均方根误差(RMSE,root mean square error)的降低率.

|

图 3 吞吐率比较(单终端,v=30 km·h-1,CQI延迟变化) |

|

图 4 吞吐率比较(单终端,τ=3 ms,移动速度变化) |

|

|

表 2 单终端移动速度30 km·h-1时的性能比较 |

|

|

表 3 单终端在CQI反馈延迟3 ms时的性能比较 |

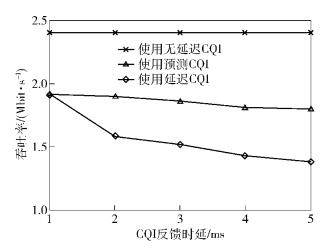

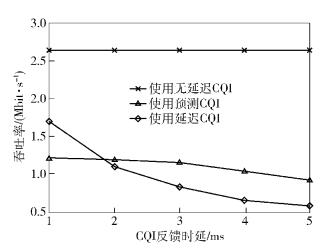

图 5和图 6所示为小区中有20个终端,基站使用延迟CQI、预测CQI和理想的无延迟CQI进行调度的吞吐率比较.

|

图 5 吞吐率比较(20个终端,v=30 km·h-1) |

|

图 6 吞吐率比较(20个终端,τ=3 ms) |

与单终端仿真结果相比,多终端时,使用理想CQI进行调度,因为用户分集的效果,基站的吞吐率比单终端场景下有提高.采用实际反馈的延迟CQI进行调度,由于基站中RB分配、每个终端的AMC都使用了不准确的CQI,放大了负面作用,所以基站的吞吐率比单终端下降得更严重.使用预测CQI进行调度,在速度较快时吞吐量的提升比单终端情况下更加明显.

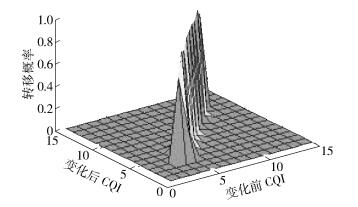

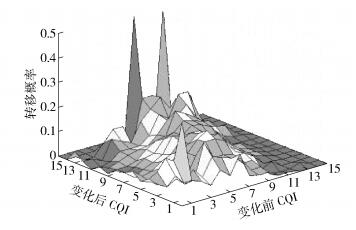

3.2 延迟CQI的转移概率分析CQI实质是离散化的SINR[7],分别对应1~15共15个整数值. 图 7和图 8记录了仿真中终端移动速度为3 km/h且CQI延迟1 ms、30 km/h且3 ms时,某RB在t-τ时刻与t时刻CQI值的转移矩阵:状态空间I={1,2,…,15},纵坐标为转移概率.

|

图 7 速度3 km/h,τ=1 ms时的CQI转移概率 |

|

图 8 速度30 km/h,τ=3 ms时的CQI转移概率 |

由图可知,在终端移动速度慢且CQI时延低的情况下,延迟CQI值与当前实际的CQI值相同的概率很大,具有很高的相关性.移动速度变快后,转移概率的值很分散.这就解释了3.1节中的结论:当终端在低速移动且CQI时延较低时,使用延迟的CQI进行调度仍具有较好的结果.

4 结束语针对延迟CQI对LTE调度产生的不利影响,设计了一种基于神经网络预测CQI的LTE下行调度方法.仿真结果表明:1) 在终端高速移动时,新方法对由CQI延迟所导致的调度性能下降有明显改善;2) 相对于单个终端,由于多终端情况下用户分集,新方法的性能有进一步提高;3) 在低速情况下,时延较短的延迟CQI可作为调度的依据.

本研究中CQI预测模型的参数根据终端速度静态设置,如何根据信道变化自适应地动态调整参数是下一步的研究内容.

| [1] | Piro G, Grieco L A, Boggia G. Two-level downlink scheduling for real-time multimedia services in LTE networks[J]. IEEE Trans on Multimedia, 2011, 13(5): 1052–1065. doi: 10.1109/TMM.2011.2152381 |

| [2] | Sadiq B, Seung J B, Vecianna G. Delay-optimal opportunistic scheduling and approximations: the log rule[J]. IEEE Trans on Networking, 2011, 19(2): 405–418. doi: 10.1109/TNET.2010.2068308 |

| [3] | Ayoub H, Assaad M. Scheduling in OFDMA system with outdated channel knowledge [C]//IEEE 2010 ICC. Cape Town: IEEE Press, 2010: 1-5. |

| [4] | Goeckel D L. Adptive coding for time-varying channels using outdated fading estimates[J]. IEEE Trans on Commun, 1999, 47(6): 844–855. doi: 10.1109/26.771341 |

| [5] | Falahati S, Svensson A, Ekman T, et al. Adaptive modulation systems for predicted wireless channels[J]. IEEE Trans on Commun, 2004, 52(2): 307–316. doi: 10.1109/TCOMM.2003.822715 |

| [6] | Morales D J, Sanchez J J, Gomez J, et al. Imperfect adaptation in next generation OFDMA cellular systems[J]. Journal of Internet Engineering, 2009, 3(1): 202–209. |

| [7] |

吴斌, 糜正琨, 王亮. CQI延迟对LTE下行调度的影响[J]. 南京邮电大学学报, 2012, 32(6): 12–16.

Wu Bin, Mi Zhengkun, Wang Liang. Impact of outdated CQI on LTE downlink scheduling[J]. Journal of Nanjing University of Posts and Telecommunications, 2012, 32(6): 12–16. |

| [8] | Wong I C, Evans B L. Optimal resource allocation in the OFDMA downlink with imperfect channel knowledge[J]. IEEE Trans on Commun, 2009, 57(1): 232–241. doi: 10.1109/TCOMM.2009.0901.060546 |

| [9] | Ham F M, Kostanic I. Principles of neurocomputing for science and engineering[M]. New York: The McGraw-Hill Companies, Inc, 2001. |

| [10] | Ikuno J, Wrulich M, Rupp M. System level simulation of LTE networks[C]//VTC 2010-Spring. Taipei: IEEE Press, 2010: 1-5. https://publik.tuwien.ac.at/files/PubDat_184908.pdf |