2. 上海交通大学医学院附属上海儿童医学中心放射科, 上海 200127

2. Department of Radiology, Shanghai Children's Medical Center, Shanghai Jiao Tong University School of Medicine, Shanghai 200127, China

据世界卫生组织报道[1],心血管疾病(cardiovascular diseases,CVDs)每年造成全球1 730万人死亡,占全球死亡总数的30%,而且死亡率高于其他疾病;并且如果依照这个趋势持续发展,至2030年时,每年死亡人数将会上升到2 360万.如何快速有效地评估心脏功能、诊断心血管疾病,降低心血管疾病死亡率、提高人类生存质量,已经成为人们密切关注的问题.

目前,借助医学成像技术评估心脏结构及功能是临床经常采用的检查手段[2].其中,心脏磁共振(cardiac magnetic resonance,CMR)电影短轴图像可清楚显示心室血池、心肌、流出道随心脏周期的变化,而且时空分辨率高、可重复性好[3],便于分割心室并计算心室容积(ventricular volumes)、每搏输出量(stroke volume,SV)和射血分数(ejection fraction,EF)等临床诊疗心血管疾病中用于观察心脏结构、评估心脏功能的常用参数.心室分割是评估心脏功能的基础[4].与左心室(left ventricle,LV)相比,右心室(right ventricle,RV)分割相对困难,主要原因在于CMR电影短轴图像中RV形状不规则,心肌壁薄,且与脂肪、乳头肌等组织毗邻,图像对比度低.在很长一段时间内,RV分割都是由放射科有经验的医生手动描绘完成,耗费时间较长,受主观因素影响大[5],因此,临床上迫切需要自动的RV分割方法.

在基于CMR电影短轴图像的RV分割方法中,常用的经典分割方法主要包括活动轮廓模型[6]、动态规划模型[7]和图割[8]等.Liu等[9]提出了一种基于拓扑稳定阈值和区域受限动态规划的心室分割方法,用于分割心内膜和心外膜;Auger等[7]采用三维数学模型对某一时间段内沿心室边界交互放置的导测点进行拟合,利用其位移信息进行心室分割.这些传统的RV分割方法往往需要手动介入或者预定义约束条件,受数据影响较大,且不能实时分割.为了促进RV分割技术的发展,医学影像计算与计算机辅助介入国际会议(Medical Image Computing and Computer Assisted Intervention,MICCAI)在2012年和2017年分别举办了右心室分割挑战(Right Ventricle Segmentation Challenge,RVSC)和自动心脏诊断挑战(Automatic Cardiac Diagnosis Challenge,ACDC)赛,两次挑战赛都公开了其数据集[10]. 在RVSC中,Zuluaga等[11]通过图像配准融合实现RV分割,其分割结果获得第一名.多图谱方法将传统的分割方法转化为配准和融合,图谱的选择对计算速度和结果精度影响较大[12].

人工神经网络可以很好地解决复杂的非线性问题,能快速准确地提取特征进行学习,近年来被广泛应用于模式识别、图像分类、语义分割等各个领域.在CMR电影短轴图像分割任务中,基于人工神经网络的深度学习可以克服上述心室分割方法中普遍存在的计算速度慢、依赖手工交互、效率低、泛化性较差等限制,通过已有的数据库进行训练学习与参数调整,有效提取心脏特征实现更加精确的分割与分析.在2015年Kaggle挑战赛之后,深度学习开始被广泛应用于心脏分割[10].Tran[13]首次使用一种端到端的深度完全卷积神经网络(fully convolutional network,FCN)来进行心脏自动分割,其输入图像的大小不受限制,通过卷积、池化进行特征提取,避免了手动特征选取的复杂性;并且通过上采样恢复原图大小,可以实现端到端、像素到像素的训练,提高了计算速度与效率,不足的地方是缺乏空间一致性;Ronneberger等[14]提出了U-net网络框架,即使在RV的小样本分割中也能取得较为精确的结果,被广泛应用于医学图像分割.在2017的ACDC比赛中,10组全自动分割方法中有9组使用了深度学习模型,多数性能较好的方法均为U-net修改版本[15].Khened等[16]在FCN的基础上提出了新的密集连接FCN进行心室分割,该网络融合了FCN、残差网络与密集连接卷积网络(Dense-Net)[17],更好地提取出多尺度特征,提高了分割精度,在RVSC和ACDC公共数据集上进行算法验证,取得较好结果.有研究者还提出了深度学习与传统方法相结合的方式,以减小深度学习网络的复杂度.Avendi等[18]使用卷积神经网络提取感兴趣区域,之后利用堆栈式自编码器进行RV初步分割,最后使用可形变模型对初分割结果进行优化,三者相结合提高了RV分割的精度和鲁棒性;Yang等[19]提出了与多图谱结合的方法,使用深度学习完成标签融合和特征提取.除此之外,还有3D深度学习网络,例如3D-CNN[20]和3D-Unet[21],以及其他一些新的深度学习网络,如E-net[22]和Grid-net[23]等也被用于分割任务.

本文提出了一种密集多尺度U-net网络(dense multi-scale U-net,DMU-net)用于基于CMR电影短轴图像的RV分割,这种新的网络融合紧密连接块(dense block)[17]、多尺度特征提取等结构的特点,在U-net[14]网络的基础上改进其卷积结构和跳跃连接(skip-connections)结构,使特征提取过程中的底层与深层以及不同尺度的特征可以紧密结合起来,网络学习能力增强,提高了分割精度.本文首先详细介绍DMU-net网络结构及分割方法,然后利用实验验证了该方法的有效性.

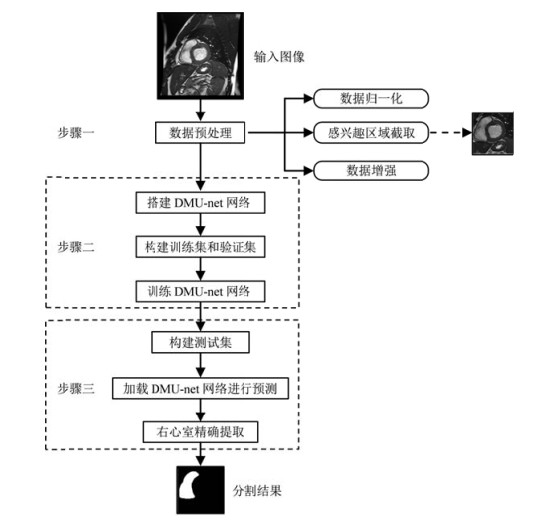

1 网络结构及分割方法本文的目标是建立一个深度学习网络模型用来实现自动RV分割,整个方法的流程如图 1所示,包含三个阶段:数据预处理、DMU-net网络的搭建与训练、数据集预测分割.

|

图 1 本文提出的用于右心室自动分割的方法 Fig. 1 The flow chart of automatic RV segmentation proposed in this research |

不同的CMR电影短轴图像可能因采集机器或采集参数的不同而具有不同的图像对比度和灰度分布.为了提高提取特征的效率,本文对每例图像数据采用常见的Z-score标准化方法进行归一化预处理,以消除像素灰度分布范围的差异.Z-score标准化是指每幅心脏图像都减去其像素平均值并除以像素标准差,使处理后的数据像素灰度分布符合标准正态分布,用于后续感兴趣区域的提取和数据集的制作.

CMR电影短轴图像不仅包括RV,还包括LV、心房及其它器官和组织,会造成误分割和增加计算量,因此,本文根据心脏运动及其形状结构的特点提取感兴趣区域.CMR电影短轴图像在一个心动周期内只有心脏部分发生明显变化,周围组织基本保持不变,而且心脏舒张末期和收缩末期的形状差异较大,考虑到LV形状与圆形相近且与RV毗邻,于是本文对CMR电影短轴图像中部分层面的舒张末期与收缩末期差值的绝对值图实施霍夫圆变换,确定LV中心,并根据LV和RV的位置关系(二者毗邻),同时截取含有LV和RV的部分作为感兴趣区域,裁剪后的图像尺寸为128×128.此外,为了减少训练样本不足带来的过拟合、抑制网络学习能力等问题,本文采用平移、旋转、翻转、缩放的方法扩充样本量.

1.2 DMU-net网络结构U-net网络在医学图像处理中应用较广,并取得了较好的效果[14, 21].本文是在U-net的基础上,融合紧密连接与多尺度特征提取构建出新的DMU-net网络.相比于仅有多尺度特征提取的网络结构,本文的网络可以更好地融合图像的深层和浅层特征,实现更加精确的分割.

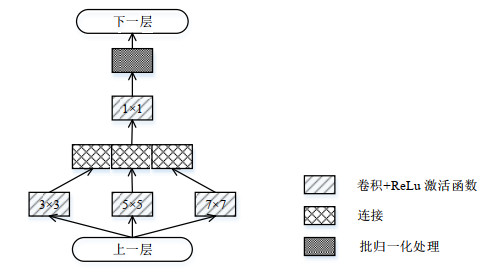

传统的U-net网络包括由基本卷积层、池化层组成的用于特征提取的编码器,由反卷积层组成的用于维度恢复的解码器,以及将二者提取的特征相融合的跳跃连接.卷积层通过不同大小的卷积核进行特征提取,但RV形状在心脏中部、底部和顶部切片上差别较大,为卷积核的选择带来困难.RV中部面积较大,包含的特征信息较多,偏好较大的卷积核;底部和顶部则相反.增加网络的深度(网络层数)和宽度(每一层的单元数)可以提升网络的性能,但会增加计算量;并且CMR电影短轴图像数量有限,在复杂的网络中训练会产生过拟合的问题.考虑到Inception模块[24]及其变体可以有效减小在复杂网络中训练产生的过拟合问题,本文将U-net网络中单一核大小的卷积层改为包含三个不同尺度卷积核的Inception模块,同时提取并融合不同尺度的特征信息,其结构如图 2所示,卷积核的大小为3×3、5×5和7×7,将提取的特征图连接后进行标准1×1卷积来融合特征,经过ReLu函数激活后,进行批归一化(batch-normalization)处理,以减小因中间层的数据分布发生改变而对后一层输入数据的影响.

|

图 2 多尺度Inception模块 Fig. 2 Multi-scale Inception block |

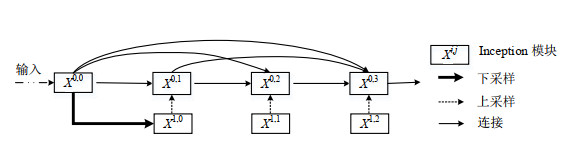

U-net网络中的跳跃连接可以把不同层之间的特征结合起来,达到语义和空间信息的融合,被广泛应用到识别、分类和分割等任务中.但它仅将每层编码部分的特征与对应的解码部分直接连接,缺乏浅层特征与深层特征的融合.为了更好地融合不同层面的特征信息,本文根据Zhou等[25]提出的U-net++网络中的跳跃连接结构,采用了嵌套的密集连接的卷积层,将不同下采样阶段得到的不同维度的特征图相融合,更为有效地提取不同感受野对应的图像特征.跳跃连接的结构如图 3所示,

| ${x^{i, j}} = \left\{ {\begin{array}{*{20}{l}} I({x^{i - 1, j}}), \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ \ j = 0 \\ I([[{x^{i, k}}]_{k = 0}^{j - 1}, U({x^{i + 1, j - 1}})]), \ j > 0 \\ \end{array}} \right.$ | (1) |

|

图 3 跳跃连接结构 Fig. 3 The structure of the skip connection |

其中,

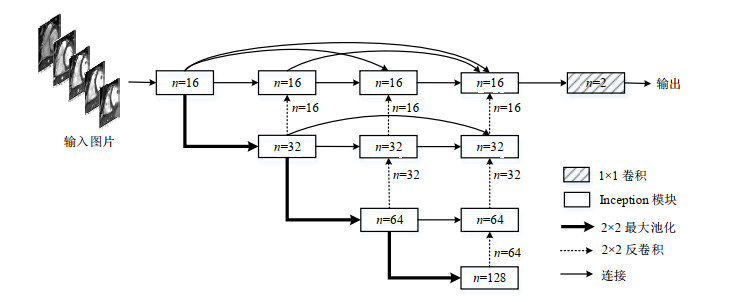

整体的DMU-net网络结构如图 4所示,由编码器和解码器组成,其中,每个矩形框代表Inception模块,其输出为多通道特征图,n代表特征通道数量.编码器部分每一模块输出的特征图通过核大小为2×2的池化操作,大小减半输入下一模块,提取不同尺寸的RV特征,这些特征通过跳跃连接分别传播到对应的解码器,解码器通过反卷积恢复原始图像维度大小,其卷积核的大小、特征通道的数量均与对应编码器部分的一致,最后通过1×1卷积输出2通道结果.DMU-net网络为端到端的网络结构,因此将网络提取出的特征送入sigmoid分类器进行二分类,可以直接输出分割后RV的概率图.

|

图 4 密集多尺度U-net(DMU-net)网络结构 Fig. 4 The architecture of the proposed dense and multi-scale U-net (DMU-net) |

为了训练DMU-net网络,采用Dice系数(Dice metric,DM)构建损失函数,DM是衡量预测结果与真实结果的相似度的指标,定义为:

| $DM({y_n}, \widehat {{y_n}}) = \frac{{2|{y_n} \cap \widehat {{y_n}}|}}{{|{y_n}| + |\widehat {{y_n}}|}}$ | (2) |

其中,

| $L(w) = 1 - DM({y_n}, \widehat {{y_n}})$ | (3) |

DMU-net网络的输出结果为概率图,即每一个像素点属于RV的概率,设置阈值对其进行二值化处理得到二值图,根据1.1节中感兴趣区域提取得到的RV位置信息判断分割得到的区域是否属于RV,去除不属于RV的部分,减少预测过程中因RV周围相似的组织结构造成的误分割现象,提高分割准确度.

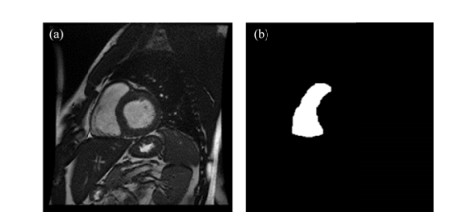

2 实验部分 2.1 实验数据本文随机对71例CMR电影短轴图像进行了回顾性分析,其中,男性49例,女性22例,年龄涵盖23~93岁.所有数据均符合伦理要求.所用数据在GE 1.5T MRI扫描仪通过SSFP(steady-date free precession)序列获得,典型的采集参数是:图像矩阵大小为256×256,视野(field of vision,FOV)为360 mm×360 mm,重复时间(repetition time,TR)为3.5 ms,回波时间(echo time,TE)为1.4 ms,层厚为6~8 mm,层间距为2~4 mm,每例数据包含6~10层,每层涵盖20~28个时相,由专门从事心脏研究的影像科医生手动勾画了舒张末期与收缩末期的RV轮廓作为金标准.图 5显示了舒张末期的一幅原始图像及其金标准.

|

图 5 舒张末期的(a)原始图像及(b)其RV手动分割结果(金标准) Fig. 5 (a) The original image and (b) its RV manual segmentation (the ground truth) at end diastole |

在制作数据集时,所有的病人数据都是随机选取的,包含舒张末期和收缩末期原始图像及其金标准.对数据进行预处理后,通过提取感兴趣区域将原始图片与其金标准均调整到128×128大小.42例数据共计595幅CMR图像作为训练集,14例共计198幅CMR图像作为验证集,训练集和验证集用来训练网络,调整网络的各项参数;15例数据共计208幅CMR图像作为测试集,进行预测与评估.

网络搭建采用Keras框架,显卡为NVIDIA GeForce GTX 1050Ti,操作系统为Windows 10.网络训练过程中,采用平移、旋转、翻转、缩放的方法扩充样本量,以减小数据不足带来的过拟合、提高网络的精确性和鲁棒性.采用(3)式中的

为了评估本文方法的分割效果,本文采用几何指标和临床指标两种方式.

几何指标包括DM和豪斯多夫距离(Hausdorff distance,HD)两个参数,其中,DM如(2)式所示.HD用来度量两幅图像的最大不对称差异,采用(4)式:

| $HD(A, B) = \max \{ {\max _{a \in A}}[{\min _{b \in B}}d(a, b)], {\max _{b \in B}}[{\min _{a \in A}}d(a, b)]\} $ | (4) |

(4)式中,A表示预测的轮廓,B表示专家手动标注的金标准的轮廓,

临床指标包括RV的舒张末期容量(end-diastolic volume,EDV)、收缩末期容量(end-systolic volume,ESV)、EF和SV.对算法分割结果计算得到的心功能参数与临床数据进行相关性和一致性分析可以评估算法的临床表现.其中,相关性指二者的相关密切程度;一致性由Bland-Altman图实现,通过算法结果与临床数据的偏差均值及一致性界限来衡量二者一致性.

3 实验结果与讨论 3.1 RV自动分割结果使用2.2节所列条件进行DMU-net网络训练,其训练至收敛所需时间为59 min.网络训练300轮后得到的训练集与验证集的损失曲线如图 6所示,可以看出本文提出的DMU-net网络在采集的数据集上可以较好的拟合,验证集的

|

图 6 训练集(虚线)与验证集(实线)的损失曲线 Fig. 6 The loss curve of training set (dotted line) and validation set (solid line) |

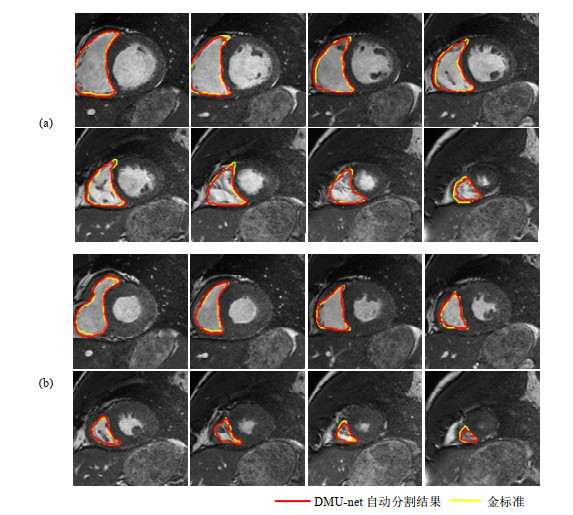

使用训练好的网络对测试集进行测试,图 7(a)和7(b)展示了测试集中某一例数据在舒张末期和收缩末期从基底到顶端的分割结果,其中红色为使用DMU-net算法的分割结果,黄色为专家手动分割金标准.从图中可以看出,本文方法能够较好的适应RV形状变化,比较精确的勾画RV.

|

图 7 (a) 舒张末期和(b)收缩末期从基底到顶端的RV分割结果 Fig. 7 RV contour at (a) end diastole and (b) end systole from base to apex |

使用DMU-net网络对测试集进行RV分割测试,分割结果在舒张末期和收缩末期的平均DM分别为0.898和0.826,平均HD分别为4.142 mm和4.739 mm,从结果来看,舒张末期的RV分割结果比收缩末期好,是因为舒张末期RV面积较大、边界较为清晰,特征提取较准确.

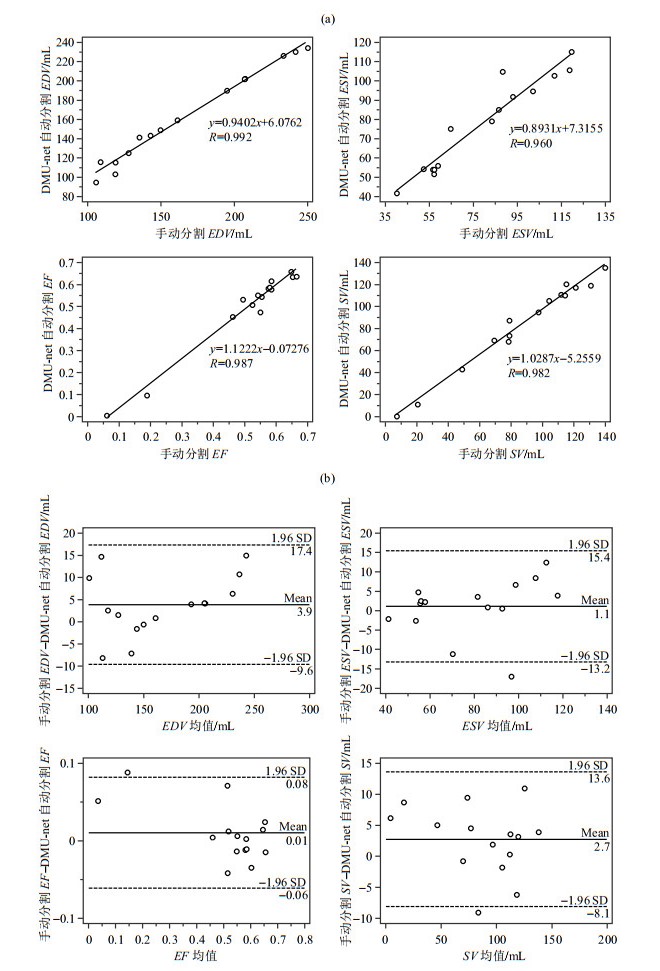

使用DMU-net网络进行RV分割得到的心功能参数与手动金标准的相关性和一致性分析如图 8所示.图 8(a)显示了使用DMU-net方法得到的RV分割结果与金标准的相关性,横纵坐标分别为金标准和使用本文算法分割的结果,对应的回归方程均在图中标出.EDV、ESV、EF和SV的相关系数R分别为0.992、0.960、0.987和0.982,其中使用DMU-net分割得到的EDV与手动分割的临床指标相关性最高,高相关性说明了使用本文方法分割的轮廓与金标准的轮廓匹配程度较高.图 8(b)为使用DMU-net方法得到的分割结果与金标准的一致性,其中横轴为两种方法所得结果的均值,纵轴为两种方法所得结果的偏差,Mean表示偏差的平均值,SD表示偏差的标准差,(Mean±1.96 SD)为一致性界限(图中虚线).可以看出,使用DMU-net方法得到的EDV、ESV、EF和SV的偏差均值为3.9 mL、1.1 mL、0.01和2.7 mL,普遍小于手动分割结果,但偏差很小,多数点差异在一致性界限内,说明使用DMU-net方法得到的分割结果可以接受,与手动分割结果较为一致.

|

图 8 使用DMU-net算法自动分割与金标准得到的EDV、ESV、EF及SV分析. (a)相关性曲线;(b) Bland-Altman一致性曲线 Fig. 8 Analysis of EDV, ESV, EF and SV acquired with DMU-net algorithm and the ground truth. (a) Correlation curves; (b) Bland-Altman plots |

使用本文提出的DMU-net算法对测试集自动分割的结果大部分较好,但也存在误分割和欠分割的情况,如部分容积效应可能会导致网络不能准确判断RV的形状;RV顶部面积较小且形状多变导致分割错误;RV边界模糊或与周围组织相连导致将周围组织误分割为RV等.

另外,本文所采集的临床数据有限、数据集较小,不能充分包含各种实际情况,如肺动脉高血压、冠心病、心脏发育不良等心脏疾病造成的RV形状的变化,仅依靠传统的数据增强方法只能在一定程度上提高分割结果精度,进一步扩大数据集可以使网络学习更多的形状位置特征以得到更好的泛化能力.除此之外有些RV边界过于模糊,脂肪、小梁肌、乳头肌等都会对分割结果产生不好的影响,引入一些必要的先验知识对解决此类问题很有帮助.

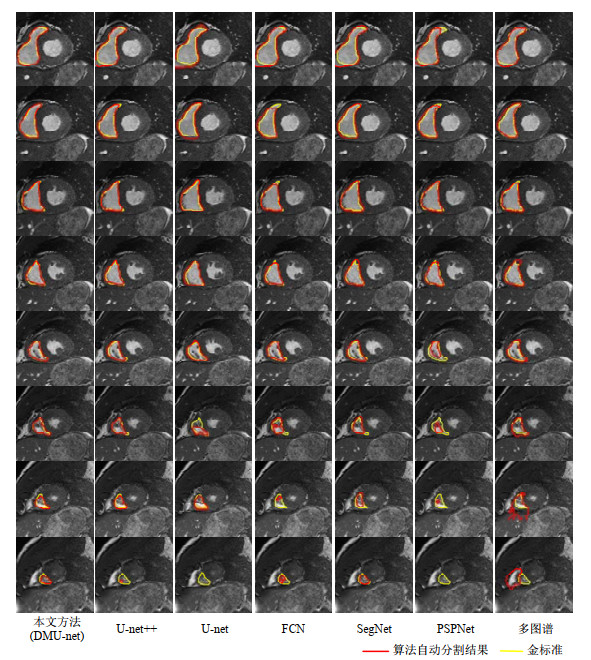

3.3 使用DMU-net与其他方法自动分割结果的比较为了进一步验证本文分割方法的准确性,将本文结果与使用其它分割效果较好的方法得到的结果进行了对比.图 9展示了用于图像分割任务的U-net[14]、U-net++[25]、FCN[13]、SegNet[26]、PSPNet[27]以及多图谱方法[28]的对同一例病人收缩末期不同切片的RV自动分割结果,其中深度学习网络(图 9第2~6列)使用本文数据集进行训练验证后对相同测试集进行分割,多图谱方法通过B样条配准与COLLATE融合得到分割结果.由图 9可以看出:心脏底部和中部面积较大时,所有方法均能得到较好的分割结果;但心脏顶部面积较小、较难分割时,本文方法分割结果优于其它六种方法(图 9最后一行).各算法对舒张末期RV分割结果的比较见图S1(扫描文章首页OSID码,或者在文章网络版查看附件).

|

图 9 使用不同方法对同一例病人收缩末期不同切片进行RV自动分割的结果 Fig. 9 RV automatic segmentation for the different slices of one patient at end systole using different methods |

表 1显示了使用不同方法对本文测试集进行RV自动分割得到的DM与HD,从表中可以看出,本文方法在舒张末期的分割结果的HD(4.142 mm)略高于PSPNet(4.089 mm),但DM优于其他方法;在收缩末期的分割结果的DM(0.826)略低于SegNet(0.831)和多图谱(0.830),但HD结果均优于其他方法.综合考虑,本文方法可以取得较为准确地分割结果.从方法学角度考虑,本文将Inception模块的多尺度特征提取与U-net++的跳跃连接结构相结合,一方面更好的提取并融合了深层与浅层的特征信息,另一方面结合不同层面RV大小不同的特点,多个卷积核提取不同尺度信息,实现了更为精确的特征提取,提高了网络分割能力.

| 表 1 使用本文方法(DMU-net)与其它方法得到的DM和HD Table 1 DM and HD values acquired using our approach (DMU-net) and other segmentation methods |

对比几种分割方法,在相同硬件条件下,基于深度学习的各网络模型对本文数据集训练至收敛所需时间不同,其中SegNet与UNet++可以较快得到收敛,虽然本文方法训练时间较长,但完成训练后可对不同数据进行快速分割,测试集中平均每例病人耗费约6 s(使用不同方法进行RV自动分割所需的时间见表S1).

为了衡量本文方法分割结果的临床表现,将其与Circle Cardiovascular Imaging心脏分析软件(CVI,http://www.circlecvi.com/)得到的心功能参数进行了比较.CVI软件基于卷积神经网络,比较广泛地应用于临床心脏功能分析[29, 30].表 2展示了手动分割结果、CVI软件分割结果和本文算法分割结果的EDV、ESV、EF和SV,结果显示使用本文算法自动分割的结果与手动分割结果更为接近.

| 表 2 RV手动分割,CVI软件和本文方法(DMU-net)自动分割得到的EDV、ESV、EF和SV Table 2 EDV, ESV, EF and SV values obtained from clinical expert, CVI software and the proposed method (DMU-net) |

我们对CVI自动分割结果与金标准也进行了相关性及Bland-Altman一致性分析,结果显示本文方法与金标准之间的相关性优于CVI自动分割结果与金标准之间的相关性(EDV、ESV、EF、SV的R分别为0.908、0.738、0.832和0.797).CVI的分割结果在收缩末期普遍大于手动分割结果,而且与手动分割的结果的偏差(ESV偏差均值为-3.3,EDV、EF和SV的偏差均值为4.4、0.02和7.7)大于本文方法自动分割结果与手动分割的偏差.以上结果说明本文方法自动分割结果与手动分割结果更接近.CVI对LV的分析较为成熟,但由于RV结构较为复杂,当训练集有差别的时候,CVI对RV的分割结果不够精确,临床一般通过有经验的专家手动修正.考虑到专家手动分割结果的误差与数据集的多样性,CVI软件存在不能充分适应本文数据集的问题,而本文方法对其他数据的泛化性也需要在之后的研究中进一步采集新的数据集进行实验验证.

4 结论本文提出了一种密集多尺度U-net网络——DMU-net网络来进行RV自动分割.首先针对CMR电影图像进行数据预处理,具体包括归一化使其像素分布均衡,数据增强用于减少样本数量过少带来的影响,提取感兴趣区域来减小周围器官组织的影响、降低计算量;然后,搭建DMU-net网络并使用数据集进行训练与验证;最后对测试集进行预测,并根据RV位置信息得到最终的RV分割结果.通过对分割结果进行DM、HD,以及临床参数的评估与分析,并与其它先进方法进行对比,证实了本文方法自动分割结果与手动结果相似度更高、差异性更小.

针对RV形状变异性很大的情况,可通过扩大数据集使本文的方法在未来具有更好的泛化性;针对边缘分割不准确问题,可尝试结合先验知识与其他算法进行改进;并进一步将2D网络推广到3D网络对3D数据进行分割与重建,更好的满足临床需求.

| [1] | MENDIS S, PUSKA P, NORRVING B. Global atlas on cardiovascular disease prevention and control[M]. Geneva: Geneva World Health Organization, 2011: 1-13. |

| [2] | CAUDRON J, FARES J, VIVIER P H, et al. Diagnostic accuracy and variability of three semi-quantitative methods for assessing right ventricular systolic function from cardiac MRI in patients with acquired heart disease[J]. Eur Radiol, 2011, 21(10): 2111-2120. DOI: 10.1007/s00330-011-2152-0. |

| [3] |

HUANG X Q, ZHAO L L, CHEN L Y, et al. Accelerated cardiac CINE imaging with CAIPIRINHA and partial parallel acquisition[J].

Chinese J Magn Reson, 2017, 34(3): 283-293.

黄小倩, 赵乐乐, 陈利勇, 等. 基于同时多层激发和并行成像的心脏磁共振电影成像[J]. 波谱学杂志, 2017, 34(3): 283-293. |

| [4] | PETITJEAN C, DACHER J N. A review of segmentation methods in short axis cardiac MR images[J]. Med Image Anal, 2011, 15(2): 169-184. |

| [5] | PETITJEAN C, ZULUAGA M A, BAI W, et al. Right ventricle segmentation from cardiac MRI:A collation study[J]. Med Image Anal, 2015, 19(1): 187-202. |

| [6] | PENG P, LEKADIR K, GOOVA A, et al. A review of heart chamber segmentation for structural and functional analysis using cardiac magnetic resonance imaging[J]. Magn Reson Mater Phy, 2016, 29(2): 155-195. DOI: 10.1007/s10334-015-0521-4. |

| [7] | AUGER D A, ZHONG X, EPSTEIN F H, et al. Semi-automated left ventricular segmentation based on a guide point model approach for 3D cine DENSE cardiovascular magnetic resonance[J]. J Cardiovasc Magn R, 2014, 16(1): 8. DOI: 10.1186/1532-429X-16-8. |

| [8] | GROSGEORGE D, PETITJEAN C, DACHER J N, et al. Graph cut segmentation with a statistical shape model in cardiac MRI[J]. Comput Vis Image Und, 2013, 117(9): 1027-1035. DOI: 10.1016/j.cviu.2013.01.014. |

| [9] | LIU H, HU H F, XU X Y, et al. Automatic left ventricle segmentation in cardiac mri using topological stable-state thresholding and region restricted dynamic programming[J]. Acad Radiol, 2012, 19(6): 723-731. DOI: 10.1016/j.acra.2012.02.011. |

| [10] | BERNARD O, LALANDE A, ZOTTI C, et al. Deep learning techniques for automatic MRI cardiac multi-structures segmentation and diagnosis:Is the problem solved?[J]. IEEE T Med Imaging, 2018, 37(11): 2514-2525. DOI: 10.1109/TMI.2018.2837502. |

| [11] | ZULUAGA M A, CARDOSO M J, OURSELIN S. Automatic right ventricle segmentation using multi-lablel fusion in cradiac MRI[C]//Medical Image Computing nd Computer-Assisted Intervention-MICCAI 2012. arXiv: 2004, 02317. |

| [12] |

LI Y, WANG L J, NIE S D. Research progress of automatic right ventricle segmentation based on cardiac cine magnetic resonance image[J].

Journal of Biomedical Engineering, 2016, 33(6): 1203-1208.

李亚, 王丽嘉, 聂生东. 基于心脏电影磁共振图像的右心室自动分割研究进展[J]. 生物医学工程学杂志, 2016, 33(6): 1203-1208. |

| [13] | TRAN P V. A fully convolutional neural network for cardiac segmentation in short-axis MRI[J]. Computer Vision and Pattern Recognition, 2016. arXiv:1604.00494. |

| [14] | RONNEBERGER O, FISCHER P, BROX T. U-Net:Convolutional networks for biomedical image segmentation[J]. Computer Vision and Pattern Recognition, 2015. arXiv:1505.04597. |

| [15] |

SU X Y, WANG L J, NIE S D, et al. Progress of right ventricle segmentation from short-axis images acquired with cardiac cine MRI[J].

Chinese J Magn Reson, 2019, 36(3): 377-391.

苏新宇, 王丽嘉, 聂生东, 等. 基于心脏磁共振短轴电影图像的右心室分割新进展[J]. 波谱学杂志, 2019, 36(3): 377-391. |

| [16] | KHENED M, ALEX V, KRISHNAMURTHI G. Fully convolutional multi-scale residual densenets for cardiac segmentation and automated cardiac diagnosis using ensemble of classifiers[J]. Med Image Anal, 2019, 51: 21-45. DOI: 10.1016/j.media.2018.10.004. |

| [17] | HUANG G, LIU Z, LAURENS V D M, et al. Densely connected convolutional networks[J]. Computer Vision and Pattern Recognition, 2017. arXiv:1608.06993 |

| [18] | AVENDI M R, KHERADVAR A, JAFARKHANI H. A combined deep-learning and deformable-model approach to fully automatic segmentation of the left ventricle in cardiac MRI[J]. Med Image Anal, 2016, 30: 108-119. DOI: 10.1016/j.media.2016.01.005. |

| [19] | YANG H, SUN J, LI H, et al. Deep fusion net for multi-atlas segmentation: application to cardiac MR images[C]//Medical Image Computing and Computer-Assisted Intervention-MICCAI 2016, 2016: 521-528. |

| [20] | PATRAVALI J, JAIN S, CHILAMKURTHY S. 2D-3D fully convolutional neural networks for cardiac MR segmentation[C]//Quebec: ACDC and MMWHS Challenges, 2017, 10663: 130-139. |

| [21] | ZHENG Q, DELINGETTE H, DUCHATEAU N, et al. 3D consistent & robust segmentation of cardiac images by deep learning with spatial propagation[J]. IEEE T Med Imaging, 2018, 37(9): 2137-2148. DOI: 10.1109/TMI.2018.2820742. |

| [22] | LIEMAN S J, LE M, LAU F, et al. FastVentricle:cardiac segmentation with ENet[J]. Computer Vision and Pattern Recognition, 2017. arXiv:1704.04296 |

| [23] | ZOTTI C, LUO Z, HUMBERT O, et al. Gridnet with automatic shape prior registration for automatic mri cardiac segmentation[C]//Quebec: ACDC and MMWHS Challenges, 2017, 10663: 73-81. |

| [24] | SZEGEDY C, LIU W, JIA Y, et al. Going deeper with convolutions[J]. Computer Vision and Pattern Recognition, 2014. arXiv:1409.4842 |

| [25] | ZHOU Z W, SIDDIQUEE M M R, TAIBAKHSH N, et al. UNet++:A nested U-Net architecture for medical image segmentation[J]. Computer Vision and Pattern Recognition, 2018. arXiv:1807.10165 |

| [26] | BADRINARAYANAN V, KENDALL A, CIPOLLA R. SegNet:A deep convolutional encoder-decoder architecture for image segmentation[J]. IEEE T Pattern Anal, 2017, 39(12): 2481-2495. DOI: 10.1109/TPAMI.2016.2644615. |

| [27] | ZHAO H S, SHI J P, QI X J, et al. Pyramid scene parsing network[J]. Computer Vision and Pattern Recognition, 2017. arXiv:1612.01105. |

| [28] |

WANG L J, SU X Y, LI Y, et al. Segmentation of right ventricle in cardiac cine MRI using COLLATE fusion-based Multi-Atlas[J].

Chinese J Magn Reson, 2018, 35(4): 407-416.

王丽嘉, 苏新宇, 李亚, 等. 基于COLLATE融合多图谱的心脏电影MRI右心室分割[J]. 波谱学杂志, 2018, 35(4): 407-416. |

| [29] | KYHL K, AHTAROVSKI K A, IVERSEN K, et al. The decrease of cardiac chamber volumes and output during positive-pressure ventilation[J]. Am J Physiol Heart Circ Physiol, 2013, 305(7): H1004-H1009. DOI: 10.1152/ajpheart.00309.2013. |

| [30] | LEI X L, LIU H, HAN Y C, et al. Reference values of cardiac ventricular structure and function by steady-state free-procession MRI at 3.0T in healthy adult chinese volunteers[J]. J Magn Reson Imaging, 2017, 45(6): 1684-1692. DOI: 10.1002/jmri.25520. |

2020, Vol. 37

2020, Vol. 37