2. 中国科学院大学, 北京 100049;

3. 中国人民解放军95899部队, 北京 100076

2. University of Chinese Academy of Sciences, Beijing 100049, China;

3. Unit 95899 of PLA, Beijing 100076, China

合成孔径雷达(synthetic aperture radar, SAR)与可见光、红外等光学成像方式相比,具有全天候、全天时、作用距离远等显著优势。自提出以来,已经被广泛运用在军事探测、民用测绘、灾害监测、地球遥感和太空等诸多领域,并持续成为美、欧、俄等西方军事强国的优先发展方向[1-2]。合成孔径雷达主要通过发射微波,获取目标的微波反射数据来成像。由于其独特的成像方式,使得SAR图像的解译和目标的自动识别(automatic target recognition, ATR)十分困难。在现代战争尤其是执行空对地打击作战时,战场态势瞬息万变,目标类型众多,战场环境复杂,如何快速发现、识别并定位目标至关重要。自动目标识别成为发现、识别定位、跟踪、目标分配、打击、评估(find, fix, track, target, engage, and assess, F2T2EA)杀伤链的核心节点。

在SAR图像的自动目标识别分类上,已经有很多国内外学者提出不同方法对其进行研究[3-6]。传统的机器学习方法基于提取特征后使用分类器分类,有基于像素或是图像特征的相似性准则的模板匹配法[3]和支持向量机(support vector machine, SVM)[4]等传统机器学习方法,基于字典学习和稀疏表示[5]的方法研究,以及改进后的径向积分特征分类器方法[6]等。近年来,深度学习逐渐兴起,掀起一阵研究热潮。卷积神经网络(convolutional neural networks, CNNs)在训练的过程中能够实现对图像特征的自动提取,在光学图像的模式识别领域取得巨大的成就。各种深度模型网络,如AlexNet[7]、VGG[8]、GoogleNet[9]、ResNet[10]等网络结构自2012年以来,在ImageNet比赛上取得显著性的识别效果,甚至高于人眼的识别率。现在正被逐渐运用到SAR图像自动目标识别与检测上,并在美国国防部和空军实验室公开的MSTAR数据集上取得了一些不错的研究结果。

深度卷积神经网络是一种隶属数据驱动的算法,往往需要大量的数据来训练网络从而提取有效特征,然而由于SAR图像数据的宝贵与稀缺,现实中缺少有效尺寸的标注实测SAR图像数据。在以往的研究中,Hansen等[11]在CNNs模型的训练过程中加入基于仿真SAR图像的预训练,但其最终识别率不高。Morgan[12]构建深度卷积网络对MSTAR进行分类,最后只取得92.30%的效果,并且模型训练参数多。文献[13]使用基于其他种类与角度的实测SAR图像的迁移学习(transfer learning,TL)方法。SAR实测图像数据的不足容易造成CNNs模型的过拟合,降低模型的泛化能力。对此,文献[14]中也使用迁移学习,首先利用剪切后的大量SAR场景无标签图像预训练卷积神经网络,但具有不确定性,而且使用编码和解码两部分网络,最后去掉解码的网络,前期增加了训练复杂度。而在文献[15]中则是分别使用卷积层的随机失活(drop-out)方法和数据增广的方法来防止过拟合,最后达到99.13%的识别准确率。

近年来,SAR图像仿真技术的研究使得SAR图像数据得到进一步的补充,它是利用计算机图形学方法结合电磁波散射原理模拟SAR的成像过程,由物体3D模型得到相应的SAR仿真图像。有效的仿真SAR图像能够解决SAR图像不足的现状,为SAR图像目标识别的研究提供了必要的数据支持与补充,在SAR图像的自动识别中有着重要的作用。本研究使用的仿真SAR图像主要是基于SAR图像的回波仿真方法[16-17]得到的坦克等军事车辆的仿真SAR图像数据。其中T72型号坦克的光学图像、3D模型、部分不同角度的实测X波段SAR图像和仿真SAR图像如图 1所示。

|

Download:

|

| 图 1 T72坦克的各类型图像 Fig. 1 Different types of T72 tank images | |

为提升SAR图像稀缺情况下的自动目标识别效果,本文在已有的SAR图像仿真数据基础上,提出一种在基于CReLU(concatenated rectified linear units)激活函数与批归一化改进后的卷积神经网络模型上,结合仿真SAR图像深度迁移学习的方法,先引进仿真SAR图像预训练网络,再迁移到实测的SAR图像数据继续进行训练,结果表明可取得比以往的传统机器学习方法和深度学习方法更好的识别准确率,并且在基于部分稀疏的MSTAR训练数据集上也取得了不错的结果,验证了本文基于仿真SAR图像的深度迁移学习模型在SAR图像稀缺情况的ATR研究的有效性。下文将依次介绍改进的CNNs模型、SAR图像仿真模型、结合仿真SAR图像的深度迁移学习模型以及最终实验结果。

1 基于卷积神经网络的SAR图像分类 1.1 卷积神经网络卷积神经网络一般包括卷积层、激活层、池化层和全连接层。卷积层主要利用局部感受野和参数共享两种策略减少模型的复杂度和参数量,利用多个卷积核对上一特征图(feature map)进行特征提取,再采用激活层对其进行非线性激活,主要计算过程如下:

| $ \left\{\begin{array}{l} y_{i j}^{k}=\sum\limits_{u=1}^{m} \sum\limits_{v=1}^{n} w_{u v}^{k} \cdot x_{i+u-1, j+v-1}+b_{k}, \\ h^{k}=f\left(y^{k}\right). \end{array}\right. $ | (1) |

式中:k表示第k个卷积核;i, j表示像素点的位置;yijk表示由第k个卷积核卷积得到的在i, j位置的结果值;m, n表示的是卷积核的尺寸;wuvk为第k个卷积核在u, v位置的权重;b为偏置项。f(·)为非线性激活函数,常见的非线性激活函数有Sigmoid,tanh函数和ReLU(rectified linear units)函数等。h为通过激活层后输出的特征图。其中ReLU函数的表示式为

| $ \operatorname{ReLU}(x)=\max (x, 0). $ | (2) |

池化层的操作主要是为了缩小特征图,增加感受野,一般采取最大值池化的方法。卷积神经网络主要结构和具体操作过程如图 2所示,图中z表示经过池化层缩小后的特征图。

|

Download:

|

| 图 2 CNNs结构 Fig. 2 CNNs model | |

全连接层的作用主要是将上一层的提取到高维的数据置为一维向量作为输入,同时最终输出的节点数量为分类目标的类别数。本研究使用由Softmax归一化的结果作为10类军事目标类别的概率输出。

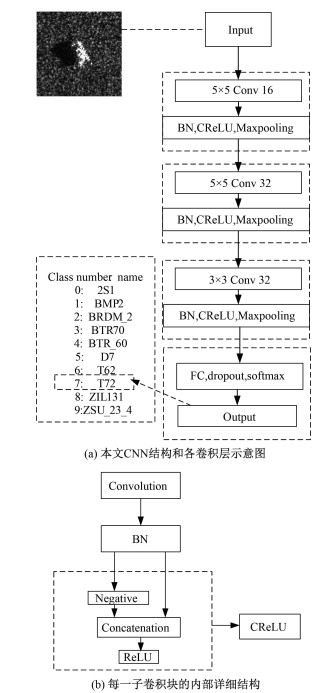

1.2 用于目标识别的卷积神经网络模型由于实测SAR图像数据量有限,更深层次和复杂的网络较容易造成CNNs模型的过拟合,同时为研究使用基于仿真SAR图像迁移学习带来的提升效果,本文中的模型只使用简易有效的3层卷积神经网络。具体的网络结构示意图如图 3(a)所示。

|

Download:

|

| 图 3 本文CNNs模型 Fig. 3 CNNs model in this work | |

本文在构建的网络模型上,使用改进后的CReLU(concatenated ReLU)激活函数[18]代替常用的ReLU函数,在激活层后能够多保留负响应部分的特征图,与ReLU相比,多提取一倍的特征图。若定义[·]+=max(·, 0),则CReLU激活函数的定义为

| $ \operatorname{CReLU}(x)=\left([x]_{+}, [-x]_{+}\right). $ | (3) |

为了减少运算的复杂度和弱化背景杂波的影响,把SAR图像中心剪切成80×80。在前两层的网络结构中,使用5×5的卷积核增加感受野提取有效的特征,之后每个卷积层后均采用2×2大小的最大值池化层下采样图像,在得到更小的特征图并将特征汇聚到更高维度空间后,使用VGG网络的思想在最后一层用3×3的卷积核。

此外,为了加速网络的收敛,本文新加入批归一化层(batch normalization,BN)[19]使得每一层数据归一化到标准高斯分布,从而能够使得梯度更好地反向传播来优化网络,加快模型的收敛速度。组合后的每一子卷积块的内部详细结构如图 3(b)所示。

1.3 CNN的初始化,损失函数和优化方法CNNs中一般使用常数值、Xavier[20]等方式初始化网络参数,但由于传统的初始化方式在深层的网络中收敛比较困难,Xavier初始化方式并不太适用于CReLU等激活函数,故本文使用基于MSRA[21]初始化方式。其初始化方式表示如下

| $ \text { weights } \sim N\left(0, \frac{2}{n_{l}}\right). $ | (4) |

式中:weights表示卷积核的参数分布;N(0, 2/nl)表示服从均值为0,方差为2/nl的高斯分布;其中nl=kl2dl-1,kl表示第l层卷积核尺寸大小,dl-1表示l-1层卷积核的层数。在损失函数的选择上,本文使用交叉熵的损失函数,Softmax函数和交叉熵如下所示:

| $ \left\{\begin{array}{l} o_{i}=\frac{\exp \left(x_{i}\right)}{\sum_{k=0}^{N} \exp \left(x_{k}\right)}, \\ L(\omega, o)=-\sum_{i=1}^{N} y_{i} \ln \left(o_{i}\right). \end{array}\right. $ | (5) |

式中:xi表示输出层第i个节点的输出,oi表示经过概率归一化后的概率值,N为类别数,yi为对应的样本标签,L为最后的交叉熵损失。对于优化方法则采用结合动量(momentum)与RMSProp方法的Adam[22]算法优化损失函数,采取反向梯度传播更新权重。Adam参数的学习率能够根据梯度的一阶矩和二阶矩估计来自适应改变,从而能更好地优化深层网络参数,其定义为:

| $ \left\{ \begin{array}{*{35}{l}} {{g}_{t}}={{\nabla }_{\omega }}{{L}_{t-1}}\left( {{\omega }_{t-1}} \right), \\ {{m}_{t}}={{\beta }_{1}}\cdot {{m}_{t-1}}+\left( 1-{{\beta }_{1}} \right)\cdot {{g}_{t}}, \\ {{v}_{t}}={{\beta }_{2}}\cdot {{v}_{t-1}}+\left( 1-{{\beta }_{2}} \right)\cdot g_{t}^{2}, \\ {{{\hat{m}}}_{t}}={{m}_{t}}/\left( 1-\beta _{1}^{t} \right), \\ {{{\hat{v}}}_{t}}={{v}_{t}}/\left( 1-\beta _{2}^{t} \right), \\ {{\omega }_{t}}={{\omega }_{t-1}}-\alpha \cdot {{{\hat{m}}}_{t}}/(\sqrt{{{{\hat{v}}}_{t}}}+\varepsilon ). \\ \end{array} \right. $ | (6) |

式中:gt为梯度计算值;ω为模型中需要学习的参数;mt为有偏一阶矩;vt为有偏二阶矩;

| 训练算法:基于Mini-Batch(小批次的)反向梯度下降算法来优化改进的卷积神经网络. |

| 1)输入: SAR图像的数据xi和对应的类别标签yi,学习率和模型参数的初始化,最大迭代步数K和批尺寸(Batch size) n. |

| 2)输出:测试SAR图像类别的CNNs模型. |

| 3)for step=1, 2, …, K |

| 从随机打乱后的SAR数据集中依次取出n张图片及其标签{(x1, y1), (x2, y2), …, (xn, yn)} |

| 使用Adam算法优化参数 |

| 循环迭代到结束. |

SAR图像回波仿真技术根据SAR的成像原理,由复杂目标的3D模型,采用电磁散射计算的方法得到扫频数据,再使用成像算法处理回波数据来实现SAR成像,使得成像结果更接近真实SAR图像。常使用弹射线法(shooting and bouncing ray, SBR)结合几何光学法(geometrical optics, GO)或者物理光学(physical optics, PO)等方法对目标模型面元的散射截面积(radar cross section, RCS)进行计算。运用电磁仿真软件CST[17]或者FEKO可以用来生成三维目标的远场复RCS数据,之后通过坐标轴转换、重采样、加窗、补零后再做逆傅里叶变换得到SAR图像。其扫频的频率间隔和角度间隔可根据实测SAR图像的方位向和距离向分辨率得到。各参数的定义如下:

| $ \left\{ \begin{array}{*{35}{l}} B=\frac{c}{2\Delta {{\rho }_{r}}}, \\ \Delta \phi =\frac{\lambda }{2\Delta {{\rho }_{x}}}, \\ {{f}_{\text{H}}}=f+B/2, \\ {{f}_{\text{L}}}=f-B/2. \\ \end{array} \right. $ | (7) |

式中:Δρr为距离向分辨率;Δρx为方位向分辨率;f为中心频率;B为带宽;Δϕ为角度区间;fH和fL分别为频率区间的上界和下界,具体的成像处理步骤如图 4所示。

|

Download:

|

| 图 4 SAR图像仿真流程 Fig. 4 Flow chart of simulation of SAR images | |

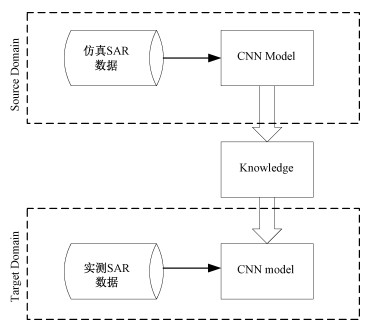

现实中由于SAR图像数据获取成本高、数据稀缺,不易获取足够多的训练数据来训练网络。同时因为仿真SAR图像与实测SAR图像可能存在类别不一样和特征上的差别,无法将其直接作为训练数据。迁移学习[14]能有效解决训练数据不足的问题,迁移学习主要从源数据域(source domain)学到有效的规则与知识(knowledge),通过将学到的隐知识运用在目标域(target domain)上,提升分类器在目标域上的分类性能。迁移学习的示意图如图 5所示。在本研究中,大量的仿真SAR图像数据集作为源数据域,实测SAR数据为目标域。先在源数据域上让卷积神经网络学到有用的知识与模型,再迁移到目标域上。由于本文的CNNs模型只有3层,层数比较少,故在迁移学习过程中采用微调(fine-tuning)所有参数的方法,先在源域即仿真SAR图像上训练分类网络,再在学到的参数基础上继续使用实测SAR图像数据训练网络,更新全部参数,从而得到最终的模型。

|

Download:

|

| 图 5 基于仿真图像的迁移学习过程 Fig. 5 Transfer learning based on simulated images | |

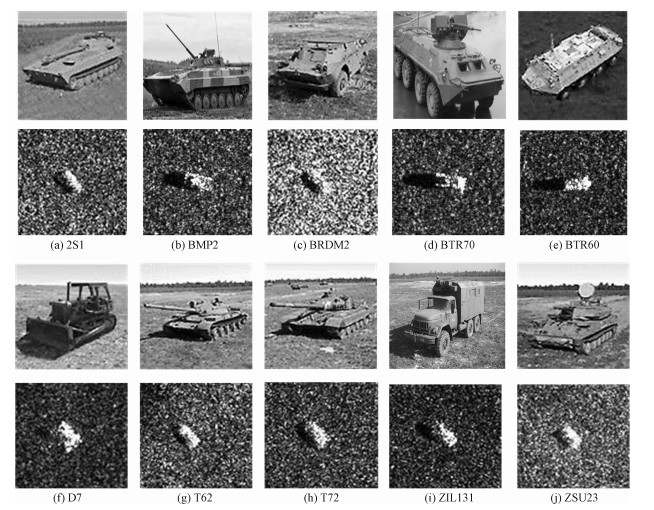

为了验证基于仿真SAR图像深度迁移学习算法的有效性,本文使用的实测数据为MSTAR实测的X波段10类军事目标(装甲车,坦克,军用卡车等)的SAR图像,其在方位向和距离向的分辨率都是0.3 m。具体军事目标SAR图像数据与类别数据如表 1所示,10类军事目标的光学图像与SAR图像如图 6所示。按照文献[3, 12]的标准划分方法,训练和测试数据分别为俯仰角为17°和15°的数据。在仿真SAR图像数据的使用上,则采用基于SARSIM仿真[17]得到的7大类车辆目标的仿真SAR图像和基于快速回波仿真方法[16]得到的相似性高的T72,BMP和BTP 3种军事目标的SAR图像数据。前者基于SARSIM仿真算法的实现过程中使用电磁商用软件CST先求得三维物体目标的RCS复数据,之后使用逆FFT得到时域图像同时结合GPU并行的方法以缩短计算时间,其公开的仿真数据集[17]的具体的类别数如表 2所示。在此研究基础上,本文的最终模型新加入后者基于快速回波仿真方法得到的3类SAR仿真图像数据,每类360张,共有1 080张,其数据由文献[16]作者提供。

|

|

表 1 MSTAR数据 Table 1 MSTAR data |

|

Download:

|

| 图 6 10类军事目标光学图像与SAR图像 Fig. 6 Optical images and SAR images for ten types of military targets | |

|

|

表 2 SARSIM数据 Table 2 SARSIM data |

本文研究的实验环境为ubuntu16.04+tensorflow1.6+GTX1050Ti。实验过程中采用的批尺寸为n=256,并且在全连接层使用随机失活(drop-out)策略减缓模型的过拟合。为了验证本文构建的CNNs模型的有效性,本研究先分别在作为基准的ReLU与改进后的CReLU激活函数的网络上只使用实测SAR图像数据进行实验,采取全部的俯仰角为17°的SAR数据作为训练数据,使用MSRA方法初始化卷积核与全连接层权重从零基础开始训练模型至收敛,在15°的测试数据上分别取得98.78%(3 164/3 203)与99.53%(3 188/3 203)的识别结果,表明本文使用CReLU后对CNNs模型结果有一定的提升效果。

为了研究在同种类别上直接将仿真SAR图像作为训练数据,实测SAR数据作为测试数据的结果,本研究先直接将T72,BMP和BTP 3种军事目标的1 080张仿真SAR图片作为训练集训练CNN分类网络,并在俯仰角为15°的实测T72,BMP和BTP 3种图像上测试识别准确率,最终只取得36.53%的结果。其准确率不高,说明直接将仿真SAR图像数据作为训练集并不能取得很好的识别结果。

4.2.2 基于微调(fine-turning)迁移学习模型的结果接下来实验研究使用基于仿真SAR图像深度迁移学习的结果。在迁移学习过程中,分别实验了把仿真SAR图像划分为7类(只使用SARSIM中的7大类)和8类(基于快速回波仿真方法得到的1 080张SAR图像单独归为一类和SARSIM中的7大类)两种情况。先把图 3的CNNs网络最后输出层的节点数分别替换为仿真SAR图像类别数,其他结构模型保持不变。先使用仿真SAR图像训练网络至收敛,得到训练后的卷积核权重参数。在此基础上把输出层节点改为实测军事目标种类,继续使用实测SAR图像训练网络,在图像没有其他预处理的情况下,最终能将识别率提升到99.60%(3 196/3 203)与99.78%(3 196/3 203),其中后者最终的10类军事目标识别准确率的混淆矩阵如表 3所示。

|

|

表 3 基于仿真SAR图像迁移学习的CNN模型在MSTAR测试集分类结果的混淆矩阵 Table 3 Confusion matrix of classification results based on transfer learning CNNs model in the MSTAR test set |

本文模型与其他模型如支持向量机[3]、稀疏编码模型[4]、基于大场景图像迁移学习模型[14]、同样引进由SARSIM仿真SAR图像数据预训练迁移学习的CNNs模型[11]和使用数据增广的CNN分类方法[15]等方法的结果如表 4所示。与同样基于SIMSAR等7类数据预训练下的文献[11]模型相比,本文的识别准确率提高到99.60%,表明本研究的深度学习模型的有效性。同时再加入文献[15]的1 080张SAR仿真数据后,在此基础上模型结果提升到99.78%。从表 4可以看出,在分类任务上,在全部17° SAR图像作为训练集时,本文基于CReLU改进的迁移学习模型相比其他模型的分类结果能取得更好的分类性能。

|

|

表 4 不同模型方法的比较 Table 4 Comparison among different model methods |

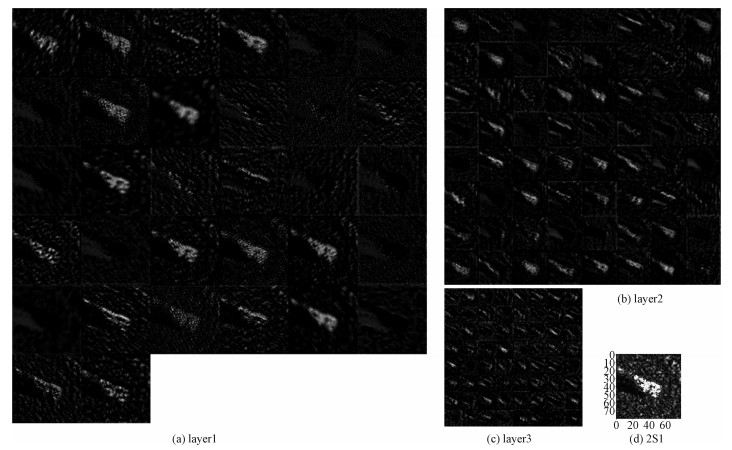

为可视化CNNs模型内部提取到的特征,实验中以2S1型号的坦克车作为输入图像为例,基于8类仿真SAR图像深度迁移学习模型的3层卷积层在经过CReLU激活函数后分别提取到的特征图如图 7所示。从图 7(a)~7(c)可以看出,不同尺度和层数的卷积核能提取到原图像的背景、目标、轮廓等不同区域的整体特征。

|

Download:

|

| 图 7 CNNs中3层激活层输出的特征图与输入的SAR图像(2S1) Fig. 7 The feature images of the three-layer outputs in CNNs and the input SAR images (2S1) | |

为了研究在实测SAR图像数据量比较稀缺的情况下,本文模型的提升结果。研究中在各个类别上抽取10%,20%,40%,60%,80%和全部的训练集图像的情况下,分别使用基于ReLU的CNNs模型、基于CReLU的CNNs模型、以及基于CReLU的仿真SAR图像迁移学习模型(CReLU+TL)测试最后的结果。在使用基于仿真SAR图像的迁移学习时,也分别实验了基于SIMSAR 7类数据的情况与加入文献[16]仿真图像后的共8类数据两种情况。其中4种模型在全部15°测试集上的最终结果如图 8所示。可以看出在不同比例的训练数据上,使用CReLU比ReLU的CNNs模型的结果都有一定的提升;在结合使用仿真SAR图像迁移学习后,识别准确率在原有的CReLU模型基础上有更进一步的提高。特别是在数据比较稀少的情况下(如10%和20%),使用基于仿真SAR图像深度迁移学习的方法后识别准确率会提升得更明显,验证了本文基于CReLU的CNNs模型的有效性。同时再加入文献[16]的1 080张SAR仿真数据后,在此基础上模型结果再有一定的提升。

|

Download:

|

| 图 8 不同比例训练集的结果 Fig. 8 Results of different scale training sets | |

本研究在针对运用深度学习方法研究SAR的自动目标识别时,实测SAR图像数据不足的问题,使用一种基于仿真SAR图像的深度迁移学习和基于CReLU改进的卷积神经网络的解决方案。先用大量的仿真SAR图像预训练网络模型,得到初步网络参数后,再在预训练好的模型的基础上继续使用实测SAR图像数据训练网络,最终能在不同比例的训练集上都取得一定的提升,并且在使用全部训练集时候取得99.78% (3 196/3 203)的识别准确率。该模型即便在只用20%的训练数据的情况依旧可以取得93.79%的识别率,从而验证了模型同样适用于数据稀缺的场景,并且在数据较稀缺的情况下对识别准确率的提升比较明显。

在此十分感谢电磁散射重点实验室董纯柱博士提供的回波仿真SAR图像数据。| [1] |

Cummimg I, Wong F. 合成孔径雷达成像:算法与实现[M]. 北京: 电子工业出版社, 2012: 2-11.

|

| [2] |

Mcnairn H, Brisco B. The application of C-band polarimetric SAR for agriculture:a review[J]. Canadian Journal of Remote Sensing, 2004, 30(3): 525-542. Doi:10.5589/m03-069 |

| [3] |

Ross T D, Worrell S W, Velten V J, et al. Standard SAR ATR evaluation experiments using the MSTAR public release data set[C]//Algorithms for Synthetic Aperture Radar Imagery V. Orlando, United States: International Society for Optics and Photonics, 1998, 3370: 566-574.

|

| [4] |

Anagnostopoulos G C. SVM-based target recognition from synthetic aperture radar images using target region outline descriptors[J]. Nonlinear Analysis:Theory, Methods & Applications, 2009, 71(12): e2934-e2939. |

| [5] |

Song S, Xu B, Yang J. SAR target recognition via supervised discriminative dictionary learning and sparse representation of the SAR-HOG feature[J]. Remote Sensing, 2016, 8(8): 683. Doi:10.3390/rs8080683 |

| [6] |

Park J I, Kim K T. Modified polar mapping classifier for SAR automatic target recognition[J]. IEEE Transactions on Aerospace and Electronic Systems, 2014, 50(2): 1092-1107. Doi:10.1109/TAES.2013.120378 |

| [7] |

Krizhevsky A, Sutskever I, Hinton G E. ImageNet classification with deep convolutional neural networks[C]//Advances in neural information processing systems. Nevada, USA: Curran Associates Inc, 2012: 1097-1105.

|

| [8] |

Schmidhuber J. Deep learning in neural networks:an overview[J]. Neural Networks, 2015, 61: 85-117. Doi:10.1016/j.neunet.2014.09.003 |

| [9] |

Szegedy C, Liu W, Jia Y, et al. Going deeper with convolutions[C]//IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE Computer Society, 2015: 1-9.

|

| [10] |

He K, Zhang X, Ren S, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE Computer Society, 2016: 770-778.

|

| [11] |

Malmgren-Hansen D, Kusk A, Dall J, et al. Improving SAR automatic target recognition models with transfer learning from simulated data[J]. IEEE Geoscience and Remote Sensing Letters, 2017, 14(9): 1484-1488. Doi:10.1109/LGRS.2017.2717486 |

| [12] |

Morgan D A E. Deep convolutional neural networks for ATR from SAR imagery[C]//Algorithms for Synthetic Aperture Radar Imagery XXII. Maryland, United States: International Society for Optics and Photonics, 2015, 9475: 94750F.

|

| [13] |

李松, 魏中浩, 张冰尘, 等. 深度卷积神经网络在迁移学习模式下的SAR目标识别[J]. 中国科学院大学学报, 2018, 35(1): 75-83. |

| [14] |

Huang Z, Pan Z, Lei B. Transfer learning with deep convolutional neural network for SAR target classification with limited labeled data[J]. Remote Sensing, 2017, 9(9): 907. Doi:10.3390/rs9090907 |

| [15] |

徐丰, 王海鹏, 金亚秋. 深度学习在SAR目标识别与地物分类中的应用[J]. 雷达学报, 2017, 6(2): 136-148. |

| [16] |

董纯柱, 胡利平, 朱国庆, 等. 地面车辆目标高质量SAR图像快速仿真方法[J]. 雷达学报, 2015, 4(3): 351-360. |

| [17] |

Kusk A, Abulaitijiang A, Dall J. Synthetic SAR image generation using sensor, terrain and target models[C]//Proceedings of EUSAR 2016: 11th European Conference on Synthetic Aperture Radar. Hamburg, Germany: VDE, 2016: 1-5.

|

| [18] |

Shang W, Sohn K, Almeida D, et al. Understanding and improving convolutional neural networks via concatenated rectified linear units[C]//International Conference on Machine Learning. New York: ICML, 2016: 2217-2225.

|

| [19] |

Ioffe S. Batch renormalization: Towards reducing minibatch dependence in batch-normalized models[C]//Advances in Neural Information Processing Systems. Long Beach: NIPS, 2017: 1945-1953.

|

| [20] |

Glorot X, Bengio Y. Understanding the difficulty of training deep feedforward neural networks[C]//Proceedings of the Thirteenth International Conference on Artificial Intelligence and Statistics. Sardinia: AISTATS, 2010: 249-256.

|

| [21] |

He K, Zhang X, Ren S, et al. Delving deep into rectifiers: Surpassing human-level performance on imagenet classification[C]//Proceedings of the IEEE International Conference on Computer Vision. Washington, DC, USA: IEEE Computer Society, 2015: 1026-1034.

|

| [22] |

Vaswani A, Shazeer N, Parmar N, et al. Attention is all you need[C]//Advances in Neural Information Processing Systems. Long Beach, NIPS, 2017: 5998-6008.

|

2020, Vol. 37

2020, Vol. 37