2. 中国科学院大学, 北京 100049

2. University of Chinese Academy of Sciences, Beijing 100049, China

随着中国空间信息技术的快速发展,高分辨率遥感影像数据急剧增加,为土地变换监测、自然灾害监测、地理数据获取、资源调查、精准农业等众多领域的发展提供了可靠的数据支持[1]。相对于中低分辨率遥感影像,高分辨率遥感影像降低了混合像元问题,提供了更丰富的地物几何结构和纹理信息[2]。但其自身髙度细节化,场景空间和结构模式高度复杂,导致影像自动解译的难度增加,精细化的实际业务中仍然以人工目视解译为主,缺乏自动化程度较高的工作方式。然而,遥感影像的目视解译,需要目视判读者具有丰富的地学知识和目视判读经验,信息获取周期长,图像的解译质量多取决于判读者的经验及其对区域的熟悉程度,众多专家学者也在研究各种自动化解译高分辨率遥感影像、提取影像信息的方法[3]。

在农业遥感领域,准确提取耕地地块边缘对农作物分类、估产等具有重大科研价值和经济价值[4-5]。研究人员提出多种分割方法以便捷地获取规整、匀质的地块[6-8],但由于欠分割、过分割等问题的存在,较多研究人员选择通过边缘检测的方式获取耕地边缘,以对分割结果进行约束,提高结果精度。Rydberg和Borgefors[9]对SPOT影像中的研究区域先通过Canny算子检测得到边缘后,将边缘结果用作迭代自组织数据分析方法(iterative self organizing data analysis techniques algorithm,ISODATA)分割算法的部分条件,得到较为精准的地块分割结果。胡潭高等[10]同样选择对分水岭分割后的图像,引入Canny边缘信息,以完成图像重构,得到最终分割结果。以Canny算子为首的经典边缘检测方法多涉及将图像与运算符(二维滤波器)进行卷积,利用图像中的亮度、颜色和纹理等局部线索或其他人工设计的特征,如Pb[9]、gPb[10]、Sketch tokens[11]等,进行边缘和非边缘的像素分类。然而,此类方法由于结构较为简单,没有包含对象级别信息,不能充分利用影像隐含信息,容易出现漏检、误检现象,尤其对于复杂场景的检测结果往往难以满足实际需求。

近年来,在图像分类[12-14]、目标检测[15]、语义分割[16-18]等众多领域,基于深度学习的相关算法取得重大突破。边缘检测方面,最新研究成果HED(holistically-nested edge detection)[19]、RCF(richer convolutional features)[20]在各大数据集上均取得接近人工的表现。由于遥感影像的大数据量特性,能够很好地满足深度学习模型训练过程的样本需求,深度学习方法在遥感影像的应用愈发引起重视,并在目标检测[21]、土地分类等方面取得显著成效[22-23]。对比传统经典算法,众多研究表明深度学习方法能够通过层间自主学习,由浅到深,生成简单到复杂的多层次特征检测器,更充分地利用影像信息,实现对复杂场景更好的检测效果[24]。

针对遥感影像中人工目视解译地块边缘耗时费力这一问题,本文将自然图像领域最新提出的边缘检测算法HED、RCF应用于高分辨率遥感影像,以像素级耕地边缘检测为例,比较两者检测精度,并对相关网络结构进行优化,构建性能表现更加优异的边缘检测模型,以期在遥感影像中取得更佳的耕地地块边缘检测效果。

1 研究方法实验技术流程简述如下:

1) 基于高分一号遥感影像,通过人工目视解译的方式,勾绘地块边缘,建立训练集、测试集;

2) 复现HED与RCF模型,构建FD-RCF网络,并通过训练集以梯度下降的方式完成模型训练;

3) 对模型检测结果进行非极大值抑制处理,以细化边缘检测结果;

4) 对非极大值抑制(non-maximum suppression, NMS)处理后的检测结果进行精度评定;

5) 依照精度评定结果,选取数据集尺度最佳(optimal dataset scale, ODS)对应阈值,对NMS细化后的边缘结果进行二值化处理;

6) 加入Canny算法所得地块边缘二值图作为对比。

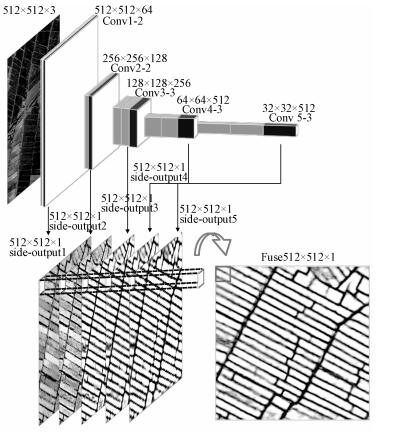

1.1 HEDHED基于全卷积网络和深度监督网络思想,直接完成端到端,即图像到图像的映射。其采用VGG16的网络结构进行修改,如图 1所示:

|

Download:

|

| 图 1 HED结构图 Fig. 1 Structure of HED | |

1) 移除第5层池化层和所有的全连接层;

2) 将conv1_2, conv2_2, conv3_3, conv4_3, conv5_3的特征图进行转置卷积, 然后通过合并层进行连接,最后添加1×1的卷积核进行加权融合。

其核心理念在于,对网络各层(conv1_2, conv2_2, conv3_3, conv4_3, conv5_3)的特征值进行转置卷积恢复原图大小,进而与标签计算损失,进行反向传播。最终,对网络各层的特征值进行加权融合,得到融合的边缘检测结果,即

| $ {{\mathit{\pmb{\hat{Y}}}}_{\text{fuse}}}=\sum\limits_{k=1}^{5}{{{w}_{k}}\mathit{\pmb{\hat{Y}}}_{\text{side}}^{(k)}}, $ | (1) |

式中:

对比HED模型,RCF的改进策略更为直接:既然不同卷积层之间信息互补,只使用池化前最后一层卷积层的特征值,依旧损失了层内其他卷积层特征值的有效信息。因此,对每层中卷积层的特征值在层内先通过和运算并转置卷积得到

边缘检测问题中,对影像的每个像素而言,其实是个判断当前像素所属为边缘/非边缘的二分类问题。同时,由于一幅影像中边缘与非边缘像素数量比可达1:9左右,训练过程中正负样本分布极不平衡。从线宽角度考虑,理想的边缘线宽仅为1像素,这又是一个小目标性质的问题。源自于此,RCF与HED在设计过程中,多采用特征分层的思想,以保证模型在训练过程中,能够充分进行多尺度、多层次的特征学习。但对于深层卷积而言,仍旧存在着因多次池化导致的位置信息损失问题。

基于RCF、HED的设计思路与存在问题,本文进一步提出构建深度学习模型full dilated-RCF,其结构如图 2所示,相对RCF网络结构,其变化主要集中在3个方面:

|

Download:

|

| 图 2 FD-RCF结构 Fig. 2 Structure of FD-RCF | |

1) 移除第3和第4池化层,并将主干网络中后续卷积层更换为空洞卷积, 以缓解多层池化带来的深层次特征图分辨率过低、损失位置信息过多的问题。同时,空洞卷积相对于普通卷积能够通过设置不同的空洞值,灵活调节当前特征值的感受野。在同等网络深度下,空洞卷积往往能够提供更大的感受野,以更好地学习到多尺度、多层次的特征,并保留位置相关信息。

2) 将对应VGG16中stage4与stage5部分的6层卷积,重新划分为各包含2层空洞卷积的stage4、stage5和stage6三部分,并采取与VGG16相似的策略,将stage4、stage5和stage6中的空洞卷积设置为stage内空洞值相同、stage间空洞值倍增的形式,以进行更丰富的多尺度特征学习。

3) 将每层中的和运算替换为合并运算,以便将各卷积层的特征值进行独立保留,进而配合其后的1×1卷积核,加权融合得到

训练过程中,对应各stage的

| $ l(\mathrm{X};\mathrm{W})=\left\{ \begin{align} & -\beta \sum\limits_{j\in {{Y}_{+}}}{\log \Pr ({{y}_{j}}=1\left| \mathrm{X};\mathrm{W}, {{w}_{k}}), \right.} \\ & -\alpha \sum\limits_{j\in {{Y}_{-}}}{\log \Pr ({{y}_{j}}=0\left| \mathrm{X};\mathrm{W}, {{w}_{k}}). \right.} \\ \end{align} \right. $ | (2) |

| $ \begin{align} & \alpha =\lambda \left| {{Y}_{+}} \right|/\left| {{Y}_{+}} \right|+\left| {{Y}_{-}} \right|, \\ & \beta =\left| {{Y}_{-}} \right|/\left| {{Y}_{+}} \right|+\left| {{Y}_{-}} \right|. \\ \end{align} $ | (3) |

式中:λ作为超参数进一步平衡边缘、非边缘造成的正负样本分布不平衡的训练集问题,

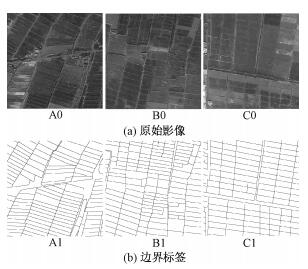

实验过程中,使用高分辨率遥感卫星高分一号融合后的多光谱影像,试验区位于塔里木盆地的阿克苏地区。阿克苏市光热资源丰富,耕地全部为水浇地,具有典型绿洲地貌和灌溉农业的特征。影像成像时间为2015年9月24日,空间分辨率达到2 m,选用3,2,1波段,以便于进行迁移学习。部分训练数据如图 3所示。

|

Download:

|

| 图 3 训练集样例 Fig. 3 Examples of original images and boundary labels | |

1) 数据准备阶段,首先将获取到的影像导入ArcGIS中,通过人工解译,完成耕地地块边缘的矢量化。之后,导出JPEG格式影像和PNG格式边缘二值图(边缘为1,非边缘为0)。

2) 考虑到训练效率和显存限制,进一步将得到的JPEG影像和PNG边缘图片逐行裁剪为512像素×512像素大小的子集,最终获得114对影像和边缘。其中,随机选择25对用作测试,其余89对用于训练。

3) 训练集数据的丰富程度对模型的训练效果具有很大影响。为保证训练效果,进一步采用中心旋转、镜像翻转等方式,对训练数据进行数据增强处理,最终扩充获得623对影像作为训练集,用于模型训练。

2.2 实验设置文中提到的深度学习网络模型均在开源框架Caffe下进行实现。由于样本数量有限,在训练过程中采用迁移学习的方式,使用在ImageNet上表现优异的VGG16模型,对各网络中对应层参数进行初始化,对于新添加卷积层采用均值为0、方差为0.01的高斯分布完成初始化,偏差初始化为0。

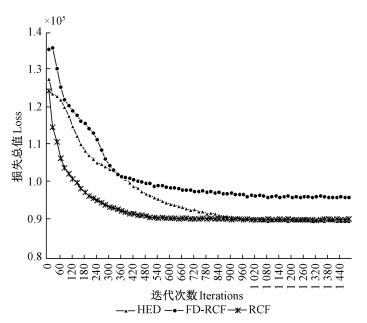

训练过程,统一使用小批量随机梯度下降法(mini-batch SGD),设置初始学习率为1e-8,每迭代500次下降为原来的0.1,学习动量0.9。由于显存限制,HED模型批处理大小设置为8,RCF批处理设置为7,FD-RCF批处理设置为5,最大迭代次数1 500次,训练过程随迭代次数的目标函数损失值如图 4所示。需注意,由于FD-RCF模型的目标函数较RCF、HED多考虑一层stage的损失,其损失值将大于RCF、HED的损失值。实验使用GTX TITAN X GPU,在同一服务器上完成。

|

Download:

|

| 图 4 随训练迭代次数变化的损失值 Fig. 4 Variation in train losses with iterations | |

模型精度验证中,选择迭代次数1 000次时,稳定收敛的模型进行精度评定以及地块边缘提取,训练过程中损失随迭代次数变化如图 4所示。使用准确率P和召回率R作为模型性能评判标准,准确率代表模型检测结果的边缘中正确边缘的占比,即检测结果的边缘中正确边缘像素数比检测结果的边缘像素数,召回率为检测结果中正确边缘在真实边缘中的占比,即检测结果的边缘中正确边缘像素数比真实边缘像素数。

精度评定前,需对各模型输出结果进行NMS处理,以细化检测边缘。关于精度评定方法,采用计算机图像处理中被广泛采用的文献[11]提出的边缘检测精度评定方法,设置匹配阈值为0.007 5。该方法中,对影像标签中的每个边缘像素与计算结果对应位置的像素进行比对,在阈值距离内则判定该位置处像素检测正确,超出阈值则判定该位置处像素检测为错误。

通过模型获得的边缘输出,需要确定某个阈值转为二值图。计算机图像相关研究中,通常采用两种评判模式:数据集尺度最佳ODS和图像尺度最佳OIS。前者指对整个数据集中图像采用同一阈值进行二值化,后者为对每张图像寻找最适合的阈值进行二值化。使用F1作为评判标准,值越高,则模型效果越好:

| $ {{F}_{1}}=\frac{2PR}{P+R}. $ | (4) |

由表 1可以看出:1)相较于Canny算法,基于深度学习的边缘检测模型精度提升巨大,构建的FD-RCF网络在精度评定中几乎领先Canny算法10个百分点。2)HED网络在遥感影像中表现优于RCF网络,不仅检测结果在ODS、OIS中的F 1值分别领先0.67、0.57个百分点,平均精度(AP)领先1.86个百分点,而且由于网络中参数更少,检测速度更快,检测速度可以达到每秒将近21张512像素×512像素大小的影像。RCF在遥感影像中这种异常表现推测源自于采用单纯的和运算融合层内特征值作为该层检测结果时,可能由于层内某些层激活结果不佳,拉低该stage检测结果表现,最终影响融合后模型的整体表现。3)构建的FD-RCF网络在检测精度上取得更佳表现,在ODS、OIS中的F1值相对RCF网络分别提升3.3、3.16个百分点,平均精度提升3.7个百分点,超越HED网络的表现。这在一定程度上论证了对RCF网络的上述猜测。4)采取merge策略,以网络1~5层的检测结果和融合输出的fuse结果的均值作为最终的模型检测结果,一定程度上对结果有改善作用。5)采取多尺度(multiscale, ms)策略,即对原始影像分别进行缩放获得3层金字塔影像,将3层影像分别输入模型得到各自检测结果后,对3层影像的fuse检测结果求均值作为最终的模型检测结果,对结果并没有改善作用,反而导致检测精度下降。6)检测效率方面,相较于HED与RCF模型,构建的FD-RCF模型由于网络结构更加复杂,引入了更多参数,检测速度有所下降,但依然能够实现每秒检测将近14张512像素×512像素大小的影像。相较于传统方式中导入GIS软件人工目视解译勾绘,速度提升巨大。

|

|

表 1 各方法精度F1对比 Table 1 Comparison among different methods |

分析表 2可知:1)相较于深度学习类边缘检测模型,经典检测算法Canny在取得最佳F1值时,具有更高的召回率,但准确率较差,总体细节较丰富,但存在较多错检。2)各网络模型在ODS与OIS两种判别方式中各取得最佳F1值时,相对于HED和RCF网络,FD-RCF网络的准确率和召回率均有明显提升。3)ms策略中,将原始影像构建影像金字塔进行检测,最终对不同分辨率下的检测结果融合的方式,能够更好地检测影像细节,降低漏检情况的发生,但也增大了误检几率。

|

|

表 2 最佳F1值下的准确率与召回率 Table 2 The precision and recall rate at the best F1 value |

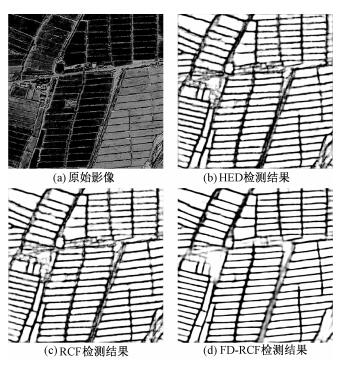

得益于更高的检测精度,相对HED与RCF模型的检测结果,构建的FD-RCF模型结果整体画面更为干净,因错检导致的不必要阴影大幅减少,毛刺问题也一定程度上得到遏制。对模型输出结果进一步经过NMS处理完成细化并根据ODS阈值完成二值化后,噪点和图斑问题也得到大幅改善。模型输出结果如图 5所示。

|

Download:

|

| 图 5 模型输出结果对比 Fig. 5 A comparison of outputs from different methods | |

对比人工解译勾绘的耕地地块边缘与模型检测结果,可以看到,针对地物单一明确的区域,深度学习类模型能够较好地完成对耕地地块的边缘检测,但对于部分地物复杂区域,由于存在其他相似性地物的强烈干扰,检测结果仍不可避免地混入噪声。此类错误在图上主要表现为:独立噪点、误检图斑、毛刺等。但是,相较于Canny算法,HED、RCF、FD-RCF模型均已经极大减少检测结果中上述问题的发生,又以FD-RCF模型取得最佳检测效果。各方法二值化结果如图 6所示。

|

Download:

|

| 图 6 二值化结果对比 Fig. 6 Comparison of binarization outputs | |

针对农业遥感中,耕地地块人工解译耗时费力,影像分割易出现过分割、欠分割现象等问题,本文探讨将深度学习中的边缘检测算法应用于检测高空间分辨率遥感影像中耕地地块边缘的有效性,结论如下:1)HED、RCF等基于深度学习的边缘检测算法,能够较好地实现高分辨率遥感影像的耕地地块边缘检测,其检测精度F1值均能达到0.8以上;2)构建的全加权融合空洞FD-RCF网络对耕地地块边缘的检测结果,在ODS、OIS的F1值分别达到0.848 1、0.850 2,平均精度0.795 7,取得最佳表现效果;3)构建原始影像图像金字塔,将不同分辨率的影像输入模型进行地块边缘检测,对不同分辨率的影像检测结果进行融合,能够更好地检测影像细节,降低漏检情况的发生,但也增大了误检几率。

对比模型检测结果与人工勾绘的耕地地块边缘,在地物复杂地区,由于存在较严重的相似性干扰,检测结果仍存在部分噪声与拓扑问题,亟待处理解决。如何根据拓扑关系完成去噪等后处理操作或带有拓扑约束条件的检测,将作为后续研究的重点。

| [1] |

李德仁. 论21世纪遥感与GIS的发展[J]. 武汉大学学报(信息科学版), 2003, 28(2): 127-131. |

| [2] |

杜凤兰, 田庆久, 夏学齐, 等. 面向对象的地物分类法分析与评价[J]. 遥感技术与应用, 2004, 19(1): 20-23. Doi:10.3969/j.issn.1004-0323.2004.01.005 |

| [3] |

宫鹏, 黎夏, 徐冰. 高分辨率影像解译理论与应用方法中的一些研究问题[J]. 遥感学报, 2006, 10(1): 1-5. |

| [4] |

Yang M D, Huang K S, Kuo Y H, et al. Spatial and spectral hybrid image classification for rice lodging assessment through UAV imagery[J]. Remote Sensing, 2017, 9(6): 583. Doi:10.3390/rs9060583 |

| [5] |

Liu W, Dong J, Xiang K, et al. A sub-pixel method for estimating planting fraction of paddy rice in Northeast China[J]. Remote Sensing of Environment, 2018, 205: 305-314. Doi:10.1016/j.rse.2017.12.001 |

| [6] |

Ryherd S, Woodcock C. Combining spectral and texture data in the segmentation of remotely sensed images[J]. Photogrammetric Engineering and Remote Sensing, 1996, 62(2): 181-194. |

| [7] |

Mitra P, Shankar B U, Pal S K. Segmentation of multispectral remote sensing images using active support vector machines[J]. Pattern Recognition Letters, 2004, 25(9): 1067-1074. Doi:10.1016/j.patrec.2004.03.004 |

| [8] |

Dey V, Zhang Y, Zhong M. A review on image segmentation techniques with remote sensing perspective[C]//Wagner W, Székely B. ISPRS TC VII Symposium-100 Years ISPRS. Vienna: IAPRS, 2010: 31-42.

|

| [9] |

Rydberg A, Borgefors G. Integrated method for boundary delineation of agricultural fields in multispectral satellite images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2001, 39(11): 2514-2520. Doi:10.1109/36.964989 |

| [10] |

胡潭高, 朱文泉, 阳小琼, 等. 高分辨率遥感图像耕地地块提取方法研究[J]. 光谱学与光谱分析, 2009, 29(10): 2703-2707. Doi:10.3964/j.issn.1000-0593(2009)10-2703-05 |

| [11] |

Martin D R, Fowlkes C C, Malik J. Learning to detect natural image boundaries using local brightness, color, and texture cues[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2004(5): 530-549. |

| [12] |

Arbelaez P, Maire M, Fowlkes C, et al. Contour detection and hierarchical image segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33(5): 898-916. Doi:10.1109/TPAMI.2010.161 |

| [13] |

Lim J J, Dollar P, Zitnick III C L. Learned mid-level representation for contour and object detection: U.S. Patent Application 13/794, 857[P]. (2014-09-18)[2018-11-10].

|

| [14] |

Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition[J]. arXiv preprint arXiv:1409, 2014. |

| [15] |

Krizhevsky A, Sutskever I, Hinton G E. Imagenet classification with deep convolutional neural networks[C]//Advances in Neural Information Processing Systems. 2012: 1097-1105.

|

| [16] |

Szegedy C, Liu W, Jia Y, et al. Going deeper with convolutions[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2015: 1-9.

|

| [17] |

Ren S, He K, Girshick R, et al. Faster r-cnn: Towards real-time object detection with region proposal networks[C]//Advances in Neural Information Processing Systems. 2015: 91-99.

|

| [18] |

Long J, Shelhamer E, Darrell T. Fully convolutional networks for semantic segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2015: 3431-3440.

|

| [19] |

Schulz H, Behnke S. Learning object-class segmentation with convolutional neural networks[C]//ESANN. 2012: 151-156.

|

| [20] |

Chen L C, Papandreou G, Kokkinos I, et al. Deeplab:Semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected crfs[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(4): 834-848. Doi:10.1109/TPAMI.2017.2699184 |

| [21] |

Xie S, Tu Z. Holistically-nested edge detection[C]//Proceedings of the IEEE International Conference on Computer Vision, 2015: 1395-1403.

|

| [22] |

Liu Y, Cheng M M, Hu X, et al. Richer convolutional features for edge detection[C]//Computer Vision and Pattern Recognition (CVPR), 2017 IEEE Conference on. IEEE, 2017: 5872-5881.

|

| [23] |

Dai J, Li Y, He K, et al. R-fcn: Object detection via region-based fully convolutional networks[C]//Advances in Neural Information Processing Systems, 2016: 379-387.

|

| [24] |

Hu F, Xia G S, Hu J, et al. Transferring deep convolutional neural networks for the scene classification of high-resolution remote sensing imagery[J]. Remote Sensing, 2015, 7(11): 14680-14707. Doi:10.3390/rs71114680 |

| [25] |

Cheng G, Han J, Lu X. Remote sensing image scene classification:benchmark and state of the art[J]. Proceedings of the IEEE, 2017, 105(10): 1865-1883. Doi:10.1109/JPROC.2017.2675998 |

2020, Vol. 37

2020, Vol. 37