2. 中国科学院大学, 北京 100049;

3. 海南省地球观测重点实验室, 海南 三亚 572000;

4. 吉林大学地球探测科学与技术学院, 长春 130012

2. University of Chinese Academy of Sciences, Beijing 100049, China;

3. Key Laboratory for Earth Observation of Hainan Province, Sanya 572000, Hainan, China;

4. College of Earth Exploration Science and Technology, Jilin University, Changchun 130012, China

伴随着遥感技术的快速发展,空间对地观测数据获取能力不断提升,陆地观测卫星的成像时间分辨率不断缩短,单星模式高分辨率卫星的重访需要2~5 d,即使轻小型卫星组建的星座缩短了重返周期,也难以满足对遥感特定目标进行实时观测的需求[1-2]。视频卫星的出现将时间分辨率提升到秒级,在大型商业区车辆实时监测、自然灾害应急快速响应、重大工程监控和军事安全等领域具有重要应用潜力,是未来遥感商业发展的重要方向[3-5]。

视频卫星的出现和发展将改变传统静态单景影像的图像处理模式,未来将发展为对多帧动态视频影像的快速图像处理模式。当前传统摄像监控视频运动目标检测算法较为成熟,但是卫星视频运动目标检测与其相比具有以下不同:1)观测尺度不同。传统监控镜头因其视角范围较小,观测的范围固定为一个小场景[6-7],目前的视频卫星代表中Skysat-1和Skysat-2卫星的幅宽为2.0 km×1.1 km,“吉林一号”卫星的幅宽为4.6 km×3.4 km,UrtheCast公司装载于国际空间站的“伊里丝”(Iris)相机的幅宽达到5.0 km×3.4 km[3-5]。观测尺度不同导致卫星视频的运动目标较多,环境较为复杂;2)传感器搭载的平台不同。传统监控视频的传感器为CCD(charge coupled device)和CMOS(complementary metal oxide semiconductor),搭载于交通信号灯等平台,视频卫星代表中的Skysat-1、Skysat-2卫星和“吉林一号”的传感器为高性能CMOS,都搭载于太阳同步轨道的卫星平台,UrtheCast公司的高清虹膜相机的传感器为CCD,搭载于轨道高度为360 km的国际空间站平台[3-5]。传感器搭载平台不同导致卫星视频中目标具有与背景的对比度低、信噪比低的特点,难以完整地将目标和背景区分开来;3)空间分辨率不同。传统监控视频的空间分辨率为亚米级乃至厘米级,而视频卫星代表中Skysat-1和Skysat-2卫星空间分辨率为1.1 m,“吉林一号”卫星的分辨率为1.13 m,Iris相机分辨率为1.0 m[3-5]。空间分辨率不同导致卫星视频运动目标所占像素较少,缺乏纹理信息[8];4)成像方式不同。传统监控摄像头大多固定于交通信号灯等地拍摄彩色视频,而视频卫星“凝视”成像时观测角度、俯仰姿态沿行进方向不断调整拍摄全色或彩色视频[9]。成像方式不同导致卫星视频背景连续慢速运动带来图像全局运动,动态背景提高了目标检测的难度。

以上差异导致传统监控视频的运动目标检测算法应用到卫星视频上存在较多问题。目前目标检测的算法主要有背景差分法[10-12]、帧间差分法[13-15]和光流法[16-18]3种算法。

背景差分法通过对当前帧与背景模板之间的差值做阈值化处理提取出运动区域,该方法较为简单,但是其对场景中的遮挡、光线等背景变化和噪声的影响很敏感。尤其在背景运动情况下,背景差分法检测会产生大量的虚假目标。George和Konstantions[19]使用背景差分法对Skysat-1卫星视频进行车辆检测,通过先验知识建立道路掩膜,将当前帧与均值建立的背景模板之间的差值进行密度分割,车辆检测结果的完整度达到80%以上,正确度达到75%以上。Yang等[20]利用卫星视频序列检测的车辆生成运动轨迹,计算所有像素点与车辆运动轨迹的距离,设定分割阈值提取道路掩膜,结合ViBe背景模型[21]在道路掩膜区域检测运动车辆,该方法完整度为82%左右,正确度为35%左右。

帧间差分法通过计算相邻两帧之间的差值,对结果做阈值化处理提取运动目标。该方法计算量较小,可实时有效地实现对运动目标区域的检测,但是对“慢速”目标不敏感,对环境噪声十分敏感。为了更好地检测“慢速”目标,相关学者对帧间差分算法进行改进,提出累积帧间差分算法(accumulative frame differencing,简称AFD),提高了慢速目标的检测精度[22-23]。但AFD算法进行“慢速”目标检测时,会出现检测空洞、虚假目标等问题。Cao等[24]针对红外航空序列在相邻帧间运动变化较小的现象提出基于局部聚类分割的对称差分动目标检测算法(symmetric frame differencing object detection based on local clustering,简称SFDLC),能够检测出较完整的“慢速”目标。

光流法通过对视频中的所有像素点计算运动场,通过分析图像序列中像素运动场的时域变化和相关性来确定各自像素位置的“运动”,从而把运动目标从背景中分割出来[25]。张过[8]在经典算法随机邻域和区域匹配法的基础上,结合光流法的运动矢量辅助并加以精化处理,对“吉林一号”卫星视频数据车辆目标检测和跟踪取得较好的效果。但是光流法计算量较大,难以应用到遥感卫星视频目标的实时检测中。

上述研究虽然对卫星视频的车辆检测进行了探索,但存在以下问题:1)为了削弱复杂背景带来的噪声影响,大多选用背景较为单一的小区域作为研究区,难以证明算法的普适性;2)在遥感影像车辆目标的提取中大多采用道路掩膜去除道路以外的影像,使得背景简单化,计算量减少。但是道路掩膜的获取大多根据先验知识路网形成缓冲区和手工绘制,且道路掩膜难以与动态背景完全匹配。

车辆检测在交通监管和商业情报中具有重要地位,传统利用摄像监控对车辆检测的方法无法直接宏观展示整个区域动态车流变化,而利用卫星视频对车辆进行检测能够在大尺度上提供更全面的分析结果。利用背景差分法对大场景的卫星视频进行车辆检测受动态背景、光照变化、高楼顶部位移及阴影影响较大,误检率高。利用帧间差分法对大场景的卫星视频进行车辆检测则受环境噪声影响较大,而遥感卫星视频中的运动车辆在相邻帧之间运动的像素数目与自身尺寸像素数目的比值均小于1/2,属于“慢速”目标,帧间差分法对该类“慢速”目标不敏感。利用改进的帧间差分法SFDLC可以检测出完整的“慢速”目标,但是该方法领域窗口内有多个目标或者背景复杂的时候,会导致分割不准确,而且会忽略所占像素过少的运动目标,漏检率高。

针对以上不足,本文提出一种背景差分与帧间差分相融合的目标检测算法(combined background subtraction with SFDLC method,简称BSSFDLC),该方法无需道路掩膜等先验知识,能够快速精确地检测出运动车辆目标。

1 算法原理本文提出的BSSFDLC融合背景差分法和帧间差分法,主要包含4步:1)卫星视频图像预处理;2)基于背景差分法进行运动车辆检测;3)应用SFDLC算法获得运动目标变化共同区域;4)将背景差分法提取的结果与SFDLC提取的运动变化区域相融合,提取出完整动态目标,详细的算法流程见图 1。

|

Download:

|

| 图 1 BSSFDLC算法流程图 Fig. 1 Flow chart of BSSFDLC algorithm | |

1) 卫星视频图像预处理

由于卫星视频中存在噪声,因此先对卫星视频进行预处理,将输入图像转换为灰度图像后进行高斯滤波处理。

2) 基于背景差分法进行运动车辆检测

首先建立背景模板B(k),设预处理后的待检测图像为I(k),取邻近待检测图像的N+1帧图像的均值为背景模板:

| $B\left( k \right) = \frac{{\sum\limits_{i = n}^{n + N} {I\left( i \right)} }}{{N + 1}},n \in \left\{ {1,{\rm{ }}2, \cdots ,i} \right\}.$ | (1) |

计算待检测图像I(k)与背景模板B(k)的差值图像,设前景像素的检测阈值为T,则前景像素需要满足式(2)才能被检测出来。

| $\left| {I\left( k \right) - B\left( k \right)} \right| \ge T.$ | (2) |

本文中T根据Otsu法[26]获得,使得差值图像类间方差最大的T为本文前景像素的检测阈值。对前景像素按照式(3)进行阈值分割得到背景差分法检测出的车辆目标BD(k)。

| ${\rm{BD}}\left( k \right) = \left\{ \begin{array}{l} 1,\left| {I\left( k \right) - B\left( k \right)} \right| \ge T,\\ 0,\left| {I\left( k \right) - B\left( k \right)} \right| < T. \end{array} \right.$ | (3) |

3) 应用SFDLC算法获得运动目标变化共同区域

① 图像对称差分。对相邻t帧的3帧图像I(k-t)、I(k)和I(k+t)做对称差分,得到差分图像d1、d2。

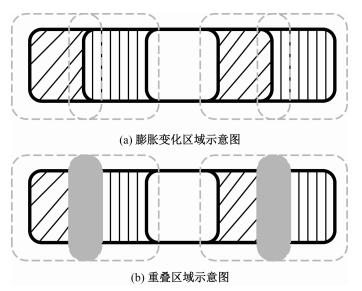

② 差分图像膨胀。中值滤波消除小噪声后,提取d1、d2中非零像素块的轮廓,作为运动变化区域[24],考虑到本文应用在大场景的卫星视频,计算多个车辆目标的外接矩形会影响算法的效率,因此通过对帧间差分的结果进行开运算后膨胀一次代替外接矩形计算出来的变化区域,如图 2(a)中虚线矩形,以保证d1与d2中由同一目标运动带来的变化区域间存在较大的重叠部分,而传统对称差分算法可能检测不出这样的重叠部分。

③ 求运动目标变化共同区域。求解d1与d2中运动变化区域的相交像素集合d,如图 2(b)中灰色填充区域,作为运动目标变化共同区域,根据d与运动目标的位置相交关系,可将d作为I(k)中的运动目标的初步定位结果。

4) 将背景差分法提取的结果与SFDLC提取的运动变化区域相融合

根据成像区域常见车辆目标的类型和分布,以及SFDLC提取的运动变化区域,设置目标可检测面积区间。

目标的可检测区域可根据视频的地面像素分辨率与目标尺寸的比值进行设定。本文实验视频UrtheCast和Skybox视频的地面像素分辨率为1.0 m和1.1 m,小轿车通常占8~10个像元,公交车通常占20~40个像元,一般道路上车辆分布与高层建筑区分布有一段距离,因此根据视频的地面像素分辨率与目标尺寸的比值和经验设置UrtheCast和Skybox视频的车辆目标可检测区域边长设为40和36,即目标可检测面积区间是以d为中心、边长为40像素和36像素的感兴趣区域(regions of interest,简称ROIs)。

根据式(4)计算出的与ROI(k)相匹配的BD(k)的集合,即为本文算法检测的运动目标Car(k)。在此基础上,采用数学形态学的方法消除Car(k)小噪声后即为本文的最终提取结果

| ${\rm{Car}}\left( k \right) = {\rm{ROI}}\left( k \right) \cap {\rm{BD}}\left( k \right).$ | (4) |

为证明本文方法的有效性,本文选取UrtheCast公司拍摄的视频和Skybox Imaging公司拍摄的视频两类数据进行算法的验证与分析,下面具体介绍两类视频数据的技术指标。

两类卫星视频数据具体技术指标见表 1[3-5]。第1个视频数据由UrtheCast公司2013年搭载在“国际空间站”的Iris相机拍摄成像,成像时间为2015年6月16日,成像区域为巴塞罗那区域,经纬度为41°21′32″N,2°9′43″E。该数据为4 K超高清全彩视频,视频时长为42 s,空间分辨率为1.0 m。第2个视频数据由Skybox Imaging公司2013年11月发射的SkySat-1卫星拍摄成像,成像时间为2014年3月25日,成像区域为拉斯维加斯城市中心商业区区域,经纬度为36°10′30″N,115°8′11″S。该数据为1 080P全高清黑白视频,视频时长为90 s,全色空间分辨率为1.1 m。

|

|

表 1 卫星视频主要技术指标 Table 1 Major technical parameters of satellite video |

图 3和图 4展示UrtheCast和Skybox原始视频序列中的第508帧和第821帧。本文的实验数据分别采用背景差分法、SFDLC算法和BSSFDLC算法进行运动车辆检测,对实验结果进行分析与对比,并对区域A、区域B、区域C和区域D的3种方法的检测结果局部放大进行对比。

|

Download:

|

| 图 3 UrtheCast原始视频图像序列第508帧 Fig. 3 Frame 508 in original UrtheCast video sequence | |

|

Download:

|

| 图 4 Skybox原始视频图像序列第821帧 Fig. 4 Frame 821 in original Skybox video sequence | |

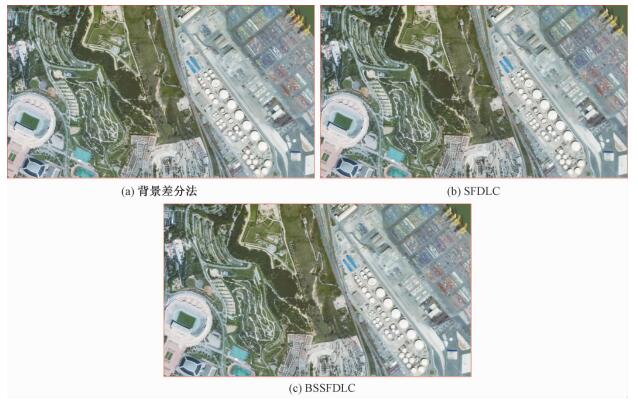

本文将背景差分法、SFDLC算法与BSSFDLC算法的结果进行比较,从而定性和定量评价本文的BSSFDLC算法的目标检测效果。图 5为UrtheCast视频第508帧3种方法车辆目标检测结果,图 5(a)中红色小矩形表示背景差分法从第508帧图像检测出的111辆运动车辆,包括一些在高层建筑顶端的位移、建筑阴影和光线变化造成的大量虚假目标。其中在区域A由于高楼顶层的位移造成大量虚假目标对检测结果影响较大。图 5(b)中红色小矩形表示SFDLC法从第508帧图像检测出的54辆运动车辆,虽然消除了高层建筑顶端位移和建筑阴影的影响,但是该方法基于局部聚类分割,将某些与道路灰度值相近的地物错分为车辆,检测的车辆轮廓不精确,且对小型车辆漏检率高。图 5(c)红色小矩形表示BSSFDLC法从第508帧图像检测出的63辆运动车辆,该方法剔除了图像右上角和中上位置的高楼顶部位移和建筑阴影产生的虚假目标,同时通过在运动变化区域设置感兴趣区匹配背景差分法的结果,对右下方的小型运动车辆检测效果较好。

|

Download:

|

| 图 5 UrtheCast视频第508帧车辆目标检测 Fig. 5 Target detection in frame 508 of UrtheCast | |

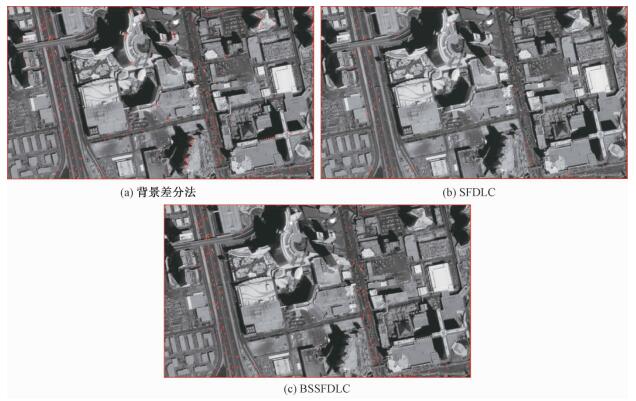

图 6为Skybox视频第821帧3种方法车辆目标检测结果,图 6(a)中红色小矩形表示背景差分法从第821帧图像检测出的426辆运动车辆,包括一些在高层建筑顶端的位移、建筑阴影和光线变化造成的大量虚假目标。以区域C为代表的高楼顶层的位移造成的虚假目标造成检测结果误检率高。图 5(b)中红色小矩形表示SFDLC法从第508帧图像检测出的114辆运动车辆,虽然消除了高层建筑顶端位移和建筑阴影的影响,但是该方法基于局部聚类分割,将某些与道路灰度值相近的地物错分为车辆,检测的车辆轮廓不精确,且对小型车辆漏检率高。图 5(c)红色小矩形表示本文的BSSFDLC法从第508帧图像检测出的177辆运动车辆,该方法剔除了图像中部和边沿位置的高楼顶部位移和建筑阴影产生的虚假目标,同时通过在运动变化区域设置感兴趣区匹配背景差分法的结果,对道路中的小型运动车辆检测效果较好。通过以上定性对比得出,本文的方法更适用于Skybox数据与UrtheCast数据两种数据的运动车辆目标检测。

|

Download:

|

| 图 6 Skybox视频第821帧车辆目标检测 Fig. 6 Target detection in frame 821 of Skybox | |

表 2为区域A、区域B、区域C和区域D 4个区域的3种方法的局部放大图对比表。其中区域A中部和区域C左侧存在高楼,背景差分法在区域A中部和区域C左侧形成大量虚假目标,由于卫星“凝视”过程中沿着轨道飞行,导致高楼的顶部在图像上出现位移,目前尚没有一种背景模板可以完全匹配运动的背景,因此背景差分法对存在高楼的视频误检率高;SFDLC算法计算相邻3帧的差值图,能够适应光线变化和动态背景,因此消除了高楼顶部位移对目标检测的影响;本文的BSSFDLC算法运用SFDLC算法获得运动目标变化共同区域并建立感兴趣区域,因此也可以一定程度上剔除高楼顶部位移对目标检测的影响,适应于动态背景,因此对于有高楼的区域A和区域C检测效果较好。

|

|

表 2 3种方法目标检测结果局部放大表 Table 2 Enlarged views of target detection using three methods |

区域B和区域D存在高度较低的建筑物,某些运动车辆尺寸较小,且区域B在道路上存在于车辆灰度值相近的静态地物。背景差分法在区域B和区域D检测目标数量较完整,漏检率低,但是由于光照环境的变化等干扰因素导致在区域B右侧出现误检测;SFDLC算法对光照环境变化等不敏感,误检率低,但是由于车辆所占的像素过少使得3帧差分共同变化区域过小,导致区域B下侧和区域D中部出现漏检测,另外,由于区域B中部的白色地物与车辆灰度值相近,SFDLC进行局部聚类时也将该地物归类为车辆;本文的BSSFDLC算法融合了背景差分法的漏检率低和SFDLC误检率低的优势,可以剔除光照环境的变化等导致背景差分法产生的虚假目标,也可降低某些地物与车辆灰度值相近带来的SFDLC算法的误检测率,同时提高对小目标的检测能力。

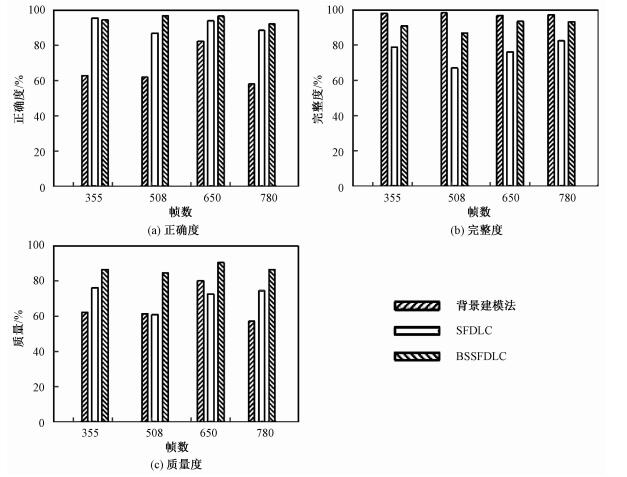

3.2 定量评价指标对比本文选取正确度(Correctness)、完整度(Completeness)和质量指标(Quality)3个定量评价指标来评价检测精度,其计算公式如下:

| ${\rm{Correctness}} = {\rm{TP}}/\left( {{\rm{TP}} + {\rm{FP}}} \right),$ | (5) |

| ${\rm{Completeness}} = {\rm{TP}}/\left( {{\rm{TP}} + {\rm{FN}}} \right),$ | (6) |

| ${\rm{Quality}} = {\rm{TP}}/\left( {{\rm{TP}} + {\rm{FP}} + {\rm{FN}}} \right).$ | (7) |

式中:TP表示正确检测车辆的辆数,FP表示错误检测车辆的辆数,FN表示漏检车辆的辆数。

通过抽取UrtheCast视频的第355帧、第508帧、第650帧和第780帧采用背景差分法、SFDLC算法和BSSFDLC算法分别进行目标检测,图 7(a)、图 7(b)和图 7(c)为3种算法的正确度、完整度和质量的定量评价指标对比图。从图 7可知,背景差分法的完整度较好,漏检率低;SFDLC算法的正确度较高,误检率低;本文的BSSFDLC算法综合了背景差分法和SFDLC算法的优势,该算法的正确度和质量指标明显高于背景差分法和SFDLC算法的完整性和质量指标,同时保持了较好的完整度。综上可得,本文的BSSFDLC算法综合了背景差分法漏检率低和SFDLC算法误检率低的优势,可以改善SFDLC算法中车辆所占像素过少导致3帧差分共同变化区域过小而漏检测的问题,可有效改善SFDLC算法由于局部聚类中某些地物与车辆灰度值相近导致误检测的情况,减少背景差分法中移动背景边缘和残留噪声的干扰,提高动态背景和高噪声情况下的检测精度,但是对某些低对比度的目标不敏感。

|

Download:

|

| 图 7 3种算法正确度对比表 Fig. 7 Comparison of correctness among the three algorithms | |

本次仿真实验是在处理器型号为Inter(R)-Xeron(R)E5-2650V2,主频为2.60 GHz,内存为32 G,操作系统为Windows 7中文版64位的PC机上使用MATLAB 2014 a版本实现。对于尺寸为1 920像素×1 080像素的视频来说,背景差分法的处理效率为6.2帧/s,SFDLC方法的处理效率可以达到17.1帧/s。本文的改进算法由于结合背景差分法和SFDLC,算法上增加了复杂性,处理效率受到一定的影响,但也达到平均4.7帧/s。未来可以通过图像分块处理和并行计算提高算法效率,满足大视场、大容量数据多目标实时检测的要求。

4 结论本文提出的BSSFDLC算法融合背景差分法和帧间差分法两种方法的优势,采用均值建立动态背景模板,无需道路掩膜等先验知识,通过参数对SFDLC算法检测出的车辆变化共同区域设置车辆目标可检测区,进而检测该区域与感兴趣区相匹配的背景差分法结果,得到最终检测结果。实验证明,本文提出的方法可以抑制移动背景边缘和残留噪声的干扰,提高动态背景和高噪声情况下的处理精度,提高检测的正确度和质量,同时保持较好的完整度。该方法对其他动态目标检测也具有一定的应用潜力。随着遥感视频卫星的发展,卫星视频数据源不断丰富,未来可以从视频的多源多模态特征出发,研究更加普适的动态目标快速检测方法。

| [1] |

Gómez C, White J C, Wulder M A. Optical remotely sensed time series data for land cover classification:a review[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2016, 116:55–72.

DOI:10.1016/j.isprsjprs.2016.03.008 |

| [2] |

李德仁, 王密, 沈欣, 等. 从对地观测卫星到对地观测脑[J]. 武汉大学学报(信息科学版), 2017, 42(2):1–5.

|

| [3] |

刘韬. 国外视频卫星发展研究[J]. 国际太空, 2014, 9(2):50–56.

|

| [4] |

朱厉洪, 回征, 任德锋, 等. 视频成像卫星发展现状与启示[J]. 卫星应用, 2015(10):23–28.

|

| [5] |

潘益云, 李海超. 低轨视频卫星成像特性分析[J]. 航天器工程, 2015, 24(5):52–57.

|

| [6] |

Yilmaz A, Javed O, Shah M, et al. Object tracking:a survey[J]. ACM Computing Surveys, 2006, 38(4):1–45.

|

| [7] |

Mithun N C, Howlader T, Rahman S M, et al. Video-based tracking of vehicles using multipleźtime-spatialźimages[J]. Expert Systems with Applications, 2016, 62:17–31.

DOI:10.1016/j.eswa.2016.06.020 |

| [8] |

张过. 卫星视频处理与应用进展[J]. 应用科学学报, 2016, 34(4):361–366.

|

| [9] |

付凯林, 杨芳, 黄敏, 等. 低轨道视频卫星任务模式的研究与应用[C]//北京力学会学术年会, 2015: 17-22.

|

| [10] |

Amri S, Barhoumi W, Zagrouba E, et al. A robust framework for joint background/foreground segmentation of complex video scenes filmed with freely moving camera[J]. Multimedia Tools and Applications, 2010, 46(2):175–205.

|

| [11] |

Sobral A, Vacavant A. A comprehensive review of background subtraction algorithms evaluated with synthetic and real videos[J]. Computer Vision and Image Understanding, 2014, 122(5):4–21.

|

| [12] |

Appiah K, Hunter A, Dickinson P, et al. Accelerated hardware video object segmentation:from foreground detection to connected components labelling[J]. Computer Vision and Image Understanding, 2010, 114(11):1282–1291.

DOI:10.1016/j.cviu.2010.03.021 |

| [13] |

Khare M, Srivastava R K, Khare A, et al. Single change detection-based moving object segmentation by using Daubechies complex wavelet transform[J]. Iet Image Processing, 2014, 8(6):334–344.

DOI:10.1049/iet-ipr.2012.0428 |

| [14] |

Yin H, Chai Y, Yang S X, et al. Fast-moving target tracking based on mean shift and frame-difference methods[J]. Journal of Systems Engineering and Electronics, 2012, 22(4):587–592.

|

| [15] |

Alani M, Hammouri A. Video compression algorithm based on frame difference approaches[J]. International Journal of Soft Computing, 2011, 2(4):67–79.

DOI:10.5121/ijsc |

| [16] |

Suganyadevi K, Malmurugan N. OFGM-SMED:an efficient and robust foreground object detection in compressed video sequences[J]. Engineering Applications of Artificial Intelligence, 2014, 28(1):210–217.

|

| [17] |

Xin Y, Hou J, Dong L, et al. A self-adaptive optical flow method for the moving object detection in the video sequences[J]. Optik-International Journal for Light and Electron Optics, 2014, 125(19):5690–5694.

DOI:10.1016/j.ijleo.2014.06.092 |

| [18] |

Yalcin H, Hebert M, Collins R T, et al. A flow-based approach to vehicle detection and background mosaicking in airborne video[J]. Computer Vision and Pattern Recognition, 2005:1202–1202.

|

| [19] |

George K, Konstantinos K. Vehicle detection and traffic density monitoring from very high resolution satellite video data[C]//2015 IEEE International Geoscience and Remote Sensing Symposium (IGARSS). 2015:1881-1884.

|

| [20] |

Yang T, Wang X, Yao B, et al. Small moving vehicle detection in a satellite video of an urban area[J]. Sensors, 2016, 16(9):1528.

DOI:10.3390/s16091528 |

| [21] |

Barnich O, Droogenbroeck M V. ViBe:a powerful random technique to estimate the background in video sequences[J]. IEEE International Conference on Acoustics, Speech and Signal Processing, 2009:945–948.

|

| [22] |

Qiu G N, Quan H M. Moving object detection algorithm based on symmetrical-differencing and background subtraction[J]. Computer Engineering and Applications, 2014, 50:158–162.

|

| [23] |

Bhattacharya S, Idrees H, Saleemi I, et al. Moving object detection and tracking in forward looking Infra-Red aerial imagery[J]. Machine Vision Beyond Visible Spectrum, 2011, 1:221–252.

|

| [24] |

Cao Y T, Wang G, Yan D, et al. Two algorithms for the detection and tracking of moving vehicle targets in aerial Infrared image sequences[J]. Remote Sensing, 2015, 8(8):28–49.

|

| [25] |

谢红, 原博, 解武. LK光流法和三帧差分法的运动目标检测算法[J]. 应用科技, 2016, 43(3):23–28, 33.

|

| [26] |

Otsu N. A threshold selection method from gray-level histograms[J]. IEEE Transactions on Systems, Man, and Cybernetics, 2007, 9(1):62–66.

|

2018, Vol. 35

2018, Vol. 35