2. 中国科学院大学电子电气与通信工程学院, 北京 100049;

3. 中国科学院大学资源与环境学院, 北京 100049

2. School of Electronic, Electrical and Communication Engineering, University of Chinese Academy of Sciences, Beijing 100049, China;

3. College of Resources and Environment, University of Chinese Academy of Sciences, Beijing 100049, China

农业大棚是农业生产种植领域的一种农业设施,通常被用于控制栽培环境、防雨防风、提高生产力和产量以及种植稀缺作物等。常见的农业大棚因作物的喜阴喜阳特点而被分为阴棚和阳棚2种类型。通常把大棚表面透光、棚内种植喜阳作物的大棚统称为“阳棚”;把大棚表面透光度低且呈深色,棚内种植耐阴作物的一类大棚称为“阴棚”。区分不同类别农业大棚、统计大棚面积和空间分布信息,对于农业设施普查、区域经济发展规划有着现实意义。在小范围情况下,人力统计方法尚可,当统计大范围大棚信息时,采用人工手段则存在成本和效率均不可操作问题。

随着卫星、无人机等地球监测平台的迅速发展,获取高空间、高时间、高光谱分辨率影像的成本越来越低[1]。将海量遥感数据与先进的人工智能技术相结合,能克服人工调查农业大棚分布费时费力的缺陷,实现对于农业大棚的高效信息提取与定量时空分析,对于现有的农业信息统计以及长期的空间规划都有着长远意义。

当前基于遥感影像的农业大棚信息提取方法,主要分为面向对象和基于像素的方法。面向对象法通常先将影像划分成超像素块,再根据规则特征对超像素块分类,得到农业大棚提取结果。王雪英和郭卫华[2]采用多尺度分割算法将高分1号分割成超像素块,再根据光谱、高程与纹理规则对超像素块分类,生成提取结果。汤紫霞等[3]使用eCognition软件对高分2号影像做多尺度分割,再基于最优特征子空间的随机森林算法分类超像素块,减少数据冗余,取得更高的精度。但该方法的分类精度上限受到超像素的制约,当超像面积较大时,容易造成地物类别混淆,面积较小时,会使地物类别细碎。

基于像素的方法中,遥感指数特征、深度学习技术常被用来提取农业大棚。遥感指数法通常利用遥感影像不同波段构建用于区分农业大棚的特征指数,并利用阈值比较等手段区分农业大棚,有计算快捷、应用方便的优点。

2017年,Yang等[4]提出新型的用于区分农业大棚的光谱指数,旨在抑制植被的光谱信息,提高农业大棚与其他地物的光谱特征差异。在Landsat和Quickbird-2影像上均得到了优异的提取结果。2020年,Shi等[5]提出一种基于多种光谱指数的农业大棚制图方法,正确率高达97.34%。但是在大范围提取农业大棚时,人工调节指数的阈值费时费力,且整体精度较低。

随着U-Net[6]、HRNet[7]、EfficientNet[8]等高效准确的网络架构出现和高分辨率遥感影像资源的增多,当前主流基于深度学习提取农业大棚的方法常基于卷积神经网络和遥感影像实现。

Li等[9]基于高分2号与高分1号混合影像,比较3种经典目标检测算法提取农业大棚的性能。发现YOLO v3[10]能快速准确地完成农业大棚目标检测任务。Feng等[11]基于改进的深度卷积神经网络准确区分Google影像中的塑料大棚与地膜并依据提取结果制图。Baghirli等[12]将U-Net解码器中的上采样步骤改进为并行的转置卷积和双线性上采样,缓解提取结果的噪声。但编码器采用简单堆叠的“卷积-激活-池化”结构,提取农业大棚的高级语义特征能力较弱。Feng等[13]使用语义分割与目标检测相结合的双流网络PODD提取农业大棚的面积和数量,精度较高。Zhang等[14]改进HRNet模型,将边缘检测与语义分割任务相耦合,增加了通道注意力机制,使用高分2号影像实现对农业大棚的高精度提取。但仅有通道注意力对重要的地物特征捕捉能力不够强。而且它只从语义分割结果还原边缘信息,没有充分融合编码器提取的边缘特征。

现有研究表明,与传统技术相比,深度学习技术在遥感农业大棚提取任务上具有明显优势。虽然许多学者已对农业大棚信息提取进行了大量研究,但研究对象大多是针对地面特征显著的阳棚,缺少对于阴棚的信息提取研究;而且目前用于提取农业大棚的特征提取模块对高维语义特征的抽取能力弱,对农业大棚的边缘信息利用不充分,需要进一步研究。

本文利用改进后的U-Net模型进行农业大棚信息提取,而且是同时提取阴棚与阳棚。针对U-Net的编码器提取农业大棚高层语义信息能力弱的问题,改进编码器结构,并在网络跳层连接处利用坐标注意力和通道空间注意力模块,提高模型对深层语义信息的提取能力;针对边缘信息利用不充分的问题,引入边缘检测分支,优化语义分割结果。由于尚不存在公开的农业大棚语义分割数据集,所以本文基于在研究区的自制数据集,进行改进前后模型的训练和测试对比。

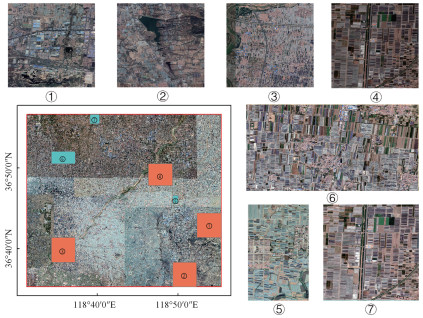

1 研究区域与数据集山东省潍坊市地处山东半岛,地貌自北向南由高到低,是中国建设农业大棚数量最多的城市之一,其农业大棚特征较为典型,因此在其下辖县乡选择部分典型区域作为研究区。研究区域如图 1所示,选择其下寿光市、昌乐县和青州市的交界区,地处118°31′16″E~118°55′21″E,36°35′16″N~36°56′38″N,面积约1 400 km2,是潍坊市农业大棚分布最密集的区域。

|

Download:

|

| 图 1 研究区域位置 Fig. 1 Study area location | |

本研究中使用的高分辨率遥感数据来自开源的谷歌地球(Google Earth)平台(http://earth.google.com),属于19级数据,由Pleiades-1和WorldView-3等多源卫星拼接而成,有红光、绿光和蓝光3个波段,具有0.54 m的空间分辨率。选取2022年11月份影像作为实验数据。利用Arcgis10.7的渔网工具划分研究区,并根据随机原则生成训练与测试区域,图 1中①②③④是训练区域(平均像素:8 448×9 216),包含农业大棚18 962个,⑤⑥⑦是测试区域(平均像素:3 754×4 949),包含农业大棚3 273个。将训练区影像裁剪为512×512大小,每次滑动256个像素,得到图像4 735张。按照4∶1的比例划分,得到训练集3 972张和验证集947张,将包含阴棚的影像做水平与垂直翻转数据增强,这能在一定程度上缓解阴棚阳棚像素不均衡的问题。

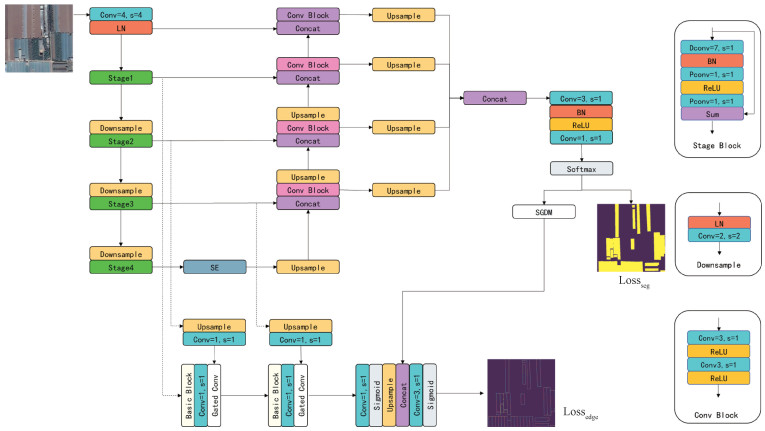

2 研究方法 2.1 U-Net模型的改进U-Net以其简单的编码器-解码器结构,精度高被广泛应用于遥感影像语义分割任务中。U-Net编码器经过连续4次卷积-激活-池化操作,得到分辨率为原始影像1/16且包含高层语义信息的特征图。在U-Net基础上,ResUNet[15]将编码器替换为残差块,缓解梯度弥散,提高模型训练的稳定性和特征提取能力,但精度仍不尽人意。

ConvNeXt[16]是一种将ResNet[17]改进为与Swin Transformer[18]具有相似结构的卷积神经网络,简单且性能高效。该模型的特征提取模块与Swin Transformer相似,它将ResUNet的stem层替换为核是4跨步为4的卷积,使用分组卷积和大卷积核策略,并将ReLU和批归一化(batch normalization,BN)函数替换为GeLU和层归一化(layer normalization,LN)函数,从而提高模型对高层语义特征的提取能力,使精度提高且减小参数规模。

本研究将编码器替换为ConvNeXt-Tiny[16],每阶段堆叠块比例为3∶3∶9∶3,输出特征图的通道数分别为96,192,384,768。利用迁移学习的思想,使用经ImageNet-1k数据集预训练的模型初始化网络权重,加快模型收敛。

此外,模型通过加入坐标注意力[19](coordinate attention,CA)模块和通道空间注意力[20](convolutional block attention module,CBAM)模块引入注意力机制。

改进后的模型将CA模块置于U-Net跳层连接中分辨率最高、通道数是96的第1层,以实现在高分辨率特征图上捕获像素间的长距离关系。将CBAM模块置于跳层连接中通道数为768的最深层,从通道和空间维度上有选择地利用富含语义信息的特征图,抑制无用特征。

2.2 多任务模型架构语义分割提取农业大棚的方法往往仅聚焦于如何充分利用像素的语义信息[12-13],而常常忽略边缘信息。边缘通常被认为是像素梯度值大的位置,农业大棚的边缘有较强的辨识度,且边缘检测的精确度往往与语义分割的精度呈正相关。受文献[21-22]启发,本研究为模型增加了边缘检测分支网络,以多任务学习的形式优化农业大棚分割结果。

边缘检测分支有3个步骤:从U-Net模型的编码器获取语义特征信息,从解码器获取边缘特征信息,然后对二者做特征融合。详细步骤如下:

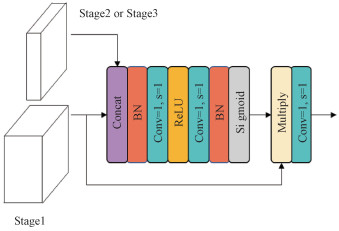

1) 获取来自编码器的特征:该阶段主要使用ConvneXt-Tiny的stage1,stage2和stage3输出的特征图,利用门控卷积层[21](gated convolutional layer)完成信息融合。图 2中的门控卷积层本质上是一种注意力机制,它能让stage2和stage3的深层特征去指导stage1聚焦农业大棚的边缘信息。改进的U-Net网络经过门控卷积层两次特征融合,得到C=24的特征图,再经过1×1的卷积生成基于Convnext-tiny编码器的边缘检测特征图B(C=3)。C是特征图的通道数。

|

Download:

|

| 图 2 门控卷积层结构 Fig. 2 Gated convolutional layer structure | |

2) 获取来自解码器的特征:该阶段利用空间梯度检测模块(spatial gradient detection module,SGDM)来计算2.1中解码器输出语义分割概率图的空间梯度Δ G(C=3)。

| $ \nabla G(x, y)=\mid M(x, y) \text { - Averagepool }(M(x, y)) \mid \text {. } $ | (1) |

其中:x, y是像素的位置;|·|是绝对值函数,以防梯度值为负;Averagepool是平均池化函数,池化核为3×3,跨步为1,使池化后特征图的尺寸与池化前相同。

3) 编码器与解码器的特征融合:将空间梯度ΔG与特征图B的对应通道拼接融合,经过分组为3的分组卷积生成边缘检测结果E(C=3):

| $ E=\text { Conv } 2 \mathrm{~d}_{\text {out }}^{\text {in }}\left[\nabla G_0, B_0, \nabla G_1, B_1, \nabla G_2, B_2\right] \text {. } $ | (2) |

其中:Conv2d是二维卷积;in是输入通道数,out是输出通道数,in=6,out=3;ΔGn、Bn分别是ΔG和B的通道特征,n是通道的索引n=0, 1, 2;[·]是拼接操作。

2.3 损失函数农业大棚数据集中阳棚和阴棚样本不均衡,而且与语义分割任务相比,边缘检测任务中农业大棚边缘像素与背景像素更加不均衡。因此,模型的联合损失函数Losscombined由加权语义分割损失Lossseg和加权边缘检测损失Lossedge组成,分别由M、E与真值计算得到。

| $ \operatorname{Loss}_{\mathrm{seg}}=-\frac{1}{N} \sum\limits_{i=1}^N \sum\limits_{j=1}^K \alpha_j y_{i j} \log \left(p_{i j}\right), $ | (3) |

| $ \operatorname{Loss}_{\text {edge }}=-\frac{1}{N} \sum\limits_{i=1}^N \sum\limits_{j=1}^K \beta_j x_{i j} \log \left(q_{i j}\right) \text {, } $ | (4) |

| $ \operatorname{Loss}_{\text {combined }}=\operatorname{Loss}_{\text {seg }}+\lambda \cdot \operatorname{Loss}_{\text {edge }} \text {. } $ | (5) |

其中:N是批处理量;K是类别数量(K=3);yij是语义分割的标签像素,当i的类别为j时取1,否则取0;pij是语义分割任务中像素i属于类别j的概率; αj是语义分割任务中类别j损失的权重; xij是边缘检测的标签像素;qij代表像素i预测为边界类别j的概率; βj是边缘检测任务中类别j损失的权重; λ是2类损失的平衡权重。模型改进后的结构如图 3所示。

|

Download:

|

| 图 3 改进的U-Net网络结构 Fig. 3 Improved U-Net model structure | |

实验在一台搭载了NVIDIA TITAN-RTX(24 G运行内存)的Ubuntu16.04的操作系统上运行。采用Pytorch1.7.1深度学习框架。在训练过程中,所有网络使用AdamW[23]优化器,输入网络的图片大小为512×512,批处理量设置为8,初始学习率设置为1×10-4,权重衰减为5×10-4。整个训练过程使用指数衰减法调整学习率,指数为0.9。对整个数据集进行100次迭代循环训练后,模型收敛,学习停止。

3.2 实验评估指标为测试模型精度,研究使用的评估指标包括召回率(Recall)、精确度(Precision)、综合精度得分(F1) 和交并比(intersection over union,IoU)。其中F1是Recall和Precision的调和平均数,IoU衡量预测结果与真值间重合度。以上指标具体计算方法如下:

| $ \text { Recall }=\frac{T_{\mathrm{P}}}{T_{\mathrm{P}}+F_{\mathrm{N}}}, $ | (6) |

| $ \text { Precision }=\frac{T_{\mathrm{P}}}{T_{\mathrm{P}}+F_{\mathrm{P}}}, $ | (7) |

| $ F_1=2 \times \frac{\text { Precision } \cdot \text { Recall }}{\text { Precision + Recall }}, $ | (8) |

| $ \mathrm{IoU}=\frac{T_{\mathrm{P}}}{T_{\mathrm{P}}+F_{\mathrm{P}}+F_{\mathrm{N}}} . $ | (9) |

式(6)~式(9)中:TP(true positives)、FP(false positives)、FN(false negatives)分别表示正确检测的农业大棚像素、错误检测的农业大棚像素和错误检测的背景像素。

3.3 实验评估结果为反映改进后的U-Net的农业大棚提取效果,利用图 1中的测试区⑤⑥⑦分别对比评价ResUNet[15]、PODD[13]和LANet[24]的提取精度。其中,PODD专用于提取农业大棚,其核心网络是Deeplabv3+[25],该网络使用空洞卷积来扩大卷积核的感受野,LANet嵌入了增强图像高级语义信息的注意力模块,适用于遥感影像的语义分割任务。

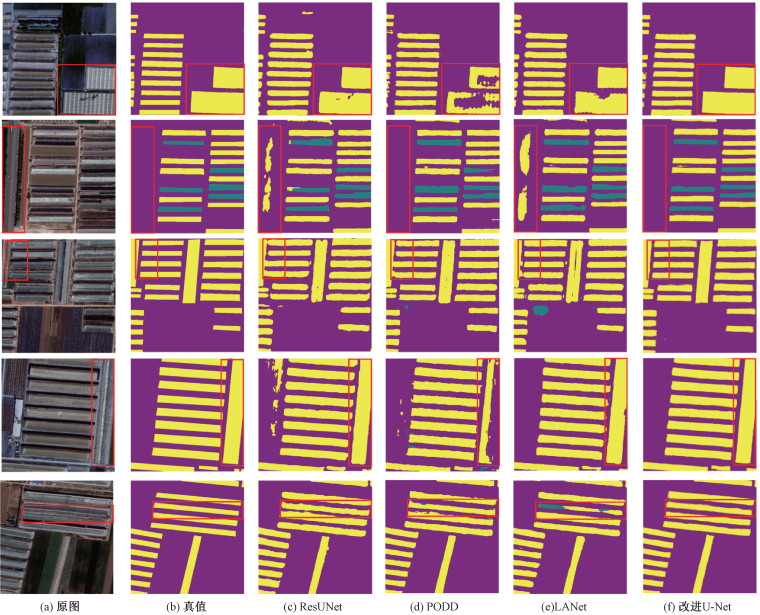

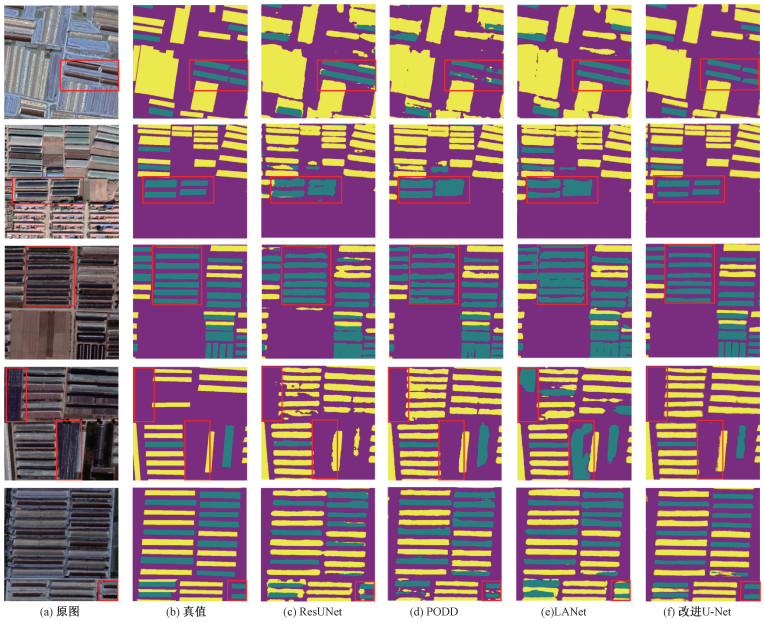

阳棚的精度评价如表 1所示,分别在3个测试区进行提取结果评价。结果表明,改进的U-Net提取阳棚的结果优于其他3种算法。改进的U-Net平均 F1分数达89.02%,高于LANet的86.65%、PODD的86.48%和ResUNet的84.87%。虽然在3个测试区的Precision略低于PODD,但Recall均比PODD高5个百分点以上,并在精度上全面领先于其他网络。阳棚的提取效果如图 4所示,从左到右依次为原图、人工标注的真值、ResUNet结果、PODD结果、LANet结果和改进U-Net结果。其中,紫色是背景,黄色是阳棚,青色是阴棚,红色矩形是重点对比区域。可以看到改进的U-Net对连栋阳棚有较好检测能力,识别结果的孔洞少,形状更加完整。与其他网络相比,由于充分利用了遥感影像的边缘信息,生成的阳棚边界更加平滑。它对与阳棚颜色和形状特征相似的道路区分能力更强,说明对遥感影像的深层语义信息捕捉得更完整,对地物类别的辨识能力更强。

|

|

表 1 阳棚测试结果精度 Table 1 Accuracy of the transparent agricultural greenhouses test results |

|

Download:

|

| 图 4 测试区阳棚对比图 Fig. 4 Comparison of transparent agricultural greenhouses in the test area | |

阴棚在3个测试区的精度评价如表 2所示。改进的U-Net平均F1分数为82.95%,高于ResUNet的74.44%、PODD的75.93%和LANet的76.21%。需要强调的是,虽然它在某些测试区上的Precision略低于ResUNet和PODD,Recall略低于PODD和LANet,但是它的平均F1分数最高,说明该模型对阴棚的查准和查全能力都较强。阴棚的总体精度低于阳棚,这是因为实际阴棚在数量上远少于阳棚而且分散,导致样本不平衡。为保证样本中农业大棚的边缘完整,本文把有些阴阳棚混合的农业大棚视为阴棚,导致模型极易将该类地物视为阳棚,使分割结果相较于阳棚精度降低。图 5是测试区阴棚的部分提取结果,改进U-Net网络能把置于阳棚中的阴棚完整地识别出来,而且也能区分出与阴棚形状、光谱特征相似的建筑物阴影和深色地膜,抑制分割结果中的噪声能力最强。这说明改进的U-Net能更好地提取遥感影像的语义特征,提高了对农业大棚的辨识能力。第3行的提取结果表明本文的方法对于密集分布的阴棚,提取结果有一定的提升,而且对大棚边界平滑度差的现象也有不错的改善。

|

|

表 2 阴棚测试结果精度 Table 2 Accuracy of the non-transparent agricultural greenhouses test results |

|

Download:

|

| 图 5 测试区阴棚对比图 Fig. 5 Comparison of non-transparent agricultural greenhouses in the test area | |

如表 3所示,从整体上看,改进U-Net模型同时提取阴棚和阳棚的平均F1分数和平均IoU分别为85.98%和75.50%,高于另外3种对比网络。与文献[14]相比,我们在优化模型时不仅考虑了农业大棚的边缘特征,还对它的边缘进行分类,即区分检测到的边缘像素是阳棚还是阴棚,能够增强对二者的提取能力。因此,从精度和原理分析上说明改进的U-Net模型能更好地同时区分阴棚和阳棚。

|

|

表 3 阴棚和阳棚的测试结果精度 Table 3 Accuracy of the non-transparent and transparent agricultural greenhouses test results |

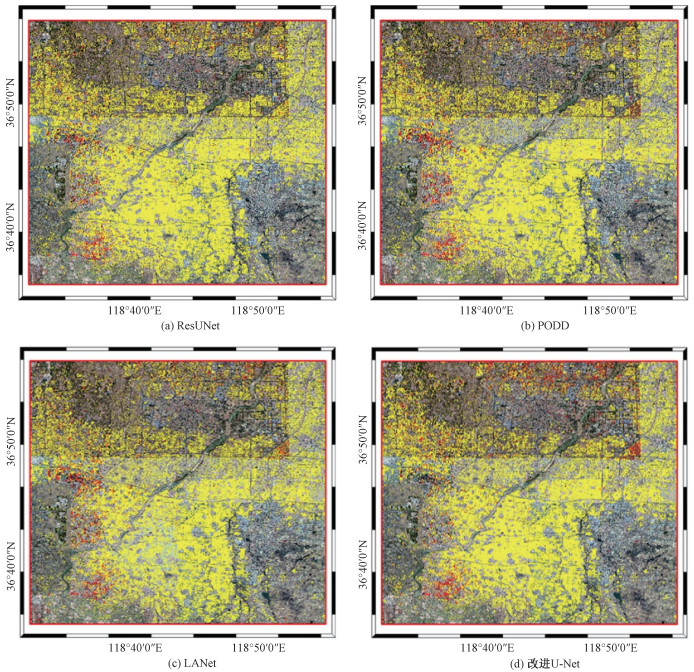

分别利用ResUNet、PODD、LANet和改进U-Net模型对研究区域的阳棚和阴棚制图。图 6中黄色为阳棚,红色是阴棚。整体上,阳棚集中分布在研究区的中部和南部,阴棚主要分布在西南和东北部。具体地,对于阳棚,PODD和LANet分别对研究区的中部和南部的阳棚有大量漏检,而ResUNet和改进的U-Net的漏检现象较轻。对于阴棚,ResUNet对东北部阴棚的识别效果明显劣于其他3种模型。在研究区西部存在大量与阴棚形状、颜色相似的深色植被,极易与阴棚混淆造成大量错检。与其他3种网络相比,改进的U-Net很好地缓解了这一现象。以上说明我们的方法可以识别不同背景下农业大棚,对阴棚和阳棚的区分能力很强,适用于大规模自动化制图。

|

Download:

|

| 图 6 研究区制图结果 Fig. 6 Mapping results of the study area | |

本节对损失函数中的权重参数进行敏感性分析,并通过消融实验分析新增模块作用。

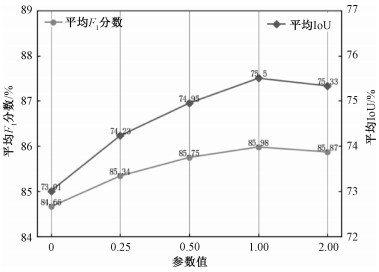

4.1 损失函数权重的敏感性分析本研究提出的联合损失函数是分割损失与边界损失的加权之和,使用不同的权值λ可能会对分割结果造成影响。式(5)使用不同λ的损失函数训练改进U-Net,从而探究边界损失对分割结果的贡献。令λ=0、0.25、0.5、1、2,共做5组实验。

参数λ代表模型对边缘的关注程度,λ越大,模型对边缘的关注程度越高。图 7中,当λ=0时精度最低,表明加入边缘损失的模型一定优于无边缘损失的模型。当λ过大或过小都会影响模型的稳定性,因此实验选择λ=1,使模型的精度最高。

|

Download:

|

| 图 7 在农业大棚数据集上使用不同λ的Losscombined的精度比较 Fig. 7 Comparison of the Losscombined using different λ on the agricultural greenhouses dataset | |

为分析改进的U-Net模型中各个新增模块的作用,在该模型的基础上分别做去除ConvNeXt网络和去除边缘检测分支网络的消融实验,并采用F1分数和IoU指标进行评估。

表 4中,√和×代表该模块被使用与否。将ConvNeXt替换为普通的“卷积-激活-池化”时,模型对阴棚和阳棚提取结果中的平均F1分数和平均IoU均略有下降,说明ConvNeXt与普通的骨干网络相比具有更加强大的特征提取能力。当模型去掉边缘检测分支时,平均F1分数和平均IoU也各有下降,说明该分支对优化农业大棚提取结果有较大贡献。

|

|

表 4 网络设计消融实验 Table 4 Ablation experiments for the network design |

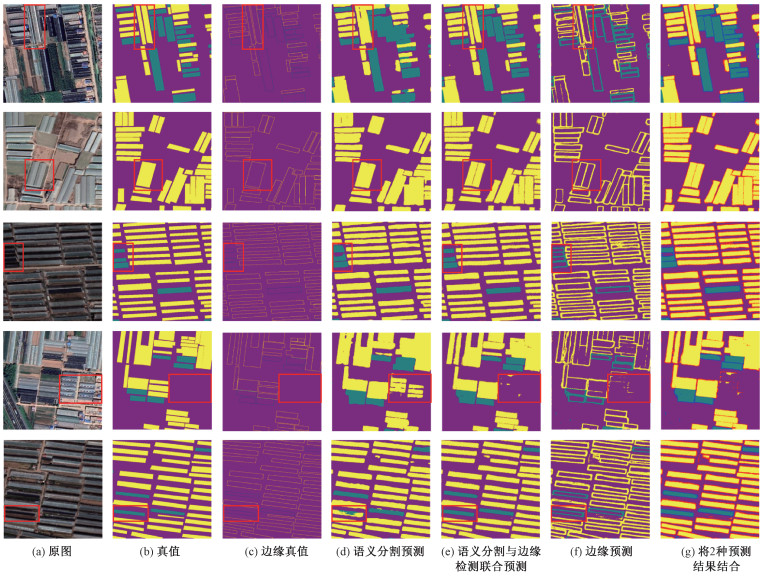

然后将模型是否使用边缘检测分支的局部预测图进行比较。从图 8的前3行能看出:模型增加边缘检测分支后对农业大棚边缘的预测效果更好,边缘更加平滑,能将距离相近且边界模糊不清的大棚提取出来。在预测边缘时,有时甚至能检测出人工未标注到的边界。从图 8的后2行中能看出:边缘检测分支的引入缓解了模型对2种农业大棚的错检现象。这得益于边缘像素的语义信息对边界内农业大棚类别的约束作用,使得农业大棚类别与边缘类别保持较强的一致性,从而提高分类效果。

|

Download:

|

| 图 8 训练时是否使用边缘检测分支的结果比较 Fig. 8 Comparison of whether edge detection branche is used during training. | |

文献[13-14]是当前使用深度学习提取农业大棚精度较高的算法。本文的精度略低于文献[13-14]中的精度,有以下原因:1)数据源不同:他们使用带有4个波段的高分2号(GF-2)影像,比本研究中使用的Google影像多了近红外波段,该波段给网络提供了更多用于区分农业大棚和背景的信息。而且Google数据是由多源、多时相数据采样拼接而成,这给农业大棚的提取带来了更大的困难。2)任务目标不同:文献[13-14]的网络只用于区分农业大棚和非农业大棚,是二分类网络,而且正负样本像素比例相当。而我们的网络用于区分阳棚、阴棚和背景,是三分类网络。由于现实中阴棚的比例远小于阳棚,所以在构造样本数据集时,阴棚的像素比例要少于阳棚。因此,我们的网络同时面临着三分类任务和类间样本比例极不均衡的挑战,所以精度会低一些。3)文献[13]中的PODD算法本质上是用ResNet作为骨干网络的Deeplabv3+。我们在实验中复现了该算法,发现该算法在测试区上精度不佳。因此,我们提出的改进U-Net算法在多类农业大棚分类上具有优越性。

5 结论针对当前农业大棚提取方法的特征提取能力弱,边缘提取效果不佳问题,本文提出一种基于高分辨率遥感影像同时提取阴棚和阳棚的语义分割模型。该模型引入ConvNeXt-Tiny骨干网络和注意力机制,强化了捕捉语义特征的能力,并增加边缘检测分支,以多任务学习的形式同时学习农业大棚的边界信息与语义信息,有效缓解了分割结果精度低、地物边缘平滑度差的缺陷。

经过优化,在实验区阳棚和阴棚的平均F1分数与平均IoU分别达到85.98%和75.50%,优于其他3种对比网络。然后使用改进U-Net模型提取研究区域内的阳棚和阴棚信息并制图,该制图结果对于农业设施普查,指导县域经济发展和农业政策制定具有一定指导意义。

改进U-Net模型在基于高分辨率遥感影像的阴棚阳棚信息提取中表现优异,但阴棚信息提取精度略低于阳棚,模型参数量较多,在大规模制图时存在一些漏检现象。在今后的研究中,针对阴棚样本数量少、精度低的问题,设计小样本学习方法,提升其精度; 针对模型复杂的问题,可以从模型压缩的方面做改进,在保证检测精度的同时减小模型参数; 针对大规模制图时对于阴棚和阳棚的漏检问题,可以增加样本数量并组合使用多种数据增强方法,提升模型的泛化能力。

| [1] |

陈经纬, 李宇, 陈俊, 等. 基于MFF-Deeplabv3+ 网络的高分辨率遥感影像建筑物提取方法[J/OL]. 中国科学院大学学报. (2023-03-21)[2023-05-10]. DOI: 10.7523/j.ucas.2023.010.

|

| [2] |

王雪英, 郭卫华. 面向对象的高分一号卫星影像大棚信息提取研究[J]. 湖北农业科学, 2019, 58(24): 217-220. Doi:10.14088/j.cnki.issn0439-8114.2019.24.053 |

| [3] |

汤紫霞, 李蒙蒙, 汪小钦, 等. 基于GF-2遥感影像的葡萄大棚信息提取[J]. 中国农业科技导报, 2020, 22(11): 95-105. Doi:10.13304/j.nykjdb.2019.0759 |

| [4] |

Yang D D, Chen J, Zhou Y, et al. Mapping plastic greenhouse with medium spatial resolution satellite data: development of a new spectral index[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2017, 128: 47-60. Doi:10.1016/j.isprsjprs.2017.03.002 |

| [5] |

Shi L F, Huang X J, Zhong T Y, et al. Mapping plastic greenhouses using spectral metrics derived from GaoFen-2 satellite data[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2019, 13: 49-59. Doi:10.1109/JSTARS.2019.2950466 |

| [6] |

Ronneberger O, Fischer P, Brox T. U-net: convolutional networks for biomedical image segmentation[C]//International Conference on Medical Image Computing and Computer-Assisted Intervention. Cham: Springer, 2015: 234-241. DOI: 10.1007/978-3-319-24574-4_28.

|

| [7] |

Sun K, Xiao B, Liu D, et al. Deep high-resolution representation learning for human pose estimation[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). June 15-20, 2019, Long Beach, CA, USA. IEEE, 2020: 5686-5696. DOI: 10.1109/CVPR.2019.00584.

|

| [8] |

Tan M X, Le Q V. EfficientNet: rethinking model scaling for convolutional neural networks[EB/OL]. 2019: arXiv: 1905.11946. (2019-05-24)[2023-05-10]. https://arxiv.org/abs/1905.11946.

|

| [9] |

Li M, Zhang Z J, Lei L P, et al. Agricultural greenhouses detection in high-resolution satellite images based on convolu-tional neural networks: comparison of faster R-CNN, YOLO v3 and SSD[J]. Sensors, 2020, 20(17): 4938. Doi:10.3390/s20174938 |

| [10] |

Redmon J, Farhadi A. YOLOv3: An incremental improve-ment[EB/OL]. 2018: arXiv: 1804.02767. (2018-04-08)[2023-05-10]. https://arxiv.org/abs/1804.02767.

|

| [11] |

Feng Q L, Niu B W, Chen B A, et al. Mapping of plastic greenhouses and mulching films from very high resolution remote sensing imagery based on a dilated and non-local convolutional neural network[J]. International Journal of Applied Earth Observation and Geoinformation, 2021, 102: 102441. Doi:10.1016/j.jag.2021.102441 |

| [12] |

Baghirli O, Ibrahimli I, Mammadzada T. Greenhouse seg-mentation on high-resolution optical satellite imagery using deep learning techniques[EB/OL]. 2020: arXiv: 2007. 11222. (2020-07-22)[2023-05-10]. https://arxiv.org/abs/2007.11222.

|

| [13] |

Feng J N, Wang D L, Yang F, et al. PODD: a dual-task detection for greenhouse extraction based on deep learning[J]. Remote Sensing, 2022, 14(19): 5064. Doi:10.3390/rs14195064 |

| [14] |

Zhang X P, Cheng B, Chen J F, et al. High-resolution boundary refined convolutional neural network for automatic agricultural greenhouses extraction from GaoFen-2 satellite imageries[J]. Remote Sensing, 2021, 13(21): 4237. Doi:10.3390/rs13214237 |

| [15] |

Zhang Z X, Liu Q J, Wang Y H. Road extraction by deep residual U-net[J]. IEEE Geoscience and Remote Sensing Letters, 2018, 15(5): 749-753. Doi:10.1109/LGRS.2018.2802944 |

| [16] |

Liu Z, Mao H Z, Wu C Y, et al. A ConvNet for the 2020s[C]//2022 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). June 18-24, 2022, New Orleans, LA, USA. IEEE, 2022: 11966-11976. DOI: 10.1109/CVPR52688.2022.01167.

|

| [17] |

He K M, Zhang X Y, Ren S Q, et al. Deep residual learning for image recognition[C]//2016 IEEE Conference on Com-puter Vision and Pattern Recognition (CVPR). June 27-30, 2016, Las Vegas, NV, USA. IEEE, 2016: 770-778. DOI: 10.1109/CVPR.2016.90.

|

| [18] |

Liu Z, Lin Y T, Cao Y, et al. Swin transformer: hierarchical vision transformer using shifted windows[C]//2021 IEEE/CVF International Conference on Computer Vision (ICCV). October 10-17, 2021, Montreal, QC, Canada. IEEE, 2022: 9992-10002. DOI: 10.1109/ICCV48922.2021.00986.

|

| [19] |

Hou Q B, Zhou D Q, Feng J S. Coordinate attention for efficient mobile network design[C]//2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). June 20-25, 2021, Nashville, TN, USA. IEEE, 2021: 13708-13717. DOI: 10.1109/CVPR46437.2021.01350.

|

| [20] |

Woo S, Park J, Lee J Y, et al. CBAM: convolutional block attention module[C]//European Conference on Computer Vision. Cham: Springer, 2018: 3-19. DOI: 10.1007/978-3-030-01234-2_1.

|

| [21] |

Takikawa T, Acuna D, Jampani V, et al. Gated-SCNN: gated shape CNNs for semantic segmentation[C]//2019 IEEE/CVF International Conference on Computer Vision (ICCV). October 27-November 2, 2019, Seoul, Korea (South). IEEE, 2020: 5228-5237. DOI: 10.1109/ICCV.2019.00533.

|

| [22] |

Zhen M M, Wang J L, Zhou L, et al. Joint semantic segmentation and boundary detection using iterative pyramid contexts[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). June 13-19, 2020, Seattle, WA, USA. IEEE, 2020: 13663-13672. DOI: 10.1109/CVPR42600.2020.01368.

|

| [23] |

Loshchilov I, Hutter F. Fixing weight decay regularization in Adam[EB/OL]. 2017: arXiv: 1711.05101. (2017-11-14)[2023-05-10]. https://arxiv.org/abs/1711.05101.

|

| [24] |

Ding L, Tang H, Bruzzone L. LANet: local attention embedding to improve the semantic segmentation of remote sensing images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2021, 59(1): 426-435. Doi:10.1109/TGRS.2020.2994150 |

| [25] |

Chen L C, Zhu Y K, Papandreou G, et al. Encoder-decoder with atrous separable convolution for semantic image segmen-tation[C]//European Conference on Computer Vision. Cham: Springer, 2018: 833-851.10.1007/978-3-030-01234-2_49.

|

2024, Vol. 41

2024, Vol. 41