2. 中国科学院大学电子电气与通信工程学院, 北京 100049;

3. 中国科学院计算机网络信息中心, 北京 100083;

4. 中国科学院大学计算机科学与技术学院, 北京 100049

2. School of Electronic, Electrical and Communication Engineering, University of Chinese Academy of Sciences, Beijing 100049, China;

3. Computer Network Information Center, Chinese Academy of Sciences, Beijing 100083, China;

4. School of Computer Science and Technology, University of Chinese Academy of Sciences, Beijing 100049, China

建筑物作为生产生活中必不可少的场所,是基础的地理信息要素之一。精确地获得建筑物信息在城市规划、地图制作更新、环境监测以及交通规划管理等诸多领域具有重要的应用价值。然而,传统建筑物提取方法,例如土地测量、车载信息采集等,耗时费力、效率低下,难以满足大规模实际应用的需求。随着卫星、无人机等地球监测平台的迅速发展,遥感影像的空间分辨率也不断提升,为提取建筑物信息提供了海量的高分辨率遥感影像。分辨率的提高使得影像中建筑物具有更加清晰的纹理和结构,但同时带来了形状多变、背景复杂等问题。所以,如何在高分辨率遥感影像中准确地提取建筑物信息一直是遥感信息提取与高分辨率对地观测应用中的重要研究方向。

基于遥感影像提取建筑物信息的方法根据特征构造规则可分为2类:传统方法和基于深度学习的方法。其中,传统方法大多根据建筑物的空间结构、边缘[1]、上下文信息[2]等特性,人工构造相应的特征,结合机器学习的识别算法[3],实现遥感影像中建筑物信息的提取,如基于纹理信息的方法[4]、基于像素形状指数的方法[5]、基于空间结构和波谱特征的方法[6]和基于形态学建筑物指数(morphological building index, MBI)的方法[7]。传统方法在中低分辨率的建筑物提取中取得了不错的效果,但是通常需要很强的先验知识和辅助数据。另外,传统方法往往只能反映低层次特征、难以获得更高层的语义信息,所以泛化能力比较有限[8]。因此,往往不能满足高分辨率遥感影像建筑物提取的精度需求。

近年来,深度卷积神经网络(deep convolutional neural network, DCNN)在图像处理、语音识别、自然语言处理等方面取得了前所未有的成果[5, 9-10]。相较于传统方法,DCNN根据大量的样本学习得到特征,提取的特征更加准确、鲁棒以及深层化,能够在较为复杂的环境下完成信息的提取。同时,由于遥感影像数量众多,可以更好地发挥深度学习的优势。建筑物提取方法也逐渐从传统方法转向以完全卷积网络[11](fully convolutional network, FCN)、UNet和Deeplab系列为代表的深度学习方法。

FCN首次实现端到端的语义分割,通过一次前向传播就可以直接获得图像中每个像素的标签,成为语义分割领域一个重要的里程碑。许多基于FCN的深度学习方法被提出以进行建筑物的提取:Ji等[12]使用FCN完成了航空和卫星影像中建筑物的提取;杨旭勃和田金文[13]提出一种轻量化全连接分割网络ZF-FCN,应用于小数据集中的小型建筑物提取;Zuo等[14]设计分层融合卷积神经网络HF-FCN,集合多尺度特征,提高了建筑物提取的精度。但FCN中连续下采样操作会造成空间信息的丢失,使模型产生的特征图无法获得全局信息,导致提取建筑物的精度受到限制。

UNet[15]使用跳跃连接将编码层与解码层中的特征图结合,并在上采样时使用反卷积代替线型插值,使网络能够接收更多的上下文细节特征,提高了模型的提取精度。古煜民和阎福礼[16]以3种不同的卷积神经网络为骨架对标准UNet++进行改造,提高了模型的运行效率与特征提取能力。Liu等[17]提出深度残差序列学习网络SS-Net,在UNet跳跃连接中加入残差表示,实现遥感影像中建筑物信息的提取。Yi等[18]以UNet为基础结合残差连接模块构建DeepResUnet,增强特征的表达能力。胡明洪等[19]结合注意力机制提出SER-Unet,徐佳佳等[20]结合金字塔池化提出PRCUnet,都增强了模型对于小尺寸建筑物的提取能力。基于UNet的方法,虽然在一定程度上提高了提取精度,但是没有充分融合深层特征与浅层特征,容易导致特征图中重要信息丢失。另外,跳跃连接中可能会引入冗余信息,造成提取精度的降低。

Deeplab系列[21-24]引入空洞空间卷积池化金字塔(atrous spatial pyramid pooling, ASPP),通过并行或串联不同空洞率的空洞卷积以扩大感受野,从而有效减少细节丢失,进一步提高模型精度。Deeplab系列逐渐成为主流的语义分割模型,比较成熟的Deeplabv3+网络得到了广泛应用。Guo等[25]选用Xception[26]作为Deeplabv3+网络的骨干网络,并应用到马萨诸塞州建筑物数据集上,取得了较高的提取精度。王华俊和葛小三[27]将轻量化网络引入Deeplabv3+中,提出一种轻量化建筑物提取模型,减少了模型参数量,提高了模型的训练速度。

上述方法在建筑物提取中成果显著,但仍有以下问题:1)对全局特征描述不够,导致提取结果中出现空洞、不连续等现象。例如,在Deeplabv3+网络模型中,解码层仅利用骨干网络产生了一个低级特征图,只能获得局部特征,没有充分融合深层特征与浅层特征。2)提取细节特征的能力不足,导致提取结果中出现错检现象。例如,UNet中的连续下采样、Deeplabv3+中较大的空洞率的空洞卷积和4倍上采样都会造成特征图中内容细节和空间位置信息丢失。3)多尺度表达能力不足,导致提取结果中出现小目标漏检现象。对于不同尺度和不同形状的建筑物,缺少对特征的优化选择,算法泛化性有待提高。例如,在UNet体系结构中,仅有简单的跳跃连接以恢复信息,缺乏多尺度特征的提取和融合。在Deeplabv3+ 中,仅使用骨干网络产生的最大尺度特征图,没有充分融合不同尺度的特征图。

针对上述问题,本文提出一种基于MFF-Deeplabv3+(multiscale feature fusion-Deeplabv3+)网络的高分辨率遥感影像建筑物提取方法,通过设计更有效的多尺度特征增强模块(atrous spatial pyramid pooling with Do-Conv, Do-ASPP)模块,提高模型的多尺度特征提取能力以及对小尺寸建筑物的检测能力、训练速度与性能;同时设计更有效的特征融合模块,融合对应深层特征与浅层特征以丰富语义信息;另外引入更有效的注意力机制模块,优化特征学习。最终精确有效地实现高分辨率遥感影像中建筑物提取。

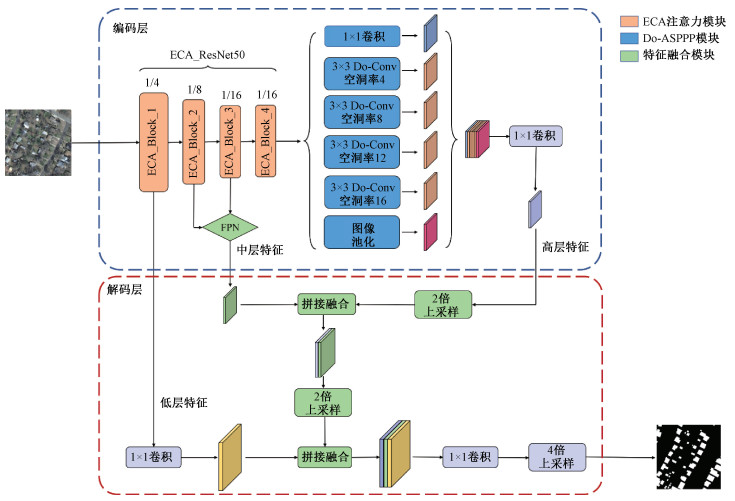

1 研究方法 1.1 MFF-Deeplabv3+方法概述本文方法的建筑物提取网络MFF-Deeplabv3+ 结构如图 1所示,以Deeplabv3+网络为基本框架,使用引入高效通道注意力机制的ResNet50作为骨干网络,同时设计了Do-ASPP模块和特征融合模块,改进的关键处理环节如下。

|

Download:

|

| 图 1 MFF-Deeplabv3+的网络结构 Fig. 1 Structure of the MFF-Deeplabv3+ network | |

1) 加入Do-ASPP模块。通过修改空洞卷积的参数与数量以得到不同的感受野,从而增强模型获取多尺度信息的能力;替换传统卷积为逐深度过参数化卷积[28](depthwise over-parameterized convolutional layer, Do-Conv),在模型参数量增加不大的前提下提升模型的训练速度和性能。模块产生的特征图在经过1×1卷积降维后作为解码层的一个输入。

2) 加入特征融合模块。在模型编码层设计特征金字塔网络(feature pyramid networks, FPN)模块[29],通过融合骨干网络多阶段产生的不同尺寸特征图获得更广泛的语义特征。FPN模块产生的特征图作为解码层输入的另一个重要分支;在解码层增加跳跃连接的数量以充分融合深层特征与浅层特征,增强了特征图中像素的连续性,恢复了在编码过程中下采样丢失的细节信息,最终获得精度较高的建筑物提取结果。

3) 引入有效注意力机制模块。输入高分辨率遥感影像通过骨干网络提取信息时,有效通道注意力机制[30](efficient channel attention, ECA)根据特征图层次和位置的重要性设置不同的权重,从而可以选择更准确的特征进行表达,以提高网络模型的提取准确率。

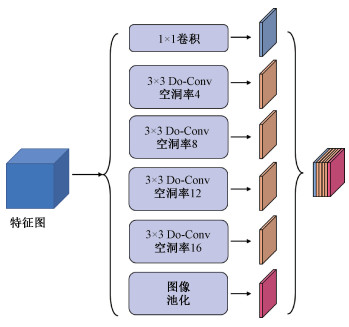

1.2 Do-ASPP模块Do-ASPP模块能够捕获多尺度上下文信息,有效降低空间信息的损失。原ASPP模块中较大空洞率的卷积核仅有利于提取大尺寸建筑物信息,而对于较小尺寸建筑物则会造成细节信息和空间信息丢失。随着骨干网络生成特征图的尺寸越来越小,增较小空洞率的空洞卷积对于小尺寸建筑物的提取十分重要。

本文采用的网络模型对ASPP模块的改进包括两方面:空洞率参数和卷积方式。Do-ASPP模块如图 2所示。将原先空洞卷积的空洞率从6、12、18修改为4、8、12、16。修改后的模块具有更多尺度的卷积核,因此能够提取不同尺度的特征,从而增强模型识别提取不同尺寸建筑物的能力。

|

Download:

|

| 图 2 Do-ASPP模块结构 Fig. 2 Structure of the Do-ASPP module | |

同时将原先模块中的3×3标准卷积替换为Do-Conv。Do-Conv结合了普通卷积与深度卷积,通过增加线性层来提高模型的特征表达能力,同时连续的线性层可由单个线性层表示,从而不会大量增加模型的复杂度。普通卷积与深度卷积的结合有2种形式,分别为特征组成与核组成。特征组成首先对输入特征图进行深度卷积,再进行标准卷积。核组成方式首先将深度卷积核与标准卷积核合并,然后利用得到的中间结果进行标准卷积。2种方式在数学上等价,但是核组成方式具有更高的训练效率,因为2个卷积核合并后在推理时不会增加计算开销,不影响计算速度。所以,Do-Conv选择使用核组成的方式进行训练,其计算公式如下所示

| $ \left\{ {\begin{array}{*{20}{c}} {{\boldsymbol{W}}' = {{\boldsymbol{D}}^{\rm{T}}}^\circ {\boldsymbol{W}}, }\\ {{\boldsymbol{O}} = {\boldsymbol{W}}' * {\boldsymbol{P}}.} \end{array}} \right. $ | (1) |

式中:D、W分别表示深度卷积核、标准卷积核,O、P分别表示输出特征图与输入特征图,运算符○、*分别代表深度卷积与标准卷积。对比传统卷积,在不增加网络推理计算量的前提下,Do-Conv使用更多的参数参加训练,不仅收敛速度更快,而且可以提高网络性能。

Do-ASPP模块的具体实现细节为:1/16大小、2 048通道的输入特征图分别进行1×1卷积、空洞率组合为4、8、12、16的Do-Conv以及池化,得6个尺寸、通道数相同的特征图,将这6个1/16大小、256通道数的特征图拼接融合得到此模块输出的特征图。

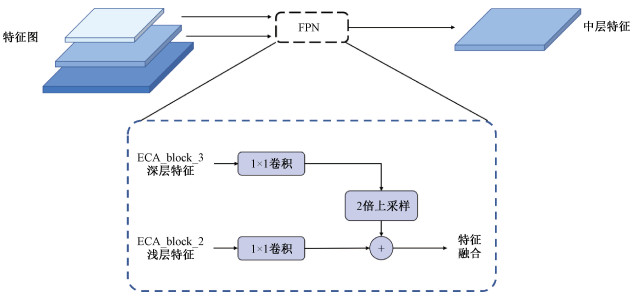

1.3 特征融合模块特征融合模块能够有效融合深层特征与浅层特征,增强提取结果像素的连续性。低层特征的语义信息少,但位置信息精确;高层特征的语义信息丰富,但位置粗略。因此,网络模型产生的不同尺寸、不同层次的特征图都会影响最终提取结果的精度,但Deeplabv3+在解码层融合时仅使用了骨干网络第一层产生的特征图,特征不够丰富导致提取精度降低。

本文方法在编码层增加FPN模块,利用它将骨干网络产生的不同尺寸、不同层次的特征图融合,并将融合特征图作为解码部分中逐层上采样融合的关键组成部分。FPN能够有效联合低层与高层的特征信息,结构如图 3所示,自下而上地将大尺寸的低层特征与小尺寸的高层特征进行连接,增强不同尺度下特征图的特征信息。FPN模块的输入为2个不同尺寸的特征图,经过融合后得到图 3所示的融合特征图。

|

Download:

|

| 图 3 FPN模块结构 Fig. 3 Structure of the FPN module | |

FPN模块的具体实现细节为:首先对骨干网络第3层产生的深层特征图进行1×1卷积降维,再进行2倍上采样,此时得到1/8大小、256通道数的特征图,将其作为FPN上层分支;然后,对骨干网络第2层产生的浅层特征图进行1×1卷积降维,得到大小、通道数与上层相同的特征图,将其作为FPN的下层分支;最后,将上层分支与下层分支相加融合产生最终特征图。FPN模块提取的特征具有丰富的语义信息,减少了细节信息的丢失,能够有效提高提取的准确率。

在Deeplabv3+网络解码部分,首先将编码部分输出的特征图进行降维,然后使用简单的4倍上采样以恢复特征图的尺寸。由于上采样只能恢复尺寸并不能恢复特征图像素矩阵中的原有数值,采样倍数过大会导致原本连续的像素在增大尺寸的图像中变得不连续,影响提取结果精度,严重时提取结果中可能会出现断裂、大量空洞等现象。针对这个问题,采用逐步上采样的方法,即先将Do-ASPP模块输出特征图 2倍上采样后再与FPN模块输出特征图融合,然后将融合结果进行第2次2倍上采样,相当于利用2次2倍上采样实现4倍上采样,使提取建筑物结果中像素值更加连续、与原图像中像素值更加接近,从而有效减少结果中的空洞现象,提高精度。

特征融合模块的具体实现细节为:2倍上采样编码部分输出的特征图,此时特征图尺寸与FPN模块产生特征图尺寸一致,对二者拼接融合后使用1×1卷积进行降维,此时特征图为1/8大小、256通道数,然后继续对特征图 2倍上采样,最后将其与骨干网络第1层产生的1/4大小、64通道数的特征图拼接融合得到最终特征图。以上改进仅仅增加了1次卷积操作和2次上采样操作,参数量增加非常少。

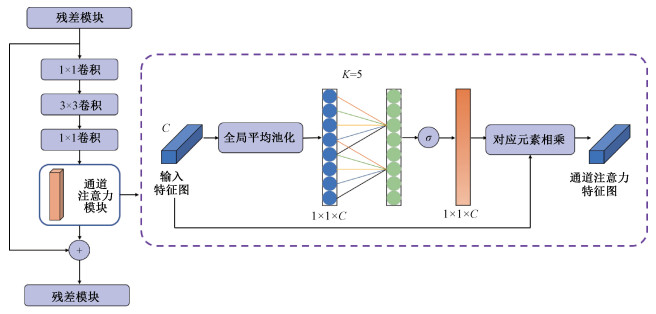

1.4 注意力机制模块为进一步提升模型精度,引入轻量化的通道注意力机制。大多数注意力机制的引入方法,因要同时考虑位置注意力和通道注意力,导致设计过于复杂。本文模型中已有Do-ASPP模块和特征融合模块用于增强空间信息,因此,再引入轻量化ECA通道注意力模块。ECA相比于其他注意力机制,对于模型复杂度的增加更小,同时还具有显著的提升效果。

ECA通道注意力机制从避免降维和跨通道信息交互两方面进行改进,在SE(squeeze and excitation)[31]注意力机制的基础上去掉其全连接层以避免降维对预测结果的影响。引入ECA通道注意力机制的残差模块如图 4所示。ECA注意力机制在不降维的全局平均池化后利用共享权重的一维卷积进行特征学习,通过考虑每个通道与其相邻的K个通道的相关性以捕获跨通道信息。ECA通道注意力机制避免了降维,以极轻量的方式有效捕获了跨通道交互的信息。

|

Download:

|

| 图 4 通道注意力残差模块的结构 Fig. 4 Structure of the channel attention residual model | |

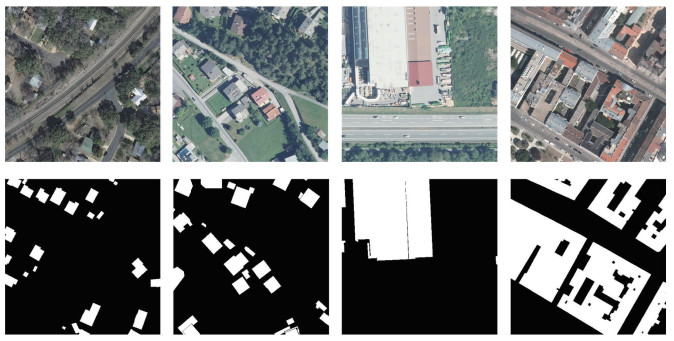

实验采用的数据集是法国国家信息与自动化研究所(institut national de recherche en informatique et en automatique, Inria)2017年发布的城市航空遥感建筑物数据集(Inria aerial image labeling dataset)。Inria数据集是目前建筑物语义分割领域最常见的数据集,该数据集标签分为建筑与非建筑2种,尺寸为5 000×5 000共360张。考虑到计算机内存以及小尺寸建筑物的识别,将影像统一裁剪为尺寸为512×512的小尺寸影像。裁剪完后的部分影像与标签如图 5所示。对剪裁后的影像进行随机旋转、透视变换、亮度变换以及颜色变换等数据增强操作,获得17 985张航空遥感建筑物影像。实验按照8∶2的比例划分训练集、测试集,得到训练集14 388张、测试集3 597张。

|

Download:

|

| 图 5 Inria建筑物数据集(部分样本) Fig. 5 Samples of the Inria data set | |

泛化实验采用的数据集为WHU建筑物数据集,本文使用其中的卫星影像数据集,该数据集由6个相邻卫星的影像组成,覆盖东亚地区860 km2,包含34 085栋建筑。

2.2 实验环境及评价标准本文所有实验均在装有CentOS7.9操作系统的工作站进行。工作站配置了Intel i9-10920X处理器,125 G的内存以及Nvidia GeForce RTX 3090显卡。所有网络模型均在基于Python3.7+Pytorch1.8.0+CUDA11.2的深度学习环境下运行。采用随机梯度下降(stochastic gradient descent, SGD)优化器迭代更新参数,输入图片大小为512×512,批处理数量(batch size)为16。

为定量评估本文方法的有效性,采用像素精度(pixel accuracy, PA)、均像素精度(mean pixel accuracy, MPA)、均交并比(mean intersection over union, MIoU)、频权交并比(frequency weighted intersection over union, FWIoU)作为评价建筑物提取精度的主要标准。其中,PA指正确预测的像素数量占总像素的比例,MPA指每一类预测正确的像素数量占该类总像素数量的比例的平均值,MIoU表示提取建筑物结果与标签真值的重合度,FWIoU是均交并比的简单提升,根据每个类出现的概率设置权重。由于MIoU具有简洁和代表性强的特征,所以选择其作为最主要的评价标准。所用指标计算公式如下:

| $ {\mathrm{PA}}=\frac{\sum_{i=0}^k p_{i i}}{\sum_{i=0}^k \sum_{j=0}^k p_{i j}}, $ | (2) |

| $ {\text { MPA }}=\frac{1}{k+1} \sum_{i=0}^k \frac{p_{i i}}{\sum_{j=0}^k p_{i j}}, $ | (3) |

| $ {\rm{MIoU}}=\frac{1}{k+1} \sum_{i=0}^k \frac{p_{i i}}{\sum_{j=0}^k p_{i j}+\sum_{j=0}^k\left(p_{i j}-p_{i i}\right)}, $ | (4) |

| $ {\text { FWIoU }}=\frac{1}{\sum_{i=0}^k \sum_{j=0}^k p_{i j}} \sum_{i=0}^k \\ \frac{p_{i i}}{\sum_{j=0}^k p_{i j}+\sum_{j=0}^k\left(p_{i j}-p_{i i}\right)}. $ | (5) |

式中:k+1为图像像素的类别数量,pij表示实际类别为i而预测类别为j的像素数量,pii表示实际类别和预测均为i的像素数量。

2.3 实验结果分析 2.3.1 网络模型对比将本文提出的MFF-Deeplabv3+与UNet、Deeplabv3、Deeplabv3+、DeepResUnet以及HF-FCN-Res提取的建筑物进行对比分析,实验中Deeplabv3和Deeplabv3+的骨干网络均使用ResNet50。

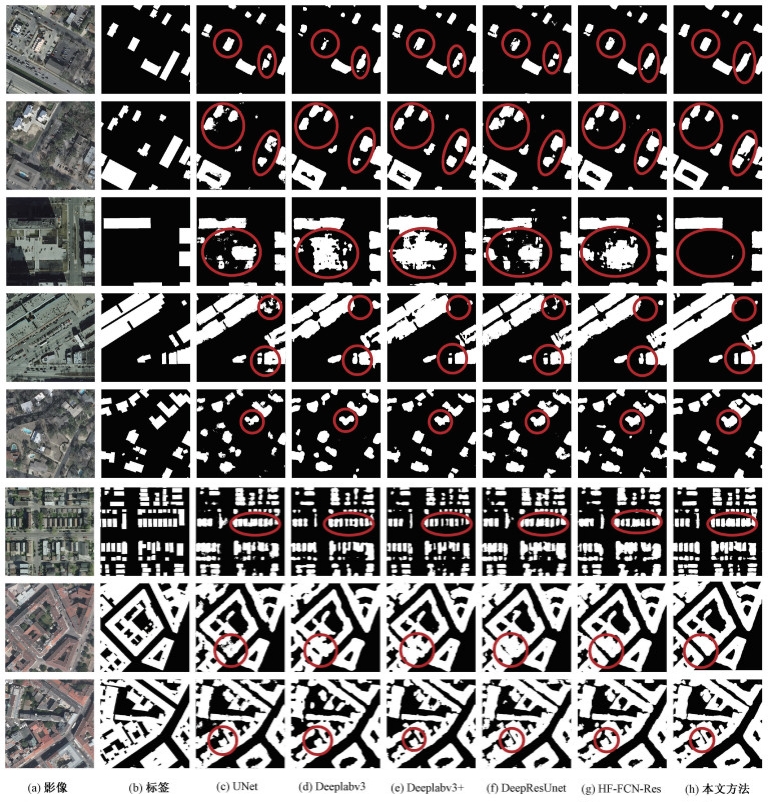

图 6给出采用不同方法的建筑物提取结果,其中6(a)列为遥感影像,6(b)列为标签图像,6(c)~6(h)列分别为采用UNet、Deeplabv3、Deeplabv3+、DeepResUnet、HF-FCN-Res以及MFF-Deeplabv3+网络模型的建筑物提取结果。

|

Download:

|

| 图 6 不同方法的建筑物提取结果 Fig. 6 Images of building extraction results of different methods | |

从图 6中可以看出UNet提取的建筑物中存在大量空洞,特别是大型建筑以及边缘处尤为明显。可能的原因是UNet特征提取使用了普通的卷积与池化,导致大量细节信息丢失,产生的1/16大小的特征图感受野范围小,所以在提取较大尺寸建筑物时会出现空洞的现象。Deeplabv3和DeepLabv3+提取结果中空洞现象改善了很多,分析原因为这2种网络都加入了空洞空间卷积池化金字塔池化进行多尺度的特征提取,整合不同尺寸不同层次的特征,同时空洞卷积扩大了感受野,在一定程度上解决了问题。HF-FCN-Res与DeepResUnet通过残差模块增大了感受野,可以弥补出现空洞的现象。本文方法通过特征融合模块增强了获得的高层语义信息,减少了浅层特征与对应深层特征的语义鸿沟,同时通过Do-ASPP模块,可以获得更多尺寸的特征,所以提取的建筑物提取结果中出现的空洞相比于其他方法较少,提取效果有一定提升。

从图 6的提取结果可以看出UNet、Deeplab、DeepResUnet以及HF-FCN-Res的提取结果都存在错分、漏分的现象,其中UNet尤为严重,其原因可能为UNet仅仅通过卷积提取的特征层次较低,高级语义信息不丰富。Deeplabv3通过ASPP在一定程度上改善了语义信息的丰富程度,Deeplabv3+通过编码解码结构融合了不同层次特征,相较于Deeplabv3进一步提高了语义信息的丰富程度,所以提取结果相对较好,但Deeplabv3+中的4倍上采样会造成必要空间信息丢失,所以同样会出现上述现象。DeepResUnet与HF-FCN-Res相似,都通过分层融合提取了高级特征信息并丰富了多尺度特征,所以结果相对好些,但DeepResUnet与HF-FCN-Res的解码层结构较简单仍会导致空间信息的丢失。从第3行的红色框可以看出,本文方法提取的建筑物与其他方法相比没有明显的错分。同时从第7和第8行的分类结果可以看出,在面对形状较为复杂的建筑物时,本文方法错分、漏分较其他方法有明显的改善。再者,第6行表明对于密集分布的建筑物,本文方法提取结果有一定的提升,且小目标漏分的现象也有改善。分析原因为本文方法通过加入特征融合模块,提高了特征语义信息的表达能力,同时通过通道学习力机制增强了深层特征与浅层特征中一致的部分,抑制了不重要的冗余信息及噪声,对最终的提取结果进行了优化。但是第2与第3行的提取结果显示,本文方法仍存在较少的错分与漏分现象,其原因可能为虽然相较于其他方法, 本文方法具有更多尺度的特征,但仍无法完全恢复丢失的信息。总体来说,相较于其他几种方法提取结果中的错分、漏分现象,本文方法有了不错的改善,能够较好地获得建筑物提取结果。

对比不同方法的提取结果,可以看出本文方法的建筑物提取结果与标签图像的相似程度更大,即分割精度更高,且具有更强的鲁棒性。

对以上各方法的定量评价如表 1所示,从表中可以看出,本文方法与UNet、Deeplabv3、Deeplabv3+、HF-FCN-Res、DeepResUnet相比,在PA、MPA、FWIoU和MIoU指标中均取得了最高的精度。

|

|

表 1 各种方法定量比较 Table 1 Quantitative comparison of various methods |

为进一步了解本文模型的性能,对本文方法设计的多个模块进行消融实验。对模型中加入的各子模块进行定量精度评价,分别分析Deeplabv3+ & ECA、Deeplabv3+ & ECA & Do-Conv、Deeplabv3+ & ECA & Do-Conv & FPN在Inria数据集上的提取结果。表 2给出了消融实验的结果,相较于基础框架Deeplabv3+,逐项加入ECA、Do-Conv、FPN子模块后,PA、MPA、MIoU和FWIoU等指标均有不同程度的提升。其中效果最明显的是ECA,最不明显的为Do-Conv。推测原因如下:Do-Conv主要针对模型训练加速模型的收敛,所以MIoU的提升较小。

|

|

表 2 Inria数据集上的消融实验 Table 2 Ablation experiment with the Inria data set |

为验证改进空洞率组合的有效性,针对空洞率组合进行对比实验。表 3为本文方法原先的空洞率组合与修改后的空洞率组合定量分析结果。通过对比可以发现,相较于原先空洞率组合的测试结果,改进空洞率的模型预测结果有明显的提升。

|

|

表 3 ASPP模块中不同空洞率组合下的测试结果 Table 3 Test results under different combinations of dilation rate in ASPP module |

为验证本文方法的泛化能力,将在Inria数据集上训练的MFF-Deeplabv3+模型直接应用于WHU建筑物数据集。

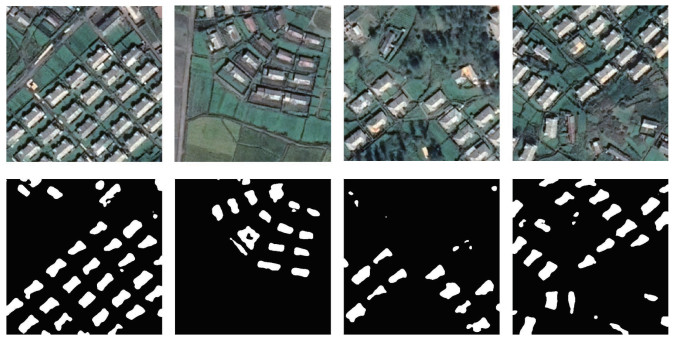

在WHU建筑物数据集上提取的建筑物可视化结果如图 7所示,定量评价如表 4所示。可以看出,本文模型在WHU建筑物数据上有较好的提取结果,除第2张影像错误地将部分围栏识别为建筑物外没有其他明显错分现象,并且漏分现象较少。相比于Inria数据集,WHU建筑物数据集分辨率较低,表现为图像中建筑物尺寸较小。实验结果说明本文方法可以适用于不同尺寸、不同环境下的建筑物提取,即本文方法具有较好的泛化性。

|

Download:

|

| 图 7 WHU建筑物数据集上的建筑物提取结果 Fig. 7 Visualization results of building extraction in the WHU building data set | |

|

|

表 4 WHU建筑物数据集泛化实验定量评价 Table 4 Quantitative evaluation of generalization test in the WHU building data set |

针对高分辨率复杂环境下建筑物提取精度低以及容易出现空洞现象、错分和漏分等问题,本文提出一种基于MFF-Deeplabv3+网络的高分辨率遥感影像建筑物提取方法。MFF-Deeplabv3+是一个基于编码-解码结构的神经网络模型,为充分挖掘图像的深层特征、多尺度信息以及提高建筑物提取精度,引入Do-ASPP模块、FPN模块和ECA注意力机制模块。在定性和定量评估中,将MFF-Deeplabv3+与UNet、Deeplabv3和Deeplabv3+ 等3种方法进行比较分析,实验结果表明:

1) MFF-Deeplabv3+中的Do-ASPP模块通过并行不同尺度的空洞卷积核,可增强对不同尺度建筑物的特征及高级语义信息的提取,有效减少空洞现象的出现。模块中Do-Conv的使用在一定程度上提高了提取的精度。

2) MFF-Deeplabv3+的FPN模块通过融合不同尺寸的特征图,可以获得更广泛和更深层的特征,有效地提高了不同尺寸建筑物提取的精度。模块通过逐层上采样将4倍上采样分解为2个2倍上采样,可以有效地解决上采样倍数过大造成的空间信息、细节信息的丢失。

3) MFF-Deeplabv3+中的ECA注意力机制模块,有效捕获了跨通道交互的信息,可增强关键特征的表达,抑制噪声和不重要的特征,进一步增强模型提取的精度。

4) 在Inria数据集的对比实验中,本文方法取得了最高精度,在不同分辨率的数据集上同样取得了不错的提取效果,表明本文所提出的方法相对其他方法更具有准确性与可行性,且在面对不同场景、不同尺度的数据时仍有不错的提取效果,即泛化性较强。但由于不同数据集的图像采集时间、分辨率、建筑物形状等不同,会导致在其他数据集中建筑物提取性能有一定程度的下降。

本文方法具有较强的泛化能力,但是检测效果在一定程度上取决于数据集的数量和质量。未来,我们将尝试建立一个更大更丰富的训练数据集,以进一步提高模型的泛化性。而且,本文方法是以像素为基本分析单位,如何将建筑物作为分析对象进行识别、提取,仍需要进一步研究。

| [1] |

Sirmacek B, Unsalan C. Urban-area and building detection using SIFT keypoints and graph theory[J]. IEEE Transactions on Geoscience and Remote Sensing, 2009, 47(4): 1156-1167. Doi:10.1109/TGRS.2008.2008440 |

| [2] |

Lee D S, Shan J, Bethel J S. Class-guided building extraction from ikonos imagery[J]. Photogrammetric Engineering & Remote Sensing, 2003, 69(2): 143-150. Doi:10.14358/PERS.69.2.143 |

| [3] |

Li E, Xu S B, Meng W L, et al. Building extraction from remotely sensed images by integrating saliency cue[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2017, 10(3): 906-919. Doi:10.1109/JSTARS.2016.2603184 |

| [4] |

Bischof H, Schneider W, Pinz A J. Multispectral classification of Landsat-images using neural networks[J]. IEEE Transactions on Geoscience and Remote Sensing, 1992, 30(3): 482-490. Doi:10.1109/36.142926 |

| [5] |

Zhang F, Du B, Zhang L P. Scene classification via a gradient boosting random convolutional network framework[J]. IEEE Transactions on Geoscience and Remote Sensing, 2016, 54(3): 1793-1802. Doi:10.1109/TGRS.2015.2488681 |

| [6] |

Tarabalka Y, Benediktsson J A, Chanussot J. Spectral-spatial classification of hyperspectral imagery based on partitional clustering techniques[J]. IEEE Transactions on Geoscience and Remote Sensing, 2009, 47(8): 2973-2987. Doi:10.1109/TGRS.2009.2016214 |

| [7] |

Huang X, Zhang L P. A multidirectional and multiscale morphological index for automatic building extraction from multispectral GeoEye-1 imagery[J]. Photogrammetric Engineering & Remote Sensing, 2011, 77(7): 721-732. Doi:10.14358/PERS.77.7.721 |

| [8] |

Shi Y L, Li Q Y, Zhu X X. Building segmentation through a gated graph convolutional neural network with deep structured feature embedding[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2020, 159: 184-197. Doi:10.1016/j.isprsjprs.2019.11.004 |

| [9] |

Collobert R, Weston J. A unified architecture for natural language processing: deep neural networks with multitask learning[C]//Proceedings of the 25th international conference on Machine learning. July 5-9, 2008, Helsinki, Finland. New York: ACM, 2008: 160-167. DOI: 10.1145/1390156.1390177.

|

| [10] |

Zhu X X, Tuia D, Mou L C, et al. Deep learning in remote sensing: a comprehensive review and list of resources[J]. IEEE Geoscience and Remote Sensing Magazine, 2017, 5(4): 8-36. Doi:10.1109/MGRS.2017.2762307 |

| [11] |

Song S R, Lichtenberg S P, Xiao J X. SUN RGB-D: a RGB-D scene understanding benchmark suite[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). June 7-12, 2015, Boston, MA, USA. IEEE, 2015: 567-576. DOI: 10.1109/CVPR.2015.7298655.

|

| [12] |

Ji S P, Wei S Q, Lu M. Fully convolutional networks for multisource building extraction from an open aerial and satellite imagery data set[J]. IEEE Transactions on Geoscience and Remote Sensing, 2019, 57(1): 574-586. Doi:10.1109/TGRS.2018.2858817 |

| [13] |

杨旭勃, 田金文. 小数据集中的小型建筑物提取方法研究[J]. 测绘通报, 2019(10): 51-55. Doi:10.13474/j.cnki.11-2246.2019.0317 |

| [14] |

Zuo T C, Feng J T, Chen X J. HF-FCN: hierarchically fused fully convolutional network for robust building extraction[M]//Computer Vision-ACCV 2016. Cham: Springer International Publishing, 2017: 291-302. DOI: 10.1007/978-3-319-54181-5_19.

|

| [15] |

Ronneberger O, Fischer P, Brox T. U-net: convolutional networks for biomedical image segmentation[M]. Cham: Springer International Publishing, 2015: 234-241. Doi:10.1007/978-3-319-24574-4_28

|

| [16] |

古煜民, 阎福礼. 基于不同骨架UNet++网络的建筑物提取[J]. 中国科学院大学学报, 2022, 39(4): 512-523. Doi:10.7523/j.ucas.2020.0040 |

| [17] |

Liu J Y, Wang S S, Hou X W, et al. A deep residual learning serial segmentation network for extracting buildings from remote sensing imagery[J]. International Journal of Remote Sensing, 2020, 41(14): 5573-5587. Doi:10.1080/01431161.2020.1734251 |

| [18] |

Yi Y N, Zhang Z J, Zhang W C, et al. Semantic segmentation of urban buildings from VHR remote sensing imagery using a deep convolutional neural network[J]. Remote Sensing, 2019, 11(15): 1774. Doi:10.3390/rs11151774 |

| [19] |

胡明洪, 李佳田, 姚彦吉, 等. 结合多路径的高分辨率遥感影像建筑物提取SER-UNet算法[J]. 测绘学报, 2023, 52(5): 808-817. Doi:10.11947/j.AGCS.2023.20210691 |

| [20] |

徐佳伟, 刘伟, 单浩宇, 等. 基于PRCUnet的高分遥感影像建筑物提取[J]. 地球信息科学学报, 2021, 23(10): 1838-1849. Doi:10.12082/dqxxkx.2021.210283 |

| [21] |

Chen L C, Papandreou G, Kokkinos I, et al. Semantic image segmentation with deep convolutional nets and fully connected CRFs[EB/OL]. arXiv: 1412.7062. (2014-12-22)[2023-02-02]. https://arxiv.org/abs/1412.7062.

|

| [22] |

Chen L C, Papandreou G, Kokkinos I, et al. DeepLab: semantic image segmentation with deep convolutional nets, atrous convolution, and fully connected CRFs[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(4): 834-848. Doi:10.1109/TPAMI.2017.2699184 |

| [23] |

Chen L C, Papandreou G, Schroff F, et al. Rethinking atrous convolution for semantic image segmentation[EB/OL]. arXiv: 1706.05587. (2017-06-17)[2023-02-02]. https://arxiv.org/abs/1706.05587.

|

| [24] |

Chen L C, Zhu Y K, Papandreou G, et al. Encoder-decoder with atrous separable convolution for semantic image segmentation[C]//Computer Vision-ECCV 2018: 15th European Conference, Munich, Germany, September 8-14, 2018, Proceedings, Part Ⅶ. New York: ACM, 2018: 833-851. DOI: 10.1007/978-3-030-01234-2_49.

|

| [25] |

Guo Z C, Xu J M, Liu A D. Remote sensing image semantic segmentation method based on improved Deeplabv3+[C]//Proc SPIE 11928, International Conference on Image Processing and Intelligent Control (IPIC 2021), 2021, 11928: 101-109. DOI: 10.1117/12.2611930.

|

| [26] |

Chollet F. Xception: deep learning with depthwise separable convolutions[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). July 21-26, 2017, Honolulu, HI, USA. IEEE, 2017: 1800-1807. DOI: 10.1109/CVPR.2017.195.

|

| [27] |

王华俊, 葛小三. 一种轻量级的DeepLabv3+遥感影像建筑物提取方法[J]. 自然资源遥感, 2022, 34(2): 128-135. Doi:10.6046/zrzyyg.2021219 |

| [28] |

Cao J M, Li Y Y, Sun M C, et al. DO-conv: depthwise over-parameterized convolutional layer[J]. IEEE Transactions on Image Processing: a Publication of the IEEE Signal Processing Society, 2022, 31: 3726-3736. Doi:10.1109/TIP.2022.3175432 |

| [29] |

Lin T Y, Dollár P, Girshick R, et al. Feature pyramid networks for object detection[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). July 21-26, 2017, Honolulu, HI, USA. IEEE, 2017: 936-944. DOI: 10.1109/CVPR.2017.106.

|

| [30] |

Wang Q L, Wu B G, Zhu P F, et al. ECA-net: efficient channel attention for deep convolutional neural networks[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). June 13-19, 2020, Seattle, WA, USA. IEEE, 2020: 11531-11539. DOI: 10.1109/CVPR42600.2020.01155.

|

| [31] |

Hu J, Shen L, Sun G. Squeeze-and-excitation networks[C]//2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition. June 18-23, 2018, Salt Lake City, UT, USA. IEEE, 2018: 7132-7141. DOI: 10.1109/CVPR.2018.00745.

|

2024, Vol. 41

2024, Vol. 41