移动互联时代下每个人可以轻松地生产、获取图像媒体,这是人们交换信息、理解世界的重要媒介。为充分传达想表达的信息,原生图像往往需要经过人为地编辑。利用人工智能技术的图像补全是一种自动化的图像媒体编辑方法,能快速补全图像、消除图像中的无用对象。相比于基于人工的图像抠图、绘制方法,可节省大量人力和时间,引起人们的广泛关注。

根据是否需要数据驱动的模型,图像补全方法分为传统的启发式算法和基于深度学习的算法。传统的启发式算法[1]参考背景像素来填充缺失区域,但无法合成独立或非重复的材质,例如人脸。得益于算力、数据集、神经网络系列算法的发展,利用数据驱动模型的深度学习算法逐渐应用在图像补全任务中。相对启发式算法,基于深度学习的方法不仅可以补全掩码覆盖率更高的缺失区域,还能高效地按批次进行图像处理。

Pathak等[2]最早借鉴U-Net[3]架构来设计深度图像补全模型,由下采样层、瓶颈模块、上采样层构成,后续在此基础上衍生诸多变种。Iizuka等[4]引入双判别器和空洞卷积,实现全局和局部结构的学习,建模背景区域和前景掩码的关联,并引入空洞卷积,在不用增加网络参数的同时确保瓶颈模块的感知野大小。Liu等[5]提出局部卷积,在每层卷积计算时,启发式地更新卷积变换后的掩码区域,解决了掩码区域的像素仍被视为合法像素的问题。Yu等[6]则进一步提出门控卷积,用非线性sigmoid激活的卷积来代替掩码区域的启发式更新。Yan等[7]提出偏移网络建模传统补全算法中的像素偏移假设,显式地为局部特征图提供了最相似块的上下文特征。总地来说,为让上述U-Net风格的方法泛化到更复杂的场景,研究者们提出了各种判别器损失[4]、卷积算子[5-6]、上下文注意力机制[7]等手段,但由于U-Net模型结构的限制,它们难以补全极端规模(70 % ~90 % 的掩码覆盖率)的缺失区域,并只能生成模糊不清的马赛克或伪影。

为解决极端缺失下的图像补全问题,我们从图像生成领域中的生成对抗网络(generative adversarial network,GAN)模型[8-10]得到了启发。最早GAN模型以博弈对抗的策略进行训练,可以从随机噪声输入出发,合成一幅具有实际语义的图像。随着对抗训练过程的稳定[11-15],合成图像的质量如分辨率、保真度得到迅速提高。尤其是大规模GAN模型[16],如StyleGAN[17-18],它在经过数以百万计的图像数据训练后,模型的各层神经表征包含多种层次的图像语义和模式[19],使合成图像达到了照片级的视觉效果。因此,可将图像补全任务视为有条件(即非缺失区域)约束的图像生成问题,并利用StyleGAN模型来填充大面积缺失区域。

GAN模型的原生输入是随机噪声向量,图像补全任务的输入是受损图,即红绿蓝(red-green-blue,RGB)3通道的二维矩阵。为了对齐GAN模型的输入,GAN反演[20-21]是一种很自然的解决方案。现有的GAN反演方法可以大致分为编码器式[22-23]和优化式[24-25],其中mGANprior[24]利用多个隐藏代码和自适应通道进行图像重建,可执行各种图像处理应用,包括图像补全;pSp[22]用编码器和风格映射网络嵌入图像到扩展隐藏空间[26],提取的风格向量对应StyleGAN的18个风格调制层输入,在图像生成任务上展示了高保真的合成结果。

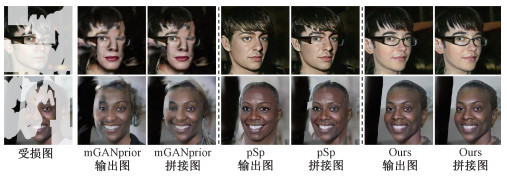

GAN反演应用于超分辨率、人脸转正、日夜转换、图像补全等广泛的图像翻译任务,但忽略了图像补全的任务目标具有硬约束,即输入输出在非缺失区域需要完全一致。具体而言,目前的方法[22-24]只能使用中间隐藏向量生成图像,该隐藏向量因池化操作丢失了输入图像的全局结构,所以生成器在非缺失区域只能生成近似像素,在图像拼接后,掩码边缘会由于颜色和语义的不连续而出现明显的缝隙,如图 1第2~5列。为增强生成器对输入图像非缺失区域的感知,本文为GAN反演框架提出新的双向感知生成器和预调制网络,在CelebA-HQ和Places2数据集上进行定量和定性实验,验证了我们的方法可大幅降低不连续性,生成无缝的图像补全结果。

|

Download:

|

| 图 1 对比现有最佳GAN反演方法(mGANprior[24]和pSp[22]) Fig. 1 Compared with the cutting-edge models of mGANprior and pSp | |

图像补全的目标是在广泛图像域平滑地生成受损图像的修复结果。广泛图像域包含不同分辨率、不同图像内容、不同受损掩码模式等。遵循过往的研究,分别选取人脸数据集CelebA-HQ[13]和场景数据集Places2[27]。

人脸图像作为具有丰富特征以及非重复纹理的数据,传统启发式算法对其进行图像补全几乎是一项不能完成的任务,所以人脸数据集也一直作为图像补全算法性能的一项主要评估基准。CelebA-HQ人脸数据集包含30 000张1 024×1 024分辨率的已标准化处理(人脸位于图像中心)的名人头像,常用于人脸相关的计算机视觉训练任务。由于其带有语义分割人工标注,可用于人脸属性标识训练、人脸检测训练等。我们按照早前工作[6]的方案来拆分此数据集进行训练和测试。

但除处于数据分布边缘的图像(如侧脸、带有奇装异饰的人脸图像)之外,对于深度模型而言,标准化人脸的模式较单一、易被学习。因此现也需要辅以模式复杂、目标众多的场景数据集进行测试。本文选取的Places2数据集采集了超过200 000张真实世界的场景照片,单幅往往有众多目标例如红绿灯、汽车、房屋等,数据分辨率为256×256。在模型训练、测试上采用官方的数据集划分标准。

对于缺失区域,利用先前工作[28]提供的掩码生成脚本,进行不规则的自由形式掩码绘制。我们的模型和所有基准方法都采用完全相同的方式进行训练和测试,以确保实验结果的公平性。

1.2 图像补全相关定义为表明本文的研究任务与目标,首先列举用到的数学符号,如表 1所示。

|

|

表 1 符号表 Table 1 Notations |

图像补全任务可以形式化为一个有监督的学习问题:给定原始图像序列In∶ = { I1, …, In},图像序列中的语义前景对象O是选定的待补全区域或待消除对象。通过实例分割或手动选取等方法得到目标对象在I上的掩码序列O → Mn∶ = { M1, …, Mn}。对于每个掩码Mi,其中值为1的像素表示缺失区域,值为0的像素表示保留区域。由此映射函数p(·)的输入为Xi∶ = (1- Mi)⊙ Ii,⊙算子表示哈达玛积(Hadamard product),映射函数希望学习后,条件分布为Xn的生成数据

| $ p\left(\hat{{\boldsymbol{I}}} \mid {\boldsymbol{X}}^n\right) \rightarrow p\left({\boldsymbol{I}} \mid {\boldsymbol{X}}^n\right). $ | (1) |

由于非缺失区域的像素是图像补全任务的硬约束,需要将掩码区域的模型输出与保留区域的原始图像进行拼接操作,即

| $ {\boldsymbol{Y}}_i:=\left(1-{\boldsymbol{M}}_i\right) \odot {\boldsymbol{I}}_i+{\boldsymbol{M}}_i \odot \hat{{\boldsymbol{I}}}_i. $ | (2) |

此外,在模型训练过程中,Y和

图像补全(image completion):当掩码区域Mn不再为前景对象O的映射,而是随机大小、位置以及不规则形状的掩码区域,同时序列长度n退化为1。此为本文研究目标。

对象消除(object removal):掩码区域严格为待消除的目标前景对象O,并在对象对应的掩码区域Mn上重建与背景内容保持一致的新像素。

视频修复(video inpainting):当掩码区域Mn不再为前景对象O的映射,而是随机大小、位置以及不规则形状的掩码区域时。

背景替换(matting):当掩码区域Mn为除前景对象O的背景区域时,即O →(1- Mn)。

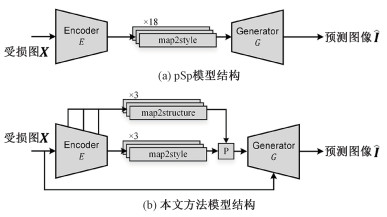

2 无缝GAN反演为解决现有GAN反演方法忽视硬约束造成的颜色、语义不一致问题,同时进一步提高合成图像的保真度,提出预调制模块和双向感知生成器。如图 2所示,图 2(a)为现有GAN反演方法pSp[22]的模型结构,图 2(b)为本文提出方法的模型结构。

|

Download:

|

| 图 2 对比现有GAN反演方法pSp[22]的设计结构 Fig. 2 Illustration of the differences in pipeline from existing GAN inversion method pSp[22] | |

我们的方法基于编码器式的GAN反演框架。此架构主要包含2个模块:特征金字塔网络和下采样网络构成的编码器E(·)、StyleGAN2构成的生成器G(·)。编码器中的特征金字塔网络处理输入的受损图X,并将中间特征图送至L个下采样网络,嵌入为512维的隐藏向量[26]。

生成器骨干采用预训练的StyleGAN2模型,编码器输出的L个隐藏向量作为StyleGAN2生成器的输入,去控制最终合成图像的内容。L对应StyleGAN2生成器模型的层数,不同层次的风格向量语义不同,可大致对应于不同的细节水平(粗、中、细)[18]。L=log2(s) ·2-2,其中s表示图像分辨率。由此编码器式GAN反演框架可形式化定义为

| $ \hat{\boldsymbol{I}}=G(E(\boldsymbol{X})). $ | (3) |

上述流程源于现有GAN反演方法[22-24]的结构设计,这种设计只能采用中间隐藏向量来调制生成器的合成图像,而中间隐藏向量在下采样网络的池化操作后丢失了输入图像全局结构,这让合成图像在拼接后具有颜色差异和语义不一致问题。

2.2 预调制网络与双向感知生成器图像补全任务的硬约束条件是指输入图像和输出图像的部分内容需要保持像素级的完全一致,形式化定义硬约束为

| $ \hat{{\boldsymbol{I}}} \odot(1-{\boldsymbol{M}}) \equiv I \odot(1-{\boldsymbol{M}}). $ | (4) |

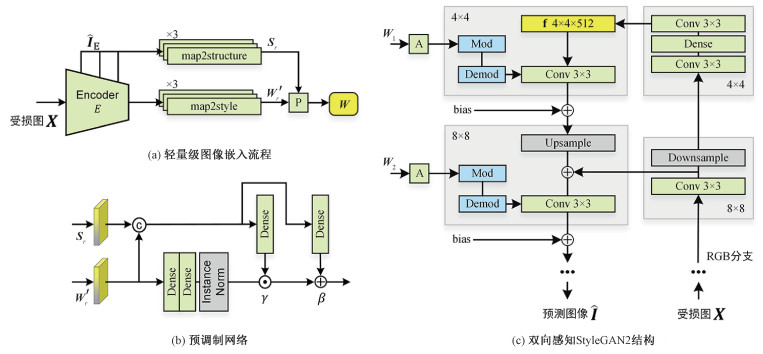

为解决硬约束问题,需要设计新的模块来增强生成器对于输入图像的感知,尤其是非缺失区域。因此提出新颖的双向感知生成器和预调制网络,如图 3所示。

|

Download:

|

| 图 3 所提方法技术细节 Fig. 3 Technical details of the proposed method | |

其中双向感知生成器的具体结构如图 3(c),为生成器设计了反向下采样的RGB分支。通过输入受损图到RGB分支,得到与生成器的L层上采样网络相对应的特征图,双向分支之间采用特征恒等映射,类似于U-Net模型中的跳跃连接[3],使生成器在合成图像时不仅受目标风格的指导还能直接感知受损图像的非缺失区域内容。由此可更新公式(3)如下

| $ \hat{{\boldsymbol{I}}}=G(E({\boldsymbol{X}}), {\boldsymbol{X}}) . $ | (5) |

值得注意的是,根据实验经验,StyleGAN2的噪声通道在这项工作中起着微不足道的作用。为减少变量,为生成器设定了从高斯分布中随机采样的噪声。

由图 3(a)所示,为将输入的RGB受损图嵌入到扩展隐藏空间,我们的图像编码器除经过特征金字塔模型处理,还进行了预调制网络(图 3(a)中由‘P’表示)的信号增强。具体而言,首先为特征金字塔模型的每层上采样新增RGB头网络,这个网络层为一层卷积神经网络。将当前特征图的通道数投射到RGB 3通道上,RGB头输出的结果使用原始图像进行监督,相当于让RGB头利用中间特征图进行补全的预测。特征金字塔网络的3次上采样对应3个RGB头网络,预测的补全结果用

最后预调制中间隐藏向量,如图 3(b)所示,在2层全连接和实例归一化IN(·)[19]调节w′r后,用编码判别性语义的结构向量Sr学习仿射变换系数,对w′r实施解归一化,用输入图像结构增强隐藏向量的统计分布,得到最终的强化风格向量w。框架中有L个轻量的预调制网络,它们输出的强化风格向量

| $ {\boldsymbol{w}}_l={\boldsymbol{\gamma}}_l \odot I N\left({\boldsymbol{w}}_r^{\prime}\right)+{\boldsymbol{\beta}}_l, $ | (6) |

其中:γl和βl表示实例归一化模块中的仿射变换系数对,由结构向量Sr分别经过1层全连接网络学习而来,l={1, 2, …, L}表示第l个向量。

2.3 目标函数为训练编码器模型,首先遵循以前的图像补全方法[4],采用常规的修复损失组合,包含L1损失

| $ \mathcal{L}_{\text {ipt }}(\hat{\boldsymbol{I}}, I)=\ell_1+\mathcal{L}_{\text {percptual }}+\mathcal{L}_{\text {style }}+\mathcal{L}_{\text {tv }}, $ | (7) |

其中距离度量在

同时充分利用编码器的性能,采用原始图像I来直接监督编码器预测的多尺度补全结果

| $ \mathcal{L}_{\mathrm{msr}}\left(\hat{{\boldsymbol{I}}}_E, {\boldsymbol{I}}\right)=\sum\limits_r^3\left(\mathcal{L}_{\text {percptual }}^r+\mathcal{L}_{\text {style }}^r+\ell_1^r\right). $ | (8) |

为了生成图像的保真度,使预测的风格向量尽可能不偏离预训练StyleGAN2模型的平均模式

| $ \mathcal{L}_{\text {reg }}({{\boldsymbol{w}}})=\|{{\boldsymbol{w}}}-\overline{{{\boldsymbol{w}}}}\|_2, $ | (9) |

可利用预训练StyleGAN2模型的映射网络随机采样隐藏向量,计算所有向量的平均值以获取

总之,模型训练的总体损失函数为

| $ \mathcal{L}=\mathcal{L}_{\mathrm{ipt}}+\mathcal{L}_{\mathrm{msr}}+\mathcal{L}_{\mathrm{reg}} . $ | (10) |

图像补全的目标是在广泛图像域平滑地生成受损图像的修复结果,满足新图像的内容在客观上具有上下文一致性,且主观上人眼不能辨别真伪,尤其是在掩码区域和保留区域的交接边际处。

指标峰值信号噪声比(peak signal-to-noise ratio, PSNR)[29]、结构相似度(structural similarity,SSIM)[29]、FID(Fréchet inception distance)[30]是图像补全任务常见的评价度量。PSNR基于像素点间的均方误差,在评估噪声图像的质量方面具有良好性能,其定义如下

| $ {\mathrm{PSNR}}=20 \cdot \log _{10}\left(\frac{\mathrm{MAX}_{\boldsymbol{I}}}{\sqrt{\mathrm{MSE}}}\right), {\mathrm{MSE}}=\frac{1}{n} \sum\limits_{i=1}^\boldsymbol{n}(\boldsymbol{I}-\hat{\boldsymbol{I}})^2 . $ | (11) |

结构相似度指标SSIM被认为与人类视觉系统的质量感知相关,SSIM不是使用传统的误差求和方法,而是通过将图像失真建模为3个因素的组合,即相关度损失、亮度失真和对比度失真。

在评价退化图像的实践上,PSNR和SSIM对加性高斯噪声比高斯模糊和JPEG压缩更敏感,即2幅图在PSNR和SSIM指标上表现优秀,但并未考虑到人眼的视觉特性,因而经常出现评价结果与人的主观感觉不一致的情况。

指标FID基于Inception模型得分,从多维变量概率分布上采用弗朗明歇距离来衡量图片的相似度和质量。FID相对PSNR、SSIM,能很好地捕捉到模糊、漩涡、噪声等干扰的程度并评价图像的多样性。因此生成对抗模型方法或针对多样性的工作中更适合采用FID一类指标进行图像质量评价。FID的定义如下

| $ \begin{gathered} {\rm{FID}}({\boldsymbol{I}}, \hat{{\boldsymbol{I}}})=\left\|\mu_{\boldsymbol{I}}-\mu_{\hat{\boldsymbol{I}}}\right\|_2^2+ \\ {\rm{tr}}\left({\boldsymbol{\varSigma}}_{{\boldsymbol{I}}}+{\boldsymbol{\varSigma}}_{\hat{{\boldsymbol{I}}}}-2 \sqrt{{\boldsymbol{\varSigma}}_{\boldsymbol{I}} {\boldsymbol{\varSigma}}_{\hat{\boldsymbol{I}}}}\right), \end{gathered} $ | (12) |

式中:μI和

在人脸数据集CelebA-HQ和场景数据集Places2上执行实验,以证明本文方法的特点和优越性。为验证该方法在大规模缺失区域下补全图像的能力,从2个方面选择基线方法:首先,与先进、主流的U-Net风格图像补全方法(包括EC[31]、GC[6]、RFR[28]、MEDFE[32]、CTSDG[33]和CRFill[34])进行比较;其次,与现有的基于GAN反演方法(包括mGANprior[24]和pSp[22])进行比较。利用官方源代码来复现上述所有基线方法。对于Places2数据集,采用作者官方发布的预训练权重加载模型。对于CelebA-HQ数据集,EC[31]、GC[6]、mGANprior[24]提供了官方的预训练权重。其余基线方法,利用官方源代码重新训练了权重。

实验中,所有数据集的图像尺寸缩放到256×256分辨率作为输入。为实现更多样化的掩码形状,更新了基于RFR[28]提出的掩码生成脚本,采用可控的掩码覆盖率和随机矩形。在定量对比实验中,根据掩码覆盖率将测试掩码分为3个难度级别,分别为掩码覆盖率10 % ~30 %、40 % ~60 %、70 % ~90 %。在测试过程中,为公平比较,对所有的基线方法都使用了相同的图像-掩码对。

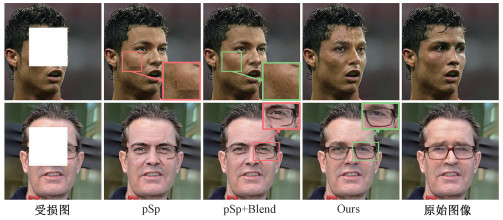

3.3 解决颜色、语义不连续问题忽视图像补全的硬约束导致现有GAN反演方法生成具有颜色、语义不连续问题的图像。在研究之初,我们寄希望于图像后处理来解决这个问题。具体来说,我们考虑了图像混合法[35](image blending),它利用梯度滤波器混合低级内容再采用泊松网络还原同尺度输出,可以实现颜色差异的消除(如图 4第1行第3列),但它对语义不连续问题没有任何帮助(如图 4第2行第3列)。

|

Download:

|

| 图 4 颜色、语义不连续问题的解决效果对比 Fig. 4 Results of resolving color and semantic inconsistent | |

为进一步证明所提方法的优越性,构建变体pSp+Blend,表示pSp模型输出后,在拼接图像时引入图像混合法[35]进行后处理。在图 4中,第2列显示了pSp在掩码边缘明显的颜色差异,第3列pSp+Blend修复了颜色差异问题。但即便如此,第2行第3列pSp+Blend的结果图显示无法解决语义不连续的问题,因为眼镜仍然不完整。与上述2种方法相比,如图 4第4列所示,所提方法的输出图像既不再存在颜色差异,也完整地修复了眼镜,解决了语义不连续的问题。

进一步在CelebA-HQ数据集上进行针对硬约束问题的定量的对比实验,见表 2。此定量对比实验的结果显示,在解决颜色、语义不连续问题之后,在PSNR、SSIM、FID指标得分上,所提方法在现有的基于GAN反演的图像补全方法中表现最好,也超过了增加图像混合后处理的变体方法mGANprior+Blend和pSp+Blend。此外我们的模型不需要对合成图像进行任何后处理,比如图像混合。其中表 2的↑和↓分别表示其对应的指标值越高越好和越低越好。

|

|

表 2 CelebA-HQ上与基于GAN反演系列方法定量对比结果 Table 2 Comparison of the results on CelebA-HQ dataset |

为评估方法在图像补全领域的提升效果,进行了详细的定量和定性对比实验。

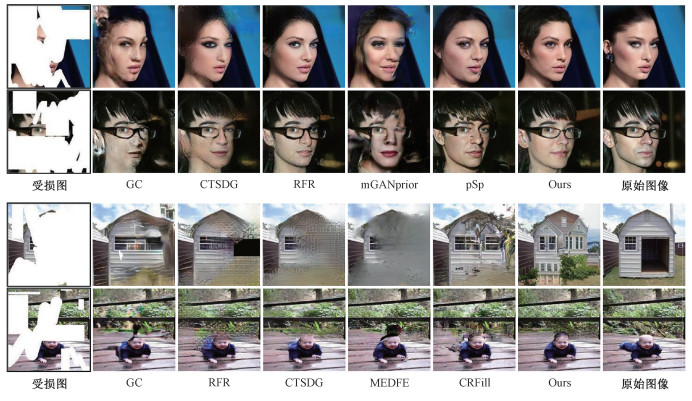

表 3展示了定量对比结果,所提方法在主流的图像补全方法中,能够取得最好或相当的性能。在70 % ~90 % 的大规模缺失区域设定下,就FID指标而言,所提方法分别在Places2和CelebA-HQ数据集上降低49.2 % 和16.4 % (2项数据分别对比了次优方法CRFill、RFR),性能得到有效提升,这验证了该设计的优越性。

|

|

表 3 定量对比实验结果 Table 3 Qualitative comparison results on CelebA-HQ and Places2 |

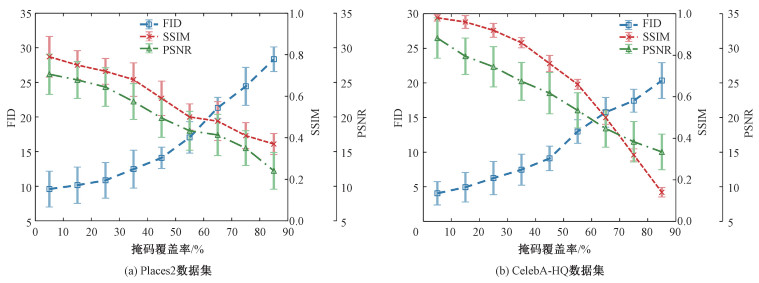

为展示本文方法不仅可补全大规模缺失区域(70 % ~90 %),同样能够泛化到极小的掩码,比如掩码覆盖率只有5 % 时。设计了图 5所示的实验,用于展示由易到难不同掩码覆盖率下的模型效果。从图 5中PSNR、FID、SSIM 3个指标的度量结果来看,本文提出的模型能够较好地处理各种掩码覆盖率下的受损图。

|

Download:

|

| 图 5 本文方法在不同掩码覆盖率下的效果 Fig. 5 Evaluation results of our method in the various mask ratio | |

图 6提供了在Places2和CelebA-HQ数据集上的定性对比结果,可见当输入的图像有较大的损坏时,基线方法难以生成精致的纹理。例如图 6的Places2数据集部分中,RFR[28]、MEDFE[32]、CTSDG[33]只能合成模糊背景或马赛克,GC[6]和CRFill[34]则生成扭曲的伪影;反之我们的方法能够重建出语义丰富的物体,如窗户、屋梁。对于CelebA-HQ数据集,所有基线方法都很难合成一幅具有完整人脸部位,且不存在违和感的结果,与我们模型的输出形成对比。特别地,虽然RFR[28]相较其他基线方法有着优秀的定量得分(见表 3),但图 6的视觉结果展示RFR生成了具有一定结构但存在大量重复模式的像素块。至于基于GAN反演的基线方法,mGANprior[24]和pSp[22]可以为损坏的区域合成真实的像素,但由于它们忽视了图像补全的硬约束问题,而在掩码边缘存在明显的颜色或语义不连续。

|

Download:

|

| 图 6 定性对比实验结果 Fig. 6 Qualitative comparison results of CelebA-HQ and Places2 | |

综合结果表明,本文提出的模型在Places2数据集和CelebA-HQ数据集上的PSNR、SSIM、FID指标超过了主流图像补全基线方法以及现有的GAN反演方法。此外,该模型可以还原70 % ~90 % 掩码覆盖率的大面积损失区域,并产生更合理、语义一致的结果,同时对不同的掩码覆盖率具有良好的泛化性。

4 结论与未来工作本文发现并验证了现有GAN反演技术忽视图像补全中硬约束从而造成的颜色、语义不连续问题。为解决此问题,提出双向感知生成器帮助模型从数据表征层面感知输入图像的非缺失区域,以及预调制网络进一步为风格向量提供判别性更强的语义。对比pSp和图像混合法,证实本文方法的合成图像不再存在颜色和语义的不连续问题,且不需要任何后处理。该方法弥补了GAN反演技术和图像补全任务之间的缺口。在Places2、CelebA-HQ数据集上的定量和定性对比实验结果表明,该方法优于图像补全基线,在70 % ~90 % 的大规模缺失下,使FID值降低49.2 %。综合证明本文方法不仅可以进行无缝图像补全,还能为大面积缺失区域重建逼真像素。

由于大规模缺失下图像补全的任务特点,主流指标PSNR、FID、SSIM不再适用,模型应该聚焦在确保输出图像的真实性,而不是相似性。因此提出相关的评价度量、为训练框架设计合理的损失函数是未来值得研究的问题之一。

| [1] |

赵露露, 沈玲, 洪日昌. 图像修复研究进展综述[J]. 计算机科学, 2021, 48(3): 14-26. Doi:10.11896/jsjkx.210100048 |

| [2] |

Pathak D, Krähenbühl P, Donahue J, et al. Context encoders: feature learning by inpainting[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition. June 27-30, 2016, Las Vegas, NV, USA. IEEE, 2016: 2536-2544. DOI: 10.1109/CVPR.2016.278.

|

| [3] |

Ronneberger O, Fischer P, Brox T. U-net: convolutional networks for biomedical image segmentation[C]//Medical Image Computing and Computer-Assisted Intervention-MICCAI 2015, 2015: 234-241. DOI: 10.1007/978-3-319-24574-4_28.

|

| [4] |

Iizuka S, Simo-Serra E, Ishikawa H. Globally and locally consistent image completion[J]. ACM Transactions on Graphics, 2017, 36(4): 1-14. Doi:10.1145/3072959.3073659 |

| [5] |

Liu G L, Reda F A, Shih K J, et al. Image inpainting for irregular holes using partial convolutions[C]//Computer Vision-ECCV 2018, 2018: 85-100. DOI: 10.1007/978-3-030-01252-6_6.

|

| [6] |

Yu J H, Lin Z, Yang J M, et al. Free-form image inpainting with gated convolution[C]//2019 IEEE/CVF International Conference on Computer Vision (ICCV). October 27-November 2, 2019, Seoul, Korea (South). IEEE, 2019: 4470-4479. DOI: 10.1109/ICCV.2019.00457.

|

| [7] |

Yan Z Y, Li X M, Li M, et al. Shift-net: image inpainting via deep feature rearrangement[C]//Computer Vision-ECCV 2018, 2018: 1-17. DOI: 10.1007/978-3-030-01264-9_1.

|

| [8] |

Mirza M, Osindero S. Conditional generative adversarial nets[EB/OL]. arXiv: 1411.1784v1, (2014-11-06)[2022-04-11]. https://arxiv.org/abs/1411.1784.

|

| [9] |

Salimans T, Goodfellow I, Zaremba W, et al. Improved techniques for training gans[EB/OL]. arXiv: 1606.03498v1, (2016-06-10)[2022-04-11]. https://arxiv.org/abs/1606.03498.

|

| [10] |

Arjovsky M, Chintala S, Bottou L. Wasserstein Gan[EB/OL]. arXiv: 1701.07875v3, (2017-12-06)[2022-04-11]. https://arxiv.org/abs/1701.07875.

|

| [11] |

Gulrajani I, Ahmed F, Arjovsky M, et al. Improved training of wasserstein gans[EB/OL]. arXiv: 1704.00028v3, (2017-12-25)[2022-04-11]. https://arxiv.org/abs/1704.00028.

|

| [12] |

Ledig C, Theis L, Huszár F, et al. Photo-realistic single image super-resolution using a generative adversarial network[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition. July 21-26, 2017, Honolulu, HI, USA. IEEE, 2017: 105-114. DOI: 10.1109/CVPR.2017.19.

|

| [13] |

Karras T, Aila T, Laine S, et al. Progressive growing of GANs for improved quality, stability, and variation[EB/OL]. arXiv: 1710.10196v3, (2018-02-26)[2022-04-11]. https://arxiv.org/abs/1710.10196.

|

| [14] |

Mao X D, Li Q, Xie H R, et al. Least squares generative adversarial networks[C]//2017 IEEE International Conference on Computer Vision. October 22-29, 2017, Venice, Italy. IEEE, 2017: 2813-2821. DOI: 10.1109/ICCV.2017.304.

|

| [15] |

Miyato T, Kataoka T, Koyama M, et al. Spectral normalization for generative adversarial networks[EB/OL]. arXiv: 1802.05957v1, (2018-02-16)[2022-04-11]. http://arxiv.org/abs/1802.05957.

|

| [16] |

Brock A, Donahue J, Simonyan K. Large scale GAN training for high fidelity natural image synthesis[EB/OL]. arXiv: 1809.11096v2, (2019-02-25)[2022-04-11]. http://arxiv.org/abs/1809.11096.

|

| [17] |

Karras T, Laine S, Aila T M. A style-based generator architecture for generative adversarial networks[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). June 15-20, 2019, Long Beach, CA, USA. IEEE, 2019: 4396-4405. DOI: 10.1109/CVPR.2019.00453.

|

| [18] |

Karras T, Laine S, Aittala M, et al. Analyzing and improving the image quality of StyleGAN[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). June 13-19, 2020, Seattle, WA, USA. IEEE, 2020: 8107-8116. DOI: 10.1109/CVPR42600.2020.00813.DOI: 10.1109/CVPR42600.2020.00813.

|

| [19] |

Huang X, Belongie S. Arbitrary style transfer in real-time with adaptive instance normalization[C]//2017 IEEE International Conference on Computer Vision. October 22-29, 2017, Venice, Italy. IEEE, 2017: 1510-1519. DOI: 10.1109/ICCV.2017.167.

|

| [20] |

Zhu J Y, Krähenbühl P, Shechtman E, et al. Generative visual manipulation on the natural image manifold[C]//Computer Vision-ECCV 2016, 2016: 597-613. DOI: 10.1007/978-3-319-46454-1_36.

|

| [21] |

Xia W H, Zhang Y L, Yang Y J, et al. GAN inversion: a survey[EB/OL]. arXiv: 2101.05278v5, (2022-03-22)[2022-04-11]. https://arxiv.org/abs/2101.05278.

|

| [22] |

Richardson E, Alaluf Y, Patashnik O, et al. Encoding in style: a StyleGAN encoder for image-to-image translation[C]//2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). June 20-25, 2021, Nashville, TN, USA. IEEE, 2021: 2287-2296. DOI: 10.1109/cvpr46437.2021.00232.

|

| [23] |

Xu Y H, Shen Y J, Zhu J P, et al. Generative hierarchical features from synthesizing images[C]//2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). June 20-25, 2021, Nashville, TN, USA. IEEE, 2021: 4430. DOI: 10.1109/cvpr46437.2021.00441.

|

| [24] |

Gu J J, Shen Y J, Zhou B L. Image processing using multi-code GAN prior[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). June 13-19, 2020, Seattle, WA, USA. IEEE, 2020: 3009-3018. DOI: 10.1109/cvpr42600.2020.00308.

|

| [25] |

Wang H P, Yu N, Fritz M. Hijack-GAN: unintended-use of pretrained, black-box GANs[C]//2021 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). June 20-25, 2021, Nashville, TN, USA. IEEE, 2021: 7868-7877. DOI: 10.1109/cvpr46437.2021.00778.

|

| [26] |

Abdal R, Qin Y P, Wonka P. Image2StyleGAN: how to embed images into the StyleGAN latent space?[C]//2019 IEEE/CVF International Conference on Computer Vision (ICCV). October 27-November 2, 2019, Seoul, Korea (South). IEEE, 2019: 4431-4440. DOI: 10.1109/ICCV.2019.00453.

|

| [27] |

Zhou B L, Lapedriza A, Khosla A, et al. Places: a 10 million image database for scene recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(6): 1452-1464. Doi:10.1109/TPAMI.2017.2723009 |

| [28] |

Li J Y, Wang N, Zhang L F, et al. Recurrent feature reasoning for image inpainting[C]//2020 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). June 13-19, 2020, Seattle, WA, USA. IEEE, 2020: 7757-7765. DOI: 10.1109/CVPR42600.2020.00778.

|

| [29] |

Wang Z, Bovik A C, Sheikh H R, et al. Image quality assessment: from error visibility to structural similarity[J]. IEEE Transactions on Image Processing, 2004, 13(4): 600-612. Doi:10.1109/TIP.2003.819861 |

| [30] |

Heusel M, Ramsauer H, Unterthiner T, et al. GANs trained by a two time-scale update rule converge to a local nash equilibrium[EB/OL]. arXiv: 1706.08500v6, (2018-01-12)[2022-04-11]. https://arxiv.org/abs/1706.08500.

|

| [31] |

Nazeri K, Ng E, Joseph T, et al. EdgeConnect: structure guided image inpainting using edge prediction[C]//2019 IEEE/CVF International Conference on Computer Vision Workshop (ICCVW). October 27-28, 2019, Seoul, Korea (South). IEEE, 2019: 3265-3274. DOI: 10.1109/ICCVW.2019.00408.

|

| [32] |

Liu H Y, Jiang B, Song Y B, et al. Rethinking image inpainting via a mutual encoder-decoder with feature equalizations[C]//Computer Vision-ECCV 2020, 2020: 725-741. DOI: 10.1007/978-3-030-58536-5_43.

|

| [33] |

Guo X F, Yang H Y, Huang D. Image inpainting via conditional texture and structure dual generation[C]//2021 IEEE/CVF International Conference on Computer Vision (ICCV). October 10-17, 2021, Montreal, QC, Canada. IEEE, 2021: 14114-14123. DOI: 10.1109/ICCV48922.2021.01387.

|

| [34] |

Zeng Y, Lin Z, Lu H C, et al. CR-fill: generative image inpainting with auxiliary contextual reconstruction[C]//2021 IEEE/CVF International Conference on Computer Vision (ICCV). October 10-17, 2021, Montreal, QC, Canada. IEEE, 2021: 14144-14153. DOI: 10.1109/ICCV48922.2021.01390.

|

| [35] |

Wu H K, Zheng S, Zhang J G, et al. GP-GAN: towards realistic high-resolution image blending[C]//Proceedings of the 27th ACM International Conference on Multimedia. 2019: 2487-2495. DOI: 10.1145/3343031.3350944.

|

2024, Vol. 41

2024, Vol. 41