2. 上海科技大学信息科学与技术学院, 上海 201210;

3. 中国科学院大学, 北京 100049

2. School of Information Science and Technology, ShanghaiTech University, Shanghai 201210, China;

3. University of Chinese Academy of Sciences, Beijing 100049, China

由于正在使用的海上信息服务——船舶自动识别系统(automatic identification system, AIS)和特殊应用报文(application-specific messages, ASM)的信道容量已经趋于饱和,国际海事组织(International Maritime Organization,IMO)、国际航道标志协会(International Association of Lighthouse Authorities,IALA)和国际电信联盟(International Telecommunication Union,ITU),共同提出建设未来海上通信平台VDES(VHF data exchange system)。为了争夺未来全球海上通信系统标准的制高点,依照VDES技术建议书[1]和VDES技术规范草案[2],各个海洋强国积极投入到VDES系统的研究和建设中[3-5]。超过10个国家正在计划或建造多颗VDES卫星,而出于国家安全需要,难以实现国家间的星间链路。因此,VDES异构星座兼容共存是未来发展的必然趋势。现有协议草案中所有VDES星座采用相同的频率、时间对齐方式和时隙表[2],导致重复覆盖区的链路大量冲突,严重影响系统整体性能,因此VDES多星座兼容是VDES建设关键问题之一。

现有机制通过扩频的调制编码方式和2个卫星专用信道使得重复覆盖区最多能同时收到4个不同星座的扩频信号[2]。然而扩频信号的数据量是非扩频信号的1/131~1/2.5[2],无法充分满足应用数据的交互需求。

星座间兼容有硬兼容和软兼容2种方式,硬兼容指通过只改变硬件参数以达到兼容。星座间兼容已在全球导航卫星系统(Global Navigation Satellite System,GNSS)中提出,解决方法主要有功率控制、卫星姿态控制和天线覆盖范围控制等。VDES卫星具有单波束覆盖范围广、重复覆盖区面积大、重复覆盖率高的特点,导致功率控制、姿态控制的运算和控制开销大,无法使用。为了兼容地面通信,VDES卫星天线采用60°斜装,也无法控制覆盖范围。

软兼容指通过只改变软件协议,以达到兼容。随着卫星产业的商业化和规模化,地球静止轨道(geostationary earth orbits,GEO)卫星和低轨(low earth orbit,LEO)卫星逐渐成为星座间兼容的焦点。LEO卫星之间信息交互协作,在保证GEO卫星通信质量的同时,提高时间利用率和吞吐量[6-8]。为进一步提升性能,在GEO卫星性能不明显下降的情况下,通过LEO和GEO星座联合资源控制,提高频谱效率[9-10]。然而GEO和LEO共存时,GEO性能更加优先,受干扰更少,而VDES星座的优先程度相同。

近年来,由于深度强化学习(deep reinforcement learning,DRL)在序列决策问题上的优异性能[11],被广泛应用到通信资源分配上。针对LEO卫星的波束间资源分配问题,通过将通信请求的特征作为状态的一部分[12],降低了链路切换时的延迟,在此基础上增加对波束内资源的统筹[13],进一步提高整体性能。但这些策略仅针对单一系统的场景,目前缺乏针对多星座共存时通信链路特点的时隙分配研究。

基于以上分析,结合VDES通信的高时变性的特点,提出一种基于改进DQN算法的VDES多星座兼容策略。首先, 在现有VDES通信机制的基础上,设置船站作为时隙资源感知节点,使卫星能够获得所有其他卫星的历史资源分配信息;然后,将VDES通信资源分配过程建模成强化学习问题,以最大化长期动作收益总和为目标;最后通过状态重构及DQN算法对强化学习问题进行求解, 得到近似最优的资源分配策略,提高VDES通信的性能。

1 时隙分配DQN模型 1.1 异构VDES星座兼容策略VDE-SAT是TDMA系统,一帧时长1 min,以一分钟的开始为一帧的开始。1帧有3个子帧,每个子帧包含发送、处理、传输的完整通信流程,有6个DC(data channel)时隙用于传输应用数据。卫星获取请求后,开始规划请求的分配,由于下行的DC时隙一定排在上行的DC时隙前面,导致所有卫星给同方向的请求分配的DC时隙具有趋同性[2]。然后卫星广播分配方案,DC时隙被相应的终端占用传输应用数据。同序号的DC时隙被同一个终端占用直至应用数据全部传输完毕。

在自组织网络中,通过侦听信道能够感知其他终端的传输情况,降低碰撞[14],而VDES异构星座之间无法感知互相的时隙占用情况。在此启发下,针对星船通信特性,提出一种自组织星座间信息交互策略:卫星指定在重复覆盖范围内的某个船站作为时隙资源感知节点,然后向卫星转发其他星座卫星上个子帧的时隙分配信息。在不改变现有通信体制的情况下,达到星座间交互资源分配信息的目的。虽然卫星只能获得其他卫星上个子帧的分配情况,但历史DC时隙分配情况能为当前子帧的分配提供指引。上个子帧传输成功的DC时隙意味着该种分配方式具有较高的成功率,应为待发送请求选择最相似的分配方式。

根据其他消息的设计,设置资源分配信息消息为上行信令,指定船站作为节点的消息为下行信令。资源分配信息消息需要增加一次突发作为开销。上行信令采用扩频因子为8的扩频信号[2],因此增加资源分配信息不会对正常的上行信令传输造成过大影响。另一方面,指定船站作为节点的消息开销仅为6个字节,而卫星一个子帧最多传输234个字节的下行行令[2],即使有多个星座重复覆盖,该消息对下行信令的影响也有限。

1.2 系统模型VDES时隙分配是一种序列决策问题,而当前子帧的分配会对未来产生影响,应着眼于长远利益,最大化未来的总传输成功时隙数量。

性能评估函数设为平均传输成功时隙数量PS和时隙利用率PU,PS用于衡量策略的整体性能,PU用于衡量策略对空闲时隙的利用程度。由于一个子帧是一个完整通信流程,PS和PU都基于子帧衡量,PS定义为

| $ P_{\mathrm{S}}=\sum\limits_{t=1}^T n_{\mathrm{suc}}^t /(6 \times T) $ | (1) |

其中:T为总子帧数,nsuct为第t个子帧中传输成功的DC时隙数量。PU定义为

| $ P_{\mathrm{U}}=\sum\limits_{t=1}^T n_{\mathrm{usd}}^t / \sum\limits_{t=1}^T n_{\mathrm{vac}}^t \text {, } $ | (2) |

其中:

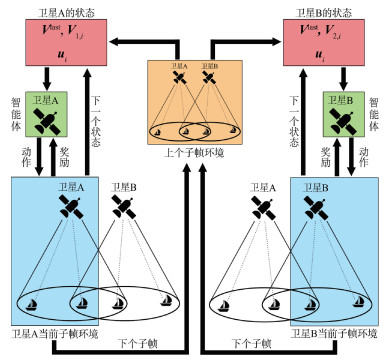

由于VDES系统时变性高,尚处于预研阶段,具有较少的先验信息,无法针对通信过程建立有效的系统模型。这使得传统的动态规划算法[15-16]无法解决此类资源分配问题。因此,考虑通过基于无模型的强化学习算法[17]获得最大化PS的策略。由于PS为离散值,无法直接作为目标函数进行优化,需要通过优化一种与PS具有较强相关性的目标函数间接优化PS。假如传输成功的DC时隙价值高,传输碰撞的DC时隙价值低,则PS与所有DC时隙的总价值呈正相关。由于不分配时隙的操作也能通过降低碰撞率来提升DC时隙的价值,所以DC时隙的价值转换成操作的价值,将未来动作的总价值作为目标函数。基于以上分析,将时隙分配问题建模为RL问题,模型如图 1所示。

|

Download:

|

| 图 1 时隙分配问题的RL模型 Fig. 1 RL model of slot allocation problem | |

1) 状态: 状态是环境高度精简概括。假设在某个子帧, 第

时弥状态矩阵(slot state matrix, SSM) 定义为

| $ \boldsymbol{V}_k=\left[\begin{array}{cccc} v_1^1 & v_1^2 & \cdots & v_1^4 \\ v_2^1 & v_2^2 & \cdots & v_2^4 \\ \vdots & & & \vdots \\ v_m^1 & v_m^2 & \cdots & v_m^4 \\ \vdots & & & \vdots \\ v_6^1 & v_6^2 & \cdots & v_6^4 \end{array}\right] \text {, } $ | (3) |

其中:

针对VDE-SAT的高时变性和星座间的信息交互, 状态应该包含请求信息

| $ \boldsymbol{s}_{k, i}=\left\{\boldsymbol{V}^{\text {last }}, \boldsymbol{V}_{k, i}, \boldsymbol{u}_i\right\} \text {. } $ | (4) |

基于VDE-SAT的通信流程, 对于同一子帧的请求, 上个子帧传输结果一致, 所以这些请求对应

2) 动作:动作是对正在处理的请求执行的操作。对于每个请求有7种操作选择,即不分配时隙和分配6个DC时隙中的某一个。强化学习经过运算后,获得每个动作的预期价值,将其中价值最高的动作的索引输出。用分配时隙的索引表示动作ai,动作ai定义如下

| $ a_i= \begin{cases}0, & \text { 不分配 DC 时隙, } \\ i, & \text { 分配第 } i \text { 个 DC 时隙. }\end{cases} $ | (5) |

3) 奖励:奖励表示当前请求的各个动作对当前状态有利程度。不同动作对时隙分配的影响不同,奖励应分为不分配时隙时和分配DC时隙时两种情况进行判断。

当前子帧空闲DC时隙较少时, 即

| $ r_i=\left\{\begin{array}{ll} 0, & a_i=0 \& \sum\limits_m v_m^1 \leqslant 3, \\ \alpha_1, & a_i=0 \& \sum\limits_m v_m^1=4, \\ \alpha_2, & a_i=0 \& \sum\limits_m v_m^1=5, \\ 1, & a_i=0 \& \sum\limits_m v_m^1=6, \end{array} 0<\alpha_1<\alpha_2<1 .\right. $ | (6) |

当

| $ r^{\rm o}=\left\{\begin{array}{cl} \beta, & a_{i} \neq 0 \& \text { 传输无碰撞, } \\ -\beta, & a_{i} \neq 0 \& \text { 传输有碰撞, } \end{array} \quad \beta>0 .\right. $ | (7) |

为进一步提升传输成功时隙数量,基于星座间信息交互策略,当前子帧的链路与上个子帧的链路越相似,请求传输成功的可能性越高,这样分配的动作价值也越高。在传输成功的基础上,

| $ r_{i}=\left\{\begin{array}{l}r^{\rm o}, a_{i} \neq 0 \& v_{k, a_{i}}^{2} \odot u_{i}^{1}+v_{k, a_{i}}^{3} \odot u_{i}^{2}=0, \\ \delta r^{\rm o}, a_{i} \neq 0 \& v_{k, a_{i}}^{2} \odot u_{i}^{1}+v_{k, a_{i}}^{3} \odot u_{i}^{2}=1, \delta>0 . \\ \delta^{2} r^{\rm o}, a_{i} \neq 0 \& v_{k, a_{i}}^{2} \odot u_{i}^{1}+v_{k, a_{i}}^{3} \odot u_{i}^{2}=2, \end{array}\right. $ | (8) |

为有效计算当前子帧的时隙分配结果对未来环境的影响,需要最大化未来动作的总价值。根据贝尔曼方程,在策略π下动作ai的价值定义为

| $ \begin{align*} & q_{\pi}(\boldsymbol{s}, a)=E_{\pi}\left(r_{i}+\gamma r_{i+1}+\gamma^{2} r_{i+2}+\cdots \mid \boldsymbol{s}=\boldsymbol{s}_{k, i}\right. \\ & \left.a=a_{i}\right)=r_{i}+\gamma \sum\limits_{\boldsymbol{s}^{\prime} \in S} P_{\boldsymbol{s} \boldsymbol{s}^{\prime}} \sum\limits_{a^{\prime} \in A} \pi\left(a^{\prime} \mid \boldsymbol{s}^{\prime}\right) q_{\pi}\left(\boldsymbol{s}^{\prime}, a^{\prime}\right) \end{align*} $ | (9) |

其中:

| $ a_{\text {opt }}=\operatorname{argmax}_{a_{i} \in A} q_{*}\left(\boldsymbol{s}_{i}, a_{i}\right), $ | (10) |

其中, 行为价值函数

| $ q_{*}\left(\boldsymbol{s}_{i}, a_{i}\right)=r_{i}+\gamma \sum\limits_{\boldsymbol{s}_{i+1} \in S} P_{\boldsymbol{s}_{i} \boldsymbol{s}_{i+1}} \max _{a_{i+1}} q_{*}\left(\boldsymbol{s}_{i+1}, a_{i+1}\right) $ | (11) |

通过计算式(11)可以针对当前处理的请求得到最优决策,但由于状态空间过大,而且状态中的历史资源信息导致连续的状态之间具有强相关性,使得传统的RL算法计算量巨大又低效。而DQN算法[18]的记忆池加抽样不仅能应对状态空间过大,而且能破坏强相关性,使强化学习快速有效,可以有效解决此类问题。

整个问题已经简化成寻找行为价值函数

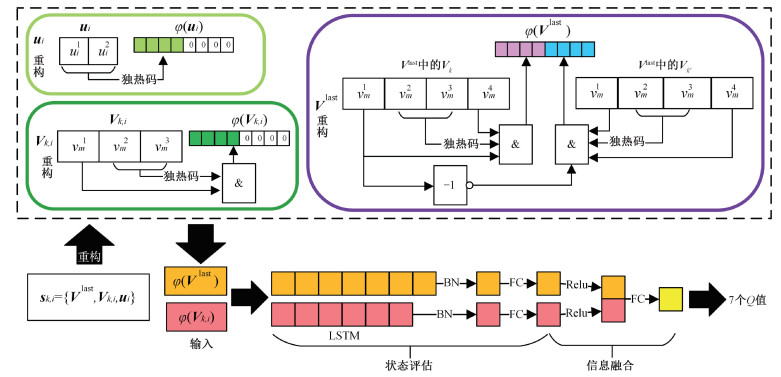

| $ \varphi\left(\boldsymbol{s}_{k, i}\right)=\varphi\left(\boldsymbol{V}^{\text {last }}, \boldsymbol{V}_{k, i}\right) $ | (12) |

如图 2所示,Q网络的输入是具有2个元素的φ(si),输出是7个动作的Q值。Q网络的结构分为状态评估和信息融合两部分。由于时隙分配具有有序、时间相关的特点,而且同时需要长期的通信环境特征和当前子帧的通信环境特征,所以使用2个长短期记忆(long-short term memory,LSTM) 层作为状态评估的网络,用以分析

|

Download:

|

| 图 2 状态的重构与Q网络结构 Fig. 2 Reformulation of state variables and structure of Q network | |

为优化策略,需要通过迭代优化Q网络的参数θ。值得注意的是,与一般的强化学习问题不同,时隙分配问题没有终止状态。若当前子帧没有空闲时隙时,应拒绝以后的请求。该状态被认为是当前子帧的分配终止,设置为无效状态,其目标Q值的计算方式与其他状态不同。

损失函数

| $ L(\theta)=E\left[\left(y_{i}-Q\left(\varphi\left(\boldsymbol{s}_{i}\right), a_{i} ; \theta\right)\right)^{2}\right] $ | (13) |

目标Q值实际上只有在每次迭代结束后才能更新。在实际应用中,为降低运算量,引入时序差分(1-step TD)学习的概念,用当前奖励加上折扣后的未来奖励作为目标Q值, 因为受过部分训练的网络已经可以提供一个近似最优的策略。目标Q值yi的计算公式为

| $ y_{i}=\left\{\begin{array}{l} r_{i}+\eta, \quad \boldsymbol{s}_{i+1} \text { 为无效状态; } \\ r_{i}+\gamma \max _{a_{i+1}} \bar{Q}\left(\varphi\left(\boldsymbol{s}_{i+1}\right), a_{i+1} ; \bar{\theta}\right), \\ \boldsymbol{s}_{i+1} \text { 不为无效状态. } \end{array}\right. $ | (14) |

其中:

改进的DQN算法的主要实现过程如算法1所示, 分为初始化阶段和训练阶段。初始化阶段包括场景参数和模型参数的初始化。在更新Q网络参数的过程中, 使用

算法1基于改进DQN的时隙分配算法

初始化

初始化当前子帧的SSM、上个子帧的SSM、Q网络和经验池

训练

For请求

只保留3个子帧之内达到的请求

由

if

令ai=0

else

重构

使用ε-贪心算法获得动作ai

更新Vk, i

通过下一个请求获得

end if

标记

if当前子帧的请求处理完毕 then

通过各个卫星的时隙分配,获得传输结果

根据传输结果获得动作ai对应的奖励ri

更新Vlast和Vk, i

将{φ(si), ai, ri, φ(si+1)}存入经验池

end if

从经验池中取一批元组计算L(θ)

根据L(θ)的值执行梯度下降

每G个子帧用θ=θ更新θ

End for

依照AIS和ASM的实际运行过程中的真实数据,VDES仿真参数设置如表 1所示。重复覆盖率为在重复覆盖区与卫星建立通信链路的船站在所有与卫星建立通信链路的船站中的占比,假设所有卫星的重复覆盖率相同。针对VDES海洋通信容量更大的特点,增加了业务传输所需时隙数量。业务的传输方向和船站位置服从平均分布。新请求到达率服从独立的泊松分布。策略参数如表 2所示。

|

|

表 1 仿真参数 Table 1 Simulation parameters |

|

|

表 2 策略参数 Table 2 Strategy parameters |

由于分配实际由卫星执行,对分配产生影响的是请求的总数以及各类请求的比例,因此将平均一个子帧里卫星收到的新请求数量作为卫星请求到达数量,而重复覆盖率反映了船站位置的分布。为保证请求的实时性,每个请求最多被尝试分配3次,之后将作为旧请求被剔除。此外,将随机分配方法作为对照。随机分配方法为每个请求随机选择不分配时隙或者分配某个DC时隙。现有分配方法[2]和随机分配方法均仅依靠卫星自身的分配信息,不具有通信环境感知能力。

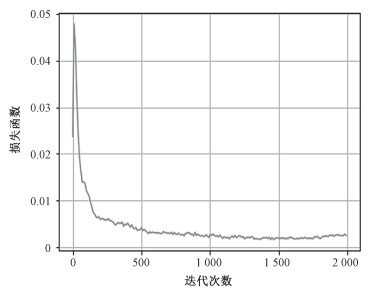

图 3显示了DQN算法的迭代收敛过程,在仿真过程中,卫星请求到达个数为12,重复覆盖率为0.5。从图 3中可以看出,DQN算法在经过200多次迭代后逐渐收敛,表明该算法能够通过历史资源分配信息和当前资源分配信息合理分配资源。

|

Download:

|

| 图 3 DQN算法损失函数收敛速度 Fig. 3 The convergence speed of the DQN algorithm | |

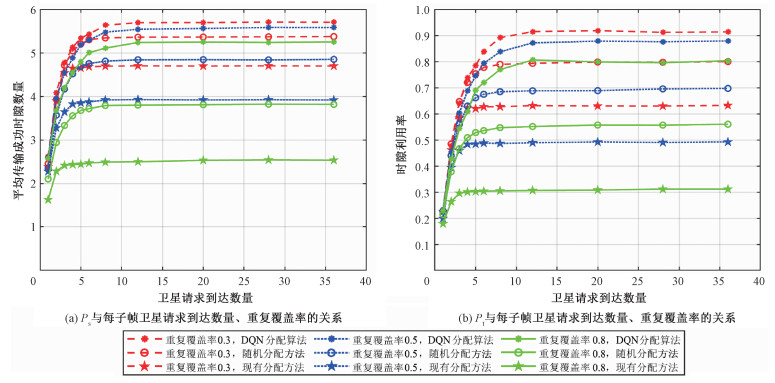

传输成功时隙数量PS与卫星请求到达数量的仿真结果如图 4(a)所示。时隙利用率PU与卫星请求到达数量的仿真结果如图 4(b)所示。由图 4可知,相比其他2种方法,基于DQN的分配算法在不同卫星请求到达数量、不同重复覆盖率的情况下都表现出更好的性能,证明了所提出策略的有效性。现有机制的分配方法性能最差,是因为现有机制倾向于给同一DC时隙分配同向请求,提升了碰撞发生概率。当卫星请求到达率超过8时,所有算法达到性能上限,对时隙的利用能力不再随请求的增加而提高。对于基于DQN的分配算法,再增加请求个数只会为了降低碰撞而不为新请求分配时隙;对于现有分配方法和随机选择,因为此时几乎所有时隙已经被分配完,再增加请求个数不会对结果造成影响。性能上限表明,当卫星请求到达个数超过8时,此时卫星应广播限制低重要性的请求发送频率,保证重要信息的传输顺畅。此外,每秒浮点数运算次数(floating point operations per second,FLOPS)反映神经网络算法对硬件性能的要求。目前市面上的DSP和FPGA的FLOPS大多为1~80 G。经统计,基于DQN的分配算法的单次运行所需浮点数运算次数为40 573,则运算用时小于1 ms,卫星硬件水平能够承受算法的时间开销。

|

Download:

|

| 图 4 不同时隙分配方法的通信性能对比 Fig. 4 Communication performance comparison of different slot allocation methods | |

针对VDES多星座重复覆盖场景中的同频碰撞问题,本文提出了一种基于改进DQN的星座间兼容策略。基于VDES通信流程,通过设置船站作为卫星时隙资源感知节点,提升星座间的信息交互性。在此基础上提出一种基于改进DQN的时隙分配算法,将重构后的请求信息、历史时隙分配结果和当前子帧的时隙分配方案作为关键因素输入网络,获得时隙分配方案,并通过分配结果更新优化算法。仿真结果表明,提出的策略能够显著提高传输成功时隙数量。下一阶段的研究可以从重复覆盖率的动态变化入手,模拟真实场景中的卫星运动,为VDES协议的进一步完善提供建议。为实现工程化应用,在维持性能不变的同时,降低DQN参数精度和模型压缩以满足卫星的计算能力也是研究方向之一。

| [1] |

ITU-R. Recommendation ITU-R M. 2092-1-Technical characteristics for a VHF data exchange system in the VHF maritime mobile band[S/OL]. Geneva: International Telecommunication Union: (2022-02-23)[2022-04-20]. https://www.itu.int/rec/R-REC-M.2092-1-202202-I/en/.

|

| [2] |

IALA. Guideline G1139 the technical specification of VDES[S/OL]. Saint Germain en Laye: International Association of Marine Aids to Navigation and Lighthouse Authorities: (2019-06-21)[2022-04-20]. https://www.iala-aism.org/product/g1139-technical-specification-vdes/.

|

| [3] |

姚治萱. VDES通信技术应用及其发展趋势[J]. 世界海运, 2019, 42(2): 34-38. Doi:10.16176/j.cnki.21-1284.2019.02.007 |

| [4] |

胡旭, 林彬, 王珍. 基于VDES的空天地海通信网络架构与关键技术[J]. 移动通信, 2019, 43(5): 1-8. Doi:10.3969/j.issn.1006-1010.2019.05.001 |

| [5] |

王福斋, 胡青, 姚高乐, 等. 甚高频数字交换系统发展现状及推进工作建议[J]. 中国海事, 2021(2): 18-21. Doi:10.16831/j.cnki.issn1673-2278.2021.02.005 |

| [6] |

Wang Y F, Ding X J, Zhang G X. A novel dynamic spectrum-sharing method for GEO and LEO satellite networks[J]. IEEE Access, 2020, 8: 147895-147906. Doi:10.1109/ACCESS.2020.3015487 |

| [7] |

Gu P, Li R, Hua C Q, et al. Dynamic cooperative spectrum sharing in a multi-beam LEO-GEO co-existing satellite system[J]. IEEE Transactions on Wireless Communications, 2022, 21(2): 1170-1182. Doi:10.1109/TWC.2021.3102704 |

| [8] |

Gu P, Li R, Hua C Q, et al. Cooperative spectrum sharing in a co-existing LEO-GEO satellite system[C]//GLOBECOM 2020: 2020 IEEE Global Communications Conference. December 7-11, 2020, Taipei, China. IEEE, 2020: 1-6. DOI: 10.1109/GLOBECOM42002.2020.9347950.

|

| [9] |

Jia M, Li Z, Gu X M, et al. Joint multi-beam power control for LEO and GEO spectrum-sharing networks[C]//2021 IEEE/CIC International Conference on Communications in China (ICCC). July 28-30, 2021, Xiamen, China. IEEE, 2021: 841-846. DOI: 10.1109/ICCC52777.2021.9580210.

|

| [10] |

李壮. 基于干扰控制的LEO和GEO频谱共享方法[D]. 哈尔滨: 哈尔滨工业大学, 2021.

|

| [11] |

Bu G J, Jiang J. Reinforcement learning-based user scheduling and resource allocation for massive MU-MIMO system[C]//2019 IEEE/CIC International Conference on Communications in China (ICCC). August 11-13, 2019, Changchun, China. IEEE, 2019: 641-646. DOI: 10.1109/ICCChina.2019.8855949.

|

| [12] |

Li Z W, Xie Z C, Liang X W. Dynamic channel reservation strategy based on DQN algorithm for multi-service LEO satellite communication system[J]. IEEE Wireless Communications Letters, 2021, 10(4): 770-774. Doi:10.1109/LWC.2020.3043073 |

| [13] |

李子煜. 多波束低轨卫星通信系统切换与资源管理算法研究[D]. 重庆: 重庆邮电大学, 2021.

|

| [14] |

Seo J, Cho K, Cho W, et al. A discovery scheme based on carrier sensing in self-organizing bluetooth low energy networks[J]. Journal of Network and Computer Applications, 2016, 65: 72-83. Doi:10.1016/j.jnca.2015.09.015 |

| [15] |

韩存武, 周慧, 刘蕾, 等. 基于数据的无线通信网络功率和速率控制[J]. 计算机仿真, 2022, 39(2): 375-379, 511. Doi:10.3969/j.issn.1006-9348.2022.02.072 |

| [16] |

曾欢, 张灿, 陈德元. 空间通信网中音视频传输的应用层QoS控制与测试方法[J]. 中国科学院研究生院学报, 2011, 28(1): 108-115. Doi:10.7523/j.issn.2095-6134.2011.1.016 |

| [17] |

Strehl A L, Li L H, Wiewiora E, et al. PAC model-free reinforcement learning[C]//ICML'06: Proceedings of the 23rd international conference on Machine learning. June 25-29, 2006, Pittsburgh, USA. New York: ACM, 2006: 881-888. DOI: 10.1145/1143844.1143955.

|

| [18] |

Mnih V, Kavukcuoglu K, Silver D, et al. Human-level control through deep reinforcement learning[J]. Nature, 2015, 518(7540): 529-533. Doi:10.1038/nature14236 |

2024, Vol. 41

2024, Vol. 41