2. 中国科学院大数据挖掘与知识管理重点实验室, 北京 100190

2. Key Laboratory of Big Data Mining and Knowledge Management, Chinese Academy of Sciences, Beijing 100190, China

随着计算机技术、物联网技术、智能设备的逐渐普及,传统的身份认证方式易丢失、易复制、易冒用,在诸多场景下已经不能满足现实需求。生物特征识别技术是基于生物特征进行身份认证的,比传统的身份认证方式更安全可靠。常见的能够用于身份认证的生物特征包括生理特征(指纹、掌纹、虹膜、DNA、静脉、人脸等)和行为特征(声音、步态等)。指纹因为具有唯一性、持久性、普遍性以及易于采集等特点,在众多生物特征中占据优势地位[1-2]。经过不断的技术革新,自动指纹识别系统已经在刑事侦查、法庭科学、安全检查和金融支付等领域有着广泛应用。尤其在刑事侦查和法庭科学领域,随着指纹采集条件逐渐完善,亿万级的指纹图像数据采集、预处理、特征提取、特征比对已经成为现实。指纹图像质量直接影响指纹鉴定结论的准确性和可靠性,关乎有效证据的形成和刑事案件的侦破。好的指纹图像质量评价算法不仅有助于指纹专家对指纹进行分析和鉴定,还能够提升自动指纹识别系统(automatic fingerprint identification system,AFIS)的性能:有助于减少设备资源消耗、缓解数据处理的压力、缩短任务执行时间、提高指纹匹配算法的准确率等。因此,指纹图像质量评价算法的研究一直是指纹领域专家学者关注的热点。

1 指纹图像质量评价有关指纹图像质量的研究,最早可追溯到20世纪90年代。Bolle等[3]根据方向场的强度分割出有效区域与无效区域,并计算二者面积占比来评估指纹图像质量。Shen等[4]使用Gabor滤波的方法区分有无明显方向特征的指纹小块并以此计算质量分值。这些算法参考的特征因子过于单一,而且对复杂背景的指纹图像质量评价缺乏鲁棒性,容易受噪声影响。2004年,美国国家标准与技术研究院(National Institute of Standards and Technology,NIST)研发出NIFQ1.0[5]指纹图像质量评价算法。该算法依靠传统的指纹特征提取算法提取11个特征因子,将正则化后的指纹匹配分数作为监督信息训练感知机分类网络,最终将指纹质量分为5个等级。但该算法无法提供高精度的质量分数,因此适用场景受到极大限制。随着ISO/IEC29794系列标准文献[6-8]对生物特征样本质量的明确,NIST进一步研发出NFIQ2.0[9]指纹图像质量评价算法。但该算法仍然部分延续NFIQ1.0的实现思路,即依靠传统的指纹特征提取算法提取特定的特征因子,然后利用传统的机器学习算法实现质量分类。虽然NFIQ2.0算法可以提供高精度的评估分数(0~100分),也符合ISO相关标准基本要求[7-8],并受到国内外专家学者的广泛关注,但是该方法仍然缺乏评价指纹图像局部区域质量的能力,而此项能力对于刑事侦查和法庭科学的指纹鉴定任务是极为重要的。另外,NFIQ2.0算法相关报告中提供的案例指纹的质量分数与指纹专家的质量评价结果存在较大偏差,其分数存在畸高、畸低和不合理下滑的现象。近年来,国内外关于指纹图像质量的研究不断有新方法被提出。2016年,Li等[10]针对不同曲率的指纹区域提取不同的特征因子,提出一种混合的指纹图像质量评价方法。2019年,Richter等[11]推荐一种基于污点噪声(smudge noise)的指纹图像质量评价方法,并在部分公开数据集上有突出表现。2020年,Chen等[12]针对移动设备传感器获取的部分指纹图像,提出融合纹理和几何特征的混合指纹图像评价方法。2021年,Agarwal和Bansal[13]结合脊线清晰度特征、纹理特征和细节点特征提出针对现场指纹(latent fingerprint image)的图像质量评价方法。2021年,Hendre等[14]通过对比已有的多种质量评价方法对部分采集指纹的评价能力,认为现有的方法中NFIQ2.0算法和基于Gabor滤波的方法能够对部分采集指纹进行有效的低质量检测。近年来对指纹图像质量评价问题的研究大多延续传统图像处理和机器学习的方法,尽管在一些数据集上能够有效降低指纹匹配算法拒识率(false non-match rate,FNMR),但仍然缺乏对指纹图像局部区域质量的评价能力。

从文献来看,目前国际较为通用的指纹图像质量评价算法是NFIQ2.0算法。在我国,现有的国家标准[15-17]在指纹数据交换格式中定义了图像质量域,但还没有解释和定义评价指纹图像质量的方法,相应的评价策略仍主要参考美国的NIST_NFIQ算法[5, 9]及ISO/IEC-29794标准[6-8],因此本文主要针对NFIQ2.0算法实施对比实验。

深度学习技术尤其是卷积神经网络(convolutional neural network,CNN)在指纹领域的应用已有先例。2016年,江璐等[18]提出基于卷积神经网络的指纹纹型分类算法。2017年,Qin等[19]提出基于全卷积神经网络的多尺度奇异点检测算法。2018年,Li等[20]提出基于卷积神经网络的现场指纹增强方法,Liu等[21]对指纹奇异点检测问题提出基于Faster-RCNN的新思路。2020年,Zhou等[22]基于卷积神经网络提出两阶段的快速细节点特征提取算法,Liu等[23]基于深度学习技术提出对齐指纹匹配算法。这说明深度学习尤其是CNN的方法在解决指纹领域问题方面有很好的前景,因此本文尝试将CNN的方法应用于指纹图像质量评价算法的设计中。一般而言,CNN的深度越深,特征提取能力越强,但会导致训练难度增加和计算资源过度消耗。2016年,He等[24]提出残差学习的网络模型,有效解决了训练深层CNN的难题。同年,Huang等[25]提出的DenseNet网络模型能够在参数更少、计算成本更小的情况下,实现比前者更优的性能。

针对刑事侦查和法庭科学领域指纹图像鉴定的应用场景,本文将指纹图像质量评价问题拓展到二维质量空间上,学习指纹专家对纹线局部区域的质量感知策略,提出一种基于视觉感知模型的指纹图像质量评价算法。首先介绍算法的整体框架;接着准备训练数据、构建和训练CNN感知分类网络,目的是使CNN网络学习指纹专家对纹线局部区域的质量感知策略,这是本文算法在训练阶段的核心任务;然后给出感兴趣区域(region of interest,ROI)提取算法和高斯赋权模型;最后结合ROI区域提取算法、CNN感知分类网络和高斯赋权模型完成基于视觉感知模型的指纹图像质量评价算法设计。本文在二维空间中对指纹图像局部区域的质量分布进行表示,这符合刑事侦查和法庭科学领域指纹鉴定应用场景的需求。为了验证本文算法的合理性,本文从质量分值合理性、质量空间表达合理性、指纹匹配算法拒识率FNMR指标3个方面做出实验分析。

2 视觉感知模型指纹图像质量评价问题可以描述为2个映射过程,如下所示

| $ \left\{\begin{array}{l} f_{\mathrm{s}}: \mathbb{R}^{w \times h} \mapsto \mathbb{R} \\ f_{\mathrm{q}}: \mathbb{R}^{w \times h} \mapsto \mathbb{R}^{w \times h} \end{array}\right., $ | (1) |

其中:w、h分别是图像的宽和高;fs是从w×h的图像空间到标量分数的映射,表示对指纹图像整体的评价过程;fq是从图像空间到二维质量空间的映射,体现了对指纹图像局部区域质量评价。现有的指纹图像质量评价问题的相关文献均仅是研究指纹图像整体的质量评价问题(即研究fs的映射问题),缺少对fq的探索研究。事实上,fs、fq并非两个独立的映射过程,即指纹图像局部区域质量鉴定可以为指纹图像整体质量评价提供依据。这意味着可以在统一的基础模型中实现fs、fq两个指纹图像质量评价的映射过程。本文从仿生学的角度出发,分析指纹专家对指纹图像质量的评价过程,并设计出同时实现fs、fq两个指纹图像质量评价任务的指纹图像质量评价算法。

指纹专家通过视觉感知行为对指纹图像质量做出评价是其视觉神经系统高度复杂的活动过程。在此过程中,指纹专家首先快速定位指纹图像的ROI区域,然后对ROI局部区域在主观意识的指导下进行细致分析。前者快速定位ROI区域是受指纹图像内容驱动的自底而上的视觉关注模式;后者对纹理局部区域的细致分析是在主观意识命令下的自顶而下的视觉关注模式。视觉感知结论的形成还需要指纹专家视觉神经系统内在的推导机制,即指纹专家视觉神经系统并非直接去理解进入眼睛的视觉信号,而是会根据大脑中的先验知识来推导预测其视觉内容。

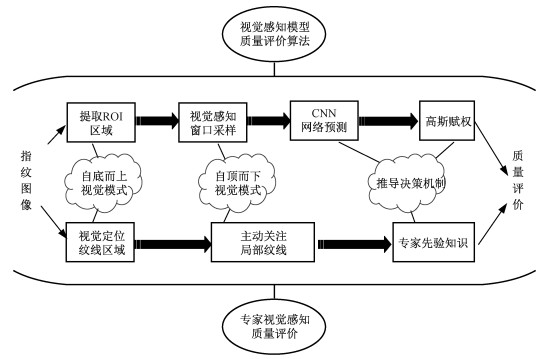

本文模拟指纹专家对指纹图像的视觉感知质量评价过程,提出基于视觉感知模型的指纹图像质量评价算法。该算法以原始指纹图像为输入,最终输出指纹图像的整体质量分数和二维质量空间分布。在该模型中,模拟指纹专家自底而上的视觉关注模式,设计ROI区域提取算法引导视觉感知模型关注指纹图像的纹理区域;模拟指纹专家自顶而下的视觉关注模式,以视觉窗口采样的方式对指纹图像进行细致分析;训练CNN感知分类网络,学习指纹专家大脑中对指纹图像局部质量认知的先验知识,以模拟指纹专家对指纹局部区域做出质量评价的推导决策机制。此外,设计高斯赋权模型,模拟指纹专家对不同指纹区域特征重要性的一般认知规律,使得本文视觉感知模型对指纹图像质量评价的推导决策机制更加匹配指纹专家对指纹图像质量的视觉感知原理。视觉感知模型质量评价算法与指纹专家视觉感知质量评价对应过程如图 1所示。

|

Download:

|

| 图 1 视觉感知模型质量评价算法与专家视觉感知质量评价对应过程 Fig. 1 The corresponding process of visual perception model quality evaluation algorithm and expert visual perception quality evaluation | |

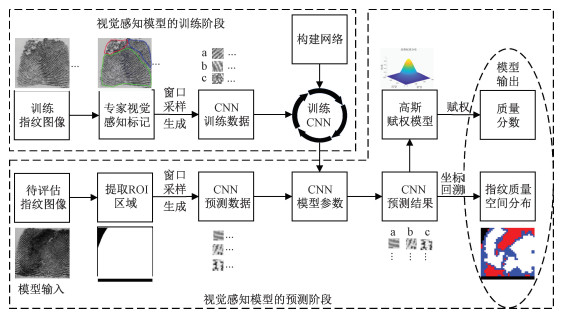

算法具体实施分为视觉感知模型的训练阶段和预测阶段。在训练阶段,主要设计CNN感知分类网络算法,通过数据驱动的方式引导CNN网络学习专家对指纹图像局部纹理质量感知的先验知识,以使得本文视觉感知模型在预测阶段能够模拟指纹专家对指纹图像局部纹理质量评价的神经推导机制。预测阶段,设计ROI区域提取算法,提取指纹图像的纹理区域,并以视觉窗口采样的方式生成CNN感知分类网络的预测数据,并通过训练完成的CNN网络参数获得预测数据的分类结果。最终既可以将预测结果进行坐标回溯生成指纹图像的二维质量空间分布,也可以结合高斯赋权模型生成指纹图像的质量分数。视觉感知模型质量评价算法具体实施框架如图 2所示。

|

Download:

|

| 图 2 视觉感知模型质量评价算法具体实施框架 Fig. 2 The implementation framework of visual perception model quality evaluation algorithm | |

本文数据来源于国内某省刑侦十指指纹数据,共计7 000枚指纹图像。从中随机选取6 500枚指纹图像用作准备训练数据,另外500枚指纹图像用于质量空间分布合理性验证。首先组织指纹专家对6 500枚指纹图像实施视觉感知质量标记实验,即专家对指纹图像局部纹理区域做出质量好、质量中等和质量差的质量判定,为CNN感知分类网络的训练提供监督信息。

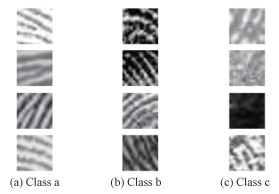

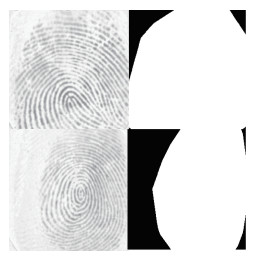

形状不规则的大面积质量标记区域不能体现自顶而下的视觉感知模式,且不利于CNN感知分类网络的训练,因此需要设定统一尺寸的视觉感知窗口对专家质量标记区域进行采样。若设定视觉感知窗口尺寸过小,会导致单位窗口内只有单条纹线或没有纹线,从而无法提供用来进行质量评价的依据;若设定视觉感知窗口尺寸过大,与专家细致分析局部纹理的视觉感知过程相悖。对于分辨率为500 dpi的指纹图像,纹线周期一般为10~12个像素,因此为确保单位视觉感知窗口内存在2条以上的指纹纹线,同时便于引导模型细致分析指纹图像局部纹理,本文设定32像素×32像素的视觉感知窗口在专家标记的质量区域内进行采样,所得采样图像作为CNN感知分类网络的训练数据。为进一步增广训练数据集,设定16像素的采样间隔,并在(-30°, +30°)范围内对采样视觉感知窗口进行随机旋转。最终共计将305 667枚采样所得指纹小块用于CNN感知网络训练。按专家质量标记信息,将指纹小块分为3个类别(Class a,Class b,Class c):

Class a:质量好的指纹小块,纹线清晰,基本无噪声;Class b:质量中等的指纹小块,纹线模糊,有噪声但经过处理基本可恢复;Class c:质量差的指纹小块,无明显纹线信号特征的区域,完全不可用。3种类别指纹图像小块质量差异对比示意图,见图 3。

|

Download:

|

| 图 3 不同质量类别的指纹图像小块 Fig. 3 Fingerprint image blocks of different quality classes | |

进一步按照8∶1∶1的比例,将305 667枚指纹图像小块随机分成训练集(244 533枚,Class a:81 503,Class b:122 215,Class c:40 815)、测试集(30 566枚,Class a: 10 200,Class b:15 283,Class c: 5 083)和验证集(30 568枚,Class a: 10 189,Class b:15 213,Class c:5 166),作为CNN训练、测试和验证的数据。

2.1.2 CNN感知分类网络CNN结构机制与人类视觉系统对图像的认知原理具有先天的相似性,并且CNN应用于图像领域已得到广泛认可。本文设计CNN感知分类网络模拟专家视觉感知指纹图像局部纹理质量的推导机制,并以专家质量标记的数据驱动网络学习专家质量感知的先验知识。

CNN感知分类网络的输入尺寸与训练数据的采样窗口尺寸(32像素×32像素)保持一致。一般而言,越深层的CNN网络非线性表达能力越强,可以学习更复杂的变换,从而可以模拟更复杂的神经推导机制。但随着网络深度的增加,网络参数量也随之增加,容易带来模型难以训练和过拟合问题。理论上从感受野的角度,2个3×3的卷积核等同于1个5×5的卷积核,3个3×3的卷积核等同于1个7×7的卷积核;从参数的角度,2个或3个3×3小尺寸卷积核参数量(分别是18,27)比单个5×5和7×7卷积核的参数量(分别是25,49)要少得多。因此,本文在网络设计中,采用3×3和1×1两种小尺寸的卷积核构建深层感知分类网络既可以尽可能地减少训练参数量,又可以保持深层网络的优势。

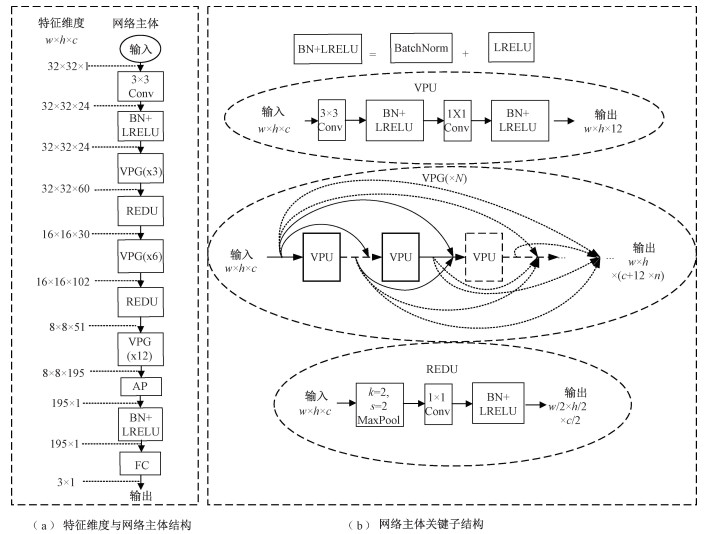

本文设计的CNN感知分类网络结构和参数如图 4所示。图 4(a)说明网络主体结构和特征维度变化,图 4(b)说明网络主体的关键子结构。其中3×3 Conv和1×1 Conv分别表示卷积核为3和1的卷积层。BN+LRELU是BatchNorm层和LRELU非线性激活函数的简化表示;VPG(×N)表示是由N个VPU构成的子结构,其中VPU是由卷积层、激活函数、批正则化层构成的基础结构单元;REDU是由核为2×2(k=2),步长为2(s=2)的最大值池化(max pool)层和1×1 Conv为主要构成的特征降维子结构。AMP表示自适应最大池化(adaptive max pool)层,作用是将c个通道特征图采用非极大值抑制的池化方法降维为c维的特征向量;FC表示全连接层。CNN感知分类网络最终输出一个3维向量,经过softmax归一化指数激活函数(未在网络中标注)可以代表CNN感知分类网络将输入预测为3个质量类别的概率。

|

Download:

|

| 图 4 CNN感知分类网络结构 Fig. 4 CNN perception classification network structure | |

在每个VPU中,本文设计3×3 Conv加强网络对特征图不同空间位置的感知能力,设计1×1 Conv实现跨通道的视觉信息组合,进一步将VPU输出固定为12个特征通道,并与输入尺寸(w×h)保持一致,便于多层VPU之间的特征融合。简单的VPU线性叠加无法融合多层次的视觉感知信息,且会导致网络难以得到有效的训练。因此本文在网络主体的不同阶段,分别引入3、6、12个VPU组成的VPG。每个VPG内部采用特征复用的方式连接VPU,即VPG内部前面各级VPU的特征输出以特征通道维度拼接的方式作为下一级VPU的输入,并以此类推。网络深度的增加使得卷积层提取的特征图更加全局和抽象,但特征空间也急剧膨胀。本文在VPG之间引入REDU结构的目的是以非极大值抑制的方法选择典型突出特征并将特征图尺寸(w×h)缩小1/2,同时利用1×1 Conv整合通道信息并进一步将特征图通道数减少1/2。REDU结构既可以有效减少计算资源的消耗,又可以进一步选择出有代表性的视觉特征。在网络中,BatchNorm层和LRELU分段线性激活函数能够加快网络收敛速度,同时缓解训练过程中梯度消失和爆炸的现象。图 4(b)详细说明了VPG、VPU、REDU和BN+LRELU的关键结构。

2.1.3 网络训练本文所用硬件实验环境为Intel(R) Core(TM) i9-10900KF CPU、32 G内存、Nvidia RTX3090显卡。软件环境为Python3.8、Pytorch1.9。

专家标记的6 500枚刑侦指纹图像中3种不同质量区域的面积分布差别很大,导致经过视觉感知窗口采样生成的训练样本存在严重的样本不均衡问题。在生成的305 667枚训练样本中,Class b的样本数量远远大于Class a、Class c的样本数量(a∶b∶c≅1∶2∶1),如果不加干涉地直接用于网络训练容易导致网络无法学习到有效的视觉特征,网络更倾向于将输入预测为Class b。为解决样本不均衡问题对CNN感知分类网络的影响,在训练过程设定交叉熵分类损失函数,并对不同类别训练样本所得的计算损失设置不同的权重(Wa∶Wb∶Wc≅2∶1∶2),相对增强a、c两类样本在分类损失函数中提供的损失信息,从而提高CNN感知分类网络的分类准确率。

设yi, i=1, 2, 3表示CNN感知分类网络输出每个维度的值。ci, i=1, 2, 3表示网络输入数据对应的真实类别标签,取值为0或1。并设w1=Wa, w2=Wb, w3=Wc。则网络预测输入为每个类别的概率、训练过程分类损失的计算如下

| $ p_i=\operatorname{softmax}\left(y_i\right)=\frac{\mathrm{e}^{y_i}}{\sum\nolimits_{j=1}^3 \mathrm{e}^{y_j}}, $ | (2) |

| $ \operatorname{loss}=-\sum\limits_{i=1}^3 w_i c_i \log \left(p_i\right) . $ | (3) |

进一步,采用Kingma和Ba[26]提出的Adam优化器作为网络权重参数的更新策略。在训练过程中,设定Adam一阶矩的指数衰减率β1=0.9,二阶矩的指数衰减率为β2=0.99。

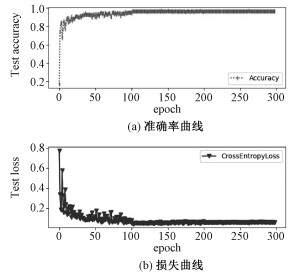

此外,采用多阶段的学习率衰减策略,设定初始学习率l=0.01,衰减间隔为100个训练周期(epoch),衰减率为0.1。随着迭代次数增加,网络分类准确率先上升后趋于稳定,损失先下降后趋于稳定,说明网络权重参数在逐渐收敛。最终经过300 epoch,模型在验证集上的预测准确率达到96.4%。随着训练过程迭代周期数增加,在验证集上CNN感知分类网络的损失和预测准确率的收敛情况如图 5所示。

|

Download:

|

| 图 5 验证数据集上模型预测损失和准确率曲线 Fig. 5 Model prediction loss and accuracy curve on validation data set | |

进一步将训练好的CNN感知分类网络在测试数据集上测试最终得到96.2%的平均预测准确率,这说明该模型得到了有效训练,没有过拟合和欠拟合的现象。

2.2 预测阶段 2.2.1 ROI区域提取算法本文需要快速引导视觉感知模型的注意力关注到指纹图像的纹理区域,以近似模拟专家视觉感知过程的自底而上视觉关注模式。值得注意的是,任何有效的ROI区域提取算法都可嵌入本文视觉感知模型的框架中,本文仅在算法2.1中就一种可行的ROI区域提取算法进行说明。一般而言,指纹图像的ROI区域比背景和噪声区域具有明显的局部方向性,可以作为判别ROI区域的依据。在算法设计中,首先使用直方图均衡化算法[27]提高图像对比度,然后对增强后的指纹图像计算其方向可靠性强度[28],得到强度分布矩阵r。然后,最大类间方差法[29]计算r的最佳分割阈值并完成初步分割。进一步,对初步分割结果进行形态学处理[27]以抑制面积较小的边界噪声区域和连通距离较近的目标区域。最后,为了保证ROI区域的提取结果能够近似保留指纹形态,利用凸包检查[30]算法保留面积最大的凸包区域作为最终所得ROI区域。在具体实现中,借助OpenCV图像处理算法库,并尽可能地将迭代计算过程转换成二维卷积和矩阵Hadamard乘积以提高算法的执行效率。以FVC2000[31]Db1中两幅的指纹图像为例,ROI区域提取效果如图 6所示。

算法2.1 ROI区域提取算法

输入:指纹图像灰度值矩阵I,并做如下初始化:

K3×3=ones(3), K7×7=ones(7), K9×9=ones(9)

1: 直方图均衡化I(灰度增强),结果记为I′。

2: Sobel算子对I′做二维卷积运算(⊙表示),计算I′在x, y方向的梯度矩阵Sx、Sy:

3: 计算Sx、Sy之间的Hadamard乘积(⊗表示):

4:K3×3分别对XX、XY、YY进行二维卷积:

5: 计算方向可靠性矩阵:

6: 最大类间方差法对r进行阈值分割,大于阈值的位置灰度值设为255,否则设为0,所得二值分割矩阵记为Ib。

7: 以K7×7为结构元对Ib进行形态学开运算,再以K9×9为结构元对Ib进行形态学闭运算,所得结果记为Im。

8: 对Im进行凸包检查,并填充最大面积的凸包区域灰度值为255,其他区域灰度值设为0,所得结果为IR。

输出:ROI区域提取结果IR(灰度值为255的区域)。

|

Download:

|

| 图 6 ROI区域提取效果 Fig. 6 Extraction effect of ROI region | |

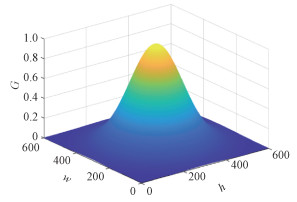

不同的指纹采集区域在指纹鉴定过程中不具有同等重要性,低质量的指纹中心区域往往要比低质量的指纹边缘区域损失更多的有价值特征是指纹专家的一般性先验认知。依据对指纹局部特征重要性衰减分布认知的一般规律,提出自适应图像尺寸的高斯赋权模型,对不同位置的指纹局部质量预测结果适配合理的权值,从而提高最终评估分值的合理性。如下所示

| $ \boldsymbol{G}(w, h)=\exp \left(\left(\frac{\left(w-w_0\right)^2}{2 \sigma_w^2}+\frac{\left(h-h_0\right)^2}{2 \sigma_h^2}\right)\right), $ | (4) |

式中:w0、h0分别等于图像的宽度和高度,σw=w0/3, σh=h0/3,w∈[0, 2w0),h∈[0, 2h0)。

由式(4)可以得到特征重要性权值矩阵G。以300像素×300像素的图像为例,得到G的权值分布情况如图 7所示。

|

Download:

|

| 图 7 高斯赋权模型权重分布 Fig. 7 Weight distribution of Gaussian weighting model | |

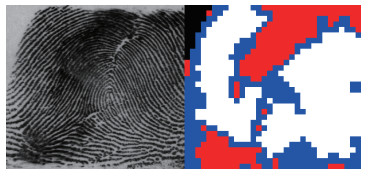

利用ROI区域提取算法模拟专家快速定位指纹纹理区域的自底而上视觉关注模式,然后设定32像素×32像素的视觉感知窗口对ROI区域进行采样,以模拟专家主动视觉注意指纹局部纹理的自顶而下视觉关注模式。前述CNN感知分类的网络构建和训练过程使得CNN感知分类网络获得模拟专家对指纹图像局部纹理进行质量感知的能力,可以对局部视觉感知窗口的指纹图像纹理做出质量预测。进一步,本文设计高斯赋权模型以模拟指纹专家对指纹局部特征重要性衰减认知的一般规律。将ROI区域内每个视觉感知窗口的指纹图像小块输入CNN感知分类网络,经过前向传播得到质量预测结果,再经过高斯赋权模型的适配权重,可以计算指纹图像整体质量分数。进一步,将CNN感知分类网络的预测结果进行坐标回溯和统计分析,可以得到指纹图像质量的二维空间分布。具体算法设计见算法2.2。指纹图像质量的二维空间分布可视效果如图 8所示。

算法2.2质量分值与二维空间分布预测算法

输入:原始指纹图像I

w←I的宽度,h←I的高度,M=A=Q=zeros((w, h))

1: 算法2.1提取I的ROI区域,输出IR。

2: XB=0,YB=0,SB=0

3: for i=0∶1∶h do

4: for j=0∶1∶w do

5: if IR[i, j]==255 then

6: YB+=i, XB+=j,SB+=1

7: end if

8: end for

9: end for

10: XC=XB/SB, YC=YB/SB

11: XO=XC-w/2, YO=YC-h/2

12: SSum=0, S=0

13: for i=0∶16∶h do

14: for j=0∶16∶w do

15: Bij=I[i: i+32, j: j+32]

16: RBij=sum (IR[i: i+32, j: j+32])/255

17: r=h/2+i-YO,c=w/2+j-XO

18: GW(Bij)= sum(G[r: r+32, c: c+32])/1024 #G是特征重要性权值矩阵

19: if RBij < 0.75 then

20: SSum+=GW(Bij)

21: else

22: _, idx=max(CNN(Bij)) #CNN预测

23: C(Bij)=3-idx

24: S+=GW(Bij)C(Bij)

25: SSum+=3GW(Bij)

26: M[i: i+32, j: j+32]+=C(Bij)

27: A[i: i+32, j: j+32]+=1

28: end if

29: end for

30: end for

31: S=S/SSum×100

32: Q=M/A # M和A矩阵对应元素相除

33: 进步对Q进行阈值分割,Q≥2.5标记为白色,2.5>Q≥1.5标记为蓝色,1.5>Q≥1标记为红色,其它位置标记为黑色。可以得到质量二维空间分布Q的可视效果。(阈值可根据实际需要调整)

输出:指纹图像质量分数S; 指纹图像质量二维空间分布Q。

|

Download:

|

| 图 8 指纹图像质量二维空间分布 Fig. 8 Two-dimensional spatial distribution of fingerprint image quality | |

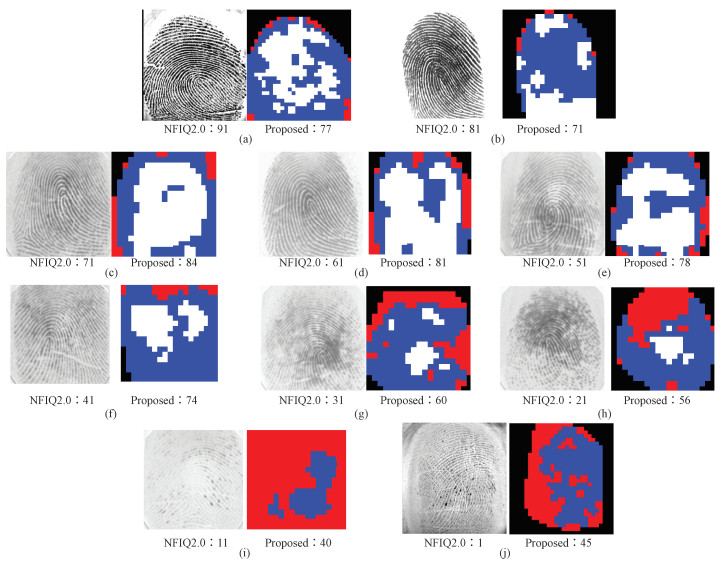

本文针对NFIQ2.0算法关于FVC2000 Db1/Db3、FVC2002[32] Db1公开数据集的测试指纹图像案例,分别给出NFIQ2.0算法质量评分和视觉感知模型质量评价算法质量评分,进一步给出本文算法对每幅指纹图像二维质量空间分布的评价结果,如图 9所示。

|

Download:

|

| 图 9 视觉感知模型质量评价算法与NFIQ2.0算法关于质量评价分数的对比 Fig. 9 The comparison of quality evaluation score between visual perception model quality evaluation algorithm and NFIQ2.0 algorithm | |

国家公安部物证鉴定中心的指纹专家认为原有NFIQ2.0算法存在明显不合理的评分估值。比如:图 9(a)、9(b)两幅指纹图像存在捺印采集不全的质量缺陷,会导致在刑事侦查等部分指纹应用场景下存在漏比风险,因此NFIQ2.0算法评分估值偏高(分别是91、81分),而本文的方法给出的评分估值(分别是77、71分)相对合理;图 9(c)~9(h)指纹图像并不存在质量上的显著性差异,而NFIQ2.0算法给出的质量分数存在明显下滑的现象(分别是:71、61、51、41、31、21分),这种不合理的分数分布,不仅无法与专家视觉感知指纹图像质量的评价结果相匹配,而且很难被众多的指纹采集民警所理解和认同,如果以此评分估值作为指导法庭科学指纹检验和违法犯罪人员指纹采集的质量指标,合理性存疑。反观本文算法给出的质量分数分布更加合理(分别是84、81、78、74、60、56分),且从指纹图像二维质量空间分布图可以直观验证本文算法对指纹图像局部区域质量评价的合理性;图 9(i)、9(j)两幅指纹图像,在刑事侦查的应用场景下存在明显的应用价值,而NFIQ2.0算法给出明显的畸低质量分数(分别是11、1分),这会导致大量有鉴定价值的指纹数据被排除。反观本文算法给出的质量分数更加合理(分别是40、45分)。

本文算法提供的指纹图像质量空间分布,将单一的质量评估分数分散到二维空间中表达,从而可以清楚地定位指纹的低质量区域,方便指纹采集和AFIS有针对性的优化。因此,无论从质量评分估值合理性角度还是质量空间分布的直观性角度,本文的方法都具有很强的优越性。

3.2 质量空间表达合理性分析本文首次将指纹图像质量评价问题拓展到二维质量空间上,现有文献并未找到相似算法,因此无法进行横向对比实验。为说明本文算法在二维质量空间中对指纹图像质量评价结果的合理性,将2.1.1节中所提及的剩余500枚指纹图像进行专家质量感知标记,测试本文视觉感知模型算法与专家视觉感知的质量评估结果在二维空间上的一致性。

本次共组织15名专家进行有重复的质量标记实验,具体从500枚指纹图像中进行有放回的采样,每次抽取其中200枚指纹图像交给其中一名指纹专家进行标记,共计重复采样15次,也即平均每枚指纹图像有6名指纹专家进行视觉感知标记。为排除专家个体的视觉感知偏差,将有3次以上专家视觉感知结果一致的区域视为确定性区域,记为C3,其他区域统一视为不确定区域。在指纹应用场景中,一般认为Class a和Class b区域都为指纹图像的有效区域,其对指纹鉴定过程存在有价值的信息,Class c区域为无效区域,基本不存在任何有价值的特征信息。因此,从特征有无价值的角度出发,将Class a和Class b合并作为有效区域,Class c作为无效区域。统计500枚指纹图像中本文算法预测和专家标记有效性一致的区域面积(都为有效或都为无效)占确定性区域C3总面积的比例,以此作为衡量本文算法预测与专家视觉感知结果的一致性程度。最终统计计算结果为99%,说明本文的感知模型与专家的视觉感知结果具有高度一致性。

本文算法预测与专家视觉感知一致性实验可视化结果如图 10所示。其中红色区域为模型预测为无效(Class c)的区域,白色区域为模型预测为有效(Class a、Class b)的区域;黄色区域为C3中专家标记为无效的区域,蓝色区域为C3中专家标记为有效的区域。从图中可以看出,蓝色区域基本落入白色区域,黄色区域基本落入红色区域,从而直观地验证了本文模型与专家视觉感知结果的一致性。

|

Download:

|

| 图 10 视觉感知模型质量评价算法与专家视觉感知结果的一致性 Fig. 10 The consistency of visual perception model quality evaluation algorithm with the expert visual perception results | |

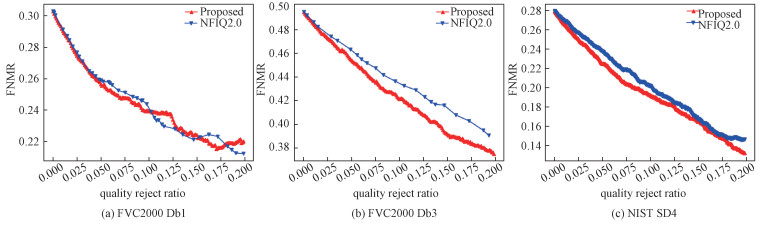

在AFIS系统中,质量较差的指纹图像更容易造成FNMR的升高,有效地排除低质量指纹,会导致FNMR下降。因此,随着低质量指纹排除率上升,FNMR的下降情况对比是质量评价算法效果的指标之一。在此实验中,使用基于细节点特征的开源指纹算法库NBIS[33]在FVC2000 Db1/Db3、NIST SD4[34] 3个指纹库上进行指纹匹配,其中的MINDTCT算法用于特征提取,BOZORTH3算法用于特征匹配,并设定匹配阈值为45分。因此,在45分的固定匹配分数阈值下,FNMR以下式定义

| $ \mathrm{FNMR}=P(\mathrm{TPMS}<45 \mid \mathrm{TP}), $ | (5) |

其中TP表示同一根手指采集的真实指纹对,TPMS表示真实指纹对的匹配分数(此处为BOZORTH3所得分值)。相同的低质量指纹排除率,FNMR的值越低说明指纹质量评价算法越有效。

视觉感知模型质量评价算法与NFIQ2.0算法分别排除低质量指纹带来的FNMR下降情况如图 11所示。结果表明,FVC2000 Db1的数据集上本文算法和NFIQ2.0算法互有胜负,在FVC2000 Db3数据集和NIST SD4数据集上本文算法比NFIQ2.0算法更有优势。尽管NBIS是基于细节点的指纹算法库,且NFIQ2.0算法直接将细节点相关特征作为质量评估的关键特征,而本文视觉感知模型并没有直接将这种匹配特征(细节点)作为质量评估依据,但在此对比实验中本文算法仍然比NFIQ2.0算法有优异表现。

|

Download:

|

| 图 11 视觉感知模型质量评价算法与NFIQ2.0算法关于FNMR指标的对比实验 Fig. 11 Comparison experiment of visual perception model quality evaluation algorithm with NFIQ2.0 algorithm on FNMR index | |

本文提出基于视觉感知模型的指纹图像质量评价算法,包括设计ROI提取算法模拟指纹专家快速定位指纹纹理区域自底而上的视觉关注模式,设计32像素×32像素的视觉感知采样窗口模拟指纹专家关注局部纹理自顶而下的视觉关注模式,设计CNN感知分类网络和高斯赋权模型模拟指纹专家对指纹图像质量视觉感知过程的神经推导机制。进一步,从质量分值合理性分析、质量二维空间分布合理性分析和FNMR指标分析3个角度验证本文算法的优越性。

本文主要贡献包括:提供更加合理的指纹图像质量评分算法;将指纹图像质量评价问题拓展到二维质量空间上,对于刑事侦查和法庭科学领域的指纹鉴定任务有较高的应用价值;从模拟指纹专家视觉感知的角度设计指纹图像质量评价算法,所得质量评价分数和二维质量空间分布结果更容易被指纹专家所理解和认同,可以作为指纹入库采集的质量衡量参照;FNMR指标分析的结果表明,本文算法对于提高AFIS性能也具有优异表现;本文脱离现有指纹图像质量评价算法设计思路,无需依赖传统特征提取算法,而是利用CNN提取指纹局部纹理的视觉感知特征,进而从局部到整体地完成质量评价。

本文从指纹专家视觉感知指纹图像质量原理的原理出发设计指纹图像质量评价算法,实验表明,该算法无论是指纹图像质量整体评价的分数还是二维质量空间分布均和指纹专家的质量评价一致,且能够有效降低FNMR。不过对于少部分背景复杂的指纹图像,本文ROI区域提取结果存在一定偏差,所以后续会尝试设计更加有效的ROI区域提取算法。此外,我们将进一步关注对现场遗留指纹的质量评定,争取将本文算法改进泛化到用于解决现场遗留指纹的质量评定问题。

| [1] |

Maltoni D, Maio D, Jain A K, et al. Handbook of fingerprint recognition[M]. London: Springer London, 2009. Doi:10.1007/978-1-84882-254-2

|

| [2] |

Jain A K, Ross A, Prabhakar S. An introduction to biometric recognition[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2004, 14(1): 4-20. Doi:10.1109/TCSVT.2003.818349 |

| [3] |

Bolle R M, Pankanti S U, Yao Y S. System and method for determining the quality of fingerprint images: US5963656[P]. 1999-10-05.

|

| [4] |

Shen L L, Kot A, Koo W M. Quality measures of fingerprint images[C]//International Conference on Audio-and Video-Based Biometric Person Authentication. Springer, Berlin, Heidelberg, 2001: 266-271. DOI: 10.1007/3-540-45344-X_39.

|

| [5] |

Tabassi E, Wilson C L, Watson C I. Fingerprint image quality[R]. National Institute of Standards and Technology, 2004. DOI: 10.6028/nist.ir.7151.

|

| [6] |

ANSI. ISO/IEC 29794-1: 2009: Information technology — Biometric sample quality — Part 1: Framework[EB/OL]. (2009-08)[2022-01-22]. https://www.iso.org/standard/43583.html.

|

| [7] |

ANSI. ISO/IEC TR 29794-4: 2010: Information technology — Biometric sample quality — Part 4: Finger image data[EB/OL]. (2010-04)[2022-01-22]. https://www.iso.org/standard/50911.html.

|

| [8] |

ANSI. ISO/IEC 29794-4: 2017: Information technology — Biometric sample quality — Part 4: Finger image data[EB/OL]. (2017-09)[2022-01-22]. https://www.iso.org/standard/62791.html.

|

| [9] |

NIST. Development of NFIQ 2.0[EB/OL]. (2014-04)[2022-01-22]. http://www.nist.gov/itl/iad/ig/development_nfiq_2.cfm.

|

| [10] |

Li X, Wang R X, Li M Q, et al. A hybrid quality estimation algorithm for fingerprint images[C]//Biometric Recognition, 2016: 214-223. DOI: 10.1007/978-3-319-46654-5_24.

|

| [11] |

Richter R, Gottschlich C, Mentch L, et al. Smudge noise for quality estimation of fingerprints and its validation[J]. IEEE Transactions on Information Forensics and Security, 2019, 14(8): 1963-1974. Doi:10.1109/TIFS.2018.2889258 |

| [12] |

Chen C H, An C S, Chen C Y. Fingerprint quality assessment based on texture and geometric features[J]. Journal of Imaging Science and Technology, 2020, 64(4): 40403-1. Doi:10.2352/j.imagingsci.technol.2020.64.4.040403 |

| [13] |

Agarwal D, Bansal A. Assessment of latent fingerprint image quality based on level 1, level 2, and texture features[C]//International Conference on Innovative Computing and Communications, 2021: 489-501. DOI: 10.1007/978-981-15-5113-0_38.

|

| [14] |

Hendre M, Patil S, Abhyankar A. Utility of quality metrics in partial fingerprint recognition[J]. International Journal of Computing and Digital Systems, 2021, 10(1): 839-849. Doi:10.12785/ijcds/100177 |

| [15] |

中华人民共和国公安部. 指纹特征规范第5部分: 指纹细节特征点标志方法: GA 774.5—2008[S]. 北京: 中国标准出版社, 2008.

|

| [16] |

中华人民共和国公安部. 十指指纹图像数据复现动态链接库接口: GA 785—2008[S]. 北京: 中国标准出版社, 2008.

|

| [17] |

中华人民共和国公安部. 居民身份证指纹采集和比对技术规范: GA/T 1012—2019[S]. 北京: 中国标准出版社, 2012.

|

| [18] |

江璐, 赵彤, 吴敏. 基于深度卷积神经网络的指纹纹型分类算法[J]. 中国科学院大学学报, 2016, 33(6): 808-814. Doi:10.7523/j.issn.2095-6134.2016.06.013 |

| [19] |

Qin J, Han C Y, Bai C C, et al. Multi-scaling detection of singular points basedon fully convolutional networks in fingerprint images[C]//Biometric Recognition, 2017: 221-230. DOI: 10.1007/978-3-319-69923-3_24.

|

| [20] |

Li J, Feng J J, Kuo C C J. Deep convolutional neural network for latent fingerprint enhancement[J]. Signal Processing: Image Communication, 2018, 60: 52-63. Doi:10.1016/j.image.2017.08.010 |

| [21] |

Liu Y H, Zhou B C, Han C Y, et al. A method for singular points detection based on faster-RCNN[J]. Applied Sciences, 2018, 8(10): 1853. Doi:10.3390/app8101853 |

| [22] |

Zhou B C, Han C Y, Liu Y H, et al. Fast minutiae extractor using neural network[J]. Pattern Recognition, 2020, 103: 107273. Doi:10.1016/j.patcog.2020.107273 |

| [23] |

Liu Y H, Zhou B C, Han C Y, et al. A novel method based on deep learning for aligned fingerprints matching[J]. Applied Intelligence, 2020, 50(2): 397-416. Doi:10.1007/s10489-019-01530-4 |

| [24] |

He K M, Zhang X Y, Ren S Q, et al. Deep residual learning for image recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition. June 27-30, 2016, Las Vegas, NV, USA. IEEE, 2016: 770-778. DOI: 10.1109/CVPR.2016.90.

|

| [25] |

Huang G, Liu Z, van der Maaten L, et al. Densely connected convolutional networks[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition. July 21-26, 2017, Honolulu, HI, USA. IEEE, 2017: 2261-2269. DOI: 10.1109/CVPR.2017.243.

|

| [26] |

Kingma D P, Ba J. Adam: a method for stochastic optimization[EB/OL]. arXiv: 1412.6980v9[cs. LG]. (2017-01-30)[2022-01-22]. https://arxiv.org/abs/1412.6980.

|

| [27] |

Gonzalez R C, Woods R E. Digital image processing[M]. 2nd ed. New Jersey: Prentice Hall, 2002.

|

| [28] |

Kass M, Witkin A. Analyzing oriented patterns[J]. Computer Vision, Graphics, and Image Processing, 1987, 37(3): 362-385. Doi:10.1016/0734-189X(87)90043-0 |

| [29] |

Otsu N. A threshold selection method from gray-level histograms[J]. IEEE Transactions on Systems, Man, and Cybernetics, 1979, 9(1): 62-66. Doi:10.1109/tsmc.1979.4310076 |

| [30] |

Suzuki S, be K. Topological structural analysis of digitized binary images by border following[J]. Computer Vision, Graphics, and Image Processing, 1985, 30(1): 32-46. Doi:10.1016/0734-189X(85)90016-7 |

| [31] |

Maio D, Maltoni D, Cappelli R, et al. FVC2000: fingerprint verification competition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2002, 24(3): 402-412. Doi:10.1109/34.990140 |

| [32] |

Maio D, Maltoni D, Cappelli R, et al. FVC2002: second fingerprint verification competition[C]//2002 International Conference on Pattern Recognition. August 11-15, 2002, Quebec City, QC, Canada. IEEE, 2002: 811-814. DOI: 10.1109/ICPR.2002.1048144.

|

| [33] |

Watson C I, Garris M D, Tabassi E, et al. User's guide to NIST biometric image software (NBIS)[R]. National Institute of Standards and Technology, 2007. DOI: 10.6028/nist.ir.7392.

|

| [34] |

Watson C I, Wilson C L. NIST special database 4: fingerprint database[R/OL]. National Institute of Standards and Technology (1992-03-17)[2022-01-22]. http://www.informatik.uni-ulm.de/ni/Lehre/SS03/ENIPRAKT/nist_sd4.pdf.

|

2023, Vol. 40

2023, Vol. 40