2. 中国科学院自动化研究所复杂系统管理与控制国家重点实验室, 北京 100190;

3. 中国科学院脑科学与智能技术卓越创新中心, 上海 200031

2. State Key Laboratory of Management and Control for Complex Systems, Institute of Automation, Chinese Academy of Sciences, Beijing 100190, China;

3. Center for Excellence in Brain Science and Intelligence Technology, Chinese Academy of Sciences, Shanghai 200031, China

无人机是一类通过自主程序控制或者利用无线电遥控设备和控制装置操纵的非载人飞机。与载人飞机相比,它具有体积小、造价低、使用方便、对作战环境要求低、战场生存能力较强等特点,且具有自主飞行能力的无人机更适合到危险的环境中执行任务。在军事环境中,无人机越来越多地应用到不同的场景中,比如:情报侦查、定点打击、电子干扰等[1-5]。

然而在当前的研究和实际应用中,缺乏能够在不同战场环境中进行指定目标智能打击的无人机系统,因而这种任务往往由无人机指挥员或者载人飞机执行。这种任务需要飞行员时刻保持高度警觉,同时拥有对不同战场环境的适应能力和快速的反应能力,这对飞行员来说是个巨大的挑战。因此,研究能够在不同战场环境中进行指定目标自主打击的无人机系统是非常必要的。

目标检测是无人机执行自主巡航打击任务过程中最基础的问题之一,其目的是对图像中的物体进行定位并识别出类别[6]。随着深度学习技术的发展,基于深度学习的目标检测算法在标准数据集上取得了明显的进步,但是在真实、开放的环境中,由于光线、背景、视角等因素时刻发生变化,使得训练数据(源域)和测试数据(目标域)分布产生较大差异,导致网络的泛化性能明显下降;同时,在目标域上收集、标注大量用于训练的数据也需消耗大量人力和物力,更遑论在多数军事对抗下,根本无法提前获取大量敌方目标样本。针对上述问题,提出利用一种风格迁移[7]的网络,将数据从源域迁移到目标域,用于网络的学习,从而提高网络的泛化性能。

当无人机进行目标打击时,需要不断下降靠近目标,但是无人机本身的抖动或者外界干扰产生的抖动导致固定在无人机上的相机拍摄的画面会产生巨大的偏移,从而影响下降阶段定位的稳定性。为解决这个问题,提出一种像素补偿的方法进行消抖,提高无人机系统下降阶段定位的稳定。

当下降到一定高度时,目标可能充斥整个相机视野,使得仅仅使用彩色图像信息定位的精度受到较大的影响。因此,提出一种融合深度信息和彩色图像信息的薄弱部位精准定位算法,确保单个模态定位的精度,提高打击的准确性和高效性。同时通过深度信息的判断,保证了对投弹时机的精准把握。

综上,本文设计一种基于无人机平台的自主巡航、检测、定位、打击的系统。通过结合跨域目标检测、相机消抖和薄弱部位定位等模块,所提出的算法有效提高了整个系统的可靠性和稳定性。该系统在实际搭建的环境中进行了充分的测试,能够圆满完成预定的打击任务。

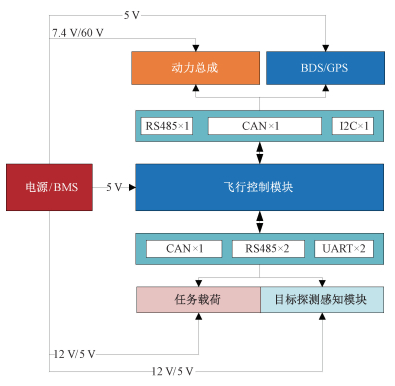

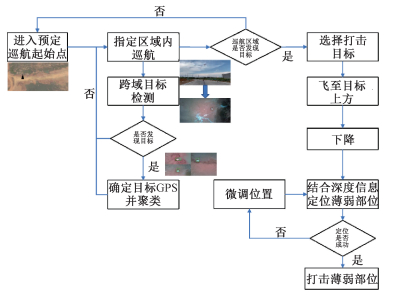

1 系统设计 1.1 系统总体架构本文设计一个基于共轴双旋翼无人机平台的自主巡航打击系统。整个系统由硬件系统和软件系统构成,其中硬件系统如图 1所示。主要的智能感知系统搭载目标探测感知模块上。系统执行任务的总体流程图如图 2所示:首先,无人机到达指定位置,并在指定区域内巡航,同时进行目标检测任务;当巡航完成,若发现目标,则靠近目标并下降打击目标;若未发现目标,则飞抵下一个巡航区域开展相同的任务。

|

Download:

|

| 图 1 无人机平台系统框图 Fig. 1 Block diagram of unmanned aerial vehicle platform system | |

|

Download:

|

| 图 2 系统流程图 Fig. 2 System flowchart | |

针对指定目标打击任务,微小型共轴双旋翼无人飞行器结构紧凑,体积小,灵活性好,隐蔽性强,具备较长时间空中悬停、垂直起降以及多方向飞行的能力,能够在复杂或者狭小环境中飞行,在执行攻击任务时,具有固定翼飞行器无法比拟的优势。因此,本文使用共轴双旋翼无人机平台进行实验。

共轴双旋翼无人飞行平台硬件系统基于小型化、高可靠性、易维修性和易扩展性等原则进行优化设计。硬件系统根据系统结构设计方案进行总体布局,模块间的信号用屏蔽线连接。各主要电路组件采用SMD封装,自发热器件通过有利于电屏蔽和热源隔离,并且提高系统的可维修性,电气总体布局如图 1所示。根据系统要求以及系统结构,硬件系统主要划分为:1)动力总成模块;2)电源/BMS模块;3)飞行控制模块;4)任务载荷模块;5)目标探测感知模块。其中目标探测感知模块是无人系统智能核心,其主要功能是在可见光和弱光情况下,检测并识别既定目标,完成对目标的定位,引导飞行平台瞄准目标薄弱部位,实现对薄弱部位的打击爆破。

1.3 系统软件设计系统软件部分即搭载在目标探测感知模块上的智能感知系统,主要分为3个模块:目标检测模块、下降靠近模块和薄弱部位定位模块。

1.3.1 目标检测模块现代战争包含的实际场景包括城市公路、野外草地、沼泽池塘等复杂多变的情况,直接使用基于深度学习的算法,往往在新环境中无法取得与训练环境中相当的结果。比如,在室内环境中训练的模型在室外环境中的检测效果就会显著下降。因此,本文搭建了一种基于风格迁移的跨域目标检测算法。整个算法包括离线风格迁移网络和目标检测网络2个部分。

该算法使用CUT(contrastive learning for unpaired image-to-image translation)[8]网络模型完成对源域数据的风格迁移。其基于对比学习[9]的方法,目的是使编码器可以专注于源域和目标域之间共性的部分如形状,忽略两个域之间的差异部分如颜色,从而实现对源域数据的风格迁移。

在实际使用过程中,本文直接使用CUT网络在源域和目标域网络上进行训练。训练完成后,将目标域风格迁移到源域数据上,使用目标检测网络进行训练。

基于深度学习的通用目标检测算法主要分为二阶段算法和一阶段算法。其中,二阶段算法首先生成可能包含目标的候选区域,再对候选区域内的目标进行分类,主要包括RCNN[10]、Fast-RCNN[11]、Faster-RCNN[12]等方法。二阶段算法比一阶段算法精度高,但是速度慢。一阶段算法的网络通过学习直接输出包含目标的区域坐标以及类别信息,主要包括YOLO[13]、YOLO9000[14]、YOLOv3[15]、YOLOv4[16]、YOLOv5,SSD[17]、CenterNet[18]等方法。其速度快,但精度略低于二阶段算法。

在无人机上部署算法需要考虑硬件计算能力和功耗的限制,同时需要保证检测的速度和精确率的平衡,本文选用YOLOv5算法作为基础的目标检测算法,并使用蒸馏模型对网络进行压缩。

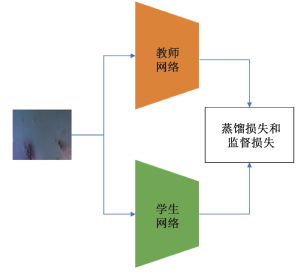

蒸馏,即知识蒸馏,Hinton等[19]在2015年首次提出神经网络中的知识蒸馏技术/概念。这是一个通用而简单的、不同的模型压缩技术。它是将教师网络的知识迁移到学生网络上,使学生网络具备教师网络相当的性能,并且具有更小的模型和更快的速度,便于部署到算力较弱的设备上。无人机平台算力有限,而且为了保持更久地续航,硬件平台所拥有的功率也非常有限,这些都限制了大模型在无人平台上的部署,因此,我们使用更小的模型(YOLOv5s)为基础,并结合蒸馏方法,提高模型的性能和速度。

蒸馏网络结构如图 3所示,首先使用精度更高YOLOv5l作为教师网络在数据集上进行训练,然后使用速度更快的YOLOv5s作为学生网络进行蒸馏训练。其中教师网络在进行蒸馏训练时,权重固定;学生网络的权重由教师网络的权重进行初始化,并且使用随机梯度下降算法进行更新。网络损失函数为

| $\operatorname{Loss}_{\text {obj }}\left(\boldsymbol{o}_i^{\mathrm{gt}}, \boldsymbol{o}_i, \boldsymbol{o}_i^{\mathrm{t}}\right)=f_{\text {obj }}\left(\boldsymbol{o}_i^{\mathrm{gt}}, \boldsymbol{o}_i\right)+\lambda f_{\text {obj }}\left(\boldsymbol{o}_i, \boldsymbol{o}_i^{\mathrm{t}}\right) , $ | (1) |

| $\begin{gathered}\operatorname{Loss}_{\mathrm{cls}}\left(\boldsymbol{p}_i^{\mathrm{gt}}, \boldsymbol{p}_i, \boldsymbol{p}_i^{\mathrm{t}}, \boldsymbol{o}_i^{\mathrm{t}}\right)=f_{\mathrm{cls}}\left(\boldsymbol{p}_i^{\mathrm{gt}}, \boldsymbol{p}_i\right)+ \\ \boldsymbol{o}_i^{\mathrm{t}} \lambda f_{\mathrm{cls}}\left(\boldsymbol{p}_i, \boldsymbol{p}_i^{\mathrm{t}}\right)\end{gathered}, $ | (2) |

| $\begin{gathered}\operatorname{Loss}_{\mathrm{reg}}\left(\boldsymbol{b} \boldsymbol{b}_i^{\mathrm{gt}}, \boldsymbol{b b}_i, \boldsymbol{b} \boldsymbol{b}_i^{\mathrm{t}}, \boldsymbol{o}_i^{\mathrm{t}}\right)=f_{\mathrm{reg}}\left(\boldsymbol{b} \boldsymbol{b}_i^{\mathrm{gt}}, \boldsymbol{b} \boldsymbol{b}_i\right)+ \\ \boldsymbol{o}_i^{\mathrm{t}} \lambda f_{\mathrm{reg}}\left(\boldsymbol{b} \boldsymbol{b}_i, \boldsymbol{b} \boldsymbol{b}_i^{\mathrm{t}}\right) .\end{gathered}$ | (3) |

|

Download:

|

| 图 3 知识蒸馏网络结构 Fig. 3 Knowledge distillation network architecture | |

3个损失函数分别为YOLO的目标损失、分类损失以及回归损失。其中,oigt, oi, oit分别表示第i个位置对应的目标真实标签、学生网络预测值及教师网络预测值;pigt, pi, pit分别表示第i个位置对应的类别标签、学生网络预测值及教师网络预测值;bbigt, bbi, bbit分别表示第i个位置对应的回归标签、学生网络预测值及教师网络预测值。每一行等式右边第1项为网络的原始损失,即学生网络的输出与真实标签的损失;第2项为蒸馏损失,其使用教师网络的输出作为标签,计算学生网络的输出与该标签的损失,其中λ为平衡常数,在实际训练时,设置为0.05。网络的总体损失为3个损失之和。

| $\begin{gathered}\operatorname{Loss}=\operatorname{Loss}_{\mathrm{obj}}\left(\boldsymbol{o}_i^{\mathrm{gt}}, \boldsymbol{o}_i, \boldsymbol{o}_i^{\mathrm{t}}\right)+\operatorname{Loss}_{\mathrm{cls}}\left(\boldsymbol{p}_i^{\mathrm{gt}}, \boldsymbol{p}_i, \boldsymbol{p}_i^{\mathrm{t}}, \boldsymbol{o}_i^{\mathrm{t}}\right)+ \\ \operatorname{Loss}_{\mathrm{reg}}\left(\boldsymbol{b} \boldsymbol{b}_i^{\mathrm{gt}}, \boldsymbol{b} \boldsymbol{b}_i, \boldsymbol{b} \boldsymbol{b}_i^{\mathrm{t}}, \boldsymbol{o}_i^{\mathrm{t}}\right) .\end{gathered}$ | (4) |

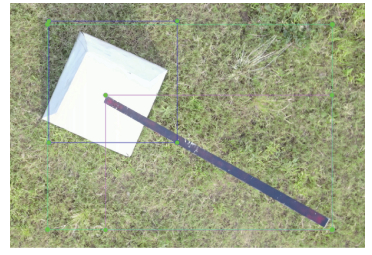

为提高目标检测算法对于遮挡物体检测的效果,本文在数据标注时将每个目标都标注为N+1个类,即局部1,局部2…局部N以及整体。前向推理时,通过投票的方法确定是否检测到正确的目标,提高检测的稳定性(如图 4)。

|

Download:

|

| 图 4 标注样例 Fig. 4 Annotated examples | |

当检出目标时,为实现对目标的精准定位和打击,需要知道高精度的目标GPS坐标,但是单次计算目标的GPS会产生较大的误差,因此,使用一种GPS在线聚类的算法提高定位的精度,其通过记录历史GPS坐标进行聚类,以减少单次计算误差。

1.3.2 下降迫近模块在下降阶段,由于外界干扰或者无人机本身飞行时产生的抖动会使相邻帧中相同目标的像素坐标发生较大的漂移,影响定位的稳定性。因此,本文使用基于像素补偿的防抖算法和跟踪算法提高定位的稳定性。

像素补偿防抖算法具体流程如下:首先根据无人机的姿态,即俯仰角、横滚角和方位角,计算出相机光轴与初始位置(即竖直向下)的夹角θ;其次将成像平面旋转θ,使得相机光轴与初始位置重合;最后对旋转后的图片进行裁剪和填补,再送入检测跟踪算法,进行目标识别和定位。

单次下降需要稳定地跟随同一个目标进行下降,此时需要跟踪器进行稳定的定位,但是仅仅使用跟踪器会出现错跟和漏跟的情况,将会严重影响到跟踪的效果。将跟踪器和检测器叠加使用,以减少漏检和误检情况,提高系统的稳定性,具体流程见算法1。

算法1视觉防抖跟踪与鲁棒定位

输入:彩色图像I,未检测到目标次数n,未检测到目标次数阈值N

1. dets=Detector(I), track=Tracker(I).

2. if dets=Ø and track! =Ø then

3. n=n+1.

4. if n≥N then

5. Stop(Tracker).

6. else

7. bb=track.

8. end if

9. end if

10. if dets=Ø and track=Ø then

11. n=n+1.

12. if n≥N then

13. Stop(Tracker).

14. end if

15. bb=None.

16. end if

17. if dets! =Ø and track! =Ø then

18. if maxIoU (dets, track)=0 then

19. n=n+1.

20. end if

21. bb=track.

22. end if

23. if dets! =Ø and track=Ø then

24. Init(Tracker).

25. bb=Select(dets).

26. end if

输出:bb

通过深度相机可以获取的深度图像包含了视野中物体的深度(距离)信息,而目标一般要高于其周围物体,因此利用这些深度信息同样有助于目标的检测以及薄弱部位定位任务。图 5所示是两幅包含目标的深度图像数据(添加伪彩色),分别表示陆地和水域两种环境下获取的数据。图像中每个点的像素值代表此处的距离信息,颜色越接近蓝色表示距离相机拍摄位置越近,而越接近红色表示距离越远。分析图像可知,目标的深度特征较明显,但同样存在较大的噪声,且当在水域环境下,噪声程度会极剧增加。

|

Download:

|

| 图 5 深度图像数据实例 Fig. 5 Examples of depth images | |

基于上述分析,本文将基于深度图像的目标检测及薄弱位置定位问题的求解过程总结为如下几个步骤:1)图像预处理;2)目标提取;3)薄弱位置定位。图像预处理主要用于消除噪声,一种简单有效的方法是通过深度相机测距的有效范围进行噪声去除。例如,深度相机测距有效范围为0.5~10 m,则将深度数据中大于等于10 m及小于0.5 m的数据视为噪声去除,噪声处像素可重新赋值为非噪声像素的均值。

目标提取主要完成前景与背景的分割,本文采用图像处理中的二值化技术对深度图像进行分割提取前景,二值化的阈值通过二分查找获得。具体过程如算法2。算法输入深度图像以及估算的目标在图像中的大小,其中可通过相机内参以及目标实际大小计算得到。算法2步骤1~2估算图像中的最大最小值,分别作为二分查找的上限和下限;步骤4~18为二分查找的具体过程,查找过程中保存分割后前景面积最接近的二值化结果,当前景面积和足够接近或当查找的上限下限足够接近时停止。

算法2深度图像二值化

输入: 预处理后的深度图像I, 目标在图像中的预估面积a(通过相机内参估算)

1. A=AvgPool(I, kernel=k, step=k).

2. u=min(A), v=max(A).

3. B=0.

4. while true

5. t=(u+v)/2.

6. T=I>t.

7. if abs (sum(T)-a) <

8. break.

9. end if

10. if abs(sum(T)-a) < abs(sum(B)-a)then

11. B=T.

12. end if

13. if sum(T)>a then

14. v=t.

15. else

16. u=t.

17. end if

18. end while

输出:B

通过算法2获取二值化图像B后,二值图像中前景很可能并非目标,因此还需对目标做进一步判别。具体地,首先获取二值图像中的连通域,对各连通域分别进行判别,判别方法包括但不仅限于面积分析、轮廓分析、形状分析及神经网络等。面积分析即去除面积过小或过大的区域;轮廓分析即目标的轮廓长度与其外接旋转矩形框的周长相近;形状分析主要通过包含2个子分布的混合高斯模型估计前景分布,并由此计算2个分布的长短轴比例,长短轴两侧目标中像素坐标分布的对称性等;神经网络方法主要用于对前景所在区域的原始深度图像提取特征并分类。

目标薄弱位置定位主要通过计算二值图像连通域质心获取。但受桩柱的影响,质心会偏离薄弱部位而偏向桩柱一侧(如图 6实心圆所示)。为消除这种偏移,可先求解目标连通域外界矩形框(图 6虚线矩形框),然后通过目标区域深度信息选择矩形框接近基座的短边,并求解其中心位置,薄弱位置即处于质心与该中心位置连线的中点处(实心矩形)。

|

Download:

|

| 图 6 薄弱位置定位示意图 Fig. 6 Schematic diagram of weak location positioning | |

实验采用在2个不同的场景,不同天气情况(比如晴天、阴天),光照条件下采集到的数据进行跨域目标检测的验证。训练数据包括739张在郊区土地场景下尺寸为1 280×720的彩色图像,共包括3 621个实例,分为“局部1”,“局部2”和“整体”3类。测试数据采用485张池塘场景下尺寸为1 280×720的彩色图像,包括1 245个样例(部分样例如图 7所示)。

|

Download:

|

| 图 7 训练图像与测试图像 Fig. 7 Training images and testing images | |

对于薄弱位置定位算法的测试,共选取1 250张距离目标高度在0.4~5 m高度不等,水边陆地不同场景的尺寸为1 280×720的深度数据。

除在静态数据集上的测试,我们也在实际情况下进行了测试。实际测试是在4个不同场景下进行的(如图 8所示),同一个场景也包含不同的天气条件如晴天阴天,不同的光线条件如强光弱光,以及场景中出现不同的干扰,如制造假的目标、车辆干扰、行人干扰等等。

|

Download:

|

| 图 8 测试场景 Fig. 8 Testing scenarios | |

目标探测感知模块由于飞行平台重量和体积的限制,其由嵌入式AI计算平台NVIDIA Jetson TX2和深度相机Intel RealSense D455构成。其中NVIDIA Jetson TX2配备NVIDIA Pascal GPU,具有8 GB内存和256个计算核心,可以实现快速的深度学习计算和推理;Intel RealSense D455相机具备RGB传感器和深度传感器,RGB传感器可以为无人机提供1 280×720的彩色图片,为目标检测模型提供高清有效的输入数据;深度传感器在0.4~6 m范围内可以提供高精度的深度数据,可为实现对目标的薄弱位置高精度定位提供有效的支持。

目标检测与蒸馏算法的具体参数信息如表 1所示。

|

|

表 1 算法参数表 Table 1 Algorithm parameters |

目标检测模块的训练中,使用4张显存大小是11 GB的NVIDIA Geforce 2080Ti显卡训练,并在无人机平台上进行测试。在训练过程中,采用带有Nesterov动量的SGD训练网络,初始学习率初始化设置为0.01,权值衰减设置为0.000 5,动量系数设置为0.937,batch size设置为64,最大迭代次数设置为300轮,并用余弦退火训练的前3轮。网络的输入图像大小为640×640,并采用随机上下翻转、左右翻转、颜色增强、随机mixup和mosaic操作对数据进行增广。蒸馏训练时,设置平衡常数λ为0.05。

视觉防抖跟踪与鲁棒定位算法中,将未检测到目标次数阈值N设置为5。

深度图像二值化算法中,经过池化后图片大小为640×360,均匀池化中卷积核大小为2,步长2,其中

对于目标检测算法,采用的评价指标为查准率P (precision),以及在不同IoU(intersection over union)阈值下的平均类别精确率(mean average precision, mAP)和召回率R(recall)。

对于薄弱位置定位算法的评估,使用传统的Niblack[20]、Otsu[21]、Sauvola[22]进行对比,采用像素的平均绝对误差(mean absolute error,MAE)和平均计算所需时间作为评价指标。

2.4 实验结果目标检测的实验结果如表 2所示,由表中可以看出,使用CUT风格迁移网络进行数据增广可以极大地提高网络在测试数据集上的性能(mAP@0.50从12 % 提高到41 %),从而使网络具备在不同环境下的检测能力;通过知识蒸馏,可在保持NVIDIA Jetson TX2上实现平均42 ms/帧处理速度的前提下,进一步提高模型的性能(mAP@0.50从41 % 提高至43 %)。并且在实际搭建的硬件平台上,在实际的不同光照条件和随机增加一些外界干扰的场景中测试可以高效地模拟完整的爆破流程。

|

|

表 2 目标检测结果 Table 2 Results of object detection |

将薄弱位置定位算法,分别与Niblack算法、Otsu算法和Sauvola算法进行对比,实际对比结果如图 9所示,可以很明显地看出本文所提出的算法分割的效果优于其他3种算法。

|

Download:

|

| 图 9 分割结果 Fig. 9 Segmentation results | |

如表 3所示,在定量结果上,本文提出的算法显然优于对比的3种方法,其中“--”表示根据分割结果和计算薄弱位置的规则,无法获得薄弱位置的像素坐标。本文提出的算法在测试数据上取得平均绝对误差为34.6个像素的结果,远远优于Otsu的337.4和Sauvola的131.8;在计算速度上,所提出的算法在硬件平台上可以达到10.3 ms/帧的速度,也远远优于对比的3种算法。2个指标都证明了提出的分割算法的有效性。

|

|

表 3 语义分割结果 Table 3 Results of object segmentation |

同时,在实际不同场景下的测试也较好地完成了整个任务流程,最终正确下降至距离薄弱位置。

3 结论本文提出一种基于无人机平台的目标检测、下降靠近及薄弱部位定位的系统架构。该系统使用风格迁移模型将源域数据迁移至目标域,提高模型在目标域的性能,并通过知识蒸馏在保持模型推理速度的前提下,提高模型的检测性能;下降过程中,将检测结果和跟踪结果融合判断,提高对目标定位的准确率和鲁棒性;最后使用基于图像分割的薄弱部位定位算法,进一步提高系统对目标薄弱位置的精准定位,提高爆破的准确性和有效性。并通过在实际采集的数据上进行测试,验证了本文提出系统的可行性和有效性。

| [1] |

Zhao J H, Xiao G, Zhang X C, et al. A survey on object tracking in aerial surveillance[C]//Proceedings of International Conference on Aerospace System Science and Engineering 2018, 2019: 53-68. DOI: 10.1007/978-981-13-6061-9_4.

|

| [2] |

Vanegas F, Campbell D, Roy N, et al. UAV tracking and following a ground target under motion and localisation uncertainty[C]//2017 IEEE Aerospace Conference. March 4-11, 2017, Big Sky, MT, USA. IEEE, 2017: 1-10. DOI: 10.1109/AERO.2017.7943775.

|

| [3] |

Tijtgat N, Van Ranst W, Volckaert B, et al. Embedded real-time object detection for a UAV warning system[C]//2017 IEEE International Conference on Computer Vision Workshops. October 22-29, 2017, Venice, Italy. IEEE, 2017: 2110-2118. DOI: 10.1109/ICCVW.2017.247.

|

| [4] |

Du D W, Qi Y K, Yu H Y, et al. The unmanned aerial vehicle benchmark: Object detection and tracking[M]. Cham: Springer International Publishing, 2018: 375-391. Doi:10.1007/978-3-030-01249-6_23

|

| [5] |

Mittal P, Singh R, Sharma A. Deep learning-based object detection in low-altitude UAV datasets: a survey[J]. Image and Vision Computing, 2020, 104: 104046. Doi:10.1016/j.imavis.2020.104046 |

| [6] |

Zou Z X, Shi Z W, Guo Y H, et al. Object detection in 20 years: A survey[EB/OL]. arXiv: 1905.05055. (2019-05-16)[2021-11-01]. https://arxiv.org/abs/1905.05055v1.

|

| [7] |

Parmar N, Vaswani A, Uszkoreit J, et al. Image transformer[EB/OL]. arXiv: 1802.05751. (2018-02-15)[2021-11-01]. https://arxiv.org/abs/1802.05751.

|

| [8] |

Park T, Efros A A, Zhang R, et al. Contrastive learning for unpaired image-to-image translation[C]//Computer Vision - ECCV 2020, 2020: 319-345. DOI: 10.1007/978-3-030-58545-7_19.

|

| [9] |

Chen T, Kornblith S, Norouzi M, et al. A simple framework for contrastive learning of visual representations[EB/OL]. arXiv: 2002.05709. (2020-02-13)[2021-11-01]. https://arxiv.org/abs/2002.05709.

|

| [10] |

Girshick R, Donahue J, Darrell T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]//2014 IEEE Conference on Computer Vision and Pattern Recognition. June 23-28, 2014, Columbus, OH, USA. IEEE, 2014: 580-587. DOI: 10.1109/CVPR.2014.81.

|

| [11] |

Girshick R. Fast R-CNN[C]//2015 IEEE International Conference on Computer Vision. December 7-13, 2015, Santiago, Chile. IEEE, 2015: 1440-1448. DOI: 10.1109/ICCV.2015.169.

|

| [12] |

Ren S Q, He K M, Girshick R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149. Doi:10.1109/TPAMI.2016.2577031 |

| [13] |

Redmon J, Divvala S, Girshick R, et al. You only look once: unified, real-time object detection[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition. June 27-30, 2016, Las Vegas, NV, USA. IEEE, 2016: 779-788. DOI: 10.1109/CVPR.2016.91.

|

| [14] |

Redmon J, Farhadi A. YOLO9000: better, faster, stronger[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition. July 21-26, 2017, Honolulu, HI, USA. IEEE, 2017: 6517-6525. DOI: 10.1109/CVPR.2017.690.

|

| [15] |

Redmon J, Farhadi A. YOLOv3: an incremental improvement[EB/OL]. arXiv: 1804.02767. (2018-04-08)[2021-11-01]. https://arxiv.org/abs/1804.02767v1.

|

| [16] |

Bochkovskiy A, Wang C Y, Liao H Y M. YOLOv4: optimal speed and accuracy of object detection[EB/OL]. arXiv: 2004.10934. (2020-04-23)[2021-11-01]. https://arxiv.org/abs/2004.10934v1.

|

| [17] |

Liu W, Anguelov D, Erhan D, et al. SSD: single shot MultiBox detector[C]//Computer Vision - ECCV 2016, 2016: 21-37. DOI: 10.1007/978-3-319-46448-0_2.

|

| [18] |

Duan K W, Bai S, Xie L X, et al. CenterNet: keypoint triplets for object detection[C]//2019 IEEE/CVF International Conference on Computer Vision (ICCV). October 27-November 2, 2019, Seoul, Korea (South). IEEE, 2019: 6568-6577. DOI: 10.1109/ICCV.2019.00667.

|

| [19] |

Hinton G E, Vinyals O, Dean J. Distilling the knowledge in a neural network[J]. IEICE Transactions on Fundamentals of Electronics, Communications and Computer Sciences, 2015, abs/1503.02531.

|

| [20] |

McKinley G A. An introduction to digital image processing[J]. Clinical Microbiology Newsletter, 1990, 12(12): 89-92. Doi:10.1016/0196-4399(90)90015-4 |

| [21] |

Otsu N. A threshold selection method from gray-level histograms[J]. IEEE Transactions on Systems, Man, and Cybernetics, 1979, 9(1): 62-66. Doi:10.1109/TSMC.1979.4310076 |

| [22] |

Sauvola J, Pietikäinen M. Adaptive document image binarization[J]. Pattern Recognition, 2000, 33(2): 225-236. Doi:10.1016/S0031-3203(99)00055-2 |

2023, Vol. 40

2023, Vol. 40