2. 中国科学院大学,北京 100049;

3. 天津市城市规划设计研究总院有限公司 天津市智慧城市规划企业重点实验室,天津 300000

2. University of Chinese Academy of Sciences, Beijing 100049, China;

3. Key Enterprises Laboratory of Smart City Planning of Tianjin, Tianjin Urban Planning and Design Institute Co., Ltd, Tianjin 300000, China

特定建筑物或场所的识别在智慧城市规划、土地利用分析及平安城市建设中具有重要意义[1]。传统测绘手段虽然准确度高,但费时费力,更新周期长,不能满足快速更新和变化的城市建设需求。随着传感器和航空航天技术的飞速发展,遥感技术可以在短时间内获得地物详细的信息,使得识别特定建筑物或场所成为可能。基于遥感影像的学校场所目标提取较复杂,当前,学校场所识别的研究重心往往放在操场的识别上,部分研究利用边缘检测的方法,如黄海涛和柯长青[2]通过改进霍夫变换实现操场跑道圆弧形边缘的提取,并基于提取结果识别出操场直线边缘,细化后完成操场跑道的检测。部分研究利用卷积神经网络实现操场的自动提取,如普恒[3]在Mask R-CNN基础上,通过对内部层的改进实现操场、建筑及水体的高精度识别,达到91.33%的准确率。然而,学校场所的识别不完全等同于操场的识别,一方面是因为操场的识别包含体育场馆等其他非学校类型场所,另一方面不同学校操场的规模并不一致,在农村地区的一些幼儿园、小学等学校场所甚至没有规则的操场作为识别标识。一般来说,学校场所往往由形状、数量和空间分布各异的多栋建筑物及规模不等的空间场地构成,难以从几何特征的角度抽象出学校场所的统一规律。但在新疆地区为发展教育事业,由政府主导统一规划为乡镇村各级行政区域兴建了各类幼儿园、中小学教育场所,这些场所的形态、位置及其与周边地物的关系往往具有特定的规律性,使得基于空间信息识别这些学校场所成为可能。

卷积神经网络(convolutional neural networks,CNN)具有较强的空间结构信息挖掘能力,其自动学习的机制减少了目标识别过程中的人工干预。因此,CNN被广泛用于遥感图像中的目标识别[4-6]。目前,用于目标识别的主流CNN有两种类型:基于区域的CNN和基于回归的CNN。基于区域的CNN是两步网络,分步式的学习策略使这类网络的识别准确率很高,但很耗时,难以实时处理大量遥感影像。这类网络的经典代表有R-CNN[7]、Fast R-CNN[8]、Faster R-CNN[9]和Mask R-CNN[10]。基于回归的CNN是一步式网络,它将整个预测过程视为一个回归过程,流程的简化带来了速度的提高。YOLO(you only look once)[11]系列网络是典型的基于回归的CNN,例如YOLO、YOLOv2[12]、YOLO9000[12]和YOLOv3[13]等,其中,YOLOv3在速度和精度之间取得了较好的平衡[14],可以满足实时应用的需求。

YOLOv3因其实用性而被广泛应用于遥感图像中各种目标的识别。余东行等[15]通过将YOLOv3、显著性检测和连通区提取相结合,对遥感影像中的机场进行了快速准确的识别。Ma等[16]利用改进的YOLOv3实现了震后高分辨率遥感影像倒塌建筑物的高精度识别。陈连凯等[17]通过改进的YOLOv3实现了复杂水面环境下的船舶目标识别。同时,这些研究也发现YOLOv3具有召回率低和边框回归不准确的问题。因此,YOLOv3的学习能力和预测框回归方法有待进一步改进。另外,由于实际应用中硬件条件的限制,对改进后网络的参数复杂度进行控制也是必不可少的。

本文基于YOLOv3开发了一种名为YOLO-S-CIoU的新型CNN模型(YOLO、S和CIoU分别指YOLOv3、SRXnet和CIoU损失),用于遥感影像中学校场所的目标提取。首先,通过重复SE-ResNeXt[18]构建SRXnet;然后,将YOLOv3中的特征提取网络——Darknet53替换为SRXnet,以显著提升YOLO-S-CIoU的特征学习能力,同时保持与YOLOv3相似的复杂度;最后,利用complete-IoU loss[19](CIoU loss)实现边界框更好的回归。

1 数据集 1.1 遥感影像以新疆维吾尔自治区图木舒克市为示范研究区。为得到有代表性的学校场所数据集(school sample dataset, 简称SS数据集),以覆盖新疆维吾尔自治区喀什地区12个县市的1 200余景航空、航天遥感影像作为主要数据源(分辨率约0.5 m,见图 1)。对于部分质量较差的影像,辅以高质量谷歌地图影像(分辨率约0.45 m)。此外,还获取了覆盖图木舒克市部分区域的Worldview数据以及覆盖山东省烟台市部分地区的谷歌地图 18级影像(分辨率约0.45 m)以测试模型识别效果和泛化性能。

|

Download:

|

| 图 1 遥感影像缩略图 Fig. 1 Remote sensing image thumbnail | |

结合已有的遥感影像和兴趣点(point of interest,PoI)数据制作包含学校场所数据的SS数据集,其包含616张416×416的学校场所图片,绝大部分图片仅包含一个目标。SS数据集的制作过程除参考PoI数据外,还充分考虑了目标地物在遥感影像上的识别标志。因此在制作学校场所数据之前,对新疆地区的学校场所形态做了广泛调研,并得到以下几点共性:1)除幼儿园外,几乎所有的小学、中学及大学等都有操场,虽然操场材质不尽相同,但都具有极相似的跑道形状(如图 2(a)、2(b));2)除学校外,其他场所几乎不含带跑道的操场;3)部分学校场所分布呈U形(如图 2(b)、2(c)、2(d));4)大部分学校场所的园艺呈现对称的特点;5)大多数幼儿园由一正面呈近似S形的建筑构成(如图 2(c)、2(d))。SS数据集的制作过程严格控制数据质量。被树木、阴影遮挡,以及拍摄环境造成的影像质量较差的目标地物均未被采集到数据集中,以避免对地物特点造成干扰,影响后续模型质量。

|

Download:

|

| 图 2 SS数据集学校场所数据示例(蓝框为标注框) Fig. 2 School examples of SS dataset (the blue boxes are the label boxes) | |

由于喀什地区的学校场所数量有限,且SS数据集并未收集质量较差的影像。因此SS数据集在数量规模上相对较小,多样性也较为缺失,难以满足卷积神经网络的训练需要。此外,由于受光照、拍摄角度、拍摄时间等一系列因素的影响,不同遥感影像的色调等存在差异。为增加数据多样性,避免模型过度拟合,采取裁剪、旋转、翻转、增加噪声、颜色变换等扩展方式[20]对SS数据集进行处理,扩展后的数据情况见表 1。

|

|

表 1 扩展后的数据详情 Table 1 Details of data after data expansion |

YOLOv3是YOLO系列中比较经典的网络,因其速度快、精度高被广泛应用于各类目标识别任务中。作为第3代YOLO,YOLOv3不仅继承了前两代YOLO的众多特点,还引入了几项新的创新。主要有3个方面:改进特征提取网络、引入多尺度特征识别以及在分类器中使用Logistic。

YOLOv3的主体可以分解为两部分:特征提取网络和多尺度预测网络。与YOLOv2不同,YOLOv3使用更深的Darknet53作为特征提取网络,性能由此得到巨大改善。此外,YOLOv3用5个步长为2的卷积代替池化实现5次下采样获得在13×13尺度上的预测,并采用类似特征金字塔网络(feature pyramid networks, FPN)的上采样方法实现2次上采样并结合融合策略得到26×26及52×52尺度的预测,实现粗细特征的融合。最后,YOLOv3使用Logistic预测对象类别。YOLOv3不仅可以支持多标签对象,而且极大地减少了计算量。但许多实践证明YOLOv3存在召回率低及边框回归不准确的问题。

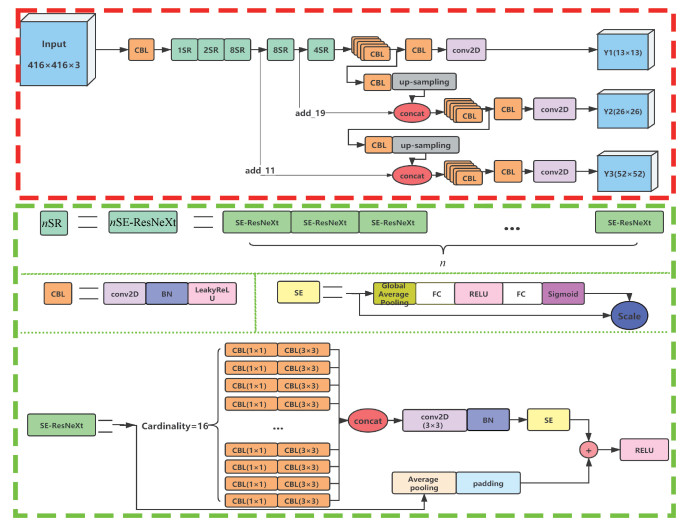

针对YOLOv3召回率低的问题,本文使用SRXnet代替Darknet53得到改进的YOLO-S-CIoU模型。SRXnet(其中SRX来自SE-ResNeXt,net表示网络)是文中新提出的一个网络,它由5组n值分别为1、2、8、8和4的nSR模块组成。nSR模块由n个SE-ResNeXt叠加形成,这使得SRXnet既保持了较大深度,同时也增加了基数维度。SE-ResNeXt主要由16组权值相同的变换组成,每个变换由2个CBL结构构成。CBL是模型中使用最频繁的基本组件,含1个卷积层(convolutional)、1个批处理规范化层(batch normalization,BN)[21]和1个LeakyReLU激活层。此外,在每个SE-ResNeXt的末尾都添加了SEnet(squeeze-and-excitation net),以确保从当前SE-ResNeXt学到的优势特征优先应用于下一个SE-ResNeXt的学习过程。SEnet的加入也可以抑制一些无用特征对学习的干扰。最后,在SE-ResNeXt中,仍使用跳层连接策略以防止反向传播中的梯度问题。YOLO-S-CIoU的详细结构如图 3所示,红色虚线框中的部分代表YOLO-S-CIoU的整体结构;绿色虚线框中的部分代表YOLO-S-CIoU的4个子结构。相同颜色的模块表示相同的操作,concat表示级联操作。

|

Download:

|

| 图 3 YOLO-S-CIoU的结构 Fig. 3 Structure of the YOLO-S-CIoU | |

针对YOLOv3边框回归不准的问题,YOLO-S-CIoU中的损失函数也进行了改进。在YOLOv3中,预测框通过交并比(intersection over union,IoU)回归得到,但IoU只考虑了预测框和真值框之间的重叠面积,当这两个框不相交或者包含时IoU无法提供优化方向。GIoU[22](generalized intersection over union)在IoU的基础上考虑了两框的最小外接矩形,较好地解决了两框不相交时的优化问题。但GIoU主要通过不断增大预测框解决这一问题,在预测框与真值框相交后就退化为IoU。因此也不可避免地存在IoU无法精确反映重叠关系以及两框包含无法优化的问题。DIoU(distance-IoU loss)从最小化两框之间的距离出发, 不仅解决了IoU和GIoU的问题,而且极大地提高了回归速度。DIoU的计算公式如下

| $ \mathrm{DIoU}=1-\mathrm{IoU}+\frac{l\left(O_{\mathrm{p}}, O_{\mathrm{t}}\right)^2}{C^2}, $ | (1) |

其中:Op和Ot分别表示预测框和真值框的中心点,l表示两框中心点之间的欧式距离,c表示两框最小外接矩形对角线之间的距离。DIoU可以很好地指导预测框的回归,但当预测框和真值框中心重合后就无法继续提供优化方向。CIoU(complete-IoU loss)将对形状的惩罚项考虑在内,实现了更加全面的优化。CIoU的计算公式如下

| $ \mathrm{CIoU}=1-\mathrm{IoU}+\frac{l\left(O_{\mathrm{P}}, O_{\mathrm{t}}\right)^2}{c^2}+\alpha \times v, $ | (2) |

其中:α是平衡比例的系数,υ用于衡量预测框与真值框之间的比例一致性,计算公式如下

| $ v=\frac{4}{\pi^2}\left(\arctan \frac{w_{\mathrm{t}}}{h_{\mathrm{t}}}-\arctan \frac{w_{\mathrm{p}}}{h_{\mathrm{p}}}\right)^2, $ | (3) |

| $ \alpha=\frac{v}{(1-\mathrm{IoU})+v} \text {, } $ | (4) |

其中:wt, ht为真值框的长宽;wp, hp为预测框的长宽。已有研究表明,回归损失可以直接作为YOLOv3的位置损失,从而取代通过二值交叉熵以及均方根误差计算得到的XY损失和WH损失。YOLO-S-CIoU最后的损失函数如下

| $ \text { CIoU_LOSS }=\text { Confidence }(2-w \times h)(1-\text { CIoU }) \text {. } $ | (5) |

实验在一台配置为RTX2080Ti显卡(运行内存11 GB),i9-9900k处理器的windows10操作系统上进行。采用tensorflow和keras作为框架。采用adam优化器,批处理量为8,初始学习率为10-3;当验证损失在20期次(每期次指所有训练图像前向传播一次)内不变时, 学习率下降为1/10,直到变为10-6;当达到500期次或损失在50期次内不变时,训练停止。

3.2 实验评估指标为准确反映模型改进前后的性能,采用精确度(precision,P)、召回率(recall, R)[23]、F1分数和AP(average precision,AP)[24]等4个指标对模型进行评估。

混淆矩阵,也称为误差矩阵,是由4个一级指标组成的矩阵。这4项指标分别为假阴性(false negative, FN)、假阳性(false positive, FP)、真阴性(true negative, TN)和真阳性(true positive, TP),依次表示模型划分为负的正目标、模型划分为正的负目标、模型划分为负的负目标和模型划分为正的正目标。这4个指标是基础指标,难以全面反映模型的综合性能。基于这4个基本统计值,可生成R和P。其中:P指在所有系统判定为“真”的样本中,确实是“真”的占比, R指在所有确实为“真”的样本中,被判别为“真”的占比。F1分数的数值越大代表模型的性能就越好。计算公式如下

| $ P=\frac{T_{\mathrm{p}}}{T_{\mathrm{P}}+F_{\mathrm{P}}}, $ | (6) |

| $ R=\frac{T_{\mathrm{P}}}{T_{\mathrm{P}}+F_{\mathrm{N}}}, $ | (7) |

| $ F_1=\frac{2 \cdot P \cdot R}{P+R}, $ | (8) |

AP是目标识别任务中评估模型性能最常用的指标。当存在多个类别时,可以进一步使用mAP(mean average precision)对模型进行更准确的评估。

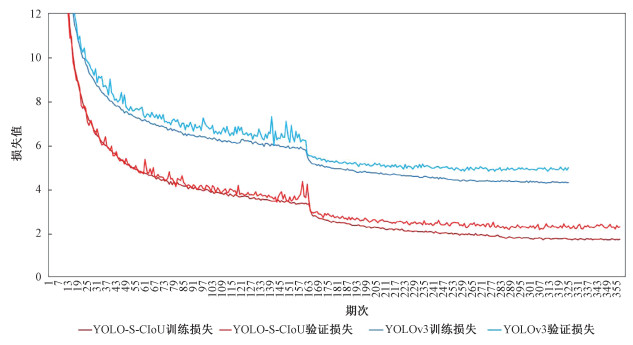

3.3 模型训练及测试为探究模型效果,利用SS数据集训练并测试了原始YOLOv3和YOLO-S-CIoU。图 4展示了2个模型的训练和验证损失曲线。为方便比较,采用相近色调表征同一个模型,但验证损失曲线更加鲜亮。可以看出2个模型的训练和验证损失曲线都是合理的,表明这2个模型在数据集上都表现良好;且都随着期次的增加逐步收敛。同时表 2给出改进前后2个模型的P、R、F1分数、AP及参数量等指标。可以看出YOLO-S-CIoU的AP、F1和参数量分别为96.46%、96.5%和226 MB。相比YOLOv3,YOLO-S-CIoU的AP提升2.3%,F1提升0.5%,参数量减少9 MB,实现了在不增加模型参数量的同时提升模型识别性能。

|

Download:

|

| 图 4 模型改进前后的损失曲线 Fig. 4 Loss curves of the two models before and after improvement | |

|

|

表 2 2个模型的指标评估 Table 2 Index evaluation of the two models |

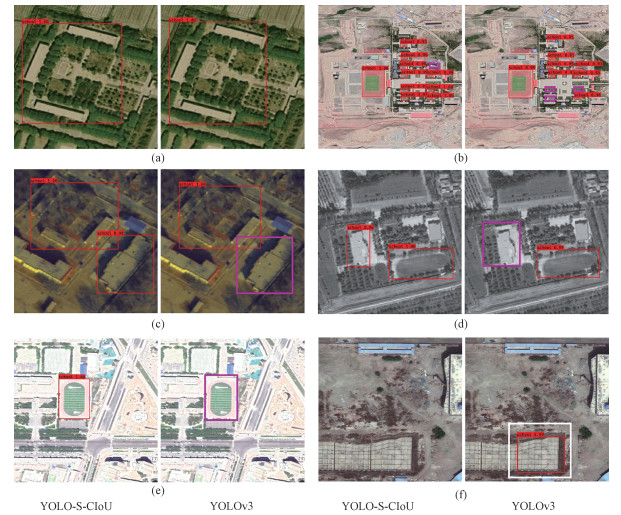

为评估模型改进前后对图片的识别效果,文中选取了6张包含学校场所的416×416的小图片对YOLOv3和YOLO-S-CIoU进行识别。图 5展示2个模型在学校场所识别中的效果,红色框为模型预测框,紫色框标注漏检目标,白色框标注错检目标。通过对比2个模型对同一张图片的识别效果可以看出,对于一些特征明显的学校场所(图 5(a)),2个模型都可以实现精确识别。但当图片质量较差或有多个学校场所元素(图 5(b)~5(e))时,YOLO-S-CIoU识别更加准确。此外,YOLOv3还存在严重的误检现象(图 5(f)),而YOLO-S-CIoU很好地避免了这些问题。这表明YOLO-S-CIoU具有更强的鲁棒性,对不同质量的图像具有更强的识别能力和更高的精度。

|

Download:

|

| 图 5 YOLOv3和YOLO-S-CIoU对学校场所的识别结果 Fig. 5 Identification results of schools using YOLOv3 and YOLO-S-CIoU | |

相对于416×416的图片,遥感影像具有更加复杂的背景及更多干扰,因此对识别模型的要求更高。为测试模型改进前后对遥感影像的识别效果,本文利用覆盖新疆维吾尔自治区图木舒克市部分区域的Worldview(分辨率为0.5 m)数据对2个模型进行测试,结果见图 6。其中黄色框为地物真实位置,红色框为模型预测输出结果,蓝色框表示被正确检测的目标(TP), 白色框表示被错检的目标(FN), 紫色框表示被漏检的目标(FP)。将图 6(b)、6(c)与6(a)对比可得,虽然YOLO-S-CIoU在面对更加复杂的遥感影像时也出现了一定程度的错检和漏检现象,但错误现象明显轻于YOLOv3,且可以完成一半以上目标的正确识别。这充分证明相对原始YOLOv3,YOLO-S-CIoU更能胜任遥感影像上学校场所的识别任务。

|

Download:

|

| 图 6 图木舒克市学校场所的识别结果示例 Fig. 6 Examples of school identification results of Tumshuk City | |

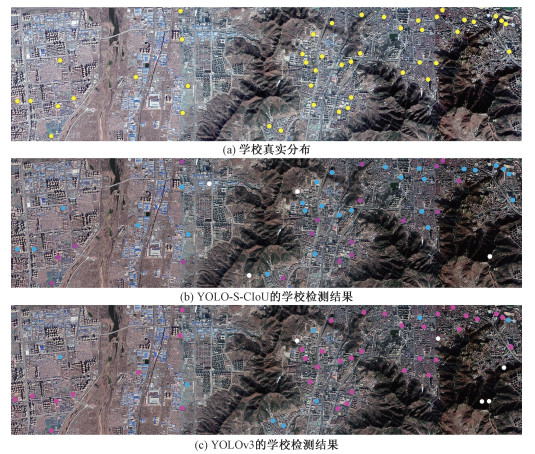

图木舒克市的遥感数据虽然未参与模型训练,但图木舒克市在地理位置上与训练数据的数据源位置(喀什地区)邻近。为进一步测试模型的鲁棒性和普适性,又利用山东省烟台市的18级谷歌影像测试模型识别效果,识别结果见图 7。其中黄色点为地物真实位置,蓝色点表示被正确识别的目标(TP), 白色点表示被错检的目标(FN), 紫色点表示被漏检的目标(FP)。可以看出,对于与训练数据地域特点完全不同的烟台市,YOLO-S-CIoU仍然具有更好的识别效果。虽然出现了错检和漏检问题,但问题明显轻于YOLOv3。识别结果进一步证明YOLO-S-CIoU具有更好的鲁棒性以及更强的普适性。

|

Download:

|

| 图 7 烟台市学校场所的识别结果示例 Fig. 7 Examples of school identification results of Yantai City | |

为定量评估2个模型在图木舒克市和烟台市的识别效果,基于图 6、图 7进行统计,得到表 3。基于这几个统计值计算得到召回率和精确度。对比这2个指标可以看出,YOLO-S-CIoU的召回率在2个识别区域相对YOLOv3都有显著提升,模型的改进实现了原始模型召回率的显著提升。

|

|

表 3 2个模型在2个区域的识别结果对比 Table 3 Comparison of identification results using the two models in two regions |

学校等重点场所的遥感识别对于智慧城市及平安城市建设具有重要意义,传统的目标识别方法受遥感影像复杂背景影响往往精度较低。随着CNN的迅猛发展,涌现出YOLOv3等一批优秀的深度学习模型,为遥感影像的目标识别提供了技术支持。本文针对YOLOv3在学校场所识别中存在的问题,通过改进特征提取网络以及损失函数得到YOLO-S-CIoU模型。新模型在实验数据集上的训练结果表明:YOLO-S-CIoU的AP为96.46%,比YOLOv3提升2.3%,且改进后的模型的参数量(226 MB)相对于YOLOv3(235 MB)减少9 MB,实现了在减少模型参数的基础上提升模型性能。此外,在图木舒克及烟台市验证结果表明,改进后模型的错检及漏检问题明显低于YOLOv3,召回率得到显著提升,表明新模型具有更强的鲁棒性与普适性,随着后续数据集的不断扩充和完善,利用改进后的模型有望在不同时相、不同类型传感器影像上得到很好的扩展。

然而,我们也注意到,尽管优于传统的YOLOv3模型,但新模型仍然存在漏检现象。这首先是由于遥感图像背景复杂,地物种类和数量繁多,而学校场所的目标特征具有较强的随机性,对识别造成较大干扰。其次,实验使用的训练数据集为喀什地区的学校目标,数据量相对较小,虽然训练前采用了一些数据增强策略,但对于学校场所特征组合的多样性尚有欠缺,这可以在后续通过逐步扩展数据集得到完善。最后,在此期间,YOLO系列模型已经发展到了YOLOv4[25],YOLOv5[26],这些模型改进的策略与本文方法类似,均针对YOLOv3在网络结构及损失函数等方面进行了优化,并在一些公共数据集的目标识别上取得了很好的效果。后续我们将跟踪比较YOLOv4、YOLOv5在本实验中学校场所目标识别上的表现,并汲取其中的成功部分以达到更好的效果。

| [1] |

甄峰, 席广亮, 秦萧. 基于地理视角的智慧城市规划与建设的理论思考[J]. 地理科学进展, 2015, 34(4): 402-409. Doi:10.11820/dlkxjz.2015.04.001 |

| [2] |

黄海涛, 柯长青. 高分辨率遥感影像中操场跑道的自动提取[J]. 遥感信息, 2009, 24(3): 19-22, 29. Doi:10.3969/j.issn.1000-3177.2009.03.005 |

| [3] |

普恒. 高分遥感城市典型地物对象化识别方法研究[D]. 北京: 北京建筑大学, 2019.

|

| [4] |

范荣双, 陈洋, 徐启恒, 等. 基于深度学习的高分辨率遥感影像建筑物提取方法[J]. 测绘学报, 2019, 48(1): 34-41. DOI: CNKI:SUN:CHXB.0.2019-01-006.

|

| [5] |

Wen Q, Jiang K Y, Wang W, et al. Automatic building extraction from google earth images under complex backgrounds based on deep instance segmentation network[J]. Sensors (Basel, Switzerland), 2019, 19(2): 333. Doi:10.3390/s19020333 |

| [6] |

Chen Y, Wei Y M, Wang Q J, et al. Mapping post-earthquake landslide susceptibility: a U-net like approach[J]. Remote Sensing, 2020, 12(17): 2767. Doi:10.3390/rs12172767 |

| [7] |

Girshick R, Donahue J, Darrell T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]//2014 IEEE Conference on Computer Vision and Pattern Recognition. June 23-28, 2014, Columbus, OH, USA. IEEE, 2014: 580-587. DOI: 10.1109/CVPR.2014.81.

|

| [8] |

Girshick R. Fast R-CNN[C]//2015 IEEE International Conference on Computer Vision (ICCV). December 7-13, 2015, Santiago, Chile. IEEE, 2015: 1440-1448. DOI: 10.1109/ICCV.2015.169.

|

| [9] |

Ren S Q, He K M, Girshick R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149. Doi:10.1109/TPAMI.2016.2577031 |

| [10] |

He K M, Gkioxari G, Dollár P, et al. Mask R-CNN[C]//2017 IEEE International Conference on Computer Vision (ICCV). October 22-29, 2017, Venice, Italy. IEEE, 2017: 2980-2988. DOI: 10.1109/ICCV.2017.322.

|

| [11] |

Redmon J, Divvala S, Girshick R, et al. You only look once: unified, real-time object detection[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). June 27-30, 2016, Las Vegas, NV, USA. IEEE, 2016: 779-788. DOI: 10.1109/CVPR.2016.91.

|

| [12] |

Redmon J, Farhadi A. YOLO9000: better, faster, stronger[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). July 21-26, 2017, Honolulu, HI, USA. IEEE, 2017: 6517-6525. DOI: 10.1109/CVPR.2017.690.

|

| [13] |

Redmon J, Farhadi A. YOLOv3: an incremental improvement[EB/OL]. arXiv: 1804.02767. (2018-04-08)[2021-12-15]. https://arxiv.org/abs/1804.02767.

|

| [14] |

Alganci U, Soydas M, Sertel E. Comparative research on deep learning approaches for airplane detection from very high-resolution satellite images[J]. Remote Sensing, 2020, 12(3): 458. Doi:10.3390/rs12030458 |

| [15] |

余东行, 张宁, 张保明, 等. 结合卷积神经网络与显著性特征的机场检测[J]. 测绘通报, 2019(7): 44-49. Doi:10.13474/j.cnki.11-2246.2019.0216 |

| [16] |

Ma H J, Liu Y L, Ren Y H, et al. Detection of collapsed buildings in post-earthquake remote sensing images based on the improved YOLOv3[J]. Remote Sensing, 2019, 12(1): 44. Doi:10.3390/rs12010044 |

| [17] |

陈连凯, 李邦昱, 齐亮. 融合图像显著性的YOLOv3船舶目标检测算法研究[J]. 软件导刊, 2020, 19(10): 146-151. Doi:10.11907/rjdk.201157 |

| [18] |

Hu J, Shen L, Albanie S, et al. Squeeze-and-excitation networks[C]//IEEE Transactions on Pattern Analysis and Machine Intelligence. IEEE, : 2011-2023. DOI: 10.1109/TPAMI.2019.2913372.

|

| [19] |

Zheng Z H, Wang P, Liu W, et al. Distance-IoU loss: faster and better learning for bounding box regression[J]. Proceedings of the AAAI Conference on Artificial Intelligence, 2020, 34(7): 12993-13000. Doi:10.1609/aaai.v34i07.6999 |

| [20] |

Hernández G A, König P. Do deep nets really need weight decay and dropout?[EB/OL]. arXiv: 1802.07042. (2018-02-21)[2021-12-15]. https://arxiv.org/abs/1802.07042.

|

| [21] |

Ioffe S, Szegedy C. Batch normalization: accelerating deep network training by reducing internal covariate shift[EB/OL]. arXiv: 1502.03167. (2021-03-29)[2021-12-15]. http://arxiv.org/abs/1502.03167v3.

|

| [22] |

Rezatofighi H, Tsoi N, Gwak J, et al. Generalized intersection over union: a metric and a loss for bounding box regression[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). June 15-20, 2019, Long Beach, CA, USA. IEEE, 2019: 658-666. DOI: 10.1109/CVPR.2019.00075.

|

| [23] |

谢梦, 刘伟, 杨梦圆, 等. 深度卷积神经网络支持下的遥感影像飞机检测[J]. 测绘通报, 2019(6): 19-23. Doi:10.13474/j.cnki.11-2246.2019.0177 |

| [24] |

Zhang P, Su W H. Statistical inference on recall, precision and average precision under random selection[C]//2012 9th International Conference on Fuzzy Systems and Knowledge Discovery. May 29-31, 2012, Chongqing, China. IEEE, 2012: 1348-1352. DOI: 10.1109/FSKD.2012.6234049.

|

| [25] |

Bochkovskiy A, Wang C Y, Liao H Y M. YOLOv4: optimal speed and accuracy of object detection[EB/OL]. arXiv: 2004.10934. (2020-04-23)[2021-12-15]. https://arxiv.org/abs/2004.10934.

|

| [26] |

Jocher G, Nishimura K, Mineeva T, et al. YOLOv5[EB/OL]. (2020-08-10)[2021-12-15]. https://github.com/ultralytics/yolov5.

|

2023, Vol. 40

2023, Vol. 40