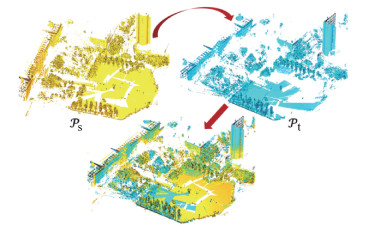

三维点云是对真实场景的形状和几何结构的直观反映,随着扫描设备(地面激光雷达、深度相机等)的发展,这类数据的获取已经变得十分快捷。目前,由于三维点云所具备的大量优点,这种数据被广泛地应用于计算机视觉、计算机图形学和遥感领域的各项应用中。然而,点云的扫描获取基于反射原理,因此每站扫描只能捕获到场景的单侧表面信息。为了实现点云数据对目标场景的完整表示,在不考虑形变的情况下,需要将多次扫描场景所得到的点云进行配准,这使得三维点云的配准成为当前的研究热点。三维点云的配准是指将多帧点云变换到同一个世界坐标系中并使共有部分重合。其中,2帧点云配准是多帧点云配准的重要基础,如图 1所示,它旨在为任意位姿的源点云

|

Download:

|

| 图 1 三维点云配准示例 Fig. 1 Illustration of 3D point cloud registration | |

通常,点云配准过程包括特征提取、特征匹配和变换参数计算。其中,特征提取和匹配的效果是决定配准精度的核心因素,而现有的配准方法大多利用了基于点的特征匹配,因此其性能严重受制于点云中噪声、共有区域小或无共有区域等问题的影响。一方面,在共有区域小的点云中可能并不存在对应的点特征,这导致难以实现有效的特征匹配;另一方面,随着噪声程度的上升,对特征匹配的干扰随之增大,配准的精度也会随之下降。由于数据扫描的现场环境中存在大量遮挡和难以克服的地况问题,扫描得到的数据经常存在噪声、共有区域小或无共有区域等质量问题,这些数据质量问题进而使原始点云难以被现有方法正确配准。尽管在扫描过程中不计成本地提升数据质量有助于配准问题的解决,但这样的解决方案不仅降低了数据获取的灵活性,还使获取可用数据的效率变得低下。针对难以解决的噪声问题,一些研究者提出基于平面图元的配准方法[10-12],尽管这些方法巧妙利用了平面图元对噪声的鲁棒性,但由于它们依赖于场景中的平面图元足够多的假设,所以可实际应用的场景仍然受到一些限制。此外,基于平面图元的配准方法至少需要成功匹配3对互不平行的平面图元,这在共有区域小的2帧点云中难以实现。因此,基于平面图元的配准方法很难配准共有区域小的2帧点云。综上所述,点云配准具有重大的研究价值并且存在重大挑战,尤其是面对共有区域小的点云配准问题。

为更好地解决含有噪声、共有区域小或无共有区域点云的配准问题,提出一个新的配准方法,该方法基于先验知识,首先在原始点云中提取平面、圆柱面和球面图元并利用它们构造与点云的6个自由度相对应的有效图元组;其次,在有效图元组中提取特征元素和特征关系并创建特征描述子;然后,基于描述子匹配,实现局部坐标系匹配并从中计算出一系列变换参数;最后,基于全局评估选出最佳变换,并以此实现2帧原始点云的最佳配准。本文所提方法的核心模块执行在几何图元层次上,因此该方法不仅继承了几何图元对噪声的鲁棒性,还因计算规模的减小而具有更高的效率。大量的实验证明所提方法不仅在不同尺度的基准数据上取得了最佳的配准效果,还可以配准一些由对称扫描获得的无共有区域的点云数据。

1 相关工作由于所面向的具体问题不同,三维点云配准方法被分为粗配准方法和精配准方法。其中,粗配准方法旨在配准距离和角度相差大的原始点云,而精配准方法依赖粗配准方法提供初值,利用迭代优化提升配准精度,常见的ICP方法[3-4]和它的一些变体[5-9]都是典型的精配准方法。由于本文方法旨在解决粗配准问题,因此在这一部分仅介绍重要的粗配准方法。

1.1 基于点特征的配准这一类方法的核心模块通常遵循一个相似的流程,即首先进行关键点检测,然后根据关键点创建特征描述子,最后基于描述子匹配实现点云配准。具体来说,常用的关键点检测方法包括本征形状签名[13](intrinsic shape signature, ISS)、3D Harris[14]以及局部最大曲率等,这些关键点通常都具有局部邻域内最显著的几何特征。在关键点的基础上,一些方法通过编码更高层的局部抽象创建特征描述子[15]。其中,Rusu等[16]提出经典的快速点特征直方图(fast point feature histogram, FPFH),该描述子对采样点局部范围内的多尺度特征进行编码,具有很高的效率。Tombari等[17]提出方向直方图特征(signature of histograms of orientations, SHOT),它结合采样点的几何分部信息和直方图统计信息。Zhou等[18]提出快速全局配准(fast global registration, FGR),该方法使用优化函数代替迭代优化,因此具有很高的效率。为加速描述子匹配,研究者们还提出一些快速匹配搜索方法,常用的有几何哈希[19]和随机采样一致性(random sample consensus, RANSAC)[20-21]等。此外,还有一些方法同时提出了描述子及相应的高效搜索策略。例如,Aiger等[22]基于空间点距离比例的仿射不变性提出4点法(4-points congruent sets, 4PCS)。随后,Mellado等[23]为4PCS引入智能搜索策略并提出超级4点法(super 4-points congruent sets, Super 4PCS),从而进一步提高了配准效率。

尽管基于点特征的配准方法可以解决整体配准和部分配准问题,但它们仍然要求2帧点云之间拥有足够大的共有区域,以获取足够多的对应点。此外,基于点特征的配准方法普遍对噪声敏感。

1.2 基于几何图元的配准为摆脱基于点特征的配准方法所面临的困境,研究者们提出了一些利用几何图元进行配准的方法。相比于点特征,几何图元对点云中的噪声问题具有较强的鲁棒性。配准中使用到的几何图元主要包括直线[24-25]、曲线[26]和平面图元,而在其中平面图元最常被用到。Xu等[11]在体素化的点云中提取高质量平面,并提出基于3对平面图元匹配的配准方法。Xu等[27]随后仿照传统的4PCS方法提出新的体素4点法(voxel based 4-points congruent sets, V4PCS),该方法利用平面间角度比例的仿射不变性创建特征描述子。Chen等[12]提出基于平面组合的描述子PLADE,该描述子对场景中的局部结构进行编码,具有较高的鲁棒性。尽管与基于点的方法相比,基于平面的配准方法具有更强的鲁棒性,但它们都要求场景中具有足够多的平面,因此可适用的场景范围比较受限。为克服对平面的依赖,Hattab和Taubin[28]在提出的配准方法中引入曲面,并根据匹配度对多次随机选出的3对图元进行评估,进而实现点云配准,由于缺少对常见局部结构的准确抽象,该方法无法配准少于3对共有图元的场景。

1.3 基于深度学习的配准近年来,随着点云深度学习技术的发展[29-30],研究者们相继提出利用深度神经网络自动学习并构建特征的方法,这些方法主要面向室内场景和人造物体的点云配准。例如,Gojcic等[31]提出三维平滑网络(3D smooth net),该网络首先学习到点云的局部特征,然后利用RANSAC框架进行特征匹配,该网络还证明其在室内配准数据集3DMatch[32]上具有最佳表现。此外,Aoki等[33]将经典的光流算法嵌入点云神经网络并提出网络模型PointNetLK,这使得该方法的适用性和计算效率都获得了一定的提高。Wang和Solomon[34]提出深度最近点(deep closest point,DCP),它是一个端到端的配准网络,并且在基于ModelNet40数据集[35]构建的实验数据上验证了配准精度。深度学习方法可以自主学习到用于配准的特征,从而减少在特征设计阶段的人工参与,尽管可以获得较高的配准精度,但由于过度依赖在相同类型数据上的预先训练,基于深度学习的配准方法具有场景泛化性很差的缺点。

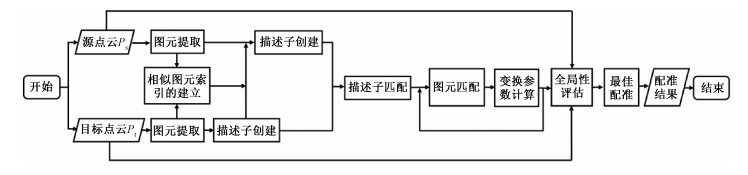

2 本文方法本文提出的基于多类型几何图元匹配的三维点云配准方法框架如图 2所示,面对输入的源点云

|

Download:

|

| 图 2 本文提出的三维点云配准方法流程图 Fig. 2 Workflow of the proposed 3D point cloud registration method | |

特征描述子的准确创建是特征匹配的重要基础。其中,描述子创建过程被分为图元提取、有效图元组的构建和描述子向量的创建3个阶段。

1) 图元提取

本文方法旨在解决人造物体或建筑场景的点云配准,而在这些物体或场景中含有丰富的平面、圆柱面和球面,根据这一先验知识,在原始点云中提取这3种常见图元。由于图元提取需要具有鲁棒性、高效性和对多种尺度场景的处理能力,本文使用efficient RANSAC算法[36]提取图元。为降低图元提取时的参数依赖,在提取图元前将原始点云的尺寸缩放至单位球中,并在配准后按照需求决定是否进行尺寸还原。为加速后续的描述子匹配,首先为源点云

2) 有效图元组的构建

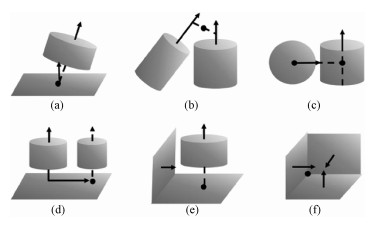

在不同视角下针对同一物体或场景获得的原始点云中,物体或场景表面的局部结构保持不变,由于这些局部结构均由几何图元组合而成,因此本文方法用图元组合表示这些局部结构。尽管在多数图元中可以恢复2个自由度,但在随机类型和位姿的图元组合中,图元的数量与组合中可恢复的自由度数目并不构成线性关系。为保证由图元组合中产生的描述子可以和所属点云的坐标系一一对应,可以恢复出6个自由度这一有效性是图元组合构建过程中需要遵从的一个重要规则。此外,为尽量多地产生不同图元组合以应对2帧点云间共有图元少的情况,组合中应该包含最少的图元数目。结合对场景或物体表面局部结构的观察和对图元组合有效性的遵从,本文提出如图 3所示的6种固定组合,其中包括1个圆柱斜插于1个平面、2个不平行的圆柱、1个球面和1个轴心线不过其球心的圆柱、2个平行圆柱和1个与它们垂直的平面、1个圆柱和2个分别与其平行和垂直的平面, 以及3个相互不平行的平面。

|

Download:

|

| 图 3 固定的有效图元组合 Fig. 3 The given effective primitive combinations | |

3) 描述子向量的创建

在6种固定的有效图元组合中提取特征元素和关系,以构建相应的特征描述子,为方便计算匹配度,描述子被定义为如表 1所示的高维向量。其中,r1 和 r2 分别表示相应图元组中的最小和最大图元半径(如球体半径或圆柱的截面圆半径),a1、a2 和 a3 分别表示图元组中的图元间最小、次小和最大夹角(如圆柱轴线间的夹角、圆柱轴线与平面法线之间的夹角或平面法线之间的夹角),d 表示图元组中的图元间距离(如两圆柱轴线间的最短距离、圆柱轴线与球心间的最短距离或者圆柱轴线和与其平行的平面间的距离)。需要说明的是,以上的所有角度均以弧度制表示。

|

|

表 1 6种描述子向量 Table 1 Six types of descriptor vectors |

本文方法以特征描述子的匹配为媒介,计算变换参数并生成候选变换,该过程包含特征描述子的匹配和变换参数的计算2个阶段。

1) 特征描述子的匹配

为使描述子匹配更加高效,在为目标点云

2) 变换参数的计算

在每一对匹配的描述子中可以获得2或3对匹配图元,这些匹配图元共同确立了2帧点云所在坐标系(简称点云坐标系)间的对应关系,这些对应关系潜在地确立了2帧点云间的一个候选配准。基于对匹配图元组内关键几何元素的操作,构建与2个点云坐标系对应的局部坐标系(简称描述子局部坐标系),然后通过使描述子局部坐标系的方向和位置重合令2个点云坐标系重合,进而实现点云配准。具体而言,在匹配图元组中,首先, 获取所有可能的2组关键直线

算法1 Given a pair of matched descriptors (Di, Dk), estimate the transformation parameters (R, T) by making their local coordinate frames coincide.

1: procedure TRANSFORMATION(Di, Dk)

The transformation between the local coordinate frames of Dk and Di

2: Extract (li1, li2, pi) and (lk1, lk2, pk) from Di and Dk, respectively

3: Extract unit vectors (vi1, vi2) and (vk1, vk2) from (li1, li2) and (lk1, lk2), respectively

4: compute the unit coordinate frames (Xi, Yi, Zi) and (Xk, Yk, Zk)

5: compute the rotation matrix R1 that makes Xk and Xi coincide

6: (Xk, Yk, Zk)←(R1·Xk, R1·Yk, R1·Zk)

7: compute the rotation matrix R2 that makes Xi and Z-axis coincide

8: (Xk, Yk, Zk)←(R2·Xk, R2·Yk, R2·Zk), (Xi, Yi, Zi)←(R2·Xi, R2·Yi, R2·Zi)

9: compute the rotation matrix R3 that makes Yk and Yi coincide

10: R4←R2-1

11: R=R4·R3·R2·R1

12: pk←R·pk

13: T←pi-pk

14: return(R, T)

15: end procedure

在令描述子单位坐标系重合的过程中, 首先, 计算出使

| $ \boldsymbol{R}=\boldsymbol{R}_4 \cdot \boldsymbol{R}_3 \cdot \boldsymbol{R}_2 \cdot \boldsymbol{R}_1 . $ | (1) |

为进一步使描述子局部坐标系的位置重合,基于旋转矩阵 R 和描述子中获得的对应点(pi, pk) ,可计算出平移向量为

| $ \boldsymbol{T}=\boldsymbol{p}_i-\boldsymbol{R} \cdot \boldsymbol{p}_k . $ | (2) |

在为所有的匹配的描述子计算变换参数后,获得使

本文方法使用全局性的评估策略确定候选变换集

| $ C=\alpha \cdot N+S_2. $ | (3) |

其中: α 被设置为足够大的值(默认为10 000),以确保重合图元数 N 是评估候选变换的主要指标。在完成所有评估后,评估分数最高的变换被选为最佳变换,并以目标点云

为验证本文方法的有效性,展示了与其他经典点云配准方法的对比,除传统方法SAC-IA[16]、Super 4PCS[23]和FGR[18],还有深度学习方法DCP[34]。采用均方根误差(root mean square error, RMSE)和平均绝对误差(mean absolute error, MAE)分别对旋转和平移误差进行测量。

本文方法以C++实现,所采用的实验环境为IntelCorei7-3770CPU@3.4 GHz,16 GB内存Windows10 64位操作系统,实验数据收集自多个基准数据集。此外,为了在同一尺度下衡量本文方法对不同尺寸数据的配准结果,在配准结果中没有对归一化的尺寸进行还原。

3.2 实验结果与分析首先在Semantic3D数据集[37]中选取2帧城市场景的三维点云, 并分别为其添加高斯噪声

|

Download:

|

| 图 4 在噪声点云上的配准结果 Fig. 4 Registration result on noisy point clouds | |

下面,在人造物体和大尺度建筑场景的点云配准上与其他先进方法进行对比及定量分析。

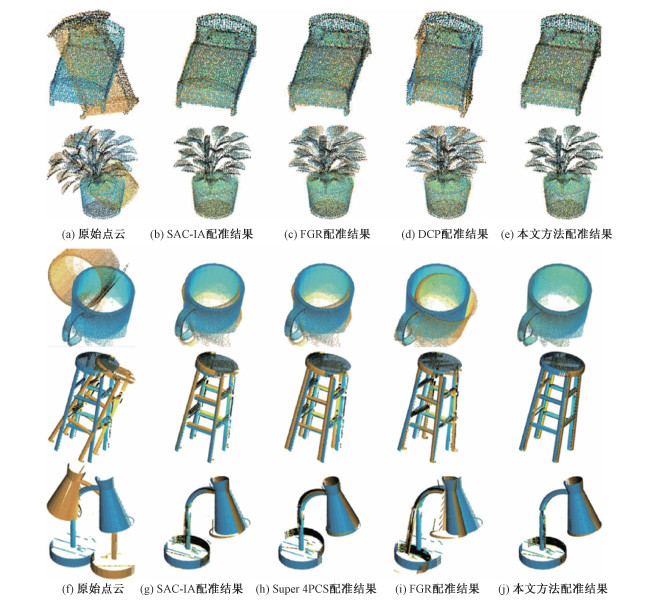

1) 人造物体点云配准

图 5展示了本文方法与其他方法在人造物体点云上的配准结果的比较。与对比方法DCP类似,在ModelNet40数据集[35]中采样并加入噪声和随机变换,从而构造出前2组待配准数据。从对前2组数据的实验结果可以看出,SAC-IA和FGR对于清晰的局部特征比较敏感,在此情况下具有很高的配准精度,而DCP基本实现了粗配准,但仍有明显误差。相比之下,本文方法基于图元匹配配准点云的局部结构,因此具有足够高的鲁棒性,可以取得最高的配准精度。此外,如图 5第3行所示,还展示了在RGB-D Scenes Dataset v2数据集[38]中获得的待配准点云上的对比实验,在这类特征简单且大量重复的数据上,SAC-IA、Super 4PCS和FGR都表现出明显的配准误差,而由于该数据的表面结构十分清晰,本文方法可以对其进行精确配准。为进一步衡量本文方法的优势,依次从对称角度扫描2个常见物体,并在产生的2组无共有区域点云上进行了实验对比,如图 5后2行所示。由于每组点云中不存在共有区域,这些点云之间不存在对应的特征点,因此基于特征点的3个配准方法均匹配到错误的特征,并产生了明显的配准误差。相比之下,由于每组点云中仍然具有共有图元,本文方法可以通过图元匹配配准原始点云。

|

Download:

|

| 图 5 本文方法与其他方法在5组人造物体点云上的配准结果对比 Fig. 5 Comparison with previous methods on five pairs of point clouds of human-made object | |

表 2对图 5的实验结果进行了定量描述,从为每个旋转和平移计算出的RMSE和MAE可以看出,在表面结构复杂的前2组数据中,SAC-IA和FGR的配准精度接近于本文方法,而在表面结构清晰的第3组数据中,本文方法开始在配准精度上具有明显优势。在对后2组数据的配准评估中可以看出,SAC-IA、FGR和DCP方法均无法配准无共有区域的原始点云,而本文方法可以匹配这类原始点云中的共有图元,进而实现精确的点云配准。此外,在效率方面,由于参与计算的图元数量远远少于原始点云的点数,本文方法具有更小的计算规模,进而拥有最快的配准速度。

|

|

表 2 本文方法与其他方法在5组人造物体点云上的配准结果对比分析 Table 2 Quantitative comparison of different methods on five pairs of point clouds of human-made objects |

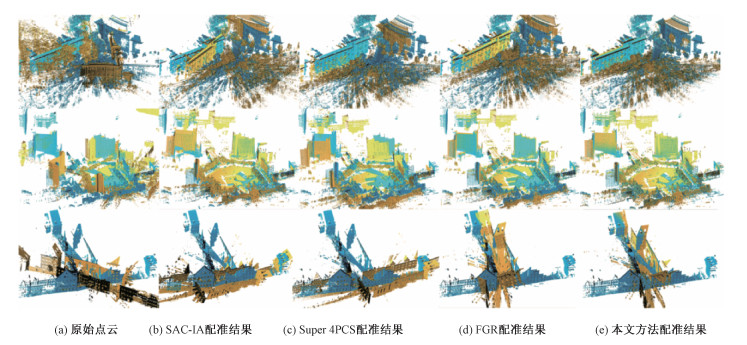

2) 大尺度建筑场景点云配准

本文还在大尺度建筑场景点云的配准上与其他方法进行了对比,并分别在图 6和表 3中展示了实验结果及其定量描述。前2组点云数据取自Whu-TLS-dataset[39],在对比中可以看出,由于门窗、树木、墙角等的局部特征十分相似,SAC-IA、Super 4PCS和FGR均表现出较高的旋转或平移误差,而本文方法主要对具有更大范围的楼体表面或地面进行匹配,因此对于局部细节的相似度并不敏感。最后一组点云数据取自Semantic3D数据集[37],点云中的场景为近乎垂直的2条街道的交叉口,并且2条街道十分相似。在这组数据中不仅存在大量相似的关键点,还存在大量相似的图元,这极易引起特征混淆而导致错误的特征匹配。从图 6和表 3可以看出,SAC-IA和Super 4PCS实现了街道层面的错误配准,从而引发了很大的旋转和平移误差。尽管FGR的表现强于SAC-IA和Super 4PCS,但所产生的旋转误差依旧明显。相比之下,尽管存在大量相似图元特征的干扰,由于本文方法结合了对局部结构相似度的敏感性及对图元匹配的全局性评估,仍然能成功配准数据并获得很高的配准精度。而面对大尺度建筑场景点云,由于点数的增长规模远远超出图元数的增长规模,图元数量少的优势被进一步扩大,使得本文方法具有更大的效率优势。

|

Download:

|

| 图 6 本文方法与其他方法在3组大型城市场景点云上的配准结果对比 Fig. 6 Comparison with different methods on three pairs of point clouds of large-scale urban scenes | |

|

|

表 3 本文方法与其他方法在3组大型城市场景点云上的配准结果对比分析 Table 3 Quantitative comparison of different methods on three pairs of point clouds of large-scale urban scenes |

本文提出的方法旨在配准人造物体或大型建筑场景的2帧任意位姿的原始点云,该方法基于提取出的常见几何图元创建特征描述子,利用描述子的匹配实现原始点云6自由度的匹配,进而通过配准原始点云坐标系计算出一系列变换参数,最终通过全局评估确定最佳变换,并利用该参数实现了2帧点云的最佳配准。本文所提方法巧妙利用图元相比于点的优势,从而对噪声问题具有更高的鲁棒性。此外,由于本文所提描述子利用有效图元组合对点云中常见的局部几何结构进行了精确编码,因此具有很强的特征描述性,使得所提配准方法有能力克服数据中由相似图元引起的干扰。与其他基于图元的配准方法相比,该方法能感知更复杂的局部结构,因此具有更广的适用范围,可以应用于人造物体或大型建筑场景等富含平面、圆柱面和球面几何图元的目标场景中。

本文所提方法还可用于解决一些由对称扫描获得的共有区域小或无共有区域点云的配准问题,由于几何图元在空间中具有延伸性性,即使原始点云中不存在基于点的共有区域,它们仍可能含有共有图元,这使得该方法可以利用共有图元的匹配计算变换参数,进而实现点云配准。

4 总结本文提出一种基于常见多类型几何图元匹配的三维点云配准方法,该方法的主要贡献在于配准扫描数据时能够克服噪声、共有区域小或无共有区域问题的干扰,潜在地避免了更复杂的数据获取过程。从实验结果来看,面对适用的点云数据时(如物体点云或建筑场景点云),本文方法具有强于其他方法的配准精度和配准效率。但它只应用到了图元特征,因此缺乏配准森林等纯自然场景点云的能力,在后续工作中会将特殊设计的点特征融入到配准框架内,以进一步扩宽配准方法所适用的场景类型。

| [1] |

Tam G K L, Cheng Z Q, Lai Y K, et al. Registration of 3D point clouds and meshes: a survey from rigid to nonrigid[J]. IEEE Transactions on Visualization and Computer Graphics, 2013, 19(7): 1199-1217. Doi:10.1109/TVCG.2012.310 |

| [2] |

Maiseli B, Gu Y F, Gao H J. Recent developments and trends in point set registration methods[J]. Journal of Visual Communication and Image Representation, 2017, 46: 95-106. Doi:10.1016/j.jvcir.2017.03.012 |

| [3] |

Besl P J, McKay N D. A method for registration of 3-D shapes[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1992, 14(2): 239-256. Doi:10.1109/34.121791 |

| [4] |

Chen Y, Medioni G. Object modelling by registration of multiple range images[J]. Image and Vision Computing, 1992, 10(3): 145-155. Doi:10.1016/0262-8856(92)90066-C |

| [5] |

Rueckert D, Sonoda L I, Hayes C, et al. Nonrigid registration using free-form deformations: application to breast MR images[J]. IEEE Transactions on Medical Imaging, 1999, 18(8): 712-721. Doi:10.1109/42.796284 |

| [6] |

Rusinkiewicz S, Levoy M. Efficient variants of the ICP algorithm[C]//Proceedings Third International Conference on 3-D Digital Imaging and Modeling. May 28 - June 1, 2001, Quebec City, QC, Canada. IEEE, 2001: 145-152.

|

| [7] |

Li H, Sumner R W, Pauly M. Global correspondence optimization for non-rigid registration of depth scans[J]. Computer Graphics Forum, 2008, 27(5): 1421-1430. Doi:10.1111/j.1467-8659.2008.01282.x |

| [8] |

Bouaziz S, Tagliasacchi A, Pauly M. Sparse iterative closest point[J]. Computer Graphics Forum, 2013, 32(5): 113-123. Doi:10.1111/cgf.12178 |

| [9] |

王飞鹏, 肖俊, 王颖, 等. 一种基于高斯曲率的ICP改进算法[J]. 中国科学院大学学报, 2019, 36(5): 702-708. |

| [10] |

Xiao J H, Adler B, Zhang H X. 3D point cloud registration based on planar surfaces[C]//2012 IEEE International Conference on Multisensor Fusion and Integration for Intelligent Systems (MFI). September 13-15, 2012, Hamburg, Germany. IEEE, 2012: 40-45.

|

| [11] |

Xu Y, Boerner R, Yao W, et al. Automated coarse registration of point clouds in 3d urban scenes using voxel based plane constraint[J]. ISPRS Annals of Photogrammetry, Remote Sensing and Spatial Information Sciences, 2017, IV-2/W4: 185-191. Doi:10.5194/isprs-annals-IV-2-W4-185-2017 |

| [12] |

Chen S L, Nan L L, Xia R B, et al. PLADE: a plane-based descriptor for point cloud registration with small overlap[J]. IEEE Transactions on Geoscience and Remote Sensing, 2020, 58(4): 2530-2540. Doi:10.1109/TGRS.2019.2952086 |

| [13] |

Zhong Y. Intrinsic shape signatures: a shape descriptor for 3D object recognition[C]//2009 IEEE 12th International Conference on Computer Vision Workshops, ICCV Workshops. September 27 - October 4, 2009, Kyoto, Japan. IEEE, 2009: 689-696.

|

| [14] |

Sipiran I, Bustos B. Harris 3D: a robust extension of the Harris operator for interest point detection on 3D meshes[J]. The Visual Computer, 2011, 27(11): 963-976. Doi:10.1007/s00371-011-0610-y |

| [15] |

Guo Y L, Bennamoun M, Sohel F, et al. A comprehensive performance evaluation of 3D local feature descriptors[J]. International Journal of Computer Vision, 2016, 116(1): 66-89. Doi:10.1007/s11263-015-0824-y |

| [16] |

Rusu R B, Blodow N, Beetz M. Fast point feature histograms (FPFH) for 3D registration[C]//2009 IEEE International Conference on Robotics and Automation. May 12-17, 2009, Kobe, Japan. IEEE, 2009: 3212-3217.

|

| [17] |

Tombari F, Salti S, Stefano L. Unique signatures of histograms for local surface description[C]//Computer Vision - ECCV 2010, 2010: 356-369. DOI: 10.1007/978-3-642-15558-1_26.

|

| [18] |

Zhou Q Y, Park J, Koltun V. Fast global registration[M]//Computer Vision - ECCV 2016. Cham: Springer International Publishing, 2016: 766-782.

|

| [19] |

Wolfson H J, Rigoutsos I. Geometric hashing: an overview[J]. IEEE Computational Science and Engineering, 1997, 4(4): 10-21. Doi:10.1109/99.641604 |

| [20] |

Fischler M A, Bolles R C. Random sample consensus[J]. Communications of the ACM, 1981, 24(6): 381-395. Doi:10.1145/358669.358692 |

| [21] |

Chen C S, Hung Y P, Cheng J B. RANSAC-based DARCES: A new approach to fast automatic registration of partially overlapping range images[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1999, 21(11): 1229-1234. Doi:10.1109/34.809117 |

| [22] |

Aiger D, Mitra N J, Cohen-Or D. 4-points congruent sets for robust pairwise surface registration[C]//ACM SIGGRAPH 2008 papers on - SIGGRAPH'08. August 11-15, 2008. Los Angeles, California. New York: ACM Press, 2008: 1-10.

|

| [23] |

Mellado N, Aiger D, Mitra N J. Super 4PCS fast global pointcloud registration via smart indexing[J]. Computer Graphics Forum, 2014, 33(5): 205-215. Doi:10.1111/cgf.12446 |

| [24] |

Habib A, Ghanma M, Morgan M, et al. Photogrammetric and lidar data registration using linear features[J]. Photogrammetric Engineering & Remote Sensing, 2005, 71(6): 699-707. |

| [25] |

Al-Durgham M, Habib A. A procedure for the registration and segmentation of heterogeneous lidar data[C]//2012 International Conference on Computer Vision in Remote Sensing. December 16-18, 2012, Xiamen, China. IEEE, 2012: 122-126.

|

| [26] |

Yang B S, Zang Y F. Automated registration of dense terrestrial laser-scanning point clouds using curves[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2014, 95: 109-121. Doi:10.1016/j.isprsjprs.2014.05.012 |

| [27] |

Xu Y S, Boerner R, Yao W, et al. Pairwise coarse registration of point clouds in urban scenes using voxel-based 4-planes congruent sets[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2019, 151: 106-123. Doi:10.1016/j.isprsjprs.2019.02.015 |

| [28] |

Hattab A, Taubin G. 3D rigid registration of cad point-clouds[C]//2018 International Conference on Computing Sciences and Engineering (ICCSE). March 11-13, 2018, Kuwait, Kuwait. IEEE, 2018: 1-6.

|

| [29] |

Charles R Q, Hao S, Mo K C, et al. PointNet: deep learning on point sets for 3D classification and segmentation[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). July 21-26, 2017, Honolulu, HI, USA. IEEE, 2017: 77-85.

|

| [30] |

Qi C R, Yi L, Su H, et al. PointNet++: deep hierarchical feature learning on point sets in a metric space[EB/OL]. arXiv: 1706.02413. (2017-06-07)[2021-03-04]. https://arxiv.org/abs/1706.02413.

|

| [31] |

Gojcic Z, Zhou C F, Wegner J D, et al. The perfect match: 3D point cloud matching with smoothed densities[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). June 15-20, 2019, Long Beach, CA, USA. IEEE, 2019: 5540-5549.

|

| [32] |

Zeng A, Song S R, Nießner M, et al. 3DMatch: learning local geometric descriptors from RGB-D reconstructions[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). July 21-26, 2017, Honolulu, HI, USA. IEEE, 2017: 199-208.

|

| [33] |

Aoki Y, Goforth H, Srivatsan R A, et al. PointNetLK: robust & efficient point cloud registration using PointNet[C]//2019 IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). June 15-20, 2019, Long Beach, CA, USA. IEEE, 2019: 7156-7165.

|

| [34] |

Wang Y, Solomon J. Deep closest point: learning representations for point cloud registration[C]//2019 IEEE/CVF International Conference on Computer Vision (ICCV). October 27 - November 2, 2019, Seoul, Korea (South). IEEE, 2019: 3522-3531.

|

| [35] |

Wu Z R, Song S R, Khosla A, et al. 3D ShapeNets: a deep representation for volumetric shapes[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). June 7-12, 2015, Boston, MA, USA. IEEE, 2015: 1912-1920.

|

| [36] |

Schnabel R, Wahl R, Klein R. Efficient RANSAC for point-cloud shape detection[J]. Computer Graphics Forum, 2007, 26(2): 214-226. Doi:10.1111/j.1467-8659.2007.01016.x |

| [37] |

Hackel T, Savinov N, Ladicky L, et al. semantic3d.net: a new large-scale point cloud classification benchmark[J]. ISPRS Annals of Photogrammetry, Remote Sensing and Spatial Information Sciences, 2017, IV-1/W1: 91-98. Doi:10.5194/isprs-annals-IV-1-W1-91-2017 |

| [38] |

Lai K, Bo L F, Fox D. Unsupervised feature learning for 3D scene labeling[C]//2014 IEEE International Conference on Robotics and Automation (ICRA). May 31 - June 7, 2014, Hong Kong, China. IEEE, 2014: 3050-3057.

|

| [39] |

Dong Z, Yang B S, Liang F X, et al. Hierarchical registration of unordered TLS point clouds based on binary shape context descriptor[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2018, 144: 61-79. Doi:10.1016/j.isprsjprs.2018.06.018 |

2023, Vol. 40

2023, Vol. 40