2. 中国科学院大学资源与环境学院, 北京 100049

2. College of Resources and Environment, University of Chinese Academy of Sciences, Beijing 100049, China

建筑物是城市和农村的重要组成部分,对建筑物的提取一直是遥感的一个重要应用。此外,建筑物的变化与社会经济发展息息相关,是人文地理、城乡规划、土地利用等许多领域分析研究的基础[1-2],对建筑物变化区域的提取可为地理国情监测提供重要的基础数据[3],对城市扩张进行有效监测, 促进可持续发展[4]。

卫星遥感能够在短时间内获取大范围的地物信息,从遥感影像中自动地提取建筑物变化信息,大大提升工作效率。传统遥感影像建筑物变化检测方法包括变化向量分析法[5]、变化特征提取法[6-7]及分类后处理法等[8-10]。然而,由于不同地区的建筑物在外形、高度、颜色、风格上有着丰富的多样性,以及同一地区建筑物在不同时相遥感影像上的异质性,传统方法难以在大范围场景下自动、准确地提取建筑物变化区域。因此,提出一种快速、准确、适应不同场景的建筑物变化检测方法十分有意义。

深度学习方法近年来在图像处理领域得到迅速发展:Krizhevsky等提出的AlexNet[11]获得当年ImageNet图像分类竞赛的冠军; Shelhamer等提出全卷积神经网络[12],实现了任意图像大小的端到端的语义分割; Faster-RCNN[13]的提出实现了端到端的高精度图像目标检测。除常见的图像识别领域外,深度学习方法同样应用到图像变化检测领域。

Gong等[14]提出用面向对象分割的方式提取变化区域,之后用神经网络判别每个变化块是否为建筑物变化块,以输出像素级建筑物变化检测结果。Ji等[15]采用深度学习语义分割网络从两时相影像中分别提取建筑物,之后将提取结果与模拟样本结合来训练建筑物变化检测网络,以此实现建筑物变化检测。此类两阶段的方法存在速度慢、误差累积的问题。端到端的建筑物变化检测网络以2期或多期影像为输入,直接输出变化图,避免了误差累积问题,且速度更快,较两阶段方法更为高效。单阶段深度学习变化检测网络中最具代表性的是孪生网络。孪生网络[16]是一种双路径权重共享的卷积神经网络,在基于神经网络的图像变化检测领域有着广泛的应用。Zhan等[17]提出用共享权重网络结合对比度损失函数实现变化检测。El Amin等[18]利用VGG网络[19]挖掘特征图,然后对多时相特征图进行PCA变换挖掘变化信息。Daudt等[20]基于哨兵2号卫星影像制作了Onera卫星变化检测(OSCD)数据集,并提出基于早期融合和基于双生网络的卷积神经网络用于图像块的变化检测。Bao等[21]提出PPCNET,在孪生网络基础上引入变化块分支。Jiang等[22]提出PGA-Siames网络,将变化残差模块引入孪生网络,提高了建筑物变化检测精度。

以上方法主要通过网络结构上的修改以提升网络对变化检测任务的学习能力,未考虑解决建筑物变化检测样本不足带来的精度受限问题。本文除对孪生网络结构进行改进以外,还通过分割样本预训练的方式充分利用建筑物变化检测样本制作过程中的副产品——“建筑物分割样本”来提升网络检测能力。

综上所述,本文主要有以下3个贡献点:

1) 在网络结构上,以孪生网络为基础,提出变化注意力残差模块,将变化残差与注意力机制相结合,有效提升网络对变化特征图的提取能力,提高了建筑物变化检测精度。

2) 提出利用建筑物分割样本对网络骨架进行预训练的策略,使得孪生网络能充分利用制作成本更加低廉的建筑物分割样本进行学习,提高变化检测精度。

3) 本文提出的建筑物变化检测流程能够为城乡规划、地理国情监测等领域提供重要的方法基础。

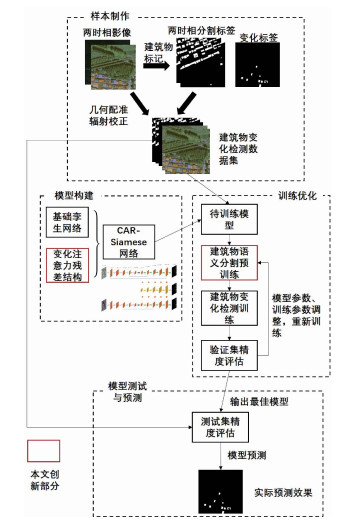

1 方法本文基于孪生卷积神经网络实现建筑物变化检测任务,整体流程如图 1所示。首先,对两期影像进行几何配准,辐射校正以缓解影像异质性引入的检测误差。之后在配准影像基础上进行变化检测样本标记,得到变化检测数据集。在利用数据集进行训练之前,在孪生网络基础上提出变化注意力残差结构,构建CAR-Siamese网络来实现建筑物变化检测。完成模型构建后在新构建数据集上进行模型训练和参数调整、迭代训练,训练过程包括本文提出的建筑物语义分割预训练和建筑物变化检测训练。最后,将训练期间得到的最佳模型用于测试集精度评估,并输出变化检测预测结果图。

|

Download:

|

| 图 1 本文建筑物变化检测流程图 Fig. 1 Flow chart of the proposed building change detection method | |

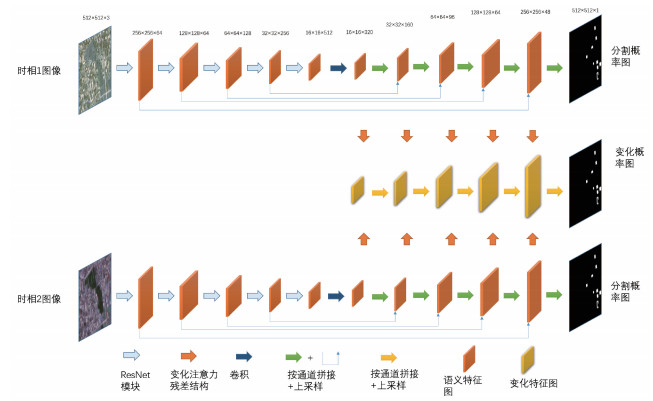

CAR-Siamese网络整体结构如图 2所示。两时相影像首先输入到共享权重的孪生ResUNet网络骨架部分(图 2橙色部分),其中前5层分辨率通过最大值池化逐层递减为上一层的1/2,分别为ResNet第1个卷积层和第1~4个ResBlock,6~10层通过双线性插值使分辨率逐层递增为上一层的2倍,最终输出与原图分辨率相同的语义分割图。网络在6~10层产生5对语义特征图。将5对语义特征图分别输入到变化注意力残差结构中得到5张变化特征图,通过逐层按通道拼接后上采样的方式(例如第6层上采样2倍后与第7层按通道拼接+卷积实现融合,之后继续进行7~8层的融合)将5张变化特征图进行融合,得到最终的变化检测结果。

|

Download:

|

| 图 2 孪生变化注意力残差网络结构 Fig. 2 Change attention residual siamese network | |

孪生网络的基本思想是利用共享权重的网络骨架输出两时相特征图,并对两时相特征图进行差分以突出变化特征。在原始孪生网络中,编码器部分的两期特征图直接相减得到变化特征图,然后通过按通道拼接后上采样的方式将变化特征图融合到解码器部分。Jiang等[22]在此基础上引入变化残差模块来代替特征图之间的直接差分,有效地提高了变化检测精度。

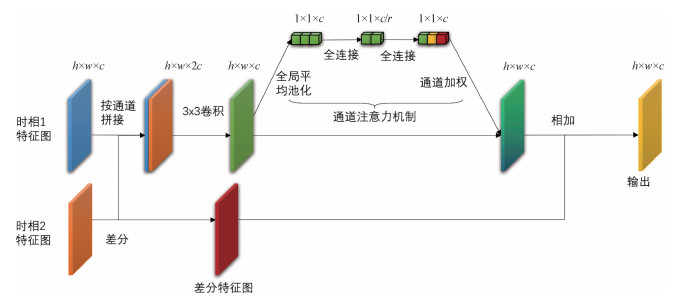

本文将变化残差结构与注意力机制[23]相结合,提出变化注意力残差结构。该结构以两时相特征图为输入,以两期特征图的差分为变化残差路径,以两期特征图的融合为变化特征路径。在变化特征路径中,两期特征图首先按通道拼接,然后对拼接后特征图进行3×3卷积得到通道数与拼接前相同的融合特征图,最后利用通道注意力机制对融合特征图进行通道加权。2个分支的特征图通过相加得到最终变化特征图。通道注意力机制首先对高、宽、道分别为(h, w, c)的特征图进行全局平均池化,得到(1, 1, c)大小的通道向量,通道向量经过2层全连接层和sigmoid函数得到(1, 1, c)大小,值域范围为[0, 1]的注意力向量,该向量与原图按通道相乘得到通道注意力加权后的特征图。图 3展示了本文的变化注意力残差结构示例。与变化残差结构相比,本文的变化注意力残差结构有以下改进:1)利用特征图按通道拼接后卷积的方式实现两时相特征图的融合,与原始变化残差结构直接相加的方式相比,这种方式允许网络学习更丰富的特征图融合模式。2)对融合特征图采用通道注意力机制进行加权,使得网络能够对重要特征给与更高权重。

|

Download:

|

| 图 3 变化注意力残差(CAR)结构示意图 Fig. 3 Structure of the change attention residual module | |

Chen和Shi[24]的实验结果表明,先用图像场景分类数据训练目标检测或语义分割网络的骨架部分进行预训练,再用自己的数据训练目标检测或语义分割网络,能有效提高网络检测精度。然而图像场景分类数据主要来自于日常生活的手持拍摄,与从天顶往地面拍摄的遥感图像在视角、光照条件、纹理等方面均存在较大差异,本文受场景分类预训练的启发,使用建筑物语义分割样本训练网络骨架,以提升网络对建筑物特征的提取与判别能力。建筑物语义分割样本制作成本低于变化检测样本,且变化检测样本通常也是由两期语义分割样本进行对比得到,故本文提出的这种预训练策略如果有效,将充分提高建筑物语义分割样本的利用率,缓解由于变化检测样本制作成本高带来的样本短缺、网络学习不充分从而导致模型精度受限的问题。由于本文变化检测网络骨架部分是一个完整的图像语义分割网络结构,训练建筑物分割时,只需要将输入由两期图像改为一期图像,并以骨架部分输出的分割概率图作为网络最终输出,配合建筑物语义分割样本进行训练。语义分割训练完毕后,将训练好的网络权重保存,在开始变化检测网络训练前首先加载骨架部分的预训练权重,即完成了用语义分割数据对变化检测网络的预训练。训练变化检测期间,骨架部分不再输出语义分割特征图,网络输出来自5层变化注意力残差层的融合。

1.3 精度评价指标本文精度评价指标采用图像分割领域常用的准确率、召回率、F1-score作为评价标准。准确率能反映模型检准率,召回率能反映模型检全率。F1-score综合考虑了模型的精度和召回率,是一种较为全面的检测精度评价指标。具体公式如下

| $ F_1=\frac{2 \text { precision } \times \text { recall }}{\text { precision }+ \text { recall }}. $ | (1) |

| $ \text { precision }=\frac{T_{\mathrm{P}}}{T_{\mathrm{P}}+F_{\mathrm{P}}}. $ | (2) |

| $ \text { recall }=\frac{T_{\mathrm{P}}}{T_{\mathrm{P}}+F_{\mathrm{N}}}. $ | (3) |

其中:precision表示模型准确率,recall代表模型召回率。此处TP表示模型判别为正类而真实标签也为正类的像素个数,FP表示模型判别为正类而真实标签为负类的像素个数,FN表示模型判别为负类而真实标签为正类的个数。联立化简可得到F1-score的最终简化计算公式

| $ F_1=\frac{2 T_{\mathrm{P}}}{2 T_{\mathrm{P}}+F_{\mathrm{P}}+F_{\mathrm{N}}}. $ | (4) |

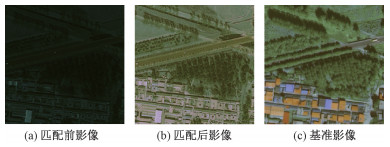

本文以北京市昌平区为研究区域,以2005年QuickBird(分辨率0.6 m)和IKONOS影像(分辨率0.82 m)为变化前底图,以2012年WorldViewⅡ影像(分辨率0.5 m)为变化后底图制作了建筑物变化检测数据集。两期图像经过人工选择控制点,二次多项式校正的方式完成几何配准,偏移控制在一个像素以内。以两时相底图为基础分别标记两期建筑物轮廓。变化轮廓通过计算两期轮廓的并减去两期轮廓的交得到。由于2005年和2012年影像来自不同卫星不同传感器,其成像质量存在明显差异,2005年影像明显过暗,而2012年影像则明亮清晰,本文除使用2005年原始影像外,还以2012年影像色彩为基准,对2005年影像进行了直方图匹配处理。图 4分别展示了2005年原始影像、2005年匹配后影像和2012年影像。

|

Download:

|

| 图 4 影像直方图匹配前后效果对比 Fig. 4 Comparison before and after image histogram matching | |

将处理得到的建筑物轮廓和建筑物变化轮廓转化为二值的栅格图像,其中255表示建筑物或建筑物变化,0表示背景。对配准的2005年影像、2012年影像、建筑物标记影像、建筑物变化标记影像大图进行切割。切图大小为512×512。舍弃变化标签中不包含变化的图像,共得到9 216对图像与标签,按训练集: 验证集: 测试集= 7:2:1的比例进行训练数据划分,训练集用于神经网络的训练,验证集用于判别网络当前精度以指导网络参数的调整,测试集用于最终精度评价。

2.1.2 Levir-CD建筑物变化检测数据集为了将本文方法与现有最新变化检测方法进行对比,本文还在公开数据集Levir-CD[25]上开展了建筑物变化检测实验。Levir-CD数据集由637对1 024×1 024大小的两时相RGB影像对以及对应的建筑物变化标签图像组成,这些影像位于美国德克萨斯州的多个地区,空间分辨率0.5 m。所有影像来自于2002—2018年间的谷歌影像,两时相影像间的时间跨度为5~14 a不等。本文在1 024×1 024大小图像的原图上对其进行裁切,得到256×256大小的样本图像10 192对,与其他现有方法的裁图保持一致。

2.2 实验设置为有效考察本文所提出的变化注意力残差结构和建筑物分割样本预训练2种改进措施对建筑物变化检测精度的提升作用,本文分别在北京昌平数据集上设置4组实验。其中第1组采用孪生网络与原始变化残差结构的组合,将该组作为基准模型; 第2组在第1组基础上采用本文的建筑物分割样本预训练策略; 第3组在第1组基础上用本文的变化注意力残差结构替换原始变化残差结构(基准模型+CAR); 第4组同时使用本文提出的变化注意力残差结构和分割样本预训练策略(基准模型+CAR+预训练)。

为了与最新的基于深度学习的建筑物变化检测方法对比,本文在Levir-CD上进行实验。由于Levir-CD数据集只包含建筑物变化检测标签而不包含建筑物语义分割标签,故分割样本预训练环节利用北京昌平区建筑物分割样本进行预训练。

在神经网络参数设置方面,所有实验保持一致:采用Adam优化器对网络参数进行训练,学习率设置为以0.000 2为基础在第30、50、80、110、170、190轮训练周期降为原来的1/2,总训练周期为200轮。每次迭代的样本批次大小设置为6。损失函数选取像素级语义分割常用的二元交叉熵损失函数。二元交叉熵损失函数(BCELoss)计算公式如下

| $ \begin{gathered} \operatorname{BCELoss}\left(Y_{\text {out}}, Y_{\text {label}}\right)= \\ Y_{\text {label}} \log \left(Y_{\text {out}}\right)+\left(1-Y_{\text {label}}\right) \log \left(1-Y_{\text {out}}\right). \end{gathered} $ | (5) |

其中:Yout表示模型预测值, 范围为[0, 1],Ylabel表示真实标签,为1表示建筑物变化,为0表示背景。

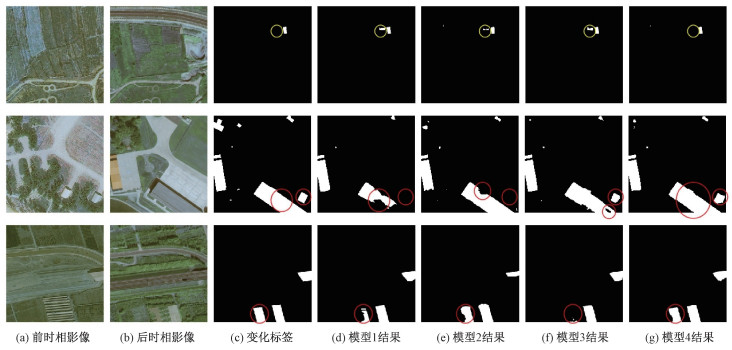

2.3 实验结果 2.3.1 模型改进有效性分析图 5展示了测试集的检测结果对比图,表 1展示了北京昌平数据集上的各方法精度对比。从表 1可以看到在基准模型基础上单独添加变化注意力残差结构或分割样本预训练策略均能有效提升变化检测F1-score(分别获得0.700 3和0.703 2,高于基准模型的0.688 9),同时使用2种方法时能进一步提升精度,获得了最高的F1-score: 0.712 0。说明本文所提出的2种改进方案均能有效提升建筑物变化检测精度。从图 5第1行黄色圆圈位置可以看到2种方法相结合后有效解决了图中误检问题。从第2第3行红色圆圈位置可以看到2种方法相结合的检测结果漏检更少,轮廓更完整。

|

Download:

|

| 图 5 北京昌平数据集测试结果对比 Fig. 5 Comparison of testing results of Beijing-Changping dataset | |

|

|

表 1 北京昌平数据集精度对比 Table 1 Accuracy comparison of Changping dataset |

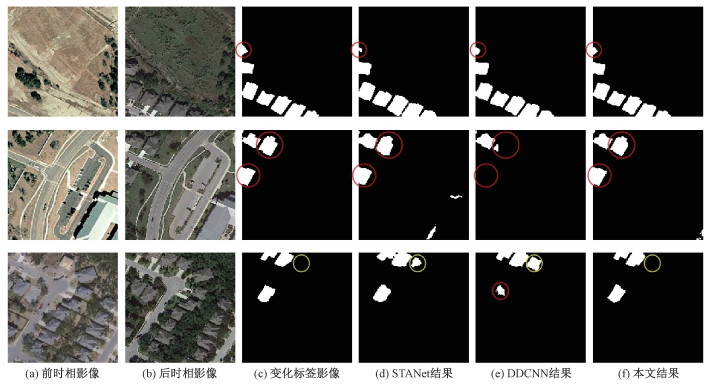

本文在Levir-CD公开数据集上开展对比实验,将本文方法与最新的基于深度学习的建筑物变化检测方法STANet[25]和DDCNN[26]进行对比。图 6展示了测试集上检测结果对比图,表 2展示了该数据集上各方法的测试集精度。

|

Download:

|

| 图 6 Levir-CD测试集检测结果对比图 Fig. 6 Comparison of testing results of Levir-CD dataset | |

|

|

表 2 Levir-CD数据集精度对比 Table 2 Accuracy comparison of Levir-CD |

从表 2可以看到本文方法的准确度和召回率均高于0.9,F1-score达到0.916 6,高于其他同类型深度学习方法1.5%以上。

从图 6第1、第2行红色圆圈区域可以看到本文方法较其他方法漏检更少。从图 6第3行黄色圆圈区域可以看到本文方法较其他方法误检更少。

3 结论本文在孪生卷积神经网络基础上,提出变化注意力残差结构,有效提升了孪生网络的变化检测精度。此外还提出使用建筑物分割样本对变化检测网络骨架进行预训练的策略,该策略能充分利用现有建筑物语义分割样本来训练建筑物变化检测网络。以北京市昌平区为研究区域,以2005与2012年影像为底图,制作了昌平区建筑物变化检测数据集。在昌平数据集上的实验结果表明,本文提出的分割样本预训练策略和变化注意力残差结构能够有效提高建筑物变化检测精度。在公开数据集Levir-CD上的实验结果表明,该方法与同类型方法相比具备精度优势。本文提出的建筑物变化检测流程能为地理国情监测提供重要的方法基础。

| [1] |

张良培, 武辰. 多时相遥感影像变化检测的现状与展望[J]. 测绘学报, 2017, 46(10): 1447-1459. |

| [2] |

马建文, 田国良, 王长耀, 等. 遥感变化检测技术发展综述[J]. 地球科学进展, 2004, 19(2): 192-196. |

| [3] |

杜培军, 王欣, 蒙亚平, 等. 面向地理国情监测的变化检测与地表覆盖信息更新方法[J]. 地球信息科学学报, 2020, 22(4): 857-866. |

| [4] |

Lu L L, Guo H D, Corbane C, et al. Urban sprawl in provincial capital cities in China: evidence from multi-temporal urban land products using Landsat data[J]. Science Bulletin, 2019, 64(14): 955-957. Doi:10.1016/j.scib.2019.04.036 |

| [5] |

Huang X, Zhang L P, Zhu T T. Building change detection from multitemporal high-resolution remotely sensed images based on a morphological building index[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2014, 7(1): 105-115. Doi:10.1109/JSTARS.2013.2252423 |

| [6] |

Tang Y Q, Huang X, Zhang L P. Fault-tolerant building change detection from urban high-resolution remote sensing imagery[J]. IEEE Geoscience and Remote Sensing Letters, 2013, 10(5): 1060-1064. Doi:10.1109/LGRS.2012.2228626 |

| [7] |

Huang X, Zhu T T, Zhang L P, et al. A novel building change index for automatic building change detection from high-resolution remote sensing imagery[J]. Remote Sensing Letters, 2014, 5(8): 713-722. Doi:10.1080/2150704X.2014.963732 |

| [8] |

Sofina N, Ehlers M. Building change detection using high resolution remotely sensed data and GIS[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2016, 9(8): 3430-3438. Doi:10.1109/JSTARS.2016.2542074 |

| [9] |

Gueguen L, Pesaresi M, Ehrlich D, et al. Urbanization detection by a region based mixed information change analysis between built-up indicators[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2013, 6(6): 2410-2420. Doi:10.1109/JSTARS.2013.2246547 |

| [10] |

Huang X, Wen D W, Li J Y, et al. Multi-level monitoring of subtle urban changes for the megacities of China using high-resolution multi-view satellite imagery[J]. Remote Sensing of Environment, 2017, 196: 56-75. Doi:10.1016/j.rse.2017.05.001 |

| [11] |

Krizhevsky A, Sutskever I, Hinton G E. ImageNet classification with deep convolutional neural networks[J]. Communications of the ACM, 2017, 60(6): 84-90. Doi:10.1145/3065386 |

| [12] |

Shelhamer E, Long J, Darrell T. Fully convolutional networks for semantic segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(4): 640-651. Doi:10.1109/TPAMI.2016.2572683 |

| [13] |

Ren S Q, He K M, Girshick R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149. Doi:10.1109/TPAMI.2016.2577031 |

| [14] |

Gong J Q, Hu X Y, Pang S Y, et al. Patch matching and dense CRF-based co-refinement for building change detection from bi-temporal aerial images[J]. Sensors, 2019, 19(7): 1557. Doi:10.3390/s19071557 |

| [15] |

Ji S P, Shen Y Y, Lu M, et al. Building instance change detection from large-scale aerial images using convolutional neural networks and simulated samples[J]. Remote Sensing, 2019, 11(11): 1343. Doi:10.3390/rs11111343 |

| [16] |

Caye Daudt R, Le Saux B, Boulch A. Fully convolutional siamese networks for change detection[C]// International Conference on Image Processing. Athens, Greece: IEEE, 2018: 4063-4067.

|

| [17] |

Zhan Y, Fu K, Yan M L, et al. Change detection based on deep Siamese convolutional network for optical aerial images[J]. IEEE Geoscience and Remote Sensing Letters, 2017, 14(10): 1845-1849. Doi:10.1109/LGRS.2017.2738149 |

| [18] |

El Amin A M, Liu Q J, Wang Y H. Zoom out CNNs features for optical remote sensing change detection[C]// International Conference on Image, Vision and Computing. Chengdu, China: IEEE, 2017: 812-817.

|

| [19] |

Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition[C]// International Conference on Learning Representations. San Diego, CA, USA: Computational and Biological Learning Society, 2015: 1-14.

|

| [20] |

Caye Daudt R, Le Saux B, Boulch A, et al. Multitask learning for large-scale semantic change detection[J]. Computer Vision and Image Understanding, 2019, 187: 102783. Doi:10.1016/j.cviu.2019.07.003 |

| [21] |

Bao T F, Fu C Q, Fang T, et al. PPCNET: a combined patch-level and pixel-level end-to-end deep network for high-resolution remote sensing image change detection[J]. IEEE Geoscience and Remote Sensing Letters, 2020, 17(10): 1797-1801. Doi:10.1109/LGRS.2019.2955309 |

| [22] |

Jiang H W, Hu X Y, Li K, et al. PGA-SiamNet: pyramid feature-based attention-guided siamese network for remote sensing orthoimagery building change detection[J]. Remote Sensing, 2020, 12(3): 484. Doi:10.3390/rs12030484 |

| [23] |

He K M, Zhang X Y, Ren S Q, et al. Deep residual learning for image recognition[C]// Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV, USA: IEEE, 2016: 770-778.

|

| [24] |

Chen H, Shi Z W. A spatial-temporal attention-based method and a new dataset for remote sensing image change detection[J]. Remote Sensing, 2020, 12(10): 1662. Doi:10.3390/rs12101662 |

| [25] |

Peng X L, Zhong R F, Li Z, et al. Optical remote sensing image change detection based on attention mechanism and image difference[J]. IEEE Transactions on Geoscience and Remote Sensing, 2020. |

| [26] |

Hu J, Shen L, Sun G. Squeeze-and-excitation networks[C]// Proceedings of the IEEE conference on computer vision and pattern recognition. Salt Lake City, UT, USA: IEEE, 2018: 7132-7141.

|

2023, Vol. 40

2023, Vol. 40