2. 中国科学院上海微系统与信息技术研究所,上海 200050;

3. 中国科学院大学,北京 100049

2. Shanghai Institute of Microsystem & Information Technology, Chinese Academy of Sciences, Shanghai 200050, China;

3. University of Chinese Academy of Sciences, Beijing 100049, China

近年来,随着数据信息化程度不断上升,网络数据库容量不断增加,如何在数据库中迅速地搜寻到准确的信息成为亟需解决的问题。由于自然语言具有多义性、复杂性和模糊性的多重特点,因此需要将文本中提到的实体与其知识库中的实体连接起来。实体链接主要是要解决实体间的歧义问题,在网络检索、信息提取和知识库填充等问题中有着广泛的应用。实体语义表达的模糊性和数据容量的日益增加,给实体歧义辨别带来很大的挑战。

实体歧义分为2种: 一种是多词同义,指多个词语代表同一个意思;另一种是一词多义,是指一个实体名称可以指代多个不同的实体。作者姓名消歧是实体消歧中的一个重要应用,已知同名作者的所有文章集合,需要通过文章的一些属性特征对文章进行聚类,使每一个聚类仅包含一个作者的文章。作者姓名消歧任务在作者文献检索、学术画像分析中有着重要的价值。例如,在学术检索时,研究者需要在文献数据库中寻找名为“Charles”的学者的文献,但是由于“Charles”在数据库中对应着很多不同的实体,系统返回了所有名为“Charles”的作者撰写的文献,这会大大降低文献检索结果的有效性和准确性,从而降低网络搜索的性能。如果将搜索结果分组在一起,则搜索的有效性可以大大提高。另外,当计算学者影响力的时候,需要准确了解每一位学者的文章类型及数目。因此,作者姓名消歧问题是近年来研究者的研究热点之一。

目前,已经有一些文献研究作者姓名消歧问题。一些学者将作者姓名消歧视为分类任务,预测每篇论文的正确标签或预测2篇文章是否由同一作者撰写。分类任务需要大量标签,所以这类任务通常是有监督的。

例如,Wang等[1]提出基于增强树的分类方法,通过文档的标题、作者、机构、摘要等属性判断2篇文章是否由同一作者撰写。深度神经网络模型[2]也被用于提取文档属性特征进行分类。其他一些方法利用了外部数据。如Han等[3]提出朴素贝叶斯概率生成模型和支持向量机模型并将这2种方法分别应用于从Web收集的数据和DBLP数据库。

另外一些工作采用无监督的聚类方法。无监督的姓名消歧任务是将文献分为几个簇,使得每个簇仅包括由一个作者所撰写的文献。

Cen等[4]通过优化线性回归模型对成对文章相似性进行建模,提出一种具有自适应停止准则的层次聚类方法。基于Dempster-Shafer理论(DST)的分层聚类方法[5]将每个文档嵌入到低维向量空间中进行聚类,通过定义2个文档各个特征之间的相似度来计算它们文档之间的相似度,将相似度大于阈值的文档划分到同一个簇中。另外一些学者利用概率模型表示文档之间的相似性[6-8]。

监督方法需要大量的标记数据,而人工标记需要昂贵的人力和财力。但是对于无监督算法,要找到最佳数目的聚类或者合适的相似性阈值具有一定的挑战性。因此也有许多学者提出半监督算法。

Levin等[9]提出一种结合分类和聚类方法的2阶段算法。在第1阶段,他们应用基于论文引用及其他的高精度规则自动生成用于有监督训练的标记数据。在第2阶段,将正例和负例用作有监督的分类器,该分类器用于预测2篇文章是否由同一作者撰写,最后将分类器的预测结果用作聚类中的相似性度量。Louppe等[10]在此基础上提出用于预处理的区域策略,将很有可能属于同一作者的文献放置于同一区域。

随着近2年图网络研究的兴起,由于作者及其刊物可以自然地构建作者-作者网络和文档-文档网络,因此一些基于图的方法也被用于姓名消歧任务。谱聚类[11]可以将图划分为几个部分从而进行聚类。Zhang等[12]提出结合全局度量学习和局部链接图模型,通过文档的属性特征学习文档的低维表征。Zhang和Hasan[13]将文章信息预处理为3个图网络:作者-作者图,文档-文档图和作者-文档图,并将文档数据投影到低维空间中。GHOST模型[14]利用作者图来计算图节点对之间的相似度。除此之外,还有基于文章对的图网络(ADANA)[15]和基于标题与共同作者的图网络(GFAD)[16]。

当前研究方法存在一些问题:1)监督方法因为使用了标注信息,所以消歧性能一般会好于无监督方法。但是由于数据集规模通常较大,人工标注所有的标签会耗费大量的人力和时间。2)现有的大多数研究方法通常只基于文献的属性特征或者基于文献关系、作者关系的研究。利用文献属性特征的方法通常采用大量的属性特征并制定相应的规则,在数据有缺失的时候会导致规则失效。基于关系图的研究往往忽略文档的基础属性特征,降低了消歧的效果。3)目前作者姓名消歧问题中大多数研究方法都是应用于小规模数据集,通常只包含10~20个作者文献集,本研究希望将研究方法应用于更大规模的数据集。

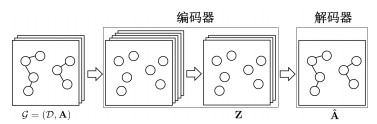

本文针对更大规模的数据集(100个待消歧作者姓名),提出一种基于文献属性特征和关系图网络的姓名消歧方法(如图 1所示)。该方法同时考虑文档的属性特征以及多个关系网络的信息,通过无监督学习的方法寻找文档表征向量,使用簇数标签进行层次聚类,取得良好的姓名消歧效果。在作者数据集AMiner上的测试结果表明:该方法优于使用大量文档标签和簇数的半监督方法[12],也优于其他基于图网络的方法[13-14]。另外,本文通过可视化的方式增加了模型的可解释性。

|

Download:

|

| 图 1 基于特征编码和图网络的姓名消歧方法 Fig. 1 Name disambiguation on encoding attributes and graph topology | |

假设

在姓名消歧任务中,i代表一个作者姓名。消歧任务就是找到合适的函数将与这个姓名相关的文档划分到不同的类别中,使得每个类别中仅包含同一作者的文档。给定一个文档集合

| $ \Phi\left(\mathcal{D}^{i}\right) \rightarrow \mathcal{C}^{i}. $ | (1) |

Word2vec模型被广泛用于单词表示学习中。本文利用word2vec的模型之一CBOW[17]用于学习文档的向量表示。

假设有一系列训练词w1, w2, …, wT,CBOW模型通过某单词周围其他单词的出现频率预测这个单词的出现频率。该模型根据训练语料库中预定义上下文窗口内词的出现频率来学习单词向量。目标是最大化出现在预定义上下文窗口中的单词的共现概率,概率函数表示为

| $ \frac{1}{T} \sum\limits_{1}^{T} \sum\limits_{-c \leqslant j \leqslant c, j \neq 0} \log p\left(\boldsymbol{w}_{t} \mid \boldsymbol{w}_{t+j}\right) . $ | (2) |

其中c代表预定义窗口大小。

本文将文档属性特征编码至文档向量中。将文献属性特征分割为单个词语并保留词干,用词干特征

| $ \boldsymbol{d}_{n}=\sum\limits_{i=1}^{M^{\prime}} \alpha_{i} \tilde{\boldsymbol{f}}_{i}. $ | (3) |

其中:αi是

对于每一个待消歧的作者姓名i,

在本文中,邻接矩阵由2种方法构建:一是计算两两文档之间的特征相似性,二是利用高精确度的规则。2个文档相似度由2个文档的共同特征进行计算。假设2个文档的共同特征为

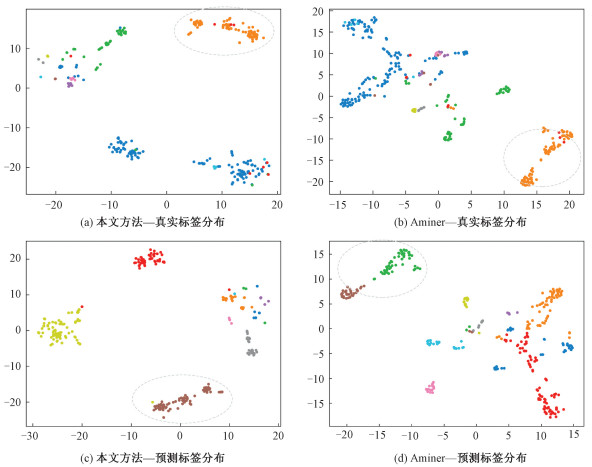

如图 2所示,本文使用变分图自动编码器用于增强模型的泛化能力。假设

| $ q(\boldsymbol{Z} \mid \boldsymbol{X}, \boldsymbol{A})=\prod\limits_{i=1}^{N} q\left(\boldsymbol{z}_{i} \mid \boldsymbol{X}, \boldsymbol{A}\right). $ | (4) |

|

Download:

|

| 图 2 变分图自动编码器 Fig. 2 Variational graph auto-encoder | |

其中

| $ q\left(z_{i} \mid \boldsymbol{X}, \boldsymbol{A}\right)=\mathcal{N}\left(\boldsymbol{z}_{i} \mid \mu_{i}, \operatorname{diag}\left(\boldsymbol{\sigma}_{i}^{2}\right)\right). $ | (5) |

| $ \operatorname{GCN}(\boldsymbol{X}, \boldsymbol{A})=\tilde{\boldsymbol{A}} \operatorname{Relu}\left(\tilde{\boldsymbol{A}} \boldsymbol{X} \boldsymbol{W}_{0}\right) \boldsymbol{W}_{1}. $ | (6) |

GCNμ(X, A)和GCNσ(X, A)共享权重矩阵W0,权重矩阵W1不同。

解码器通过线性层重构邻接矩阵

| $ p(\boldsymbol{A} \mid \boldsymbol{Z})=\prod\limits_{i=1}^{N} \prod\limits_{j=1}^{N} p\left(\boldsymbol{A}_{i j} \mid \boldsymbol{z}_{i}, \boldsymbol{z}_{j}\right). $ | (7) |

其中

| $ p\left(\boldsymbol{A}_{i j} \mid \boldsymbol{z}_{i}, \boldsymbol{z}_{j}\right)=\boldsymbol{\sigma}\left(\boldsymbol{z}_{i}^{\mathrm{T}} \boldsymbol{z}_{j}\right), $ | (8) |

σ(·)是sigmoid函数。自动编码器的优化目标是使得重构的邻接矩阵

| $ \begin{gathered} \mathcal{L}=E_{q(\boldsymbol{Z} \mid \boldsymbol{X}, \boldsymbol{A})}[\log p(\boldsymbol{A} \mid \boldsymbol{Z})]- \\ \mathrm{KL}[q(\boldsymbol{Z} \mid \boldsymbol{X}, \boldsymbol{A}) \| p(\boldsymbol{Z})]. \end{gathered} $ | (9) |

等式右边第1项表示交叉熵函数,第2项中

将编码器输出矩阵Z=[z1T, z2T, …]中的每一项作为待消歧文档的新的向量表示。通过引入节点间的关系信息,输出矩阵具有更强的表征性能。

2.3 图网络嵌入如果仅利用图自动编码器,在引入节点关系的时候只考虑到文档特征之间的相关性。当出现表 1所示情况时,无法判断文档1和文档2是否由同一作者所撰写。引入文档3和前2个文档之间的关系后,因为2篇文章的所有合作者都是文档3的作者,所以可以判断出2篇文章属于同一作者。

|

|

表 1 合作者相关联的文档 Table 1 Related documents refer to one-hop co-author |

本文研究希望通过利用合作者关系进一步推断文档相似性,并将合作者关系网络信息嵌入文档表征向量Z中。提取网络结构信息的方法有Deepwalk[18]、GCN[19]等。本文通过构建作者-作者网络、文档-作者网络和文档-文档网络,聚集有关系的作者和文档向量。

对于待消歧作者姓名i,构建作者-作者网络

文档之间的关系可以由文档-文档网络

为了将合作者关系引入文档关系中,使待消歧文档可以更好地被聚类,本文构建图网络

文档间相似性度量定义为

| $ p\left(S_{i j} \geqslant S_{i t} \mid \boldsymbol{z}_{i}, \boldsymbol{z}_{j}, \boldsymbol{z}_{t}\right)={\sigma}\left(S_{i j}^{\mathrm{dd}}-S_{i t}^{\mathrm{dd}}\right). $ | (10) |

对于待消歧文档集合

| $ p(\mathcal{D})=\prod\limits_{\substack{\left(\boldsymbol{d}_{i}, \boldsymbol{d}_{j}\right) \in \mathcal{P}_{\mathcal{G}_{\rm{dd}}} \\\left(\boldsymbol{d}_{i}, \boldsymbol{d}_{t}\right) \in \mathcal{N}_{\mathcal{G}_{\rm{dd}}}}} \sigma\left(S_{i j}^{\mathrm{dd}}-S_{i t}^{\mathrm{dd}}\right) . $ | (11) |

对于文档-文档网络,希望这个概率更大,所以需要最大化这个概率

| $ \mathcal{L}_{\mathrm{dd}}=\min _{\mathcal{D}}-\ln p(\mathcal{D}). $ | (12) |

类似地,对于作者-作者网络和作者-文档网络:

| $ \mathcal{L}_{\mathrm{pp}}=\min _{\mathcal{A}}-\ln p(\mathcal{A}), $ | (13) |

| $ \mathcal{L}_{\mathrm{pd}}=\min _{\mathcal{A}, \mathcal{D}}-\ln p(\mathcal{A}, \mathcal{D}) . $ | (14) |

目标是将3个网络的拓扑结构信息嵌入文档表征向量中,优化函数为

| $ \mathcal{L}=\min _{\mathcal{A}, \mathcal{D}} \mathcal{L}_{\mathrm{dd}}+\mathcal{L}_{\mathrm{pp}}+\mathcal{L}_{\mathrm{pd}}+\lambda\left(\|\boldsymbol{A}\|_{\mathrm{F}}^{2}+\|\boldsymbol{Z}\|_{F}^{2}\right) . $ | (15) |

其中:A为合作者构成的矩阵,Z代表微调后的待消歧文档矩阵。通过训练图嵌入模型,文档表征向量中包含了文献属性特征及3个图网络的拓扑信息。

2.4 聚类对图网络嵌入模型训练后的文档表征向量应用层次聚类算法[20]。该算法将训练样本中的每一个数据点都当作一个簇,然后计算每2个样本点之间的距离并合并距离最近的簇,直到满足终止条件。本文将终止条件设置为簇个数等于真实聚类个数。

3 仿真实验 3.1 仿真设置本文使用在线学术搜索和数据挖掘系统AMiner[21]上采样的100个作者姓名数据集,每个姓名都对应着与这个姓名相关联的文档,采样数据集共包含27 128篇文献和1 066个真实作者。

超参数设置上,CBOW模型中,文档表征向量维度设置为100,预定义上下文窗口为5。变分图自编码器中,逆文档频率的阈值为25,第1层图卷积网络输出维数为200,第2层图卷积网络输出维度设置为100,学习率为0.01,迭代200次。图网络嵌入模型中,学习率为0.05,正则化参数为0.01。

3.2 性能比较在仿真实验中,对比本文方法与其他几个基于图网络的姓名消歧方法。Zhang等[12]提出一种合并全局表示学习和局部嵌入学习的方法(Aminer)。在全局表示学习中,需要引入标签信息构建正负样本。在局部嵌入学习方法中使用图自动编码器。Zhang和Hasan[13]将作者-作者、作者-文档、文档-文档网络信息压缩至低维空间。GHOST模型[14]只考虑作者合著关系,在每个合作者间建立网络,通过选择有效路径计算作者节点之间的相关性划分作者聚类。并查集方法通过合作者和隶属机构的严格匹配在文档间建立图连接,将所有有连接关系的文档节点构成一个集群。

本文使用pairwise Precision、Recall和F1值[22]对模型进行性能比较。对100个消歧作者数据集计算每个指标的平均值。表 2显示不同的消歧方法在AMiner数据集上的仿真结果。可以看到,本文提出的方法在表中15个姓名中有11个都表现最佳,平均F1值比Aminer算法[12]提高3.87%,比Zhang和Hasan[13]的算法高25%,比GHOST模型[14]高33.85%。

|

|

表 2 几种基于图网络的姓名消歧方法的聚类结果 Table 2 Clustering results of different graph-based name disambiguation methods |

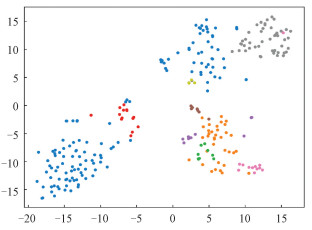

图 3是一个待消歧文档数据集通过本文方法与Aminer学习后的文档表征向量的2维空间可视化,图 3(a)、3(b)中不同的颜色表示不同的真实集群。图 3(c)、3(d)为预测集群分布。在此数据集上,本文提出的方法的F1值为0.633 8,Aminer方法仅为0.538 2。从图 3(d)虚线内的样本可以看出,Aminer方法学习后的文档表征向量在向量空间中距离较远,样本并没有被正确归类。而本文提出的方法通过将相似的表征向量聚集在一起,如图 3(a)的橙色散点表示,输出的文档表征向量更加接近,图 3(c)中并没有将这些散点划分错误,从而实现了更好的聚类效果。

|

Download:

|

| 图 3 不同姓名消歧方法聚类结果的可视化 Fig. 3 Visualization of clustering results of different name disambiguation methods | |

从表 2中可以看到对于其中的4个姓名Aminer方法更好,为进一步分析其中的原因,本文选取作者姓名为“Rong Yu”的文档集合并对本文方法与Aminer模型的聚类结果进行比较。

图 4为在这个文档数据集上2种方法聚类结果的可视化对比。从图 4(b)中的蓝色散点可以看出,通过Aminer方法学习文档向量表征后,属于这个作者的文档向量主要集中在2个区域,而本文的方法将更多的点集中到左侧椭圆虚线框内,如图 4(a)所示,这意味着本文方法将更多的文档划分到了正确的类中。但是因为本文方法将很多文档向量从右侧虚线框内移出,导致其余的文档向量在向量空间中太过分散,从图 4(c)中可以看出,这些文档向量被划分为3个不同的类。在图 4(d)中,这些文档向量虽然也被划分到另一个类别中,但是根据聚类方法中pairwise F1值的计算方法可知,这些文档向量组成的两两文档对在预测集和真实集中仍然都属于同一个类别,仍算作True-Positive文档对。因此在作者姓名为“Rong Yu”的文档数据集上,Aminer的F1值高于本文提出的方法。

|

Download:

|

| 图 4 Rong Yu文档集合上的聚类结果对比 Fig. 4 Comparison of clustering results on the document set of Rong Yu | |

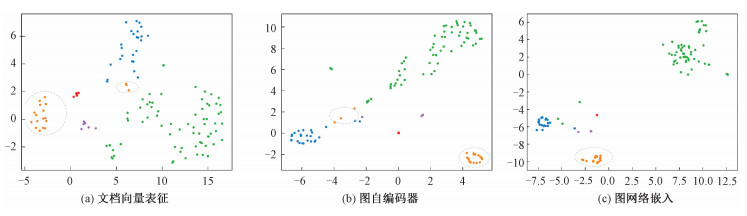

图 5为使用word2vec构建文档向量表征后直接对该文档集合中的文档向量进行聚类的结果可视化。从蓝色散点可以看出,进行文档向量表征后属于同一作者的文档向量就被划分到了向量空间中不相连的2个区域中,从文档属性特征分析,代表这个作者的文章有2个强属性特征,他的大部分文章都与其中一个属性相关,例如他可能有2个不同的研究方向,这2部分文章的特征词并不相关,所以在特征编码后与他相关的文档向量分布在2个区域。而本文方法在引入关系信息后使得模型能够区分出其中一部分文档。但是由于并不能覆盖到所有的文档,在属性特征关系弱的数据集中,文档向量分布较为分散,本文的方法会导致一部分文章被划分到多个不同的类别中,而Aminer方法虽然也没有将这些文档划分到正确的类别中,但是保留了它们彼此之间的联系,使得这些文档被划分为同一个类别,所以本文方法的聚类结果的F1值相对较低。

|

Download:

|

| 图 5 文档向量表征后的聚类结果 Fig. 5 Clustering results after document representation | |

为了展示本文方法中文档向量表征、变分图自编码器、图嵌入模型各自的作用与聚类效果,本节将每个组件分开评估。图自动编码器和图网络嵌入模型建立于构建了文档向量表征之后。如表 3所示,图自编码器和图网络嵌入分别将模型的F1值提高了0.064 1和0.048 3。而本文提出的综合方法取得了最高的准确率和召回率。图 6为每个子模型训练后学习的文档向量的低维可视化,这里使用真实标签在文档表征空间的分布,不同颜色代表不同作者所撰写的文档向量。由图 6可以看出,图自编码器将绿色点和蓝色点聚集在了一起,而图网络嵌入使这些点更加接近使得模型可以更准确地聚类。同时,图网络嵌入模型将离群的黄色点移动到了正确的区域,所以本文的模型对异常值有一定效果。

|

|

表 3 组件性能分析 Table 3 Clustering results of each component |

|

Download:

|

| 图 6 各组件聚类结果可视化 Fig. 6 Visualization of clustering results of each component | |

本文基于图网络提出一种新的作者姓名消歧方法,该方法通过文档表征、图自动编码器和图嵌入模型来编码所有论文的属性特征和作者及论文的关系图拓扑结构。采样于数据挖掘系统AMiner的数据集被用于验证本文提出的图网络姓名消歧方法,仿真结果证明本文提出的模型优于目前其他几种基于图网络的姓名消歧方法。

| [1] |

Wang J, Berzins K, Hicks D, et al. A boosted trees method for name disambiguation[J]. Scientometrics, 2012, 93(2): 391-411. Doi:10.1007/s11192-012-0681-1 |

| [2] |

Tran H N, Huynh T, Do T. Author name disambiguation by using deep neural network[C]//Intelligent Information and Database Systems. ACⅡDS 2014. Lecture Notes in Computer Science, Spvinger, Cham. 2014, 8397: 123-132. DOI: 10.1007/978-3-319-05476-6_13.

|

| [3] |

Han H, Giles L, Zha H, et al. Two supervised learning approaches for name disambiguation in author citations[C]//Proceedings of the 2004 Joint ACM/IEEE Conference on Digital Libraries, 2004. Tucson, AZ, USA. IEEE, 2004: 296-305. DOI: 10.1145/996350.996419.

|

| [4] |

Cen L, Dragut E C, Si L, et al. Author disambiguation by hierarchical agglomerative clustering with adaptive stopping criterion[C]//Proceedings of the 36th International ACM SIGIR Conference on Research and Development in Information Retrieval. Dublin Ireland. New York, NY, USA: ACM, 2013: 741-744. DOI: 10.1145/2484028.2484157.

|

| [5] |

Wu H, Li B, Pei Y J, et al. Unsupervised author disambiguation using Dempster-Shafer theory[J]. Scientometrics, 2014, 101(3): 1955-1972. Doi:10.1007/s11192-014-1283-x |

| [6] |

Song Y, Huang J, Councill I G, et al. Efficient topic-based unsupervised name disambiguation[C]//Proceedings of the 7th ACM/IEEE-CS Joint Conference on Digital Libraries. June 18-23, 2007. Vancouver, BC, Canada. New York: ACM Press, 2007: 342-351. DOI: 10.1145/1255175.1255243.

|

| [7] |

Tang J, Fong A C M, Wang B, et al. A unified probabilistic framework for name disambiguation in digital library[J]. IEEE Transactions on Knowledge and Data Engineering, 2012, 24(6): 975-987. Doi:10.1109/TKDE.2011.13 |

| [8] |

Tang J, Qu M, Mei Q Z. PTE: predictive text embedding through large-scale heterogeneous text networks[C]//Proceedings of the 21th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. 2015: 1165-1174. DOI: 10.1145/2783258.2783307.

|

| [9] |

Levin M, Krawczyk S, Bethard S, et al. Citation-based bootstrapping for large-scale author disambiguation[J]. Journal of the American Society for Information Science and Technology, 2012, 63(5): 1030-1047. Doi:10.1002/asi.22621 |

| [10] |

Louppe G, Al-Natsheh H T, Susik M, et al. Ethnicity sensitive author disambiguation using semi-supervised learning[C]//International Conference on Knowledge Engineering and the Semantic Web. Springer, Cham, 2016: 272-287. DOI: 10.1007/978-3-319-45880-9_21.

|

| [11] |

Han H Y, Zha H, Giles C L. Name disambiguation in author citations using a K-way spectral clustering method[C]//Proceedings of the 5th ACM/IEEE-CS joint conference on Digital libraries (JCDL'05). June 7-11, 2005, Denver, CO, USA. IEEE, 2005: 334-343. DOI: 10.1145/1065385.1065462.

|

| [12] |

Zhang Y T, Zhang F J, Yao P R, et al. Name disambiguation in AMiner: clustering, maintenance, and human in the loop[C]//Proceedings of the 24th ACM SIGKDD International Conference on Knowledge Discovery & Data Mining. 2018: 1002-1011. DOI: 10.1145/3219819.3219859.

|

| [13] |

Zhang B C, Hasan M A. Name disambiguation in anonymized graphs using network embedding[C]//Proceedings of the 2017 ACM on Conference on Information and Knowledge Management. Singapore, Singapore. New York, NY, USA: ACM, 2017: 1239-1248. DOI: 10.1145/3132847.3132873.

|

| [14] |

Fan X M, Wang J Y, Pu X, et al. On graph-based name disambiguation[J]. Journal of Data and Information Quality, 2011, 2(2): 1-23. Doi:10.1145/1891879.1891883 |

| [15] |

Wang X Z, Tang J, Cheng H, et al. ADANA: active name disambiguation[C]//2011 IEEE 11th International Conference on Data Mining. December 11-14, 2011, Vancouver, BC, Canada. IEEE, 2011: 794-803. DOI: 10.1109/ICDM.2011.19.

|

| [16] |

Shin D, Kim T, Choi J, et al. Author name disambiguation using a graph model with node splitting and merging based on bibliographic information[J]. Scientometrics, 2014, 100(1): 15-50. Doi:10.1007/s11192-014-1289-4 |

| [17] |

Mikolov T, Sutskever I, Chen K, et al. Distributed representations of words and phrases and their compositionality[C]//Advances in Neural Information Processing Systems(NIPS). 2013: 3111-3119.

|

| [18] |

Perozzi B, Al-Rfou R, Skiena S. DeepWalk: online learning of social representations[C]//Proceedings of the 20th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. New York, NY, USA: ACM, 2014: 701-710. DOI: 10.1145/2623330.2623732.

|

| [19] |

Kipf T N, Welling M. Semi-supervised classification with graph convolutional networks[EB/OL]. arXiv: 1609.02907. (2016-11-03)[2020-02-10]. https://arxiv.org/abs/1609.02907.

|

| [20] |

Ward Jr J H. Hierarchical grouping to optimize an objective function[J]. Journal of the American statistical association, 1963, 58(301): 236-244. Doi:10.1080/01621459.1963.10500845 |

| [21] |

Tang J, Zhang J, Yao L M, et al. ArnetMiner: extraction and mining of academic social networks[C]//Proceedings of the 14th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining. August 24-27, 2008. Las Vegas, Nevada, USA. New York, NY, USA: ACM Press, 2008: 990-998. DOI: 10.1145/1401890.1402008.

|

| [22] |

Menestrina D, Whang S E, Garcia-Molina H. Evaluating entity resolution results[J]. Proceedings of the VLDB Endowment, 2010, 3(1/2): 208-219. Doi:10.14778/1920841.1920871 |

2022, Vol. 39

2022, Vol. 39