2. 中国石油东方地球物理公司, 河北涿州 072751

2. BGP, CNPC, Zhuozhou, Hebei 072751, China

随着中国城镇化的迅速发展,地震勘探工区内的地表变得更加复杂,道路、建筑物和人工湖等障碍物的数量不断增加,严重影响了地震勘探的资料质量和施工效率。地震采集观测系统设计需要从遥感影像中提取障碍物的多边形边界,根据边界对炮点和检波点进行偏移避障,完成观测系统变观[1]。传统变观方法通常依靠人工标记障碍区,但由于工区内障碍物数量较多、形状轮廓多变,手动提取障碍物信息效率低,需要大量时间和人力成本[2]。此外,受到植被等其他地物的遮挡和勘探人员主观性的影响,人工方式难以保证障碍区提取的一致性。因此,利用计算机自动和精准地从遥感影像中提取障碍区,提高观测系统变观处理的效率和可靠性,一直以来都是工业和学术界研究人员关注的热点。

随着深度学习技术的发展,卷积神经网络(Convolutional Neural Network,CNN)被应用于图像语义分割任务,为自动提取遥感影像中的障碍物提供了可行方案。Long等[3]提出的全卷积神经网络(Fully Convolutional Network,FCN)在输出端使用卷积层替换经典CNN的全连接层,首次实现了像素级别的图像分割。Ronneberger等[4]通过跳跃连接融合网络前、后的低维细节纹理特征与高维语义特征,能够较精准地分割遥感影像中的障碍区。Zhao等[5]提出的PSPNet(Pyramid Scene Parsing Network)在池化金字塔模块中通过并联不同尺寸的全局池化层,聚合不同区域的上、下文信息,从而提高网络获取全局信息的能力。Zhou等[6]提出的D-LinkNet使用经过预训练的ResNet[7]作为特征提取主干,并在网络中心瓶颈使用串、并联相结合的组合空洞卷积融合语义特征,有效提高了跨度较大的障碍物分割精度。Chen等[8]提出的DeepLabv3+在空洞空间金字塔池化模块中拼接空洞卷积和池化层输出的特征,获得不同尺度的感受野。随后Wang等[9]提出的HRNet通过高维与低维并行,不断进行多尺度特征交互,在一定程度上提高了模型的全局建模能力,同时也能较好地保留图像细节信息,在遥感图像语义分割中取得了更好的效果。

在遥感图像中,道路和河流等障碍物通常跨度较广、面积较大,且容易受到阴影的遮挡,需要从全局的视野建立特征依赖,以准确提取和重建障碍物信息。但CNN类网络受到卷积核尺寸的限制,难以捕获远距离的特征关系,而使用较大的卷积核将导致细节丢失和计算量攀升,因此仅依靠卷积无法很好地保证地表障碍物提取的准确性和高效性。近年来,视觉Transformer(Vision Transformer,ViT)[10]利用多头自注意力机制[11]对输入图像的每个像素点进行注意力计算,获得了比卷积更大的有效感受野和更强的全局特征提取能力。但由于遥感影像的分辨率通常较高,使用ViT提取图像特征将导致网络计算量飙升。Mix-Transformer模块[12]通过带有重叠的块改进了ViT,并引入缩减比率成倍地降低了网络的参数量和计算量,使自注意力机制能应用于高分辨率的遥感影像。然而,现有基于Mix-Transformer模块的图像语义分割网络仅使用简单的线性投影完成特征解码[13],无法有效利用编码器主干提取的多尺度障碍物特征,导致分割精度降低。

为进一步提高网络分割结果的准确性,同时保证较高的计算效率,本文构建了针对遥感影像障碍物分割的V型全自注意力网络(MTNet)。该网络以高效的Mix-Transformer模块取代卷积层,全局利用自注意力机制强大的建模能力提取障碍物特征。得益于Mix-Transformer的全局有效感受野,网络足以保证高层语义信息的完整性。因此,MTNet去除了传统图像分割网络的语义融合模块,使用带有跳跃连接的V型结构,以减小网络深层的计算复杂度。同时,由于在空间维度进行上采样的转置卷积计算量太大,本文设计了更轻量的块扩展层,从通道维度实现上采样,并在解码器中嵌入Mix-Transformer模块重建上采样后的障碍物信息。实验结果表明,该网络在精度和速度上显著优于现有的图像语义分割方法。

1 方法原理 1.1 MTNet网络结构及图像分割流程勘探工区内的遥感影像背景复杂,障碍物数量较多。要准确地辨别遥感影像中的障碍物像素,尤其是被遮挡处和边缘位置,是一项具有挑战性的任务。为了分割出准确、完整的障碍区,需要获取丰富的多尺度特征和保留详细的语义信息,这就要求网络具有强大的全局特征提取能力。现有的分割方法大多以增加网络参数量和计算量为代价,通过组合不同扩张率的空洞卷积扩大网络感受野进而增强语义特征[5-6]。不同的是,MTNet利用具有远距离建模能力的Mix-Transformer模块提取和重建障碍物多尺度特征,其全局有效感受野足以保证语义信息的完整性。

MTNet的整体结构如图 1所示,该网络采用端到端的V型编码器—解码器结构。其中,编码器由一个重叠块嵌入层、四组Mix-Transformer模块和三个重叠块合并层构成。重叠块嵌入层和重叠块合并层实现下采样操作,Mix-Transformer模块提取图像的多尺度特征,解码器通过块扩展层完成上采样,并在恢复特征图尺寸的过程中嵌入Mix-Transformer模块以重建特征,重复执行此操作后输出准确的障碍物图像。同时,MTNet通过跳跃连接实现编码器与解码器的信息交互,以避免丢失细节信息。

|

图 1 MTNet网络结构 |

编码过程包含四个阶段。第一阶段中,重叠块嵌入层将输入尺寸为H×W×3的遥感影像下采样4倍后,横向拉平形成更有利于自注意力运算的特征序列,该序列经过3个Mix-Transformer模块提取图像特征,并在输出时还原回二维,获得尺寸为原图 1/4、通道数为64的特征图。后续三个阶段依次利用重叠块合并层,将输入的特征图下采样2倍后转换为特征序列,并分别通过8、27和3个连续的Mix-Transformer模块提取低维的纹理特征和高维的语义特征,输出高、宽为原来1/8、1/16和1/32,通道数为128、320和512的特征图。

与编码过程相反,解码器将低分辨率的特征图逐步恢复到原图大小,输出仅包含障碍物掩码的图像。解码器输入数据尺寸为

不同于只能生成单一分辨率特征图的ViT,MTNet的编码器通过重叠块嵌入层和重叠块合并层产生与CNN类似的多级特征金字塔。这些特征提供了高分辨率的细节纹理信息与低分辨率的语义特征,可以为网络带来更丰富的上、下文理解。现有的图像语义分割网络通常使用池化层实现特征的下采样,但由于池化操作过于直接地在一定大小的窗口内计算最大值或平均值,导致丢失局部信息且容易受到噪声的干扰。为解决此类问题,同时增强特征之间的信息传递,编码器在重叠块嵌入层使用核为7、步长为4的卷积对输入的遥感影像下采样,并在重叠块合并层使用核为3、步长为2的卷积运算。通过一层简单的卷积可以弱化特征图中奇异值的影响,而相互重叠的卷积窗口保证了局部特征的连续性。

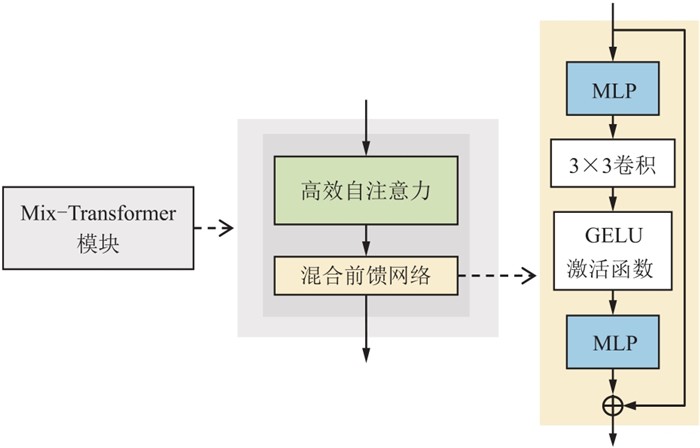

1.3 Mix-Transformer模块编码过程中,Mix-Transformer模块用于从遥感影像中提取特征。在解码时,跳跃连接通过加法融合网络前、后相同尺度的特征。但由于道路、水域等障碍物的跨度较大,需要编码器和解码器通过全局的感受野捕获远距离像素点之间的关系,以提取或恢复障碍物特征。而卷积仅在一定大小的卷积核窗口内进行运算,有效感受野范围较小,无法很好地处理全局特征信息。因此,MTNet使用Mix-Transformer模块提取图像特征,并在解码器中嵌入Mix-Transformer模块,通过全局的自注意力机制重建特征图。Mix-Transformer模块由高效自注意力层和混合前馈网络两部分组成,其结构如图 2所示。

|

图 2 Mix-Transformer模块结构 |

虽然重叠块嵌入层会对输入图像进行4倍降采样,但由于遥感影像的分辨率通常较高,仍然会为网络带来很大的计算负担。Swin[14]和VSA[15]等特征提取主干方法通过划分一定大小的滑动窗口减小计算量。但这类方法无法保证窗口之间障碍物特征的连续性,而Mix-Transformer模块的高效自注意力层通过引入缩减比率R,并利用全连接层,改进了ViT中的多头自注意力机制,在保留全局有效感受野的同时,将计算复杂度从O(N2)降低至O(N2/R),N=H×W。计算复杂度的降低使网络能应用于更高分辨率的遥感影像。高效自注意力计算过程表示为

| $ \left\{\begin{array}{l}{\boldsymbol{K}}_{R}=\mathrm{L}\mathrm{i}\mathrm{n}\mathrm{e}\mathrm{a}\mathrm{r}(CR, C)\left[\mathrm{R}\mathrm{e}\mathrm{s}\mathrm{h}\mathrm{a}\mathrm{p}\mathrm{e}\left(\frac{N}{R}, CR\right)\boldsymbol{K}\right]\\ \mathrm{A}\mathrm{t}\mathrm{t}\mathrm{e}\mathrm{n}\mathrm{t}\mathrm{i}\mathrm{o}\mathrm{n}(\boldsymbol{Q}, \boldsymbol{K}, \boldsymbol{V})=\mathrm{S}\mathrm{o}\mathrm{f}\mathrm{t}\mathrm{m}\mathrm{a}\mathrm{x}\left(\frac{\boldsymbol{Q}{\boldsymbol{K}}_{R}^{\mathrm{T}}}{\sqrt{{d}_{\mathrm{h}\mathrm{e}\mathrm{a}\mathrm{d}}}}\right)\boldsymbol{V}\end{array}\right. $ | (1) |

式中:Q、K、V均表示将输入特征图横向展平形成的特征序列,维度为N×C;KR表示经过缩减的K;dhead表示赋予每个注意力头的通道数;Reshape表示将K序列变形;Linear为线性投影;Attention表示计算自注意力。Q与KR的转置通过序列的点积运算表征序列内部相似性,通过Softmax获得(0,1)区间的自注意力权重并赋予V,以期在不改变输入特征图尺寸的情况下提取信息和重建特征。一般来说,网络所需的计算量与特征图的分辨率呈正相关,处理不同分辨率的特征图时需要对缩减比率做出调整。因此,在编码的四个阶段,根据特征图尺寸比例,MTNet将缩减比率分别设置为64、16、4和1。

1.3.2 混合前馈网络在遥感语义分割任务中,训练与测试的图像分辨率可能不同。若保留原始Transformer模块的位置编码,则需要对图像插值或通过滑动窗口做测试,将导致分割结果变差和网络效率降低。因此,Mix-Transformer模块使用一个混合前馈网络替代传统的位置编码,利用卷积的空间不变性保留位置信息,可以将同一模型权重应用于不同尺寸的测试图像且不会降低网络效率。混合前馈网络是带有残差连接的,包含2个MLP(多层感知机),1个3×3卷积(

| $ {\boldsymbol{x}}_{\mathrm{o}\mathrm{u}\mathrm{t}}=\mathrm{M}\mathrm{L}\mathrm{P}\left\{\mathrm{G}\mathrm{E}\mathrm{L}\mathrm{U}\left\{\mathrm{C}\mathrm{o}\mathrm{n}{\mathrm{v}}_{3\times 3}\left[\mathrm{M}\mathrm{L}\mathrm{P}\left({\boldsymbol{x}}_{\mathrm{i}\mathrm{n}}\right)\right]\right\}\right\}+{\boldsymbol{x}}_{\mathrm{i}\mathrm{n}} $ | (2) |

式中:xin表示高效自注意力层输出的障碍物特征;xout表示经处理后的特征图。该混合前馈网络通过3×3卷积和MLP为网络提供更灵活的位置信息,同时提升了网络在处理不同数据时的泛化能力。

1.4 块扩展层现有网络通常使用转置卷积实现特征图的上采样,即在指定大小的卷积窗口内提高特征分辨率,属于空间维度的上采样。但由于遥感影像的分辨率较高,空间跨度较长,使用转置卷积将消耗大量的计算资源。为此,本文设计了通道维度的块扩展层取代转置卷积。

块扩展层首先通过线性投影增加特征图通道,并重塑特征到目标维度,这个过程所消耗的计算量小到可忽略不计。以特征图的第一次上采样为例,需要将其维度从

本文使用LoveDA数据集[16]、马萨诸塞州道路数据集和西南地区数据集评估MTNet在遥感影像障碍物提取中的有效性。

LoveDA数据集采集自三个不同城市(南京、常州和武汉)的18个复杂场景,提供了2522张训练图像和1669张验证图像。其图像分辨率为1024×1024,空间分辨率为0.3 m,包含的障碍物类别有建筑物、道路、水域和植被等。但由于观测系统变观主要关注建筑物、道路和水域,因此本文将其他类别统一设置为背景。

马萨诸塞州道路数据集包含城市、郊区和乡村的遥感影像,反映了道路受植被和车辆干扰的情况。数据集共有1108张训练图像、14张验证图像和49张测试图像,空间分辨率为1 m,图像分辨率为1500×1500。但由于图像分辨率不满足主流语义分割网络的32倍下采样方式,因此需要使用0值像素扩边,将图像尺寸扩展至1504×1504,并在评估时恢复原始分辨率。

西南地区数据集采集自中国西南某勘探工区。该数据集代表了观测系统变观中障碍物分割的真实应用场景,影像内容包含了城市和乡村,用于验证网络的泛化能力。该影像无标签,空间分辨率为0.5 m,图像分辨率为1024×1024,这些图像可整体拼接成单张大尺寸图像,使对比结果更直观。

2.2 实验设置与定量指标本文所有实验均在NVIDIA GeForce RTX 3090上进行,使用PyTorch构建、训练和测试模型。以Adam[17]为优化算法,批量大小设置为2,训练轮次设置为100。为了加强模型的泛化能力,采用随机垂直翻转、随机水平翻转、随机旋转和随机改变饱和度等方式增强训练数据。初始学习率设置为0.00005,并使用了一个简单的学习率调整策略,即当损失值累计3轮高于最低值时,将学习率调整为自身的1/5。此外,LoveDA数据集使用交叉熵损失函数,马萨诸塞州道路数据集使用二元交叉熵加上骰子损失函数作为训练的损失函数[18]。

本文使用Precision、Recall、调和平均数(F1)、交并比(IoU)和平均交并比(mIoU)评估网络精度。Precision表示预测正确的像素与总预测像素的比值,Recall表示预测正确的像素与标签中道路像素的比值。Precision和Recall指标用于分析网络的特点,若Precision高而Recall低通常表示网络倾向于预测更少的像素点。但它们过于片面无法代表模型的实际表现,所以本文更关注综合性的评价指标F1和IoU。F1是Precision和Recall的调和平均值,IoU表示预测结果与标签的交集与并集之比。为了公平地比较不同方法,还计算了各网络的参数量和计算量。

2.3 LoveDA数据集分析结果本节对提出的MTNet与现有的遥感影像语义分割网络进行对比实验。作为对比网络,CNN类型有U-Net[4]、PSPNet[5]、D-LinkNet[6]、DeepLabv3+[8]和HRNet[9]。Transformer类型有以ViT[10]为主干的UperNet[19]和以Mix-Transformer(MiT)为主干的SegFormer[12]。为加速模型收敛并通过迁移学习达到更好的性能,除U-Net不使用主干外,其他所有的主干都经过了预训练。为了减少实验环境带来的误差,所有实验都使用相同的策略和损失函数。所有结果都是在LoveDA数据集的测试集上获得,并取训练过程中的最优模型进行对比。

表 1展示了LoveDA数据集上不同模型的实验结果。从表中可知,Transformer类网络的定量指标结果显著优于CNN类网络,说明自注意力机制相比卷积运算具有更强的障碍物特征提取能力。其中MTNet获得了83.65%的F1和72.62%的mIoU,且各类别的IoU指标均高于其他网络模型,建筑物为68.05%,道路为59.86%,水域为73.61%。相较于CNN类型网络中表现最好的HRNet,本文方法的F1和mIoU分别提升了2.31%和3.28%。与同样使用MiT-B4为主干的SegFormer相比,mIoU提高了1.15%。由于道路和水域往往具有较大的跨度和面积,需要更为广阔的有效感受野重建特征。基于此,MTNet将自注意力机制引入解码器,所分割道路和水域的IoU远超其他方法,比HRNet分别领先3.7%和6.1%,比SegFormer分别领先2.19%和2.32%。此外,MTNet的参数量较低,且使用带有衰减比率的主干和轻量化的块扩展层上采样,网络的计算量低于大多数其他方法。

|

|

表 1 LoveDA数据集上不同模型的实验结果 |

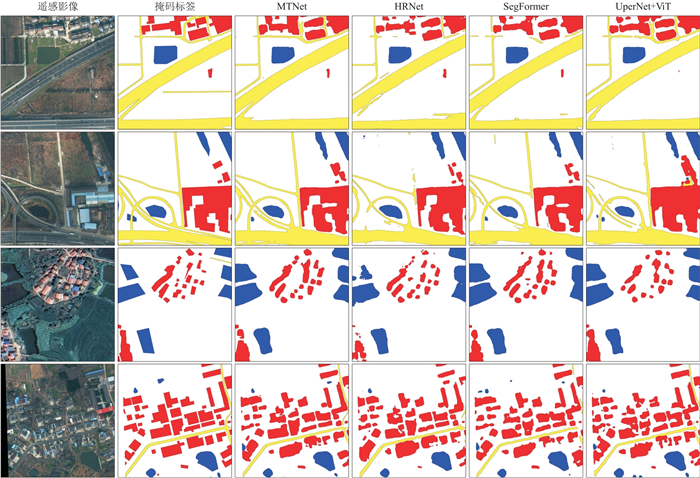

为了更直观地对比,图 3绘制了MTNet、HRNet、SegFormer和使用ViT为主干的UperNet在LoveDA数据集上的可视化分割结果。从图中第一行遥感影像可以看出,HRNet受卷积运算感受野小的限制,难以考虑到远距离像素之间的相关性,导致其识别的道路存在严重的缺失现象;SegFormer由于其解码器无法有效利用主干提取的层级特征,提取的道路和建筑出现了较多不连续和错误预测。第二行代表道路形态复杂的场景,相比于其他网络模型,MTNet能够更有效地保证复杂道路的准确性和连通性。第三行表示乡村场景,受到植被遮挡的影响,网络难以划分准确的障碍物边缘,从图中可以看出MTNet提取的障碍物准确性高且边缘清晰平滑。第四行中的建筑较为密集,ViT仅提取单一尺度的图像特征,缺乏对障碍物的多尺度理解,在分割面积较小的建筑时,难以获得准确的语义信息,导致目标缺失。MTNet有效避免了上述网络的一系列问题,实现了最为精确的遥感影像多类别障碍物识别,尤其是在建筑物与道路的密集区域,识别结果显著优于其他网络。

|

图 3 四种遥感影像不同方法的分割结果 |

从LoveDA数据集的实验结果可以看出,道路与其他类型的障碍物相比,具有更复杂的几何形态和更强的连通性,从遥感影像中准确提取道路的难度远高于其他障碍物。因此,进一步通过具有代表性的马萨诸塞州道路数据集,验证本文方法在道路提取方面的优越性。表 2展示了其他网络与MTNet在马萨诸塞州道路数据集的测试集上获得的定量指标结果。从表中可以看出,相比于现有的遥感影像语义分割网络,MTNet通过较少的计算成本取得了最高的F1和IoU,分别为80.26%和67.24%。与SegFormer相比,F1领先1.91%,IoU领先2.57%。相比于CNN类型网络中表现最好的HRNet,MTNet通过更广的有效感受野建立了更远距离的特征依赖,获得了更好的分割结果,F1领先2.01%,IoU领先2.61%。此外,DeepLabv3+、HRNet、UperNet和SegFormer都存在Precision高而Recall低的现象,原因是这些网络仅提取单一分辨率特征或其下采样倍率较低,所提取的高层语义特征模糊,致使模型倾向于预测较少的像素点,进而导致分割道路出现局部缺失。PSPNet和D-LinkNet的Precision较低但Recall较高,这是因为它们过于直接地将多尺度信息拼接或相加,使特征信息混乱,网络输出了更多的错误像素点。而MTNet通过重建特征获得了较为平衡的Precision和Recall,分别为80.53%和80.33%,表明网络输出的道路准确性高且完整性好。

|

|

表 2 马萨诸塞州道路数据集不同模型的实验结果 |

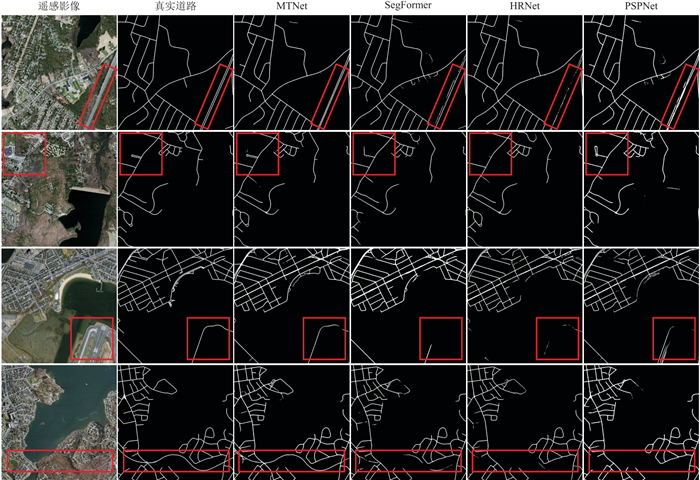

图 4绘制了代表性网络的分割结果,包括MTNet和SegFormer,它们都使用了MiT-B4作为主干,以及Precision指标最高的HRNet和Recall指标最高的PSPNet。前三行图分别表示相邻道路距离较近、道路局部复杂分布与受相似地物干扰的情况,考验了网络对障碍物细节特征的提取与恢复能力。可以看出,SegFormer能够较为准确地提取道路及其整体分布,但无法保证道路局部细节的准确性;HRNet倾向于预测更少的像素点,导致道路缺失,使Precision远高于Recall指标;而PSPNet缺乏对深层与浅层特征的信息交互,容易错误地将背景预测为道路,使Recall远高于Precision指标。图中第四行表示道路特征不明显的情况,需要网络具有强大的全局特征建模能力,从图像整体角度预测道路的像素分布。相比于其他网络模型,MTNet的编码器通过自注意力机制提取全局的道路特征,并在解码器中嵌入Mix-Transformer模块重建特征,能够建立更为统一的全局和局部特征依赖,极大地保证了道路的完整性和准确性,明显优于其他方法。

|

图 4 四种遥感影像中道路不同方法的分割结果 图中红色方框为改善明显的区域,实际分割结果与定量指标一致。 |

为了验证提出的块扩展方式上采样在遥感影像障碍物分割任务上的效果,以难度最高的道路类别为例,在马萨诸塞州道路数据集上进行了消融实验。

在遥感影像分割任务中,网络通过上采样将低分辨率特征图恢复到原始分辨率,常见方法包括传统的线性插值和在空间维度上采样的转置卷积,而本文的块扩展层是通过通道维度的扩张和重新排列实现上采样。表 3展示了不同上采样方法对MTNet的影响。结果表明,相较于线性插值,使用块扩展层后的F1领先0.51%,IoU领先0.68%,而参数量和计算量差异不大。相较于转置卷积,块扩展层的F1领先0.18%,IoU领先0.25%,但计算量减少了112.92 G,大幅降低了网络的运算成本。此外,使用线性插值时网络获得了最低Precision和最高Recall。这表明插值方法将导致网络输出更多的道路像素,同时误差率也会上升。使用转置卷积得到了最高的Precision和最低的Recall,说明使用该方法时,网络输出的像素点数量较少,将导致丢失特征信息。而块扩展层上采样的Precision和Recall较为均衡。综上所述,块扩展层在减少网络计算量的同时获得了更准确的分割结果。

|

|

表 3 MTNet上采样的消融实验结果 |

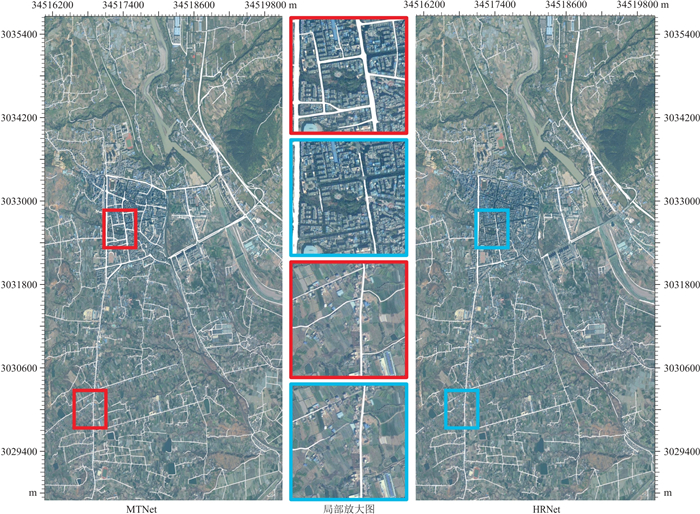

网络的泛化能力决定了模型从已有数据中学习的规律能否推广到未训练的实际数据上,将直接影响网络在遥感影像障碍物识别任务中的有效性。为了评估MTNet的泛化性以及分割真实勘探工区道路的准确性,本文将经过相同训练的MTNet与HRNet模型迁移至未被训练的西南地区数据集中。图 5展示了两种网络模型在西南地区数据集上的分割结果。从整体来看,MTNet分割出的道路数量较多,连续性好,相互连通形成拓扑,符合道路的真实分布情况。而HRNet无法保证道路的完整性,尤其处理城区内部的复杂情况时,缺失更明显。从局部放大图可以看出,MTNet分割的准确性更高,能较好地抵抗其他地表物体的干扰,几乎识别了遥感影像中的所有道路。HRNet的预测结果出现了很多缺失,且道路连续性较差。结果表明本文方法具有更优秀的泛化能力,预测未学习的工区内障碍物时更灵活和准确。

|

图 5 西南地区数据集分割结果(刻度值为高斯-克里格投影坐标) 图中左右两侧分别为MTNet与HRNet的整体分割结果,红色和蓝色框线表示显著改善区域;中间表示显著改善区域的局部放大图。 |

本文面向遥感影像的障碍物提取任务,设计了一种V型编码器—解码器结构的全自注意力网络MTNet。该网络使用Mix-Transformer取代卷积运算,通过自注意力机制提取和重建遥感影像中的多尺度全局障碍物特征,以解决传统的卷积神经网络全局建模能力不足的问题。同时,设计了在通道维度堆叠和重塑特征图的块扩展层,实现了超轻量的上采样,重建障碍物信息。三个数据集的实验结果表明,MTNet提取障碍物的准确性和完整性显著优于其他网络。得益于Mix-Transformer模块的强大全局特征提取能力,在提取跨度大、复杂程度高的障碍物时,MTNet的优势更明显。因此,利用有限样本数据训练的MTNet模型,比卷积网络模型更适用于真实的应用场景,进一步提升了利用深度学习提取遥感影像障碍物的准确性,为实现全自动观测系统变观奠定了基础。

| [1] |

陈学强, 张林. 复杂地表条件下的变观设计技术[J]. 石油地球物理勘探, 2007, 42(5): 495-498. CHEN Xueqiang, ZHANG Lin. Geometry-variable design in complex surface conditions[J]. Oil Geophysical Prospecting, 2007, 42(5): 495-498. DOI:10.3321/j.issn:1000-7210.2007.05.003 |

| [2] |

于冬梅, 温俊凤, 吴智强, 等. 三维采集现场快捷变观设计在濮城区的应用[J]. 石油地球物理勘探, 2010, 45(增刊1): 9-12. YU Dongmei, WEN Junfeng, WU Zhiqiang, et al. Application of 3D fast onsite geometry-variable design in Pucheng area[J]. Oil Geophysical Prospecting, 2010, 45(S1): 9-12. DOI:10.13810/j.cnki.issn.1000-7210.2010.s1.032 |

| [3] |

LONG J, SHELHAMER E, DARRELL T. Fully convolutional networks for semantic segmentation[C]. 2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2015, 3431-3440.

|

| [4] |

RONNEBERGER O, FISCHER P, BROX T. U-Net: convolutional networks for biomedical image segmentation[C]. Medical Image Computing and Computer-Assisted Intervention-MICCAI 2015, 2015, 234-241.

|

| [5] |

ZHAO H S, SHI J P, QI X J, et al. Pyramid scene parsing network[C]. 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2017, 6230-6239.

|

| [6] |

ZHOU L C, ZHANG C, WU M. D-LinkNet: linknet with pretrained encoder and dilated convolution for high resolution satellite imagery road extraction[C]. 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition Workshops (CVPRW), 2018, 182-186.

|

| [7] |

HE K M, ZHANG X Y, REN S Q, et al. Deep residual learning for image recognition[C]. 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), 2016, 770-778.

|

| [8] |

CHEN L C, ZHU Y K, PAPANDREOU G, et al. Encoder-decoder with atrous separable convolution for semantic image segmentation[C]. Computer Vision-ECCV 2018, 2018, 833-851.

|

| [9] |

WANG J D, SUN K, CHENG T H, et al. Deep high-resolution representation learning for visual recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2021, 43(10): 3349-3364. DOI:10.1109/TPAMI.2020.2983686 |

| [10] |

HAN K, WANG Y, CHEN H, et al. A survey on vision transformer[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2022, 45(1): 87-110. |

| [11] |

VASWANI A, SHAZEER N, PARMAR N, et al. Attention is all you need[C]. Proceedings of the 31st International Conference on Neural Information Processing Systems, 2017, 6000-6010.

|

| [12] |

XIE E, WANG W, YU Z, et al. SegFormer: simple and efficient design for semantic segmentation with transformers[C]. 35th Conference on Neural Information Processing Systems, 2021, 1-7.

|

| [13] |

WANG J F, HUANG Q M, TANG F L, et al. Stepwise feature fusion: local guides global[C]. Medical Image Computing and Computer Assisted Intervention-MICCAI 2022, 2022, 110-120.

|

| [14] |

LIU Z, LIN Y T, CAO Y, et al. Swin transformer: hierarchical vision transformer using shifted Windows[C]. 2021 IEEE/CVF International Conference on Computer Vision (ICCV), 2021, 9992-10002.

|

| [15] |

ZHANG Q M, XU Y F, ZHANG J, et al. VSA: learning varied-size window attention in vision transformers[C]. Computer Vision-ECCV 2022, 2022, 466-483.

|

| [16] |

XU R, WANG C, ZHANG J, et al. Rssformer: foreground saliency enhancement for remote sensing land-cover segmentation[J]. IEEE Transactions on Image Processing, 2023, 32: 1052-1064. DOI:10.1109/TIP.2023.3238648 |

| [17] |

HASSAN E, SHAMS M Y, HIKAL N A, et al. The effect of choosing optimizer algorithms to improve computer vision tasks: a comparative study[J]. Multimedia Tools and Applications, 2023, 82(11): 16591-16633. DOI:10.1007/s11042-022-13820-0 |

| [18] |

QUAN B, LIU B Y, FU D C, et al. Improved deeplabv3 for better road segmentation in remote sensing images[C]. 2021 International Conference on Computer Engineering and Artificial Intelligence (ICCEAI), 2021, 331-334.

|

| [19] |

XIAO T T, LIU Y C, ZHOU B L, et al. Unified perceptual parsing for scene understanding[C]. Computer Vision-ECCV 2018, 2018, 432-448.

|

罗文,四川省成都市成华区二仙桥东三路1号成都理工大学计算机与网络安全学院,610059。Email:

罗文,四川省成都市成华区二仙桥东三路1号成都理工大学计算机与网络安全学院,610059。Email: