2. 96714部队, 福建 永安 366000

2. 96714 Troops, Yong'an 366000, China

世界军事领域正处于深刻变革的时代,一方面高新技术的发展对作战理论、军事装备和作战方法等带来了巨大的影响;另一方面随着计算机技术、网络技术、多媒体技术和建模与仿真技术的发展,实验手段已产生质的飞跃[1]。在此背景下,军事能力特别是核心作战能力的生成逐步向“理论设计-实验论证-部队演练-实战运用”这一新型发展模式转变,“在实验室中研习战争”成为国防和军队建设转型发展的重要环节[2]。作战实验指运用科学实验的原理、方法和技术,在可控、可测的虚拟对抗环境中,实证性地研究战争和军队作战行动的特点规律,为军事决策和战争实践提供科学依据[3]。

目前有关作战实验的研究,主要集中在两方面:一是作战实验支撑技术;二是作战实验优化技术。其中,优化技术研究更多地是建立在解析模型或将仿真系统作为黑箱处理的基础上。文献[4-7]在武器-目标分配的研究中,基于建立的解析模型,分别采用不同的启发式搜索算法进行问题求解。国海峰等[8]在建立空战过程中无人作战飞机(UCAV)总的态势评价函数基础上,基于统计学原理进行UCAV机动决策优化。陈伟龙等[9]在建立进攻抢修任务动态调度模型基础上,采用变体遗传算法进行问题求解,以提高决策效率、降低决策风险。阮旻智等[10]在建立基于任务的携行备件动态配置模型基础上,引入拉格朗日约束因子,构建了多约束条件下的方案优化方法。杨迎辉等[11]在建立网络化作战信息流转策略的适应性演化模型基础上,采用逐次优化算法搜索最优演化路径。王枭等[12]将仿真系统作为黑箱,引入Apriori算法提出一种边实验边挖掘的序贯探索方法,以提高战争规律发现效率。文献[13]在研究导弹协同攻击体系目标中,为提高仿真优化效率,将创造性思维引入到问题求解中,基于贝叶斯网络以静态博弈去解析动态博弈过程,虽然考虑了攻防对抗过程,但仍是将仿真系统作为黑箱处理。

全流程攻防对抗是一个动态博弈问题,决策随着态势改变而改变,通常难以建立有效的解析模型表达问题并进行求解。鉴于此,本文提出基于战能控制的作战实验方法,主要研究作战系统的动态能力表达、战能环及战能转化系数,基于分布估计算法的战能转化控制。

1 面向作战实验的动态能力表达 1.1 作战行为作战行为指代驱动装备系统运转的作战人员行为,包括指挥行为和操纵行为,来源于战术条令,并基于战备远航、训练演习的指挥操纵链路不断丰富和完善。指挥行为主要为作战进程中指挥员口令集,可表示为

| $ C = \left\{ {{C_1},{C_2}, \cdots ,{C_{{n_C}}}} \right\} $ | (1) |

式中nC表示指挥行为数量。

操纵行为主要为作战进程中,各战位基于指挥员口令、依据操纵规程,对装备系统施加的行为集,可表示为

| $ O = \left\{ {{O_1},{O_2}, \cdots ,{O_{{n_O}}}} \right\} $ | (2) |

式中nO表示指挥行为数量。

对于每个行为,其带有一套描述各战位人员技能水平的参数,如操纵时间、操纵质量等。

指挥行为与操纵行为之间的关联关系:

装备系统指具有不同作战能力的武器单元或搭载平台,如舰艇平台、声呐系统、雷达系统等[14]。对于某一作战实体,如坦克、飞机、舰艇,其由装备系统可表示为

| $ S = \left\{ {{S_1},{S_2}, \cdots ,{S_{{n_S}}}} \right\} $ | (3) |

式中nS表示装备系统数量。

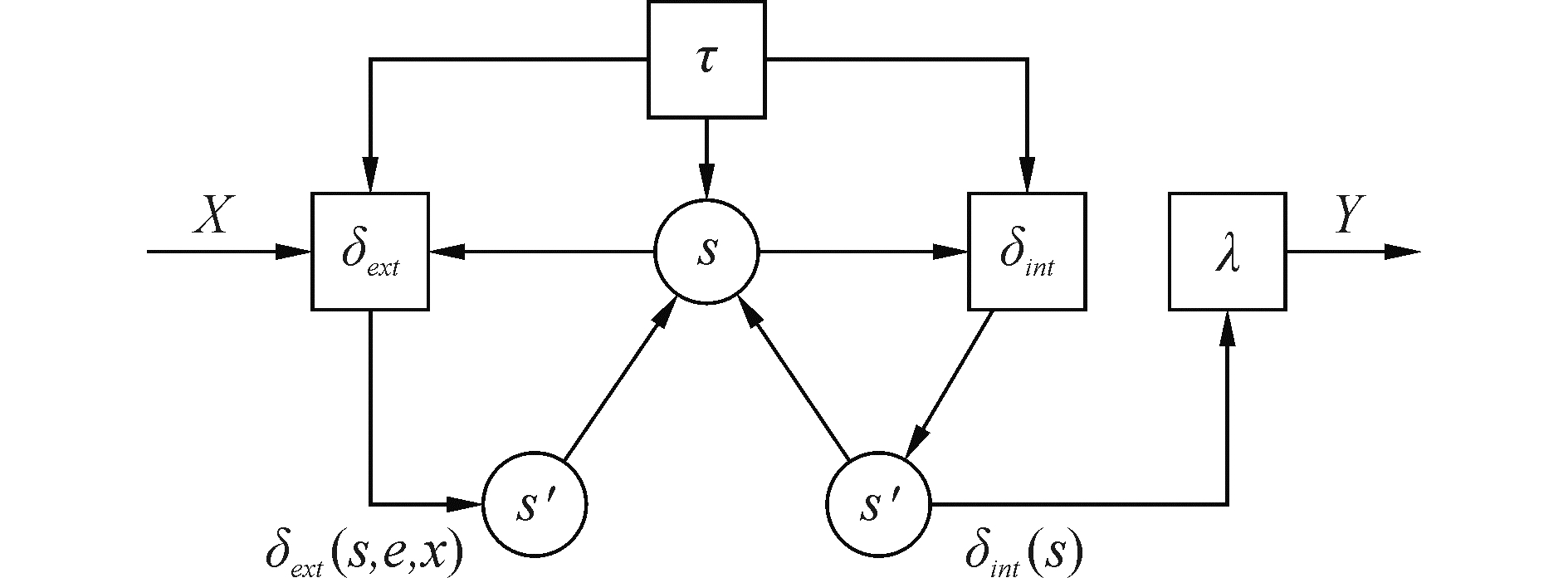

对于作战实体中的每个装备系统,可以采用离散事件系统规范化形式体系进行表示[15-16]:

| $ M = < T,X,S,Y,{\delta _{{\rm{ext}}}},{\delta _{{\rm{int}}}},\lambda ,\tau > $ | (4) |

式中:T为时间集合,X为输入集合,S为状态集合,Y为输出集合,δext为外部状态转移函数,δint为内部状态转移函数,λ为输出函数,τ为时间推进函数。相互之间的关系如图 1所示。

|

Download:

|

| 图 1 离散事件系统规范 Fig. 1 Discrete event system specification | |

装备系统的运转是在行为驱动下进行的,操纵行为与装备系统之间的关系为

能量是物质运动转换的量度,用来表征物理系统做功的本领。

借鉴物理学中能量定义,将作战能量界定为:作战进程中,作战体系或作战系统所处的一种能力状态,用于表征对敌作战的本领,简称战能。结合作战实体的组分类别及外在表现,对于每一作战实体,其战能可表达为一个七元组[16]:

| $ E = \left( {{E_{Dt}},{E_E},{E_{Df}},{E_A},{E_C},{E_I},{E_G}} \right) $ | (5) |

式中:EDt表示探测战能,EE表示隐蔽战能,EDf表示防御战能,EA表示攻击战能,EC为指控战能,EI表示通信战能,EG表示保障战能。

由能量计算方法可知,每一种能量的表达,最终都落到物理系统的状态,如高速飞行的子弹,其动能为Ek=mv2/2,其中v表达的是子弹的一种运动状态;压缩后的弹簧,其势能为Ep=kx2/2,其中x表达的是弹簧的一种变形状态。鉴于此,基于组分类别和外在表现的可分解性,将各战能分量划分为分量、样式/类别、状态三个层次,其中样式表达作战中更具主观能动性,类别表达作战中主要为客观存在性,作战实验主要是围绕样式展开研究。各战能分量的具体层次性描述为:探测战能、防御战能、隐蔽战能、攻击战能划分为分量、样式、状态,通信战能、指控战能、保障战能划分为分量、类别、状态。

装备系统与作战能量之间的关系为:

为统一量纲,所有战能样式采用价值评分进行归一化处理,值越大越优,并通过加权求和形成战能分量。

2 战能环及战能转化系数 2.1 战能环美国空军上校约翰·博依德(John Boyd)凭借其战斗机飞行员的经验和对能量机动性的研究,于1987年提出了一种作战模型,如图 2所示,它将作战过程简化抽象为由观察(Observe,O)-判断(Orient,O)-决策(Decide,D)-行动(Act,A)4个环节构成的作战回路[18-19]:

|

Download:

|

| 图 2 OODA环 Fig. 2 OODA loop | |

1) 观察,利用各类侦察探测装备对战场环境进行观察和感知,从战场环境中搜集目标的位置、状态、属性等信息;

2) 判断,将观察环节收集到的信息和数据进行处理和融合,并对当前的战场态势进行评估;

3) 决策,依据战场态势制定行动计划和方案;

4) 行动,依据计划方案或上级命令指示实施相应行动。

OODA环具有周期性和嵌套性,周期性意味着一个环结束时,另一个新环的开始,周期性的大小与作战兵力的规模、空间范围、作战样式有关;嵌套性意味着环与环以嵌套的形式关联。目前,OODA被广泛应用于作战问题分析中,它可以很好地表述作战行动的阶段性、递进性,但无法有效诠释作战行动的目的性、并行性。如搜攻任务中,在抵达作战区域时,可为搜索、打击、防御进行提前布势,在搜索阶段同样可为打击、防御进行提前布势等。鉴于此,研究提出战能积蓄-感知-传递-转化的战能环,如图 3所示,其中:

|

Download:

|

| 图 3 战能环 Fig. 3 Combat energy loop | |

1) 战能积蓄(EA),在作战进程中,以主行动目标为约束条件,基于作战行为的并行性,开展战能感知、传递和转化的优化布势。

2) 战能感知(EP),在行为驱动下,充分考虑自身隐蔽情况,基于传感器获取敌方目标信息,主要涉及探测战能、隐蔽战能、保障战能。

3) 战能传递(ED),在行为驱动下,完成目标分配及方案下发,以实现战能感知到战能转化的变迁,主要涉及指控战能、通信战能、保障战能。

4) 战能转化(ET),在行为驱动下,基于攻击武器和防御武器,对敌实施攻击或防御,主要涉及攻击战能、防御战能、保障战能。

图 3中的实线表示,完成一次攻防对抗,需要经历战能感知、战能传递、战能转化一个循环;虚线表示,战能感知、战能传递、战能转化与战能积蓄互为输入输出。

2.2 战能转化系数定义4 作战潜能

面向作战任务,作战体系或作战系统在当前战能下所具备的潜在作战效果,以转化系数进行表征,简称战势。战势不仅与当前战能相关,还受到战能感知、战能传递及作战行动的影响,鉴于此,战势可表示为

| $ \eta = \left( {{\eta _1},{\eta _2}, \cdots ,{\eta _{{n_\eta }}}} \right) = f\left( {E,{\rm{EP}},{\rm{ED}},A} \right) $ | (6) |

式中:E表示当前作战能量;EP表示战能感知,主要由精度进行表征,如位置精度、速度精度;ED表示战能传递,主要由数量进行表征,如单雷攻击、双雷齐射;A表示作战行动,以指挥行为序列进行表征,如鱼雷准备、鱼雷发射。

借鉴频谱分析的部分术语,引入转化效果、转化幅值、转化时间、转化相位、转化密度、转化斜率作为战能转化系数,对战势进行标识。

转化效果η1:当前作战行动A所能达到的转化效果。通常情况下,转化效果越好的作战方案越优。

转化幅值η2:最优作战行动A所能达到的转化效果。通常情况下,转化幅值越大,表明通过局部调整可以达到的转化效果越好。

转化时间η3:当前作战行动A完成战能转化的时间。通常情况下,两个转化效果相同的作战方案,则转化时间越短越好。

转化相位η4:当前最优作战行动A两者之间距离。两个转化效果相同的作战方案,且转化峰值相同的情况下,则转化相位大的不容易通过局部调整求取最优解。

转化密度η5:所有作战行动A的转化效果求平均值。两个转化效果相同的作战方案,则转化密度大的越容易通过局部调整求得满意解。

转化斜率η6:作战行动A所达作战效果的变化趋势。两个转化效果相同的作战方案,则斜率大的越容易通过局部调整获取更好的作战效果。

3 基于分布估计算法的战能转化控制借鉴棋牌中的动态博弈研究思路[21-23],基于战能环及战能转化系数,构建如图 4所示的优化控制框架,总体思路为:将优化算法嵌入到仿真推演中,在作战进程中根据红蓝双方态势,基于战势和战能相结合的评判准则,快速生成满意的行动方案。这样,问题求解是在一种智慧博弈下开展的,相比于传统方法,降低了求解的盲目性。主要由指挥行为编码、行动方案生成[24]、精英种群选择、概率模型更新、实验数据挖掘组成,其中子图为产生行动方案的展开阐述,战能积蓄贯穿于准备、感知、传递、转化各个阶段。

|

Download:

|

| 图 4 基于战能环的优化框架 Fig. 4 Optimize frame based on combat energy loop | |

依据战能感知、传递、转化涉及的系统组件,以及指挥行为与系统组件的关系,对指挥行为进行归类,形成指挥行为集合:

| $ \left\{ \begin{array}{l} {\mathit{\Omega }_{{\rm{EP}} \triangleright C}} = \left\{ {{C_1},{C_2}, \cdots {C_{{n_{{\rm{EP}} \triangleright C}}}}} \right\}\\ {\mathit{\Omega }_{{\rm{ED}} \triangleright C}} = \left\{ {{C_1},{C_2}, \cdots {C_{{n_{{\rm{ED}} \triangleright C}}}}} \right\}\\ {\mathit{\Omega }_{{\rm{ET}} \triangleright C}} = \left\{ {{C_1},{C_2}, \cdots {C_{{n_{{\rm{ET}} \triangleright C}}}}} \right\} \end{array} \right. $ | (7) |

起始阶段,各指挥行为的后续指挥行为等概率存在,即

| $ {P_{0,i,j}} = 1/{N_i} $ | (8) |

式中Ni表示指挥行为Ci后续可能的行为数量。

3.2 行动方案生成以当前时间节点为起点,建立分别服务于感知、传递、转化的行为流程:

1)在准备阶段,对感知、传递、转化中具有相对独立性的战能分量进行布势,具体步骤为:

步骤1:依次根据转化效果、转化幅值、转化相位、转化斜率、转化密度,基于指挥行为

| $ {\rho _{i,j}} = {\eta _{l,j}}/\sum\limits_{l = 1}^{{N_i}} {{\eta _{l,j}}} $ | (9) |

式中ηl, j中的l表示上述五个值中的一个。

步骤2:如果ρi, j不同,转步骤3;否则,表明无法获取转化系数,或无法以转化系数进行区别,则设定各战能分量权重相同,以战能聚合函数确定概率分布:

| $ \left\{ \begin{array}{l} {\rho _{i,j}} = {e_j}/\sum\limits_{j = 1}^{{N_i}} {{e_j}} \\ {e_{k,j}} = \sum\limits_{k = 1}^7 {{e_{k,j}}} /7 \end{array} \right. $ | (10) |

式中ek, j表示各战能分量的价值评分。

步骤3:基于ρi, j、Pk-1, i, j,以增量值σ1构建过渡概率模型,即

| $ {P_{k,i,j}}^T = {\sigma _1}{P_{k - 1,i,j}} + \left( {1 - {\sigma _1}} \right){\rho _{i,j}} $ | (11) |

步骤4:以概率模型Pk, i, jT确定指挥行为Ci的后续指挥行为Cj。

2) 在感知阶段,以感知为主目标,进行指挥行为序列化,具体操作步骤为:

步骤1:如准备阶段的步聚1,不同之处在于基于的指挥行为集合为

步骤2:如准备阶段的步骤2,不同之处在于概率分布的计算方式:

| $ \left\{ \begin{array}{l} {\rho _{i,j}} = {e_j}/\sum\limits_{j = 1}^{{N_i}} {{e_j}} \\ {e_{k,j}} = \sum\limits_{k = 1}^7 {{\omega _k}{e_{k,j}}} /7 \end{array} \right. $ | (12) |

式中ek, j表示各战能分量的价值评分。

步骤3:如准备阶段的步骤4。

步骤4:对

3) 在传递阶段,以传递为主目标,进行指挥行为序列化,具体操作步骤与2)类似。

4) 在转化阶段,以转化为主目标,进行指挥行为序列化,具体操作步骤与2)类似,不同之处在于其概率分布的确定顺序为转化效果、转化时间、转化幅值、转化相位、转化斜率、转化密度。

3.3 精英种群选择由于寻优的随机性导致解集在演化过程中具有一定的退化性;为了保证算法能够收敛到全局最优解,将精英策略引入到算法中。对于内外循环,采用同样的种群选择策略,具体方法为:

步骤1:设置一个存储容器CP,大小为进化种群EP的规模NP,用于存储进化过程中产生的精英种群;

步骤2:每次迭代后,从CP中选择与EP中不同的个体参与排序,将其中NP个最优个体作为执行选择操作的基础;

步骤3:每次迭代后,从CP和EP中选择NP个不同的最优个体作为精英种群替换CP中的精英种群。

3.4 概率模型更新对于内外循环,采样同样的概率模型更新方法,其中内循环的初始阶段采用外循环的概率模型,且内循环的概率模型更新不影响外循环的概率模型[25]。对于每个指挥行为,采用增量学习的方式更新概率模型,即:

| $ \left\{ \begin{array}{l} {P_{k,i,j}} = {\sigma _2}{P_{k - 1,i,j}} + \left( {1 - {\sigma _2}} \right){{P'}_{k,i,j}}\\ {{P'}_{k,i,j}} = {N_{i,j}}/{N_i} \end{array} \right. $ | (13) |

式中: k为当前迭代代数,β2为增量学习系数;Ni, j为精英种群中指挥行为Ci后续行为中Cj的数量;Ni为精英种群中指挥行为Ci的数量。

3.5 实验数据挖掘为有效获取战能转化系数,采用二阶模型进行拟合,即

| $ y = {\beta _0} + \sum\limits_{i = 1}^k {{\beta _i}{x_i}} + \sum\limits_{i = 1}^k {{\beta _{i,i}}x_i^2} + \sum\limits_i {\sum\limits_j {{\beta _{i,j}}{x_i}{x_j}} } ,\left( {i \ne j} \right) $ | (14) |

式中:x=(e, ep, ed, a),y=(η1, η3)。

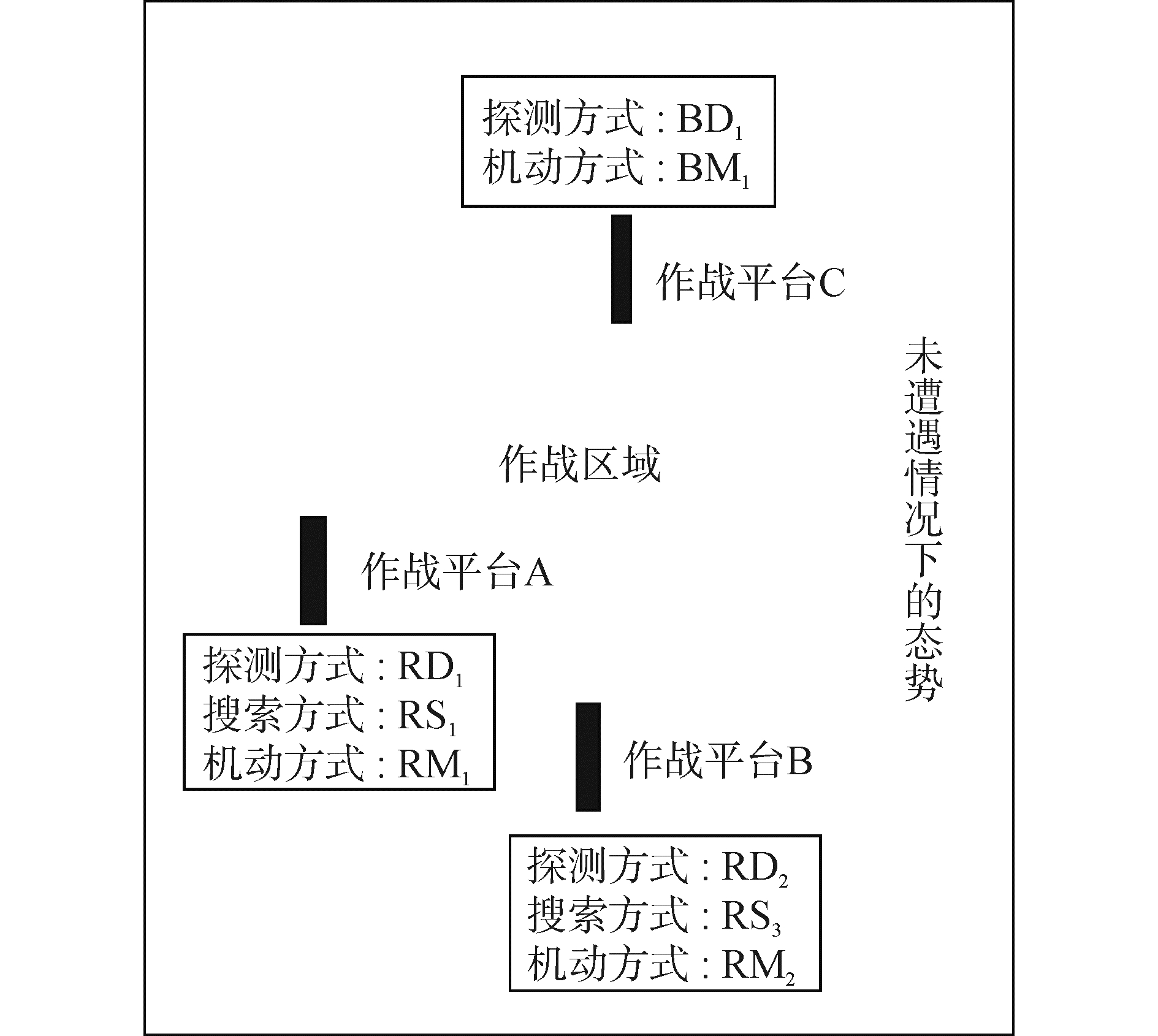

4 实例分析 4.1 实验设置红方作战平台A、B受领作战任务,对处于某个作战区域的蓝方作战平台C进行协同搜攻,其中作战平台A为指挥平台,作战平台B为协同平台。进入作战区域前,作战平台A、B需要通过指挥行为达成就位态势;进入作战区域后,作战平台A、B的探测方式为RD1、RD2二种,搜索方式为RS1、RS2、RS3三种,机动方式为RM1、RM2二种。作战平台C随机地从边界某一点进入作战区域,机动方式BM1为一种,探测方式为BD1一种。作战平台C对于探测方式RD1的隐蔽性要优于作战平台A、B对探测方式BD1的隐蔽性。

4.2 优化控制 4.2.1 战能设置基于作战平台A为指挥平台,以作战平台B为协同平台,以加权求和方式确定两者的协同战能:

| $ e = {\omega _A}{e_A} + {\omega _B}{e_B} $ | (14) |

其中,ωA=0.6、ωA=0.4。

4.2.2 战势设置由于作战任务是作战平台A、作战平台B共同完成对作战平台C的搜攻任务,因此转化效果为它们的和:

| $ {\eta _1} = {\eta _{1,A}} + {\eta _{1,B}} $ | (15) |

转化幅值、转化相位、转化斜率、转化密度都建立在此基础上的,由于转化时间独立转化效果,因此作战平台A、B分别保有自己的转化时间。

4.2.3 优化设置个体产生方式:个体长度为10,时间间隔为5 s,即从当前时刻开始,思考下50 s的作战行动,当未遭遇时,则按照战术条令中的规则开展活动。种群规模为NP=200;选择概率为PP=0.3;内部最大迭代次数It=100,即战能环的优化控制;外部最大迭代次数Ot=1 000,即仿真实验推演的次数;增量学习系数为σi=0.8(i=1, 2)。优化方式分为三种:1)Op1, 传统的基于分布估计算法的问题求解;2)Op2, 基于战能环阶段划分的问题求解;3)Op3, 战能环加转化系数的问题求解。

4.2.4 行为编码对于作战平台A、B,其作战行动都分别包括:抵达作战区域A1、侦察战场环境A2、搜索作战平台CA3、打击作战平台CA4、防御作战平台CA5几大活动。

依据作战平台A主要作战活动,其主要指挥行为集合为

| $ C = \left\{ {{C_1},{C_2}, \cdots ,{C_{{n_C}}}} \right\},{n_C} = 17 $ |

式中:C1为调整航速、航向、航深的指挥行为,C15为探测方式的指挥行为,C16为搜索方式的指挥行为,C17为机动方式的指挥行为。

指挥行为关系为:

| $ \begin{array}{l} {C_1} \to {C_i},{C_i} \to {C_1},{C_3} \to {C_4},{C_4} \to {C_5},\\ {C_5} \to {C_6},{C_6} \to {C_7},{C_8} \to {C_9},{C_9} \to {C_{10}},\\ {C_{10}} \to {C_{11}},{C_6} \to {C_7},{C_3} \triangleright {C_4},{C_4} \triangleright {C_5},\\ {C_5} \triangleright {C_6},{C_5} \triangleright {C_7},{C_8} \triangleright {C_9},{C_9} \triangleright {C_{10}},\\ {C_{10}} \triangleright {C_{11}} \end{array} $ |

其中,Ci→Cj表示存在序列约束关系,Ci

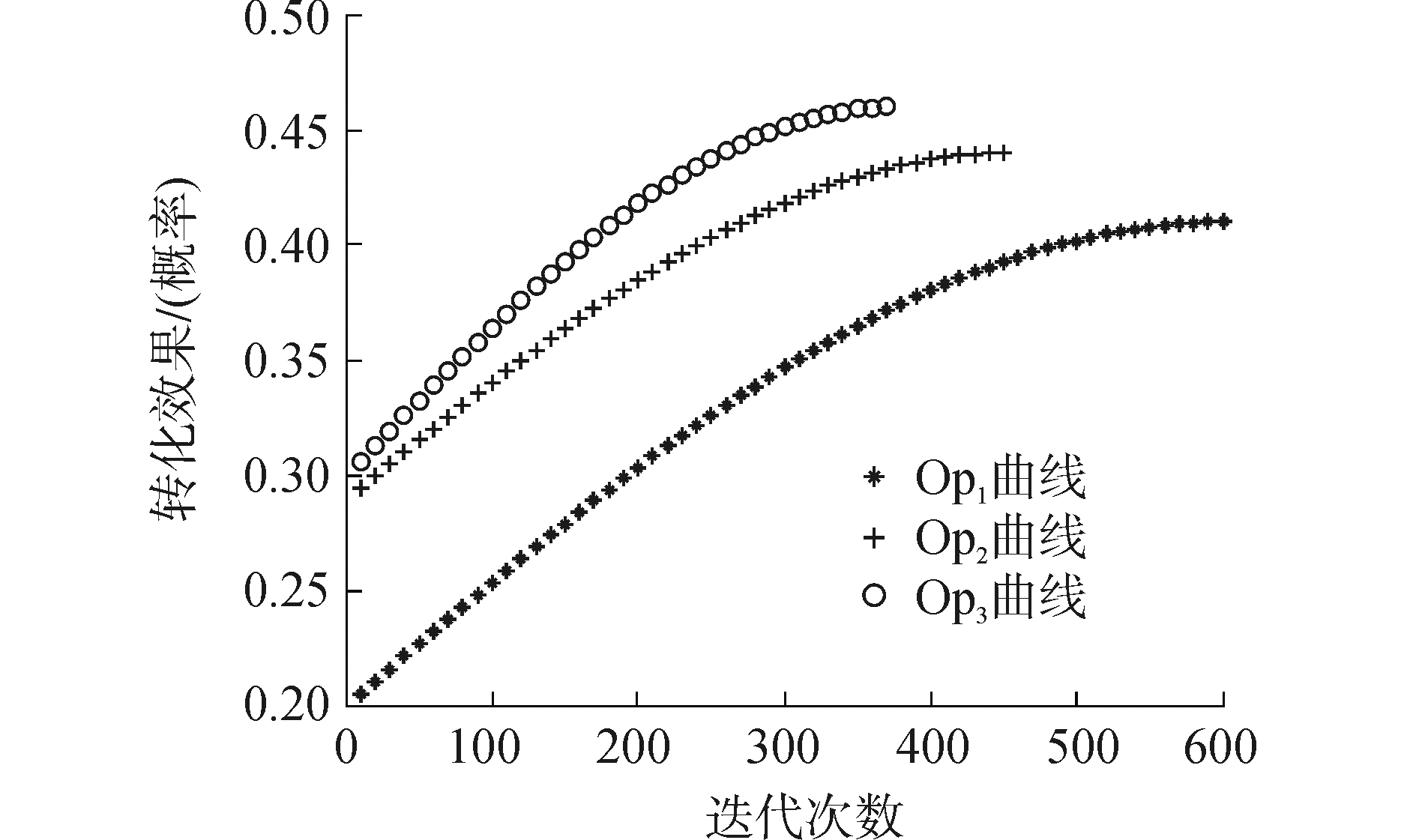

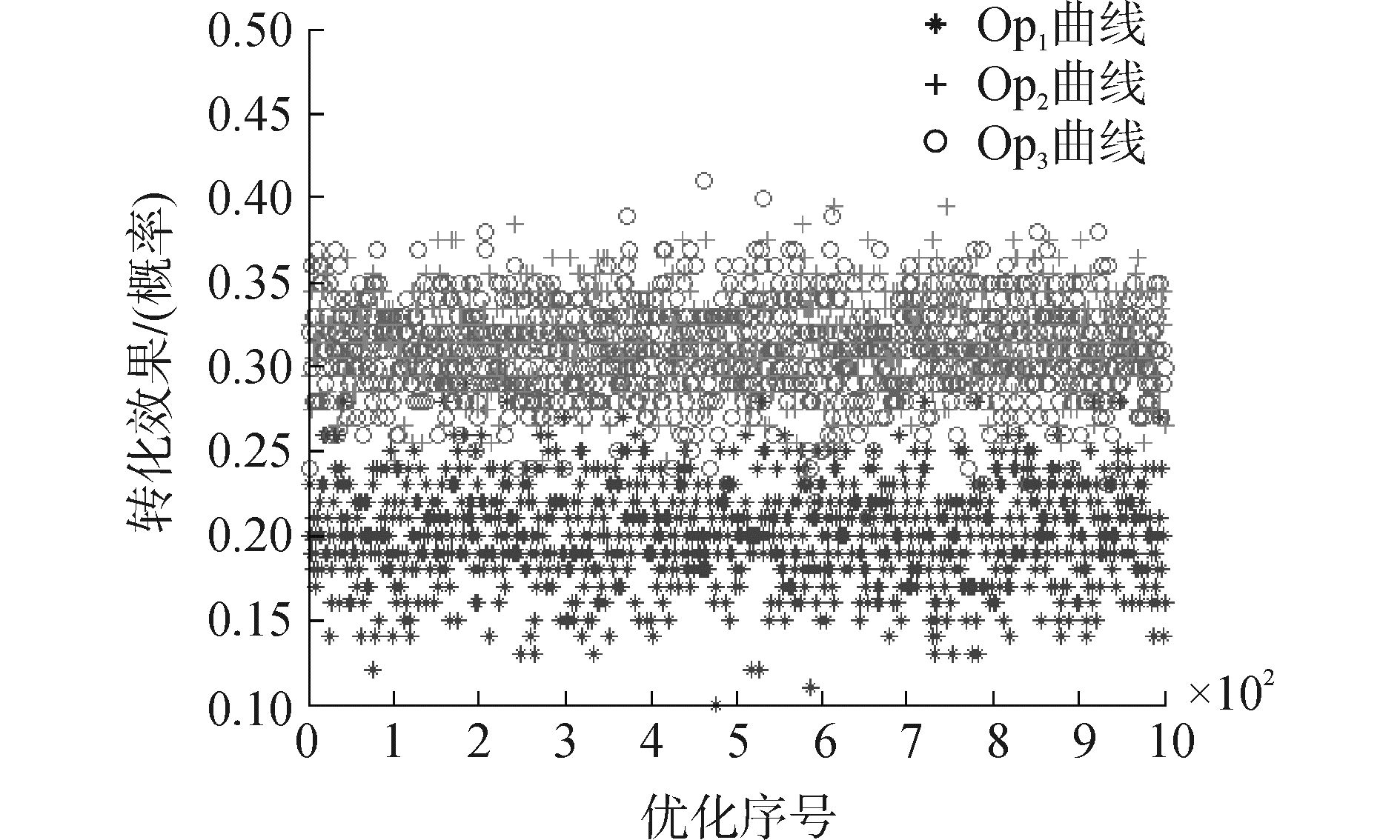

对每种优化方式开展1 000次重复优化,其中转化效果以对敌毁伤概率进行表征。

1) 转化效果演化进程。

如图 5所示,为某一次三种优化方式转化效果的演化进程;总体上,每次优化过程都服从图 5所示的曲线。第1次迭代结束后,Op2、Op3的值要优化于Op1,这是因为战能环起了作用;Op2、Op3的值基本相同,这是因为转化系数还未构建,三者以优化次数作为标识的初始值分布如图 6所示。

|

Download:

|

| 图 5 转化效果演化进程 Fig. 5 Evolution process of transform effect | |

|

Download:

|

| 图 6 初次迭代转化效果 Fig. 6 Transform effect of initial iteration | |

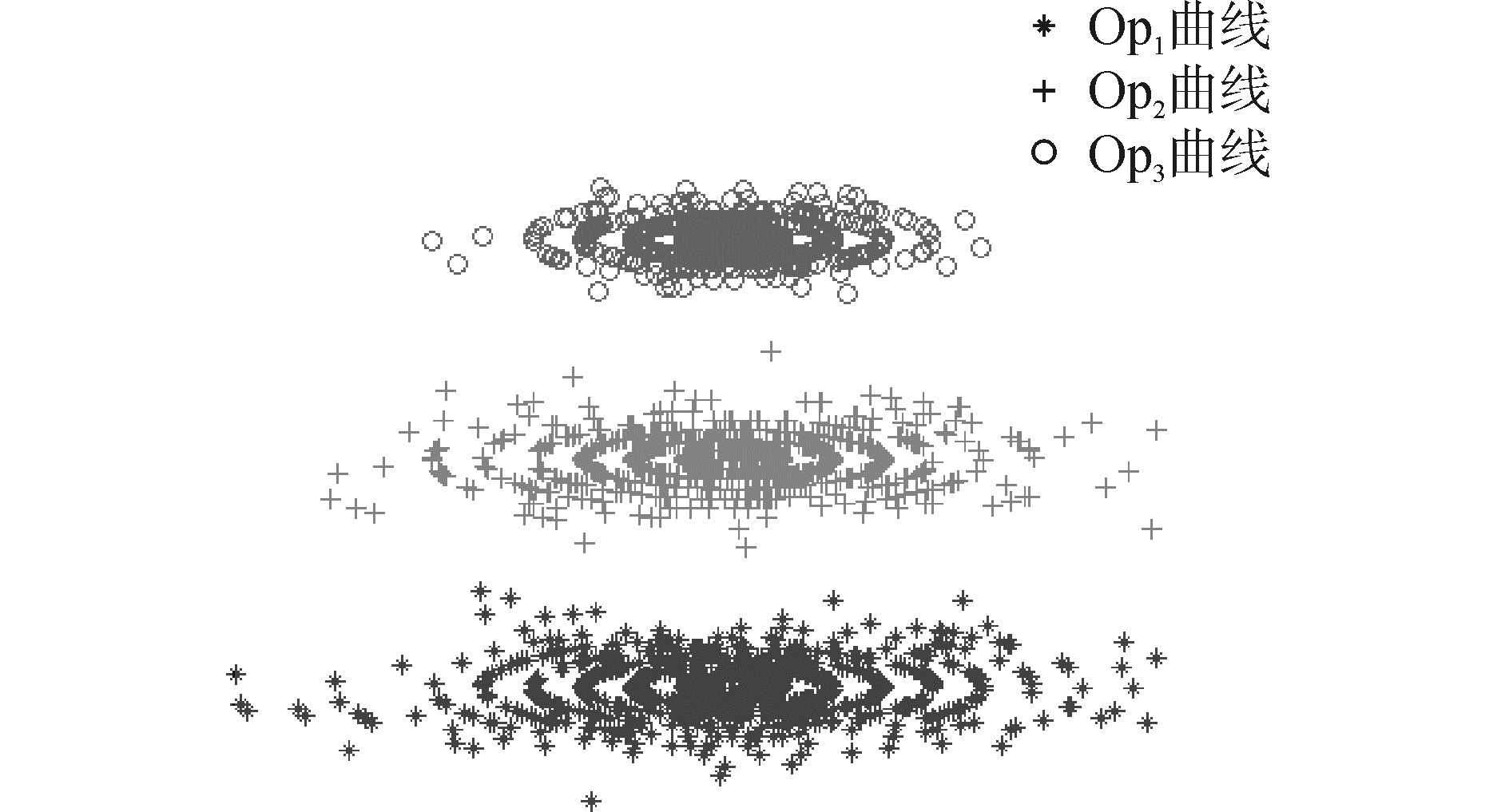

2) 优化效果均值方差。

1 000次优化的结果如图 7所示,构建方式为极坐标系:以均值为中心,以距离为极轴,以优化序号标识夹角;统计值如表 1所示。由图及统计值可知,Op3无论在优化质量还是优化效率方面,都要优于Op1、Op2。

|

Download:

|

| 图 7 转化效果分布 Fig. 7 Distribution of transform effects | |

| 表 1 优化效果均值方差 Table 1 Mean value and variance of optimize result |

由实验结果可知,战能环及战能转化系数的引入将大大提高方案探索的效率,有利于快速形成战法训法。经实验可得,作战平台A、B采用如图 8所示的就位态势所示进行搜攻任务,作战平台A采用探测方式RD1、搜索方式RS1、机动方式RM1;作战平台B采用探测方式RD2、搜索方式RS3、机动方式RM2。

|

Download:

|

| 图 8 红方搜攻任务方式 Fig. 8 Red side search and attack mode | |

1) 借鉴AlphaGo的思路,将优化算法嵌入到作战进程中,以动态能力作为评价准则,通过红蓝双方智慧博弈来探究作战行为与装备系统的最佳组合;相比于传统方法,能取得更好的优化效率及效果,为研究战争规律提出了一种新的解题思路。

2) 辅助决策存在于部分作战系统中,但通常都属于基于规则库或解析模型的单步决策,即单点最优性;本研究为考虑多时段的博弈决策,具有全局最优性。因此,本研究不仅可以有效服务于战法训法创新;还可为辅助决策系统或智能指控系统的构建提供借鉴,或达到一定成熟度时,作为一型装备装配到作战平台上。

3) 作战大致可分为战略、战役、战术三个层次,本文的立足点为战术博弈,其能力状态的量化分析相对简单;如何量化战役、战略层红蓝双方的动态能力,并据此开展优化分析,以为高层指挥员进行兵力运用提供支持,是下一步研究的方向。

| [1] |

李涛, 余军, 吴小勇, 等. 作战实验在海军装备体系建设中的应用研究[J]. 国防科技, 2014, 35(4): 37-41, 49. LI Tao, YU Jun, WU Xiaoyong, et al. Research on the applications of operational experimentation in the building of naval weapon equipment systems of system[J]. National defense science & technology, 2014, 35(4): 37-41, 49. (  0) 0)

|

| [2] |

王辉青, 张德群. 论我军作战实验发展与运用的若干重要问题[J]. 军事运筹与系统工程, 2011, 25(4): 11-14. WANG Huiqing, ZHANG Dequn. Some important issues in the development and application of operational experiments in our army[J]. Military operations research and systems engineering, 2011, 25(4): 11-14. DOI:10.3969/j.issn.1672-8211.2011.04.003 (  0) 0)

|

| [3] |

军事科学院军事运筹分析研究所. 作战实验实施指南[M]. 北京: 军事科学出版社, 2008: 1-20. Military Operations Research and Analysis Institute, Academy of Military Sciences (translate). Operational experiment guide[M]. Beijing: Military Science Publishing House, 2008: 1-20. (  0) 0)

|

| [4] |

TOKGOZ A, BULKAN S. Weapon target assignment with combinatorial optimization techniques[J]. International journal of advanced research in artificial intelligence, 2013, 2(7): 39-50. (  0) 0)

|

| [5] |

张滢, 杨任农, 左家亮, 等. 改进分解进化算法求解动态火力分配多目标优化模型[J]. 兵工学报, 2015, 36(8): 1533-1540. ZHANG Ying, YANG Rennong, ZUO Jialiang, et al. Improved decomposition-based evolutionary algorithm for multi-objective optimization model of dynamic weapon-target assignment[J]. Acta armamentarii, 2015, 36(8): 1533-1540. DOI:10.3969/j.issn.1000-1093.2015.08.022 (  0) 0)

|

| [6] |

董朝阳, 路遥, 王青. 改进的遗传算法求解火力分配优化问题[J]. 兵工学报, 2016, 37(1): 97-102. DONG Chaoyang, LU Yao, WANG Qing. Improved genetic algorithm for solving firepower distribution[J]. Acta armamentarii, 2016, 37(1): 97-102. (  0) 0)

|

| [7] |

夏维, 刘新学, 范阳涛, 等. 基于改进型多目标粒子群优化算法的武器-目标分配[J]. 兵工学报, 2016, 37(11): 2086-2093. XIA Wei, LIU Xinxue, FAN Yangtao, et al. Weapon-target assignment with an improved multi-objective particle swarm optimization algorithm[J]. Acta armamentarii, 2016, 37(11): 2086-2093. (  0) 0)

|

| [8] |

国海峰, 侯满义, 张庆杰, 等. 基于统计学原理的无人作战飞机鲁棒机动决策[J]. 兵工学报, 2017, 38(1): 160-167. GUO Haifeng, Hou Manyi, ZHANG Qingjie, et al. UCAV robust maneuver decision based on statistics principle[J]. Acta armamentarii, 2017, 38(1): 160-167. DOI:10.3969/j.issn.1000-1093.2017.01.021 (  0) 0)

|

| [9] |

陈伟龙, 陈春良, 史宪铭, 等. 基于变体GA的进攻作战抢修任务动态调度[J]. 系统工程与电子技术, 2017, 39(3): 577-583. CHEN Weilong, CHEN Chunliang, SHI Xianming, et al. Dynamic scheduling of battlefield rush-repair tasks in the offensive operation based on variant GA[J]. Systems engineering and electronics, 2017, 39(3): 577-583. (  0) 0)

|

| [10] |

阮旻智, 傅健, 周亮, 等. 面向任务的作战单元携行备件配置优化方法研究[J]. 兵工学报, 2017, 38(6): 1178-1185. RUAN Minzhi, FU Jian, ZHOU Liang, et al. Configuration and optimization method of carrying spares of mission-oriented combat unit[J]. Acta armamentarii, 2017, 38(6): 1178-1185. DOI:10.3969/j.issn.1000-1093.2017.06.018 (  0) 0)

|

| [11] |

杨迎辉, 李建华, 南明莉, 等. 网络化作战信息流转策略适应性演化建模[J]. 系统工程与电子技术, 2017, 39(7): 1513-1523. YANG Yinghui, LI Jianhua, NAN Mingli, et al. Adaptive evolution modeling for networked operational information flowing strategy[J]. Systems engineering and electronics, 2017, 39(7): 1513-1523. (  0) 0)

|

| [12] |

王枭, 刘雅奇, 齐锋. 基于Apriori算法的作战仿真探索实验控制[J]. 系统工程与电子技术, 2017, 39(4): 917-923. WANG Xiao, LIU Yaqi, QI Feng. Control method of apriori based exploratory warfare simulation experiment[J]. Systems engineering and electronics, 2017, 39(4): 917-923. (  0) 0)

|

| [13] |

吴红.面向联合火力打击任务规划的双层联动仿真优化方法研究[D].长沙: 国防科技大学, 2015: 18-27. WU Hong. Study on double linkage simulaiton optimization for joint fire strike mission planning[D]. Changsha: National University of Defense Technology, 2015: 18-27. (  0) 0)

|

| [14] |

舒宇, 谭跃进, 李菊芳. 武器装备体系结构描述方法研究[J]. 系统工程与电子技术, 2008, 30(9): 1704-1707. SHU Yu, TAN Yuejin, LI Jufang. Study on an architecture description method of weapon equipment systems[J]. Systems engineering and electronics, 2008, 30(9): 1704-1707. DOI:10.3321/j.issn:1001-506X.2008.09.026 (  0) 0)

|

| [15] |

ZEIGLER B P, PRAEHOFER H, KIM T G. Theory of modeling and simulation[M]. San Diego, CA: Academic Press, 2000: 50-65.

(  0) 0)

|

| [16] |

刘磊.面向武器装备体系发展的体系演化建模与探索分析方法研究[D].长沙: 国防科技大学, 2011: 49-51. LIU Lei. Research on evolution modeling and exploratory analysis methodology for weapon equipment system of systems development[D]. Changsha: National University of Defense Technology, 2011: 49-51. (  0) 0)

|

| [17] |

李璟. 战斗力解析[M]. 北京: 国防大学出版社, 2013: 100-123. LI Jing. Analysis of combat capability[M]. Beijing: National Defense University Press, 2013: 100-123. (  0) 0)

|

| [18] |

朱刚, 谭贤四, 王红, 等. 复杂信息关系集成的指挥控制模型[J]. 复杂系统与复杂性科学, 2015, 12(1): 53-61. ZHU Gang, TAN Xiansi, WANG Hong, et al. Command and control model based on complex information relation integration[J]. Complex systems and complexity science, 2015, 12(1): 53-61. (  0) 0)

|

| [19] |

张宇, 黄建新. 应用OODA环模型研究装备对体系贡献程度[J]. 现代防御技术, 2017, 45(2): 177-182. ZHANG Yu, HUANG Jianxin. Study on contribution degree of equipment to system of systems using OODA loop model[J]. Modern defense technology, 2017, 45(2): 177-182. DOI:10.3969/j.issn.1009-086x.2017.02.028 (  0) 0)

|

| [20] |

周树德, 孙增圻. 分布估计算法综述[J]. 自动化学报, 2007, 27(2): 113-124. ZHOU Shude, SUN Zengqi. A survey on estimation of distribution algorithms[J]. Acta automatica sinica, 2007, 27(2): 113-124. (  0) 0)

|

| [21] |

BOWLING M, BURCH N, JOHANSON M, et al. Heads-up limit hold'em poker is solved[J]. Science, 2015, 347(6218): 145-149. DOI:10.1126/science.1259433 (  0) 0)

|

| [22] |

SILVER D, HAUNG Ajia, MADDISON C J, et al. Mastering the game of Go with deep neural networks and tree search[J]. Nature, 2016, 529(7587): 484-489. DOI:10.1038/nature16961 (  0) 0)

|

| [23] |

SILVER D, SCHRITTWIESER J, SIMONYAN K, et al. Mastering the game of Go without human knowledge[J]. Nature, 2017, 550(7676): 354-359. DOI:10.1038/nature24270 (  0) 0)

|

| [24] |

郭艳燕, 童向荣, 张楠, 等. 基于演化博弈论的网络信息传播群体行为分析[J]. 智能系统学报, 2016, 11(4): 487-495. GUO Yanyan, TONG Xiangrong, ZHANG Nan, et al. Analysis of network information propagation population behavior based on evolutionary game theory[J]. CAAI transactions on intelligent systems, 2016, 11(4): 487-495. (  0) 0)

|

| [25] |

赵璨, 段琼, 何增有. 基于概率图模型的蛋白质推断算法[J]. 智能系统学报, 2016, 11(3): 376-383. ZHAO Can, DUAN Qiong, HE Zengyou. Protein inference method based on probabilistic graphic model[J]. CAAI transactions on intelligent systems, 2016, 11(3): 376-383. (  0) 0)

|

2018, Vol. 39

2018, Vol. 39