扩展功能

文章信息

- 刘建蓓, 单东辉, 郭忠印, 骆中斌, 张志伟

- LIU Jian-bei, SHAN Dong-hui, GUO Zhong-yin, LUO Zhong-bin, ZHANG Zhi-wei

- 无人机视频的交通参数提取方法及验证

- An Approach for Extracting Traffic Parameters from UAV Video and Verification

- 公路交通科技, 2021, 38(8): 149-158

- Journal of Highway and Transportation Research and Denelopment, 2021, 38(8): 149-158

- 10.3969/j.issn.1002-0268.2021.08.020

-

文章历史

- 收稿日期: 2020-08-31

2. 中交第一公路勘察设计研究院有限公司, 陕西 西安 710065;

3. 交通安全应急保障技术交通运输行业研发中心, 陕西 西安 710065

2. CCCC First Highway Consultants Co., Ltd., Xi'an Shaanxi 710065, China;

3. R & D Center of Traffic Safety and Emergency Security Technology, Ministry of Transport, Xi'an Shaanxi 710065, China

交通监测是交通运营管理的基础,交通监测主要依赖于各类检测设备,主要分类两类:固定型交通检测器(如微波、雷达等)和移动型交通检测设备(GPS,浮动车等)。然而,固定型交通检测器布设数量有限、且仅能获取断点数据,难以准确评估连续路段的交通状态;移动型检测设备受抽样率的影响,在可靠性方面有一定局限性。因此,如何机动灵活、实时准确、高可靠性的获取目标区域的交通参数,是智慧交通需要解决的关键性问题之一。

无人机通过搭载高清摄像机和通讯设备,可实现定点、巡航等机动、灵活的交通实时、连续监测。无人机视频监测集成了固定型检测器和移动型检测器的特点,根据应用场景需求,可定点、可移动,且视频信息量大、可溯源;无人机视频结合计算机图像处理技术,可大范围获取交通流量、车辆轨迹、速度等交通参数;在交通领域关注程度日益增加[1-2]。目前,无人机在交通领域的实践与应用主要涉及交通执法和交通监测两个方面[3-4], 交通执法如在中国、美国、加拿大、俄罗斯等均有应用案例[5];交通监测主要利用无人机快捷、便利的特点,进行交通预警和决策研判,如交通事件管理、应急救援等[6-7];近期,有学者研究利用无人机群实时监测道路交通运行状态,从而支撑交通流优化控制和拥堵方面的研究[4, 8]。

无人机监测应用的关键在于视频车辆检测和跟踪算法,通过不同时刻车辆位置信息提取其速度、轨迹等信息[9]。在车辆目标检测方面,主要方法有光流法、背景差异法、梯度比较法及知识型检测法等;近年来,深度学习技术的快速发展大大的推动了图像目标检测的效果,针对不同的检测场景和任务,国内外研究人员提出了多种目标检测的神经网络,如Fast-RCNN、Faster-RCNN、YOLO等[10]。同时,发布了通用场景下的目标检测公开数据集,用于深度学习模型的训练,如ImageNet、COCO、Pascal VOC、KITTI Vision等。在目标跟踪算法方面,主要分为单目标跟踪与多目标跟踪;单目标跟踪是在视频的第一帧标记目标的位置和大小,根据当帧目标的状态,预测下帧目标的位置和大小;多目标跟踪是每一帧有多个目标,需要在视频中为不同的目标分配标签,预测多个目标的位置与大小。Henriques等人提出了KCF算法[11],KCF算法在当前帧目标区域采样,训练出一个相关滤波器,然后在下一帧同一位置附近采样,根据上一帧训练出的相关滤波器,判断采样的响应程度,响应程度最大的区域则可预测为下一帧的目标所在位置。Bewley等人提出的Sort算法[12]和Deep-Sort算法[13]是非常强大的多目标跟踪算法,Sort算法利用卡尔曼滤波器和匈牙利算法来跟踪目标,而Deep-Sort算法则为其加入了目标特征信息来预测目标和关联数据。中科院、牛津等在CVPR 2019提出SiamMask网络[14],可同时预测目标的Mask和Bounding box,视频跟踪精度较优。

综上所述,利用无人机视频监测提取交通参数信息已经引起了国内外许多学者的注意,大多应用集中在交通流观测、应急救援、执法等中宏观层面,对于微观车辆参数提取和验证方面仍处于探索研究阶段。基于图像处理技术,将每帧的静态信息检测、跟踪,转变为实时动态的微观交通参数,目前研究仍存在以下局限[15-17]:(1)无人机视频车辆检测和跟踪的精度不足,通常小于90%[18-19];(2)由于交通场景复杂,无人机视频交通参数提取精度缺乏有效的实地验证。针对上述局限性,本研究提出一种无人机视频交通参数提取方法,并通过现场试验交叉验证其可行性和可靠性。

如图 1所示,本研究提出的无人机交通参数提取方法包括外业和内业部分,外业主要采集道路特征点世界坐标和无人机视频;内业部分主要包括世界坐标和图像坐标转换、车辆检测和追踪、车辆交通参数计算和提取。

|

| 图 1 无人机视频交通参数提取方法及流程 Fig. 1 Method and process for extracting traffic parameters from UAV video |

| |

1 图像参数转换 1.1 坐标系转换

交通参数的获取需要将图像信息转化为真实的物理信息,即需要将图像坐标转化为真实坐标来计算交通参数,建立图像坐标和世界坐标的转换矩阵是交通参数提取的基础。

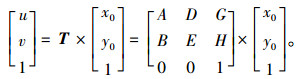

具体方法为:从每个视频中挑选一帧图像作为该视频的参考帧,记为N0;在参考帧上标记若干个标记点,并记录其图像坐标,同时获取相同标记点的世界坐标,两个坐标系下的相同的两个序列具有对应关系,通过数学运算可计算出参考帧图像坐标系和世界坐标系的透视投影矩阵T,从而利用透视投影矩阵T实现两组坐标系之间的转换,这个过程称为单应性变换[20]。坐标关系如下表示:

|

(1) |

式中,[u v p]为世界坐标,[x0 y0 z0]为参考帧N0的图像坐标。由于图像坐标为二维坐标,无人机飞行高度远远大于路面坡度差,此时坐标系转化问题转化为单平面转换,故三维坐标中高程方向的参数可取1[14],可用式(2)表示:

|

(2) |

将已知的世界坐标以及参考帧的图像坐标代入上述公式中,即可求得透视投影矩阵T。

1.2 图像匹配在假设摄像机完全固定的前提下,场景内所有相同位置的点在视频图像中每一帧的图像坐标是不会变化的,因此,理想状态下投影矩阵T适用于整个视频。然而,在实际场景下,摄像机可能受到外界的干扰(如微风、抖动等)发生微小位移、俯仰角变化等。尤其是无人机,在采集数据的过程中不可能达到完全静止,同一固定点不同帧的图像坐标会发生变化。因此,在完成图像坐标与世界坐标转换之后,需要旋转位移矩阵W标定第n帧与参考帧(N0)之间的对应关系,这就是图像匹配过程[21]。如式(3)表示不同帧之间的图像匹配过程:

|

(3) |

式中, (xn, yn)为第n帧图像坐标; (x0, y0)为参考帧N0图像坐标,根据路面标记的特征点,可得到多个方程组,从而求得第n帧与参考帧之间的旋转位移矩阵W。

2 车辆检测与跟踪算法 2.1 车辆目标检测车辆目标检测是交通参数提取的前提,也是计算机视觉与图像处理领域最受关注的任务之一。

本研究采用YOLO v3车辆检测模型,YOLO v3的核心思想是将每一帧图像作为网络输入,然后在输出层直接回归出目标框的位置和属性类别,从而实现端对端的直接优化。具体过程为:将输入图像分为S×S个网格,当某个目标中心落在这个网格中,则该网格就负责预测该目标;然后,对每个网格预测B个边框(Bounding Box),每一个box包含4个信息:中心点坐标(xc,yc)、高度(h)、宽度(w)及可信度(Confidence);同时,在每个网格中预测C个类别概率值;则得到S×S×B个目标预测窗口和S×S×B×(5+C)个预测参数,通过阈值筛选和非最大抑制(NMS)去除多余窗口;最终得到检测目标节点集N={Ni, i=1, 2, 3, …, n}和轨迹集T={Tj, j=1, 2, 3, …, m}。

YOLO v3是目前精度较高、速度较快的检测算法,在Pascal Titan X上检测速度达到了30帧/s。在mAP相当的情况下,YOLO v3的速度为SSD的2.8倍,是RetinaNet的4倍,更是FPN FRCN的7.8倍,可见YOLO v3的处理速度优势明显[22]。

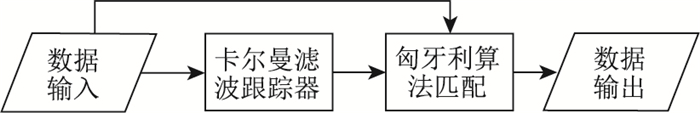

2.2 多目标跟踪算法在目标检测过程中,可以获取车辆在视频每一帧中的位置、大小等信息。为了将同一个车辆的信息在视频所有帧统一起来,需要将在不同帧出现的同一车辆命名同一个ID,为解决此问题,多目标跟踪算法被提出。本研究采用Deep-Sort多目标跟踪算法。其基本思想是基于检测的跟踪方法(Tracking-by-detection)[23],其算法结构如图 2所示。

|

| 图 2 Deep-Sort算法结构 Fig. 2 Deep-Sort algorithm structure |

| |

Deep-Sort多目标跟踪算法是通过卡尔曼滤波在图像空间跟踪目标数据,以及对跟踪和检测结果进行重叠度评价而实现数据关联,从而实现对目标跟踪的算法。所花费的时间较短,精度较高的特点。实现步骤如下:

(1) 将当前帧目标检测节点集N={Ni, i=1, 2, 3, …, n}和轨迹集T={Tj, j=1, 2, 3, …, m}为数据输入。

(2) 对车辆历史轨迹进行卡尔曼预测,得到轨迹j在第n帧的预测节点集Njn。

(3) 计算当前帧预测集与检测集的IOU匹配度,IOU=(xij)n×m,其中

(4) 通过匈牙利指派算法得到IOU最大的唯一匹配,进行数据关联[24-25];采用级联匹配的方式,使时间上临近几帧出现的目标具有较高的分配权重,同时对于每条轨迹存储数值δ, 记录轨迹从上一次成功匹配到此时的时间。若δ大于某一个设定的阈值,则认为该条轨迹终止。

3 车辆交通参数提取方法通过车辆目标检测和跟踪,能够产生不同帧同一车辆的位置信息,通过单应性变换,计算车辆相邻帧之间的真实移动距离,利用相邻帧之间的时间差计算车辆的位移、瞬时车速及加速度。由于相邻两帧之间车辆的位置变化很小,无法准确判断车辆的位移。本研究以5帧为间隔研究车辆的位置变化,利用相邻帧间的时间及车辆的真实位移计算车辆在相应帧的车速、加速度车头间距等车辆运行参数。

(1) 速度

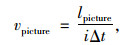

在图像中选定检测出车辆并对其进行跟踪,计算图像上车辆的速度,如式(3)所示:

|

(3) |

式中,lpicture是车辆中心点i帧的图像位移;Δt是相邻两帧的时间间隔。

通过标定车辆位置的变化可获得车辆在图像上的位移lpicture,根据坐标转换关系即可计算出车辆的真实位移lture,则目标车辆的真实速度vture如式(4)所示:

|

(4) |

(2) 车道位置

除了人工标记点,道路表面的车道线是车辆参数提取的重要参考之一,通过计算车辆和车道线的位置关系,可以获得车辆行驶的车道和轨迹信息,进而能够分析车辆换道、超车等行为。

标定帧中每条车道线的拟合函数集F={fi(x)}, 其中,i为车道线的数量。将检测框矫正后的中心点的横坐标x′c代入F中,得到集合{ai}={fi(x′c)},通过比较y′c和ai,若:

① ai<y′c,说明第i条车道线在该中心点的上方;

② ai≥y′c,说明第i条车道线在该中心点的下方。

由此来判定,该中心点位于哪两条车道线之间,从而判定该检测框代表的车辆当前处于哪个车道。

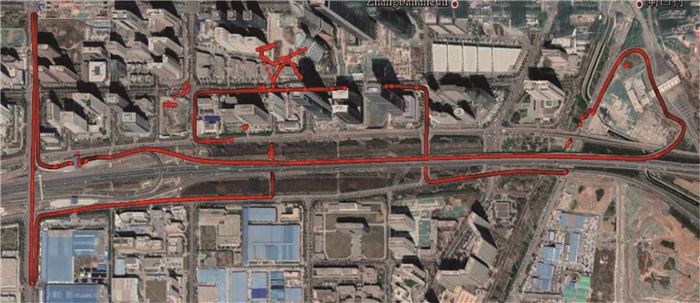

4 验证试验 4.1 试验过程试验共分4个步骤:试验路段选取、路面特征点测量、试验车辆准备、无人机悬停拍摄。

选取西安绕城高速丈八立交出口硬鼻端至上游约1 km范围为试验路段(如图 3所示),选用大疆PHANTOM 4 PRO无人机进行空中俯拍,此无人机相机参数为:3 840×2 160 24/25/30p@100 Mbps,重量1.375 kg;选取路面标线和人工标记点为特征点,特征是图像坐标和世界坐标转换的纽带,因此,试验之前在试验路段路面每间隔50 m粘贴方形标记块(50 cm×50 cm),共增加40个人工标记点(如图 4所示),道路标线端头作为道路自身标记点,共计386个道路特征点,并对特征点进行高精度测量,记录其世界坐标下的经纬度坐标。

|

| 图 3 试验路段及试验车辆 Fig. 3 Experimental sections and vehicles |

| |

|

| 图 4 路面标记点坐标测量 Fig. 4 Coordinate measurement of pavement markings |

| |

选用天宝Trimble SPS985 GNSS智能一体机RTK和车载OBD采集车辆实时运动参数。试验车辆准备阶段,用1 m×1 m方形标记块标记两辆试验车辆;并在试验车辆顶部标记中心处安装高精度GNSS差分定位移动站,设定数据频率为20 Hz;调试车载OBD通过蓝牙与手机APP连接,实时记录车辆总线数据。车载OBD实时输出车辆速度、加速度、位置等信息;GNSS通过差分基站能够将定位精度提高到厘米级,输出车辆实时位置、速度等信息[26];结合两种设备的输出数据,组合验证视频识别算法的准确性和精度。验证试验过程如图 5所示。

|

| 图 5 试验过程示意 Fig. 5 Schematic diagram of test process |

| |

验证试验过程在2019年4月23日,晴朗、无风天气进行,试验时间段为上午9:30~下午5:00,无人机操作员在进行每次飞行监测前监测控制面板和无人机终端通信连路、检测电池容量;飞行高度共有150,200,210,250,350 m这5种,试验路段试验车辆行驶速度40~90 km/h之间;单次飞行试验持续10 min,共进行7次不同高度、不同运行速度试验设计,共拍摄70 min试验路段监测视频,其中试验车辆出现时间共计210 s,产生5 400帧含试验车辆的画面,共计1 192个速度验证信息,如图 6所示。验证试验设计如表 1所示。

|

| 图 6 实时记录的数据验证 Fig. 6 Verification of recorded data |

| |

| 试验序号 | 试验车出现时长/s | 试验车车速/(km·h-1) | 无人机高度/m | 试验路段在视频画面中的长度/m |

| 1 | 24 | 40~70 | 200 | 285 |

| 2 | 20 | 50~80 | 210 | 300 |

| 3 | 35 | 50~70 | 200 | 285 |

| 4 | 30 | 50~80 | 200 | 285 |

| 5 | 25 | 30~80 | 150 | 220 |

| 6 | 26 | 50~60 | 250 | 360 |

| 7 | 30 | 50~90 | 350 | 500 |

4.2 数据分析

在上述试验路段、试验车辆视频数据采集外业工作完成之后,内业数据处理主要集中在车辆视频监测算法、跟踪算法训练和交通参数对比分析。

(1) 目标检测精度

本研究利用YOLO v3神经网络架构模型训练试验路段场景下的视频数据,算法代码用Python语言编写。训练模型时,需要对动量(momentum)、衰减(decay)和学习率的进行设定;本研究设定参数Momentum=0.93、decay=0.005;为了防止过高的学习率导致不稳定的梯度下降而使得检测模型发散,学习率初始值设定为0.000 1;当迭代达到45 000次时,损失曲线趋于平稳,但平均损失值还没有下降到0.1以内,继而设定在45 000次时学习率为0.000 01,继续训练;最终迭代至85 000次附近时趋于平稳,得到最后检测模型。检测结果如图 7所示,精度如表 2所示。

|

| 图 7 无人机视频目标检测 Fig. 7 Target detection by UAV video |

| |

| GT | TP | FP | FN | 召回率/% | 精准率/% | AP/% |

| 5 030 | 4 975 | 1 | 55 | 98.9 | 99.9 | 90.88 |

| 注:GT为Ground Truth地面真值。 | ||||||

在对目标检测模型进行训练时,本研究主要利用两个指标:精确率(Precision)和召回率(Recall)评估车辆检测精度[27]。

|

(5) |

|

(6) |

式中,TP(True Positives)为被正确检测为运动车辆的像素数量;FP(False Positives)为被错误检测为运动车辆的像素数量;FN(False Negatives)为被错误检测为背景的像素数量。同时根据召回率与精度,可以计算AP(Average Precision),AP为在各个等差召回率下精度的平均值,由此可表征模型的精度。

结果表明:试验路段试验车辆目标检测召回率与精度分别为98.9%,99.9%,平均精度为90.88%。

(2) 目标追踪精度

多目标跟踪的精度主要由MOTA (Multiple Object Tracking Accuracy)和MOTP (Multiple Object Tracking Precision)指标评价[28],这两个指标均是将所有帧中的相关跟踪指标进行加权计算后,再取平均值的结果。

|

(7) |

|

(8) |

式中,FNt为当前帧中未被匹配到的目标数;FPt为跟踪器预测额外的轨迹数;IDSW(ID Switch)为同一个目标,在跟踪过程中,为其分配的ID变化的次数,其表征的是标签信息发生的错误;IOU为预测框与对应的检测框之间Bonding box的重合比率;Gt则是当前帧中目标匹配成功的数目。

MOTA主要衡量的是跟踪过程中所有目标匹配成功的精度,直观地显示目标跟踪器在保持目标轨迹的能力,与预测目标位置的精度无关;MOTA越大跟踪精度越高。MOTP主要衡量的是目标检测的精度,与位置信息相关,而与跟踪匹配的精度无关;MOTP越大,预测框的位置更加精确。结果表明,多目标跟踪的准确率达98.9%,如图 8和表 3所示。

|

| 图 8 无人机视频多目标跟踪 Fig. 8 Multi-object tracking by UAV |

| |

| GTt | FPt | FNt | IDSW | MOTA | MOTP |

| 5 090 | 1 | 55 | 0 | 98.9 | 98.8 |

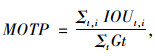

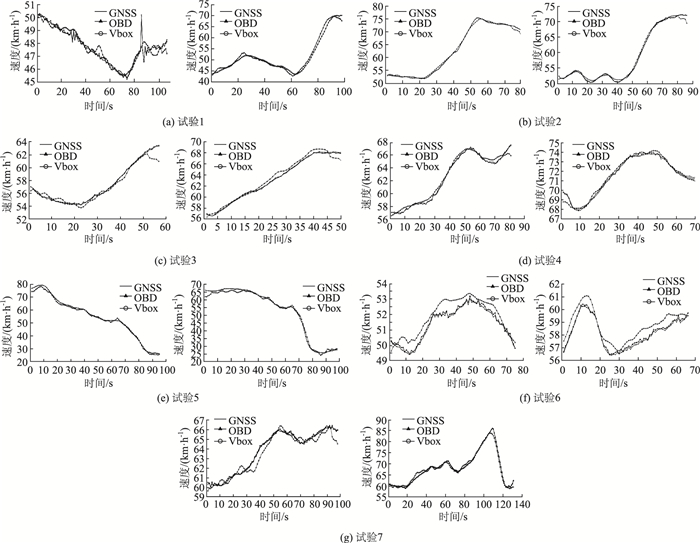

(3) 速度提取精度

车辆目标检测和跟踪能够输出车辆的时空信息,根据其坐标位置、时间数据,可以计算视频算法下车辆速度、轨迹等信息,进而目标车辆的不良交通行为(如变道、超速、蛇形驾驶)可识别。但是,对于交通参数而言,最核心、最基本的参数是车辆速度、轨迹信息,其他参数基本可以通过速度、位置、时间数据变换而得到。因此,本研究聚焦无人机视频车辆速度数据的提取验证。

由于每两帧的时间间隔过低,仅仅根据两帧间的时间差来计算速度容易造成较大的误差,故当前帧与第前5帧计算一次速度;由于高精度GNSS定位输出数据设定为20 Hz、车载OBD输出数据为5 Hz,为了对应OBD验证数据,视频识别算法输出速度数据也设定为5 Hz、高精度GNSS定位输出数据平均至最近的OBD时间点;如高精度定位GNSS在11:00:06,11:00:09,11:00:12,11:00:15时间的的平均值对应车载OBD在11:00:12的速度数据。速度准确性用最大绝对误差和平均相对误差衡量,结果如下所示。

如图 9所示,高精度GNSS-RTK定位和车载OBD输出数据基本重合,以GNSS-RTK和车载OBD输出速度的平均值作为参考速度数据,衡量视频识别算法提取速度数据的准确性。由图中可看出,视频算法提取的速度与验证速度偏差最大位置集中在视频的开始和结束帧段,这是由于在此帧段范围内车身并未全部出现在图像画面中,造成检测中心坐标的偏差,进而影响速度参数的误差。

|

| 图 9 验证试验数据对比示例 Fig. 9 Example of validation experiment data |

| |

由表 4可以看出,在试验路段进行不同飞行高度、不同行驶速度7次试验后,试验车A、试验车B分别产生593,599个速度样本数据,结果表明:试验车A、试验车B最大绝对误差分别为2.72,2.99 km/h,相对误差分别为0.85%,1.03%;这表明,视频识别算法提取的车辆速度参数整体绝对误差在±3 km/h以内、相对误差在2%以内,整体准确率达98%。

| 试验次数 | 试验车A | 试验车B | |||||||

| 样本数 | 平均速度/(km·h-1) | 最大绝对误差/(km·h-1) | 相对误差/% | 样本数 | 平均速度/(km·h-1) | 最大绝对误差/(km·h-1) | 相对误差/% | ||

| 1 | 107 | 47.65 | 2.33 | 0.63 | 98 | 52.22 | 2.99 | 1.58 | |

| 2 | 80 | 62.96 | 1.95 | 0.67 | 86 | 58.62 | 2.47 | 0.80 | |

| 3 | 57 | 57.29 | 2.36 | 0.72 | 50 | 63.02 | 1.27 | 0.77 | |

| 4 | 81 | 62.41 | 1.56 | 0.60 | 70 | 71.43 | 1.01 | 0.32 | |

| 5 | 95 | 54.67 | 2.72 | 1.64 | 98 | 52.79 | 2.95 | 1.55 | |

| 6 | 75 | 51.33 | 1.13 | 1.06 | 66 | 58.15 | 1.11 | 1.09 | |

| 7 | 98 | 63.68 | 1.42 | 0.63 | 131 | 68.17 | 2.93 | 1.12 | |

| 合计 | 593 | 57.14 | 2.72 | 0.85 | 599 | 60.63 | 2.99 | 1.03 | |

5 结论

无人机视频监测不同于传统固定型检测器和移动型检测器,根据应用场景需求,无人机可定点、可移动,且视频信息量大、可溯源,在智能交通领域的应用有诸多探索。机动灵活、实时准确、高可靠性的获取目标区域的微观交通参数,是智慧交通需要解决的关键性问题之一。针对无人机视频车辆参数提取问题,基于图像视频识别技术,本研究提出视频车辆运动参数自动提取方法和流程,并采用高精度GNSS定位和车载OBD装载试验车辆,在西安绕城丈八出口实地组合验证视频识别算法准确性。通过以上研究和试验得出以下结论:

(1) 本研究提出的基于YOLO v3和Deep-Sort无人机视频交通参数提取方法,在试验场景中检测召回率和精度分别达98.9%,99.9%,平均精度为90.88%;多目标跟踪的准确率达98.9%。

(2) 利用高精度定位GNSS和车载OBD加装的2辆试验车,共产生5 400帧图像数据、1 192个验证速度点数据,速度参数对比结果表明:车辆速度参数整体绝对误差在±3 km/h以内、相对误差在2%以内,参数提取整体准确率达98%。

(3) 7组不同飞行高度、不同运行速度提取的速度参数误差变化不大,这表明本研究提出的无人机视频交通参数提取方法鲁棒性较高,这得益于试验之前进行了大量的道路特征点采集,使得世界坐标和图像坐标转换过程中误差较小。

无人机空中监测提取车辆微观参数可为智慧交通管控、交通安全研究、交通数据采集等提供新的思路。但是,上述方法仅在高速公路出口上游路段场景试验验证,其方法的可交互性和可转移性还有待其他场景试验进一步验证。本研究试验过程无人机飞行高度在150~350 m,更高的飞行高度可能会造成参数提取误差较大的结果。后续研究将集中在多场景方法验证、不良驾驶行为参数分析、实时主动安全预警等方面。

| [1] |

彭仲仁, 刘晓锋, 张立业, 等. 无人飞机在交通信息采集中的研究进展和展望[J]. 交通运输工程学报, 2012, 12(6): 119-126. PENG Zhong-ren, LIU Xiao-feng, ZHANG Li-ye, et al. Research Progress and Prospect of UAV Applications in Transportation Information Collection[J]. Journal of Traffic and Transportation Engineering, 2012, 12(6): 119-126. |

| [2] |

杜荣义, 彭仲仁. 无人机逆向车辆检测数据时效性分析[J]. 交通运输系统工程与信息, 2014, 14(1): 34-40. DU Rong-yi, PENG Zhong-ren. Time Effectiveness Analysis of UAV Vehicle Detection Data in Reverse Direction[J]. Journal of Transportation Systems Engineering and Information Technology, 2014, 14(1): 34-40. |

| [3] |

BARMPOUNAKIS E N, VLAHOGIANNI E I, GOLIAS J C. Unmanned Aerial Aircraft Systems for Transportation Engineering: Current Practice and Future Challenges[J]. International Journal of Transportation Science and Technology, 2017, 5(3): 111-122. |

| [4] |

BARMPOUNAKIS E, GEROLIMINIS N. On the New Era of Urban Traffic Monitoring with Massive Drone Data: The pNEUMA Large-scale Field Experiment[J]. Transportation Research Part C: Emerging Technologies, 2020, 111: 50-71. |

| [5] |

ROSENFELD A. Are Drivers Ready for Traffic Enforcement Drones?[J]. Accident Analysis & Prevention, 2019, 122: 199-206. |

| [6] |

SUTHEERAKUL C, KRONPRASERT N, KAEWMORACHAROEN M, et al. Application of Unmanned Aerial Vehicles to Pedestrian Traffic Monitoring and Management for Shopping Streets[J]. Transportation Research Procedia, 2017, 25: 1720-1739. |

| [7] |

KAMGA C, SAPPHIRE J, CUI Y, et al. Exploring Applications for Unmanned Aerial Systems (UAS) and Unmanned Ground Systems (UGS) in Enhanced Incident Management, Bridge Inspection, and Other Transportation-related Operations, Final Report[R]. New York: TRID, 2017.

|

| [8] |

GARCIA-AUNON P, ROLDÁN JJ, BARRIENTOS A. Monitoring Traffic in Future Cities with Aerial Swarms: Developing and Optimizing a Behavior-based Surveillance Algorithm[J]. Cognitive Systems Research, 2019, 54: 273-286. |

| [9] |

KANISTRAS K, MARTINS G, RUTHERFORD M J, et al. A Survey of Unmanned Aerial Vehicles (UAVs) for Traffic Monitoring[C]//International Conference on Unmanned Aircraft Systems (ICUAS). Atlanta: IEEE, 2013.

|

| [10] |

LIU W, ANGUELOV D, ERHAN D, et al. SSD: Single Shot Multibox Detector[C]//Proceedings of the 14th European Conference on Computer Vision. Amsterdam: Springer, 2016.

|

| [11] |

HENRIQUES J F, RUI C, MARTINS P, et al. High-speed Tracking with Kernelized Correlation Filters[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2015, 37(3): 583-596. |

| [12] |

BEWLEY A, GE Z, OTT L, et al. Simple Online and Realtime Tracking[J]. 2016 IEEE International Conference on Image Proceedings. Phoenix: IEEE, 2016.

|

| [13] |

WOJKE, NICOLAI AND BEWLEY, ALEX AND PAULUS, DIETRICH. Simple Online and Realtime Tracking with a Deep Association Metric[J]//2017 IEEE International Conference on Image Proceedings. [S. l. ]: IEEE, 2017.

|

| [14] |

WANG Q, ZHANG L, BERTINETTO L, et al. Fast Online Object Tracking and Segmentation: A Unifying Approach[C]//IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Long Beach: IEEE, 2019.

|

| [15] |

WANG L, CHEN F L, YIN H M. Detecting and Tracking Vehicles in Traffic by Unmanned Aerial Vehicles[J]. Automation in Construction, 2016, 36(5): 294-308. |

| [16] |

GUIDO G, GALLELLI V, ROGANO D, et al. Evaluating the Accuracy of Vehicle Tracking Data Obtained from Unmanned Aerial Vehicles[J]. International Journal of Transportation Science and Technology, 2016, 42(6): 136-155. |

| [17] |

李俊彦, 宋焕生, 张朝阳, 等. 基于视频的多目标车辆跟踪及轨迹优化[J]. 计算机工程与应用, 2020, 56(5): 194-199. LI Jun-yan, SONG Huan-sheng, ZHANG Zhao-yang, et al. Multi-object Vehicle Tracking and Trajectory Optimization Based on Video[J]. Computer Engineering and Applications, 2020, 56(5): 194-199. |

| [18] |

TUERMER S, KURZ F, REINARTZ P, et al. Airborne Vehicle Detection in Dense Urban Areas Using HoG Features and Disparity Maps[J]. IEEE Journal of Selected Topics in Applied Earth Observations & Remote Sensing, 2013, 6(6): 2327-233. |

| [19] |

LEITLOFF J, ROSENBAUM D, KURZ F, et al. An Operational System for Estimating Road Traffic Information from Aerial Images[J]. Remote Sensing, 2014, 6(11): 11315-11341. |

| [20] |

SZELISKI R. Computer Vision: Algorithms and Applications[M]. New York: Springer Science & Business Media, 2010.

|

| [21] |

NEJADASL F, LINDENBERGH R. Sequential and Automatic Image-sequence Registration of Road Areas Monitored from a Hovering Helicopter[J]. Sensors, 2014, 14(9): 16630-16650. |

| [22] |

UMBAUGH S E. Digital Image Processing and Analysis: Human and Computer Vision Applications with CVIPtools[M]. New York: CRC Press, 2010.

|

| [23] |

REDMON J, FARHADI A. YOLOv3:An Incremental Improvement[J]. arXiv E-prints, 2018, 11(1): 23-36. |

| [24] |

BABENKO B, YANG M H, BELONGIE S. Robust Object Tracking with Online Multiple Instance Learning[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33: 1619-1632. |

| [25] |

BOCHINSKI E, EISELEIN V, SIKORA T. High-speed Tracking-by-detection without Using Image Information[C]//14th IEEE International Conference on Advanced Video and Signal Based Surveillance (AVSS). Lecce: IEEE, 2017.

|

| [26] |

吴明先, 许甜, 刘建蓓, 等. 基于高频高精度定位信息的车辆轮廓冲突瞬时预测方法[J]. 中国公路学报, 2019, 32(6): 105-113. WU Ming-xian, XU Tian, LIU Jian-bei, et al. Instantaneous Prediction of Vehicle Outline Conflict Using High-frequency and High-precision Position Information[J]. China Journal of Highway and Transport, 2019, 32(6): 105-113. |

| [27] |

RAHMAN M A, WANG Y. Optimizing Intersection-over-union in Deep Neural Networks for Image Segmentation[C]//International Symposium on Visual Computing. Las Vegas: Springer, 2016, 12(3): 234-244.

|

| [28] |

田澍. 基于监测与跟踪互反馈的多目标跟踪技术及应用研究[D]. 北京: 北京科技大学, 2016. TIAN Shu. Multi-object Tracking with Inter-feedback between Detection and Tracking and Its Application Study[D]. Beijing: University of Science and Technology Beijing, 2016. |

2021, Vol. 38

2021, Vol. 38