随着遥感技术的发展,从遥感影像上获取所需信息已经成为一种非常重要的信息获取手段。不同的卫星传感器对地观测可以为同一地区提供多光谱、多时相、多分辨率的多模态遥感影像(光学、红外、SAR等)。这些多模态遥感影像反映了地物的不同特征,能够为地表监测提供互补的信息,弥补单一影像源的不足,提高影像的信息量[1]。利用多模态遥感影像进行数据分析和处理前,必须进行严格的匹配或配准。虽然目前的遥感影像利用轨道参数和严格几何定位模型进行粗纠正,可消除影像间的旋转和尺度等几何形变[2],但是由于多模态影像间非线性辐射差异较大,即同一地物呈现出完全不同的灰度信息,导致同名点的匹配十分困难,所以多模态遥感影像的自动匹配仍然非常具有挑战性。

目前,影像匹配方法大致可分为两种,基于特征的方法和基于区域的方法[3-4]。基于特征的方法首先是对影像特征进行提取,再利用特征间的相似性进行匹配。常见的特征包括点特征(Moravec算子[5]、Harris算子[6]等)、线特征[7](道路、建筑物的边缘或轮廓)、面特征[8-9](湖泊、草地等)和局部不变性特征(SIFT特征[10-11]、Shape Context[12]等)。这些特征受影像间的非线性辐射差异影响较大,难以反映多模态影像间的共有属性,特征检测的重复率往往较低,从而导致匹配效率低下,不能较好应用于多模态遥感影像的自动匹配[13]。

基于区域的方法也称为模板匹配方法。首先在参考影像上选择适当尺寸的模板窗口,然后在待匹配影像的搜索域中利用某种相似性测度进行匹配,选择匹配窗口的中心作为同名点。常用的相似性度量有归一化互相关(normalized cross correlation,NCC)[14]、互信息(mutual information,MI)[15]等。这些相似性测度直接利用影像灰度信息计算,对灰度信息变化敏感,受辐射差异影响较大,在多模态遥感影像匹配中表现不佳[16]。最近,有学者利用影像间的几何结构特征构建相似性测度,该算法可以较好克服多模态影像间的辐射差异,获得较高的匹配正确率,但是其提取的特征冗余,表达力不够,而且当影像的几何结构特征不够丰富时,其匹配性能可能会有所下降[2]。

随着人工智能技术的发展,深度学习方法已深入应用于计算机视觉、图像处理和大数据等方面。在影像匹配领域,目前已有学者利用深度学习方法开展相关研究。文献[17]分析了不同神经网络模型用于影像匹配的性能,文献[18]将空间尺度卷积层加入卷积神经网络,以加强整体网络的抗尺度特性。文献[19]利用卷积神经网络开展复杂背景条件下的影像匹配研究。目前大多数应用深度学习的匹配研究采用的是基于特征的方法,即先利用特征提取算子在影像间检测特征点,再利用深度学习技术构建特征点的描述子,最后根据描述子之间的相似性识别同名点。由于首先要进行特征点检测,特征检测的性能将大大地影响匹配效率。考虑到多模态影像间显著的辐射差异和噪声干扰,特征检测的重复率往往较低,即无法有效地检测到共有特征,因此这些方法不能有效地应用于多模态影像的匹配。

Siamese网络(孪生网络)[20-21]是一种检测图像相似性的深度学习网络模型。Siamese网络具有深层次特征提取能力,被认为是一种高效的深层网络,并且它可以通过深层网络学习来提取影像间的共有特征,提高影像在不同模态情况下的相似性检测性能,能有效地抵抗影像间的非线性辐射差异。鉴于此,本文将Siamese网络应用于多模态遥感影像匹配,通过对其进行优化,使该网络能有效地提取影像间的共有特征,然后采用模板匹配策略,避免特征检测重复率的影响,来实现多模态遥感影像高精度匹配。

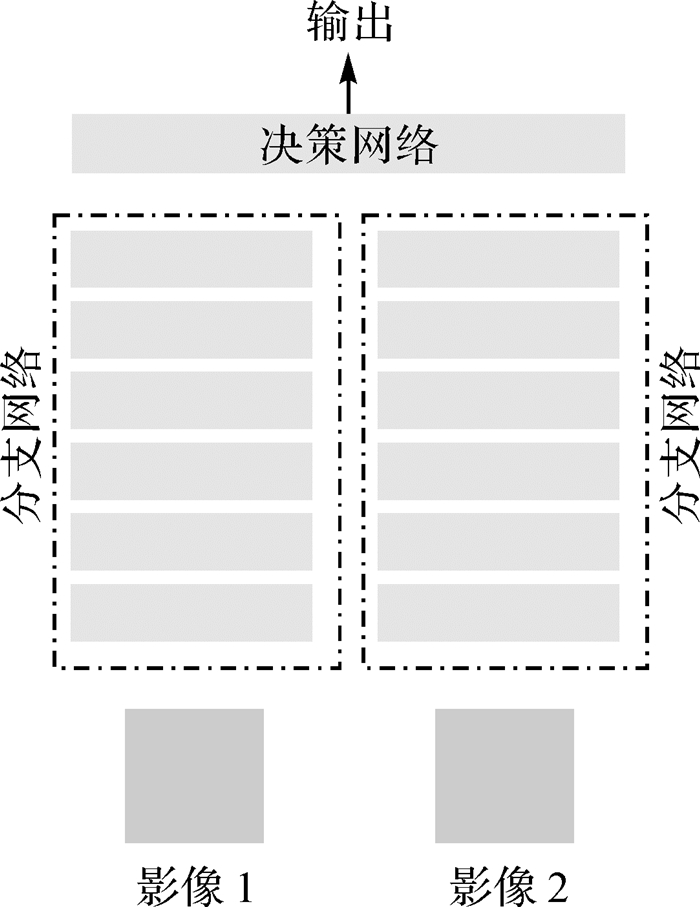

1 基于Siamese网络的影像相似性检测Siamese网络是一种提取训练样本对的深层次特征用于影像相似性检测的深度学习网络模型。它包含两个分支网络和一个决策网,如图 1[17]所示。

|

| 图 1 Siamese网络结构 Fig. 1 Siamese network structure schematics |

在Siamese网络中,分支网络包含卷积层、池化层、全连接层等,决策网络可以是全连接层,也可以是某种相似性度量算法[17]。卷积层用于提取训练影像对的特征。池化层一方面可以非常有效地缩小矩阵尺寸,降低输入影像或特征空间的空间分辨率,减少特征和参数,简化网络计算复杂度,提高计算速度;另一方面,池化层可以进行特征压缩,减少特征信息,提取主要特征,理想状态下保留显著特征,保持特征空间的某种不变性(平移、旋转等)[22-23]。全连接层相当于一个特征空间变换,可以把特征信息进行整合,降低特征维数,再加上激活函数的非线性映射,多层(两层及以上)全连接层理论上可以模拟任何非线性变换[23]。Siamese网络是对影像对同时训练的网络模型,两个分支网络的权值共享。它同时提取训练样本对的深层次特征,然后根据特征相似性判断影像是否相似。因此,Siamese网络提取的深层次特征可反映影像间的共有属性,深层次特征可看作样本对的共有特征。传统的Siamese网络中包含池化层,这些网络可以较好地应用于基于特征的匹配方法。在模板匹配过程中,池化层减少特征信息,提取主要特征,保持的特征不变性会使Siamese网络对小范围偏移的影像相似性检测不敏感,无法满足模板匹配的逐像素滑动匹配的精度要求,造成匹配正确率降低。

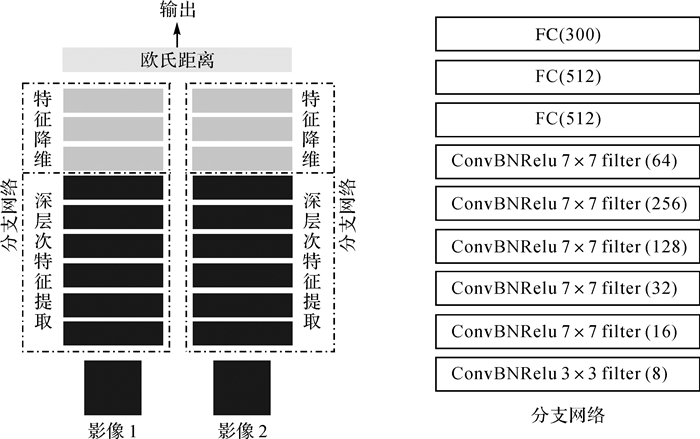

本文在传统Siamese网络模型的基础上构建了一种影像相似性检测模型。该网络模型去除了特征提取过程中的池化层,将每一个卷积层生成的特征空间完整的表达并向下层传递,使模型提取的特征的空间信息更加完整,定位精度更高。该网络模型可以有效地抵抗多模态遥感影像间非线性辐射差异和噪声干扰,提取影像间共有特征的同时保证其定位精度,实现多模态遥感影像相似性的准确检测,并且满足模板匹配的定位精度需求,模型如图 2所示。

|

| 图 2 本文网络模型 Fig. 2 The proposed network model |

该网络模型的两个分支网络完全相同且权值共享,每个分支网络包含两部分,特征提取和特征降维,特征提取由6个卷积层组成,特征降维由3个全连接层组成,单个分支网络如图 2所示。分支网络的详细参数如下

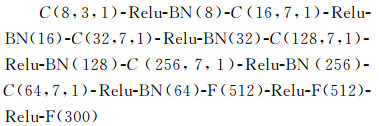

式中,C(n, m, k)表示卷积层有n个卷积核,卷积核大小为m×m,步长为k;Relu表示激活函数为Relu激活函数;BN(n)表示n维样本批量标准化;F(n)表示全连接层输出为n维。

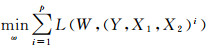

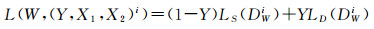

用于网络模型训练的训练影像对可分为正样本对和负样本对,正负样本对均有标签进行区别。其中,正样本对对应标签为0,负样本对对应标签为1。训练损失函数如下[24]

(1)

(1)

(2)

(2)

式中,(Y, X1, X2)i是第i对带标签的样本对;LS代表一个正样本对的局部损失函数;LD代表一个负样本对的局部损失函数;P是每次批训练的样本对的数量;DWi是第i对带标签的样本对的相似性度量。

在训练过程中,最小化来自正样本对的损失函数值,最大化来自负样本对的损失函数值,从而提取的共有特征对正负样本对有很好的区分效果,进而提高影像对相似性检测的准确性。当样本对导入该网络模型后,分支网络中卷积层提取样本共有特征,全连接层将共有特征降维并以n维特征向量的形式表达。决策网络以欧氏距离作为相似性度量,对训练样本对提取的共有特征计算欧氏距离并输出结果。根据欧氏距离的大小反映样本之间的相似性。

在试验过程中发现,特征降维会对匹配性能精度产生影响。笔者分析认为,模板匹配过程中,全连接层破坏特征空间结构,使特征信息丢失表达不全面,造成模板匹配正确率降低。因此,这里直接将网络模型中特征提取的最后一层卷积层输出的特征代入决策网络中,以欧氏距离作为相似性度量,进行模板匹配,取得了较高的匹配精度。下面通过对比试验对此进行分析。

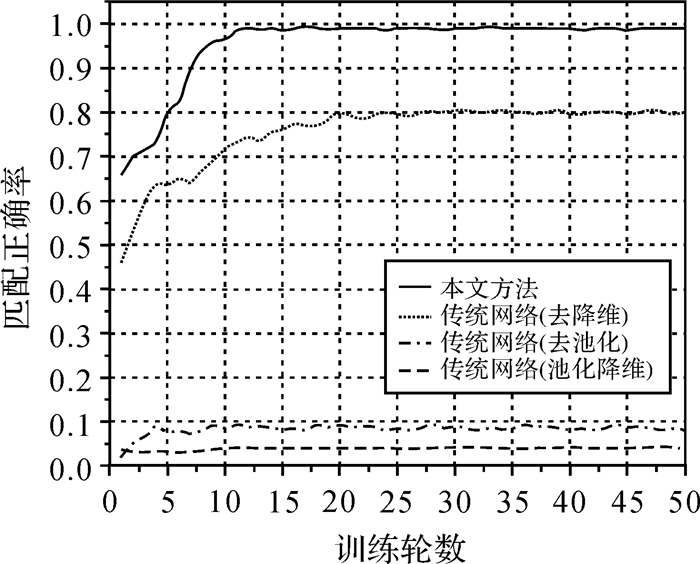

图 3是本文方法与传统Siamese网络(包含一个池化层)的模板匹配正确率的进行对比。由曲线可以看出,池化和特征降维均无法较好地应用于模板匹配,池化和特征降维会使特征定位精度降低,特征信息表达不完整,曲线趋于平缓后匹配正确率分别为80%、9%。根据本文方法提取未降维特征的匹配正确率曲线在网络模型训练12轮之后趋于平缓,匹配正确率稳定在98%,更加适用于多模态遥感影像的匹配。

|

| 图 3 方法对比 Fig. 3 Comparison of the proposed method and traditional method |

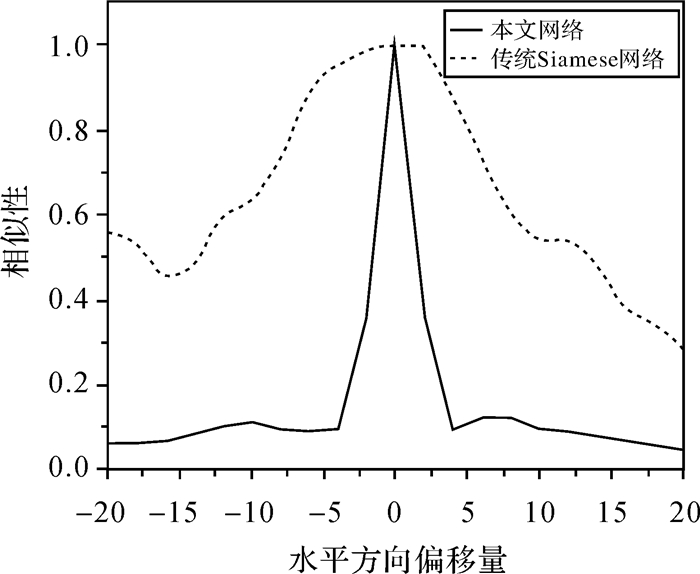

图 4是用于试验的一对SAR和光学影像,模板尺寸为72×72像素,通过对比水平方向偏移的相似性曲线来说明降低特征矩阵分辨率(池化层)对匹配性能的影响。试验过程中,传统Siamese网络采用一层最大池化层,池化窗口大小为2×2。从图 5中可以看出,池化层进行特征压缩,减少特征信息,提取主要特征,降低特征空间分辨率,保持特征空间不变性使网络模型对逐像素滑动匹配敏感度降低,造成相似性曲线的峰值区域区分度不明显,峰值无法出现在正确位置上。

|

| 图 4 试验影像 Fig. 4 Experiment image |

|

| 图 5 水平方向相似性曲线 Fig. 5 Horizontal similarity curves |

2 多模态遥感影像模板匹配流程

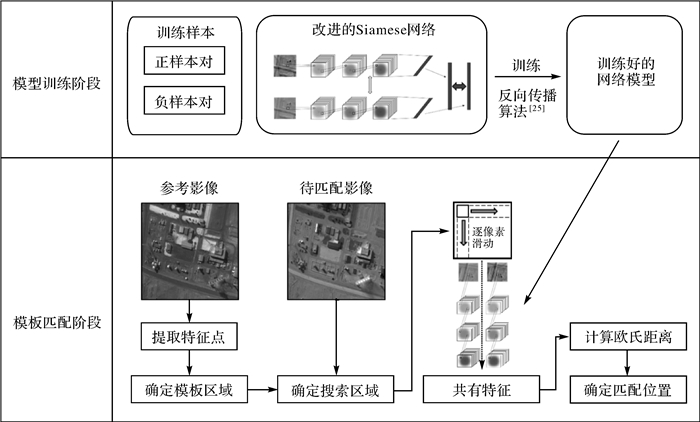

利用上述优化的Siamese网络模型提取多模态遥感影像间的共有特征用于影像匹配。根据模板匹配的思想,在参考影像合适位置构建匹配模板,在待匹配影像确定搜索域,随后提取共有特征并计算二者的欧氏距离,搜索域中欧氏距离最小的位置便是匹配最佳的位置。本文提出的影像匹配方法分为两个阶段,模型训练阶段和模板匹配阶段。在模型训练阶段,利用训练数据进行模型训练。训练数据中正样本对来自已经配准好的影像,负样本对来自未配准的影像。每对正负样本对均包含独立标签,用于网络模型训练。在模板匹配阶段,首先在参考影像中提取Harris特征点,确定模板区域,在输入影像上确定搜索区域,利用训练好的网络模型提取模板区域和搜索区域的共有特征并计算欧氏距离,将欧氏距离最小的位置作为最匹配点,直到所有特征点找到对应的匹配点。匹配流程如图 6所示。

|

| 图 6 匹配流程 Fig. 6 Matching process |

3 试验

本文进行了多组试验用于验证本文方法性能,分别从匹配正确率、均方根误差(root mean square error,RMSE)和相似性图等方面进行详细评价和分析并与NCC、MI、表示几何结构相似性的HOPC(histogram of orientated phase congruency)[2]方法以及基于传统Siamese网络的深度学习方法进行对比。试验硬件平台CPU为Inter(R) Xeon(R)E5-2640 v4 2.40 GHz,GPU为NVIDIA Tesla P40 24 GB, 内存为128 GB配置, 采用PyTorch深度学习框架实现具体卷积神经网络训练和匹配试验。

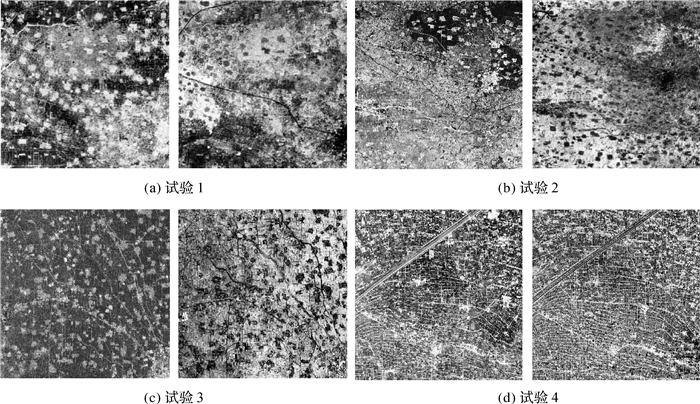

3.1 试验准备本节共设置4组多模态遥感影像试验,两组试验为光学和红外遥感影像试验,两组试验为光学和雷达遥感影像试验(图 7)。每组数据都利用严格几何定位模型和轨道参数进行粗纠正,消除了影像间的旋转和尺度等几何形变,影像间仅存在一定量的平移差异。尽管如此,影像间仍然存在显著的非线性辐射差异,匹配难度较大。具体试验数据如表 1所示。

|

| 图 7 试验数据 Fig. 7 Experiment data |

| 试验编号 | 参考影像 | 待匹配影像 | ||||||

| 传感器波段 | 大小/像素 | 分辨率/m | 传感器波段 | 大小/像素 | 分辨率/m | 影像特点 | ||

| 试验1 | TM波段3 (光学) |

777×812 | 30 | TM波段4 (近红外) |

777×812 | 30 | 影像位于城市郊区,包含部分城市区域,乡镇分布均匀,道路较清晰 | |

| 试验2 | ETM+ 波段2(光学) |

1051×1070 | 30 | ETM+ 波段5(中红外) |

1051×1070 | 30 | 影像位于农村区域,包含大量耕地,道路、水系清晰 | |

| 试验3 | 哨兵一号 VH极化(SAR) |

1907×1612 | 10 | 哨兵二号 波段4(光学) |

1907×1612 | 10 | 影像位于城市郊区,水系丰富 | |

| 试验4 | OLI 波段8(光学) |

1926×1688 | 15 | 哨兵一号 VH极化(SAR) |

1926×1688 | 10 (重采样至15) |

影像位于农村区域,包含大量耕地,道路清晰 | |

3.2 训练数据集准备

准备4组已配准的多模态遥感影像数据,分别采集用于网络模型训练和验证的正负样本对。样本尺寸为65×65像素。每组正样本对即相同位置的影像图块。每组负样本对是随机平移若干个像素模拟未配准情况。每组样本对赋予一对相同数字的标签用以区分。在试验1中,用于训练的正负样本对分别为59 535对和59 051对,用于验证的正负样本对分别为4990对和4980对。在试验2中,用于训练的正负样本对分别为62 500对和58 186对,用于验证的正负样本对分别为5300对和5152对。在试验3中,用于训练的正负样本对分别为60 577对和50 278对,用于验证的正负样本对分别为5530对和5400对。在试验4中,用于训练的正负样本对分别为56 147对和56 147对,用于验证的正负样本对分别为5210对和5330对。

3.3 模型训练每组试验网络模型训练的过程相同。以试验1数据为例,模型训练以64个样本对为一组做批次训练,一轮训练需1852批次(根据样本对数量而定),模型训练的迭代轮数最大为50轮,当每轮训练损失函数值之差小于0.001时停止训练。梯度优化算法使用随机梯度下降(stochastic gradient descent,SGD),学习率为0.001。

3.4 性能对比为了验证本文方法的匹配性能,这里与其他模板匹配方法(NCC、MI、HOPC)在匹配正确率(容差为1.5个像素)、RMSE和相似性图进行结果对比和详细分析。由于本文方法的训练样本和匹配模板均使用65×65像素,为了保证不同方法性能对比的一致性和客观性,其他模板匹配方法也使用相同尺寸的模板窗口。在匹配过程中,首先采用Harris特征点在参考影像上提取均匀分布[26]的200个特征点,然后在待匹配影像上确定21×21像素的搜索区域,并进行模板匹配。

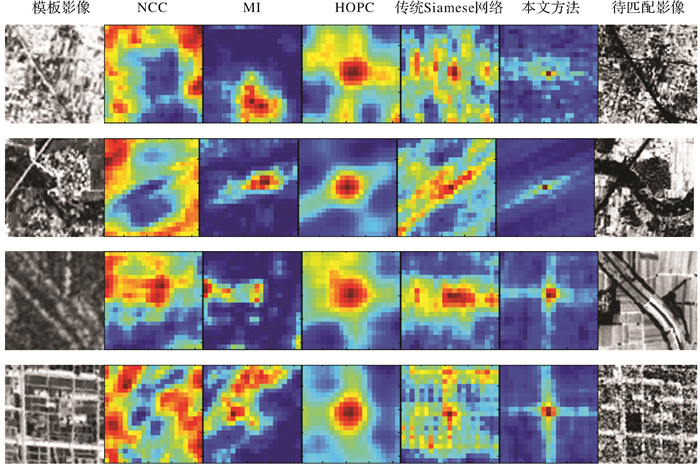

为了更直观地定性比较几种方法的匹配效果,本文将滑动匹配过程中计算得到的搜索域的欧氏距离可视化表达成相似性图,将NCC、MI、HOPC和传统Siamese网络方法类似地进行可视化表达。为了统一标准和便于比较,本文首先对不同数据归一化处理然后再进行可视化表达。相似性如图 8所示,自上至下分别为4组试验,第1列为模板影像,第7列为待匹配影像,第2至6列分别为NCC、MI、HOPC、传统Siamese网络方法和本文方法的相似性图。红色表示相似性越高,蓝色表示相似性越低。参考影像和待匹配影像是完全配准的,因此当模板滑动位于待匹配影像中心位置时,模板处于正确的匹配位置。从图 8中易看出,NCC、MI方法抵抗多模态影像非线性辐射差异效果不佳,未能找到正确匹配位置;HOPC方法和传统Siamese网络方法的匹配位置与中心位置有偏差,相似性图存在双峰或多峰或峰值不明显,峰值范围大;本文方法相似性图清晰简单,峰值位置处于搜索域中心位置,峰值范围小,定位准确,性能最优。

|

| 图 8 相似性图 Fig. 8 Similarity maps |

表 2中显示了4组试验不同方法的匹配正确率和RMSE。总体来看,NCC方法在4组试验中匹配正确率最低。这是因为NCC方法对于影像间的灰度只具有线性不变性,当辐射差异较大,尤其是非线性的辐射差异时,NCC方法通常不能得到满意的匹配效果。MI方法匹配正确率虽优于NCC方法,但整体匹配正确率较低,4组试验中匹配正确率最高为40.5%,最低仅22%,无法满足模板匹配的准确率要求。这是因为MI方法是根据像元灰度值的概率分布计算信息熵实现匹配的,需要大量计算影像灰度直方图,容易出现局部极值产生误匹配现象[27]。HOPC方法利用影像间的几何结构信息,获得较高的匹配正确率。但是,由于4组试验影像的几何结构信息丰富程度不尽相同,4组试验匹配正确率起伏较大,该方法同样存在局限性。基于传统Siamese网络的深度学习方法由于网络中存在池化层使得特征信息减少,特征定位精度降低,从而造成该方法匹配正确率较低。

| NCC | MI | HOPC | 传统Siamese网络 | 本文方法 | ||

| 试验1 | 匹配正确率/(%) | 7 | 23 | 81.5 | 79 | 99 |

| RMSE | 9.369 | 7.859 | 2.658 | 3.355 | 0.854 | |

| 试验2 | 匹配正确率/(%) | 16.5 | 26 | 97 | 92.5 | 98.5 |

| RMSE | 9.504 | 6.408 | 1.568 | 1.530 | 0.510 | |

| 试验3 | 匹配正确率/(%) | 3 | 60 | 90 | 86.5 | 97 |

| RMSE | 10.780 | 5.642 | 2.776 | 1.856 | 1.432 | |

| 试验4 | 匹配正确率/(%) | 6.5 | 22 | 89.5 | 80.5 | 97.5 |

| RMSE | 10.023 | 7.210 | 1.718 | 3.11 | 0.959 |

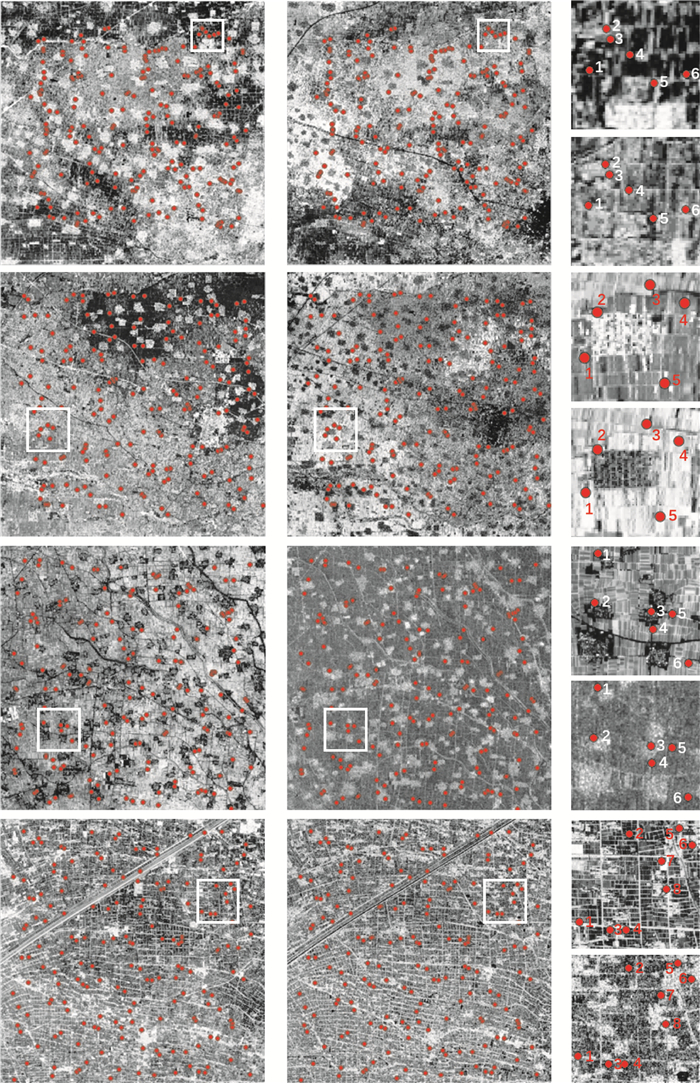

本文方法在匹配正确率上表现最佳,均保持95%以上的匹配正确率。这说明了本文方法通过对Siamese网络模型进行优化,可有效地提取多模态影像间的共有特征,增强了影像匹配的稳健性。另外本文方法的RMSE最小,这说明本文方法的匹配精度最高。如图 9所示,本文方法的匹配点都非常正确地定位在多模态影像的同名区域。这些试验表明了本文方法在匹配稳定性和精确度方面都优于其他4种方法,可有效地实现多模态遥感影像的自动匹配。

|

| 图 9 试验结果 Fig. 9 Experiment results |

4 结论

针对多模态遥感影像匹配中非线性辐射差异引起的困难问题,本文将深度学习方法引入模板匹配中,构建了一种提取影像间的共有特征的Siamese网络模型,对此进行优化,使其适用于多模态遥感影像匹配。为了验证本文方法的性能和表现,将其与NCC、MI、HOPC、基于传统Siamese网络的深度学习等方法进行详细的对比与分析,结果表明:本文方法在多组多模态遥感影像匹配试验中匹配正确率最高,匹配精度较传统的NCC、MI和传统Siamese网络方法有明显提升,并且优于目前精度较高的HOPC方法。这说明本文方法可以有效抵抗多模态遥感影像间辐射差异,获得高精度的同名匹配点,从而获得可靠的匹配精度。

由于本文方法需要事先人工配准影像进行训练数据的采集,因此,本文方法在模型训练阶段较为耗时,存在局限性。此外,模型结构仍有优化空间,训练样本的数量和质量与匹配准确度之间的关系还需要进一步的探究。本文的试验前提是利用卫星影像的轨道参数和严格定位模型对其进行粗纠正, 消除影像间的旋转和尺度差异。因此,对于具有显著旋转和尺度变化的多模态数据的匹配,有待进一步研究。

| [1] |

闫利, 王紫琦, 叶志云.

顾及灰度和梯度信息的多模态影像配准算法[J]. 测绘学报, 2018, 47(1): 71–81.

YAN Li, WANG Ziqi, YE Zhiyun. Multimodal image registration algorithm considering grayscale and gradient information[J]. Acta Geodaetica et Cartographica Sinica, 2018, 47(1): 71–81. DOI:10.11947/j.AGCS.2018.20170368 |

| [2] | YE Yuanxin, SHAN Jie, BRUZZONE L, et al. Robust registration of multimodal remote sensing images based on structural similarity[J]. IEEE Transactions on Geoscience and Remote Sensing, 2017, 55(5): 2941–2958. DOI:10.1109/TGRS.2017.2656380 |

| [3] | ZITOVÁ B, FLUSSER J. Image registration methods:a survey[J]. Image and Vision Computing, 2003, 21(11): 977–1000. DOI:10.1016/S0262-8856(03)00137-9 |

| [4] |

余先川, 吕中华, 胡丹.

遥感图像配准技术综述[J]. 光学精密工程, 2013, 21(11): 2960–2972.

YU Xianchuan, LÜ Zhonghua, HU Dan. Review of remote sensing image registration techniques[J]. Optics and Precision Engineering, 2013, 21(11): 2960–2972. |

| [5] | MORAVEC H P. Towards automatic visual obstacle avoidance[C]//Proceedings of the 5th International Joint Conference on Artificial Intelligence. Massachusetts US: MIT, 1977. |

| [6] | HARRIS C, STEPHENS M. A combined corner and edge detector[C]//Proceedings of the 4th Alvey Vision Conference. Manchester, UK: Organising Committee AVC, 1988: 147-151. |

| [7] | ZIOU D, TABBONE S. Edge detection techniques:an overview[J]. International Journal of Pattern Recognition and Image Analysis, 1998(8): 537–559. |

| [8] | ZHANG Dengrong, YU Le, CAI Zhigang. Automatic registration for ASAR and TM images based on region features[C]//Proceedings of SPIE 6752, Geoinformatics 2007: Remotely Sensed Data and Information. Nanjing: SPIE, 2007: 6752. |

| [9] |

张宝尚, 田铮, 延伟东.

基于分割区域的SAR图像配准方法研究[J]. 工程数学学报, 2011, 28(1): 7–14.

ZHANG Baoshang, TIAN Zheng, YAN Weidong. An SAR image registration algorithm based on segmentation-derived regions[J]. Chinese Journal of Engineering Mathematics, 2011, 28(1): 7–14. DOI:10.3969/j.issn.1005-3085.2011.01.002 |

| [10] | LOWE D G. Object recognition from local scale-invariant features[C]//Proceeding of the 7th International Conference on Computer Vision. Kerkyra, Corfu, Greece: IEEE, 1999: 1150-1157. |

| [11] | LOWE D G. Distinctive image features from scale-invariant keypoints[J]. International Journal of Computer Vision, 2004, 60(2): 91–110. DOI:10.1023/B:VISI.0000029664.99615.94 |

| [12] | BELONGIE S, MALIK J, PUZICHA J. Shape matching and object recognition using shape contexts[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2002, 24(4): 509–522. DOI:10.1109/34.993558 |

| [13] | SURI S, REINARTZ P. Mutual-information-based registration of TerraSAR-X and Ikonos imagery in urban areas[J]. IEEE Transactions on Geoscience and Remote Sensing, 2010, 48(2): 939–949. DOI:10.1109/TGRS.2009.2034842 |

| [14] | MARTINEZ A, GARCIA-CONSUEGRA J, ABAD F. A correlation-symbolic approach to automatic remotely sensed image rectification[C]//Proceedings of IEEE 1999 International Geoscience and Remote Sensing Symposium. Hamburg, Germany: IEEE, 1999: 336-338. |

| [15] | JOHNSON K, COLE-RHODES A, ZAVORIN I, et al. Mutual information as a similarity measure for remote sensing image registration[C]//Proceedings of SPIE 4383, Geo-Spatial Image and Data Exploitation Ⅱ. Orlando, FL, United States: SPIE, 2001: 51-61. |

| [16] | YE Yuanxin, SHAN Jie, HAO Siyuan, et al. A local phase based invariant feature for remote sensing image matching[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2018(142): 205–221. |

| [17] | ZAGORUYKO S, KOMODAKIS N. Learning to compare image patches via convolutional neural networks[C]//Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE, 2015: 4353-4361. |

| [18] |

范大昭, 董杨, 张永生.

卫星影像匹配的深度卷积神经网络方法[J]. 测绘学报, 2018, 47(6): 844–853.

FAN Dazhao, DONG Yang, ZHANG Yongsheng. Satellite image matching method based on deep convolution neural network[J]. Acta Geodaetica et Cartographica Sinica, 2018, 47(6): 844–853. DOI:10.11947/j.AGCS.2018.20170627 |

| [19] | HE Haiqing, CHEN Min, CHEN Ting, et al. Matching of remote sensing images with complex background variations via Siamese convolutional neural network[J]. Remote Sensing, 2018, 10(3): 355. DOI:10.3390/rs10020355 |

| [20] | BROMLEY J, GUYON I, LECUN Y, et al. Signature verification using a "Siamese" time delay neural network[C]//Proceedings of the 6th International Conference on Neural Information Processing Systems. Denver, Colorado: Morgan Kaufmann Publishers Inc, 1993. |

| [21] | CHOPRA S, HADSELL R, LECUN Y. Learning a similarity metric discriminatively, with Application to Face Verification//Proceeding of 2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Diego, CA: IEEE, 2005. |

| [22] |

许慧敏.基于深度学习U-Net模型的高分辨率遥感影像分类方法研究[D].成都: 西南交通大学, 2018. XU Huimin. Method research of high resolution remote sensing imagery classification based on U-Net model of deep learning[D]. Chengdu: Southwest Jiaotong University, 2018. |

| [23] |

周飞燕, 金林鹏, 董军.

卷积神经网络研究综述[J]. 计算机学报, 2017, 40(6): 1229–1251.

ZHOU Feiyan, JIN Linpeng, DONG Jun. Review of convolutional neural network[J]. Chinese Journal of Computers, 2017, 40(6): 1229–1251. |

| [24] | HADSELL R, CHOPRA S, LECUN Y. Dimensionality reduction by learning an invariant mapping[C]//Proceedins of 2006 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. New York: IEEE, 2006. |

| [25] | TRAPPEY A J C, HSU F C, TRAPPEY C V, et al. Development of a patent document classification and search platform using a back-propagation network[J]. Expert Systems with Applications, 2006, 31(4): 755–765. DOI:10.1016/j.eswa.2006.01.013 |

| [26] | YE Yuanxin, SHAN Jie. A local descriptor based registration method for multispectral remote sensing images with non-linear intensity differences[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2014(90): 83–95. |

| [27] |

林善明, 朱小艳, 周建华, 等.

一种结合互信息和模板匹配的配准方法[J]. 计算机工程, 2010, 36(14): 198–200.

LIN Shanming, ZHU Xiaoyan, ZHOU Jianhua, et al. Registration method with mutual information and template matching[J]. Computer Engineering, 2010, 36(14): 198–200. DOI:10.3969/j.issn.1000-3428.2010.14.072 |