2. 武汉大学测绘遥感信息工程国家重点实验室, 湖北 武汉 430079

2. State Key Laboratory of Information Engineering in Surveying, Mapping and Remote Sensing, Wuhan University, Wuhan 430079, China

近年来,增强现实(augmented reality,AR)技术与地理信息系统(geographic information system,GIS)结合应用开始受到广泛的关注[1-2],特别是在城市环境中,通过将3D城市建筑模型、路网信息、兴趣点信息、交通信息、街道导航信息等数据逐层精确的叠加到对应的建筑物和街道上,可以在户外大范围空间中为用户提供AR平视导航与位置服务,方便用户日常出行[3]。

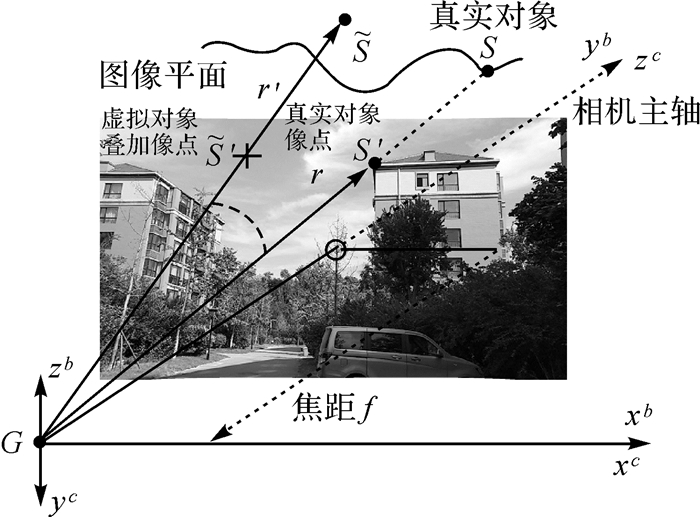

支持上述增强现实地理信息系统(augmented reality geographic information system,ARGIS)应用的一项关键技术是户外增强现实地理配准技术(geo-registration),即在真实的地理空间中,将具有三维位置的地理信息叠加在AR显示器上,使用户从不同视角观察时,虚拟信息都能够与真实世界中的对象准确套合。如图 1所示,地理配准技术的突出特点是可以户外大范围空间中,将大量相关的地理信息直观呈现在用户视野中,显然,虚拟信息与现实世界对象精确套合(配准)的程度,即虚实配准的精确度,对户外AR应用的可用性有显著的影响。实现高精度的地理配准才能为用户提供精细、精确、与位置相关的信息内容服务。

|

| 图 1 在(a)中,用户仍需要努力辨别信息与现实物体的对应关系;(b)中,多种地理内容如3D建筑轮廓、兴趣点/区域、道路、街道名称等混合在同一个虚实高精度配准的增强现实视图中,直观增强用户对周围环境的感知 Fig. 1 In (a), the user still needs to work hard to distinguish the correspondence between the information and the real objects; in (b), a variety of geographic content such as 3D building outlines, points/ areas of interest, roads, street names, etc. are mixed in the same high-accuracy augmented reality view, and intuitively enhance the user's perception of the surrounding environment |

当前,户外ARGIS系统地理配准技术主要有3类[4-6]。第1类是基于位姿传感器的地理配准方法。目前文献[7—10]等基于各类便携式位姿传感器在户外环境中进行了实时定位与地理配准研究,但试验结果表明普通便携式位姿传感器易受测量噪声和干扰因素的影响而存在测量误差,例如普通的GPS、北斗等卫星定位接收终端(如手机中集成的定位芯片)通常会有米级到10 m级的定位误差,磁力计受磁干扰影响通常也存在5°~10°的航向角偏差,因而直接使用移动便携式位姿传感器测量的6自由度(6 degree of freedom,6DOF)位姿往往难以实现较高精度的地理配准,仍需要通过人工交互方式[11]改善配准精度。第2类方法是基于预先准备的具有地理坐标参考的点云数据,根据PnP的基本原理进行视觉地理定位进而实现地理配准[12-13]。这种方法通常可以达到较高的配准精度,但是其必备的前提是必须要在试验区域预先采集大量的参考图像并重建大量的点云数据库,而后及时更新。根据文献[14]的分析,即使在较小场景中这类方法所需的视觉参考库也将是非常巨大的,例如,街景图像采集设备在100 m的距离上平均采集的图像数据约为3~5 GB,重建生成点云参考数据也通常也达数GB以上;在户外较大的环境中,移动终端本身往往难以存储所有的点云参考数据,因而必须借助服务器和网络给移动终端实时传送视觉参考数据[15-16],这很容易给原本复杂、耗时、耗能的视觉计算带来更大的延迟和消耗。第3类方法是在上述两种方法基础上实现视觉-位姿传感器混合定位与配准的方法,但目前这类方法研究较多的是将IMU与视觉SLAM方法结合进行混合位姿跟踪[17-18]。其特点是在临时设置的局部坐标系中实时、准确的跟踪用户(或相机)的相对位姿,较少顾及用户(或相机)相对于地理坐标系的初始绝对6DOF位姿。近年来,文献[19—20]提出了一种在野外条件下基于DEM数据进行视觉定位进而校正位姿传感器初始定位结果的思路,特别的是该方法能通过视觉定向自动校正位姿传感器水平航向角的测量误差,辅助提高基于位姿传感器的AR地理配准绝对精度。受这一工作的启发,本文试图建立一种在城市环境中借助广泛易得的2D地图数据为参考进行视觉定位,并自动校正位姿传感器的初始6DOF定位结果,进而提高户外AR地理配准精度的技术框架与方法。

当前,城市环境中2D地图可以通过公开的地图数据源(如通过OpenStreetMap)广泛获取,经过适当的地理定位校正后,即可具备较高精度的地理参考。但是地图只包括场景顶视图的轮廓结构信息,没有场景的表面纹理信息,必须要通过图像处理方法提取图像中的特定特征(如线特征)与2D地图进行对应才能求解图像位姿。文献[21]率先提出了一种从图像中提取建筑分段线性轮廓结构与2D地图匹配求解图像位姿的方法,但该方法定位精度不高,且需要使用宽视野的全景图像为输入;文献[22]提出了一种使用图像中建筑垂直轮廓线与2D地图中建筑角点对应求解单张图像位姿的方法,该方法可以对普通视野图像进行处理并得到较高的定位精度,但是需要通过人工辅助以准确提取建筑垂直轮廓线,尚不能完全自动实现。在参考借鉴文献[21—22]工作的基础上,本文借助当前性能较好的图像处理方法,实现了一种自动提取图像上同一建筑的3条可见垂直边缘轮廓线,并与2D地图上相应建筑的3个角点对应,求解相机在平面上的2D位置和水平航向角yaw(本文中称为2D平面位姿)的方法;进一步与重力加速度计测得的俯仰角pitch和滚动角roll,以及预先设定的高程值h(或者GNSS测量的高程值)组合后,可以得到优化的相机6DOF绝对位姿(本文中称为3D位姿),用于户外AR地理配准。如图 2所示,是本文研究的输入与输出:视觉辅助位姿优化及相应户外AR地理配准结果对比效果图。

|

| 图 2 视觉辅助位姿优化与地理配准精度改进效果对比 Fig. 2 Effects of visual aided pose optimization and geo-registration accuracy improvement |

使用局部区域中的2D地图,特别是只使用2D地图中的建筑角点信息进行视觉定位时,所需参考的数据量将到达非常小的量级(如KB级),因为在100 m×100 m区域范围内定位参考数据一般不超过十几KB,并且容易准备和获得;这非常吻合本文研究的最终目标,即实现一种“轻量”的视觉定位方法对传感器获取的初始粗略6DOF绝对地理位姿进行“离散”的校正和优化,以期最终提高户外AR“连续”地理配准的精度。下面具体对基于2D地图的视觉辅助位姿优化方法进行介绍。

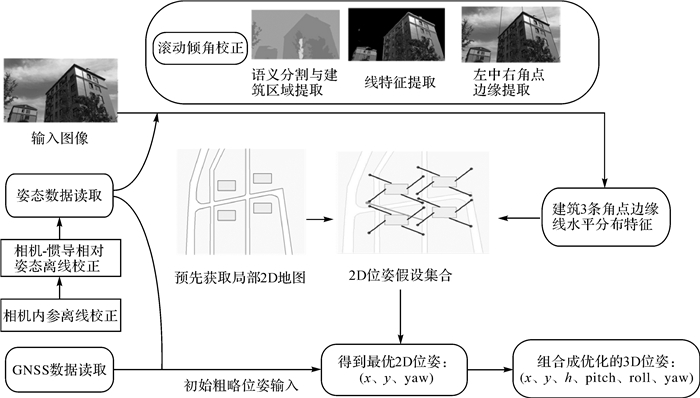

1 基于2D地图的位姿优化校正方法如图 3所示,是基于2D地图数据对图像进行定位进而对位姿传感器获取的初始6DOF位姿进行优化的整体框架,其中,位姿传感器获取的粗略6DOF位姿是视觉定位的初始输入,而视觉定位的结果反过来可以对传感器的测量结果进行校正。

|

| 图 3 基于2D地图的视觉辅助6DOF绝对位姿优化整体流程 Fig. 3 Overall framework of vision-assisted 6DOF absolute pose optimization method based on 2D map |

2D地图中的建筑底图角点通常对应于现实场景中建筑不同立面的垂直边缘交线,通过将建筑底图中的角点与图像中提取的垂直边缘线对应,可以求解出当前图像的平面2D位置和方向。但是在实际过程中,一方面从图像多而杂的线特征中准确、自动地识别出建筑垂直轮廓线就是相当具有挑战性的工作[22];另一方面,因为2D地图并没有场景表面描述信息,即使准确识别出建筑垂直轮廓线,也难以直接通过特征描述符匹配建立垂直边缘轮廓线与地图建筑角点的对应关系。因此,本文一方面借助当前较好的图像处理方法,实现自动识别图像中的建筑垂直轮廓线;另一方面,采用先假设后验证的方式,在局部地图范围内先假设垂直边缘轮廓线与地图建筑角点的对应关系,建立起图像所有可能的2D位姿假设集合,然后根据传感器初始的位姿输入筛选出可能的最优解,最终实现对初始位姿的优化校正。

因此,本文的位姿优化方法实际上可以分为以下3个步骤:①对输入图像进行校正和特征提取;②根据假设的图像特征与2D地图建筑角点对应关系,计算可能的2D位姿假设集合;③根据位姿传感器的初始位姿,筛选最优解。下面具体对每一个步骤进行介绍。

1.1 图像校正与特征提取 1.1.1 图像滚动倾角校正因为在实际观察时,相机拍摄容易存在一定的滚动倾斜,会对建筑垂直轮廓线的准确识别带来影响,因此需要校正。文献[22—23]提出了一种基于图像特征自动校正滚动倾角的方法,一方面这种方法相对复杂,且能够自动校正的倾角阈值范围较小;另一方面,在相对静态条件下,重力加速度计测得的俯仰角和滚动角通常具有较高的精度,因此本文使用重力加速度测得的滚动角对图像进行校正,使得从校正后的图像中提取的垂直直线能够汇聚交于以图像主点为原点的y轴上,水平消隐点的连线与图像x轴平行。后续的试验表明,在相对静态条件下,重力加速度计测量的倾角具有较高的精度,可以基本满足本文需求。

此外,摄像机的主点、焦距等内参数可以通过离线校正[24]得到,相机与位姿传感器的相对位姿可以通过文献[25]中的方法进行离线校正。

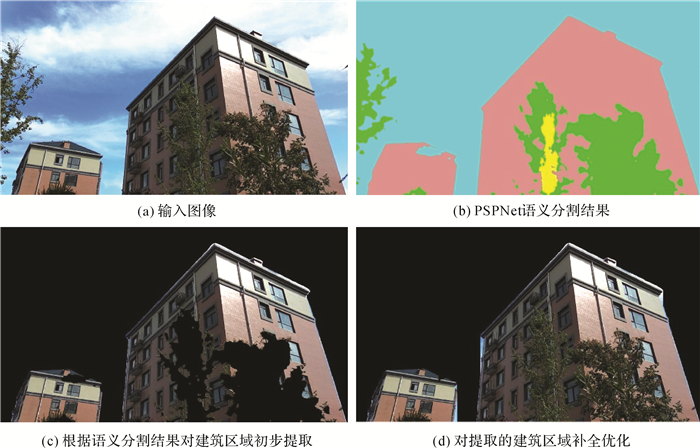

1.1.2 语义分割及建筑区域提取经过滚动校正后,图像的基本姿态得到“归正”,但是图像中的户外现实场景通常都是包含各类遮挡物的嘈杂场景,为了减小干扰和便于提取图像中的建筑垂直轮廓线,需要先对图像进行过滤,提取出图像中的建筑区域进行后续处理。考虑到户外场景通常光照明暗变化显著、或遮挡严重,为了应对户外复杂场景,本文使用目前性能较好的开源深度语义分割网络PSPNet[26]对户外场景图像进行语义分割,以语义分割后的场景类别图像为掩码,对原始输入图像进行过滤,可以快速高效的提取出图像中的建筑区域,如图 4(a)、(b)、(c)所示。

|

| 图 4 图像语义分割及建筑区域提取 Fig. 4 Image semantic segmentation and building area extraction |

另外,考虑到现实场景中通常会有树木、车辆等遮挡物对建筑区域进行遮挡,上述提取的建筑区域往往会存在“空洞”而导致建筑区域提取不全。为了弥补上述“空洞”并且兼顾算法效率,根据建筑区域在图像平面上通常沿图像y轴正向连续延伸的特点,对上述语义分割后的图像掩码进行补充,然后再对原始输入图像进行过滤,可以提取出相对完整、且独立的建筑区域,如图 4(d)所示。这为本文后续自动提取建筑角点边缘线特征打下了良好基础。

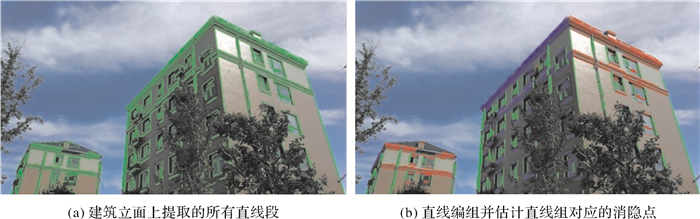

1.1.3 线特征提取及消隐点估计为了提取建筑的角点边缘线,首先需要提取建筑区域中的所有特征线,并计算水平和垂直消隐点。本文使用相对成熟的LSD直线段提取算法[27],对上述提取的建筑区域进行线特征提取,如图 5(a)所示(只在未受遮挡的建筑区域中提取线特征)。考虑到建筑是一类特殊的人工建筑,其立面通常铅垂于水平面(或地面),因此可以假设认为建筑立面中提取的大多直线段为现实场景中水平或垂直直线[28]。

|

| 图 5 建筑立面线特征提取及消隐点估计 Fig. 5 Line segments extraction on building facades and vanishing points estimation |

为了计算水平和垂直消隐点,使用J-Linkage模型[29]对上述提取的直线段进行分组,而后通过随机选取同一组直线中的两条直线计算可能的备选消隐点,循环迭代多次,取其中包含的长直线最多的消隐点(即备选消隐点到同组每条直线距离小于一定阈值的所有直线的长度和最大)为最优消隐点,求解得到每一组直线较为可靠的消隐点位置。根据消隐点在图像平面上的坐标,可以区分得到垂直直线组的消隐点和水平直线组的消隐点,通常垂直消隐点只有一个,在图像上方或下方(本案例垂直消隐点在图像上方);而水平消隐点会在图像左右两边各有一个,分别对应不同建筑立面上提取的水平直线组。如图 5(b)所示,不同颜色的直线组分别对应不同的消隐点,其中,绿色对应垂直消隐点,红色对应图像右边水平消隐点,蓝色对应图像左边水平消隐点。

1.1.4 左右及中间垂直角点边缘线识别在图像建筑立面上提取特征线并估计垂直和水平消隐点后,下一步是要从提取的特征线中识别建筑垂直角点边缘线。为了能够相对准确地识别建筑角点边缘线,本文假设被分析的图像中建筑区域位于图像中间,且能够观察到建筑的3条垂直角点边缘线,其中左、右角点边缘线分别位于图像主点的左右两侧,中间角点边缘位于左右边缘之间。显然,这一假设是合理且具有可操作性的,因为在实际拍摄图像时,只需要用户有意识地将建筑区域大致放于图像中部区域即可。

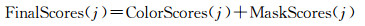

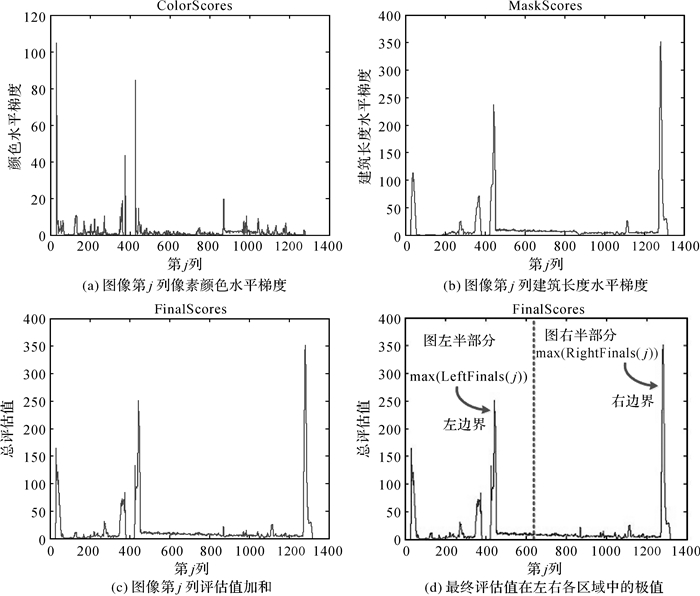

从视觉上分析,建筑垂直角点边缘通常是建筑两个不同立面的交线,并且可以与2D地图上的建筑底图轮廓角点一一对应;从图像处理的角度分析,建筑左、右垂直角点边缘线附近水平方向的颜色梯度通常会有较大的突变,如图 4(d)所示,在经过语义分析处理的图像上,背景区域和建筑区域的交界处会有显著的颜色梯度变化,且建筑区域的垂直长度也会发生较大的突变(这是需要对受遮挡的建筑区域补全的原因)。因此,根据图像每一列像素的颜色梯度与该列建筑区域长度梯度之和,求取其最大值,可以作为判定建筑左右角点边缘位置的参考依据。本文使用如下公式,计算图像上每一列作为左、右角点边缘的评估值,有

(1)

(1)

式中,j代表的是经过滚动倾斜校正后图像的第j列,需要注意的是,列j上对应的所有图像像素并非是图像上第j列沿y轴方向上的所有像素,因为在没有经过俯仰倾斜校正前,建筑立面中提取的垂直直线与图像y轴是不平行的,图像y轴方向的列像素并不能表达现实世界中的垂直线特征;因此,列j上对应的像素,是垂直消隐点(本示例在图像上方)与图像第j列最底部像素的连线与图像平面的所有交点,这条连线与建筑立面中提取的垂直直线是平行的。FinalScores(j)是第j列作为角点垂直边缘的最终评估值(即评估值加和),ColorScores(j)是第j列所有在建筑立面上的像素RGB三通道水平方向梯度之和,MaskScores(j)是第j列所有在建筑立面上的像素个数的梯度值(即相邻列像素个数差值)。

如图 6所示,当计算出图像的FinalScores(j)后,根据图像中心位置(主点横坐标)将FinalScores(j)分为LeftFinalS(j)和RightFinalS(j)两部分,分别求取两部分的最大值对应的列坐标j,分别作为图中建筑的左右角点垂直边缘线的边界参考。

|

| 图 6 建筑左、右角点垂直边缘边界估计 Fig. 6 Estimation of the boundary of vertical edges corresponding to the left and right corner of the building |

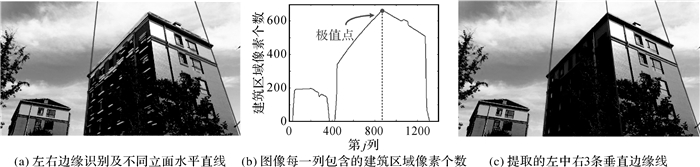

依据上述得到的左、右边界范围,建筑左、右角点垂直边缘线的确切位置,可以在建筑立面上提取的垂直直线中,分别选取最接近左、右边界的垂直直线作为最终的左右角点垂直边缘线,如图 7(a)所示。

|

| 图 7 建筑左、中、右角点垂直边缘识别提取 Fig. 7 Recognition and extraction of the left, middle and right corner vertical edge of building |

一旦左、右角点垂直边缘确定后,中间角点边缘的位置也可以确定,因为中间角点边缘通常位于左右角点边缘中间,且具有如下特征:①中间角点边缘位于建筑不同立面水平直线的交点上(如图 7(a)所示);②该边缘线位置通常也是建筑区域垂直长度(列像素个数)极大值点处(如图 7(b)所示)。本文综合上述两个条件,在保证位于两组水平直线交点上的前提下,取建筑区域垂直长度最长的列为中间角点垂直边缘的最佳位置,如图 7(c)所示。

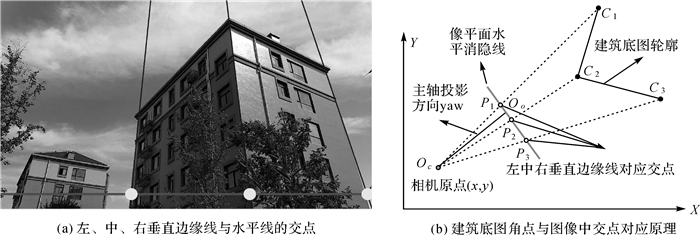

1.1.5 角点边缘线水平分布特征事实上,如图 7(a)中所示,建筑两个不同立面上的两组水平直线的交点为可以基本确定中间角点边缘的位置,而同组直线间的交点则分别是图像的左、右两个水平消隐点,连接两个水平消隐点,则得到水平消隐线,即过相机光心的水平面在图像平面上的成像线,如图 8(a)所示的水平线,3条垂直边缘线的分布特征可以通过水平消隐线与3条垂直边缘线交点的横坐标进行表征。根据2D-1D透视投影原理,如图 8(b)所示,图像上3个交点可以分别和2D地图上相应建筑轮廓角点进行对应,据此对应关系可以进一步求解相机中心的位置(x, y)和主轴水平方向yaw等2D位姿。

|

| 图 8 角点垂直边缘线水平分布与对应关系 Fig. 8 Horizontal distribution and correspondence of vertical edge of building corner points |

需要注意的是,图 8(a)中的图像拍摄时存在俯仰倾斜,3个交点的横坐标(u左, u中, u右)会随图像的俯仰角度变化而变化,因而,图 8(b)中所示的主轴方向是主轴在水平面上的投影方向,相机光心(相机原点)沿该方向与图像平面相交的水平直线长度为fx/cos(φ),这是经过俯仰倾斜角度校正后的相机横轴焦距,其中fx是相机横轴方向的原始焦距,可以通过离线校正得到;φ是图像的俯仰倾斜角,可以使用重力加速度计等传感器进行测量。

1.2 计算位姿假设集合如图 8(b)所示,根据中心透视投影物点、像点和相机光心3点共线的规律,过相机光心Oc及上述图像上交点Pi的反向投影直线必然会与现实场景中的建筑垂直边缘相交;如果从顶部向下观看,在相机光心Oc所在的水平面上,建筑的每一个轮廓角点Ci会在过相机中心Oc与图像中交点Pi的反向投影直线上。事实上,只考虑相机光心Oc所在的水平面时,这是将2D平面空间投影变换到1D线性空间中,是退化的2D-1D透视投影(相对于常见的3D-2D透视投影而言)。

相机在水平面上的2D位姿包含3个参数,即相机中心的平面坐标位置Oc-(x, y),和相机坐标系相对于平面坐标系(地图平面坐标系)的旋转角度yaw-θ(也即相机主轴OcOo相对于平面坐标系Y轴的旋转角度)。在有3对图像交点与建筑角点对应的条件下可以求解相机2D平面位姿的3个参数(x, y, θ)。

现在,定义建筑角点及其在世界平面坐标系上的坐标为C1-(cx1, cy1),C2-(cx2, cy2),C3-(cx3, cy3),相应的图像像点及其列(横)坐标为P1-u左,P2-u中,P3-u右,即

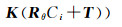

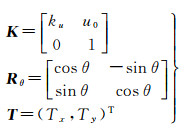

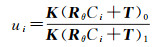

根据中心透视投影的规律,经过相机坐标变换和投影变换即可将现实世界中的物点变换为像平面中的像点,对应的变换公式为

(2)

(2)

式中

(3)

(3)

式中,ku=fx/cos(φ),是经过俯仰倾斜校正的横轴相机焦距,u0是图像主点的横坐标(可以通过离线校正得到);Rθ是由世界平面坐标到相机平面坐标的2D旋转变换矩阵,T是世界坐标系原点在相机平面坐标系中的2D位置。相机原点在世界坐标系中的位置可以通过式(4)计算,即

(4)

(4)

事实上,式(2)中求解得到的是像点横坐标ui的齐次坐标形式,根据齐次坐标与原始坐标的转换关系,可以求得

(5)

(5)

式中, (*)0、(*)1分别表示向量(*)的第1维分量和第2维分量,而ui∈(u左, u中, u右)。

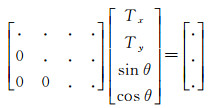

根据式(5),对每一对ui↔(cxi, cyi)T,事实上可以得到一个关于(Tx, Ty, θ)的三元一次方程,当有3对对应点时,可以得到3个方程组。尽管这些方程是非线性的(因为有三角函数参数),但是通过方程组之间的线性变换(如高斯-约丹(Gauss-Jordan)消元法),可以将3个方程组化简为如下形式

(6)

(6)

对于式(6)中的最后一行,有:asin θ+bcos θ=d,结合cos2θ+sin2θ=1,即可以求得θ值,代入式(6)的前两行,即可以求得Tx、Ty;但通常θ会有两个解,对应可以求解得到两组Tx、Ty,分别对应两组相机原点位置(x, y)。这两组解互为对称,相机方向恰好相反,其中在2D世界坐标系中距离建筑中间角点距离更近的(x, y, θ)是本文要求的相机2D位姿,而另一组位姿可以舍弃。

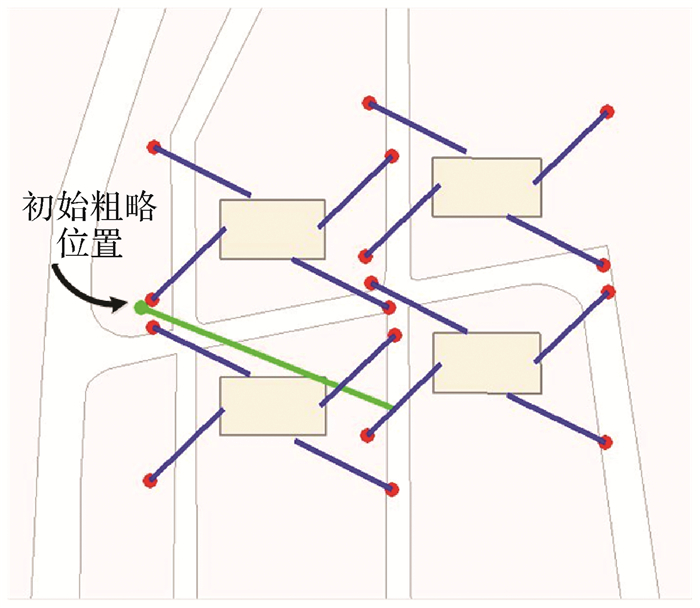

综合上述,在已知3组2D地图建筑角点与图像像点对应的情况下,可以求解图像2D位姿,但实际情况是2D地图没有现实世界的表面特征信息,难以通过特征描述符计算实现准确的2D地图建筑角点与图像垂直轮廓线对应。因此,如图 9所示,本文以初始定位位置(如GNSS定位位置)为参考,提取附近一定范围的2D地图(本文选取100 m×100 m范围)并记录范围内的有所建筑角点;对每一栋建筑,依次取其中的3个角点作为图像中3条垂直边缘线的对应点,根据前述方法,计算假设的相机2D位姿;通过循环迭代,遍历选取范围内的所有建筑角点,可以求解得到一个相机2D位姿的假设集合(图 9中红点表示相机中心平面位置,蓝线表示相机平面朝向)。

|

| 图 9 相机初始位姿及2D位姿假设集合 Fig. 9 Initial 2D camera pose and the hypothetical 2D pose set |

1.3 筛选最优位姿

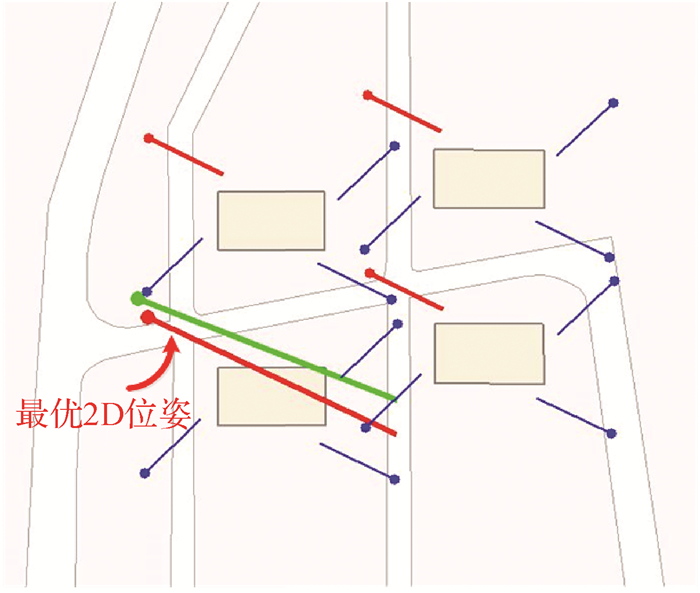

通过前述方法求解得到的2D位姿假设集合,事实上是包含(x, y, θ)3个元素的数组,为了判断哪一组数据是相机真实位姿或者最优解,需要参考位姿传感器获取的初始位姿。通常而言,在大多数普通的环境中,磁力计测量的水平航向角度误差为5°~10°,普通GNSS接收终端的水平定位精度会在米级到10米级左右。本文首先通过初始航向角角度对位姿假设集合进行过滤,只保留与磁力计测量的初始航向角绝对差值不超过30°的位姿数据组,这样可以过滤掉大部分无关的假设数据;然后,在剩下的假设集合中,逐个计算假设集合中的(x, y)与传感器初始位置(x0, y0)的两点距离,选取距离初始位置距离最近的位姿数据组作为相机2D位姿的最优解。如图 10所示,短红线表示的是与初始位姿方向相近的假设位姿,长红线是得到的最优位姿。

|

| 图 10 筛选得到相机2D位姿最优解 Fig. 10 Screening to get the optimal 2D pose solution |

一旦得到优化后的2D位姿后,结合加速度计等位姿传感器测量的滚动倾角ψ和俯仰倾角φ,以及设定的高程值h(如本文设定相机高度距离地面1.6 m),组合得到优化的6DOF绝对位姿(x, y, h, φ, φ, θ)(本文称为3D位姿),用于户外AR地理配准。

2 试验与结果分析 2.1 试验数据准备上文中提出了一种使用位姿传感器获取位姿数据为初始输入,然后基于2D地图数据进行视觉辅助位姿校正,最终用以提高户外AR地理配准精度的方法框架。本节中进行试验,用于验证:①基于2D地图的视觉定位方法可以对位姿传感器获取的初始2D位姿进行优化校正;②使用优化后组合得到的6DOF位姿进行地理配准可以提高原始配准精度,从而证明本文所提方法的有效性。

试验使用的2D地图是通过ArcGIS软件从倾斜摄影三维重建生成的正射图中采集、编辑得到2D矢量地图,为了保证地图地理参考的准确性,三维重建时在地面布设了差分控制点。事实上,试验使用的2D地图也可以来源于OpenStreetMap等网络公开地图数据源,即使其初始地理定位有所偏移,但经过适当的整体地理位置纠正,仍然可以得到比较精确的地理位置参考。试验使用的位姿传感器和图像采集设备是小米5X手机自带的集成传感器和摄像机,其中集成的加速度计是BMI120,磁力计是AK09918。

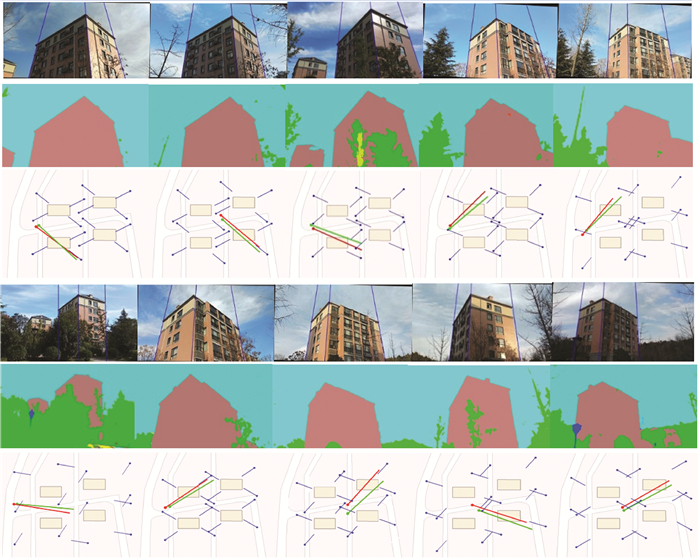

2.2 试验结果分析 2.2.1 位姿精度优化分析本次试验共在校区范围内采集了10组不同场景的数据(包括图像、传感器位姿数据等)以进行位姿精度优化和地理配准精度优化分析。因为在语义分割阶段使用开源深度网络PSPNet对图像进行语义分割,即使对于遮挡较为严重、明暗变化显著的复杂场景,也能较为准确地提取图像中的建筑区域,这为准确识别图像中的边缘线特征带来了便利。对于测试的10组场景,或光照明暗变化显著、或遮挡严重,本文方法都能自动、准确地提取其中角点垂直边缘特征,而文献[22]的方法难以处理这类复杂场景,必须要借助人工干预才能实现特征线识别与提取,这是本文工作的一项重要改进和发展。对于1280×720分辨率大小的输入图像,在MSI笔记本电脑上(CPU为intel core i7-6700HQ 2.6 GHz,内存8 GB),在Matlab环境中算法对每张图像处理的整体时间为3~4 s(不计PSPNet对图像进行语义分割处理的时间),为算法后续在其他平台中的集成应用奠定了基础。如图 11所示,是本文试验测试的10组场景案例,是在保持AR用户户外自然观察的前提下在“离散”时刻选取的,其基本要求是满足本文算法的基本假设,即可以看到目标建筑的3条角点边缘、且左右边缘线大致位于图像主点的两侧等。

|

| 图 11 本文的测试场景案例:纵向上每3幅图像对应一组测试场景,其中横向第1层为从原始图像中自动提取得到的3条角点边缘线(经滚动倾角校正);中间层为原始图像语义分割结果;第3层为传感器初始2D位姿和优化的2D位姿 Fig. 11 The test scenarios of this experiment: each of the three images in the vertical direction corresponds to a set of test scenes, where in the first horizontal layer is the three corner edges automatically extracted from the original images (corrected by rolling inclination); the middle horizontal layer is the semantic segmentation results of original images; and the third horizontal layer is the sensor's initial 2D pose and optimized 2D pose |

为了能够对比分析传感器获取的位姿与图像定位方法校正的位姿精度,本文使用EPnP[30]定位得到的6DOF位姿作为每组场景的参考真实值,分别计算传感器获取的6DOF位姿和视觉定位得到的2D平面位姿与参考真值的误差,计算它们在各自由度上的误差最大值、最小值、平均值作为精度评价指标,结果如表 1、表 2所示。

| m | |||||||||||

| 3DOF位置精度 | X(E) | Y(N) | Z(U) | ||||||||

| 最大误差 | 最小误差 | 平均误差 | 最大误差 | 最小误差 | 平均误差 | 最大误差 | 最小误差 | 平均误差 | |||

| 传感器获取的初始位置误差 | 4.286 | 0.744 | 2.307 | 6.731 | 0.755 | 3.243 | 8.906 | 0.741 | 3.686 | ||

| 视觉校正后位置误差 | 1.590 | 0.075 | 0.630 | 1.227 | 0.042 | 0.550 | — | — | — | ||

| 姿态精度 | 俯仰角pitch(绕X) | 滚动角roll(绕Y) | 偏航角yaw(绕Z) | ||||||||

| 最大误差 | 最小误差 | 平均误差 | 最大误差 | 最小误差 | 平均误差 | 最大误差 | 最小误差 | 平均误差 | |||

| 初始姿态误差 | 1.053 3 | 0.044 6 | 0.434 5 | 2.406 | 0.449 0 | 1.452 8 | 7.064 4 | 1.567 3 | 4.493 5 | ||

| 视觉校正后误差 | — | — | — | — | — | — | 1.692 9 | 0.094 9 | 0.567 3 | ||

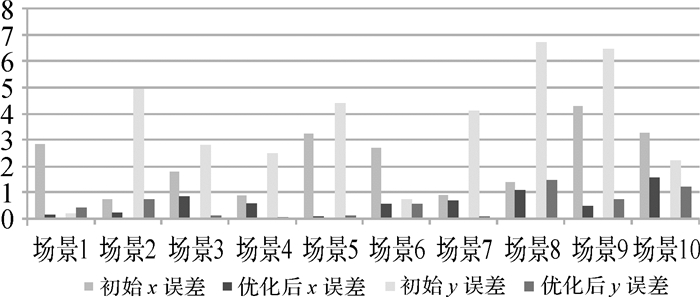

在位置精度方面,从表 1中可以看出,在普通的城市建筑环境中,直接使用普通的卫星定位信号接收终端(如手机GNSS芯片)获取的位置,其水平单方向上的平均误差接近3~4 m,这可能是因为近年来卫星定位系统快速发展(如卫星数量增多,芯片性能增强,定位信号在电离层、对流层传输误差模型得到改进等原因),卫星定位的精度水平整体有所提升;但显然,这一精度不能满足户外AR高精度地理配准的需求(相关分析参见下文地理配准精度分析)。相比较而言,在上述初始位置的基础上,基于2D地图的视觉定位方法可以对水平初始位置进行校正,如表 1中所示,经过视觉方法校正后,水平定位精度显著提升,平均误差在1 m以内,且最大的误差值显著较低,其中每一组场景的水平位置精度改进对比如图 12所示。

|

| 图 12 每一组场景水平位置精度改进对比 Fig. 12 Improvement of horizontal position accuracy of each set of scenes |

在姿态精度方面,如表 2所示,使用普通手机自带的加速度计(BMI120)和磁力计(AK09918),在相对静态条件下获取的绝对姿态,在某些自由度上也具有较高的精度,如使用重力加速计测得水平俯仰角和滚动角误差大多不超过2°,平均值误差在1°左右,这验证了本文在相对静态条件下,使用重力加速度计测得俯仰角和滚动角进行图像滚动倾角校正的可行性。

但是,通过磁力计等传感器直接测得的航向角误差通常都相对较大,在没有显著磁干扰的环境中,平均误差4°~5°,且测量结果不稳定,易出现较大误差值;如表 2中所示,与之相比,使用基于2D地图的视觉定位方法可以显著提高航向角的测量精度,平均误差降低到接近0.5°,且最大值误差也显著降低,达到2°以内,其中每一组场景的水平航向角精度改进对比如图 13所示。

|

| 图 13 每一组场景水平偏航角精度改进对比 Fig. 13 Improvement of yaw angle accuracy for each set of scenes |

在试验过程中,笔者发现使用加速度计结合陀螺仪等传感器,即使在运动状态下也可以获取相对准确的俯仰和滚动姿态值,但是直接使用磁力计测量航向角的结果极容易受环境中的磁性材质的干扰而不准确、甚至不可用,而这种磁干扰在现实世界中是普遍存在的。例如接近普通笔记本电脑内置的扩音器或接近停在路旁的汽车时,磁力计会迅速偏转导致测量误差明显增大,这使得使用磁力计在户外测量偏航角的稳定性、准确性难以保证,因而必须要借助其他方法进行“间断性”的校正。这也正是本文提出使用视觉定位方法辅助校正位姿传感器位姿(特别是航向角)的出发点和着眼点,而本文的实验结果验证了这一思路和方法的可行性和有效性。

需要说明的是,本试验中得到的偏航角误差是经过磁偏角校正后的误差,试验中使用的磁偏角大小是-5.033 3°,即磁北方向相对当地真北西偏5.033 3°,这是根据当地经纬度和测试日期时间使用2015—2020地球磁场模型[31]计算得到的结果。

2.2.2 地理配准精度优化分析本文研究的着眼点和最终目的是提高户外AR地理配准的精度,前文中已经分析了基于2D地图的视觉定位方法对位姿传感器获取的初始位姿的优化校正作用,现在需要进一步分析这种位姿优化对最终地理配准精度优化的影响。

本文以虚实对象在合成图像上的视角夹角作为评价虚实对象配准精度的量化指标,如图 14所示,虚实对象视线夹角λ越大,则配准误差越大;夹角λ越小,则虚实对象叠加越接近。因为角度可以和弧度互换,1毫弧度(mard),约等于0.057°,约等于横向0.1 m与纵向100 m形成的夹角值;10 mard约等于0.57°,即约等于横向1 m与纵向100 m形成的夹角值。考虑到使用毫弧度(mard)作为评估虚实配准精度的单位,可以方便地将虚实视角误差与虚实配准的现实意义联系起来,因此本文同时给出虚实视线夹角的角度值和毫弧度值。

|

| 图 14 虚实配准量化精度求解原理 Fig. 14 Schematic diagram for quantitative registration accuracy evaluation |

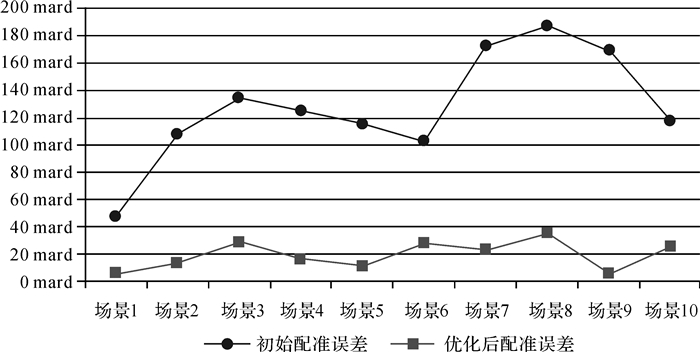

如表 3所示,是10组场景分别使用位姿传感器获取的初始6DOF和经过视觉位姿优化校正组合得到6DOF位姿进行虚实地理配准的量化精度的最大值、最小值和平均值,而图 15则给出了相应每一组场景虚实地理配准精度优化前和优化后的量化折线图。

| 配准技术方案与精度 | 最大误差 | 最小误差 | 平均误差 | |||||

| /(°) | /(mard) | /(°) | /(mard) | /(°) | /(mard) | |||

| 初始位姿配准误差 | 10.755 7 | 187.72 | 2.774 4 | 48.42 | 7.181 9 | 125.34 | ||

| 位姿优化后配准误差 | 2.049 1 | 35.76 | 0.333 5 | 5.82 | 1.116 8 | 19.49 | ||

|

| 图 15 每一组试验场景虚实地理配准精度优化前和优化后的量化折线图 Fig. 15 Quantitative line graph of geo-registration accuracy before and after optimization for each set of scenes |

从表 3可以看出,使用位姿传感器获取的初始6DOF位姿进行地理配准的误差整体相对较高,平均配准误差在120 mard左右,且最大值达到近200 mard,相当于在距离目标100 m距离观察时,虚实配准偏差接近20 m,实际观察时会显著影响AR用户体验;而经过视觉位姿校正后,地理配准精度显著提高,平均配准误差达到20 mard以下,且最大配准误差也提高到35 mard左右,这显然有助于支撑户外AR为用户提供精确、精细的信息内容服务。如图 16、图 17所示,分别给出了两组户外场景实际地理配准精度优化前和优化后的地理配准效果定性对比。

|

| 图 16 场景2虚实地理配准精度优化前与优化后的效果对比 Fig. 16 Effects of geo-registration accuracy in scene 2 before and after optimization |

|

| 图 17 场景4虚实地理配准精度优化前与优化后的效果对比 Fig. 17 Effects of geo-registration accuracy in scene 4 before and after optimization |

3 结束语

高精度的虚实地理配准技术是户外ARGIS为用户提供精细、精确信息内容服务的基础支撑,本文研究并实现了一种以2D地图为参考数据对传感器获取的初始粗略6DOF绝对位姿进行辅助校正,进而提高户外ARGIS地理配准精度的方法和技术框架。试验表明,在城市户外环境中,该方法可以有效对便携式位姿传感器获取的初始6DOF位姿进行优化,显著提高基于位姿传感器的户外AR初始地理配准精度,为户外ARGIS用户提供精确、精细信息内容服务提供重要基础支撑。当然,本文目前的测试场景仍具有一定的局限性,因为算法具有较强的约束假设,但是这些测试数据集仍是在保持AR用户户外自然观察的前提下在“离散”时刻选取的。对于更为复杂的户外三维场景,例如弧形结构建筑,或者树木等遮挡物遮挡目标建筑的一个“角点”的情况,本文的算法尚不能鲁棒处理。在2D地图数据的基础上,进一步利用建筑的高度数据(即概略的2.5D地图[32-33]),对上述更为复杂的情况进一步研究是本文后续改进的主要工作之一。

结合惯性、视觉SLAM[17-18]等相对位姿连续跟踪方法,“间断性”地采用上述方法对连续跟踪的位姿进行绝对初始化和“离散”的优化校正,实现户外ARGIS“连续、持续的”高精度虚实地理配准,进一步提高算法的实际可用性和系统性,将是后续需要进一步研究的内容。

致谢: 特别感谢慕尼黑工业技术大学的林雕同学和课题组徐旺、王玮琦师弟分别在算法原理、虚实配准和图像语义分割方面提供的支持和帮助。

| [1] |

杜清运, 刘涛.

户外增强现实地理信息系统原型设计与实现[J]. 武汉大学学报(信息科学版), 2007, 32(11): 1046–1049.

DU Qingyun, LIU Tao. Design and implementation of a prototype outdoor augmented reality GIS[J]. Geomatics and Information Science of Wuhan University, 2007, 32(11): 1046–1049. |

| [2] |

孙敏, 陈秀万, 张飞舟, 等.

增强现实地理信息系统[J]. 北京大学学报(自然科学版), 2004, 40(6): 906–913.

SUN Min, CHEN Xiuwan, ZHANG Feizhou, et al. Augment reality geographical information system[J]. Acta Scientiarum Naturalium Universitatis Pekinensis, 2004, 40(6): 906–913. DOI:10.3321/j.issn:0479-8023.2004.06.008 |

| [3] |

刘经南, 高柯夫.

增强现实及其在导航与位置服务中的应用[J]. 地理空间信息, 2013, 11(2): 1–6, 14.

LIU Jingnan, GAO Kefu. Augmented reality and its applications for navigation and location based service[J]. Geospatial Information, 2013, 11(2): 1–6, 14. DOI:10.11709/j.issn.1672-4623.2013.02.001 |

| [4] |

罗斌, 王涌天, 沈浩, 等.

增强现实混合跟踪技术综述[J]. 自动化学报, 2013, 39(8): 1185–1201.

LUO Bin, WANG Yongtian, SHEN Hao, et al. Overview of hybrid tracking in augmented reality[J]. Acta Automatica Sinica, 2013, 39(8): 1185–1201. |

| [5] | YOU Xiong, ZHANG Weiwei, MA Meng, et al. Survey on urban warfare augmented reality[J]. ISPRS International Journal of Geo-Information, 2018, 7(2): 46. DOI:10.3390/ijgi7020046 |

| [6] |

刘浩敏, 章国锋, 鲍虎军.

基于单目视觉的同时定位与地图构建方法综述[J]. 计算机辅助设计与图形学学报, 2016, 28(6): 855–868.

LIU Haomin, ZHANG Guofeng, BAO Hujun. A survey of monocular simultaneous localization and mapping[J]. Journal of Computer-Aided Design & Computer Graphics, 2016, 28(6): 855–868. DOI:10.3969/j.issn.1003-9775.2016.06.001 |

| [7] |

曲毅, 李爱光, 徐旺, 等.

基于位姿传感器的户外ARGIS注册技术[J]. 测绘科学技术学报, 2017, 34(1): 106–110.

QU Yi, LI Aiguang, XU Wang, et al. Outdoor ARGIS registration techniques based on position-posture sensor[J]. Journal of Geomatics Science and Technology, 2017, 34(1): 106–110. |

| [8] |

曲毅, 李爱光, 徐旺, 等.

面向ArGIS的多传感器混合跟踪注册研究[J]. 测绘与空间地理信息, 2017, 40(3): 114–117, 121.

QU Yi, LI Aiguang, XU Wang, et al. Research on multi sensor hybrid tracking registration for ArGIS[J]. Geomatics & Spatial Information Technology, 2017, 40(3): 114–117, 121. DOI:10.3969/j.issn.1672-5867.2017.03.031 |

| [9] |

王俊.户外增强现实GIS的应用研究[D].重庆: 西南大学, 2014. WANG Jun. Application research on outdoor augmented reality GIS[D]. Chongqing: Southwest University, 2014. http://cdmd.cnki.com.cn/article/cdmd-10635-1014264657.htm |

| [10] | SUN Min, LIU Lei, HUANG Wei, et al. Interactive registration for augmented reality GIS[C]//Proceedings of 2012 International Conference on Computer Vision in Remote Sensing. Xiamen, China: IEEE, 2012: 246-251. http://www.wanfangdata.com.cn/details/detail.do?_type=conference&id=WFHYXW536057 |

| [11] | HUANG Wei, SUN Min, LI Songnian. A 3D GIS-based interactive registration mechanism for outdoor augmented reality system[J]. Expert Systems with Applications, 2016, 55(8): 48–58. |

| [12] | VENTURA J, HÖLLERER T. Wide-area scene mapping for mobile visual tracking[C]//Proceedings of 2012 IEEE International Symposium on Mixed and Augmented Reality. Atlanta, GA: IEEE, 2012: 3-12. https://ieeexplore.ieee.org/document/6402531 |

| [13] | MIDDELBERG S, SATTLER T, UNTZELMANN O, et al. Scalable 6-DOF localization on mobile devices[C]//Proceedings of the 13th European conference on computer vision. Zurich, Switzerland: Springer, 2014: 268-283. https://link.springer.com/chapter/10.1007%2F978-3-319-10605-2_18 |

| [14] | ARTH C, VENTURA J, SCHMALSTIEG D. Geospatial management and utilization of large-scale urban visual reconstructions[C]//Proceedings of the 4th International Conference on Computing for Geospatial Research and Application. San Jose, CA: IEEE, 2013: 64-69. https://ieeexplore.ieee.org/document/6602041 |

| [15] |

段利亚.移动增强现实大范围定位与注册关键技术研究[D].武汉: 华中科技大学, 2013. DUAN Liya. Study on key technology of wide area localization and registration for mobile augmented reality systems[D]. Wuhan: Huazhong University of Science and Technology, 2013. http://www.wanfangdata.com.cn/details/detail.do?_type=degree&id=D409169 |

| [16] | VENTURA J, ARTH C, REITMAYR G, et al. Global localization from monocular SLAM on a mobile phone[J]. IEEE Transactions on Visualization and Computer Graphics, 2014, 20(4): 531–539. DOI:10.1109/TVCG.2014.27 |

| [17] | LIU Haomin, ZHANG Guofeng, BAO Hujun. Robust keyframe-based monocular SLAM for augmented reality[C]//Proceedings of 2016 IEEE International Symposium on Mixed and Augmented Reality. Merida, Mexico: IEEE, 2016: 1-10. https://ieeexplore.ieee.org/document/7781760 |

| [18] | LI Peiliang, QIN Tong, HU Botao, et al. Monocular visual-inertial state estimation for mobile augmented reality[C]//Proceedings of 2017 IEEE International Symposium on Mixed and Augmented Reality. Nantes, France: IEEE, 2017: 11-21. https://www.computer.org/csdl/proceedings-article/ismar/2017/2943a011/12OmNyQYtpg |

| [19] | MENOZZI A, CLIPP B, WENGER E, et al. Development of vision-aided navigation for a wearable outdoor augmented reality system[C]//Proceedings of 2014 IEEE/ION Position, Location and Navigation Symposium-PLANS 2014. Monterey, CA: IEEE, 2014: 460-472. https://ieeexplore.ieee.org/document/6851442 |

| [20] | GANS E, ROBERTS D, BENNETT M, et al. Augmented reality technology for day/night situational awareness for the dismounted soldier[C]//Proceedings Volume 9470, Display Technologies and Applications for Defense, Security, and Avionics IX; and Head- and Helmet-Mounted Displays XX. Baltimore, Maryland, United States: SPIE, 2015: 947004. |

| [21] | CHAM T J, CIPTADI A, TAN W C, et al. Estimating camera pose from a single urban ground-view omnidirectional image and a 2D building outline map[C]//Proceedings of 2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Francisco, CA: IEEE, 2010: 366-373. https://ieeexplore.ieee.org/document/5540191 |

| [22] | CHU Hang, GALLAGHER A, CHEN T. GPS refinement and camera orientation estimation from a single image and a 2D map[C]//Proceedings of 2014 IEEE Conference on Computer Vision and Pattern Recognition Workshops. Columbus, OH: IEEE, 2014: 171-178. https://ieeexplore.ieee.org/document/6909976 |

| [23] | GALLAGHER A C. Using vanishing points to correct camera rotation in images[C]//Proceedings of the 2nd Canadian Conference on Computer and Robot Vision. Victoria, BC, Canada: IEEE, 2005: 460-467. https://ieeexplore.ieee.org/document/1443166 |

| [24] | ZHANG Zhengyou. A flexible new technique for camera calibration[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2000, 22(11): 1330–1334. DOI:10.1109/34.888718 |

| [25] | LOBO J, DIAS J. Relative pose calibration between visual and inertial sensors[J]. The International Journal of Robotics Research, 2007, 26(6): 561–575. DOI:10.1177/0278364907079276 |

| [26] | ZHAO Hengshuang, SHI Jianping, QI Xiaojuan, et al. Pyramid scene parsing network[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI: IEEE, 2017: 2881-2890. https://arxiv.org/abs/1612.01105 |

| [27] | VON GIOI R G, JAKUBOWICZ J, MOREL J M, et al. LSD:a fast line segment detector with a false detection control[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 32(4): 722–732. DOI:10.1109/TPAMI.2008.300 |

| [28] | ZHONG Baojiang, XU Dongsheng, YANG Jiwen. Vertical corner line detection on buildings in quasi-Manhattan world[C]//Proceedings of 2013 IEEE International Conference on Image Processing. Melbourne, VIC, Australia: IEEE, 2013: 3064-3068. https://ieeexplore.ieee.org/document/6738631 |

| [29] | TARDIF J P. Non-iterative approach for fast and accurate vanishing point detection[C]//Proceedings of the 12th International Conference on Computer Vision. Kyoto, Japan: IEEE, 2009: 1250-1257. https://ieeexplore.ieee.org/document/5459328 |

| [30] | LEPETIT V, MORENO-NOGUER F, FUA P. EPnP:an accurate O(n) solution to the PnP problem[J]. International Journal of Computer Vision, 2009, 81(2): 155–166. |

| [31] | CHULLIAT A, MACMILLAN S, ALKEN P, et al. The US/UK world magnetic model for 2015-2020: technical report[R]. Boulder, CO: NOAA, 2015. |

| [32] | ARTH C, PIRCHHEIM C, VENTURA J, et al. Instant outdoor localization and SLAM initialization from 2.5D maps[J]. IEEE Transactions on Visualization and Computer Graphics, 2015, 21(11): 1309–1318. DOI:10.1109/TVCG.2015.2459772 |

| [33] | ARTH C, PIRCHHEIM C, VENTURA J, et al. Global 6DOF pose estimation from untextured 2D city models[J]. Computer Science, 2015, 25(1): 1–8. |