2. 地球空间信息协同创新中心, 湖北 武汉 430079

2. Collaborative Innovation Center of Geospatial Technology, Wuhan 430079, China

随着地对地观测技术的发展,高分辨率遥感影像的数据获取量越来越大,且已被广泛用于城市规划、灾害监测、农业管理和军事侦察等方面[1-3]。在大数据条件下,如何自动化、智能化地实现高分辨率遥感影像目标检测与识别,对高分辨率遥感影像应用价值的发挥具有重要影响[4]。为此,国内外学者开展了大量的研究,其中许多研究方法主要使用人工设计的影像目标特征进行目标检测与识别,如梯度直方图(histogram of oriented gradient,HOG)[5]、局部二值模式(local binary patterns,LBP)[6]、尺度不变特征变换(scale-invariant feature transform,SIFT)[7]和Gabor[8]等特征,然后将这些特征以特征量的形式输入到传统的分类器,如支持向量机(support vector machine,SVM)[5, 7]、AdaBoost[9]、决策树[10]等进行分类,在特定的目标识别任务中取得了较好的效果。但由于遥感卫星复杂多变的拍摄条件,传统的目标检测与识别算法难以适应不同情况下的遥感影像,算法的稳健性、普适性较差[11-12]。

近年来,卷积神经网络(convolutional neural networks,CNN)作为最热门的深度学习模型算法,其不需要人为设计目标特征,且会根据海量数据和标注自行进行有效特征提取和学习[13-14]。在训练数据充足的情况下,模型具有良好的泛化能力,能够在复杂多变的条件下依然保持良好的稳健性[15-16]。因此,卷积神经网络模型已被广泛应用于图像目标检测与识别领域。如文献[17]提出regional CNN(RCNN)算法,该算法将候选区域提取算法与CNN相结合,首先使用selective search算法提取图像的候选区域,然后通过CNN对候选区域进行特征提取,最后根据特征使用SVM进行区域分类,实现图像的目标检测与识别。文献[18]为了减少文献[17]中CNN对重叠候选区域的重复计算,提出spatial pyramid pooling net(SPPNet)算法。该算法只对CNN最后一层卷积层特定区域进行一次池化操作,输出候选区域的特征用于分类实现目标检测与识别,极大提高了模型的训练和测试速度。文献[19]提出Fast-RCNN算法,采用region of interest pooling(ROI pooling)层对CNN卷积层的特定区域进行池化,并引入多任务训练函数,使模型的训练和测试变得更加方便,且具有较高的目标检测与识别精度。文献[20]对Fast-RCNN算法进行进一步加速,提出Faster-RCNN算法,用region proposal network(RPN)网络代替selective search候选区域提取算法;RPN负责提取数量更少准确率更高的候选区域,并与Fast-RCNN提取特征的网络共享卷积层,进一步减少计算量,检测速度更快,且目标检测与识别精度优于RCNN、Fast-RCNN算法。但上述卷积神经网络算法均是针对自然图像设计的模型算法,相对于自然图像,高分辨率遥感影像存在背景更加复杂、目标区域范围更小和同类目标尺度变化更大等特点[21-22]。因此,上述卷积神经网络算法难以良好地学习与耦合高分辨率遥感影像目标特征信息,对遥感影像目标检测与识别精度不高。

针对上述问题,本文提出基于高分辨率遥感影像目标尺度特征的卷积神经网络检测与识别方法。首先通过统计遥感影像目标的尺度范围,获得卷积神经网络训练与测试过程中目标感兴趣区域合适的尺度大小。然后根据目标感兴趣区域合适的尺度,提出基于高分辨率遥感影像目标尺度特征的卷积神经网络检测与识别架构。最后通过定性对比试验和定量评价验证本文卷积神经网络架构的有效性。

1 本文方法概述本文方法主要分为两个步骤:①统计高分辨率遥感影像目标的尺度范围,获得遥感影像目标感兴趣区域尺度大小;②根据目标感兴趣区域尺度,设计高分辨率遥感影像目标检测与识别卷积神经网络架构。

1.1 目标感兴趣区域尺度范围高分辨率遥感卫星通常在近地轨道对地球表面进行成像,且成像过程中受光照、气象条件等影响,生成的遥感影像存在影像内容复杂、目标尺度范围较小,且不同时间段生成的遥感影像辐射差异较大等特点。在遥感卫星特殊的成像条件下,为了充分统计影像典型目标感兴趣区域的尺度范围,本文建立了一个包含飞机、储存罐和船只的遥感影像目标检测与识别数据集WHU-RSone。该数据集中包含2460幅高分辨率遥感影像,影像大小为600×600像素~1372×1024像素。2460幅遥感影像中包含22 191个目标,其中7732个飞机(plane)目标、10 572个储存罐(storage-tank)目标和3887个船只(ship)目标,具体信息如表 1所示。

| 目标类型 | 目标个数 |

| 飞机 | 7732 |

| 存储罐 | 10 572 |

| 船只 | 3887 |

| 总计 | 22 191 |

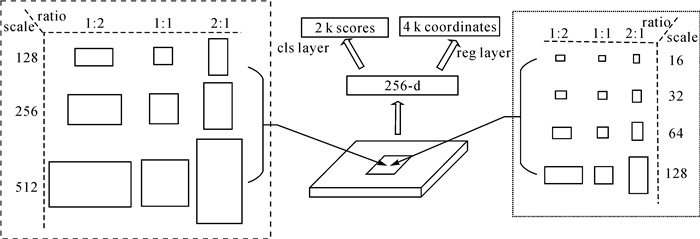

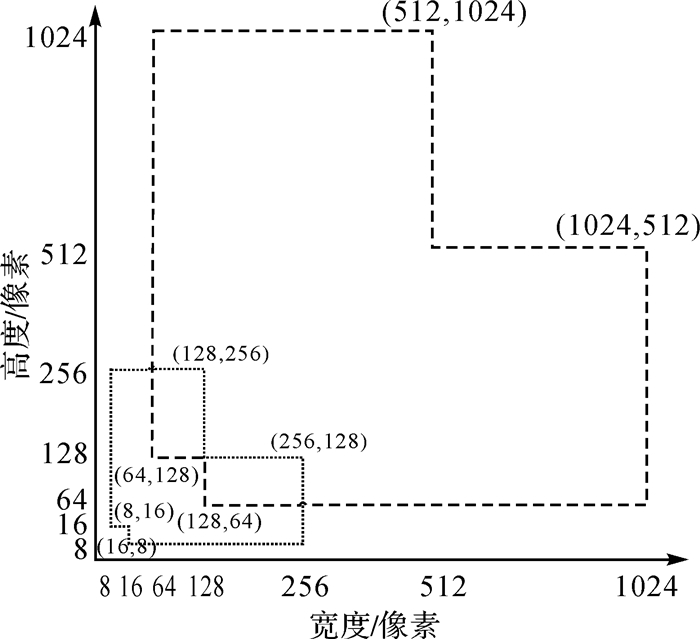

WHU-RSone数据集中包含不同辐射亮度、不同尺度大小的目标影像数据,可以用于充分统计不同成像条件下遥感影像典型目标感兴趣区域的尺度范围,图 1为WHU-RSone数据集中部分样例目标数据。在Faster-RCNN架构中RPN网络使用3种尺度(128、256和512)和3种比例(1:2、1:1和2:1)生成9种目标感兴趣区域。9种目标感兴趣区域大小如图 2左侧矩形框内所示,9种目标感兴趣区域能覆盖的区域范围如图 3面积较大多边形区域所示。

|

| 图 1 WHU-RSone目标样例数据 Fig. 1 Object sample data in WHU-RSone data set |

|

| 图 2 目标感兴趣区域提取网络 Fig. 2 Object region of interest extraction network |

|

| 图 3 目标感兴趣区域覆盖范围 Fig. 3 Coverage area of object region of interest |

对WHU-RSone数据集中22 191个目标尺寸进行统计,统计信息如图 4所示。在图 4中,WHU-RSone数据集中仅有6.95%的目标尺寸处于中RPN网络生成的9种目标感兴趣区域覆盖的区域范围内,RPN网络生成的9种目标感兴趣区域难以有效耦合遥感影像典型目标的尺寸大小。由于高分辨率遥感影像中典型目标的尺度通常较小,需要对RPN网络生成的感兴趣区域尺度进行改进,设置4种尺度(16、32、64和128)与3种比例(1:2、1:1和2:1)获得12种目标感兴趣区域。12种目标感兴趣区域大小如图 2右侧矩形框内所示,12种目标感兴趣区域能覆盖的区域范围大小如图 3面积较小多边形区域所示。在图 4中,WHU-RSone数据集中有95.65%的目标尺寸处于改进后RPN网络生成的12种目标感兴趣区域覆盖的区域范围内,几乎所有的目标尺寸均处于改进后RPN网络生成的12种目标感兴趣区域覆盖的范围内。统计结果表明,设置的4种尺度(16、32、64和128)和3种比例(1:2、1:1和2:1)生成的目标感兴趣区域能有效耦合遥感影像中典型目标的尺度范围。据此,在本文卷积神经网络架构设计中,RPN网络利用4种尺度(16、32、64和128)和3种比例(1:2、1:1和2:1)生成卷积神经网络架构训练与测试过程中目标感兴趣区域大小。

|

| 图 4 目标尺度分布范围 Fig. 4 Object scale distribution range |

1.2 目标检测与识别卷积神经网络架构

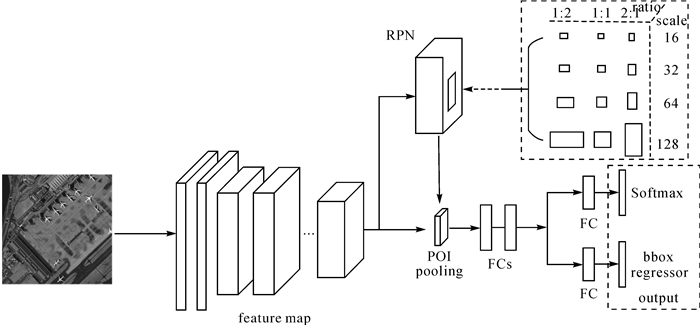

借鉴Faster-RCNN架构设计,本文卷积神经网络架构包括RPN网络和目标识别网络。其中RPN网络用于生成影像中的目标感兴趣区域,目标识别网络用于对RPN网络中生成的目标感兴趣区域进行识别分类及目标区域坐标回归。卷积神经网络架构示意图如图 5所示。

|

| 图 5 本文卷积神经网路架构 Fig. 5 The proposed convolution neural network framework |

1.2.1 RPN网络

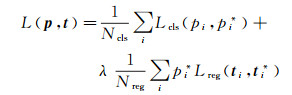

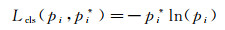

本文中RPN网络用于提取目标感兴趣区域,生成的目标感兴趣区域用于架构的目标检测与识别的训练与测试。本文架构的RPN网络采用4种尺度(16、32、64和128)和3种比例(1:2、1:1和2:1)生成12种锚点用于得到卷积神经网络架构的目标感兴趣区域,锚点示意图如图 5矩形框内所示。RPN网络在最后一层特征图上根据锚点生成目标感兴趣区域,对目标感兴趣区域进行前景与背景的二分类及目标感兴趣区域坐标回归训练,使RPN网络中的权重学习到预测目标区域的能力。二分类与目标区域坐标回归训练的损失函数L(p, t)的计算如下所示

(1)

(1)

(2)

(2)

(3)

(3)

(4)

(4)

(5)

(5)

式中,p为目标区域二分类的概率;pi为标签i锚点二分类的概率;pi*为标签i锚点二分类的概率真值,当标签i锚点为目标时,pi*=1,否则pi*=0;t为网络预测目标区域坐标向量;ti为网络对锚点i预测的坐标向量,ti=[xi yi wi hi];ti*为目标区域坐标向量真值,ti*=[xi* yi* wi* hi*];[xa ya wa ha]为锚点区域的坐标向量;Lcls(pi, pi*)为二分类损失函数,采用标准交叉熵损失函数[20];Lreg(ti, ti*)为目标区域坐标损失函数,采用smoothL1函数[19];Ncls、Nreg和λ为两类损失函数间的平衡系数,文献[20]中设置Ncls为256、Nreg为2400、λ为10。

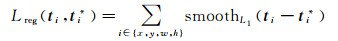

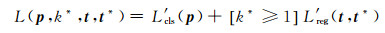

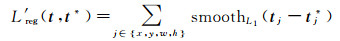

1.2.2 目标识别网络目标识别网络使用卷积层(convolution layer)、激活层(relu layer)和池化层(pooling layer)获得影像特征图(feature map)。本文分别使用Zeiler and Fergus(ZF)模型[23]和visual geometry group(VGG)模型[24]两种经典网络模型获得卷积神经网络架构的特征图,通过两种不同的模型验证卷积神经网络架构的有效性。RPN网络将生成的目标区域信息传递给目标识别网络,目标识别网络结合目标区域信息和网络中最后一层特征图,获得目标区域在特征图上特征向量信息,将特征向量信息传递至ROI pooling层,获得指定大小的特征向量信息。特征向量被传递至全连接层(fully-connected layer,FC)用于目标识别分类和区域坐标回归训练和测试。目标识别分类和区域坐标回归训练的损失函数L(p, k*, t, t*)计算如下所示

(6)

(6)

(7)

(7)

(8)

(8)

式中,p=(p0, p1, p2, …, pk),为k+1维目标识别分类的概率向量,k为目标区域识别分类的类别数;k*为生成的目标区域对应的类别真值标签,当对应的类别真值为背景时,k*=0,否则k*≥1;当生成的目标区域对应的类别标签真值为背景时,[k*≥1]为0,否则[k*≥1]为1;t为目标识别网络预测目标区域坐标向量,t=(x, y, w, h);t*为目标区域坐标向量真值,t*=(x*, y*, w*, h*);L′cls(p)为目标识别分类损失函数,为标准交叉熵损失函数;L′reg为目标区域坐标损失函数,为smoothL1函数。

1.2.3 架构训练与测试本文卷积神经网络架构利用Caffe框架实现,采用端到端的训练方式对RPN网络和目标识别网络进行训练。将RPN网络损失和目标识别网络损失相加,利用随机梯度下降法进行反向传播。训练过程中,使用ImageNet上训练好的模型初始化本文网络模型参数。本文RPN网络的batch大小为256,目标识别网络的batch大小为2000,网络训练的动量为0.9,衰减因子为0.000 5,基础学习速率为0.001,学习速率变化比率为0.1,每迭代50 000次变化学习速率,最大训练迭代次数为75 000。

在卷积神经网络架构测试阶段,将一幅遥感影像输入卷积神经网络架构,利用RPN网络生成6000个目标区域,对目标区域进行非极大值抑制,非极大值抑制的intersection over union(IoU)阈值为0.7。然后选取置信度排名前300的目标区域传递至目标识别网络,目标识别网络对300个目标区域进行分类识别及区域坐标回归,输出目标类别和区域坐标。

2 试验结果与分析大规模的学习样本是支撑深度学习发挥高性能的基础。为此,本文建立了一个包含2460幅遥感影像的目标检测与识别数据集WHU-RSone。数据集中包含22 191个目标,其中7732个飞机目标、10 572个存储罐目标和3887个船只目标,数据集具体信息如表 1所示。

为了充分验证本文卷积神经网络架构的有效性,将本文卷积神经网络架构与Faster-RCNN架构进行定性与定量对比评价。在试验中使用ZF和VGG两种网络模型获得本文架构与Faster-RCNN架构的特征图,通过两种不同的模型充分对比验证两种架构的性能。在2460幅遥感影像中随机选出1476幅影像作为训练数据,492幅影像作为验证数据,492幅影像作为测试数据。通过训练和验证数据对本文架构与Faster-RCNN架构进行训练,利用测试数据对训练后的两种架构进行对比测试。

2.1 训练损失值(loss)对比图 6为两种架构基于ZF模型和VGG-16模型训练loss走势图。图 6(a)中蓝色曲线和红色曲线分别为Faster-RCNN ZF和本文架构ZF模型训练loss曲线。相对于Faster-RCNN ZF模型loss曲线,本文架构ZF模型的loss更易趋于收敛,且收敛后的loss值小于Faster-RCNN ZF模型。图 6(b)中的蓝色曲线和红色曲线分别为Faster-RCNN VGG-16和本文架构VGG-16模型训练loss曲线。同样,相对于Faster-RCNN VGG-16模型loss曲线,本文架构VGG-16模型的loss更易趋于收敛,且收敛后的loss值小于Faster-RCNN VGG-16模型。

|

| 图 6 Faster-RCNN架构与本文架构训练loss对比图 Fig. 6 Comparison of Faster-RCNN and the proposed CNN framework training loss |

Faster-RCNN架构通过设置3种尺度(128、256和512)和3种比例(1:2、1:1和2:1)生成9种目标感兴趣区域对架构进行训练。本文架构通过设置4种尺度(16、32、64和128)和3种比例(1:2、1:1和2:1)生成12种目标感兴趣区域对架构进行训练。两种架构在其他结构相似的情况下,试验结果表明本文架构设置的4种尺度(16、32、64和128)和3种比例(1:2、1:1和2:1)生成12种目标感兴趣区域更有利于高分辨率遥感影像目标检测与识别训练,可以获得更好的模型训练结果。

2.2 目标检测与识别定量评价本文使用492幅遥感影像对训练后的Faster-RCNN架构和本文架构进行对比评价。通过mAP(mean average precision)[25]对两种架构的目标检测与识别精度进行定量评价。mAP值越大说明网络架构的目标检测与识别精度越高,反之亦然。在计算mAP时,当检测结果的坐标与目标真值坐标的IoU大于等于0.5时,认为检测结果正确,反之为错误检测结果。mAP的计算如式(9)所示

(9)

(9)

式中,n为目标类别数;i为类别标签;APi为标签i类别的平均精度,APi的大小为标签i类别的P-R曲线下包含的面积,如图 7所示。

|

| 图 7 P-R曲线 Fig. 7 P-R curve diagram |

图 8为两种架构基于ZF模型和VGG-16模型的mAP走势图,图 8(a)中实线和虚线分别为本文架构ZF模型和Faster-RCNN ZF模型的mAP曲线,图 8(b)中实线和虚线分别为本文架构VGG-16模型和Faster-RCNN VGG-16模型的mAP曲线。图 8(a)、(b)中,本文架构的mAP曲线均高于Faster-RCNN架构的mAP曲线,表明本文架构的目标检测与识别精度优于Faster-RCNN架构。

|

| 图 8 Faster-RCNN架构与本文架构测试mAP对比图 Fig. 8 The mAP comparison of Faster-RCNN and the proposed CNN framework test |

表 2中为图 8中Faster-RCNN架构和本文架构的mAP曲线平稳时,各类目标的AP值,及所有目标类别的mAP值。表 2中,本文架构ZF模型的飞机、存储罐和船只的AP值均高于Faster-RCNN ZF模型,说明本文架构ZF模型对各类目标的检测与识别精度均优于Faster-RCNN ZF模型;本文架构ZF模型和Faster-RCNN ZF模型的mAP值分别为0.772 7和0.691 0,本文架构ZF模型的mAP值比Faster-RCNN ZF模型提高了8.17%。表 2中本文架构VGG-16模型的飞机、存储罐和船只的AP值均高于Faster-RCNN VGG-16模型,表明本文架构VGG-16模型对各类目标的检测与识别精度均优于Faster-RCNN VGG-16模型;本文架构VGG-16模型和Faster-RCNN VGG-16模型的mAP值分别为0.779 0和0.695 9,本文架构VGG-16模型的mAP值比Faster-RCNN VGG-16模型提高了8.31%。试验结果表明本文架构的mAP值比Faster-RCNN架构有了较大的提升,本文架构的目标检测与识别精度优于Faster-RCNN架构。

| 模型 | 飞机 | 存储罐 | 船只 | mAP |

| Faster-RCNN ZF | 0.928 0 | 0.547 8 | 0.597 4 | 0.691 0 |

| Faster-RCNNVGG-16 | 0.931 9 | 0.540 7 | 0.615 0 | 0.695 9 |

| 本文架构ZF | 0.937 9 | 0.735 2 | 0.644 9 | 0.772 7 |

| 本文架构VGG-16 | 0.938 0 | 0.740 0 | 0.658 9 | 0.779 0 |

2.3 目标检测与识别目视判别

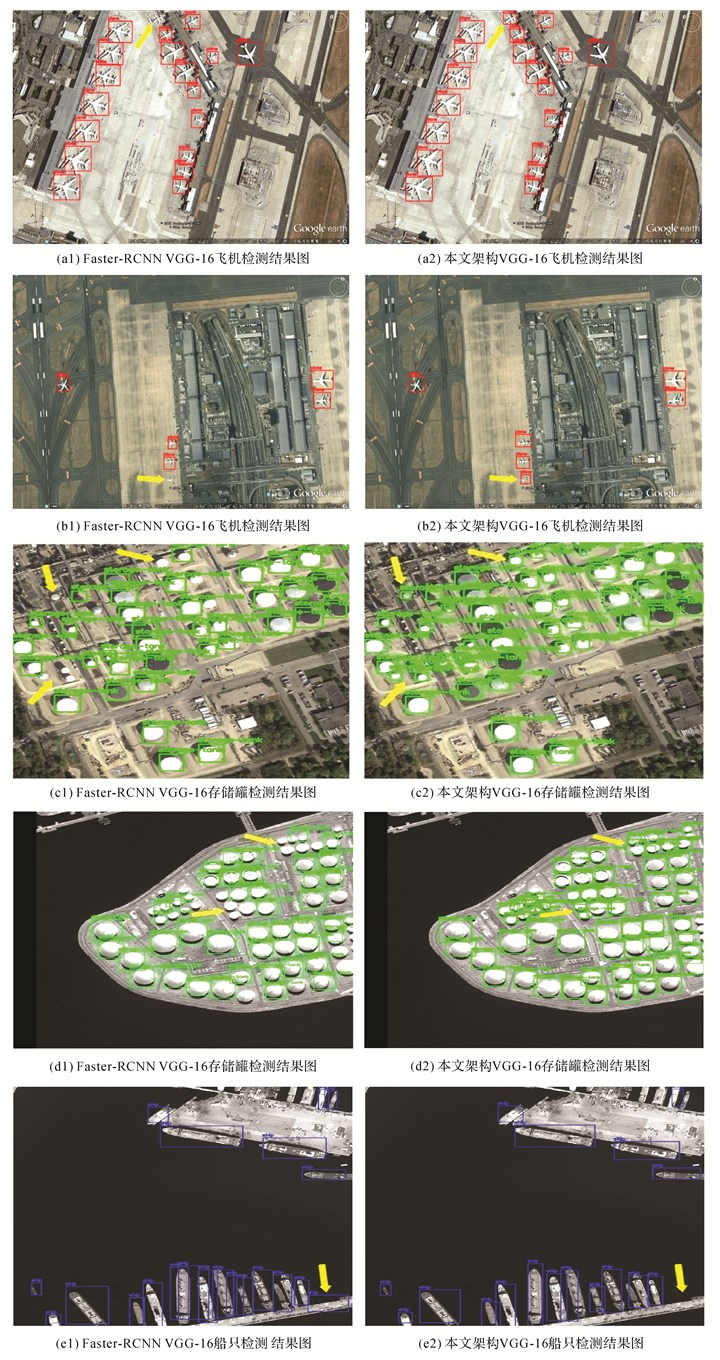

表 2中Faster-RCNN架构与本文架构基于VGG-16模型的mAP值分别高于两种架构基于ZF模型的mAP值,则对mAP值更高的Faster-RCNN VGG-16模型与本文架构VGG-16模型的检测与识别结果进行目视对比评价。两种架构目标检测与识别的置信度阈值设为0.8,图 9(a1)、(b1)、(c1)、(d1)和(e1)为Faster-RCNN VGG-16模型的测试样例结果,图 9(a2)、(b2)、(c2)、(d2)和(e2)为本文架构VGG-16模型的测试样例结果。

|

| 图 9 测试样例检测与识别结果 Fig. 9 Test sample detection and recognition results |

在图 9(a1)、(a2)中黄色箭头所指的区域,Faster-RCNN VGG-16模型难以检测与识别出尺度较小的飞机目标,而本文架构VGG-16模型可以准确检测与识别出尺度较小的飞机目标。

在图 9(b1)、(b2)中黄色箭头所指的区域,Faster-RCNN VGG-16模型难以检测与识别出尺度较小的飞机目标,而本文架构VGG-16模型可以准确检测与识别出尺度较小的飞机目标。

在图 9(c1)、(c2)中黄色箭头所指的区域,Faster-RCNN VGG-16模型难以检测与识别出尺度较小的存储罐目标,而本文架构VGG-16模型可以准确检测与识别出尺度较小的存储罐目标。

在图 9(d1)、(d2)中黄色箭头所指的区域,Faster-RCNN VGG-16模型难以检测与识别出尺度较小的存储罐目标,而本文架构VGG-16模型可以准确检测与识别出尺度较小的存储罐目标。

在图 9(e1)、(e2)中黄色箭头所指的区域,Faster-RCNN VGG-16模型将长条形状的码头区域识别为船只,而本文架构VGG-16模型可正确识别长条形状的码头区域。

试验结果表明,对于遥感影像中尺度较小的目标,本文架构VGG-16模型的检测与识别结果优于Faster-RCNN VGG-16模型,本文架构VGG-16模型可获得良好的影像检测与识别结果。

为了进一步验证本文框架的适用性与稳健性,将本文框架VGG16模型用于6幅高分二号全色影像目标检测与识别。目标检测与识别的置信度阈值设为0.8,试验结果如图 10所示。

|

| 图 10 高分二号影像目标检测与识别试验结果 Fig. 10 Experimental results of object detection and recognition on GF-2 images |

通过目视判读试验结果,本文框架VGG-16模型可有效检测与识别出影像中的飞机、存储罐和船只等典型地物。试验结果表明本文卷积神经网络架构可有效应用于高分二号影像的目标检测与识别,本文卷积神经网路架构具有良好的普适性与稳健性。

3 结论针对传统影像目标检测与识别算法中人工设计特征稳健性、普适性差的问题,本文提出基于高分辨率遥感影像目标尺度特征的卷积神经网络检测与识别。由于高分辨率遥感影像存在背景复杂、目标区域范围较小和同类目标尺度变化较大的特点,对此本文通过统计遥感影像目标的尺度范围,获得卷积神经网络训练与检测过程中目标感兴趣区域合适的尺度大小。试验统计分析得出设置4种尺度(16、32、64和128)和3种比例(1:2、1:1和2:1)生成的12种目标感兴趣区域能有效耦合遥感影像中飞机、存储罐和船只等典型目标的尺度范围。根据合适的目标感兴趣区域尺度,提出基于高分辨率遥感影像目标尺度特征的卷积神经网络检测与识别架构。通过WHU-RSone数据集测试验证,结果表明本文架构ZF模型和本文架构VGG-16模型的mAP值分别比Faster-RCNN ZF模型和Faster-RCNN VGG-16模型提高了8.17%和8.31%,本文架构可以更好地检测出影像中尺度较小的目标,获得良好的目标检测与识别效果。下一步将在遥感影像目标检测与识别的基础上,对目标方向预测进行研究。

| [1] |

李德仁, 王密, 沈欣, 等.

从对地观测卫星到对地观测脑[J]. 武汉大学学报(信息科学版), 2017, 42(2): 143–149.

LI Deren, WANG Mi, SHEN Xin, et al. From earth observation satellite to earth observation brain[J]. Geomatics and Information Science of Wuhan University, 2017, 42(2): 143–149. |

| [2] |

董志鹏, 王密, 李德仁.

一种融合超像素与最小生成树的高分辨率遥感影像分割方法[J]. 测绘学报, 2017, 46(6): 734–742.

DONG Zhipeng, WANG Mi, LI Deren. A high resolution remote sensing image segmentation method by combining superpixels with minimum spanning tree[J]. Acta Geodaetica et Cartographica Sinica, 2017, 46(6): 734–742. DOI:10.11947/j.AGCS.2017.20160514 |

| [3] |

刘婧, 李培军.

结合结构和光谱特征的高分辨率影像分割方法[J]. 测绘学报, 2014, 43(5): 466–473.

LIU Jing, LI Peijun. A high resolution image segmentation method by combined structural and spectral characteristics[J]. Acta Geodaetica et Cartographica Sinica, 2014, 43(5): 466–473. DOI:10.13485/j.cnki.11-2089.2014.0087 |

| [4] |

高常鑫, 桑农.

基于深度学习的高分辨率遥感影像目标检测[J]. 测绘通报, 2014(S1): 108–111.

GAO Changxin, SANG Nong. Deep learning for object detection in remote sensing image[J]. Bulletin of Surveying and Mapping, 2014(S1): 108–111. DOI:10.13474/j.cnki.11-2246.2014.0625 |

| [5] | CHENG Gong, HAN Junwei, GUO Lei, et al. Object detection in remote sensing imagery using a discriminatively trained mixture model[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2013, 85(11): 32–43. |

| [6] |

张剑清, 佘琼, 潘励.

基于LBP/C纹理的遥感影像居民地变化检测[J]. 武汉大学学报(信息科学版), 2008, 33(1): 7–11.

ZHANG Jianqing, SHE Qiong, PAN Li. Change detection of residential area by remote sensing image based on LBP/C texture[J]. Geomatics and Information Science of Wuhan University, 2008, 33(1): 7–11. |

| [7] | MORANDUZZO T, MELGANI F, DAAMOUCHE A. An object detection technique for very high resolution remote sensing images[C]//Proceedings of the 8th IEEE International Workshop on Systems, Signal Processing and Their Applications. Algiers, Algeria: IEEE, 2013: 79-83. https://ieeexplore.ieee.org/document/6602340 |

| [8] | BRENNING A, LONG Shilei, FIEGUTH P. Detecting rock glacier flow structures using Gabor filters and IKONOS imagery[J]. Remote Sensing of Environment, 2012, 125(10): 227–237. |

| [9] | DOU Peng, CHEN Yangbo, YUE Haiyun. Remote-sensing imagery classification using multiple classification algorithm-based AdaBoost[J]. International Journal of Remote Sensing, 2018, 39(3): 619–639. DOI:10.1080/01431161.2017.1390276 |

| [10] | YANG Guang, FANG Shenghui. Improving remote sensing image classification by exploiting adaptive features and hierarchical hybrid decision trees[J]. Remote Sensing Letters, 2017, 8(2): 156–164. |

| [11] |

曲景影, 孙显, 高鑫.

基于CNN模型的高分辨率遥感图像目标识别[J]. 国外电子测量技术, 2016, 35(8): 45–50.

QU Jingying, SUN Xian, GAO Xin. Remote sensing image target recognition based on CNN[J]. Foreign Electronic Measurement Technology, 2016, 35(8): 45–50. DOI:10.3969/j.issn.1002-8978.2016.08.011 |

| [12] |

卢艺帆, 张松海.

基于卷积神经网络的光学遥感图像目标检测[J]. 中国科技论文, 2017, 12(14): 1583–1589, 1633.

LU Yifan, ZHANG Songhai. Object detection in optical remote sensing images with convolutional neural networks[J]. China Sciencepaper, 2017, 12(14): 1583–1589, 1633. DOI:10.3969/j.issn.2095-2783.2017.14.004 |

| [13] |

何海威, 钱海忠, 谢丽敏, 等.

立交桥识别的CNN卷积神经网络法[J]. 测绘学报, 2018, 47(3): 385–395.

HE Haiwei, QIAN Haizhong, XIE Limin, et al. Interchange recognition method based on CNN[J]. Acta Geodaetica et Cartographica Sinica, 2018, 47(3): 385–395. DOI:10.11947/j.AGCS.2018.20170265 |

| [14] |

郑卓, 方芳, 刘袁缘, 等.

高分辨率遥感影像场景的多尺度神经网络分类法[J]. 测绘学报, 2018, 47(5): 620–630.

ZHENG Zhuo, FANG Fang, LIU Yuanyuan, et al. Joint multi-scale convolution neural network for scene classification of high resolution remote sensing imagery[J]. Acta Geodaetica et Cartographica Sinica, 2018, 47(5): 620–630. DOI:10.11947/j.AGCS.2018.20170191 |

| [15] |

伍广明, 陈奇, SHIBASAKIR, 等.

基于U型卷积神经网络的航空影像建筑物检测[J]. 测绘学报, 2018, 47(6): 864–872.

WU Guangming, CHEN Qi, SHIBASAKI R, et al. High precision building detection from aerial imagery using a U-Net like convolutional architecture[J]. Acta Geodaetica et Cartographica Sinica, 2018, 47(6): 864–872. DOI:10.11947/j.AGCS.2018.20170651 |

| [16] |

戴玉超, 张静, PORIKLIF, 等.

深度残差网络的多光谱遥感图像显著目标检测[J]. 测绘学报, 2018, 47(6): 873–881.

DAI Yuchao, ZHANG Jing, PORIKLI F, et al. Salient object detection from multi-spectral remote sensing images with deep residual network[J]. Acta Geodaetica et Cartographica Sinica, 2018, 47(6): 873–881. DOI:10.11947/j.AGCS.2018.20170633 |

| [17] | GIRSHICK R, DONAHUE J, DARRELL T, et al. Region-based convolutional networks for accurate object detection and segmentation[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 38(1): 142–158. DOI:10.1109/TPAMI.2015.2437384 |

| [18] | HE Kaiming, ZHANG Xiangyu, REN Shaoqing, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1904–1916. DOI:10.1109/TPAMI.2015.2389824 |

| [19] | GIRSHICK R. Fast R-CNN[C]//Proceedings of 2015 IEEE International Conference on Computer Vision. Santiago, Chile: IEEE, 2015: 1440-1448. https://arxiv.org/abs/1504.08083 |

| [20] | REN Shaoqing, HE Kaiming, GIRSHICK R, et al. Faster R-CNN:towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137–1149. DOI:10.1109/TPAMI.2016.2577031 |

| [21] |

温奇, 李苓苓, 刘庆杰, 等.

基于视觉显著性和图分割的高分辨率遥感影像中人工目标区域提取[J]. 测绘学报, 2013, 42(6): 831–837.

WEN Qi, LI Lingling, LIU Qingjie, et al. A man-made object area extraction method based on visual saliency detection and graph-cut segmentation for high resolution remote sensing imagery[J]. Acta Geodaetica et Cartographica Sinica, 2013, 42(6): 831–837. |

| [22] |

沈佳洁, 潘励, 胡翔云.

可变形部件模型在高分辨率遥感影像建筑物检测中的应用[J]. 武汉大学学报(信息科学版), 2017, 42(9): 1285–1291.

SHEN Jiajie, PAN Li, HU Xiangyun. Building detection from high resolution remote sensing imagery based on a deformable part model[J]. Geomatics and Information Science of Wuhan University, 2017, 42(9): 1285–1291. |

| [23] | ZEILER M D, FERGUS R. Visualizing and understanding convolutional networks[C]//Proceedings of the 13th European Conference on Computer Vision. Zurich, Switzerland: Springer, 2014: 818-833. https://link.springer.com/chapter/10.1007%2F978-3-319-10590-1_53 |

| [24] | SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[C]//Proceedings of the 3rd International Conference on Learning Representations. San Diego, California: [s.n.], 2015. http://www.oalib.com/paper/4068791 |

| [25] | EVERINGHAM M, ESLAMI S M A, VAN GOOL L, et al. The Pascal visual object classes challenge:a retrospective[J]. International Journal of Computer Vision, 2015, 111(1): 98–136. |