2. 中国科学院大学电子电气与通信工程学院, 北京 100049

2. School of Electronics, Electrical and Communication Engineering, University of Chinese Academy of Sciences, Beijing 100049, China

飞机目标自动检测技术是遥感图像智能解译领域的重要研究方向之一,飞机作为一类重要的军事和民用地物目标,在目标判读、交通安全和应急救援等方面具有重要的应用价值。目前,飞机目标检测算法通常可以划分为传统的多阶段检测算法和基于卷积神经网络的端到端检测算法两类。传统多阶段飞机检测算法[1-8]首先通过滑窗获得目标候选区域,然后提取特征训练分类器,最后通过分类器对候选框中的目标进行判决。事实上,多阶段飞机检测算法实现流程复杂,并且候选框的提取存在较大冗余性,在目标检测的精度和效率方面,均难以满足大范围自动化检测的需求。

近年来,基于端到端的目标检测研究取得了快速进展,研究人员提出了大量兼顾检测精度与速度的深度卷积神经网络(deep convolutional neural networks, DNNs)目标检测框架[9-13], 注1, 注2。为提高遥感目标检测精度,文献[14]提出了R-P-Faster R-CNN,该方法将RPN添加到Faster R-CNN体系结构中,从而获得了比其他基于DNNs模型更高的检测精度。文献[15]基于难样本挖掘和权重平衡策略构造了HEM-CNN框架,提高了复杂环境下的飞机目标检测精度。文献[16]提出一种多尺度共享基础网络来增强多尺度目标的检测性能。然而,由于预测特征的感受野尺度相对固定,该类方法制约了小尺度目标的检测性能。文献[17]提出了一种基于多尺度形变特征卷积网络的目标检测方法,利用可形变卷积网络对具有尺度和方向变化的遥感图像目标进行特征提取。文献[18]则在SSD网络的基础上提出了一种输入图像尺度可变的方法,该方法对输入图像进行分块,提高了飞机检测精度。然而,由于来自低层的卷积特征的语义信息较弱,该方法对多尺度目标的检测能力仍待提高。FPN[13]和TDM注3则利用top-down结构[19]解决多尺度目标检测的问题。然而,由于特征金字塔的逐级特征融合方式极大地增加了计算成本,限制了目标检测的速度,给实时检测应用造成了困难。

注1:https://arxiv.org/abs/1701.06659.

注2:https://arxiv.org/abs/1712.00960v1.

注3:https://arxiv.org/abs/1612.06851.

受上述研究启发,并针对复杂场景区域或飞机密集区域内的小尺度目标检测精度较低的问题,本文提出了一种基于多尺度融合特征的轻量级飞机检测框架MultDet。全文主要工作内容如下:

(1) 设计了一种反卷积特征融合模块,通过跳跃连接将高层语义特征融合到细节信息丰富低层特征中,得到具有丰富结构信息的融合预测特征,并研究特征融合模块对飞机检测的影响。

(2) 以SSD目标检测框架为基础,提出一种轻量级多尺度飞机目标检测框架MultDet。设计一系列不同纵横比的候选框以适应多尺度飞机目标检测,利用新的融合特征进行多尺度遥感图像飞机目标检测,MultDet显著提升复杂背景下小尺度飞机目标的检测精度。

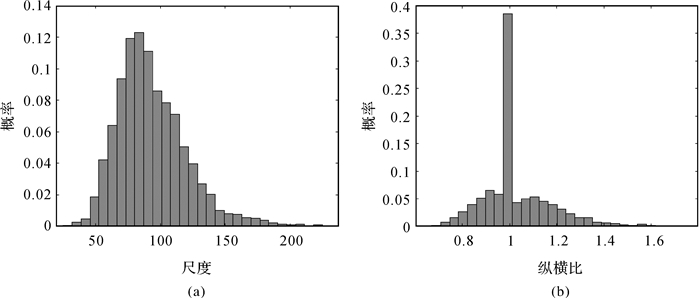

1 相关工作 1.1 多尺度目标检测对于多尺度目标检测,特别是小尺度目标的检测更加依赖低层特征信息,然而低层特征缺乏足够的语义信息,从而导致网络对小尺度目标特征的表征能力不足。因此,仅采用卷积神经网络固有的多尺度特征进行目标检测是不够的。文献[19—21]提出基于多尺度特征融合的目标检测方法,为小尺度目标检测提供更多必要的语义特征,提升了多尺度目标的检测精度。RON[21]通过反向连接增强了前向特征的语义信息;ION[21]使用跳跃连接提取多尺度特征,以及使用空间递归网络集成感兴趣区域外部的语义信息;DSOD[19]则引入密集层次连接的方式构造多尺度融合特征来强化多尺度目标的检测能力。此外,本文采用UCAS-AOD[22]多尺度数据集,以分析检测框架对于多尺度目标的检测性能。该数据集中目标实例的尺度和纵横比统计信息如图 1所示,从图 1中可以看出,数据集中目标实例的尺度分布于20~220像素,纵横比分布于0.7~1.6。数据统计表明,目标实例呈现出尺度差异明显、形态变化多样的统计特性,能够满足多尺度目标检测试验分析。

|

| 图 1 飞机数据分布信息统计 Fig. 1 The distribution of aircraft regions on training data |

1.2 特征融合算法

为了丰富特征的结构信息,文献[13, 23]考虑到特征间的关系,利用多尺度特征提高网络的检测性能注1,注2。DSSD注1采用了SSD+ResNet-101的方式,使用反卷积融合模块引入了上下文信息,提升了小尺度目标的检测精度。FSSD注2将浅层的细节特征和高层的语义特征结合起来,重构了一组金字塔特征,使网络的检测精度得到提升。FPN[13]则采用top-down结构进行充分的信息融合,增强了网络的特征表达能力。FCN[23]则使用对称结构和跳越连接来关联低层特征和高层特征。

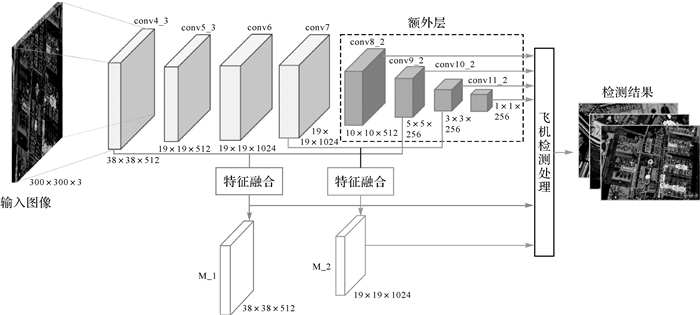

2 MultDet飞机检测框架 2.1 MultDet检测框架所提检测框架MultDet的网络整体结构如图 2所示。所提算法采用轻量级的VGG16作为基础网络提取多尺度特征信息。为充分利用低层特征信息的细节表达能力以提高网络对小尺度目标的检测精度,设定融合运算保持conv4_3和conv7层不变,将conv9_2和conv10_2分别反卷积添加到conv4_3和conv7层,新的融合特征层定义为M_1和M_2,并以此代替SSD的conv4_3和conv7进行目标检测。

|

| 图 2 MultDet飞机目标检测框架 Fig. 2 The architecture of aircraft detection MultDet |

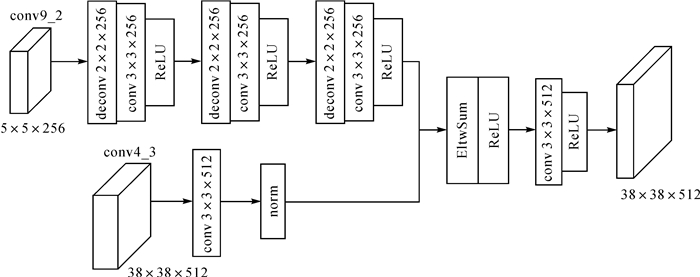

2.2 融合模块设计

MultDet通过特征融合构成了2层新的特征M_1和M_2。以MultDet300为例,M_1对应的特征融合模块结构如图 3所示,对于M_2模块同理。对于conv9_2,首先以步长为2进行3次反卷积运算,卷积核设定为2×2×256和3×3×256维张量;反卷积层后紧邻卷积层,采用L2规范化以及ReLU激活函数;conv4_3经3×3×256的卷积后,进行L2规范化,然后将两路特征进行逐元素求和,直至得到新的融合特征;最后添加3×3×256的卷积层以增强融合特征的分辨力,再经过ReLU激活函数后,即得到了M_1特征融合模块。2个特征融合模块的维度分别为512和1024。

|

| 图 3 反卷积融合模块 Fig. 3 Deconvolution fusion block |

2.3 候选框设计

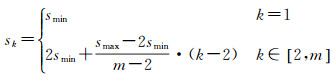

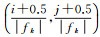

假设取m个特征层用于目标检测,则第k层特征的候选框尺度系数设定为

(1)

(1)

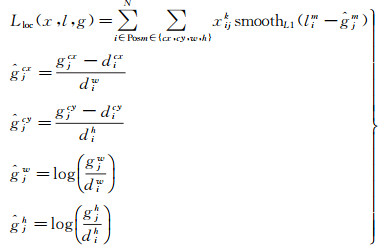

式中,smin和smax分别表示尺度系数的最值,根据图 1飞机尺度信息统计特性,尺度系数范围设定为s∈{0.05, 0.5},对于不同的预测层根据sk的定义均可计算出相应候选框的尺度系数。通过图 1的飞机数据集尺度统计信息可知,飞机目标的纵横比通常处于0.5~1.5之间。为此,本文设计相应尺度与纵横比的候选框,对于特征融合模块M_1,M_2,候选框的纵横比设置为r,r∈

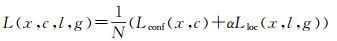

本文设计了多任务联合损失函数,用于对目标分类和边框回归两个任务进行联合训练。该损失函数如式(2)所示

(2)

(2)

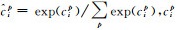

式中,N是匹配的候选框数目;α是平衡回归损失和分类损失的超参数,α通常可设置为1;损失函数的第1项Lconf(x, c)是分类损失,通常采用Softmax函数,该损失函数可表示为

(3)

(3)

式中,

(4)

(4)

式中,

本文在UCAS-AOD[23]公开数据集上评估了所有试验。该数据集包含飞机图像1000景,共标注了7482个飞机目标,本文采用1000景飞机数据作为试验数据。训练过程中,随机分配其中的60%为训练集,余下的40%为测试集,数据集的统计信息如表 1所示。

| 数据信息 | 图像数量/幅 | 尺度信息/像素 | 飞机数量/个 |

| 训练集 | 600 | 1280×659 | 3591 |

| 测试集 | 400 | 1372×941 | 3891 |

本文采用翻转以及旋转等方式将训练集进行数据扩充。扩充后训练集样本总量为3600景。本文训练和测试采用硬件平台为NVIDIA Titan Xp GPUs,并采用Pytorch深度学习框架完成试验的构建。本文采用与SSD相同的端到端训练方式,初始学习率设置为0.001,优化方法为随机梯度下降,动量设置为0.9,正则化系数设置为0.000 5,批处理大小设置为1。

3.2 评价指标本文采用平均检测精度(average precision, AP)和PR曲线(precision-recall curve, PRC)作为飞机目标检测结果的评价指标。其中,正确检测将定义为检测边框与真值边框的某一交并比(intersection over union, IoU)阈值,本文将在2种IoU阈值(0.5和0.75)下评估相应的多尺度目标检测精度。

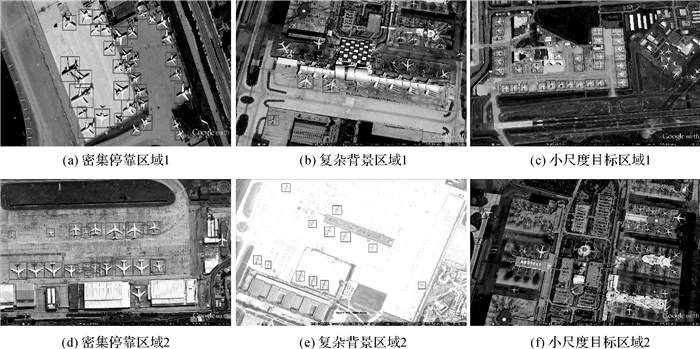

为了验证本文所提方法的有效性,本文将在UCAS-AOD数据集上训练好的飞机检测模型迁移到国产高分辨率光学影像数据的检测中。该部分试验采用的数据为4景分辨率为1 m,幅面为3000×3000像素的光学遥感图像。

3.3 试验结果与分析本文在UCAS-AOD数据集上对不同的目标检测方法进行训练和测试,检测结果如表 2所示。从表 2的检测结果可以看出:①Faster R-CNN在IoU阈值为0.5时取得了86.3%的平均检测精度,然而,当IoU阈值为0.75时,平均检测精度仅为43.5%,其原因是Faster R-CNN仅利用固定尺度的末端特征图生成预测,使得网络难以准确回归多尺度目标的位置信息;②R-FCN相较于Faster R-CNN的检测性能有了明显改善,这是由于R-FCN采用了ResNet-101网络,提升了检测器对目标特征的学习能力;此外,R-FCN提出了位置敏感得分图,增强了对多尺度目标的定位能力;③SSD300在IoU阈值为0.75时取得了73.3%的平均检测精度,相较于Faster R-CNN以及文献[24]所提的方法有明显的提高,原因在于SSD网络引入了多尺度检测思想,提升了检测精度;④FSSD相较于SSD网络进一步引入了多尺度特征融合模块,提升了多尺度目标的检测精度;⑤DSSD方法采用了反卷积特征融合策略,提高了对多尺度目标特征的表达能力;⑥相较于其他典型的目标检测方法,本文所提方法MultDet512在不同的IoU阈值下均取得了最优的平均检测精度,所提方法表现出了对于多尺度目标检测的优越性。

| 检测方法 | 基础网络 | AP0.5/ (%) |

AP0.75/ (%) |

速度/ (s/img) |

| Faster R-CNN[9] | VGG16 | 86.3 | 43.5 | 0.070 2 |

| R-FCN[10] | ResNet-101 | 90.0 | 77.7 | 0.095 0 |

| Liang[24] | VGG16 | 63.1 | - | 0.055 6 |

| Xia[25] | Darknet19 | 90.66 | - | - |

| SSD300[12] | VGG16 | 80.6 | 67.3 | 0.024 7 |

| DSSD321注1 | ResNet-101 | 81.3 | 72.7 | 0.065 6 |

| FSSD300注2 | VGG16 | 81.7 | 74.7 | 0.027 5 |

| MultDet-300 | VGG16 | 85.9 | 78.1 | 0.047 7 |

| SSD512[12] | VGG16 | 89.7 | 76.7 | 0.036 2 |

| DSSD513注1 | ResNet-101 | 90.4 | 80.6 | 0.072 7 |

| FSSD512注2 | VGG16 | 90.1 | 79.5 | 0.034 0 |

| MultDet-512 | VGG16 | 94.8 | 81.3 | 0.050 0 |

注1:https://arxiv.org/abs/1701.06659.

注2:https://arxiv.org/abs/1712.00960v1.

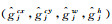

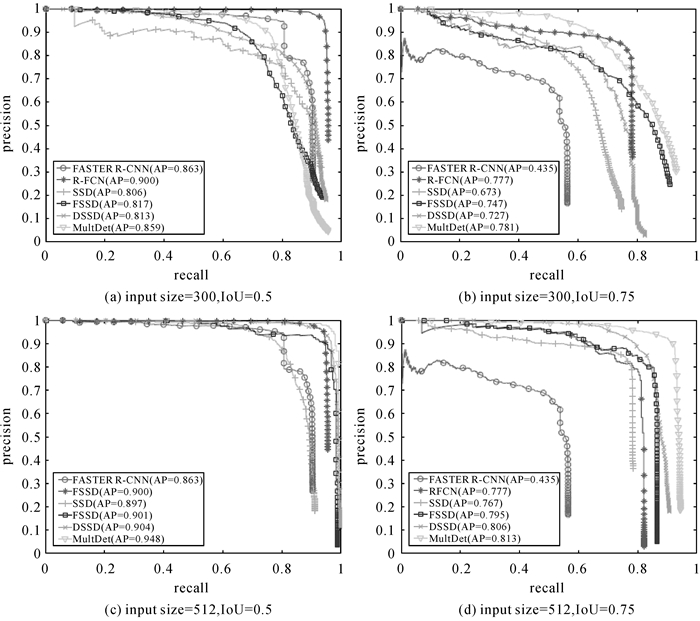

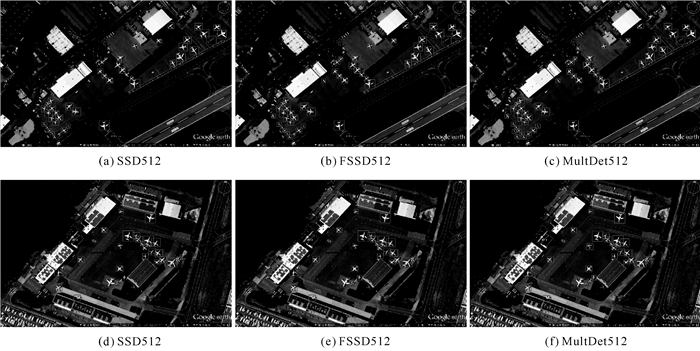

不同检测方法对应的飞机目标检测结果的PR曲线如图 4所示,本文所提MultDet检测框架在精度和召回率两个性能指标均优于其他方法。如图 5所示,分别给出SSD512(如图 5(a),图 5(d))、FSSD512(如图 5(b),图 5(e))以及MultDet512(如图 5(c),图 5(f))的飞机目标检测结果示例,方框代表检测到的飞机目标。从图 5中可以看出,相较于SSD512和FSSD512目标检测框架,基于VGG16的MultDet网络显著提升了小尺度密集飞机目标的检测能力。此外,在不同场景下,MultDet网络的部分检测结果示例如图 6所示,在密集飞机停靠区域(图 6(a)、(d))、复杂背景区域(图 6(b)、(e))以及小尺度飞机目标区域(图 6(c)、(f)),MultDet均可以精确检测出其中的飞机目标,试验结果证明了MultDet目标检测框架可以有效提高复杂场景区域及密集小尺度飞机目标的检测能力。

|

| 图 4 不同检测算法在UCAS-AOD数据集上的PR曲线 Fig. 4 Precision-recall curves of the diverse methods on the UCAS-AOD dataset |

|

| 图 5 不同框架的检测结果对比图 Fig. 5 Aircraft detection results of different detection methods |

|

| 图 6 MultDet512飞机检测结果示例 Fig. 6 Aircraft detection results of MultDet512 |

3.4 消融试验 3.4.1 融合构型分析

如表 3所示,本文设计了3组多尺度特征融合构型分析对比试验,同时评估了相应模型的检测精度。以第1组试验为例,如表 3第3~5行所示,当输入尺度为300×300时,即设定(conv4_3、conv8_2)为基本融合层时,对比了在不同融合组(conv7、conv9_2)以及(conv7、conv10_2)下的检测性能,其平均检测精度分别为85.6%和84.7%。试验结果表明,MeticDet300按所设计的不同融合构型,其平均检测精度由85.9%递减到83.7%。

| 基础特征层 | SSD层 | AP0.5/ (%) |

|||

| conv4_3 | conv7 | conv8_2 | conv9_2 | conv10_2 | |

| √ | √ | ||||

| √ | √ | 85.6 | |||

| √ | √ | 84.7 | |||

| √ | √ | ||||

| √ | √ | 84.8 | |||

| √ | √ | 85.9 | |||

| √ | √ | ||||

| √ | √ | 84.6 | |||

| √ | √ | 83.7 | |||

3.4.2 融合组件分析

表 4的对比试验分析了融合模块对飞机目标检测结果的影响,从试验结果可以看出,MultDet300在含有M_1、M_2特征融合模块时,飞机目标检测结果较仅含M_1融合模块时提高了1.6%;MultDet512检测结果较仅含M_1融合模块时提高了1.3%。试验结果表明,多尺度特征融合组件可以合理挖掘多尺度特征信息,增强多尺度目标的特征学习能力,从而提高了多尺度飞机目标检测性能。

| 项目 | MultDet-300 | MultDet-512 | ||||

| M_1 | √ | √ | √ | √ | ||

| M_2 | √ | √ | ||||

| AP/(%) | 85.9 | 84.3 | 81.7 | 94.8 | 93.5 | 87.1 |

| 时间/(s/img) | 0.047 7 | 0.035 6 | 0.024 7 | 0.050 0 | 0.038 7 | 0.036 2 |

3.4.3 候选框设计

通过表 5设计的对比结果可以看出设计多种纵横比的候选框可以提高飞机检测精度,注意到增加纵横比为

| 候选框纵横比 | AP0.5/ (%) |

|||

| {1} |  |

|

|

|

| √ | √ | √ | √ | 94.8 |

| √ | √ | √ | 94.8 | |

| √ | √ | 92.5 | ||

| √ | 87.6 | |||

3.5 检测速度

本文评估了MultDet300/512框架的飞机目标检测速度,并与几种代表性多尺度飞机检测框架进行了对比,结果如表 2第5列所示,MultDet300在单张Titan Xp GPU上的检测速度为0.047 7 s/img;由于所提算法在SSD网络上附加了融合特征层,导致额外消耗了推断时间,但是相比于DSSD网络仍具明显的速度优势。本文所提方法相较于其他目标检测算法实现了具有竞争力的检测速度,同时实现了检测精度与检测速度的良好权衡。

3.6 迁移试验分析为了验证本文所提方法的有效性,以及对于小而密集的飞机目标的检测效果,本文将在上述UCAS-AOD数据集上训练好的飞机检测模型,直接用于国产高分辨率光学遥感卫星影像数据的飞机目标检测。

如图 7所示,本文给出了4景国产高分辨率光学遥感影像的检测结果实例。从中可以看出,MultDet对于小尺度密集分布的飞机目标检测效果比较理想,证明了本文方法对于检测尺度密集分布飞机目标的有效性。此外,训练集所采用的主要是民航客机样本,而测试图像中飞机形态与训练集数据的差异性较大,本文所提方法仍然能对其进行有效检测,证明了本文方法所学习到的检测模型具有一定的迁移性和通用性。

|

| 图 7 迁移试验检测结果 Fig. 7 The migration test results |

4 结论

本文提出一种基于深度卷积神经网络的端到端飞机目标检测框架MultDet。采用轻量级的特征提取网络作为基础网络,设计多尺度特征融合模块,通过跳跃连接将高层语义特征与低层细节特征进行信息融合,增强了特征的结构信息以提高模型对多尺度目标特征的表征能力。本文根据数据集尺度分布特征,设计了相应尺度与纵横比的候选框,使检测器更好地适应多尺度飞机目标检测。试验结果表明,本文所提方法在保持较小的运算速度损失前提下,有效地解决了深层特征维度过低,特别是对小尺度目标表征能力不足的问题,实现了对复杂场景多尺度飞机目标的最优检测性能。

| [1] | CHENG Gong, ZHOU Peicheng, HAN Junwei. Learning rotation-invariant convolutional neural networks for object detection in VHR optical remote sensing images[J]. IEEE Transactions on Geoscience and Remote Sensing, 2016, 54(12): 7405–7415. DOI:10.1109/TGRS.2016.2601622 |

| [2] | HAN Junwei, ZHANG Dingwen, CHENG Gong, et al. Object detection in optical remote sensing images based on weakly supervised learning and high-level feature learning[J]. IEEE Transactions on Geoscience and Remote Sensing, 2015, 53(6): 3325–3337. DOI:10.1109/TGRS.2014.2374218 |

| [3] | CHENG Gong, HAN Junwei, ZHOU Peicheng, et al. Multi-class geospatial object detection and geographic image classification based on collection of part detectors[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2014, 98(12): 119–132. |

| [4] | HE Chu, TU Mingxia, XIONG Dehui, et al. Adaptive component selection-based discriminative model for object detection in high-resolution SAR imagery[J]. ISPRS International Journal of Geo-Information, 2018, 7(2): 72. DOI:10.3390/ijgi7020072 |

| [5] | DIAO Wenhui, SUN Xian, ZHENG Xinwei, et al. Efficient saliency-based object detection in remote sensing images using deep belief networks[J]. IEEE Geoscience and Remote Sensing Letters, 2016, 13(2): 137–141. DOI:10.1109/LGRS.2015.2498644 |

| [6] | DU Bo, ZHANG Yuxiang, ZHANG Liangpei, et al. Beyond the sparsity-based target detector:a hybrid sparsity and statistics-based detector for hyperspectral images[J]. IEEE Transactions on Image Processing, 2016, 25(11): 5345–5357. DOI:10.1109/TIP.2016.2601268 |

| [7] | LI Xuelong, MOU Lichao, LU Xiaoqiang. Scene parsing from an MAP perspective[J]. IEEE Transactions on Cybernetics, 2015, 45(9): 1876–1886. DOI:10.1109/TCYB.2014.2361489 |

| [8] | ZHANG Libao, ZHANG Yingying. Airport detection and aircraft recognition based on two-layer saliency model in high spatial resolution remote-sensing images[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2017, 10(4): 1511–1524. DOI:10.1109/JSTARS.2016.2620900 |

| [9] | REN Shaoqing, HE Kaiming, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks[C]//Proceedings of the 28th International Conference on Neural Information Processing Systems. Montreal, Canada: ACM, 2015: 91-99. https://www.ncbi.nlm.nih.gov/pubmed/27295650 |

| [10] | DAI Jifeng, LI Yi, HE Kaiming, et al. R-FCN: object detection via region-based fully convolutional networks[C]//Proceedings of the 30th International Conference on Neural Information Processing Systems. Barcelona, Spain: ACM, 2016: 379-387. |

| [11] | REDMON J, FARHADI A. YOLO9000: better, faster, stronger[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017: 6517-6525. |

| [12] | LIU Wei, ANGUELOV D, ERHAN D, et al. SSD: single shot MultiBox detector[C]//Proceedings of the 14th European Conference On Computer Vision. Amsterdam, The Netherlands: Springer, 2016: 21-37. https://link.springer.com/chapter/10.1007/978-3-319-46448-0_2 |

| [13] | LIN T Y, DOLLÁR P, GIRSHICK R, et al. Feature pyramid networks for object detection[C]//Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017: 936-944. |

| [14] | HAN Xiaobing, ZHONG Yanfei, ZHANG Liangpei. An efficient and robust integrated geospatial object detection framework for high spatial resolution remote sensing imagery[J]. Remote Sensing, 2017, 9(7): 666. DOI:10.3390/rs9070666 |

| [15] | CAI Bowen, JIANG Zhiguo, ZHANG Haopeng, et al. Airport detection using end-to-end convolutional neural network with hard example mining[J]. Remote Sensing, 2017, 9(11): 1198. DOI:10.3390/rs9111198 |

| [16] | GUO Wei, YANG Wen, ZHANG Haijian, et al. Geospatial object detection in high resolution satellite images based on multi-scale convolutional neural network[J]. Remote Sensing, 2018, 10(1): 131. DOI:10.3390/rs10010131 |

| [17] |

邓志鹏, 孙浩, 雷琳, 等.

基于多尺度形变特征卷积网络的高分辨率遥感影像目标检测[J]. 测绘学报, 2018, 47(9): 1216–1227.

DENG Zhipeng, SUN Hao, LEI Lin, et al. Object detection in remote sensing imagery with multi-scale deformable convolutional networks[J]. Acta Geodaetica et Cartographica Sinica, 2018, 47(9): 1216–1227. DOI:10.11947/j.AGCS.2018.20170595 |

| [18] | CHEN Zhong, ZHANG Ting, OUYANG Chao. End-to-end airplane detection using transfer learning in remote sensing images[J]. Remote Sensing, 2018, 10(1): 139. |

| [19] | SHEN Zhiqiang, LIU Zhuang, LI Jianguo, et al. DSOD: learning deeply supervised object detectors from scratch[C]//Proceedings of 2017 IEEE International Conference on Computer Vision. Venice, Italy: IEEE, 2017: 1937-1945. |

| [20] | BELL S, ZITNICK C L, BALA K, et al. Inside-outside net: detecting objects in context with skip pooling and recurrent neural networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas: IEEE, 2016: 2874-2883. https://ieeexplore.ieee.org/document/7780683 |

| [21] | KONG Tao, SUN Fuchun, YAO Anbang, et al. RON: reverse connection with objectness prior networks for object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Honolulu: IEEE, 2017: 5244-5252. https://arxiv.org/abs/1707.01691 |

| [22] | ZHU Haigang, CHEN Xiaogang, DAI Weiqun, et al. Orientation robust object detection in aerial images using deep convolutional neural network[C]//Proceedings of 2015 IEEE International Conference on Image Processing. Quebec City: IEEE, 2015: 3735-3739. https://ieeexplore.ieee.org/abstract/document/7351502 |

| [23] | LONG J, SHELHAMER E, DARRELL T. Fully convolutional networks for semantic segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Boston: IEEE, 2015: 3431-3440. |

| [24] |

梁华, 宋玉龙, 钱锋, 等.

基于深度学习的航空对地小目标检测[J]. 液晶与显示, 2018, 33(9): 793–800.

LIANG Hua, SONG Yulong, QIAN Feng, et al. Detection of small target in aerial photography based on deep learning[J]. Chinese Journal of Liquid Crystals and Displays, 2018, 33(9): 793–800. |

| [25] | XIA Guisong, BAI Xiang, DING Jian, et al. DOTA: a large-scale dataset for object detection in aerial images[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. Salt Lake City: IEEE, 2018: 3974-3983. https://arxiv.org/abs/1711.10398 |