2. 解放军 95899部队, 北京 100085;

3. 淮安市水利勘测设计研究院有限公司, 江苏 淮安 223000

2. 95899 Troops, People's Liberation Army, Beijing 100085, China;

3. Huai'an Surveying and Design Institute of Water Resources Co., Ltd., Huai'an 223000, China

交通是经济可持续发展的基础,并随着科学技术以及社会经济的发展而日益发达。交通需求的迅速增长导致交通阻塞、交通事故等一系列问题,成为困扰许多城市的通病[1]。针对交通环境的恶化,各国都积极采取相应的措施来改善交通状况,智能交通系统(intelligent traffic system,ITS)作为一种高效率的管理方法应运而生,也成为当今道路交通管理的发展趋势[2]。其中车辆速度检测是交通信息采集的重要组成部分,也是ITS研究中的热点和难点。

随着传感器和通信技术的发展,车辆速度检测方法主要有:线圈检测、激光检测、雷达检测等[3]。其中感应线圈是应用最早的检测技术之一,其利用电磁感应原理进行车辆速度的检测,具备稳定性强,测量精度高等优点,但其安装维修困难。激光检测通过发射激光与反射激光到车辆的时间差来计算车辆速度,具备高精度、测速范围大的优点,但安装要求较高且成本较高。雷达检测在固定时间间隔发射两个脉冲,通过测得的距离计算车辆速度,此方法测速范围广,不受天气条件影响,但只能对单个目标进行测速,且容易受到无线电波的干扰[4-5]。随着视频检测技术的发展,在交通视频中可以获取大量的交通状况信息,应用目标识别等图像处理技术可以获取视频中的车辆信息,进而检测车辆速度,其中利用相机获取视频数据简单便捷,并且视频检测容易模块化和集成化[6]。例如文献[7]利用交通录像视频计算车辆的运动轨迹以及速度等参数。文献[8]提出基于高斯-卡尔曼混合模型的背景模型对目标进行检测,并在此基础上提取运动目标的运动参数。文献[9]提出实时监测动态场景中的运动目标系统。但传统的视频检测存在局限性[10]:①相机往往固定在道路特定位置,这意味着获取数据位置较为固定,不具备数据采集位置的灵活性;②视频获取主要依靠可见光相机,其依赖良好的光照条件,昼夜或天气的转换都可能影响检测结果[11]。

无人机是一种操作便捷、能搭载多类型装备并且能重复使用的无人驾驶航空器[12]。在信息化技术、通信技术、空气动力技术等的迅猛发展下,无人机性能逐渐完善,其具有灵活机动、实时性强、风险小等独特优点,不仅在军用战场上,也在民用资源调查等领域占据着不可或缺的位置[12-13]。本文为解决传统视频获取位置较为固定问题,尝试通过无人机平台获取视频数据。当然,无人机的广泛应用也得益于搭载的传感器,传统搭载可见光相机的无人机应用于测绘、监测与制图领域[14]。由于传感器技术的发展,获取数据的类型和质量都有了提升,例如:热红外相机也具备优异的成像能力,而且成本也在急剧下降。本文尝试通过热红外相机解决夜间车辆速度检测问题,使得检测方法不依赖光照条件,提高车辆速度检测的稳健性。

综上,本文通过无人机平台获取可见光和热红外视频数据,然后综合利用多源数据检测车辆,进而提高车辆检测的精度,最后依据检测结果跟踪车辆并计算车辆速度。

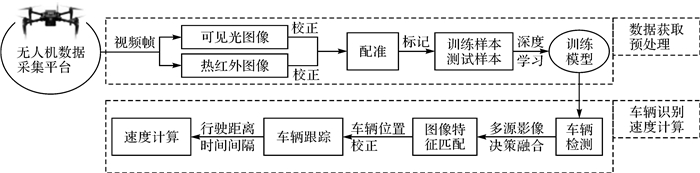

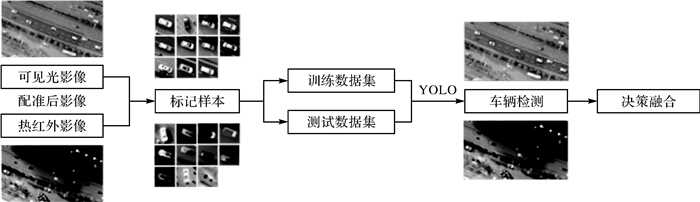

1 基于无人机多源影像的车辆速度检测本文的研究工作主要包括以下几个方面:①多源数据采集,通过无人机平台采集可见光影像和热红外影像;②多源数据预处理,对采集的多源影像进行畸变校正并配准;③车辆检测,应用深度学习对多源数据的车辆目标进行检测,并将检测结果进行决策融合;④车辆跟踪,首先对相邻视频帧进行图像特征匹配,重新定位车辆目标位置,校正因无人机运动引起的误差,然后采用离散卡尔曼滤波对识别出的车辆进行跟踪和预测;⑤车辆速度计算,根据车辆跟踪结果,绘制车辆运动轨迹路线,并根据目标车辆的像素移动距离计算车辆实际行驶距离,通过采集图像的频率计算图像采集的时间间隔,最后根据速度计算公式计算车速。方法流程如图 1所示。

|

| 图 1 本文方法流程 Fig. 1 Flowchart of the proposed approach |

1.1 搭建无人机多源数据采集平台

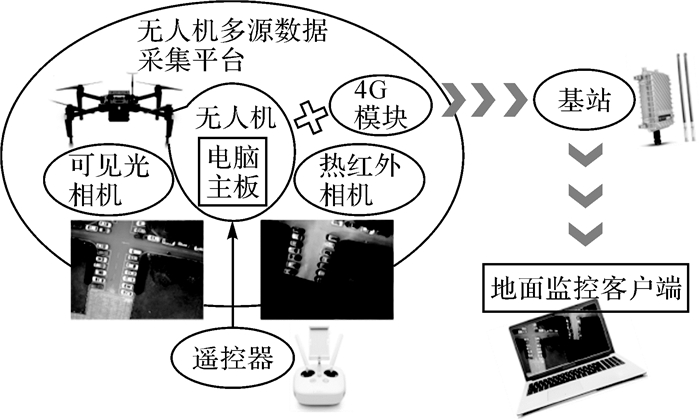

传统无人机平台由动力系统、控制系统、可见光相机、图像传输模块、GPS模块和电池等组成[15]。为获取多源影像中的热红外影像,需增加热红外相机,同时需要解决相机获取数据的同步问题和传输问题。本文尝试在无人机平台增加电脑主板,然后通过编码在电脑主板中同时获取多源影像,最后使用4G模块传输多源数据。无人机数据采集平台框架如图 2所示。由飞行遥控器控制无人机的数据采集范围,电脑主板获取多源数据并将数据通过4G模块传输至连接到基站的地面监控客户端。

|

| 图 2 多源数据采集平台框架 Fig. 2 Multi-source data acquisition system flow diagram |

1.2 相机校正

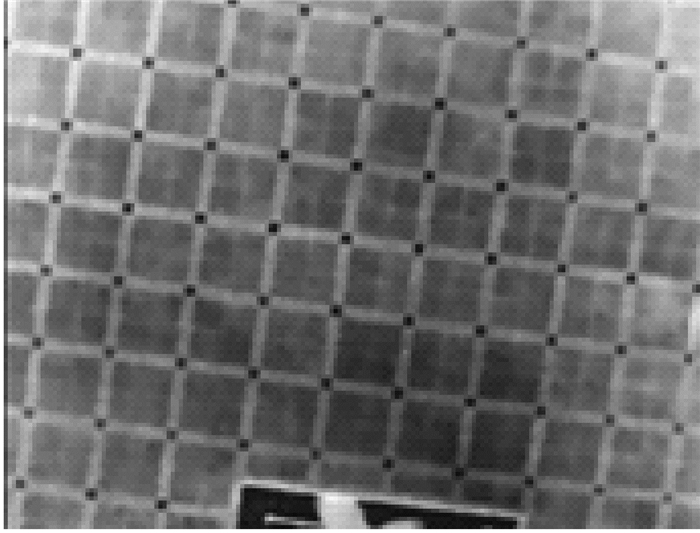

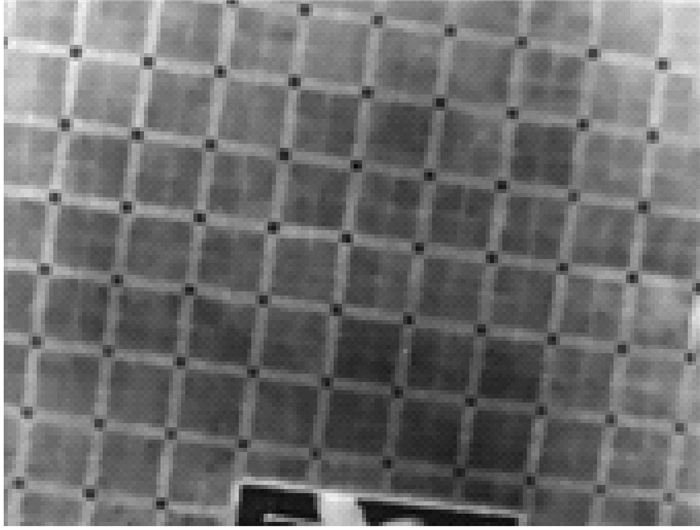

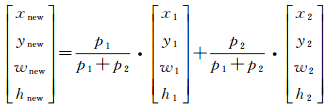

目前相机镜头处理技术正飞速地发展,但依旧存在几何畸变,为了减少因图像变形导致的配准误差及图像分辨率的计算误差,本文需要对可见光相机和热红外相机进行畸变校正。对于可见光相机,可以使用传统的黑白棋盘格作为标定板,提取棋盘格角点后估算理想无畸变情况下的内参和外参,然后应用最小二乘估算实际存在的畸变系数,最后使用最大似然法提升估算精度。校正流程使用Matlab中的相机校准工具。但传统的黑白棋盘格在热红外影像中成像几乎相同,无法提取角点,所以并不适用于热红外相机校正。幸运的是,本文发现了由不同颜色大理石组成的广场,并且大理石的排列方式和棋盘格一致。由于不同颜色的大理石反射率和吸收率是不同的,所以在光照条件下温度也是不同的,温度较高的大理石在热红外相机中表现为较亮的区域,而温度较低的大理石恰好相反,整个广场在热红外相机的成像如图 3所示,本文将该区域作为热红外相机的畸变校正区域。采用最稳定极值区域(maximally stableextremal regions,MSER)算法来定位图像中的黑色区域,因为图像中的黑色区域较小,本文将区域大小和像素平均值作为阈值提取黑色区域,计算区域的中心点,将中心点视为“棋盘格”中的角点,提取的角点如图 4所示,提取角点后可使用Matlab中的相机校准工具进行畸变校正。

|

| 图 3 校正区域的热红外影像 Fig. 3 The calibration area in thermal infrared |

|

| 图 4 提取校正区域的角点 Fig. 4 Detecting the points in the calibration area |

1.3 多源数据的车辆检测

车辆检测是车辆速度检测的基础。选择一个准确可靠的检测方法是重中之重。其中车辆检测方法主要有光流法、背景差异法、梯度比较法及知识型检测法等[16-17]。这些检测方法容易受到光照、阴影、图像质量的影响,而且本文中无人机获取多源影像时存在运动,也就意味着背景存在差异。近些年来,基于机器学习的方法取得良好的试验结果,利用大量正负样本进行学习,从而对目标进行识别,从2013的基于区域的卷积神经网络(region-based convolutional neural network,R-CNN)到Fast-R-CNN,Faster-R-CNN, SDD(the single shot detector),YOLO(arxiw preprint arxiv:1612.08242, 2016)等,一系列的方法不断刷新目标检测精度的新高[18]。本文采用的深度学习方法是YOLO,其具备速度快和效果佳的优点,十分适合处理视频数据。

1.3.1 基于YOLO的车辆检测YOLO的核心思想是利用整张图像作为网络的输入,然后在输出层直接回归出目标框的位置和目标所属的类别,以实现端对端的直接优化。YOLO的基本实现思路如下:

(1) 首先将图像分成S×S个网格,当某个目标中心落在这个网格中,则该网格就负责预测该目标。

(2) 然后在每个网格中预测B个目标框及对应的可信度(Confidence)。目标框包含5个参数:目标框的中心点坐标,宽度,高度及可信度。

(3) 在每个网格中预测C个目标类别的可能性。

(4) 最后在测试阶段,将目标类别可能性和置信度相乘,计算出每个目标框的特定类别的可能性。

通过上述过程,YOLO从整个训练图像中学习目标的特征,在测试阶段利用训练模型进行目标检测。基于YOLO的原理,在多源影像中检测车辆目标,首先标记预处理后影像中的车辆目标,并分为训练和测试数据集,使用YOLO深度学习框架训练模型,然后将保存的模型用于车辆检测,并将检测结果决策融合,流程如图 5所示。

|

| 图 5 车辆检测流程 Fig. 5 Flowchart of the vehicle detection |

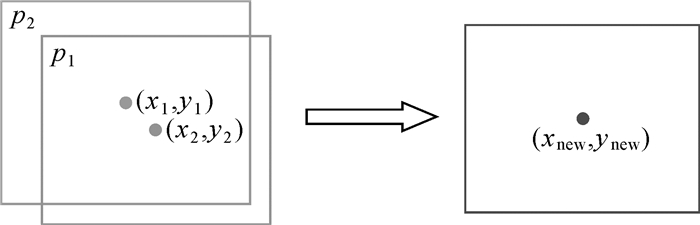

1.3.2 目标框决策融合

在多源数据车辆检测结果中存在同一车辆多次被检测的情况,如图 6所示。本文以车辆目标框中心点距离作为阈值,判断是否将目标框融合。当中心点距离较小时,认为检测结果为同一车辆目标,需进行融合[19]。

|

| 图 6 车辆检测结果决策融合 Fig. 6 Decision fusion of vehicle detection result |

新目标框的计算如式(1)所示

(1)

(1)

式中,(x, y)为目标框的中心点;(w, h)为目标框的高度和宽度;p表示目标框的可信度。

1.4 车辆跟踪与速度计算检测出车辆目标后,为准确获取车辆位移,需要图像特征匹配校正车辆位置和卡尔曼滤波跟踪车辆。

1.4.1 图像区域特征匹配为更准确地计算车辆位移,需考虑无人机平台在悬停获取多源数据时的运动。本文试验数据中背景变化差异较小,采用图像特征匹配方法匹配视频帧间的背景,估算因无人机平台抖动导致的背景位移,进而校正车辆在视频帧中的位置。

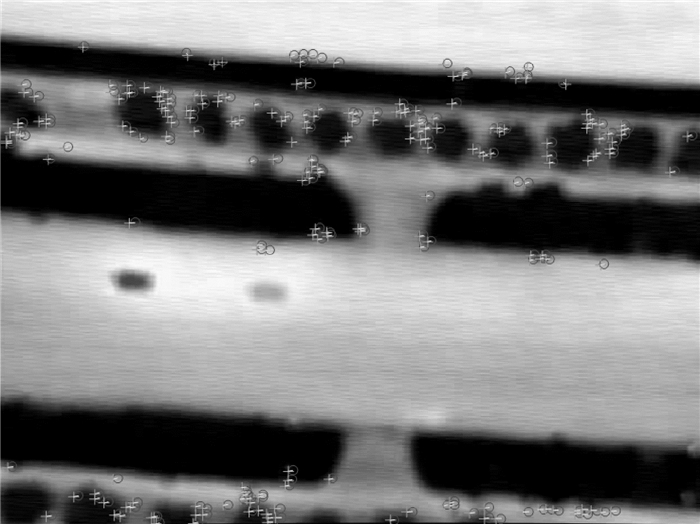

本文首先提取图像中SURF(speeded up robust features)特征点,并对特征点作匹配[20-21],根据特征点的位置变动情况计算位移变换关系,进而校正车辆位置。以可见光视频中的两帧图像为例,区域特征匹配结果如图 7所示,绿色标记点表示某一帧的特征点,红色标记点表示对应匹配特征点在下一帧的位置。当红色标记点和绿色标记点距离较近时,意味着无人机平台相对较为稳定,距离较远时则相反。同理,热红外图像特征匹配结果如图 8所示。

|

| 图 7 可见光图像匹配 Fig. 7 Visible image matching |

|

| 图 8 热红外图像匹配 Fig. 8 Thermal infrared image matching |

本文获取多源影像时,无人机高度较为固定,所以相同车辆目标在视频帧中的大小几乎不会发生变化,并且试验中的图像配准结果也表明无需考虑车辆大小的变化。

1.4.2 目标跟踪本文根据图像区域特征匹配校正视频帧间车辆位置后,需要对车辆目标进行跟踪预测,进而获取车辆的运动轨迹,当车辆即将离开拍摄范围时,结束对车辆目标的跟踪,然后绘制车辆的运动轨迹。

20世纪60年代卡尔曼滤波理论被提出,其利用统计估计理论进行递推,能根据过去的信号对未来的信号做出估计,依据的原理是时变随机信号的统计特征和线性均方误差最小化的优化准则[22-23]。本文首先将检测车辆位置的矩形框中心作为车辆的形心,采用卡尔曼滤波不断更新车辆目标的真实位置和预测位置,实现车辆的目标跟踪并绘制运动轨迹。

1.4.3 车速计算在实际试验时,为了避免把不必要的因素引入计算中,本文对试验中的无人机平台和交通情况做出3点假设:①无人机平台可以精准悬停获取数据,并提供高度信息,试验中采用的无人机平台垂直方向上的悬停精度为±0.5 m,这不仅为图像分辨率计算提供数据,也可以保证相同车辆目标在视频帧中几乎不会发生大小变化,试验中的图像配准结果也表明无须考虑车辆大小的变化。②无人机平台采集数据区域的路面是相对平坦的,可以在处理中近似认为是平面,因为复杂的路面情况会影响相机的标定,因此本试验中的路面情况相对简单。③无人机平台增加增稳云台进行相机的姿态调整,角度抖动量为±0.03°,保证相机是垂直向下进行数据的获取,尽量保证车辆位移计算的准确性。

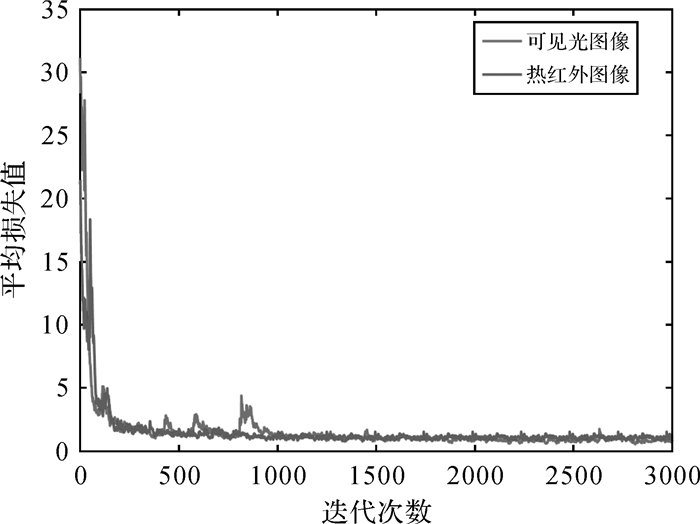

基于以上假设,根据车辆在n帧发生的位移计算车辆速度,由式(2)计算得到

(2)

(2)

式中,v为目标车辆速度;f为图像分辨率,根据无人机获取数据的高度和相机的焦距计算得知;(X(t+n), Y(t+n))表示车辆在第(t+n)帧的坐标位置;(X(t), Y(t))表示车辆在第t帧的坐标位置;T表示拍摄n帧图像的时间间隔,根据相机获取图像的帧率计算得知。

2 试验结果 2.1 数据采集本试验使用大疆MATRICE 100作为无人机平台。在MATRICE 100上搭载DLCW工业相机用于采集可见光影像,其像元尺寸为5.0 μm×5.2 μm,并搭载热红外相机用于采集热红外影像,其波长范围为8~14 μm。采集平台以视频的方式保存多源影像,其中视频帧大小为1280×960,可见光图像和热红外图像的大小为640×480。试验数据采集范围为武汉市洪山区珞瑜路及光谷一路,其中珞瑜路路况较为复杂,如图 9和图 10所示。此数据主要用于车辆目标检测模型的训练,无人机相对于地面悬停高度范围为20~80 m,获取更为丰富的训练样本。光谷一路路况较为简单,如图 11和图 12所示。此数据主要用于车辆速度计算的精度评价。为说明热红外影像在光照条件不足情况下的优势,在光谷一路分别采集白天和夜晚数据,无人机相对于地面悬停高度分别为34 m和37 m。

|

| 图 9 可见光图像(珞瑜路) Fig. 9 Visible image |

|

| 图 10 热红外图像(珞瑜路) Fig. 10 Thermal infrared image |

|

| 图 11 可见光图像(光谷一路) Fig. 11 Visible image |

|

| 图 12 热红外图像(光谷一路) Fig. 12 Thermal infrared image |

2.2 数据预处理

根据1.2节的介绍,搭载的可见光相机和热红外相机存在几何畸变,使用传统的棋盘格和广场区域分别校正可见光相机和热红外相机。将校正后的多源影像手动选择地面控制点,采用单映射矩阵进行配准,基于固定的相机和不变的模型,将图像的变换关系应用于所有图像,并将配准后的结果进行裁剪。其中配准时因可见光图像的分辨率较高,将其作为基准影像,以珞瑜路中一段为例,配准结果如图 13和图 14所示。

|

| 图 13 可见光基准影像 Fig. 13 Visible based image |

|

| 图 14 热红外图像匹配结果 Fig. 14 Thermal infrared image matching result |

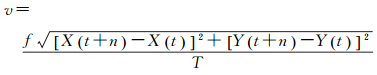

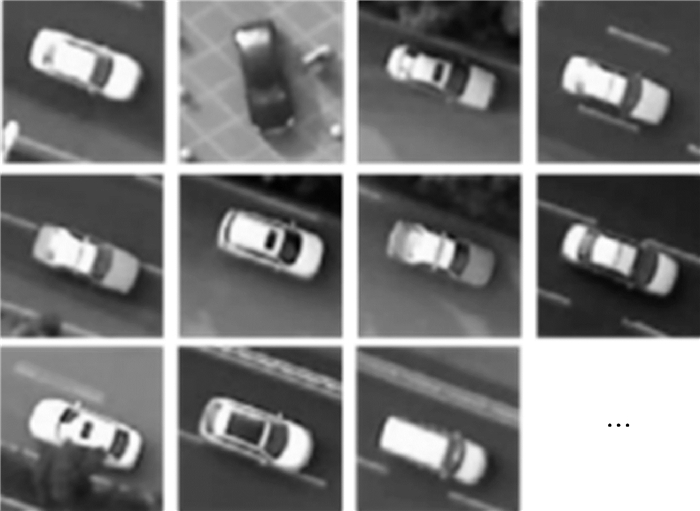

下一步是选择训练数据集和测试数据集,在多源图像中对车辆目标进行标记,标签包含五个参数(class, x, y, w, h)分别为类别车辆,以及车辆的位置坐标,宽度和高度。在试验中,本文对2000辆车进行了训练数据的标记,并标记了500辆车辆作为测试数据。可见光数据和热红外数据的标记样本分别如图 15和图 16所示。

|

| 图 15 可见光影像中的标记样本 Fig. 15 Tagged samples from the visible image |

|

| 图 16 热红外影像中的标记样本 Fig. 16 Tagged samples from the infrared thermal image |

2.3 车辆检测

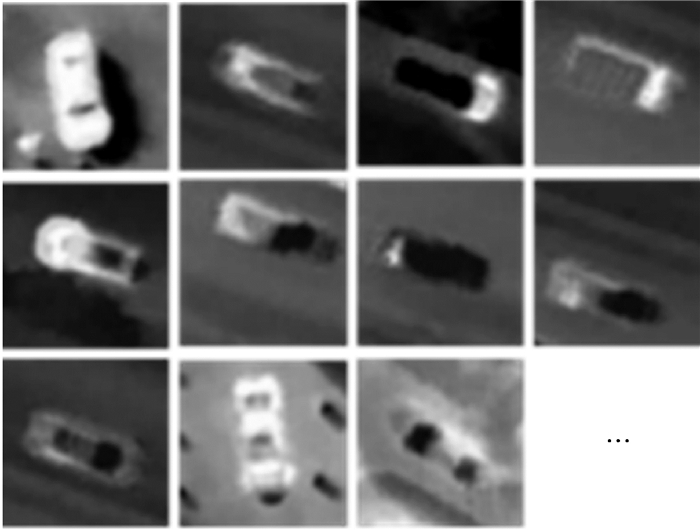

本文的YOLO训练参数设置如下:权值衰减率为0.000 5,批尺寸为15, 以及学习率为0.000 5,而且输入图像尺寸归一化为448×448。对可见光影像和热红外影像进行模型训练,保证训练结果满足收敛条件,并保存训练模型结果。试验训练共3000次,训练情况如图 17所示。

|

| 图 17 可见光和热红外影像训练情况 Fig. 17 Iterations of visible image and infrared thermal image |

将训练模型加载,对无人机平台采集的多源影像进行车辆检测,以视频中的一帧为例查看车辆检测结果,检测结果如图 18至图 21所示,其中检测结果中的可信度设置为0.5。

|

| 图 18 车辆真实位置 Fig. 18 Ground truth |

|

| 图 19 可见光图像检测结果 Fig. 19 Visible image detection |

|

| 图 20 热红外图像检测结果 Fig. 20 Thermal infrared image detection |

|

| 图 21 决策融合检测结果 Fig. 21 Decision fusion detection |

其中,编号为1、2、4的车辆在可见光图像中未被检测,编号为6的车辆在热红外图像中未被检测,而通过目标框决策融合,这些编号车辆可以在图 21中被检测,可见决策融合可以提高车辆的检测率,并且在一定程度上提升目标框的位置准确度。

同时,热红外影像可以使车辆检测方法不依赖于光照条件。夜晚情况下的光照条件较差,可见光相机成像能力较差,如图 22所示,其车辆检测难度较高。而热红外相机成像相对来说不受影响,如图 23所示,可以对车辆目标进行检测。

|

| 图 22 可见光图像(夜晚) Fig. 22 Visible image(night) |

|

| 图 23 热红外图像(夜晚) Fig. 23 Thermal infrared image (night) |

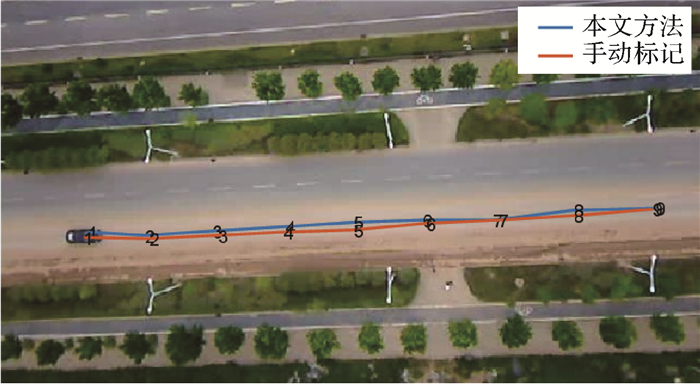

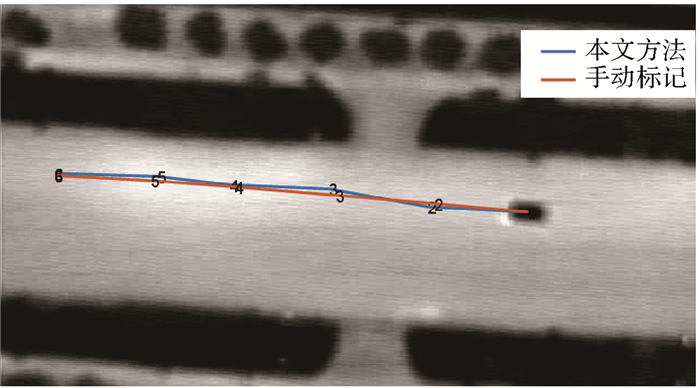

2.4 车辆跟踪

试验中使用卡尔曼滤波对目标车辆跟踪,并在白天和夜晚进行试验,以其中一组为例,运动轨迹如图 24和图 25所示,红色运动轨迹为手动标记的车辆运动轨迹,蓝色运动轨迹为本文方法跟踪的运动轨迹,其中数字表示一定时间间隔的车辆位置。

|

| 图 24 车辆在白天的跟踪情况 Fig. 24 Vehicle tracking during daylight |

|

| 图 25 车辆在夜晚的跟踪情况 Fig. 25 Vehicle tracking during night |

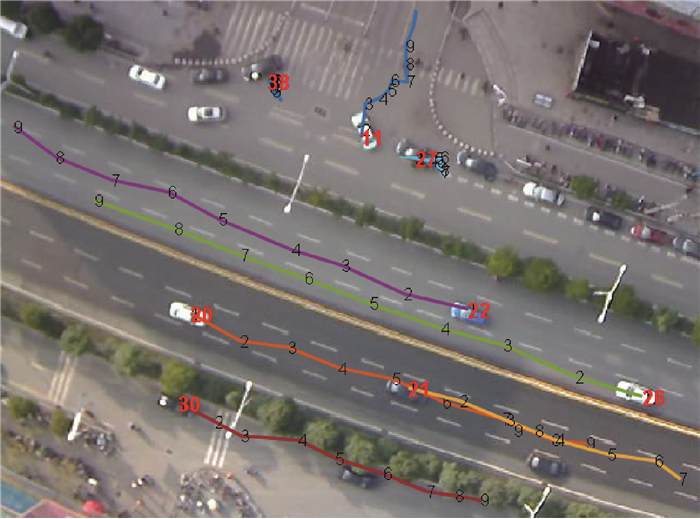

本方法也同样适用于道路车辆较为复杂的情况,跟踪效果如图 26所示,其中红色数字编号代表车辆,运动路径表明编号27和38的车辆静止,编号11车辆转向,其余车辆近似直线行驶。

|

| 图 26 多车辆目标的跟踪情况(显示部分车辆) Fig. 26 Tracking of multiple vehicles (show partial vehicles) |

2.5 车辆速度计算

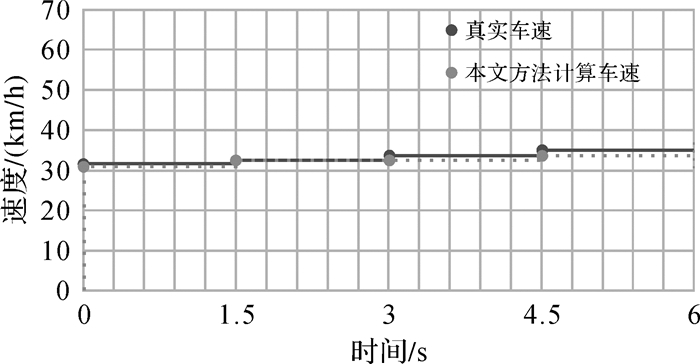

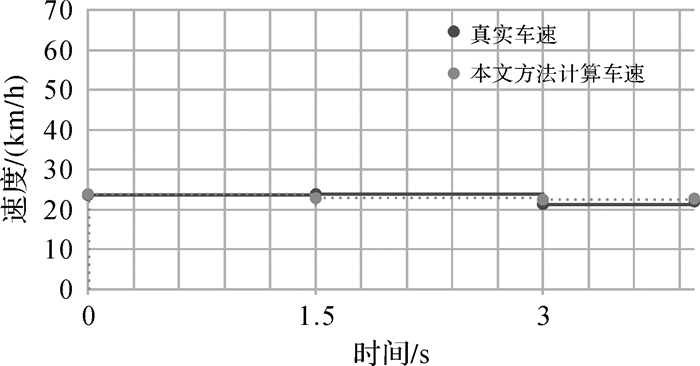

试验中,对同一车辆目标采集了连续的k帧图像,基于车辆跟踪的结果,可通过1.4.3节方法计算其速度v。以图 24和图 25跟踪结果为例,计算图像分辨率(单位:m/像素)分别为0.145和0.134,同时手动标记每帧图像中目标车辆的位置并计算速度,将其作为真实速度值,将本文方法计算的速度值与真实速度值作比较。图 24的速度计算结果如图 27所示,此时车辆仪表盘显示车辆速度为35 km/h。图 25的速度计算结果如图 28所示,此时车辆仪表盘显示车辆速度为25 km/h。

|

| 图 27 车辆计算速度与实际速度比较(白天) Fig. 27 Comparison of vehicle calculated speed and actual speed (daylight) |

|

| 图 28 车辆计算速度与实际速度比较(夜晚) Fig. 28 Comparison of vehicle calculated speed and actual speed (night) |

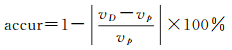

依据车辆仪表盘显示的速度及手动标记车辆位置计算的速度,图 27和图 28表明本文的车辆速度检测方法误差较小。然后进行精度评价,每一小段时间间隔的精度由式(3)计算得知

(3)

(3)

式中,vD表示本文方法计算的车辆速度; vp表示车辆速度的真实值。然后由式(4)计算一组试验的精度

(4)

(4)

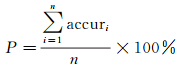

式中,P表示一组试验的精度;n表示一组试验中计算速度的时间段总数;i表示第i段时间;accur由式(3)计算得出。统计车辆速度检测的精度,白天和夜晚分别采用5组数据试验,计算每组的精度P并求均值,白天车辆速度检测的统计情况如表 1所示,夜晚车辆速度检测的统计情况如表 2所示。

| (%) | ||||||||||

| 试验1编号 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 精度P | 93.86 | 95.20 | 92.99 | 94.31 | 92.81 | 93.15 | 93.98 | 93.96 | 93.49 | 93.80 |

| 平均值 | 93.76 | |||||||||

| (%) | ||||||||||

| 试验2编号 | 1 | 2 | 3 | 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 精度P | 93.43 | 93.28 | 94.07 | 94.70 | 93.42 | 93.14 | 93.42 | 93.92 | 93.96 | 93.75 |

| 平均值 | 93.71 | |||||||||

从表 1和表 2可以得知,白天和夜晚车辆速度检测平均精度分别为93.75%和93.71%,可见本文方法能较为准确地检测车辆速度,并且基本满足灵活性、适应性等要求。

3 总结与展望本文依据车辆交通监控的需求,尝试搭建了小型无人机多源数据采集平台,无人机平台为数据的获取增加灵活性。多源数据包括可见光影像和热红外影像,热红外影像的增加使得监测车辆不受光照条件限制。将采集的多源数据实时传输至地面监控客户端,使用深度学习框架YOLO进行车辆目标检测,并将多源数据的检测结果进行决策融合,这在一定程度上提升了检测精度。最后根据检测结果对车辆目标进行跟踪并计算车辆速度。试验结果表明,本文方法检测车辆速度具备有效性,为道路监控管理部门提高了一种易操作、高效率的车辆速度监控方式。试验结果也表现出,在描述车辆运动轨迹时有波动情况,这主要由于车辆检测的定位不够精准,下一步将优化深度学习框架,提高车辆检测位置的精度,进而更为准确地描述车辆运动。

| [1] |

李德仁, 李清泉, 杨必胜, 等.

3S技术与智能交通[J]. 武汉大学学报(信息科学版), 2008, 33(4): 331–336.

LI Deren, LI Qingquan, YANG Bisheng, et al. Techniques of GIS, GPS and RS for the Development of Intelligent Transportation[J]. Geomatics and Information Science of Wuhan University, 2008, 33(4): 331–336. |

| [2] |

王圣男, 郁梅, 蒋刚毅.

智能交通系统中基于视频图像处理的车辆检测与跟踪方法综述[J]. 计算机应用研究, 2005, 22(9): 9–14.

WANG Shengnan, YU Mei, JIANG Gangyi. Review on Vehicle Detection and Tracking Techniques Based on Video Processing in Intelligent Transportation Systems[J]. Application Research of Computers, 2005, 22(9): 9–14. DOI:10.3969/j.issn.1001-3695.2005.09.003 |

| [3] |

刘伟.基于图像处理的车速检测方法研究[D].西安: 长安大学, 2014. LIU Wei. The Vehicle Speed Detection Based on Image Processing in Tracffic Monitor System[D]. Xi'an: Chang'an University, 2014. http://cdmd.cnki.com.cn/Article/CDMD-10710-1014070588.htm |

| [4] | RAD A G, DEHGHANI A, KARIM M R. Vehicle Speed Detection in Video Image Sequences Using CVS Method[J]. International Journal of the Physical Sciences, 2010, 5(17): 2555–2563. |

| [5] |

谭呈祥.

基于计算机视觉的实时车辆运动速度检测算法研究[J]. 现代电子技术, 2016, 39(9): 164–166, 170.

TAN Chengxiang. Study on Real-time Vehicle Motion-speed Detection Algorithm Based on Computer Vision[J]. Modern Electronics Technique, 2016, 39(9): 164–166, 170. |

| [6] | WU Jianping, LLU Zhaobin, LI Jinxiang, et al. An Algorithm for Automatic Vehicle Speed Detection Using Video Camera[C]//Proceedings of the 4th International Conference on Computer Science & Education. Nanning: IEEE, 2009: 193-196. |

| [7] | JACKSON S, MIRANDA-MORENO L, ST-AUBIN P, et al. Flexible, Mobile Video Camera System and Open Source Video Analysis Software for Road Safety and Behavioral Analysis[J]. Transportation Research Record, 2013, 2365: 90–98. DOI:10.3141/2365-12 |

| [8] |

王俊.智能交通信息采集子系统的研究与实现[D].武汉: 华中科技大学, 2006. WANG Jun. The Research and Implementation of ITS Information Collection Subsystem[D]. Wuhan: Huazhong University of Science and Technology, 2006. http://www.wanfangdata.com.cn/details/detail.do?_type=degree&id=D047391 |

| [9] | YANG Tao, PAN Quan, LI Jing, et al. Real-time Multiple Objects Tracking with Occlusion Handling in Dynamic Scenes[C]//Proceedings of 2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Diego, CA: IEEE, 2005(1): 970-975. |

| [10] | BAS E. Road and Traffic Analysis from Video[D]. Istanbul, Turkey: Koc University, 2007. http://citeseerx.ist.psu.edu/viewdoc/summary?doi=10.1.1.468.921 |

| [11] |

袁河洋.基于视频的车辆速度检测方法研究[D].大连: 大连海事大学, 2013. YUAN Heyang. Research of Vehicle Speed Detection Algorithm Based on Video[D]. Dalian: Dalian Maritime University, 2103. http://www.wanfangdata.com.cn/details/detail.do?_type=degree&id=Y2300332 |

| [12] | PURI A, VALAVANIS K P, KONTITSIS M. Statistical Profile Generation for Traffic Monitoring Using Real-time UAV Based Video Data[C]//Proceedings of 2007 Mediterranean Conference on Control & Automation. Athens, Greece: IEEE, 2007: 1-6. |

| [13] | KIM J, KIM Y. Moving Ground Target Tracking in Dense Obstacle Areas Using UAVs[J]. IFAC Proceedings Volumes, 2008, 41(2): 8552–8557. DOI:10.3182/20080706-5-KR-1001.01446 |

| [14] | TURNER D, LUCIEER A, WATSON C. Development of an Unmanned Aerial Vehicle (UAV) for Hyper Resolution Vineyard Mapping Based on Visible, Multispectral, and Thermal Imagery[C]//Proceedings of 34th International Symposium on Remote Sensing of Environment. Sydney, Australia: [s.n.], 2011: 4. |

| [15] | KAANICHE K, CHAMPION B, PEGARD C, et al. A Vision Algorithm for Dynamic Detection of Moving Vehicles with a UAV[C]//Proceedings of the 2005 IEEE International Conference on Robotics and Automation. Barcelona: IEEE, 2005: 1878-1883. |

| [16] | GASZCZAK A, BRECKON T P, HAN Jiwan. Real-time People and Vehicle Detection from UAV Imagery[C]//Proceedings Volume 7878, Intelligent Robots and Computer Vision XXVⅢ: Algorithms and Techniques. San Francisco Airport, CA: SPIE, 2011. |

| [17] | GLEASON J, NEFIAN A V, BOUYSSOUNOUSSE X, et al. Vehicle Detection from Aerial Imagery[C]//Proceedings of 2011 IEEE International Conference on Robotics and Automation. Shanghai: IEEE, 2011: 2065-2070. |

| [18] | LIU Wei, ANGUELOV D, ERHAN D, et al. SSD: Single Shot Multibox Detector[C]//Proceedings of the 14th European Conference on Computer Vision. Amsterdam: Springer, 2016: 21-37. |

| [19] | DAEOUD A, ALAM M S, BAL A, et al. Target Tracking in Infrared Imagery Using Weighted Composite Reference Function-based Decision Fusion[J]. IEEE Transactions on Image Processing, 2006, 15(2): 404–410. DOI:10.1109/TIP.2005.860626 |

| [20] | BAY H, TUYTELAARS T, VAN GOOL L. SURF:Speeded up Robust Features[M]. Berlin, Heidelberg: Springer, 2006: 404-417. |

| [21] | PINTO B, ANURENJAN P R. Video Stabilization Using Speeded up Robust Features[C]//Proceedings of 2011 International Conference on Communications and Signal Processing.Calicut, India: IEEE, 2011: 527-531. |

| [22] | RISTIC B, ARULAMPALAM S, GORDON N. Beyond the Kalman filter:Particle Filters for Tracking Applications[M]. . |

| [23] | LIPTON A J, FUJIYOSHI H, PATIL R S. Moving Target Classification and Tracking from Real-time Video[C]//Proceedings 4th IEEE Workshop on Applications of Computer Vision. Princeton, NJ: IEEE, 1998: 8-14. |