2. 武汉大学时空数据智能获取技术与应用教育部工程研究中心, 湖北 武汉 430079

2. Engineering Research Center for Spatio-temporal Data Smart Acquisition and Application, Ministry of Education of China, Wuhan University, Wuhan 430079, China

车载移动测量系统实现了地基侧面视角激光点云与影像数据的覆盖,可高效采集被测环境中高分辨率立面激光雷达(light detection and ranging, LiDAR)点云与全景影像等数据,是一种新型的摄影测量与遥感手段。车载移动测量系统(mobile mapping system,MMS)提供的高分辨率LiDAR点云、全景影像等多种对地观测数据,可应用于条带地形测图、高速公路资产管理、影像城市构建等领域。多源数据融合是车载MMS应用发展的趋势。车载MMS多源数据配准则是融合应用需要解决的首要问题。

全景影像与车载激光点云是典型的车载MMS测绘数据,其配准方法主要分为4类:

(1) 基于多传感器标定的半自动方法,即直接使用位置与姿态系统(position and orientation system, POS)输出方位元素值整体补偿传感器平台标定参数的方法进行车载激光点云和影像的配准[1-2],该类方法通常需要使用标定场实现标定。研究表明由于配准误差来源的多样性与硬件同步与几何标定的局限性,使用硬件同步与几何检校的方法进行数据配准后,配准差依然存在[3-6]。同时,由于不同时段GPS信号质量与IMU漂移各不相同,该类方法亦不能解决此类配准误差。

(2) 基于几何配准基元匹配的2D(全景影像)-3D(激光点云)自动方法。该类方法在LiDAR点云与影像中提取共轭配准基元匹配对,通常利用已有的建筑物线框模型作为先验知识,通过线框轮廓与激光点云轮廓的相似性,进行两者间的配准[3, 7-8]。如何稳健实现共轭配准基元的自动提取与匹配是学术界尚未完全解决的研究问题。

(3) 基于互信息最大化匹配的2D-3D自动方法。该类方法通常将点云数据依据全景影像成像模型成像,计算所得的点云强度/深度影像与全景影像的互信息测度[9],使用Nelder-Mead方法[10]求解最高互信息解,实现配准[4],但需要预先对激光点云强度进行标定。

(4) 基于多视立体匹配点云与激光点云3D(影像点云)-3D(激光点云)的配准方法[5]。该类方法利用POS系统的输出值作为初始配准,使用非刚性最近点迭代方法实现二者的配准,但是迭代最邻近点(iterative closet point,ICP)方法对初始转换参数的近似值要求较高[11],在POS提供的初始值偏差较大的情况下,难以保证该方法的收敛,算法适应性有限。

为解决序列全景影像与激光点云的稳健配准问题,本文研究了一种2D(全景影像)-3D(激光点云)几何基元对配准与3D(影像点云)-3D(激光点云)配准相结合的自动化配准方法:首先使用提取到的配准基元对进行2D-3D粗配准,进而使用全景影像虚拟影像生成的多视立体匹配密集影像点云与激光点云进行3D-3D精化配准结果,消除配准基元提取与匹配误差对配准结果的影响,从而保证算法稳健高精度收敛。

1 配准方法本文提出的车载MMS激光点云与序列全景影像的自动配准流程如图 1所示。该方法主要分为配准基元提取、粗配准、精配准3个步骤:

|

| 图 1 车载MMS激光点云与序列全景影像自动配准方法 Fig. 1 Flow chart of automatic registration of vehicles-borne mobile mapping system panoramic images sequence and laser point cloud |

(1) 配准基元提取。选取天际线(建筑物上边线)作为配准基元,在LiDAR点云中采用层次化城市场景目标提取方法[12]提取建筑物立面并规则化生成点云天际线矢量,在序列全景影像中,通过虚拟成像方法,将球面展开成像模型的全景影像转换为框幅式影像,并在该虚拟影像上结合GrabCut算法[13]与弧到点距离累计(chord-to-point distance accumulation,CPDA)角点检测算法[14]生成天际线矢量。

(2) 基于配准基元图匹配的2D-3D粗配准。依据提取到的天际线矢量,构建配准基元图,并通过配准基元图编辑距离最小化准则进行匹配,组成共轭配准基元对,自生成的共轭配准基元对,解算2D-3D粗配准模型,通过投票方法,获得摄影和测量坐标系与LiDAR参考坐标系之间的初始转换关系。

(3) 基于迭代最邻近点方法的3D-3D精确配准。自序列全景影像虚拟成像生成序列虚拟影像,使用运动结构恢复(structure from motion,SfM)方法恢复序列虚拟影像在摄影测量坐标系中的外方位元素,并通过多视立体匹配的方法由序列影像生成多视立体匹配(multi-view stereo,MVS)影像密集点云,将粗配准解算获得空间坐标转换关系作为初始值,使用ICP算法变种,实现全景影像MVS密集点云与LiDAR点云之间的最优配准,获得序列影像的精确配准参数。

1.1 配准基元提取基于特征的地基视角影像与激光点云数据配准方法中,多采用线段[15-17]、建筑物外框[18]、天际线[19]以及Sift描述子[20-21]作为特征基元。城市场景中有丰富的建筑物立面,且其提取方法有大量的成熟研究[22]。天际线指建筑物顶部边线,建筑物顶部边线与天空相接,反差较大,通常由于位置较高,不易被环境地物遮挡,出现频率与建筑物立面出现频率一致,较为适合作为配准基元特征。因此,本文采用天际线作为LiDAR点云与全景影像之间的配准基元。

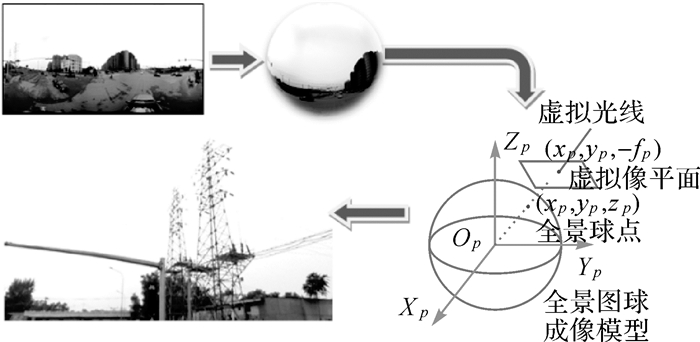

车载LiDAR点云数据中天际线提取,等价于建筑物立面的提取。本文采用层次化城市场景目标提取方法[12],进行车载LiDAR点云数据中建筑物立面的提取。对于提取到的建筑物立面点云块,使用RMBR算法[23]提取其轮廓并进行规则化,将提取到的外部多边形作为候选配准基元。全景影像成像模型为球状(见图 2)。球面为不可展开平面,在进行球面展开生成二维光谱信息存储矩阵(全景影像)的过程中,产生了较大的变形。全景影像中的地物几何结构受此影响存在较大的变形扭曲。本文提出一种全景影像虚拟成像天际线提取方法,该方法首先使用虚拟成像方法将全景影像转化为框幅式虚拟影像,继而进行直方图阈值分割确定大致天际线位置,继而使用GrabCut分割方法[13]实现天际线位置的优化,最后利用CPDA角点检测算法生成天际线矢量。令物方某点在虚拟成像平面上的像空间坐标系坐标为[xv, yv, -f]T,在全景球模型上的成像点为[xp, yp, zp]T,对应展开模型上的像素位置为(r, c),则全景球上的像点与虚拟成像像点之间的共线关系可以表示为式(1)

|

| 图 2 全景影像虚拟成像方法 Fig. 2 Virtual imaging of panoramic image |

(1)

(1)

式中,h、w分别为全景影像高与宽;r、c分别为当前像素在全景影像上的行列号。结合预定义的虚拟相机内方位元素、像素大小、虚拟面阵大小,通过对式(1)的反解,即可得出任意焦距、方位的普通镜头虚拟成像影像。天空由于反射强度较高,与图像主体的城市环境有较大的灰度差异,且与建筑物相接处有明显的边缘特征(图 3(a)、(b))。首先,对图像直方图进行统计,选择灰度中间值(128)与灰度高峰值的中间值作为分割阈值(图 3(c)); 然后,使用该分割阈值对图像进行分割,将高于阈值的区域作为候选天空像素区域,低于阈值的部分作为候选地物区域(图 3(d))。基于直方图阈值分割即可确定天际线初始位置,继而使用直方图阈值分割天际线初始位置作为GrabCut算法[13]的初始分割。优化地物前景与天空背景的分割结果,提高天际线提取质量具体步骤如下:①依据直方图阈值分割结果与天空背景位于图像上部且连续分布的先验知识,指定GrabCut初始分割,将图像定义为如图 3(e)的3个区域即,天空区域(顶部)、可能是天空区域(中部)可能是地物区域(底部);②将此初始分割作代入到GrabCut算法中进行迭代求解直到算法收敛(图 3(f));③依据分割获得的二值影像,进行轮廓提取,获得天际线。然后采用CPDA方法[14, 24]实现轮廓线上的角点检测,生成天际线矢量数据(图 3(g))。在全景影像与激光点云中提取到的天际线矢量将用于构建配准基元图,继而参入2D全景影像-3D激光点云粗配准模型参数的解算。

|

| 图 3 全景影像虚拟影像几何配准基元(天际线)提取 Fig. 3 Geometric primitive (skyline) extraction on virtual images generated by panoramic images |

1.2 基于配准基元图匹配的2D-3D粗配准

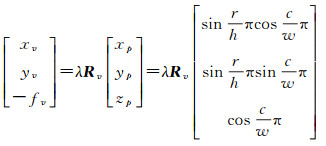

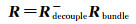

采用2D-3D共线配准模型描述全景影像与LiDAR点云之间的几何关系。令虚拟影像上的天际线角点配准基元的像点为[xv, yv, -f]T,其对应的全景影像的像点坐标为[xp, yp, zp]T,对应的建筑物角点在LiDAR数据中的坐标为(xw, yw, zw),则两角点之间的共线关系可表述为式(2)

(2)

(2)

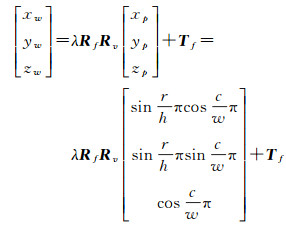

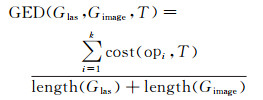

式中,Rv为虚拟成像过程中的相机旋转矩阵;Rf为旋转平移解耦计算中的旋转矩阵;Tf为相机平移参数,λ为比例参数;h、w分别为全景影像高与宽;r、c分别为当前像素在全景影像上的行列号。将全景影像直接地理定向数据经导航坐标系到摄影测量坐标系转换得到全景影像外方位元素(Rf, Tf)初始值[25]。使用该值将提取到的LiDAR天际线角点反投影到全景影像面上,继而提出一种最小图像编辑距离(graph edit distance,GED)图匹配算法,实现配准基元匹配。对于车载MMS街景数据,选择提取到的n个配准基元角点组成图节点集E。选取图顶点集合E中的任意3个顶点组合为三角形,作为图G的生成核,图的边连接规则定义为:对于核三角形顶点,直接连接构成完全图;对于非核三角形顶点,则计算该顶点到核三角形3个顶点的距离,将最短长度的边作为连接边。使用GED度量影像配准基元图Gimage=(Eimage, Vimage)与激光点云配准基元图Glas=(Elas, Vlas)在局部核三角形匹配对定义的图转换下的全局图边相似度,即将最优图匹配的问题转化为最小图编辑距离查找问题(图 4)。Gimage、Glas与之间的GED定义为式(3)

|

| 图 4 基于图匹配的几何配准基元对生成方法 Fig. 4 Conjugate geometric primitives generated by GED minimization |

(3)

(3)

式中,cost(op, T)为将Gimage经过图编辑之后完全匹配Glas所需要的K步操作(添加、删除、替换)所对应的图编辑代价函数,本文设置该代价函数为旋转图边差;length(·)为图边长度累加函数;T为局部核三角形匹配对定义的图转换。首先,使用KD树[26]对所有的核三角形内角值三维点坐标数据构建索引,提高匹配效率;其次,遍历核三角形匹配集计算各个核三角形匹配对应图转换的GED,并进行排序,将最小GED对应的T作为最佳匹配,继而采用旋转平移解耦合计算方法[11],计算基于2D-3D几何特征对的粗配准参数。

由于几何配准基元提取与匹配存在误差,导致粗配准结果精度与稳健性受限。为解决该问题,本文将粗配准空间坐标转换关系作为初始值,使用ICP算法变种,最优配准全景影像密集点云与LiDAR点云,间接获得序列影像的精确配准参数,实现数据稳健高精度配准。

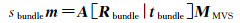

1.3 基于迭代最邻近点方法的3D-3D精确配准将全景影像密集点云构建的问题转换为传统短焦针孔相机成像数据的密集点云构建的问题。采用增量光束法平差SfM算法实现虚拟相机外参数标定[27],然后使用Daisy算法[28]生成MVS影像点云,实现物方的重构。继而最小化MVS点云与LiDAR点云之间的距离实现配准参数精化,其配准几何模型可表示为式(4)

(4)

(4)

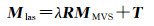

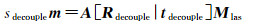

精配准包括精配准模型初值稳健估计与迭代最邻近点模型参数优化。令虚拟影像上一像点为m,其在MVS摄影测量坐标系CMVS中对应点为MMVS,在激光点云参考系Cw中对应点为Mlas则其之间的共线性关系可表达为式(5)和式(6)

(5)

(5)

(6)

(6)

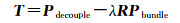

式中,[Rbundle|tbundle],[Rdecouple|tdecouple]分别为SfM与粗配准过程中计算获得的影像外参数矩阵,A为已知相机内参数矩阵。联立式(5)和式(6)可得式(7)

(7)

(7)

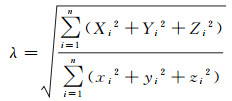

令Pdecouple(Xi, Yi, Zi)t,Pbundle(xi, yi, zi)t,为相机在Cw与CMVS中的坐标重心化后的相机位子。则其比例与平移参数可通过式(8)、式(9)计算

(8)

(8)

(9)

(9)

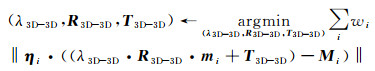

对于多张配准影像,采用投票聚类的方法实现参数的稳健估计[29],实现转换参数的解算。采用刚体空间相似变换模型作为MVS与LiDAR点云之间的配准模型。使用点到面距离差[30]作为点对误差,则误差方程可表示为式(10)

(10)

(10)

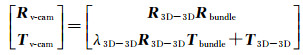

式中,mi、Mi分别为MVS与LiDAR点;wi为点对权;ηi为Mi点法向量;(λ3D-3D, R3D-3D, T3D-3D)表示需要求解的最小MVS与LiDAR点云点到面距离的空间相似变换。将粗配准解算获得的转换参数作为ICP算法初始值,对式(10)进行迭代解算,避免由于POS数据质量、几何基元配准提取与匹配错误导致ICP迭代错误收敛。为避免MVS点云外点对ICP算法的影响,采用相对运动阈值算法[31]对限制点对搜索,保证稳健性收敛。记最优摄影测量与LiDAR参考系之间的坐标转换为(λ3D-3D, R3D-3D, T3D-3D),则修正后的虚拟影像外方位元素(Rv-cam, Tv-cam)可表示为式(11)

(11)

(11)

全景影像在虚拟成像过程中与虚拟影像之间存在已知的空间旋转,即虚拟成像旋转矩阵Rv,虚拟影像与全景影像共成像中心,则精化后的全景影像外方位元素(Rpano, Tpano)可表示为式(12)

(12)

(12)

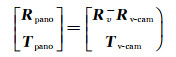

为验证本文方法的有效性,采用两种车载MMS系统采集的两组LiDAR点云与序列全景影像数据集对提出的车载MMS点云与全景影像自动配准方法进行验证。LiDAR点密度、全景影像分辨率等相关数据参数见表 1。数据集1与数据集2中场景分别为典型城区道路与居民区,均为车载MMS数据采集中常见的场景,具有较好的代表性。数据集1、2中包含的激光点云数据与样例全景影像见图 5。

|

| 图 5 试验数据集 Fig. 5 Experiment datasets |

| 数据集1 | 数据集2 | |

| 激光点平均密度/(个/m2) | 138 | 43 |

| 激光点数/个 | 2 620 376 | 6 091 293 |

| 全景影像分辨率/像素 | 4096×2048 | 4096×2048 |

| 全景影像数量/张 | 188 | 121 |

| 激光点数 | 6 506 721 | 8 893 549 |

| 测区类型 | 城市道路 | 居民区 |

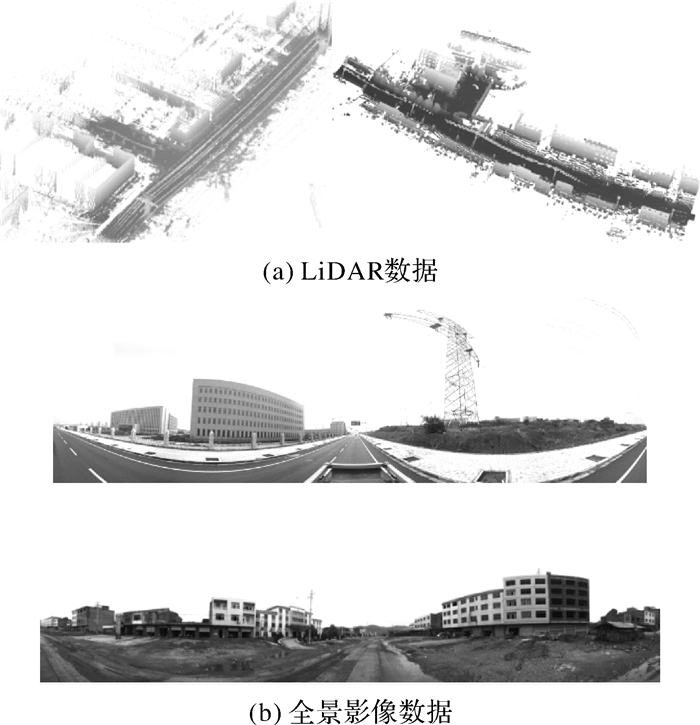

2.1 配准结果

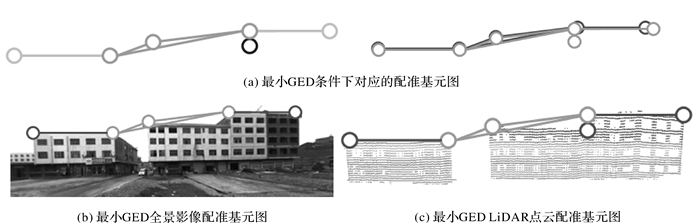

将全景影像配准后成像中心位置一定范围内(50 m)的激光点云按全景影像的球状成像模型,反投影到全景影像上,形成叠加点云显示的全景影像,从而定性判断数据配准精度。图 6为一组数据集1、2全景影像叠合激光点云显示图,其中图 6(a)、(b)各行分别为原始全景影像,使用直接地理定向数据、粗配准影像外方位元素、精配准影像外方位元素叠加点云数据配准结果。由于配准基元提取过程中的不完整以及定位不精确等因素,导致完成粗配准后配准误差依然存在(图 6(a)、(b)第3行),但相较使用直接地理定向数据进行配准的结果(图 6(a)、(b)第2行),精度有所提升。

|

| 图 6 由粗到精的激光点云和全景影像自动配准 Fig. 6 Coarse to fine registration of panoramic images and laser point cloud |

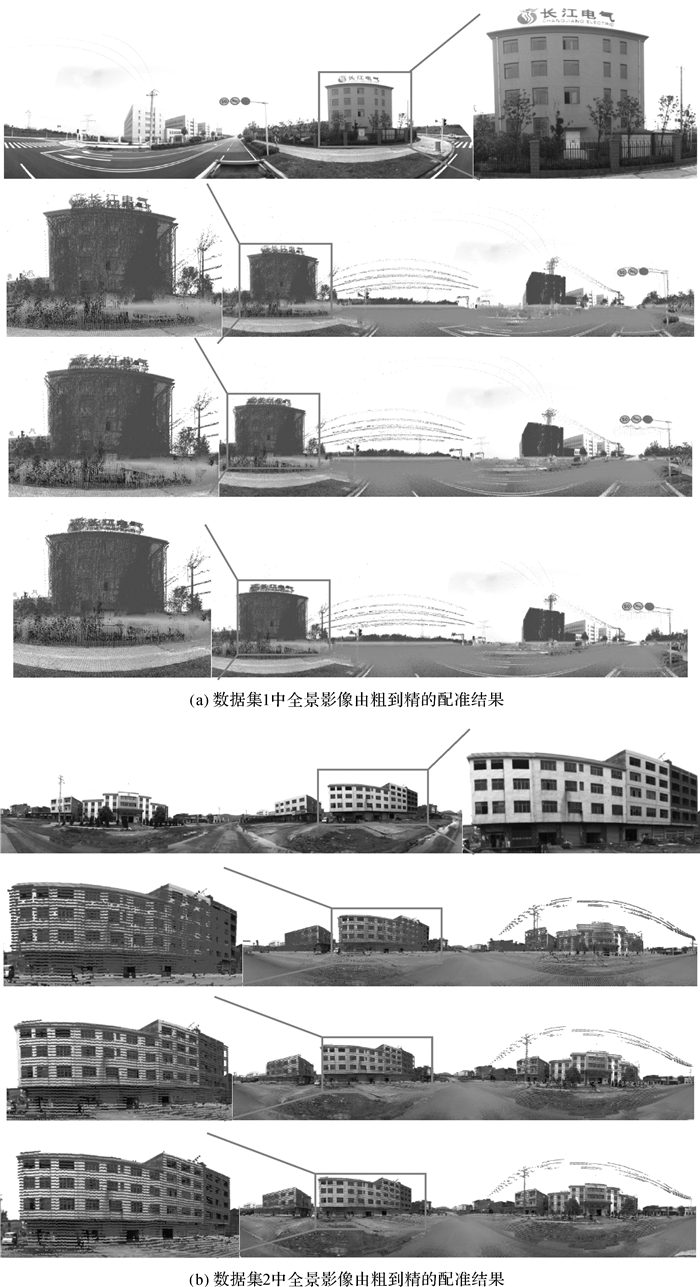

2.2 配准误差评定

为定量分析本章提出配准算法配准数据集1、2全景影像与LiDAR点云配准获得的配准结果精度,人工在配准后的全景影像与激光全景影像上选择匹配对,并计算之间的像素差,作为配准精度指标。激光全景影像即是指以当前全景影像位置为成像中心,切割出该成像中心一定范围(50 m)内的点云投影到全景球状成像模型并展开为二维平面影像。在数据集1、2中各自随机抽取20张配准后的全景影像,生成每一张全景影像对应的激光全景影像。在每对全景与激光全景影像上人工选取10个同名点,计算同名点之间的像素差的绝对值,并取标记点对误差平均值作为该帧全景影像配准精度测度。表 2为数据集1、2中随机抽样影像图人工标记点对误差统计表。由表可知,在初始配准误差较大的条件下,经由粗到精的配准,配准误差逐渐减小,配准后平均误差在1.5像素左右。图 7为数据集1、2配准过程中,抽样的20张精度评定影像的配准误差柱状图,可见,使用两步法配准方法进行配准后,配准误差大幅下降,并且帧误差标准差亦达到较低水平,说明配准结果精度较高,且具有较好的精度一致性。

|

| 图 7 随机抽样影像配准精度柱状图 Fig. 7 Residual projection error distribution of the random labeled points |

| 像素 | |||||||||||

| 最大误差 | 最小误差 | 平均误差 | 误差标准差 | ||||||||

| 数据集1 | 数据集2 | 数据集1 | 数据集2 | 数据集1 | 数据集2 | 数据集1 | 数据集2 | ||||

| 数据集 | 1 | 2 | 1 | 2 | 1 | 2 | 1 | 2 | |||

| 直接地理参考 | 44.0 | 45.3 | 20.0 | 22.3 | 31.43 | 35.26 | 7.42 | 7.17 | |||

| 粗配准 | 9.0 | 15.0 | 2.7 | 3.9 | 5.91 | 8.98 | 1.92 | 3.19 | |||

| 精配准 | 2.5 | 2.3 | 0.1 | 0.5 | 1.22 | 1.56 | 0.64 | 0.53 | |||

LiDAR点云数据与序列全景影像数据配准完成后,对LiDAR点云数据与序列全景影像进行融合。图 8为LiDAR点云数据与序列全景影像数据配准完成后生成的彩色激光点云,由其房屋边缘细节可知,数据配准精度良好。

|

| 图 8 建筑物立面彩色点云细节 Fig. 8 Color point cloud details on the facade of buildings |

3 结论

本文提出一种车载移动测量系统(MMS)激光点云与序列全景影像自动配准方法。该方法首先使用几何基元对实现2D全景影像到3D点云的粗配准,继而通过最小化密集匹配全景影像点云与激光点云3D-3D点间距实现精配准。该方法弥补了3D-3D配准方法需要较为准确初始值方能收敛的缺陷,同时打破了几何基元对配准方法对基元正确提取与匹配的依赖。经定性与定量配准精度分析,本文提出的自动配准方法可以实现车载MMS激光点云与序列全景影像的像素级自动配准,配准成果可应用于车载MMS激光点云/影像数据融合应用。由于本文方法将建筑物上边线即天际线作为配准基元,在高速公路等无建筑物环境区域不适用,下一步研究将拓展几何基元提取与匹配方法,致力于研制一种全地形环境适用的车载MMS点云与全景影像配准方法。

| [1] |

侯艳芳, 叶泽田, 杨勇.

基于POS数据的车载面阵CCD影像与激光点云融合处理研究[J]. 遥感信息, 2011(4): 76–79.

HOU Yanfang, YE Zetian, YANG Yong. Research on Integrated Processing of Vehicle-borne Array CCD Images and Laser Point Cloud Based on POS Data[J]. Remote Sensing Information, 2011(4): 76–79. |

| [2] |

吴胜浩, 钟若飞.

基于移动平台的激光点云与数字影像融合方法[J]. 首都师范大学学报(自然科学版), 2011, 32(4): 57–61.

WU Shenghao, ZHONG Ruofei. The 3D Visualization's Approach Based on Vehicle-borne Laser Scanning[J]. Journal of Capital Normal University (Natural Science Edition), 2011, 32(4): 57–61. |

| [3] | PYLVÄNÄINEN T, ROIMELA K, VEDANTHAM R, et al. Automatic Alignment and Multi-View Segmentation of Street View Data Using 3D Shape Priors[C]//Proceedings of the 5th International Symposium on 3D Data Processing, Visualization and Transmission (3DPVT). Paris, France:Espace Saint Martin, 2010:738-739. |

| [4] | WANG Ruisheng, FERRIE F P, MACFARLANE J. Automatic Registration of Mobile LiDAR and Spherical Panoramas[C]//Proceedings of 2012 IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshops (CVPRW). Providence, RI:IEEE, 2012:33-40. |

| [5] | SWART A, BROERE J, VELTKAMP R, et al. Refined Non-rigid Registration of A Panoramic Image Sequence to a LiDAR Point Cloud[M]//STILLA U, ROTTENSTEINER F, MAYER H, et al. Photogrammetric Image Analysis. Berlin:Springer, 2011:73-84. |

| [6] | CHEN C, YANG B, DENG C. Registration of the Panoramic Image Sequence onto Mobile Laser Scanning Point Cloud Using Linear Features[C]//The International Symposium on Mobile Mapping Technology (MMT2013). Taiwan, China:2013:1-9. |

| [7] | TANEJA A, BALLAN L, POLLEFEYS M. Geometric Change Detection in Urban Environments Using Images[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(11): 2193–2206. DOI:10.1109/TPAMI.2015.2404834 |

| [8] | HOFMANN S, EGGERT D, BRENNER C. Skyline Matching Based Camera Orientation from Images and Mobile Mapping Point Clouds[J]. ISPRS Annals of Photogrammetry, Remote Sensing and Spatial Information Sciences, 2014, Ⅱ-5: 181–188. |

| [9] | VIOLA P, WELLS Ⅲ W M. Alignment by Maximization of Mutual Information[J]. International Journal of Computer Vision, 1997, 24(2): 137–154. DOI:10.1023/A:1007958904918 |

| [10] | NELDER J A, MEAD R. A Simplex Method for Function Minimization[J]. The Computer Journal, 1965, 7(4): 308–313. DOI:10.1093/comjnl/7.4.308 |

| [11] | RUSINKIEWICZ S, LEVOY M. Efficient Variants of the ICP Algorithm[C]//Proceedings of the 3rd International Conference on 3-D Digital Imaging and Modeling. Quebec City, Canada:IEEE, 2001:145-152. |

| [12] | YANG Bisheng, DONG Zhen, ZHAO Gang, et al. Hierarchical Extraction of Urban Objects from Mobile Laser Scanning Data[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2015, 99: 45–57. DOI:10.1016/j.isprsjprs.2014.10.005 |

| [13] | ROTHER C, KOLMOGOROV V, BLAKE A. "GrabCut":Interactive Foreground Extraction Using Iterated Graph Cuts[C]//Proceedings of ACM SIGGRAPH 2004. New York, NY:ACM, 2004:309-314. |

| [14] | AWRANGJEB M, LU Guojun, FRASER C S. Performance Comparisons of Contour-based Corner Detectors[J]. IEEE Transactions on Image Processing, 2012, 21(9): 4167–4179. DOI:10.1109/TIP.2012.2200493 |

| [15] | CHRISTY S, HORAUD R. Iterative Pose Computation from Line Correspondences[J]. Computer Vision and Image Understanding, 1999, 73(1): 137–144. DOI:10.1006/cviu.1998.0717 |

| [16] |

邓非, 张祖勋, 张剑清.

利用激光扫描和数码相机进行古建筑三维重建研究[J]. 测绘科学, 2007, 32(2): 29–30.

DENG Fei, ZHANG Zuxun, ZHANG Jianqing. 3D Reconstruction of Old Architecture by Laser Scanner and Digital Camera[J]. Science of Surveying and Mapping, 2007, 32(2): 29–30. |

| [17] |

王晏民, 胡春梅.

一种地面激光雷达点云与纹理影像稳健配准方法[J]. 测绘学报, 2012, 41(2): 266–272.

WANG Yanmin, HU Chunmei. A Robust Registration Method for Terrestrial LiDAR Point Clouds and Texture Image[J]. Acta Geodaetica et Cartographica Sinica, 2012, 41(2): 266–272. |

| [18] | LIU L, STAMOS I. Automatic 3D to 2D Registration for the Photorealistic Rendering of Urban Scenes[C]//Proceedings of IEEE Computer Society Conference on Computer Vision and Pattern Recognition. San Diego:IEEE, 2005:137-143. |

| [19] | RAMALINGAM S, BOUAZIZ S, STURM P, et al. SKYLINE2GPS:Localization in Urban Canyons Using Omni-skylines[C]//Proceedings of 2010 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Taipei, Taiwan, China:IEEE, 2010:3816-3823. |

| [20] | SATTLER T, LEIBE B, KOBBELT L. Fast Image-based Localization Using Direct 2D-to-3D Matching[C]//Proceedings of 2011 IEEE International Conference on Computer Vision (ICCV). Barcelona, Spain:IEEE, 2011:667-674. |

| [21] | KNOPP J, SIVIC J, PAJDLA T. Avoiding Confusing Features in Place Recognition[M]//DANⅡLIDIS K, MARAGOS P, PARAGIOS N. Computer Vision-ECCV 2010. Berlin:Springer, 2010:748-761. |

| [22] | LI Zhuqiang, ZHANG Liqiang, ZHONG Ruofei, et al. Classification of Urban Point Clouds:A Robust Supervised Approach with Automatically Generating Training Data[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2017, 10(3): 1207–1220. DOI:10.1109/JSTARS.2016.2628399 |

| [23] | KWAK E. Automatic 3D Building Model Generation by Integrating LiDAR and Aerial Images Using a Hybrid Approach[D]. Calgary:University of Calgary, 2013. |

| [24] | AWRANGJEB M, LU Guojun, FRASER C S, et al. A Fast Corner Detector Based on the Chord-to-point Distance Accumulation Technique[C]//Proceedings of 2009 Digital Image Computing:Techniques and Applications. Melbourne, VIC, Australia:IEEE, 2009:519-525. |

| [25] |

袁修孝, 张雪萍, 付建红.

高斯-克吕格投影坐标系下POS角元素的转换方法[J]. 测绘学报, 2011, 40(3): 338–344.

YUAN Xiuxiao, ZHANG Xueping, FU Jianhong. Transformation of Angular Elements Obtained Via A Position and Orientation System in Gauss-Kruger Projection Coordinate System[J]. Acta Geodaetica et Cartographica Sinica, 2011, 40(3): 338–344. |

| [26] | ZHOU Kun, HOU Qinming, WANG Rui, et al. Real-Time KD-Tree Construction on Graphics Hardware[J]. ACM Transactions on Graphics (TOG), 2008, 27(5): 126. |

| [27] | SNAVELY N, SEITZ S M, SZELISKI R. Modeling the World from Internet Photo Collections[J]. International Journal of Computer Vision, 2008, 80(2): 189–210. DOI:10.1007/s11263-007-0107-3 |

| [28] | TOLA E, LEPETIT V, FUA P. DAISY:An Efficient Dense Descriptor Applied to Wide-baseline Stereo[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 32(5): 815–830. DOI:10.1109/TPAMI.2009.77 |

| [29] | YANG Bisheng, CHEN Chi. Automatic Registration of UAV-borne Sequent Images and LiDAR Data[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2015, 101: 262–274. DOI:10.1016/j.isprsjprs.2014.12.025 |

| [30] | CHEN Y, MEDIONI G. Object Modeling by Registration of Multiple Range Images[C]//Proceedings of 1991 IEEE International Conference on Robotics and Automation. Sacramento, CA:IEEE, 1991:2724-2729. |

| [31] | POMERLEAU F, COLAS F, FERLAND F, et al. Relative Motion Threshold for Rejection in ICP Registration[M]//HOWARD A, IAGNEMMA K, KELLY A. Field and Service Robotics. Berlin:Springer, 2010:229-238. |