2. 武汉大学测绘遥感信息工程国家重点实验室, 湖北 武汉 430079;

3. 武汉大学遥感信息工程学院, 湖北 武汉 430079;

4. 珠海欧比特控制工程股份有限公司, 广东 珠海 519080

2. State Key Laboratory of Information Engineering in Surveying, Mapping and Remote Sensing, Wuhan University, Wuhan 430079, China;

3. School of Remote Sensing and Information Engineering, Wuhan University, Wuhan 430079, China;

4. Zhuhai Orbita Control Engineering Co., Ltd., Zhuhai, 519080, China

2013年底,美国Skybox Imaging公司发射了全球首颗能够拍摄高清卫星视频的小卫星SkySat-1[1],开启了全新的动态对地观测模式;长光卫星技术有限公司于2015年10月发射我国首颗商用卫星“吉林一号”。“吉林一号”是一种小型遥感卫星,其搭载的高分辨率视频相机,在国内首次实现了从外太空中拍摄高清全彩色视频[2]。除了经典光学遥感卫星影像包含的静态信息外,卫星视频还可以获取一定时空范围内的实时动态信息,使得遥感观测有更广阔的应用前景。在卫星视频数据处理中,运动目标跟踪是动态信息提取的重要一步,同时也是后续处理和应用的基础和前提,如超分重建、三维重建、智能监控、车速估计[3-4]等。因此实现卫星视频目标的准确、抗差跟踪显得尤为重要。

在机器视觉中,目标跟踪可以分为两大类:生成式和判别式[5]。生成式方法利用生成的特征描述模板,搜索相似性最高的候选目标,该方法主要关注目标本身,在目标剧烈变化和隐藏时容易产生漂移。经典方法有密度估计法[6]、稀疏编码[7]、相关滤波[8]等;判别式方法不但关注目标本身,还关注背景特征,一般通过训练的分类器进行前、背景的判别跟踪,因此该方法又称为基于检测的跟踪(tracking by detection)。判别式方法跟踪效果较好,但由于需要分类器训练、更新和前、背景判别,所以耗时较大。经典方法有TLD[9]、多实例学习[10]、压缩感知法[11]和时空关联法[12]等。无论哪种方法,其本质都是利用样本训练、灰度统计、滤波、压缩降维、概率估计、特征融合等方法提取合适的视觉特征建立目标跟踪的描述模板,然后根据特征描述信息寻找与目标模板匹配相似度最高的ROI区域,实现目标跟踪[13-16]。在一般地面或低空条件下,经典的方法取得了很好的跟踪结果,其抗差跟踪的关键在于特征的合理选择和描述,有赖于目标尺寸较大、对比度高、特征纹理丰富,其目标跟踪模板具有较高的排他性和可辨识性,有利于跟踪结果的准确定位。

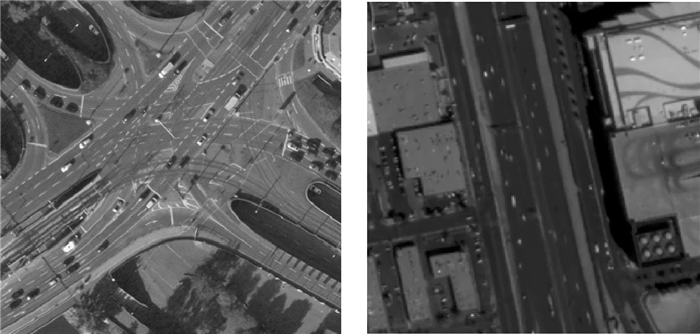

但是在卫星视频条件下,与一般地面视频和航空视频相比,目标跟踪主要存在3个问题:① 影像宽幅大、分辨率低、画面对比度和清晰度低;② 运动目标大部分为点目标,尺寸小、特征和纹理稀少;③ 目标数量较多,目标与目标、目标与背景之间的可区分性差,彼此相似性较高、相互干扰严重。这3个卫星视频特有特点使得特征选取困难,特征描述不显著,目标模板的排他性和可辨识性不高。如图 1所示,航空视频下,汽车的顶部天窗、前后玻璃、甚至是后视镜都有可能作为特征提取和识别出来,便于目标跟踪时的特征描述;而卫星视频下,汽车是由少量亮度相近的像素点组成,内部几乎无纹理和特征可提取,难以进行特征描述和关联,点目标跟踪容易产生漂移或丢失的结果。

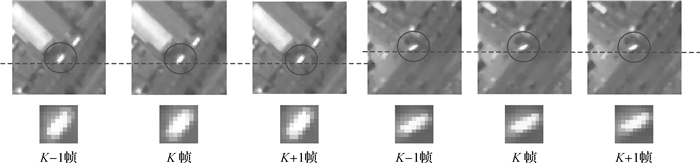

经典的点跟踪算法是文献[18]提出的LK光流法。方法的本质其实是一种灰度相似性模板匹配,在匹配策略的约束下,利用方程求解的方式代替窗口搜索定位。在相邻帧之间,利用邻域像素点集的绝对误差和(SAD)最小的原则建立光流方程,并采用最小二乘法求解点的运动矢量,实现点跟踪[19]。在此基础上,国内外出现了许多优秀的点跟踪方法,这些方法数学建模的基本准则和依据都是视频相邻帧之间具有的3个特征——同一物体亮度恒定、运动变化缓慢、邻域内的像素具有相同运动[20]。而在高清卫星视频中,为保障视频的流畅性,其帧率一般优于25 fps;又因为分辨率和对比度较低,尤其是在稳像处理后,相机运动产生的变化被消除[21],因此视频相邻帧的3个特点在卫星视频中更加显著。如图 2所示卫星视频连续3帧的运动变化比对,由于基高比较低,可以认为运动点目标只存在两种运动:平移和旋转。左3列目标作平移运动,右3列目标做旋转运动。为便于观察帧间的变化,画两条完全水平的直线作为基准。可以很清楚地看到,相邻帧间点目标平移和旋转运动变化平滑、且微小。第2行为对应目标矩形区域放大显示。分别对k、k-1和k+1、k帧目标区域进行灰度相似性计算,相似性度量采用性能优于SAD的归一化相关系数[22]。计算后得到的结果均优于0.99。说明相邻帧间点目标的灰度相似性很高,满足亮度恒定的特征。

|

| 图 2 目标在连续3帧中的运动和灰度变化对比 Fig. 2 The target motion and grayscale changes in continuous 3 frames |

鉴于此可以得出,卫星视频点目标在相邻帧中具有“二小一高”的特征:尺寸小、帧间运动变化小以及灰度相似性高。其运动在相邻帧之间满足运动平滑性的特征,即目标运动矢量的方向和大小与历史轨迹相比,变化是平滑的;同时也严格符合目标灰度统计的高相似性。相反,如果某个待判断矩形ROI的运动突变显著,或者灰度相似性低,那么该矩形ROI是目标的可能性就低。因此,可以利用点目标“二小一高”特征进行目标模板的特征描述。在概率统计中,利用事物的特征属性进行事物类别概率判断的经典有效方法是朴素贝叶斯分类法[23],文献[24-25]正是利用特征属性对潜在的目标进行分类判断,从而寻找到可靠的跟踪结果。综上,本文借鉴了前人的思想,专门针对卫星视频的点目标跟踪问题,提出了一种运动平滑特性约束的贝叶斯分类点目标跟踪方法(BMoST,Bayesian motion smooth tracker)。将点目标的灰度高相似性作为目标的特征属性,同时考虑运动平滑性特征约束,然后在朴素贝叶斯框架下,通过特征属性的似然度建立分类器的条件概率模型,进而实现点目标的抗差跟踪。

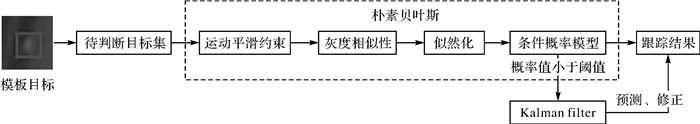

1 BMoSTBMoST的基本流程是,在视频第1帧中输入跟踪目标矩形ROI,获取目标矩形ROI中心和宽、高,建立初始模板目标。从第2帧开始,根据模板目标位置建立待判断目标集,然后将每一个待判断目标带入贝叶斯框架中判断。在贝叶斯框架中,首先对目标进行运动平滑约束处理,将符合条件的目标做灰度相似性统计,并根据灰度相似性构建似然函数,进而利用条件概率模型求解后验概率,完成当前帧的目标跟踪。在约束判断和后验概率值不高时,采用Kalman滤波优化辅助处理。方法流程如图 3所示。下面将对各主要部分进行详细描述说明。

|

| 图 3 算法流程 Fig. 3 Algorithm flow chart |

1.1 待判断目标集

在第1帧中已经获取到模板目标,从第2帧开始,每一帧的处理首先要建立待判断目标集,该目标集由一系列矩形ROI组成,本文采用滑动窗口的方式生成目标集。在当前帧中,将上一帧目标ROI中心像素位置的48邻域(7×7像素)设定为搜索区域ROI。在搜索区域中,不断滑动模板目标:从左至右、从上至下,每次滑动步长为一个像素。在每一个位置,模板目标与当前帧重叠的矩形区域形成一个待判断目标的矩形ROI。如图 4所示,绿色矩形框为搜索区域,为观察方便,将搜索区域扩大。模板目标滑动整个搜索区域后,完成待判断目标集的建立。

|

| 图 4 模板目标的窗口滑动示意 Fig. 4 The window slides diagram of template |

1.2 目标跟踪的条件概率模型

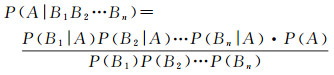

在一般情况下,往往不能直接通过表象特征来判断事物类别,但是可以利用事物的先验知识和样本集的训练获取到事物所包含特征的条件概率,用来表示事物的似然度,进而可以间接进行事物类别判断,这是贝叶斯分类器的主要思想。朴素贝叶斯分类器的基础是贝叶斯定理,它是关于随机事件A和B的条件概率P(A|B),表示在事件B发生的条件下,事件A发生的概率。事件B可以视作事件A所包含的特征,如果事件A中包含n个特征,Bj(j=1, 2, …,n)表示事件A的n个特征,并且假设所有特征相互独立(朴素),有

(1)

(1)

式(1) 即为朴素贝叶斯分类的理论公式。目标跟踪可以视作一种特殊的分类问题,将待判断的区域分为目标和非目标两类。那么在贝叶斯分类框架下,可以利用目标的灰度相似性属性进行分类判别。此外,由于每个属性之间是相互独立的,且不依赖于事物本身,因此式(1) 等号右边的分母可认为是常数。综上,目标跟踪的条件概率模型可表达为

(2)

(2)

式中,gray代表目标的灰度相似性属性;cos和dis表示运动平滑特性中的余弦相似性和欧氏距离属性,即运动矢量方向和大小的度量;obj代表目标。由于N个待判断ROI是目标的概率是相等的,均为1/N,因此在分类时,上式中的P(Obj)不用计算。下文将详细讨论各属性特征和式(2) 的具体计算方法。

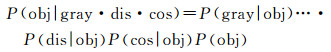

1.3 运动平滑性约束运动平滑性是指,目标相对于某一状态的运动矢量的大小和方向的变化是平滑的。矢量大小(欧氏距离)约束如图 5所示,obj表示目标,k-i表示帧号(i=-1,0,1),假设第k帧已经处理完毕,目标在第k、k-1帧中位置的欧氏距离为d。在第k+1帧中,要判断目标集1、2、3中哪个是跟踪目标。分别计算目标1、2、3与第k帧中的目标位置的距离d1、d2和d3。d2和d3相对于d有明显的变化,那么根据欧氏距离约束,运动矢量的大小变化是平滑的,因此可判断目标2、3不是跟踪目标。

|

| 图 5 欧氏距离约束示意 Fig. 5 European distance constraint diagram |

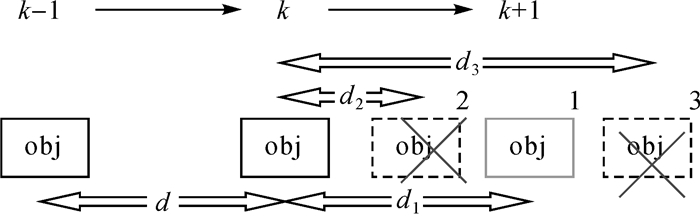

矢量方向约束如图 6所示。同样的,目标在第k帧中的位置相对于k-1帧的旋转角度为θ。在第k+1帧中,要判断目标1、2、3中哪个是跟踪目标。分别计算目标1、2、3与第k帧中的目标位置的旋转角度θ1、θ2和θ3。θ2和θ3相对于θ有明显的变化,那么根据方向约束,运动矢量的方向变化应是平滑的,因此可判断目标2、3不是跟踪目标。

|

| 图 6 矢量方向约束示意 Fig. 6 Vector direction constraint diagram |

运动矢量的大小和方向分别采用欧氏距离和余弦相似性描述。具体计算方法如下。

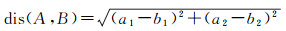

1.3.1 欧氏距离计算目标运动矢量大小采用欧氏距离度量,两个点A(a1,a2)、B(b1,b2)的欧氏距离公式为

(3)

(3)

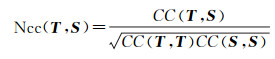

运动矢量大小约束可表示为

(4)

(4)

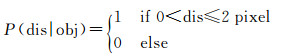

式中,objk表示当前帧待判断目标ROI中心点;objk-i表示第k-i帧的跟踪目标ROI中心点,i=1, 2。若欧氏距离变化较大,则一定不是目标。欧氏距离概率为

(5)

(5)

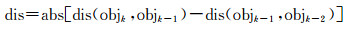

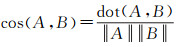

余弦相似性表示两个向量之间夹角的关系,两个矢量A、B的余弦相似性计算公式为

(6)

(6)

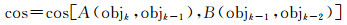

式中,dot表示两个向量的点积;‖*‖表示向量的二范数。目标运动矢量方向可采用余弦相似性度量,计算方法为

(7)

(7)

式中,objk表示当前帧待判断目标的中心点坐标;objk-i表示第k-i帧跟踪目标中心点坐标,i=1, 2。A(objk, objk-1)表示由objk和objk-1构成的向量,B同理。目标运动方向的变化是微小的,相对应的余弦相似性应较高。余弦属性概率为

(8)

(8)

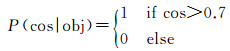

目标特征属性及描述是跟踪的主要依据。不依赖目标的运动先验知识,采用在线学习的方式,利用目标的灰度相似性属性描述目标特征似然度,构建跟踪模型,同时统计并记录目标运动轨迹。相关系数是用以反映变量之间相关关系密切程度的统计指标,在跟踪处理中可用于描述目标间的相似程度。相关系数的计算方法为

(9)

(9)

式中,T、S为两个向量,i为向量元素索引号。将其归一化,有利于提高匹配精度和抗干扰能力,归一化方法为

(10)

(10)

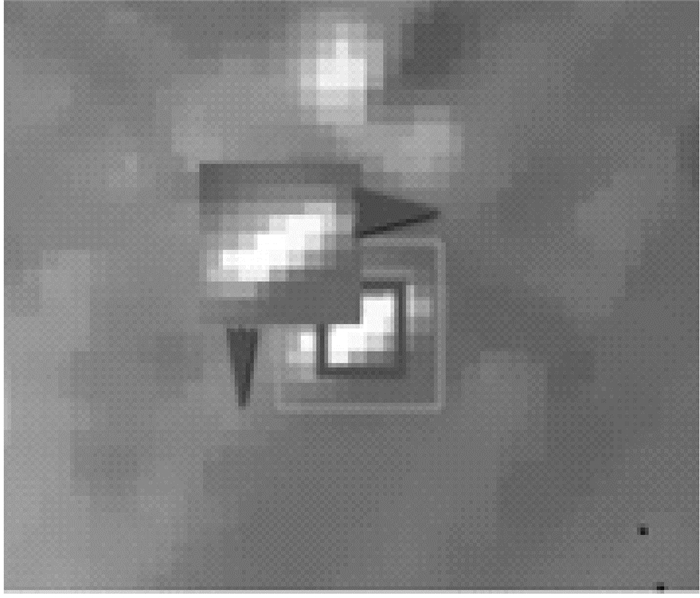

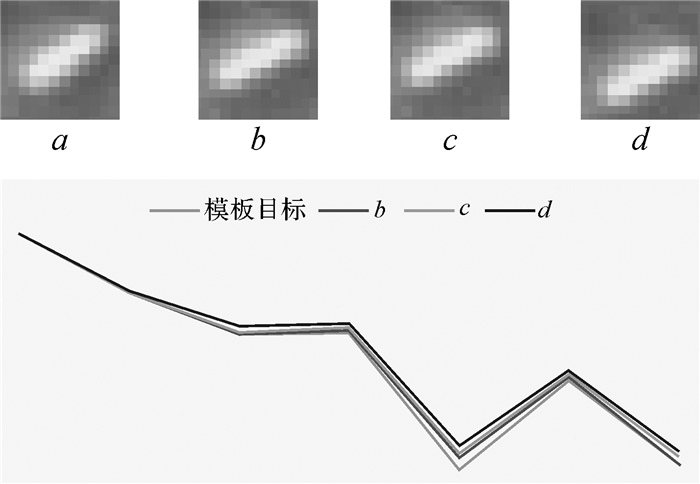

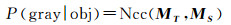

在前文中已经提到,通常相邻帧的目标的运动矢量的方向变化小,通过相关系数计算,跟踪目标具有较高的灰度相似性。但在某些特殊情况下,目标可能发生较大的旋转运动。由于相关系数度量对较大的旋转较敏感,此时匹配度较高的区域并不一定是目标区域。因此,考虑点目标的较大转弯运动,在相关系数的基础上,本文引入了HU不变矩的灰度相似性度量。HU不变矩由文献[26]提出,借助代数不变矩理论,通过构造不变矩多项式来实现旋转不变性。在具体实现时,利用二阶、三阶归一化后的几何中心距构造出7个不变矩。因此可以利用图像的HU不变矩特性作为目标跟踪模型的似然度,使得目标在旋转和平移运动时可以更准确地进行特征描述。如图 7所示为4个点目标ROI及对应的不变矩折线比对图。其中,a为模板目标,b、c、d为待判断目标,且旋转较大。计算各目标的不变矩,并分别画出折线图。可采用折线图来表示目标特征,各折线图的7个节点为相应目标的7个不变矩。为便于观察,将数值放大100倍。通过折线图比对可以看出,目标b与模板目标的折线拟合度(相似性)最高,因此在b、c、d中,b是跟踪目标的可能性最高。

|

| 图 7 灰度特征的HU折线描述及比对 Fig. 7 HU broken line description and comparison of grayscale features |

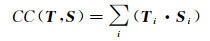

几何中心距和HU不变矩的构造方法可参见文献[27]。HU不变矩由7个参数组成,在似然化时将7参数视作一个7维向量,通过计算7维向量的归一化相关系数进行目标相似性计算,建立灰度特征似然度。根据式(10),计算方法为

(11)

(11)

式中,MT、MS分别表示目标模板图像和待判断ROI图像的7个HU不变矩参数组成的7维向量。

1.5 算法及步骤在综上,BMoST跟踪算法的详细步骤为:

(1) 在第当前帧中,以窗口滑动的方式建立待判断像目标集;

(2) 进行运动平滑约束,根据式(5) 和式(8) 计算每个待判断目标的余弦和欧氏距离概率,将概率为1的目标记录保留;

(3) 根据式(11) 分别计算保留下来的目标灰度相似性概率,进而得到最终概率P;

(4) 取P最大值的目标作为跟踪结果。当前帧处理结束,进入下一帧处理。

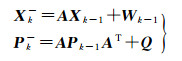

若求得的最终后验概率低于阈值,说明跟踪结果不够准确。为提高算法的抗差性,此时加入了Kalman滤波。Kalman滤波通过线性最小均方误差估计,能够根据目标历史轨迹预测当前帧的位置[28],并结合当前帧的观测值来优化跟踪结果。Kalman滤波针对k时刻预测的状态方程为

(12)

(12)

式中,Xk-1=[xk-1 yk-1 ux-1 vx-1]T为k-1时刻的状态值(即跟踪结果),其中x和y表示目标中心点坐标,u和v分别表示水平、垂直方向速度;A表示从k-1时刻到k时刻的状态转移矩阵;Pk-1表示k-1时刻的最优协方差矩阵;W是相互独立的零均值标准正态高斯白噪声序列,表示状态转移干扰噪声;Q是W的协方差矩阵

(13)

(13)

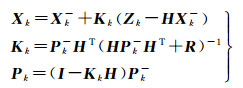

根据式(12) 可得到预测的初始结果,下面利用增益矩阵Kk(4×2) 对其进行修正,使结果达到最优估计。Kalman滤波预测的状态更新方程为

(14)

(14)

式中,

这样,利用式(12) 和式(14) 的不断迭代更新可实现自回归的最优估计,使得目标跟踪算法在某几帧概率判断失效时仍有可能确保目标不丢失。在试验中,概率的阈值设定为0.95,是通过多对帧间同名目标的相似性计算试验得出的经验值。概率P计算的伪代码见算法1。

算法1 概率计算

1:objk←待判断目标ROI中心点

2:objk-1←前1帧跟踪结果目标ROI中心点

3:objk-2←前2帧跟踪结果目标ROI中心点

4:dis←dis(objk, objk-1)-dis(objk-1, objk-2)

5:if dis<=2&&dis>0

6: P(dis|obj)=1

7:else

8: P(dis|obj)=0

9:end if

10:cos←cos((objk, objk-1),(objk-1, objk-2)

11:if cos>0.7

12: P(cos|obj)=1

13:else

14: P(cos|obj)=0

15:end if

16:ROI(objk-1)←前一帧模板目标ROI

17:ROI(objk)←当前帧待判断目标ROI

18:CC←correlation coefficient

19:P(gray|obj)←CC(HU(ROI(objk-1)), HU(ROI(objk)))

20:P(gray|obj)←P(gray|obj)/…

21:sqrt(CC(HU(ROI(objk-1)), HU(ROI(objk-1))*CC(HU(ROI(objk)), HU(ROI(objk)))

22:P=P(dis|obj)*P(cos|obj)*P(gray|obj)

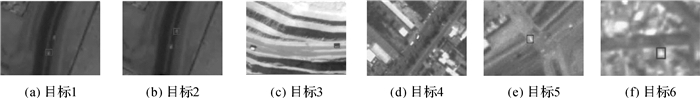

2 试验 2.1 试验数据说明在卫星视频常见的场景中对BMoST跟踪算法进行测试,场景主要包括了目标变速运动、目标旋转、辐射亮度变化以及相邻近似目标和背景干扰等,选择机动目标做测试,目标尺寸小、无纹理特征、且与背景的对比度较低。试验数据为SkySat全色视频2段和吉林一号彩色视频2段,视频影像分辨率为1.1 m,帧频优于25 fps。SkySat视频1是一段迪拜城区视频,将道路行驶汽车作为跟踪目标,视频中的跟踪目标进行弯道和变速行驶,并且邻域干扰严重,与邻近目标距离近、相似度高;SkySat视频2是一段矿区作业监控视频,矿车作为跟踪目标,视频中目标的灰度是变化的,且与背景相似度较高,在视频后半段中目标几乎隐藏在背景中;吉林一号视频1是墨西哥城区的交通路况视频,道路上汽车作为跟踪的目标。其中目标4首先做直线匀速运动,然后减速并转弯90°,速度逐渐接近于零。目标5首先处于静止状态,然后启动并90°转弯行驶。吉林一号视频2是某城区上空飞机飞过的场景,视频的图像质量不佳、清晰度低,背景变化快,并且存在临近相似背静干扰和目标隐藏在背景中的情况。

| 目标 | 视频 | 目标大约尺寸/像素 | 视频总帧数 | 目标隐藏帧数 |

| 目标1 目标2 |

SkySat视频1 | 5×5 | 500 | 0 |

| 目标3 | SkySat视频2 | 10×10 | 1600 | 450左右 |

| 目标4 目标5 |

吉林一号视频1 | 6×6 | 494 | 0 |

| 目标6 | 吉林一号视频2 | 15×15 | 169 | 11左右 |

|

| 图 8 测试视频第一帧截图 Fig. 8 The first frame screenshot of test videos |

2.2 试验结果与分析

对上述4段视频中的6个目标进行BMoST方法测试试验,同时又对目标1和目标4采用一般灰度法进行比对试验。便于观察跟踪效果,将当前帧目标位置和200帧历史轨迹标记出。6个目标的跟踪结果如表 2所示。从跟踪效果上看,本文方法除了1521帧之后的目标3,试验的6个目标全部成功跟踪,在整个过程中保持较好的跟踪状态,未丢失目标。而一般灰度法的跟踪不够稳健,存在目标丢失情况。这里的一般灰度法是指仅仅利用图像灰度相似性进行特征描述的跟踪方法。在卫星视频中点目标尺寸较小,为了更细化描述跟踪结果,这里将正确跟踪阈值定为

| 目标 | 视频总帧数 | 目标隐藏帧数 | 正确跟踪帧数 | 跟踪精度 |

| 目标1 | 500 | 0 | 453 | 0.906 |

| 目标2 | 500 | 0 | 461 | 0.922 |

| 目标3 | 1600 | 450 | 1392(1521帧之前) 0(1521帧之后) |

0.915 (1521帧之前) |

| 目标4 | 494 | 0 | 442 | 0.895 |

| 目标5 | 494 | 0 | 449 | 0.909 |

| 目标6 | 169 | 11 | 151 | 0.893 |

2.2.1 SkySat视频1

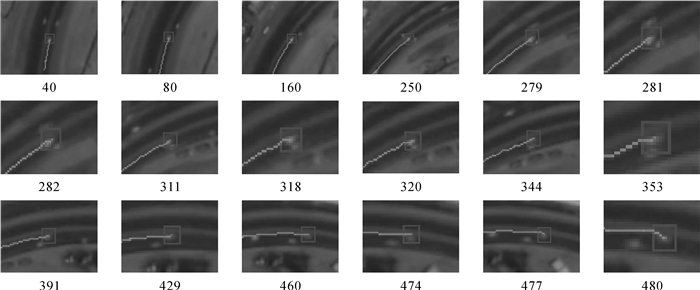

如图 9所示为本文方法的跟踪效果,目标1处于道、靠近中间道路隔离带行驶。在前40帧的运动轨迹近似于直线,40帧以后开始持续均匀转弯,没有其他目标和背景的干扰,在250帧之前,跟踪精度为100%,并且轨迹平滑。从250帧开始,目标1不断接近右侧车道的目标2,跟踪精度开始有所下降,有2个像素左右的漂移;279帧后,两目标开始相互缠绕粘连,280、282帧的跟踪结果偏移了2~3个像素,312帧到318帧左右也有同样的情况。但281、283~311帧利用运动平滑约束修正了位置,轨迹跟踪较稳定。320帧时两目标几乎并排行驶,粘连程度和干扰面积最大,但依然可以较好地进行跟踪,并无明显漂移。344帧开始超车,353开始分离,391帧完成超车,并逐渐结束弯道行程,跟踪趋于稳定。429帧到474帧左右,这期间目标不够清晰,并且目标上方的隔离带与目标相似性极高,使得跟踪向上漂移,但方法仍然可以沿着隔离带跟踪,如460帧轨迹。在480帧左右时,目标清晰度提升,灰度相关性约束将目标跟踪位置纠正回来。

|

| 图 9 本文方法的目标1跟踪效果 Fig. 9 Target 1 tracking results of our method |

如图 10所示为一般灰度法的跟踪效果,330帧之前总体跟踪效果良好、轨迹平滑。尤其是从250帧开始,在有目标轻微干扰的情况下也能保持很好的跟踪状态,这个阶段的跟踪轨迹状态优于本文方法。但是在330帧以后,临近目标粘连和干扰程度较大,跟踪开始有较大偏差。由于没有运动平滑性的约束,在334帧时产生了目标漂移。在342帧左右,跟踪漂移到临近相似目标,目标跟踪失败。

|

| 图 10 一般灰度法目标1跟踪效果 Fig. 10 Target 1 tracking results of general grayscale method |

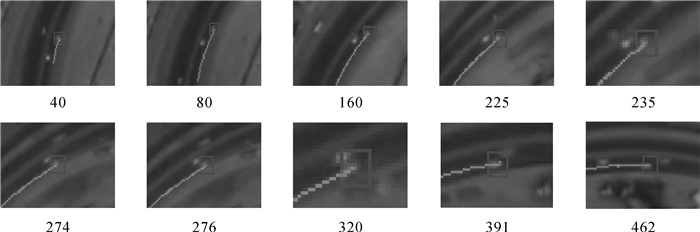

跟踪的目标2处于外道,行驶速度相对目标1较慢。本文的跟踪方法如图 11所示。160帧之前的运动近似直线、转弯角度小,跟踪稳定平滑,精度高,225帧左右开始转弯角度增大,且与右侧相似背景缠绕粘连,产生了干扰,在276帧之前目标频繁向右偏移,但没有丢失目标,见235、274帧历史轨迹。直到276帧左右,目标2与右侧背景分离,位置修正。279帧开始,目标1和2相互粘连缠绕,320帧左右目标1与目标2并排行驶,到391帧左右两目标分离,整个过程都能保持稳定跟踪,并且轨迹平滑、整体弧度与道路基本吻合。392帧之后临近干扰解除,同时逐渐从弯道转入直线行驶,跟踪精度几乎100%。

|

| 图 11 目标2跟踪效果 Fig. 11 Target 2 tracking results |

SkySat视频1中的目标跟踪面临的主要挑战是,在目标大旋转半径转弯时伴随临近高相似目标和背景的干扰,导致跟踪偏移和精度降低,但BMoST方法能有效地抵抗这种干扰,使得整个跟踪过程维持较高的精度和稳定性。

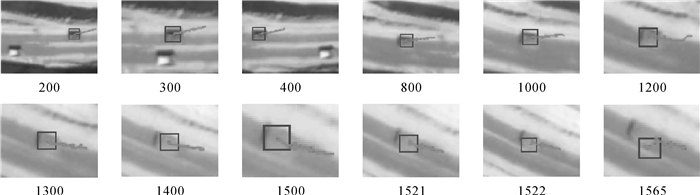

2.2.2 SkySat视频2SkySat视频2目标3在视频前半段中行驶在两种颜色道路的边缘,边缘将跟踪目标分成了上、下两个部分,下半部分与道路的灰度相似性极高,可认为目标隐藏在背景中。整个视频中矿车移动速度较慢,200帧时大概移动了20个像素左右。300、400帧时跟踪状态稳定,此时矿车的灰度值开始变化。800帧时灰度有了明显变化,并逐渐向下方高相似背景过度,跟踪状态较稳定,轨迹无明显跳变。到1000帧左右时目标几乎全部进入高相似背景中,只有左侧、上侧边缘具有明显灰度对比,此时跟踪轨迹已经出现轻微跳变,稳定性降低。到1200帧左右目标几乎全部隐藏在相似背景中,轨迹跳变较严重,但跟踪未出现漂移。到1300、1400帧左右,该过程在目标隐藏的情况下进行跟踪,灰度相似性完全失去作用,依靠余弦和欧氏距离相似性以及Kalman滤波的约束,将轨迹跟踪控制在较稳定的状态,目标未丢失。在1500帧左右,目标逐渐旋转向左上方加速行驶,并带有旋转,过长时间隐藏状态下目标跟踪的性能下滑,轨迹跳变严重、杂乱无章。1521帧左右跟踪偏移开始增大,1522帧开始产生了跟踪漂移,1565帧左右彻底丢失目标。

SkySat视频2中目标跟踪主要面临的挑战是,目标部分或几乎全部隐藏在背景中,灰度相似性完全或部分失效。在这种情况下,MoST跟踪法能够有效地在目标部分隐藏时进行抗差跟踪,甚至可以在一段时间内(500帧左右),针对几乎完全隐藏的目标进行相对稳定跟踪,目标的位置虽然有所偏移,但并不会丢失。

|

| 图 12 目标3跟踪效果 Fig. 12 Target 3 tracking results |

2.2.3 吉林一号视频1

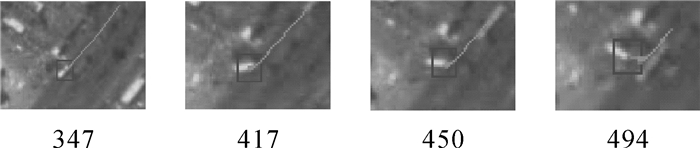

吉林一号视频1的试验主要是为了验证跟踪算法针对目标大角度旋转时的跟踪效果,如图 13所示为本文方法的跟踪效果。目标4前200帧处在匀速直线的运动状态,跟踪精度几乎为100%,跟踪轨迹近似为一条直线。到200帧左右,目标开始减速,准备入弯。到250帧左右,开始逐渐增加转向的角度。347帧左右开始,转向角速率提高,此时旋转角度大约为10°。383帧时大约旋转了30°左右;417帧大约45°;450帧60°, 494达到90°左右。

|

| 图 13 本文方法的目标4跟踪效果 Fig. 13 Target 4 tracking results of our method |

如图 14所示为一般灰度法的跟踪效果。在347帧之前目标作直线运动,跟踪轨迹和效果好;但在进入弯道之后,由于一般的灰度法对较大旋转敏感,相关系数的相似性度量不能很好地描述目标特征。在目标做旋转运动时的跟踪精度降低,大约偏移4个像素,如417、450和494帧。

|

| 图 14 一般灰度法的目标4跟踪效果 Fig. 14 Target 4 tracking results of general grayscale method |

目标5的跟踪效果如图 15所示。目标5开始处于静止、待转弯状态。到159帧左右,目标开始启动并开始转弯、加速。216帧左右转弯角度大约为30°,250帧45°,275帧60°,320帧左右90°,转弯完毕,进入直线加速行驶。直到494帧为直线阶段,轨迹平滑,近似真实轨迹。

|

| 图 15 目标5跟踪效果 Fig. 15 Target 5 tracking results |

吉林一号视频1跟踪试验主要面临的挑战,是目标小转弯半径下的大角度旋转(90°),使得相邻帧目标旋转角度较大。试验表明提出的BMoST跟踪方法在相邻帧点目标存在较大旋转时,能保证稳定、准确地跟踪。

2.2.4 吉林一号视频2吉林一号视频2的清晰度较差,目标6几乎处在匀速直线行驶状态,本文算法的跟踪效果如图 16所示。前17帧跟踪状态稳定,从17帧开始目标6开始进入高相似背景区域,20帧时,目标6有一半区域被隐藏;22帧时目标几乎隐藏背景中,23帧时目标完全隐藏背景中,直到31帧完全脱离隐藏区域,在这个过程中目标跟踪沿运动方向的偏差较大,但算法依靠运动平滑约束,并未丢失目标。41帧左右目标左侧出现高相似区域,53帧左右脱离相似区域干扰,跟踪稳定。53帧以后除了背景变化以外无相似背景干扰,跟踪精度高,轨迹平滑、近似真实轨迹。

|

| 图 16 本文算法目标6跟踪效果 Fig. 16 Target 6 tracking results of our method |

吉林一号视频2的跟踪试验主要面临的挑战是目标和背景清晰度低,且存在目标隐藏在背景中的情况,试验结果表明,BMoST方法在该视频,虽然在目标隐藏的几帧中的跟踪有2~3个像素的偏移,但并没有丢失目标,仍然可以沿着目标的运动方向跟踪。同时在目标未隐藏时,能够保持非常高的跟踪精度。

3 结论卫星视频条件下点目标的跟踪主要面临的挑战有,目标尺寸小、特征和纹理信息稀少;影像分辨率和对比度低、前景和背景可区分性差;目标彼此相似性高、相互干扰严重。针对这些问题,提出的BMoST方法利用了目标的运动平滑性和灰度相关性,在朴素贝叶斯分类的框架下,实现了卫星视频点目标的有效跟踪,并通过6组试验验证了该方法的有效性。该方法在目标转弯同时的临近相似目标和背景干扰、目标掩藏在背景中、目标小转弯半径下的大角度旋转、视频质量模糊等情况下,都有很好的跟踪效果和精度。处理结果可用于后续的高级应用。

| [1] | MURTHY K, SHEARN M, SMILEY B D, et al. SkySat-1:Very High-resolution Imagery from a Small Satellite[C]//SPIE Remote Sensing. International Society for Optics and Photonics. Amsterdam, Netherlands:SPIE, 2014:9241. |

| [2] | 张过. 卫星视频处理与应用进展[J]. 应用科学学报, 2016, 34(4): 361–370. ZHANG Guo. Satellite Video Processing and Applications[J]. Journal of Applied Sciences-Electronics and Information Engineering, 2016, 34(4): 361–370. |

| [3] | 朱厉洪, 回征, 任德锋, 等. 视频成像卫星发展现状与启示[J]. 卫星应用, 2015(10): 20–28. ZHU Lihong, HUI Zheng, REN Defeng, et al. Development Status and Inspiration of Video Imaging Satellite[J]. Satellite Application, 2015(10): 20–28. |

| [4] | D'ANGELO P, MáTTYUS G, REINARTZ P. Skybox Image and Video Product Evaluation[J]. International Journal of Image and Data Fusion, 2016, 7(1): 3–8. DOI:10.1080/19479832.2015.1109565 |

| [5] | 王飞, 房胜. 加权局部特征结合判别式字典的目标跟踪[J]. 中国图象图形学报, 2014, 19(9): 1316–1323. WANG Fei, FANG Sheng. Visual Tracking Based on the Discriminative Dictionary and Weighted Local Features[J]. Journal of Image and Graphics, 2014, 19(9): 1316–1323. DOI:10.11834/jig.20140908 |

| [6] | LEICHTER I. Mean Shift Trackers with Cross-bin Metrics[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(4): 695–706. DOI:10.1109/TPAMI.2011.167 |

| [7] | ZhANG Dongmei, WANG Ronggui, YANG Juan, et al. Research on Sparse Coding Object Tracking Method[J]. Computer Engineering and Applications, 2015, 51(22): 53–60. |

| [8] | HENRIQUES J F, CASEIRO R, MARTINS P, et al. High-speed Tracking with Kernelized Correlation Filters[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(3): 583–596. DOI:10.1109/TPAMI.2014.2345390 |

| [9] | ZDENEK K, MIKOLAJCZYK K, MATAS J. Tracking-learning-detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(7): 1409–1422. DOI:10.1109/TPAMI.2011.239 |

| [10] | 周志宇, 彭小龙, 吴迪冲, 等. 在线特征选取的多示例学习目标跟踪[J]. 中国图象图形学报, 2015, 20(10): 1346–1357. ZHOU Zhiyu, PENG Xiaolong, WU Dichong, et al. Object Tracking Based on Multiple Instance Learning with Online Feature Selection[J]. Journal of Image and Graphics, 2015, 20(10): 1346–1357. DOI:10.11834/jig.20151008 |

| [11] | 朱秋平, 颜佳, 张虎, 等. 基于压缩感知的多特征实时跟踪[J]. 光学精密工程, 2013, 21(2): 437–444. ZHU Qiuping, YAN Jia, ZHANG Hu, et al. Real-time Tracking Using Multiple Features Based on Compressive Sensing[J]. Optics and Precision Engineering, 2013, 21(2): 437–444. |

| [12] | XU Jianqiang, LU Yao, LIU Jinwu. Robust Tracking via Weighted Spatio-temporal Context Learning[C]//Proceedings of 2014 IEEE International Conference on Image Processing. Paris, France:IEEE, 2014:413-416. |

| [13] | ZAPPELLA L, DEL BUE A, LLADO X, et al. Joint Estimation of Segmentation and Structure from Motion[J]. Computer Vision and Image Understanding, 2013, 117(2): 113–129. DOI:10.1016/j.cviu.2012.09.004 |

| [14] | 王春平, 王暐, 刘江义, 等. 基于色度饱和度-角度梯度直方图特征的尺度自适应核相关滤波跟踪[J]. 光学精密工程, 2016, 24(9): 2293–2301. WANG Chunping, WANG Wei, LIU Jiangyi, et al. Scale Adaptive Kernelized Correlation Filter Tracking Based on HHS-OG Feature[J]. Optics and Precision Engineering, 2016, 24(9): 2293–2301. |

| [15] | 修春波, 魏世安, 万蓉凤. 二维联合特征模型的自适应均值漂移目标跟踪[J]. 光电子·激光, 2015(2): 342–351. XIU Chunbo, WEI Shian, WAN Rongfeng. CAMShift Target Tracking Based on Two-dimensional Joint Characteristics[J]. Journal of Optoelectronics·Laser, 2015(2): 342–351. |

| [16] | BERTINETTO L, VALMADRE J, GOLODETZ S, et al. Staple:Complementary Learners for Real-time Tracking[C]//Proceedings of 2016 IEEE International Conference on Computer Vision and Pattern Recognition. Las Vegas, NV:IEEE, 2016:1401-1409. |

| [17] | ZHANG Yanning, TONG Xiaomin, YANG Tao, et al. Multi-model Estimation Based Moving Object Detection for Aerial Video[J]. Sensors (Basel, Switzerland), 2015, 15(4): 8214–8231. DOI:10.3390/s150408214 |

| [18] | SHI Jianbo, TOMASI C. Good Features to Track[C]//Proceedings of 1994 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Seattle, WA:IEEE, 1994:593-600. |

| [19] | CHEN Z W, CHIANG C C, HSIEH Z T. Extending 3D Lucas-Kanade Tracking with Adaptive Templates for Head Pose Estimation[J]. Machine Vision and Applications, 2010, 21(6): 889–903. DOI:10.1007/s00138-009-0222-y |

| [20] | FORTUN D, BOUTHEMY P, KERVRANN C. Optical Flow Modeling and Computation:A Survey[J]. Computer Vision and Image Understanding, 2015, 134: 1–21. DOI:10.1016/j.cviu.2015.02.008 |

| [21] | 王霞, 张过, 沈欣, 等. 顾及像面畸变的卫星视频稳像[J]. 测绘学报, 2016, 45(2): 194–198. WANG Xia, ZHANG Guo, SHEN Xin, et al. Satellite Video Stabilization with Geometric Distortion[J]. Acta Geodaetica et Cartographica Sinica, 2016, 45(2): 194–198. DOI:10.11947/j.AGCS.2016.20150238 |

| [22] | 高广珠, 李忠武, 余理富, 等. 归一化互相关系数在图像序列目标检测中的应用[J]. 计算机工程与科学, 2005, 27(3): 38–40. GAO Guangzhu, LI Zhongwu, YU Lifu, et al. Application of the Normalized Cross Correlation Coefficient in Image Sequence Object Detection[J]. Computer Engineering & Science, 2005, 27(3): 38–40. |

| [23] | 吕昊, 林君, 曾晓献. 改进朴素贝叶斯分类算法的研究与应用[J]. 湖南大学学报(自然科学版), 2012, 39(12): 56–61. LÜ Hao, LIN Jun, ZENG Xiaoxian. Research and Application of Improved Naive Bayesian Classification Algorithm[J]. Journal of Hunan University (Natural Sciences), 2012, 39(12): 56–61. DOI:10.3969/j.issn.1674-2974.2012.12.010 |

| [24] | ZHANG Kaihua, ZHANG Lei, YANG Minghsuan. Real-time Compressive Tracking[C]//European Conference on Computer Vision. Berlin, Heidelberg:Springer, 2012:864-877. |

| [25] | 耿磊, 王学彬, 肖志涛, 等. 结合特征筛选与二次定位的快速压缩跟踪算法[J]. 自动化学报, 2016, 42(9): 1421–1431. GENG Lei, WANG Xue-bin, XIAO Zhitao, et al. Fast Compressive Tracking Algorithm Combining Feature Selection with Secondary Localization[J]. Acta Automatica Sinica, 2016, 42(9): 1421–1431. |

| [26] | HU Ming-kuei. Visual Pattern Recognition by Moment Invariants[J]. IRE Transactions on Information Theory, 1962, 8(2): 179–187. DOI:10.1109/TIT.1962.1057692 |

| [27] | 黄敏, 马亚琼, 朱颢东, 等. 基于Hu修正不变矩的商标识别[J]. 华中师范大学学报(自然科学版), 2014, 48(2): 182–185. HUANG Min, MA Yaqiong, ZHU Haodong, et al. Trademark Recognition Based on Hu Modified Invariant Moment[J]. Journal of Huazhong Normal University (Natural Sciences), 2014, 48(2): 182–185. |

| [28] | 闫钧华, 陈少华, 艾淑芳, 等. 基于Kalman预测器的改进的CAMShift目标跟踪[J]. 中国惯性技术学报, 2014, 22(4): 536–542. YAN Junhua, CHEN Shaohua, AI Shufang, et al. Target Tracking with Improved CAMShift Based on Kalman Predictor[J]. Journal of Chinese Inertial Technology, 2014, 22(4): 536–542. |