2. 信息工程大学导航与空天目标工程学院, 河南 郑州 450000

2. Information Engineering University, School of Navigation and Aerospace Engineering, Zhengzhou 450000, China

目前旋翼无人机的应用越来越广泛,实现智能化是无人机发展的必然趋势,其中自主避障是无人机实现智能化的一个亟需解决的问题。视觉传感器具有隐蔽性好、信息丰富、目标完整等优点,是实现自主导航与避障的一种较为优良的环境感知系统。目前,国内外许多高校和研究机构都开展了无人机视觉导航与避障技术研究。文献[1-2]采用立体视觉实现了旋翼无人机室内避障飞行;文献[3]采用深度相机获得室内环境的位置信息,实现了室内自主避障飞行,但他们的方法只适用于室内已知环境,不能满足室外复杂环境的避障需求。文献[4]采用光流法与运动补偿,实现了障碍物检测;文献[5]采用人工识别与光流法,实现了无人机的自主着陆和室外避障飞行;文献[6]采用SLAM与光流法,实现了固定翼无人机的自主避障;文献[7]采用光流法实现了旋翼无人机室外避障飞行;文献[8]采用二值模板匹配与光流法,实现了无人机自主着陆与室外避障;文献[9]采用光流融合方法实现了旋翼无人机室外避障。他们都采用光流法检测障碍物从而实现无人机避障,但是这些方法都要求无人机必须向正前方飞行,否则会降低障碍物检测的准确性与可靠性。现有的视觉避障研究大部分都基于图像分割,图像深度提取,以及众多的光流算法[10-12]。图像分割方法计算效率高,但精度比较低[13]。深度提取方法需构建3D地图,难以满足无人机实时避障的要求[14-15]。光流法能兼顾实时性与准确性,是一种较为优良的障碍物检测算法,但传统光流算法只适用于沿正前方的理想飞行,当飞行偏离理想轨迹时,其准确性与适应性不能满足避障要求。

针对传统光流算法在室外复杂环境下障碍物检测准确性不高的问题,本文提出一种基于径向光流的旋翼无人机单目视觉自主实时障碍物检测方法。该方法用金字塔LK光流与切向光流求差得到径向光流,可消除切向光流带来的误差,提高了算法的准确性,能够满足无人机的室外避障飞行。

1 径向光流原理及计算根据环境条件或作业需求,无人机在飞行过程中不仅有正前方向的移动,还有上下左右的移动,可将无人机正前方向的移动称为径向移动,垂直于正前方向的移动称为切向移动。由无人机径向移动产生的光流称为径向光流,切向移动产生的光流称为切向光流,求解金字塔LK光流和切向光流的矢量差可得到径向光流。径向光流是检测障碍物的重要依据,本节重点介绍径向光流的基本原理与计算方法。

1.1 金字塔LK光流光流法是一种能根据相对较小变化产生流动向量的图像运动表达方式[16]。光流含有丰富的运动信息,反映了运动载体拍摄到图像的变化[17-18],因此可以用来确定载体与目标的相对运动。常见的光流法中LK光流法具有较好的稳健性,因此本文采用LK光流求解图像的光流。

LK光流算法基于以下3个假设,相邻两幅影像之间满足:① 亮度恒定;② 运动是“小运动”;③ 空间一致,临近点有相似运动,保持相邻[19]。

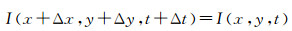

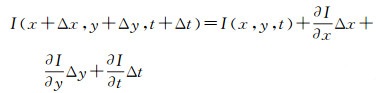

由假设(1) 亮度恒定可以得到一个约束方程

(1)

(1)

式中,I(x, y, t)是t时刻图像中点(x, y)的亮度;Δx与Δy分别为x与y在Δt时间内的增量。

由假设② 可知像素的移动足够小,对图像约束方程使用泰勒公式,并舍去高次项,可得

(2)

(2)

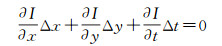

将式(2) 代入式(1) 可得

(3)

(3)

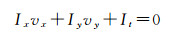

对式(3) 两边同时除以Δt,即可得到光流约束方程

(4)

(4)

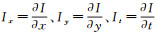

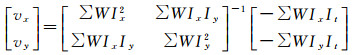

式中,

将式(4) 写成矩阵形式

(5)

(5)

将式(5) 记为:Av=b。由于光流偏差与各点光流与中心点的距离相关,距离越大,光流偏差也越大,给予靠近中心的像素更多的权重会更有利。因此,取一个从中心向四周递减的W函数作为权值函数,从而加强控制领域中心部分的光流偏差。采用最小二乘法求解式(5) 可得LK光流v为

(6)

(6)

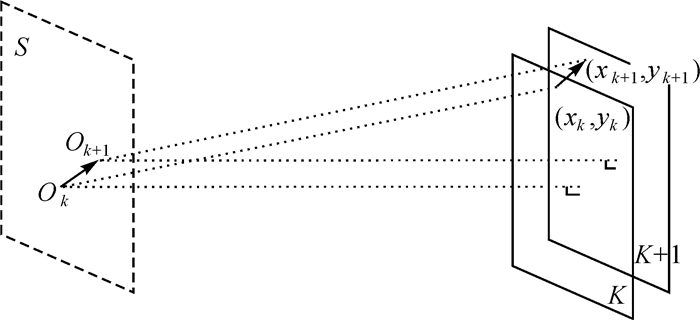

LK方法要求必须满足小运动,亮度不变以及区域一致,但无人机运动较快使图像中近距离物体产生的光流变化较大,不能满足假设条件,导致最终求得的光流值有较大的偏差,因此本文采用图像金字塔对光流进行从粗到精的估计,如图 1所示。在图像金字塔的最高层计算光流,用得到的运动估计结果作为下一层金字塔的起始点,重复这个过程至金字塔最底层,这样就能将不满足运动假设的可能性降到最低[20]。

|

| 图 1 金字塔LK光流原理 Fig. 1 Principle of Pyramid LK optical flow |

1.2 切向光流

切向光流是无人机切向移动产生的光流,表示了前一帧图像到后一帧图像的整体移动量。本文根据连续两帧图像的单应矩阵H求解切向光流。

单应矩阵可以表示空间中同一平面的任意两幅图像的对应关系[21],而本文所用的影像并非来自同一平面。为解决这一问题,本文使用RANSAC算法对所有的特征点进行筛选,取尽可能多的点在同一平面,将这个平面称为最优障碍物平面。用最优障碍物平面上的点计算单应矩阵H,可降低计算误差。

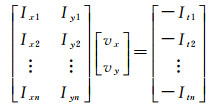

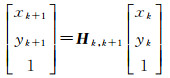

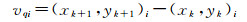

假设相机平面与最优障碍物平面平行,只考虑切向运动,不考虑径向运动。如图 2所示,拍摄第k帧和第k+1帧图像时,相机有OkOk+1的平移量,其中(xk, yk)i为第k帧图像上的坐标点,(xk+1, yk+1)i是点(xk, yk)i经过单应变换后在第k+1帧图像上的坐标点。单应变换公式如下

(7)

(7)

|

| 图 2 切向光流示意图 Fig. 2 Tangential flow diagram |

式中,Hk, k+1为第k帧到第k+1帧图像的单应矩阵。将(xk+1, yk+1)i与(xk, yk)i做差,即得到每个点对应的切向光流。公式如下

(8)

(8)

切向光流表示两帧图像之间整体的移动量,在图像上均匀选取n×n个点,分别求解切向光流,然后求均值可得这两帧图像的切向光流vq

(9)

(9)

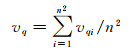

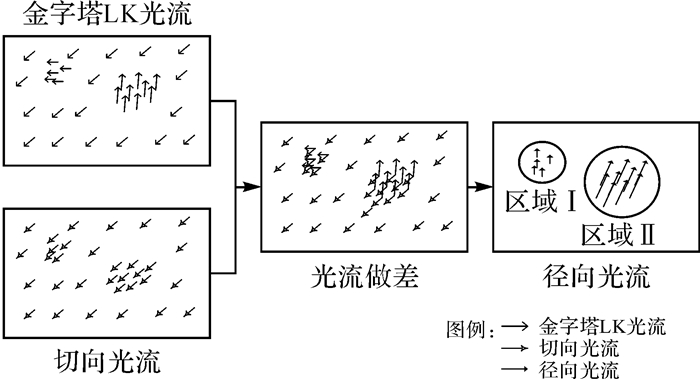

金字塔LK光流是由于无人机的实际运动产生的光流,无人机的运动可分解为径向移动与切向移动,因此金字塔LK光流可分解为径向光流与切向光流。如图 3所示,左上图为金字塔LK光流,左下图为切向光流,二者求矢量差可得到右图的径向光流。径向光流公式如下

(10)

(10)

|

| 图 3 光流示意图 Fig. 3 Diagram of the optical flow |

2 径向光流检测障碍物

光流可以表示连续两帧图像上像素点的运动量[22],径向光流的大小能够表示前方物体的距离远近。本节通过分析摄像机成像得到径向光流与运动的关系,并基于此设定检测阈值,比较检测阈值与径向光流的大小进行障碍物检测。

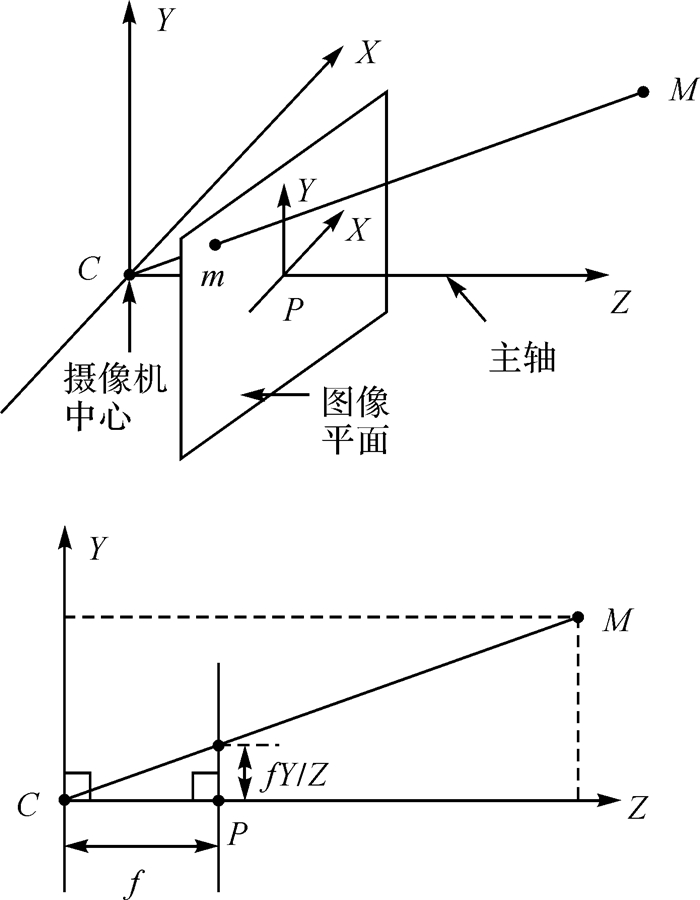

2.1 光流的原理与分析分析摄像机成像原理可得影响径向光流的基本因素。本文采用针孔摄像机模型[23-24]。如图 4所示,空间一点对一张平面进行中心投影,令投影中心位于一个欧氏坐标系的原点,平面Z=f被称为图像平面。在针孔摄像机模型下,物点M被映射到图像平面上的一点,该点是连接物点M与投影中心的直线与图像平面的交点,称为像点m。图中,投影中心C为摄像机中心,摄像机中心到图像平面的垂线称为摄像机的主轴,而主轴与图像平面的交点P为图像中点,过物点M平行于图像平面的平面称为物平面。

|

| 图 4 针孔摄像机几何模型 Fig. 4 Geometric model of pinhole camera |

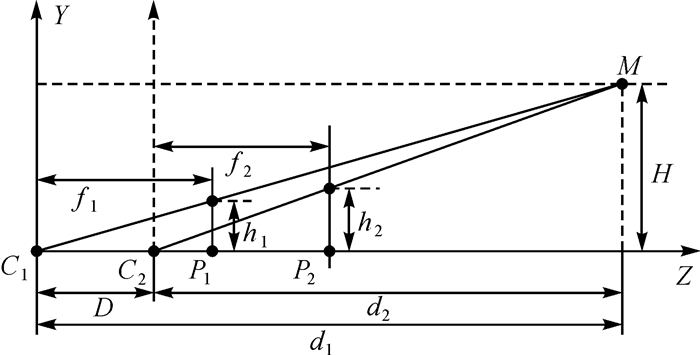

连续拍摄两帧图像,其成像模型如图 5所示,C1、C2为摄像机中心;P1、P2为两帧图像的中点;D为基线长度;d1、d2为物距,即摄像机中心到物平面的距离;H为物点M到主轴的距离;h1、h2为像点m1、m2到主轴的距离。在图像坐标系内,像点m1到m2的矢量即为两帧图像上物点M产生的光流。

|

| 图 5 两帧图像的成像模型 Fig. 5 The imaging model of two-frame image |

根据相似三角形原理,可知

(11)

(11)

飞行过程中保持焦距不变,故f1=f2,由图 5可知D=d1-d2,代入式(11) 可得光流的表达式为

(12)

(12)

由式(12) 可知,光流与特征点到图像中点的距离h1成正比,与基线长度D成正比,与物距d2成反比。基线长度D是无人机的飞行速度V与拍摄时间间隔t的乘积,因此光流与速度V和拍摄间隔t成正比。

2.2 障碍物检测利用运动视差可以判断场景物体与观察者的相对距离[25-26]。将摄像头看作运动的观察者,由于观察者观察位置的远近不同,前方物体出现的视角变化也不同,即产生的光流存在差异。距离摄像头近的物体视角变化较大,产生光流较大,距离摄像头远的物体,视角变化较小,产生光流较小,距离为无穷远时,光流为零[27]。利用这一原理来估计障碍物到无人机的距离。

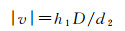

如图 6所示,L为危险距离,到无人机的距离大于L的区域为安全区域,小于L的区域为危险区域。若目标物体进入无人机危险区域,则会影响到无人机飞行,判定其为障碍物,需要采取避障行为;若未进入危险区域,则判定为非障碍物,则飞行路线不变。如图 6中所示,检测到前方有3个物体,其中物体Ⅰ进入了危险区域,物体Ⅱ、Ⅲ未进入危险区域,因此物体Ⅰ为障碍物,物体Ⅱ、Ⅲ不是障碍物。

|

| 图 6 障碍物检测模型 Fig. 6 Obstacle detection model |

由2.1节内容知,径向光流与特征点到图像中点的距离h1成正比,与基线长度D成正比,与物距d2成反比,当物距d2大于危险距离L时无人机处于安全状态,取d2=L处的光流值作为核心阈值WL。核心阈值可以表示为

(13)

(13)

试验发现,越靠近图像中点的系统误差越大,图像中点的理论光流为0,但真值往往不为0,会引起障碍物的误检。为避免这一现象,给阈值增加一个较小的基本阈值W0,通常基本阈值W0的取值范围为0.1~0.3。检测障碍物所用的检测阈值W为核心阈值与基础阈值之和,公式如下

(14)

(14)

比较径向光流与检测阈值的大小,若径向光流大于检测阈值,则物距d2小于危险距离L,检测到前方有障碍物,若径向光流小于检测阈值,则前方物体未进入无人机危险区域,检测到无障碍物。

径向光流检测障碍物算法的实现流程如下:

(1) 通过金字塔LK光流法求解两帧图像上同名点的光流向量集合

(15)

(15)

式中,n为同名点个数;n∈N;Ja为光流向量集合;(asi, aei)为每个光流的起点与终点。

(2) 计算两帧图像的切向光流vq。

(3) 求解金字塔LK光流与切向光流的矢量差,得到径向光流的向量集合

(16)

(16)

式中,(bsi, bei)=(asi, aei-vq)。

(4) 计算每个径向光流的大小

(17)

(17)

(5) 计算前一帧图像上的特征点到图像中心点的距离

(18)

(18)

式中,(Ox, Oy)是图像中点的坐标。

(6) 将径向光流中|vji|>0.3h1i的奇异点从向量集合中剔除。

(7) 根据已知的危险距离L、基线长度D设定检测阈值W

(19)

(19)

(8) 比较径向光流与检测阈值,当|vji|>Wi时,认为障碍物进入无人机的危险区域。

3 试验本节设计了两组试验对径向光流检测障碍物算法的性能进行验证,采用高精度视觉导航工控平台模拟无人机飞行进行半实物仿真试验,采用四旋翼无人机进行实际飞行试验。

3.1 半实物仿真试验半实物仿真试验以高精度视觉导航工控平台为试验平台,如图 7所示。该平台可以控制摄像机上下、左右、前后运动,误差为0.01 mm,摄像机像素为640×480像素。试验用沙盘模拟障碍物,用摄像机的移动模拟无人机飞行,摄像机方向始终竖直向下,摄像机的上下移动为径向移动,摄像机的前后左右移动为切向移动。由于该设备的精度高,误差小,因此试验结果具有较高的可靠性。

|

| 图 7 高精度视觉导航工控平台 Fig. 7 High-precision visual navigation industrial control platform |

试验1:分别用传统金字塔LK光流与径向光流检测障碍物

摄像机在高为1.9 m处拍摄第1帧图像,向下移0.1 m又向右移0.05 m后拍摄第2帧图像。由于沙盘有0.2 m的起伏高度,所以物距d2的取值范围为1.6~1.8 m,摄像机的切向移动产生了切向光流。分别用金字塔LK光流与径向光流对障碍物(有光流的区域)进行检测。

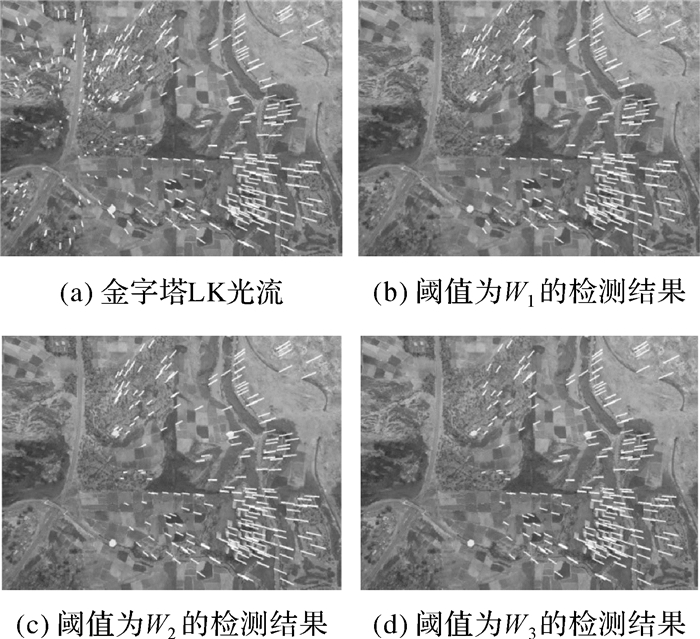

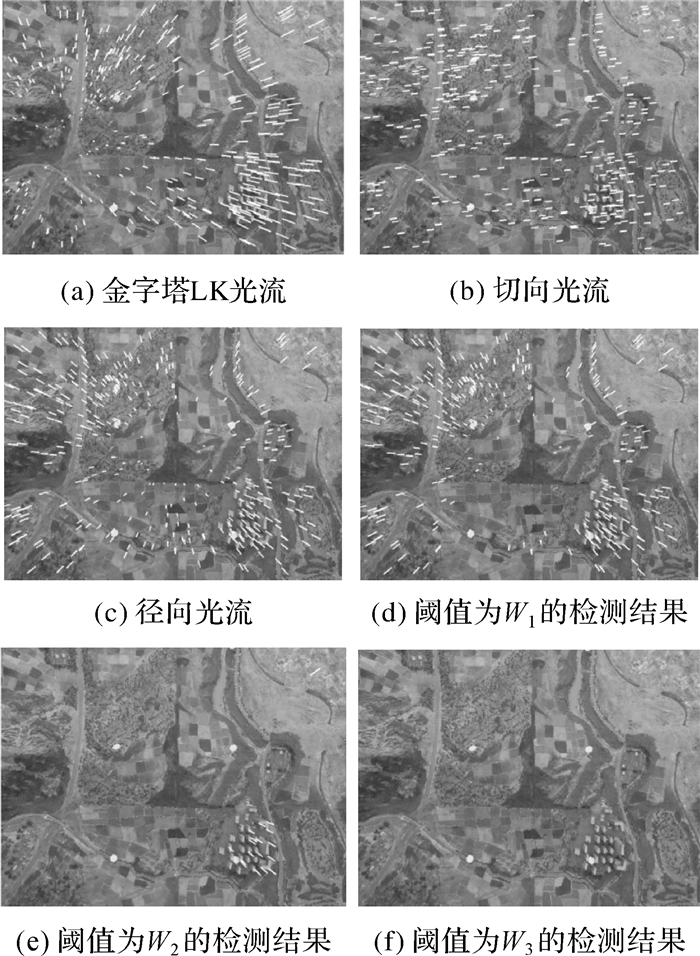

图 8为金字塔LK光流的障碍物检测结果。图 8(a)为金字塔LK光流。根据危险距离L设定阈值,当L为1.8 m、1.7 m、1.6 m时对应的阈值为W1、W2、W3。比较金字塔LK光流与检测阈值检测障碍物,其理想结果为:L=1.8 m时,整个沙盘进入危险区域,全区域都有光流;L=1.7 m时,只有沙盘凸起处进入危险区域,部分区域有光流;L=1.6 m时,全区域未进入危险区域,无光流。实际检测结果如图 8(b)、(c)、(d)所示,左侧较小的光流被剔除,右侧较大的光流未被剔除,与理想结果完全不符合。因此,当存在切向光流时,传统金字塔LK光流不能准确检测到障碍物。

|

| 图 8 金字塔LK光流检测障碍物 Fig. 8 Pyramid LK optical flow detect obstacle |

图 9为径向光流的障碍物检测结果。图 9(a)为金字塔LK光流,图 9(b)为切向光流,图 9(c)为径向光流。比较径向光流与检测阈值的大小检测障碍物,图 9(d)为L=1.8 m时阈值W1的检测结果,全区域都有光流;图 9(e)为L=1.7 m时阈值W2的检测结果,只有沙盘凸起区域有光流;图 9(f)为L=1.6 m时阈值W3的检测结果,全区域无光流,检测结果与理想结果完全符合。因此,径向光流可以规避切向光流的影响,准确检测到障碍物。

|

| 图 9 径向光流检测障碍物 Fig. 9 Radial optical flow detect obstacle |

试验2:在不同物距、不同阈值条件下用径向光流检测障碍物

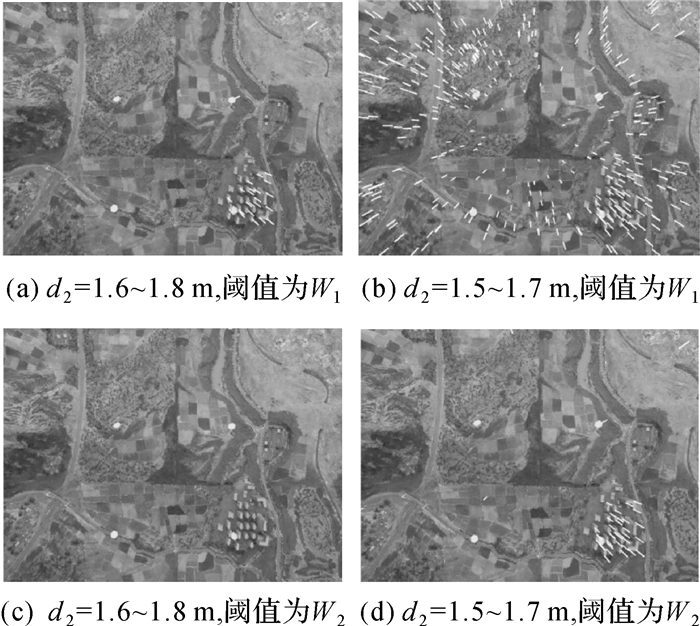

摄像机在高为1.9 m、1.8 m、1.7 m处各拍摄一帧图像,且在拍摄过程中除了径向移动,还有切向移动。第1、2帧图像的物距d2的范围为1.6~1.8 m,第2、3帧图像的物距d2的范围为1.5~1.7 m,危险距离L=1.7 m对应阈值W1,L=1.6 m对应阈值W2。若物距d2小于危险距离L,则这一区域进入危险区域,可判定其为障碍物。比较径向光流与检测阈值检测障碍物,结果如图 10所示。

|

| 图 10 障碍物检测结果 Fig. 10 Obstacle detection results |

当物距d2=1.6~1.8 m,L=1.7 m,阈值为W1时,检测结果如图 10(a)所示,沙盘上只有凸起部分为障碍物;当物距d2=1.5~1.7 m,L=1.7 m,阈值为W1时,如图 10(b)所示,整个沙盘都是障碍物;当物距d2=1.6~1.8 m,L=1.6 m,阈值为W2时,如图 10(c)所示,全区域无障碍物;当物距d2=1.5~1.7 m,L=1.6 m,阈值为W2时,如图 10(d)所示,沙盘上凸起区域为障碍物。从试验结果可以看出,当物体进入危险区域时径向光流可以准确检测到障碍物。

半实物仿真试验结果表明,径向光流可以规避切向光流引入的误差,检测效果远高于传统的金字塔LK光流法,当障碍物进入预设的危险区域时,用径向光流可以准确的检测到障碍物。

3.2 无人机实际飞行试验采用四旋翼无人机进行室外实际飞行试验对本文提出的障碍物检测算法的性能进行验证。旋翼无人机主要参数如下:最大时速为20 km/h;最长飞行时间为25 min;CCD摄像机像素为480×270像素。用无人机采集图像,然后用PC平台进行数据处理,最后用算法进行障碍物检测。

试验1:室外环境下分别用传统金字塔LK光流与径向光流检测障碍物。

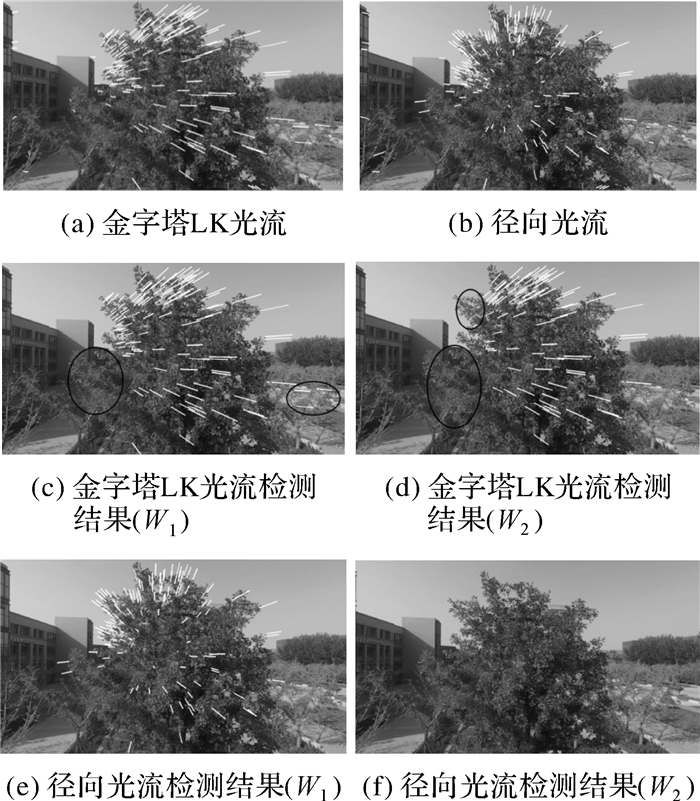

本试验以距离无人机较近的树冠为目标障碍物,其他物体作为背景,无人机以1 m/s的速度向前飞行,在风的作用下有向左的切向移动。每隔0.5 s采集一帧图像,采用距离目标障碍物约为5 m和4.5 m的两帧图像进行试验。由此可知物距d2=4.5 m,基线长度D=0.5 m,当危险距离L为4.5 m、3.5 m时,对应的阈值W1、W2。分别用金字塔LK光流和径向光流检测障碍物,结果如图 11所示。

|

| 图 11 障碍物检测结果 Fig. 11 Obstacle detection results |

图 11(a)为金字塔LK光流,图 11(b)为径向光流。图 11(c)、(d)为金字塔LK光流法的检测结果,当L=4.5 m,阈值为W1时,如图 11(c)所示,左侧黑色线框中不该被剔除的光流被剔除,存在漏检,右下角黑色线框中该被剔除的光流未被剔除,存在误检;当L=3.5 m,阈值为W2时,如图 11(d)所示,左侧漏检区域变得更大。图 11(e)、(f)为径向光流法的检测结果,当L=4.5 m,阈值为W1时,如图 11(e)所示,可准确检测到障碍物;当L=3.5 m,阈值为W2时,如图 11(f)所示,检测到无障碍物。从试验结果可以看出,当存在切向光流时,传统金字塔LK光流法会有漏检或错检,而径向光流可以准确检测到障碍物。

试验2:在不同物距、不同阈值条件下用径向光流检测障碍物。

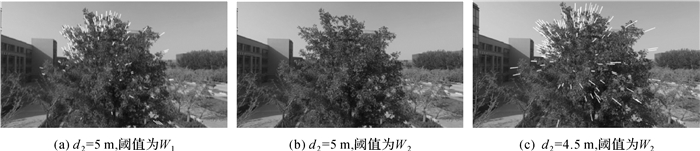

无人机飞行环境不变,采用距离目标障碍物分别约为5.5 m、5 m和4.5 m的3帧图像进行试验。基线长度D=0.5 m,第1、2帧图像的对应物距d2=5 m,第2、3帧图像的对应物距d2=4.5 m。取危险距离L为5 m、4.5 m时对应的阈值为W1、W2。用径向光流检测障碍物,结果如图 12所示。

|

| 图 12 障碍物检测结果 Fig. 12 Obstacle detection results |

图 12(a)为d2=5 m,阈值为W1时的障碍物检测结果,可检测到目标障碍物;图 12(b)为d2=5 m,阈值为W2时的检测结果,检测到无障碍物,此时目标障碍物未进入危险区域;图 12(c)为d2为4.5 m,阈值为W2时的检测结果,可检测到目标障碍物。从试验结果看出,若障碍物进入无人机的危险区域,二者之间的距离小于危险距离,则用径向光流可以检测到障碍物,若障碍物未进入危险区域,二者之间的距离大于危险距离,则检测结果为无障碍物。

无人机实际飞行试验的结果表明:径向光流检测障碍物的方法能够规避无人机切向运动引入的误差,对障碍物的检测效果良好,可以满足无人机室外环境下的自主避障需求。

4 结论旋翼无人机在室外环境下运动状态多变,传统光流法不能在同时有径向运动和切向运动的情况下准确检测到障碍物,针对这一问题,本文提出了一种径向光流检测障碍物的方法。旋翼无人机的实际运动可以分解为径向运动和切向运动,用金字塔LK光流求解得到无人机实际运动产生的光流,通过单应矩阵求解得到切向移动产生的切向光流,二者求矢量差可得无人机径向移动产生的径向光流。径向光流与被检测物体的物距成反比,设无人机在危险距离处的径向光流为检测阈值,比较被检测物体产生的径向光流与检测阈值的大小可以判定被检测物体是否进入危险区域,从而检测出障碍物的位置。半实物仿真试验与实际飞行试验结果表明:

(1) 径向光流检测障碍物的准确性较高,当被检测物体进入无人机危险区域时可以准确检测到障碍物。

(2) 径向光流能够规避无人机切向移动引入的误差,可用于室外环境下旋翼无人机自主避障。

本文提出的障碍物检测方法为无人机自主避障提供了一种新的思路。需要指出的是,本文只是在视觉避障领域进行了初步的探究,还存在许多不足之处需要在后续工作中继续完善。

| [1] | REINEMAN B D, LENAIN L, STATOM N M, et al. Development and Testing of Instrumentation for UAV-based Flux Measurements within Terrestrial and Marine Atmospheric Boundary Layers[J]. Journal of Atmospheric and Oceanic Technology, 2013, 30(7): 1295–2954. DOI:10.1175/JTECH-D-12-00176.1 |

| [2] | 马源. 基于双目立体视觉的深度感知技术研究[D]. 北京: 北京理工大学, 2015. MA Yuan. Research on Depth Perception Based on the Binocular Stereo Vision[D]. Beijing:Beijing Institute of Technology, 2015. http://cdmd.cnki.com.cn/Article/CDMD-10007-1015030756.htm |

| [3] | CHAO Haiyang, CAO Yongcan, CHEN Yangquan. Autopilots for Small Unmanned Aerial Vehicles:A Survey[J]. International Journal of Control, Automation and Systems, 2010, 8(1): 36–44. DOI:10.1007/s12555-010-0105-z |

| [4] | ZINGG S, SCARAMUZZA D, WEISS S, et al. MAV Navigation through Indoor Corridors Using Optical Flow[C]//Proceedings of the 2010 IEEE International Conference on Robotics and Automation (ICRA). Anchorage, AK:IEEE, 2010:3361-3368. |

| [5] | LIYANAGE D K, PERERA M U S. Optical Flow Based Obstacle Avoidance for the Visually Impaired[C]//Proceedings of the 2012 IEEE Business Engineering and Industrial Applications Colloquium (BEIAC). Kuala Lumpur:IEEE, 2012:284-289. |

| [6] | LIAU Y S, ZHANG Qun, LI Yanan, et al. Non-metric Navigation for Mobile Robot Using Optical Flow[C]//Proceedings of the 2012 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). Vilamoura:IEEE, 2012:4953-4958. |

| [7] | SRINIVASAN M V, MOORE R J D, THURROWGOOD S, et al. From Biology to Engineering:Insect Vision and Applications to Robotics[M]//BARTH F G, HUMPHREY J A C, SRINIVASAN M V. Frontiers in Sensing. Vienna:Springer, 2012:19-39. |

| [8] | 徐伟杰. 基于视觉的微小型无人直升机位姿估计与目标跟踪研究[D]. 杭州: 浙江大学, 2012. XU Weijie. Research on Vision-based Pose Estimation and Object Tracking for Miniature Unmanned Helicopter[D]. Hangzhou:Zhejiang University, 2012. http://cdmd.cnki.com.cn/Article/CDMD-10335-1013185874.htm |

| [9] | 赵海, 陈星池, 王家亮, 等. 基于四轴飞行器的单目视觉避障算法[J]. 光学精密工程, 2014, 22(8): 2232–2241. ZHAO Hai, CHEN Xingchi, WANG Jialiang, et al. Obstacle Avoidance Algorithm Based on Monocular Vision for Quad-rotor Helicopter[J]. Optics and Precision Engineering, 2014, 22(8): 2232–2241. |

| [10] | ERESEN A, İMAMOǦLU N, ÖNDER EFE M. Autonomous Quad Rotor Flight with Vision Based Obstacle Avoidance in Virtual Environment[J]. Expert Systems with Applications, 2012, 39(1): 894–905. DOI:10.1016/j.eswa.2011.07.087 |

| [11] | 易礼智. 基于机器视觉的避障智能小车系统研究[D]. 长沙: 中南大学, 2012. YI Lizhi. Research on Obstacle Avoidance Smart Car System Based on Machine Vision[D]. Changsha:Central South University, 2012. http://cdmd.cnki.com.cn/Article/CDMD-10533-1014148321.htm |

| [12] | 郑海华. 基于视觉的平地探测机器人避障研究[D]. 长沙: 中南大学, 2014. ZHENG Haihua. Research on Obstacle Avoidance of Flat Detection Robot Based on Vision[D]. Changsha:Central South University, 2014. http://cdmd.cnki.com.cn/Article/CDMD-10533-1014408359.htm |

| [13] | 刘正东, 高鹏, 杨静宇. 一种用于道路避障的双目视觉图像分割方法[J]. 计算机应用研究, 2005, 22(4): 249–251. LIU Zhengdong, GAO Peng, YANG Jingyu. Binocular Image Segmentation Algorithm for Obstacles Avoidance[J]. Application Research of Computers, 2005, 22(4): 249–251. |

| [14] | KENDOUL F, FANTONI A, NONAM A. Optic Flow-based Vision System for Autonomous 3D Localization and Control of Small Aerial Vehicles[J]. Robotics and Autonomous Systems, 2009, 57(6-7): 591–602. DOI:10.1016/j.robot.2009.02.001 |

| [15] | GRIGORESCU S M, MACESANU G, COCIAS T T, et al. Robust Camera Pose and Scene Structure Analysis for Service Robotics[J]. Robotics and Autonomous Systems, 2011, 59(11): 889–909. |

| [16] | VO V, LY N. An Effective Approach for Human Actions Recognition Based on Optical Flow and Edge Features[C]//Proceedings of the 2012 International Conference on Control, Automation and Information Sciences (ICCAIS). Ho Chi Minh City:IEEE, 2012:24-29. |

| [17] | CHATTERJEE A, RAKSHIT A, SINGH N N. 基于视觉的自主机器人导航[M]. 连晓峰, 译. 北京: 机械工业出版社, 2014. CHATTERJEE A, RAKSHIT A, SINGH N N. Vision Based Autonomous Robot Navigation[M]. LIAN Xiaofeng, trans. Beijing:Machinery Industry Press, 2014. |

| [18] | 张正鹏, 江万寿, 张靖. 自适应运动结构特征的车载全景序列影像匹配方法[J]. 测绘学报, 2015, 44(10): 1132–1141. ZHANG Zhengpeng, JIANG Wanshou, ZHANG Jing. An Matching Method for Vehicle-borne Panoramic Image Sequence Based on Adaptive Structure from Motion Feature[J]. Acta Geodaetica et Cartographica Sinica, 2015, 44(10): 1132–1141. DOI:10.11947/j.AGCS.2015.20140622 |

| [19] | BRADSKI G, KAEHLER A. 学习OpenCV[M]. 于仕琪, 刘瑞祯, 译. 北京: 清华大学出版社, 2009: 358-366. BRADSKI G, KAEHLER A. Learning OpenCV[M]. YU Shiqi, LIU Ruizhen, trans. Beijing:Tsinghua University Press, 2009:358-366. |

| [20] | 李佳田, 李显凯, 李应芸, 等. 航空图像光流场的逆向金字塔计算方法[J]. 测绘学报, 2016, 45(9): 1059–1064. LI Jiatian, LI Xiankai, LI Yingyun, et al. A Backward Pyramid Oriented Optical Flow Field Computing Method for Aerial Image[J]. Acta Geodaetica et Cartographica Sinica, 2016, 45(9): 1059–1064. DOI:10.11947/j.AGCS.2016.20150367 |

| [21] | HARTLEY R, ZISSERMAN A. Multiple View Geometry in Computer Vision[M]. Cambridge: Cambridge University Press, 2004. |

| [22] | EBERLI D, SCARAMUZZA D, WEISS S, et al. Vision Based Position Control for MAVs Using One Single Circular Landmark[J]. Journal of Intelligent & Robotic System, 2011, 61(1-4): 495–512. |

| [23] | HARTLEY R, ZISSERMAN A. 计算机视觉中的多视图几何[M]. 韦穗, 杨尚骏, 章权兵, 译. 合肥: 安徽大学出版社, 2002. HARTLEY R, ZISSERMAN A. Multiple View Geometry in Computer Vision[M]. WEI Hui, YANG Shangjun, ZHANG Quanbing, trans. Hefei:Anhui University Press, 2002. |

| [24] | 崔燕茹. 基于双目视觉的障碍物识别与重建[D]. 南昌: 南昌航空大学, 2012. CUI Yanru. Obstacle Recognition and Reconstruction Based on Binocular Vision[D]. Nanchang:Nanchang Hangkong University, 2012. http://cdmd.cnki.com.cn/Article/CDMD-10406-1012032800.htm |

| [25] | STEFANOSKI N, WANG O, LANG M, et al. Automatic View Synthesis by Image-domain-warping[J]. IEEE Transactions on Image Processing, 2013, 22(9): 3329–3341. DOI:10.1109/TIP.2013.2264817 |

| [26] | 夏军营, 徐小泉, 熊九龙. 利用平行透视投影模型的位姿迭代估计[J]. 光学精密工程, 2012, 20(6): 1342–1349. XIA Junying, XU Xiaoquan, XIONG Jiulong. Iterative Pose Estimation Using Paraperspective Camera Model[J]. Optics and Precision Engineering, 2012, 20(6): 1342–1349. |

| [27] | 戴碧霞. 基于光流的微小型飞行器室内避障方法研究[D]. 成都: 电子科技大学, 2015. DAI Bixia. Research on Obstacle Avoidance Method of MAV in Indoor Environment Based on Optical Flow[D]. Chengdu:University of Electronic Science and Technology of China, 2015. http://cdmd.cnki.com.cn/Article/CDMD-10614-1015708658.htm |