2. 武汉大学资源与环境科学学院, 湖北 武汉 430079

2. School of Resources and Environmental Science, Wuhan University, Wuhan 430079, China

随着传感器、计算机和网络通信技术的发展,各行各业产生的数据呈现爆炸式增长,人类社会已经进入大数据时代。在大数据时代,数据采集的方式越来越多样化,数据传输的效率越来越高效化,数据存储的规模越来越海量化,由此产生的大数据具有体量大(volume)、类型多(variety)、价值密度低(value)、处理速度快(velocity)和真实性低(veracity)等基本特征[1]。数据是信息的载体,“大数据中蕴藏着关乎社会动向、市场变化、科技发展、国家安全的重要战略资源”,文献[2]指出“未来的信息世界是‘三分技术,七分数据’,得数据者得天下”。然而,海量规模的大数据已远超出传统信息处理系统的处理能力,因此,有必要发展可行、高效的大数据处理技术。

大数据时代是当前摄影测量面临的新的时代背景,它的到来给作为地理空间信息提取主要手段的摄影测量的发展带来了新的机遇。摄影测量大数据包含两类数据:新获取的影像数据(包括可能同时获取的定位、定姿、LiDAR)和已有的、处理过的地理空间信息数据。一方面,随着各种新型航空传感器的不断涌现、低空无人机的广泛应用和其他消费级摄影设备的普及,影像获取方式越来越简单、快捷,由此带来了航空、车载影像爆发式的增长。相对于传统航测获取的影像,这些影像具有如下特点:① 影像数据量大;② 获取周期短,时效性高;③ 规范性弱,缺乏严格的航线规划;④ 大多为非量测型相机拍摄,相对于量测型相机而言,影像几何质量不高。另一方面,经过测绘部门几十年的测绘生产实践,我国已经积累了大量的地理空间信息数据,包括数字正射影像图(DOM)、数字高程模型(DEM)、数字线划地图(DLG)等,这些已有地理空间信息产品数据可作为控制信息。另外必须强调的是,激光探测与测量(light detection and ranging, LiDAR)数据与已知定向参数的影像都是重要的地理空间信息控制数据。

摄影测量大数据的智能化处理是现阶段摄影测量迫切需要解决的问题。通过空中三角测量,获取航空影像精确内外方位元素,是摄影测量处理的首要任务。摄影测量大数据的空中三角测量处理主要包含两方面的问题:① 如何对新获取的影像进行快速、高效、自动、智能的摄影测量处理以获取准确的地理空间信息;② 如何将已有地理空间信息数据作为控制信息,有效地用于新获取影像的摄影测量处理过程,以提高处理效率和精度。对于前者,得益于SIFT[3]等特征匹配技术、基于词汇树的图像检索技术[4]、“运动恢复结构”技术[5](structure from motion, SfM)和针对非量测相机物镜畸变的自检校平差技术[6-7]的发展,摄影测量和计算机视觉领域在空中三角测量方面取得了长足的进步,涌现了如Smart3DCapture(现改名为ContextCapture)、Pix4Dmapper、PhotoScan等软件,可实现低空无人机正视与倾斜影像的全自动空中三角测量处理,但它们在实际应用中仍然存在诸多问题,如对于某些正常数据无法处理出正确结果、处理流程难以满足摄影测量实际处理要求等;对于后者,随着摄影测量处理时效性要求的提高,文献[8]在基于DOM+DEM的卫星影像自动定向方面进行大量的深入研究,并在此基础上研发了DPGrid正射影像更新软件,广泛应用于中小比例尺(1:5000至1:50 000) 的正射影像更新生产实践之中;近年来,随着LiDAR技术的兴起和快速发展,利用LiDAR设备获取的高密度、高精度激光点云并结合航空影像数据,被越来越多地应用于城市场景大比例尺(1:500至1:2000) 的三维重建之中。这其中首先需要解决的便是LiDAR点云与航空影像的几何坐标一致性问题,为此,文献[9]在航空影像和LiDAR点云的几何配准方向进行了研究。

1 “云控制”摄影测量的背景与概念摄影测量与遥感的实质是从影像中提取被摄对象的几何与辐射信息,国际摄影测量与遥感学会(ISPRS)从2000年在阿姆斯特丹举行的第十九次代表大会开始,便将“information from imagery”作为其标语[10],其中遥感关注于提取辐射信息,而摄影测量关注于提取几何信息。摄影测量的处理过程便是在控制信息的约束下,将原始的影像数据加工为DOM、DEM、DLG和数字表面模型(DSM)等地理空间信息产品。

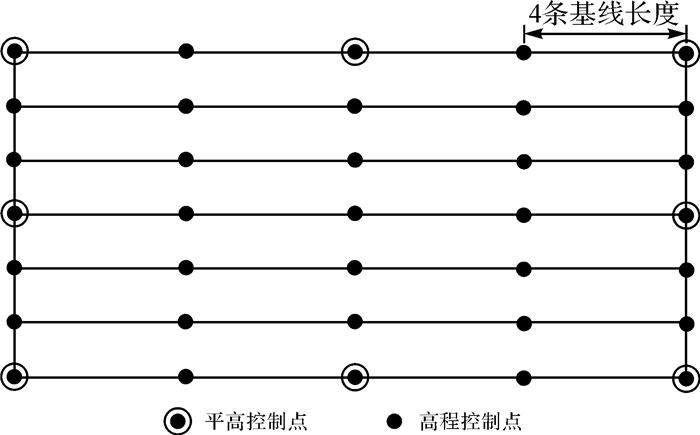

传统摄影测量的控制信息为外业采集的控制点,这些点一般位于地面上明显标志点,如圆点、交点和角点等,在此称之为“点控制”摄影测量。为保证空三加密和立体测图的精度,“点控制”摄影测量的控制点分布需要遵守严格的作业规范,如图 1所示,一般要求测区周边布设平高控制点,测区内部按一定倍数的基线长度布设多排高程控制点。对于传统量测型相机而言,由于影像像幅大,测区影像数量少,需要控制点的数量有限;然而,现阶段广泛使用的无人机影像,其像幅小、几何畸变大和质量不佳等特点,决定了其空三加密需要大量的控制点。尽管GNSS技术降低了外业控制点采集的难度,然而,测量外业控制点仍然十分困难与耗时,造成测量外业控制点的时间远超过影像获取的时间。显然,外业控制点量测仍然是制约航测空三加密效率的关键因素,导致“点控制”摄影测量已难以适应大数据时代影像数据的特点和其对处理效率和高度自动化的要求。

|

| 图 1 “点控制”摄影测量的控制点分布示意图 Fig. 1 Distribution of control points in "points control" photogrammetry |

为了解决以上问题,本文提出“云控制”摄影测量(“cloud control” photogrammetry)的概念,它的提出,具备“控制数据”和“处理技术”两方面的支撑。前者指的是:已有地理空间信息数据(包括公众地理信息数据,如Google Earth影像、天地图影像、SRTM数字高程模型、OpenStreetMap地图数据等)、LiDAR点云和已知定向参数(如卫星影像姿轨参数以及由此拟合计算的有理多项式系数——RPC参数、航空影像内外方位元素)的影像(框幅式航空影像、线阵扫描航空影像和卫星影像——称已有影像)等,它们都处在统一的地理空间信息框架内,为新获取的新影像数据构成了“控制框架”;后者指的是:通过新影像之间的匹配构建空三自由网,以及通过新影像与已有影像的匹配或与控制框架内其他数据的配准,从中为新影像自由网的加密点获取大量密集的控制信息。由于其获取的控制点非常密集,形成了控制点云,因此称之为“云控制”。“云控制”概念中的“云”取自密集点云(point cloud)[11]的“云”。

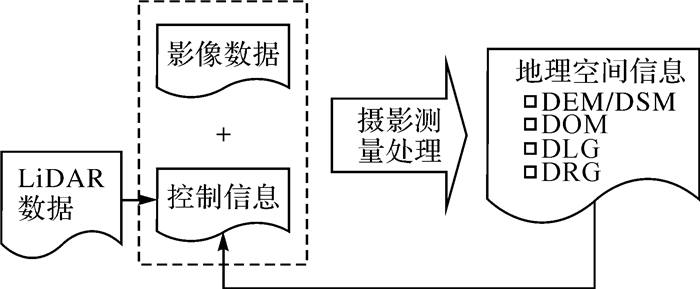

“云控制”摄影测量将改变摄影测量处理的模式。传统摄影测量处理是从影像数据到地理空间信息的单向过程,即生产的地理空间信息作为产品归档后不会返回至摄影测量处理过程;如图 2所示,“云控制”摄影测量处理则是一个“闭合”的回路,生产的地理空间信息产品(图 2右侧的DEM/DSM、DOM、DLG等产品数据)将作为控制信息用于以后的摄影测量处理过程,从而实现地理空间信息“从摄影测量生产中来,又回到摄影测量生产中去”。另外,具有地理信息的LiDAR数据也可以作为“云控制”的一种控制信息。

|

| 图 2 “云控制”摄影测量的闭合作业模式 Fig. 2 Closed production mode of "cloud control" photogrammetry |

2 “云控制”摄影测量的几种形式和应用

“云控制”摄影测量的实质是控制方式的改变,相对于“点控制”摄影测量,它使用带有精确地理信息的几何参考数据替代外业控制点作为控制。根据所使用的几何参考数据的不同,“云控制”摄影测量具有3种形式:① 基于影像的云控制;② 基于矢量的云控制;③ 基于LiDAR点云(包括DLG)的云控制。

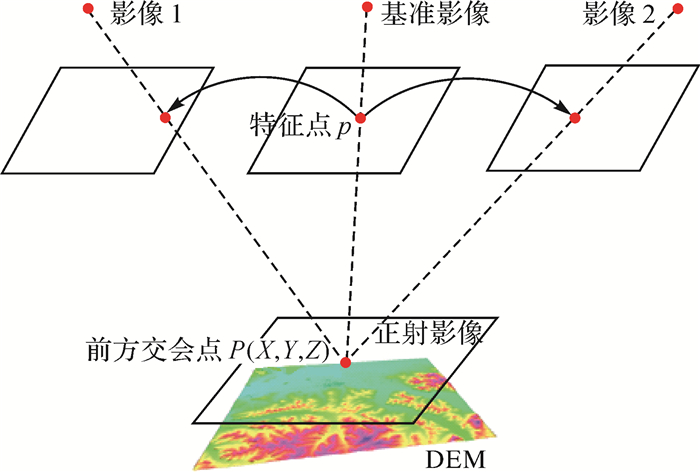

2.1 基于影像的云控制从正射影像(与DEM)和已知定向参数的原始影像都可以提取精确的空间位置,前者不言而喻,后者指的是利用定向参数进行同名像点(用于控制)的前方交会获取三维物方坐标。基于影像的云控制又可以分为基于DOM+DEM的云控制和基于已知定向参数的影像的云控制两种方式。

2.1.1 基于DOM+DEM的云控制基于DOM+DEM的云控制通过新影像与正射影像的自动匹配提取控制点,控制点自动提取的原理示意如图 3所示。首先,在新影像上提取特征点,通过自动影像匹配将提取的特征点匹配到周边的影像,从而获取连接点;其次,使用新影像的定向参数初值(可通过原始定向参数辅助下的自由网定向获得),对连接点进行前方交会,计算其初始地面坐标;然后,在正射影像上的对应地面范围内匹配同名像点,根据正射影像的平面坐标与DEM上的高程,获得连接点对应控制点的三维物方坐标。

|

| 图 3 基于DOM/DEM的控制点自动提取示意图 Fig. 3 Schematic diagram of automatic control points extraction from DOM and DEM |

基于DOM+DEM的云控制模式已经获得广泛的应用,国内学者利用该方法实现了国产高分辨率卫星影像的在轨几何标定,文献[12]利用谷歌地球正射影像和SRTM为控制实现了资源三号卫星影像的在轨几何标定,文献[13]则基于公众地理信息数据实现资源一号02C卫星全色与多光谱影像的在轨几何标定;在航空影像方面,以下列举一个例子。

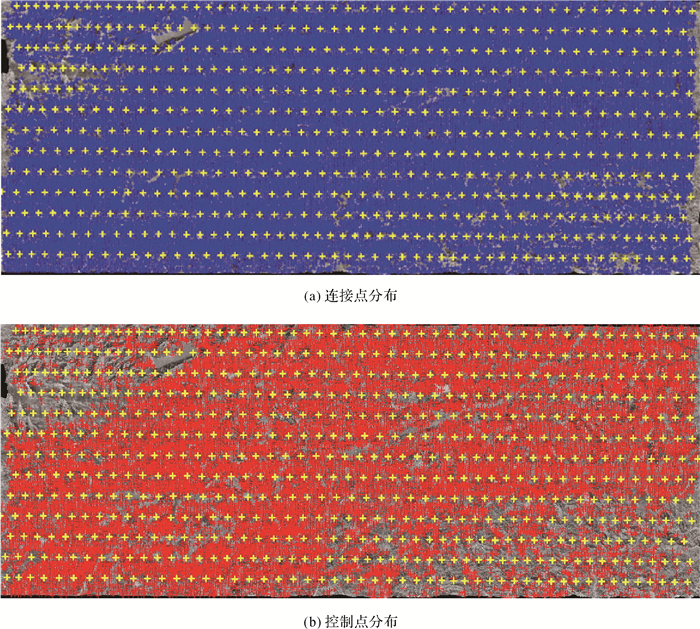

试验数据为一个含有24条航带、1267张RC30相机拍摄的航空影像的测区。摄影比例尺约为1:30 000,影像像素大小为21 μ,地面分辨率约为0.65 m。测区的西北和东南区域为覆盖有大面积茂密植被的高山地形,高程范围为50~1200 m。使用该测区5年前成图的48幅1:10 000正射影像和DEM作为控制信息,共自动匹配了276 662个连接点,其中控制点46 884个,连接点和控制点的分布如图 4所示。控制点占连接点的比例为16.95%,这与传统的“点控制”摄影测量完全不同,传统摄影测量是研究怎样减少控制点,而“云控制”则是“多多益善”。

|

| 图 4 测区前13条航带的连接点与控制点分布图(黄色十字丝为影像位置) Fig. 4 Distribution of tie points(blue) and control points(red) of the 13 strips(yellow crosses are images) |

空三单位权中误差为7.8 μ,控制点平面X和Y的中误差均为1.5 m,高程Z的中误差为2.3 m。基于该空三结果生成的正射影像图满足1:10 000比例尺正射影像精度要求,具体精度检测情况如表 1所示。

| m | ||||

| 图幅 | 地形 | 总点数 | 允许中误差 | 检测中误差 |

| 图幅1 | 平地/丘陵 | 95 | ±5 | ±2.21 |

| 图幅2 | 丘陵 | 94 | ±5 | ±2.28 |

| 图幅3 | 丘陵 | 64 | ±5 | ±1.61 |

| 图幅4 | 山地 | 66 | ±7.5 | ±1.91 |

| 图幅5 | 丘陵 | 93 | ±5 | ±1.93 |

| 图幅6 | 丘陵 | 95 | ±5 | ±1.50 |

云控制摄影测量不仅仅能实现控制的自动化,更重要的是新、老正射影像的套合比传统的点控制(或利用控制点库)方法要精确得多,也为下一步的变化检测提供了更好的底图数据。

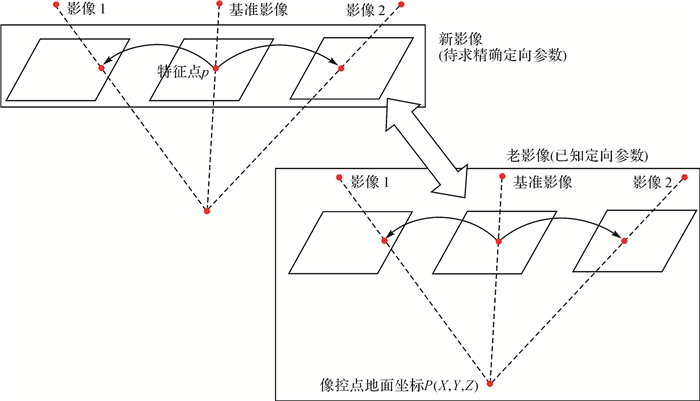

2.1.2 基于已知定向参数影像的云控制基于已知定向参数影像的云控制第一步与基于DOM+DEM的云控制一样,首先由新影像构建自由网;然后,通过新、老影像间的匹配,将新影像的自由网加密点传递给老影像,再进行老影像间的匹配;最后,使用老影像的定向参数进行前方交会,获得新影像的自由网加密点的三维物方坐标。其原理如图 5所示。

|

| 图 5 基于已知定向参数的影像的控制点自动提取示意图 Fig. 5 Schematic diagram of automatic control point extraction from images with orientation parameters |

值得注意的是,新影像与老影像既可以是同源影像(相同类型传感器拍摄的影像,如两者都是框幅式航空影像),也可以是异源的(如框幅式航空影像与线阵扫描式航空影像)。以下简单介绍一个基于已知定向参数的异源影像控制的试验实例。

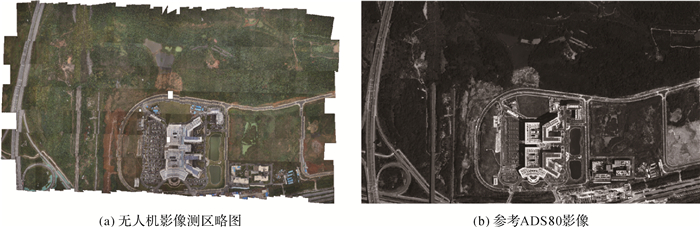

试验测区总计321张无人机影像(分辨率为6 cm,2016年10月拍摄),共7个航带,以分辨率为15 cm的ADS80影像(2016年8月拍摄,用于1:2000比例尺测图)控制数据。测区略图和参考ADS80影像如图 6所示。

|

| 图 6 无人机影像测区略图和参考ADS80影像 Fig. 6 UAV block and the reference ADS80 image |

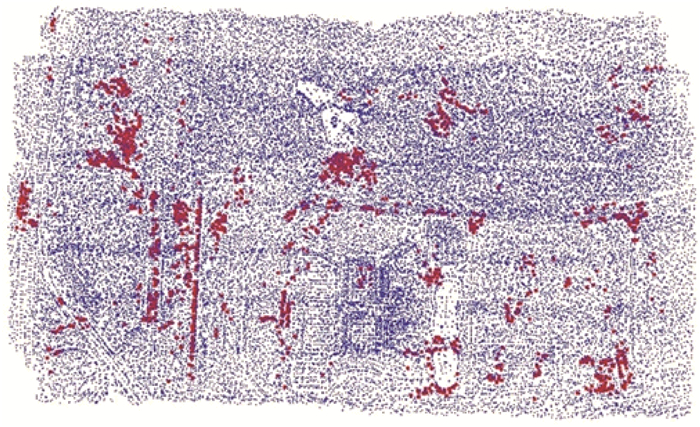

通过自动影像匹配共提取了77 649个连接点,其中控制点2832个(控制点占连接点的3.06%),如图 7所示,图中蓝色点为连接点,红色点为控制点。另外,人工量测了49个外业检查点进行精度评定。从图 7可以看出,控制点大都分布在道路和建筑物等人工地物所在区域,而对于植被区域,由于变化大、匹配难度较大,加之无人机航空影像与ADS80线阵扫描影像之间存在较大辐射差异,难以提取有效的控制点。

|

| 图 7 无人机影像测区自动提取的连接点(蓝色)和控制点(红色) Fig. 7 Tie points (blue) and control points (red) of UAV images block |

经过平差定向后,像点中误差为0.2个像素,控制点和检查点的精度如表 2所示。

| m | |||||

| 误差项 | 控制点误差 | 检查点误差 | |||

| 中误差 | 最大误差 | 中误差 | 最大误差 | ||

| 平面X | 0.19 | 1.70 | 0.18 | -0.47 | |

| 平面Y | 0.19 | -1.49 | 0.23 | -0.36 | |

| 平面XY | 0.27 | 1.72 | 0.29 | 0.59 | |

| 高程Z | 0.23 | 0.87 | 0.27 | -0.77 | |

2.1.3 两种方式的比较与讨论

由于两种方式的控制影像(一是正射影像,一是原始影像)的不同,基于DOM+DEM和基于已知定向参数的影像的云控制的方式不同,精度与适用范围也不同:

(1) 控制点获取方式不同,结果也不同。前者控制点的三维坐标来自于DOM+DEM,而DEM是地形的高度,而非地物的高度,对于诸如树木、房屋等地物上的控制点,DEM上的高程值并非真实高程,而是考虑了地物的高度;而后者可以直接获得控制点的正确三维坐标。

(2) 后者的精度(特别是高程精度)优于前者。前者适用于中小比例尺的影像几何定位,而后者可用于大比例尺的影像几何定位。

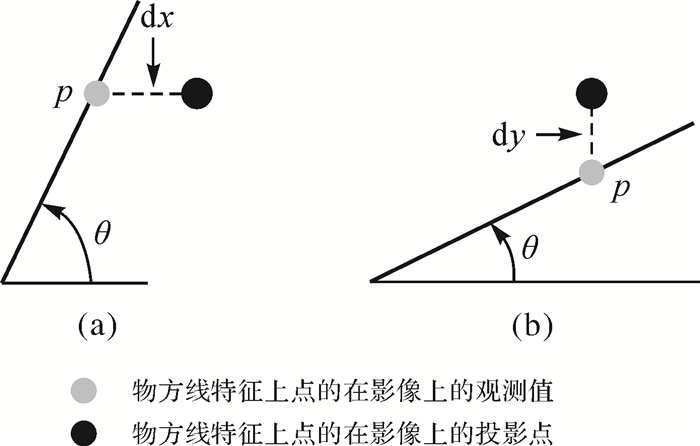

2.2 基于矢量的云控制已有的矢量数据具有地物信息(道路、河流等线状地物),也可以作为“云控制”数据。但是基于矢量的云控制存在两个难点:首先,由于线特征控制与影像的像点观测没有严格的对应关系,因此,基于线特征控制条件的影像定位方法需要对传统的基于控制点的定位方法进行扩充;其次,由于影像和矢量是两种完全不同类型的数据,二者之间的自动配准也是一个难点。前者可以通过广义点摄影测量理论[14]解决;而后者,学者们研究了很多影像与矢量自动配准的方法。

2.2.1 广义点摄影测量理论摄影测量起源于测量学中“测点”的前方交会和后方交会,所涉及的点都是影像上可以明显判别的点(明显点),为了将大量线特征(如道路线、建筑物边缘线等)作为控制信息进行影像几何定位,必须将点扩展到线。传统的点可以列x、y两个误差方程式,而广义点(线)则根据影像线特征角度的大小选择性地列出一个误差方程式。如图 8所示,设p点所在特征线与水平方向夹角为θ,当-45° < θ≤45°或当135° < θ≤225°时(见图 8(a)),特征点在x方向残差(特征点在影像上观测坐标与对应物方点在影像上投影坐标之差)较小,可列像点观测值x的方程;否则,则列像点观测值y的方程,参与摄影测量处理的平差计算。直观地理解特征线上一个点就相当于“半个”特征点,其他没有差别。基于线的“云控制”与基于点“云控制”完全兼容,因此“广义点”非常灵活、非常方便。

|

| 图 8 广义点所在处线特征与水平方向夹角的两种情况 Fig. 8 Two kinds of generalized points according to angles between the line features the horizontal direction |

2.2.2 影像与矢量自动配准方法

目前较为常见的方法是利用矢量数据中的道路矢量线与影像进行自动配准。文献[15]研究了矢量与遥感影像自动配准的方法,实现了遥感影像的自动纠正和地理编码以及矢量地图的自动配准,为地形图快速修测与地理信息数据的快速更新奠定了基础;文献[16-17]研究了基于道路中心线检测的影像与矢量自动配准的方法,该方法将影像与道路矢量线的配准问题转化为道路中心线的检测问题,通过将道路矢量投影到影像,并沿着投影向量的垂直方向在一定范围内使用边缘的阶跃模板检测道路的两个边缘,从而确定道路的中心点位置,实现矢量地图与高分辨率卫星影像的自动配准。

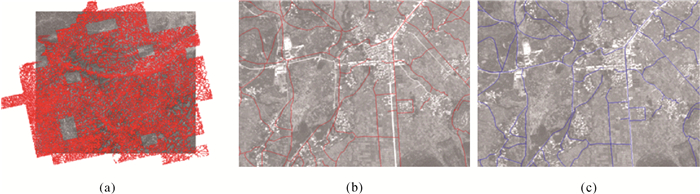

图 9所示为利用基于道路中心线检测的影像与矢量自动配准方法进行SPOT 5影像与矢量地图配准的试验,其中图(a)为影像与矢量(红线)的整体套合图,图(b)为局部区域影像与矢量(红线)的套合情况,图(c)为自动配准后影像与矢量(蓝线)的套合情况。试验区共匹配了7062条矢量线,检测了77 953个道路中心点作为SPOT 5影像定向的控制点,采用广义点摄影测量理论进行定向的像点中误差为1.45像素。从图 9中可以看出,自动配准后影像与矢量的套合一致性较好,有效地实现了基于矢量地图的影像几何定位。

|

| 图 9 SPOT 5影像与矢量的自动配准 Fig. 9 Automatic registration between SPOT 5 satellite image and vector map |

基于广义点的现有影像与矢量自动配准方法,虽然能较好地解决小比例尺矢量控制的影像几何定位问题,然而对于大中比例尺的情况,由于场景更加复杂,影像和矢量数据的信息更加丰富,如矢量数据中道路线由单线矢量变为双线矢量、建筑物轮廓线、影像上道路宽度更大,且地物遮挡现象严重,影像与矢量配准的难度更大,尚需继续研究。

2.3 基于LiDAR点云与DLG的云控制DLG虽有高程注记点,但是它是二维的平面(X、Y)图,不能独立用于摄影测量的云控制,只有与LiDAR构成多元云控制。下面首先介绍基于LiDAR的云控制,然后介绍两者相结合的多元云控制。

LiDAR可快速获取大范围、高精度的地表几何数据,已成为当前获取高精度地形与地表信息的一种重要手段。由于其获取的地物表面信息比较全面,且精度较高,因此又常用作光学影像几何定位的基准,实现光学影像的精确几何定位。本文称“基于LiDAR点云的光学影像精确几何定位”为基于LiDAR的云控制。

基于LiDAR的云控制需要研究两个关键问题:首先,需要对LiDAR点云精度进行评定;其次,影像和LiDAR点云属于两种不同类型的数据。前者为栅格数据,后者为离散点云数据,二者之间的自动配准也是一个关键问题。

2.3.1 LiDAR点云精度评定LiDAR点云的精度决定了影像几何定位的精度。在LiDAR点云精度评价方面,虽然学者们以各种方式评价了LiDAR点云的精度,文献[18]从潜在的误差源上分析了LiDAR点云的理论精度,文献[19]使用检查点评价了LiDAR点云的高程精度,然而,较少有评定LiDAR点云平面精度的研究。文献[20]通过对比LiDAR的强度图与参考正射影像的方式评价了LiDAR点云的平面精度,但LiDAR强度图和参考正射影像的分辨率较低(分别为1.5 m和0.33 m),难以反映LiDAR点云的真实平面精度。

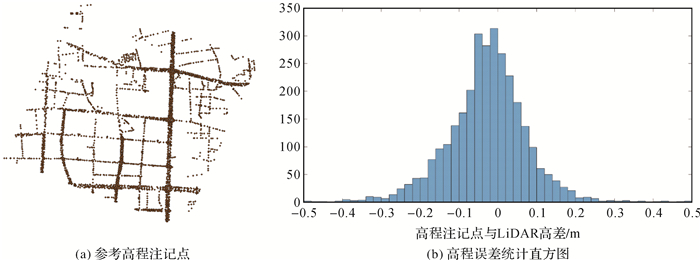

本文采用已有的1:500比例尺DLG作为基准数据评定LiDAR点云的精度。其中高程精度评定使用DLG的高程注记点,平面精度评定则使用DLG中的建筑物轮廓线。如图 10与图 11所示为试验区域LiDAR点云精度评定的情况。

|

| 图 10 试验测区LiDAR点云高程精度评定 Fig. 10 Vertical accuracy assessment for LiDAR data of test area |

|

| 图 11 试验测区LiDAR点云平面精度评定 Fig. 11 Horizontal accuracy assessment for LiDAR data of test area |

图 10为高程精度评定情况,图(a)为DLG中的高程注记点,其精度约为2~3 cm,共3030个,图(b)为高程注记点与LiDAR点云之间高程差值的分布直方图,由图 10可知LiDAR点云高程误差呈正态分布。采用图(a)的高程注记点评定的LiDAR的高程中误差为7.8 cm。

图 11为平面精度评定情况,图(a)为DLG中的房屋轮廓线,其平面精度优于5 cm,图(b)为局部区域从LiDAR点云中提取的房屋立面点与DLG中房屋轮廓线的套合图,图(c)为房屋立面点到DLG房屋轮廓线的垂直距离的统计直方图。平面精度评定共使用38 299个房屋立面点,评定的LiDAR点云平面中误差为6.9 cm(略优于高程精度)。

我国现行数字航空摄影测量规范对于平地1:500地形测图航测内业加密检查点的精度要求为平面精度优于0.175 m,高程精度优于0.28 m,由以上评定结果可知,此次评定的试验区域的LiDAR点云精度满足1:500地形图精度要求,可用作1:500内业加密的控制数据。当然,不同的LiDAR点云精度存在一定差异性,需要更多区域的精度评定结果以客观地反映LiDAR点云的真实精度。

2.3.2 影像与LiDAR点云的配准影像与LiDAR点云是由完全不同的传感器采集,二者具有不同的属性。影像为二维栅格数据,LiDAR点云为三维离散数据,二者的数据维度和类型均不相同,它们之间的配准具有一定的特殊性。影像与LiDAR点云配准的方法大致可以归纳为3类[21]:

(1) 基于二维图像匹配的方法。利用LiDAR的强度图像或点云转换为深度、距离等二维图像,将二维影像与三维LiDAR点云的配准转换为二维影像之间的配准。

(2) 基于三维点云配准的方法。通过多视影像生成的点云(稀疏空三加密点云或密集匹配点云)与LiDAR点云之间的配准,实现影像与LiDAR点云之间的配准,迭代最邻近算法[22](iterative closest point, ICP)和基于三维特征匹配[23]的方法均属于此类方法。

(3) 基于二维图像和三维点云直接匹配的方法。此类方法主要利用影像和LiDAR点云的直线特征[24]和平面特征[25]。

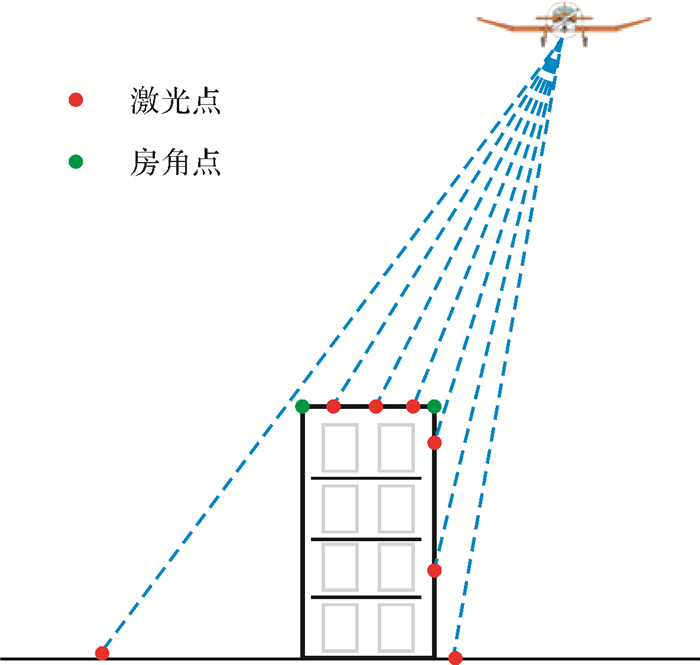

以上3类方法,具有不同的特点和适用范围。如图 12所示,由于LiDAR点云的采样密度(一般为4~10 pts/m2)相对于较易获取的超高分辨率影像(如分辨率4~10 cm的影像)来说仍然较低,LiDAR点云难以覆盖建筑物的边缘。因此,对于第1类方法,LiDAR点云转换生成的深度或距离二维图像中建筑物边缘位置和大小往往不够准确,易造成配准精度的降低;而第3类方法则大都需要人工辅助;第2类方法尤其是基于ICP的方法使用较为广泛。

|

| 图 12 LiDAR点云扫描间隔导致的不完整性问题 Fig. 12 The incompleteness of the LiDAR point cloud caused by big scan interval |

ICP算法最早由Besl和McKay于1992年提出,是两组三维点云之间几何配准的经典算法。其基本原理如图 13所示,对于p和q(基准)表示的两组点云,通过最小化最临近点的距离实现它们之间的配准。一般采用两种最近原则:点间距离最近原则(见图 13(a))和点面距离最近原则(见图 13(b))。ICP的改进算法常常被直接或间接地应用于影像与三维点云的几何配准之中。文献[26-27]研究了ICP与区域网平差相结合并迭代解算的方法,在每次空三区域网平差之后,利用ICP算法配准空三加密点和LiDAR点云,筛选高质量配准点作为控制点,并再次进行区域网平差以解算新的定向参数,如此迭代,直至配准精度满足设定的阈值。该方法通过区域网平差与ICP的交叉迭代,利用大范围航空影像与LiDAR点云的自动配准实现了基于LiDAR点云的云控制。

|

| 图 13 ICP算法的基本原理 Fig. 13 The basic principle of ICP algorithm |

2.3.3 影像与LiDAR点云+DLG的配准

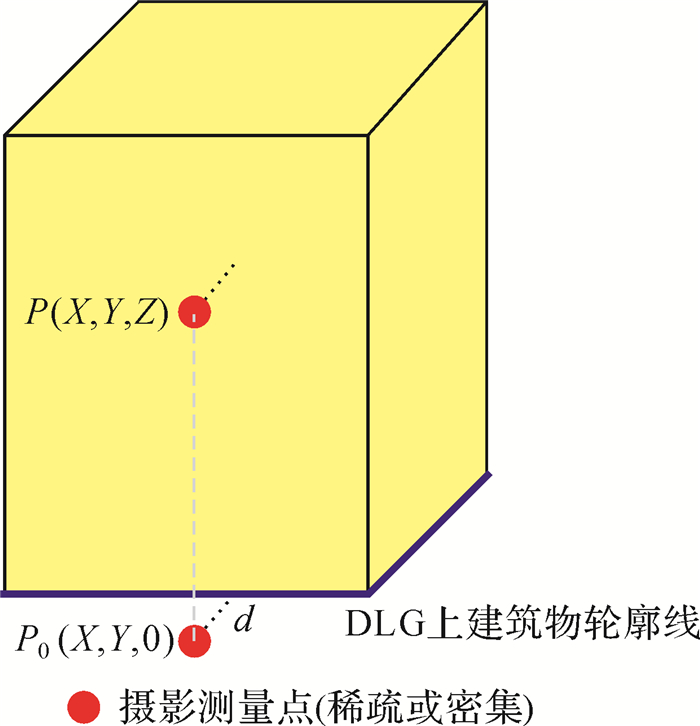

在具有DLG的情况下,LiDAR点云可与DLG组合成多元联合控制。可在LiDAR点云控制的基础上,利用DLG进一步加强平面控制。对于城市场景,DLG的控制作用主要来自建筑物的轮廓矢量线,如图 14所示,黄色立方体表示建筑物,其底部的蓝线为DLG中建筑物的轮廓矢量线,对于墙面上的摄影测量点P,通过最小化其在水平面上投影点P0到蓝线的距离d,可实现影像墙面点与DLG建筑物轮廓线平面位置的重合,进而实现DLG对影像的平面控制。

|

| 图 14 DLG建筑物轮廓矢量的平面控制原理 Fig. 14 Horizontal control from building contour vectors of DLG |

3 结束语与展望

大数据的简单算法比小数据的复杂算法更有效[28],这是大数据时代“云控制”摄影测量的核心。“云控制”摄影测量充分利用带有地理空间信息的数据替代外业控制点,实现摄影测量影像大数据的高效、自动与智能化处理,具有较大的现实意义和应用前景。“云控制”摄影测量的两个支撑条件中数据为主、技术为辅,而当前的地理空间信息数据存在以下问题:① 已有测绘地理空间信息成果的使用问题,测绘生产的大量地理空间信息没有作为控制信息有效地用于新影像的摄影测量处理之中,其价值基本没有得到发挥;② 影像数据的管理与存储问题,在现实生产中,“重成果、轻影像”,生产结束后DOM、DEM等成果作为“线上”数据保存,而对于处理的影像及其定向参数作为“线下”数据保存。为实现“云控制”摄影测量,应拓展地理空间信息数据的使用,加强已知定向参数的影像数据的存储与管理。

笔者认为,“云控制”摄影测量技术在中小比例尺影像的几何定位与数据更新方面已经成熟(特别是广泛地应用于卫星影像处理),其未来的发展趋势包括如下几点:①“云控制”摄影测量将越来越多地应用于大比例尺航空影像(特别是无人机影像)的几何定位、数据更新与测图;② LiDAR点云、大比例尺DLG等高精度参考数据的大量积累,影像分辨率的提高、信息的丰富化和地面场景的复杂化,都增加了大比例尺影像(包括倾斜影像)云控制的难度,基于单一数据的云控制可能难以较好地解决问题,因此,需要研究基于影像、DLG和LiDAR点云等多源数据联合控制的云控制方式。

致谢: 感谢武汉大学遥感信息工程学院数字摄影测量与计算机视觉中心的相关研究人员提供的相关研究成果。

| [1] | HILBERT M. Big Data for Development:A Review of Promises and Challenges[J]. Development Policy Review, 2016, 34(1): 135–174. DOI:10.1111/dpr.2016.34.issue-1 |

| [2] | 陈鲸. 大数据面临的挑战复杂艰巨[J]. 信息安全与通信保密, 2016(2): 20. CHEN Jing. Big Data Faces Complex and Arduous Challenges[J]. Information Security and Communications Privacy, 2016(2): 20. |

| [3] | LOWE D G. Distinctive Image Features from Scale-invariant Key Points[J]. International Journal of Computer Vision, 2004, 60(2): 91–110. DOI:10.1023/B:VISI.0000029664.99615.94 |

| [4] | BORE N, AMBRUS R, JENSFELT P, et al. Efficient Retrieval of Arbitrary Objects from Long-term Robot Observations[J]. Robotics and Autonomous Systems, 2017, 91: 139–150. DOI:10.1016/j.robot.2016.12.013 |

| [5] | SCHÖNBERGER J L, FRAHM J M. Structure-from-motion Revisited[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas, NV:IEEE, 2016:4104-4113. |

| [6] | FRASER C S. Digital Camera Self-calibration[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 1997, 52(4): 149–159. DOI:10.1016/S0924-2716(97)00005-1 |

| [7] | BRITO J H, ANGST R, KÖSER K, et al. Radial Distortion Self-Calibration[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Portland, OR:IEEE, 2013:1368-1375. |

| [8] | ZHANG Zuxun, LU Luping, TAO Pengjie, et al. Registration of CBERS-02B Satellite Imagery in Quick GIS Updating[C]//Proceedings of SPIE, Remote Sensing Image Processing, Geographic Information Systems, and Other Applications. Guilin, China:SPIE, 2011:8006OC. http://proceedings.spiedigitallibrary.org/proceeding.aspx?articleid=1266512 |

| [9] | ZHENG Shunyi, HUANG Rongyong, ZHOU Yang. Registration of Optical Images with Lidar Data and Its Accuracy Assessment[J]. Photogrammetric Engineering & Remote Sensing, 2013, 79(8): 731–741. |

| [10] | CHEN Jun, DOWMAN Ian, LI Songnian, et al. Information from Imagery:ISPRS Scientific Vision and Research Agenda[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2016, 115: 3–21. DOI:10.1016/j.isprsjprs.2015.09.008 |

| [11] | AXELSSON P. Processing of Laser Scanner Data:Algorithms and Applications[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 1999, 54(2-3): 138–147. DOI:10.1016/S0924-2716(99)00008-8 |

| [12] | ZHANG Yongjun, ZHENG Maoteng, XIONG Jinxin, et al. On-orbit Geometric Calibration of ZY-3 Three-line Array Imagery with Multistrip Data Sets[J]. IEEE Transactions on Geoscience and Remote Sensing, 2014, 52(1): 224–234. DOI:10.1109/TGRS.2013.2237781 |

| [13] | TAO Pengjie, LU Luping, ZHANG Yong, et al. On-orbit Geometric Calibration of the Panchromatic/Multispectral Camera of the ZY-102C Satellite Based on Public Geographic Data[J]. Photogrammetric Engineering & Remote Sensing, 2014, 80(6): 505–517. |

| [14] | 张祖勋, 张剑清. 广义点摄影测量及其应用[J]. 武汉大学学报(信息科学版), 2004, 30(1): 1–5. ZHANG Zuxun, ZHANG Jianqing. Generalized Point Photogrammetry and Its Application[J]. Geomatics and Information Science of Wuhan University, 2004, 30(1): 1–5. |

| [15] | 张宏伟. 矢量与遥感影像的自动配准[D]. 武汉: 武汉大学, 2004. ZHANG Hongwei. Automatic Registration between Remote Sensing Image and Vector Map[D]. Wuhan:Wuhan University, 2004. http://cdmd.cnki.com.cn/Article/CDMD-10486-2006031608.htm |

| [16] | ZOU Songbai, ZHANG Jianqing, ZHANG Yong. The Automatic Registration between High Resolution Satellite Images and a Vector Map Based on RFM[C]//Proceedings of IEEE International Conference on Image Analysis and Signal Processing. Taizhou:IEEE, 2009:397-401. http://ieeexplore.ieee.org/document/5054632/ |

| [17] | LU Luping, ZHANG Yong, TAO Pengjie, et al. Estimation of Transformation Parameters between Centre-line Vector Road Maps and High Resolution Satellite Images[J]. The Photogrammetric Record, 2013, 28(142): 130–144. DOI:10.1111/phor.2013.28.issue-142 |

| [18] | MAY N C, TOTH C K. Point Positioning Accuracy of Airborne LiDAR Systems:A Rigorous Analysis[J]. International Archives of Photogrammetry, Remote Sensing and Spatial Information Sciences, 2007, 36: 107–111. |

| [19] | AGUILAR F J, MILLS J P. Accuracy Assessment of LiDAR-derived Digital Elevation Models[J]. The Photogrammetric Record, 2008, 23, 122: 148–169. |

| [20] | RAY J A, GRAHAM L. New Horizontal Accuracy Assessment Tools and Techniques for LiDAR Data[C]//Proceedings of the ASPRS 2008 Annual Conference. Portland, Oregon:[s.n.], 2008. |

| [21] | 熊小东. 基于多种特征的机载激光点云与航空影像配准方法研究[D]. 武汉: 武汉大学, 2014. XIONG Xiaodong. Registration of Airborne LiDAR Point Cloud and Aerial Images Using Multi-features[D]. Wuhan:Wuhan University, 2014. |

| [22] | BESL P J, MCKAY N D. A Method for Registration of 3-D Shapes[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 1992, 14(2): 239–256. DOI:10.1109/34.121791 |

| [23] | RUSU R B, BLODOW N, BEETZ M. Fast Point Feature Histograms (FPFH) for 3D Registration[C]//Proceedings of IEEE International Conference on Robotics and Automation. Kobe:IEEE, 2009:3212-3217. http://ieeexplore.ieee.org/xpls/icp.jsp?arnumber=5152473 |

| [24] | HABIB A, GHANMA M, Morgan M, et al. Photogrammetric and LiDAR Data Registration Using Linear Features[J]. Photogrammetric Engineering & Remote Sensing, 2005, 71(6): 699–707. |

| [25] | HABIB A, SHIN S, KIM C, et al. Integration of Photogrammetric and LiDAR Data in a Multi-primitive Triangulation Environment[C]//Innovations in 3D Geo Information Systems, First International Workshop on 3D Geoinformation. Kuala Lumpur, Malaysia:DBLP, 2006:29-45. |

| [26] | 杜全叶. 无地面控制的航空影像与LiDAR数据自动高精度配准[D]. 武汉: 武汉大学, 2010. DU Quanye. Automatic High Precision Registration between Aerial Images and LiDAR Data without Ground Control Points[D]. Wuhan:Wuhan University, 2010. http://cdmd.cnki.com.cn/Article/CDMD-10486-2010166389.htm |

| [27] | 黄荣永. 多元数据几何配准方法与应用研究[D]. 武汉: 武汉大学, 2015. HUANG Rongyong. Research on Geometric Registration Methods of Multiple Photogrammetric Data and Their Applications[D]. Wuhan:Wuhan University, 2015. |

| [28] | 维克托·迈尔-舍恩伯格, 肯尼思·库克耶. 大数据时代: 生活、工作与思维的大变革[M]. 盛杨燕, 周涛, 译. 杭州: 浙江人民出版社, 2013. MAYER-SCHONBERGER V, CUKIER K. Big Data:A Revolution that Will Transform How We Live, Work and Think[M]. SHENG Yangyan, ZHOU Tao, trans. Hangzhou:Zhejiang People's Publishing House, 2013. |