当前,摄影测量影像数据不断向着多元化和海量化的方向发展,摄影测量大数据时代已悄然来临[1-2]。如何高效地利用这些影像数据是一个亟待解决的问题。其中,利用影像数据进行地表的三维显示与表达是摄影测量一个持续发展的重要研究方向。利用立体影像,借助于三维观测工具,可实现目标区域的真三维显示与量测。传统的立体影像大多是基于影像获取时形成的天然视差直接构建。然而,在大多数情况下,得到的天然视差信息并不理想,左右视差与上下视差可能同时存在,不符合立体观测的最佳条件。此时,往往需要利用一定的方法,重新生成更合适人眼观测的人工视差。另外,随着影像共享网站的不断涌现,现如今已能免费下载到较高分辨率的正射影像、数字高程模型(digital elevation model,DEM)或者数字表面模型(digital surface model,DSM),如何将这些数据转换为立体影像,使其更易于人眼观测和地形分析,是值得研究的问题。

文献[3]对基于正射影像构建立体模型进行了研究,提出生成立体正射影像对的概念。立体正射影像对的研究对象是单独立体像对,原理是将左影像和右影像分别生成正射影像,由此组成立体正射影像对。文献[4]对立体正射影像对的三维量测性进行了研究。文献[5]则对基于航空影像的无缝正射影像对的生成进行了研究。文献[6]对利用正射影像生成立体匹配片从而构建三维立体模型进行了研究。然而,这些方法虽能够生成立体像对,但对人眼的视觉感受顾及较少,并不能自适应地生成符合人眼视觉感受的立体影像,这一问题对于地形复杂区域的立体构建尤为明显。由此,本文对利用多种数据源自适应生成符合人眼视觉感受的立体影像进行了相关研究。

构建立体影像的实质是影像间视差的控制。视差的大小与整体分布直接决定了人眼的视觉感受。在大区域复杂地形下,较大的相对高差对应着较大的视差范围,由此双眼产生了较大的深度感知范围。通过人眼疲劳产生的机制[7-10]可以知道,这是造成视觉不适的最主要原因之一。近年来,计算机视觉理论的不断发展为解决这一问题提供了有效途径。在计算机视觉领域,将影像视差调节到适合人眼感知的范围之内称为深度映射[11-13]。深度映射一般通过两种途径进行实现:①在成像时进行参数调整;②在成像后进行影像处理[14]。针对成像后影像处理,计算机视觉经典方法是首先计算出新视差,然后通过对应局部影像的变形平移或灰度内插形成立体影像[15-16]。这种途径的主要任务之一是进行视差的重新映射。针对实时处理系统,文献[17]提出场景分块处理的思想,对于不同的区域采用不同的深度压缩率进行映射,但不同区域的压缩比率变化是非连续的。文献[18]研究了一种随场景深度范围动态改变深度压缩率的方法,用于减小变形带来的瑕疵。文献[14]提出了一种非均匀深度压缩方法,保证了压缩率的连续变化。

在以上研究的基础上,本文提出了一种区域立体快速自适应重建方法,能够改进复杂地形条件下的视差变形,生成符合人眼视觉感受的立体影像。该方法可以对多种数据源进行处理,基于DEM(或DSM)数据,利用映射函数对高差进行深度映射,通过视差函数得到视差值,生成立体配对片,借助立体显示设备完成立体视觉重建。

1 立体快速自适应重建 1.1 立体配对片制作方法立体配对片可通过对正射影像引入人工视差的方法进行制作,一般包括斜平行投影法、对数投影法和变角度投影法[5, 20]。

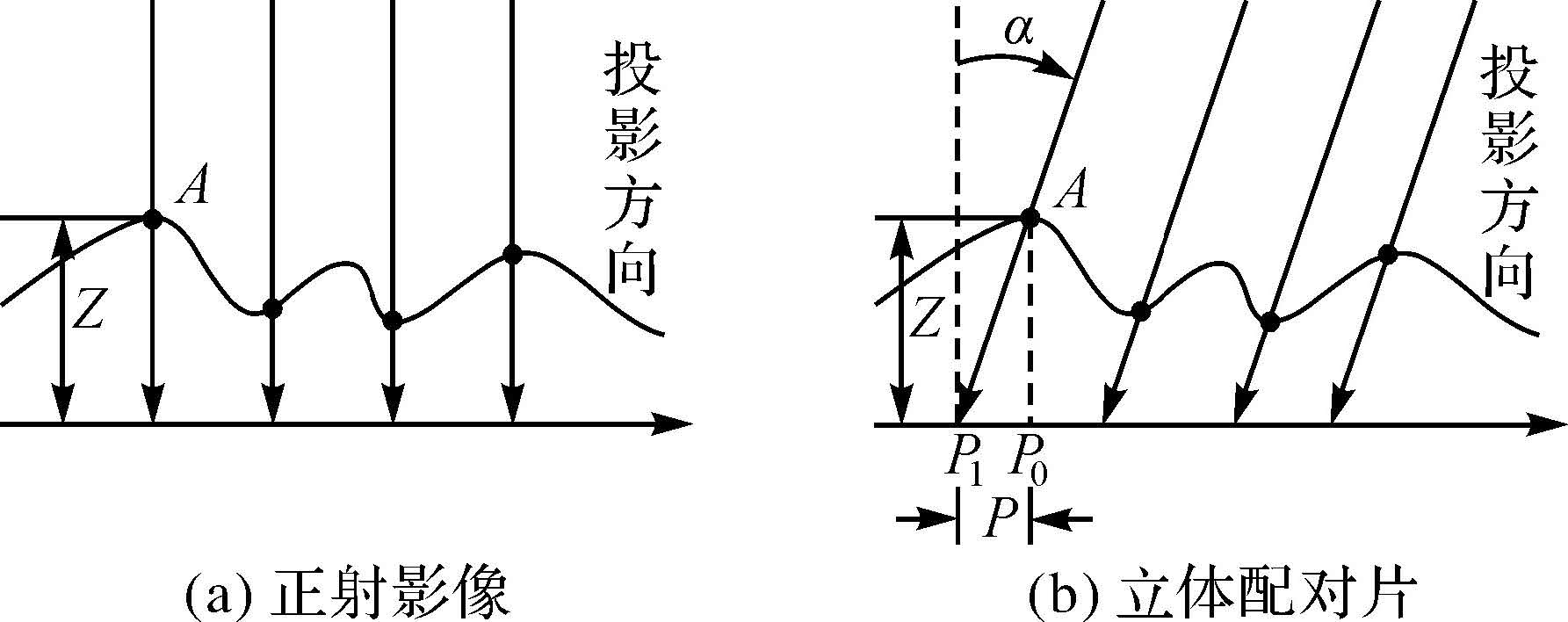

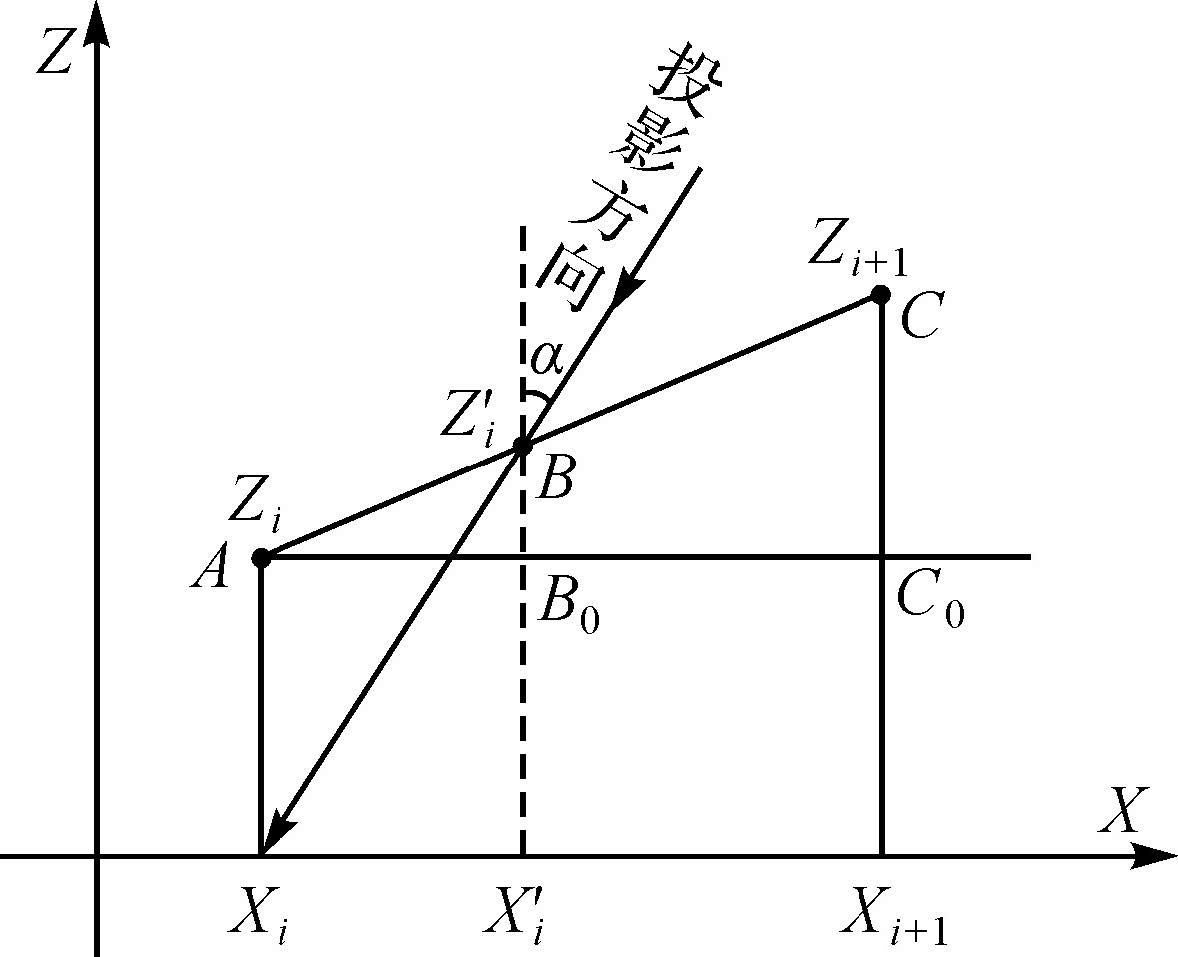

斜平行投影法利用角度为α的平行光线对DEM(或DSM)进行投影,得到仅有左右视差的配对片,求解过程简单,计算较为方便。如图 1所示,以地面点A为例,其高程值为Z,垂直投影点为P0,斜投影点为P1。图 1(a)为求解的正射影像,图 1(b)为斜平行投影求解的立体配对片。选取斜平行投影方向平行于XZ平面,使得正射影像和立体配对片的同名像点只存在左右视差,避免上下视差,同时使得左片和右片的比例尺相同,从而满足立体观测的先决条件。此时,立体观测的左右视差P为

|

| 图 1 斜平行投影法断面示意图 Fig. 1 The section of the oblique parallel projection method |

(1)

(1)

为了便于量测,α的角度须尽量与原始立体模型的视差保持一致,一般取tanα=B/H,B为立体像对的摄影基线,H为摄影时的航高,因此,

(2)

(2)

此时将立体正射影像对上量测的左右视差P除以系数k=tanα,便可以获得该点的高程

(3)

(3)

平行投影的光线与DEM(或DSM)表面格网点线性内插交点

|

| 图 2 斜平行投影交点计算 Fig. 2 Intersection calculation of the oblique parallel projection method |

由图中的几何关系可知

(4)

(4)

式中,k=tanα。

对数投影法和变角度投影法都是斜平行投影法的进一步改进,目的都是尽量使得引入的视差与原始视差相符合,其核心都是对视差函数P=ψ(Z)的改进。其中,对数投影法改善了斜平行投影法生成的人工视差与原始像对天然视差不一致的情况,采用的视差函数为:P=B·ln(H/(H-Z));变角度投影法降低了对数投影法中的求解复杂度,采用的视差函数为: P=B·Z/(H-Z)[5, 20]。

1.2 深度映射模型研究表明,人眼的调节和汇聚是紧密耦合的过程[14, 21],但观看立体影像时,会导致调节和汇聚分离,而较大的调节汇聚冲突会导致视觉不适或疲劳。文献[7, 9]提出适宜的感知深度应当在一定阈值之内。从调节与汇聚冲突和感知深度的角度来看,计算视差时,应在尽量保持原有立体效果的情况下,将视差控制在最大视差感知深度范围内,以减小视觉疲劳。基于这个思想,可通过深度映射将场景深度压缩到适宜的范围之内。

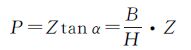

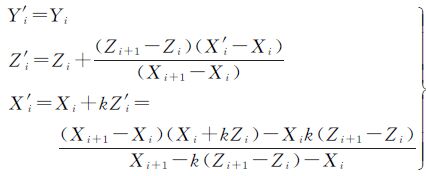

根据压缩率的变化情况,深度映射可分为非连续型处理和连续型处理[14, 17, 22]。图 3(a)表示场景深度整体以一个压缩率进行映射,能够保持场景的相对深度关系;图 3(b)表示场景深度的不同区域以不同的压缩率进行映射,能够突出重点区域,减小重点区域物体的压缩变形,但整体的相对深度关系存在较大变形;图 3(c)表示场景深度以非均匀连续压缩率进行映射,能够在减小重点区域压缩变形的同时尽量保持相对深度关系。进行深度映射的核心思想可表述如下:对于场景深度区域Ri=(sdi,sdi+1),按照视觉感知深度得到映射范围$\phi $i=(gpdi,gpdi+1),确定映射函数{Yi=Fi(Xi)|Xi∈Ri,Yi∈$\phi $i}进行映射(见图 4)。对于整个场景R={R1,R2,…,Rn}映射到合适的视觉深度$\phi $={$\phi $1,$\phi $2,…,$\phi $n},若F={F1,F2,…,Fn}不连续则为非连续型处理,反之,若其连续则为连续型处理。由此,可以看出,深度映射中影响人眼视觉效果的两个重要因素分别是感知深度$\phi $与映射函数F。一般而言,人眼感知较为舒适的深度范围是固定的,因此,研究的重点应为映射函数F的确定,这也是本文研究的关键。

|

| 图 3 深度映射方法示意图 Fig. 3 Depth mapping method |

|

| 图 4 映射函数性质示意图 Fig. 4 Mapping function properties |

1.3 基于深度映射的区域立体重建

区域立体制作应遵循以下两点原则:①立体深度的相对关系应尽可能地与实际相似。②立体深度应在人眼视觉感知深度范围之内。前者保证了立体整体畸变较小,能够真实地反映实际地形、地物;后者则保证了观看立体时能够尽可能地减小人眼疲劳。依据正射影像及DEM(或DSM)制作区域立体,实质是视差的确定,可以看作是进行深度映射的过程。区域立体的场景深度可由计算视差进行控制,而视差由高程计算而得。因此,可利用映射函数对高程进行变换,以实现深度映射。

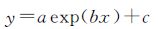

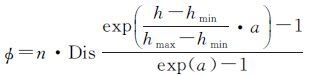

假设给定区域内的最高高程为hmax,最低高程为hmin,由此可得到最大高差Δhmax=hmax-hmin。依据影像分辨率确定适合人眼感知的最大高差限为$\phi $max=n×Dis,Dis为影像分辨率,n为人眼所能感知的较为舒适的最大深度(以视差形式表示)。由此,依据人眼感知视差限制,可以确定以下对应关系:实际最大高差Δhmax对应着感知最大高差$\phi $max,实际最小高差0对应着感知高差0。更进一步地,对于实际的大区域影像而言,最大高差对应的最大高程区域一般为山地地形,最小高差对应的最小高程区域一般为平地或居民地。因此,对应关系可进一步确定为:实际最大高差Δhmax对应着压缩率为fmax=$\phi $max/Δhmax,实际最小高差0对应着压缩率为f0=1。即较高的地形使用一定的压缩使其限制在人眼视觉感知范围之内,较低的地形尽量较小地压缩以保持立体的局部细节。在得到两点的值fmax和f0之后,再确定压缩率函数f=F(Δh)的具体形式,就可以确定每一高差点对应的压缩率值,然后由$\phi $=f·Δh可确定每一高差点的映射值。但在非线性情况下,压缩率函数f=F(Δh)的单调性与映射函数$\phi $=f·Δh的单调性间并不存在特定联系,为了保证映射关系的单调性,可直接进行映射函数的设计。为了达到预期效果,这里使用一种非线性的函数形式

(5)

(5)

式中,a、b、c为参数值。由于映射函数的先验条件仅有两点坐标(0,0)、(Δhmax,$\phi $max),故求解的映射函数应包含一个参数变量,其中一种具体形式为

(6)

(6)

式中,a为参数变量。将a取不同的值,观察函数$\phi $的性质变化,具体如图 4所示。

其中,取n=120,Dis=5,hmin=0,hmax=1000,h∈[0, 1000]。图 4中,线A对应a=e时的非均匀映射函数$phi $;线B对应a=-e时的非均匀映射函数$phi $;线C对应原始未映射值;线D对应均匀映射函数;线E对应分块均匀映射函数。可以发现,均匀映射函数以统一固定比率同时映射所有高程,并不能突出表述目标高程区域(突出目标高程区域是指将目标高程区域映射到较宽的视觉感受区,即“拉伸”目标区域高程,“压缩”非目标区域高程);分块非均匀映射函数以不同的比率映射对应高程,达到了突出表述目标高程区域的目的,但映射曲线并不光滑,不利于人眼的视觉感受;非均匀映射函数以变化的比率映射高程,映射曲线光滑,可通过控制参数值以突出表述目标高程区域,具有较好的性质。因此,在具体运用中一般选择非均匀映射函数进行映射操作。对于本文运用的非均匀映射函数,当a=e时,由曲线A可以发现,“低”高程被分配了较窄的映射区域,“高”高程分配了较宽的映射区域,将“高”高程目标区域进行了突出表述;当a=-e时,由曲线A可以发现,“低”高程被分配了较宽的映射区域,“高”高程分配了较窄的映射区域,将“低”高程目标区域进行了突出表述。本文试验中,选择a=-e,以突出表述“低”高程目标区域。

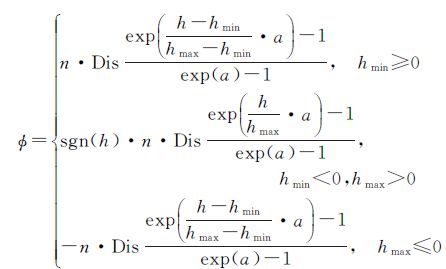

由式(6),输入每一点高程h即可得到相应的映射高程$phi $,式中最低高程点对应的映射高程为0,人眼感知为无立体,但若最低高程点为负值,则此时的人眼感知并未能真实地反映“凹立体”的实际地形,因此,可对式(6)改进如下

(7)

(7)

即,若hmin≥0,按式(6)计算;若hmin<0,hmax>0,令式(6)中的hmin=0,hmax=max(|h|),且计算压缩率时取高差的绝对值代入计算;若hmax≤0,按式(6)取负计算,为“凹立体”。应注意到,对于式(7),若h

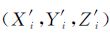

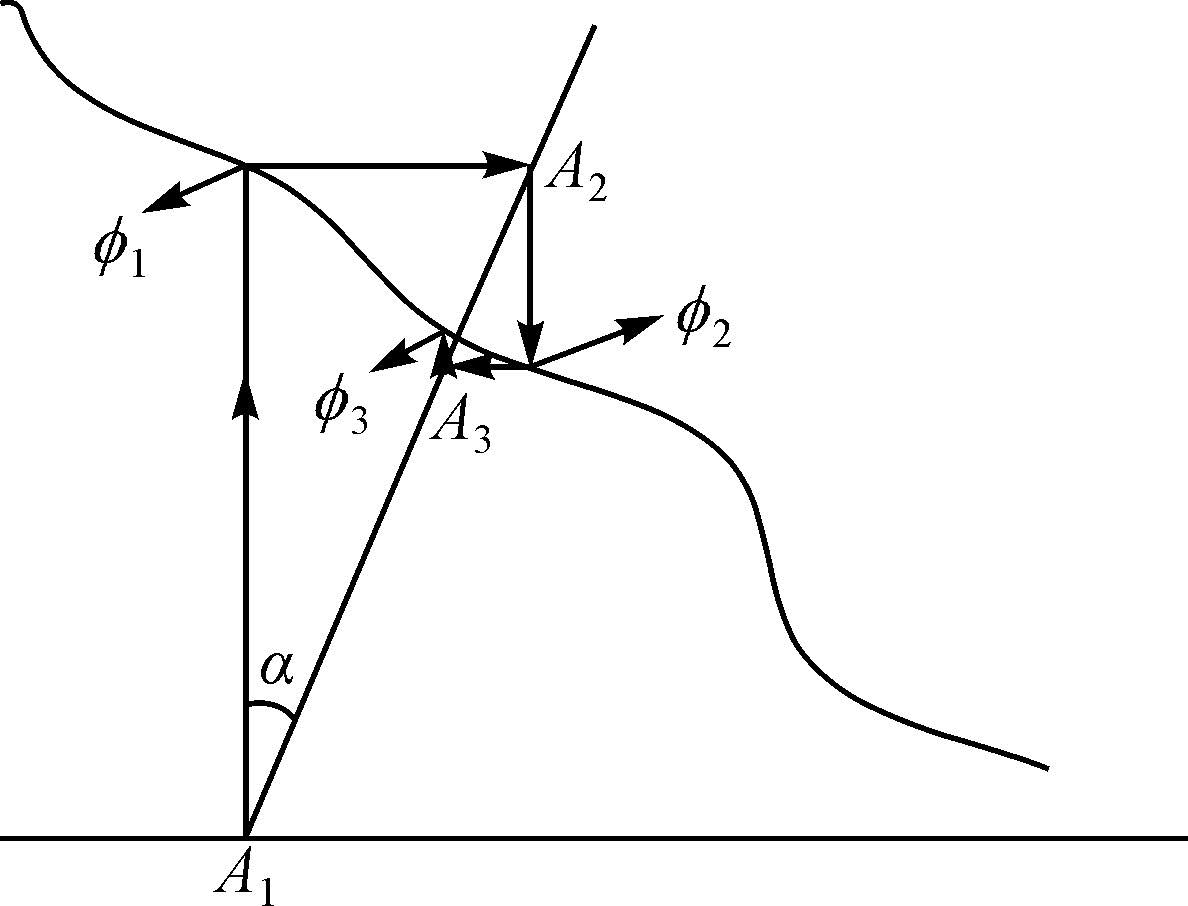

得到映射高程后,可通过视差函数来计算影像点的同名点。考虑到算法的计算复杂度,这里使用一种线性的视差函数形式p=k$phi $,即斜平行投影法。此时,可直接取得k=1。在具体计算中可通过迭代法进行求解。迭代流程是立体配对片上A1点的映射高程为$phi $1,根据已知k求得A2点X坐标为X1+k·$phi $1;同理,根据A2点的映射高程值为$phi $2,依次迭代出A3、A4等,直到$phi $A满足阈值,得到A1点的同名像点A的X坐标,然后,将影像上A点灰度值赋给立体配对片上A1点。最后,逐像元求解出立体辅助影像。迭代过程如图 5所示。

|

| 图 5 映射高程求解视差示意图 Fig. 5 Parallax solving by mapping elevation |

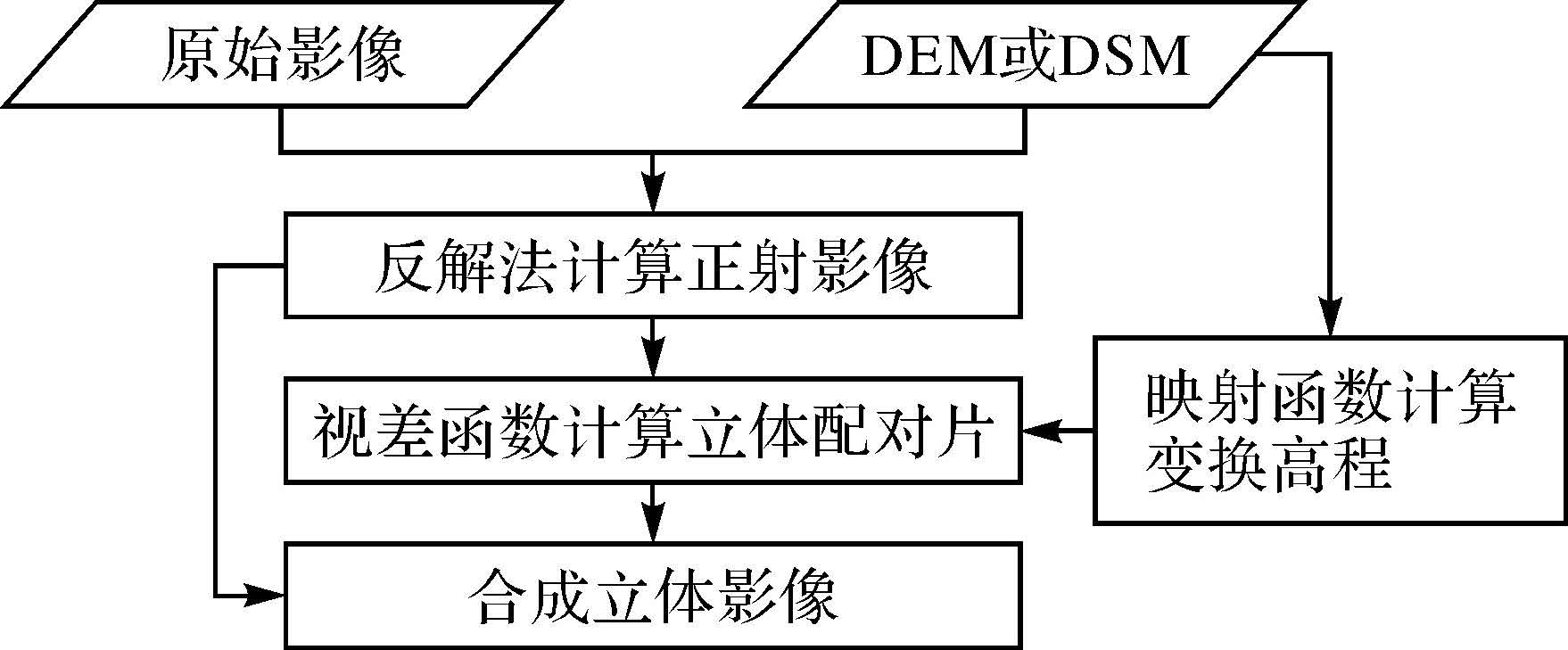

综上所述,区域立体快速重建过程如下:首先,利用DEM(或DSM)对原始影像进行微分纠正,得到正射影像;其次,通过DEM(或DSM)和映射函数$phi $=F(h),计算映射高程;然后,利用计算的映射高程和视差函数P=ψ(Z)迭代求解同名点坐标,逐像元计算出配对片;最后,利用正射影像及相应的配对片,根据实际的立体显示设备合成立体影像。其制作流程见图 6。

|

| 图 6 立体影像制作流程 Fig. 6 Stereo image making process |

2 试验及其结果分析 2.1 试验设计

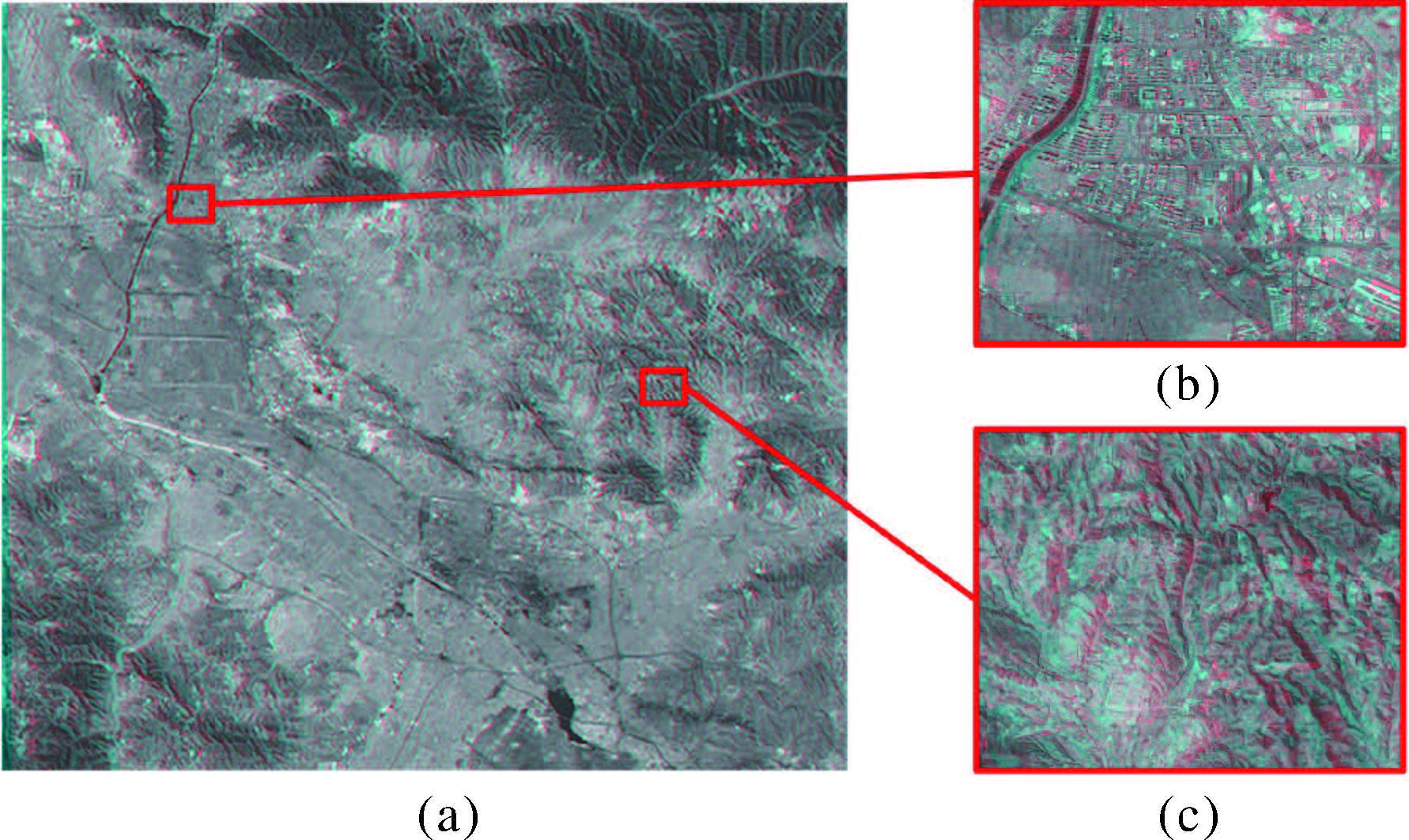

为了验证本文方法的有效性,选取某区域进行立体影像生成试验。影像及对应DEM(或DSM)已根据地理信息进行了重叠区域的裁剪,地理范围完全一致。试验数据包括4组(见表 1)第1组为“天绘一号”卫星三线阵影像,大小适中,包含有山地、居民地等,整体起伏明显;第2组为“天绘一号”卫星高分辨率影像,范围较小,包含土丘、平地等,地形较为简单;第3组为从互联网上获取的大区域正射影像及对应的SRTM,范围较大,包含山地、居民地、湖泊等,地形复杂;第4组数据为30m分辨率SRTM,包含山地、平地等,地形丰富,主要进行本文方法中深度映射的特性检验。对于第2组与第3组数据,试验前首先对DSM或SRTM进行了内插处理,得到对应分辨率的高程数据。试验采用Visual Studio 2012开发环境,采用Intel E5620 2.4GHz双处理器、16GB内存的运行环境,采用红蓝影像的方式进行立体显示。试验中为了实现区域立体的快速重建,采用16个线程进行并行加速处理。

| 序号 | 影像类型 | DSM类型 | 影像大小 /像素 | 实际大小 /km |

| 1 | 5m“天绘一号” 三线阵影像 | 5m DSM | 12000×12000 | 60×60 |

| 2 | 2m“天绘一号” 高分辨率影像 | 5m DSM | 5613×5138 | 11×10 |

| 3 | 10m彩色影像 | 30m SRTM | 20023×26542 | 200×265 |

| 4 | 30mSRTM | 2227×2227 | 66×66 |

2.2 结果分析

基于本文方法,利用上述设计方案,对第1组数据进行试验,试验结果如图 7所示。从图 7(a)、图 7(b)和图 7(c)中可以看出,立体影像能够符合人眼的视觉感受,并未产生复视现象(双眼竞争)。由图 7(a)的整体图可以看出,立体影像中山区部分立体感较强,整体能够真实地反映实际的地形情况;由图 7(b)的局部图可以看出,对于居民地等细节部分,观看时仍有较强的立体感,能够较好地表现局部地形细节;由图 7(c)的局部图可以看出,对于山地部分,观看时有较强的立体感,能够很好地突显出山体变化。

|

| 图 7 三线阵影像红蓝立体图 Fig. 7 Red and blue stereo image of three linear array images |

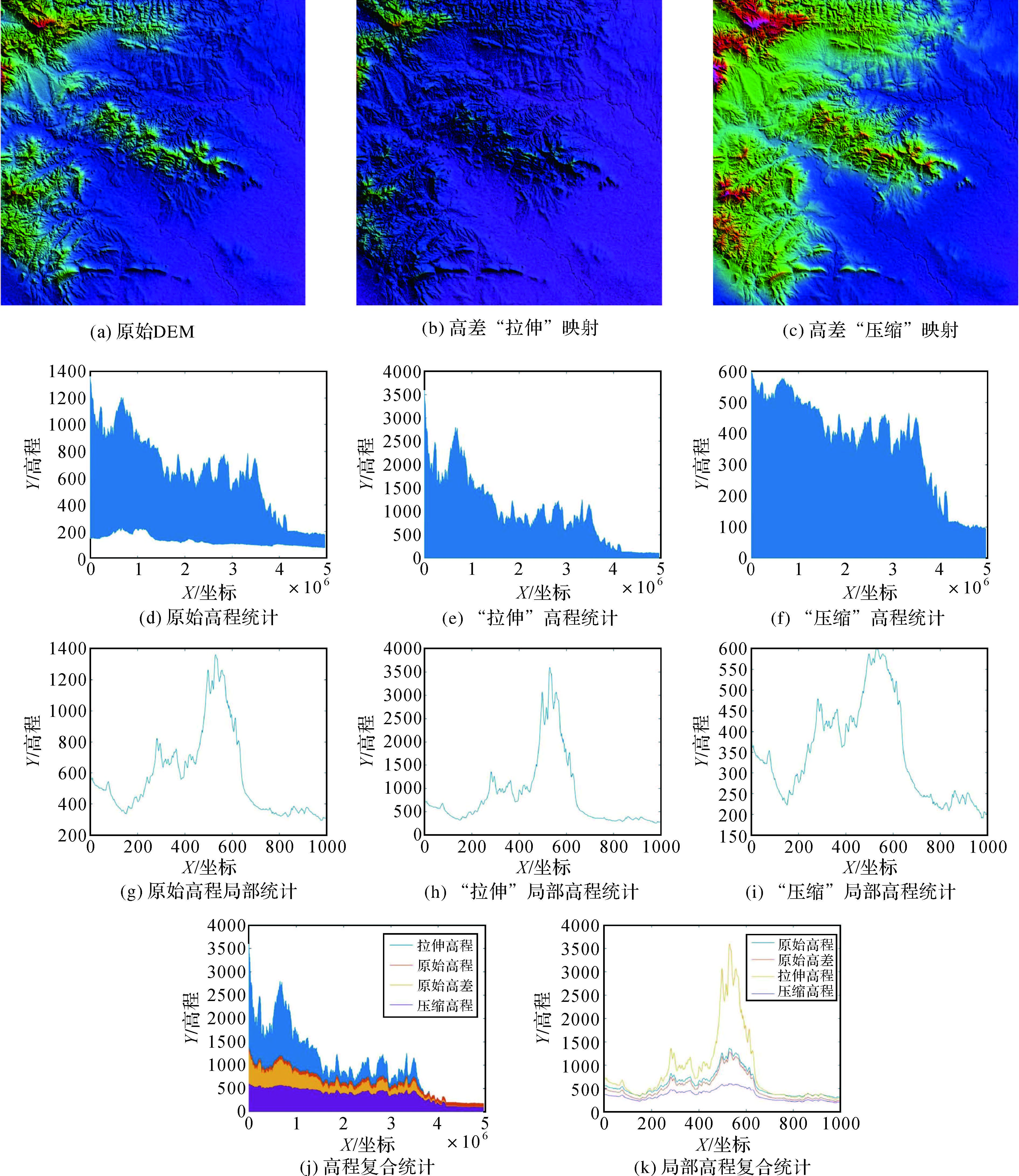

为了检验深度映射后的高程变化特点,采用第4组数据进行本文方法中的映射,结果如图 8所示,具体信息如表 2所示。图 8(a)是某一区域原始DEM渲染图,该区域最高高程为1361m,最低高程为77m,最大高差为1284m;图 8(b)是设置最大映射高程为3600m后的结果渲染图,可以看出该映射对高差进行了拉伸;图 8(c)是设置最大映射高程为600m后的结果渲染图,可以看出该映射对高差进行了压缩。由高程统计图 8(d)-(i)可以看出,处于映射上边界(即高差较大处)的压缩率较大,变形较大,而映射下边界的变形较小,这是由于选取的映射函数的特性所造成的,与预期效果相同。其中图 8(g)-(i)的局部统计图是取原始高程统计中前1000个高程点统计而成。图 8(j)-(k)是原始高程、原始高差、拉伸高程和压缩高程4组数据的复合统计图。可以明显看出,“拉伸”或者“压缩”映射最主要的是对较高区域(一般为山地部分)的处理,给人的最终感官变化是山地变高或山地变低,更加符合视觉感受。

|

| 图 8 映射高程示意图 Fig. 8 Mapping elevation |

| 最大值 | 最小值 | 最大高差 | 中值 | 平均值 | |

| 原始高程 | 1361.454 | 76.945 | 1284.509 | 218.195 | 266.013 |

| 拉伸高程 | 3600 | 0 | 3600 | 158.173 | 249.065 |

| 压缩高程 | 600 | 0 | 600 | 129.891 | 156.922 |

但是,由于映射函数的非线性特性,使得相对地形发生了形变,造成了观看效果与真实地形有所偏差。若要避免这种情况的发生,将映射函数定义为线性函数即可,但这样会使得局部细节变化同时受到较大压缩率的影响,不利于高差较小部分(一般为平地或居民地部分)的立体呈现。因此,对于不同的侧重情况可选择不同的映射函数进行处理:若侧重于视觉效果的表现,可选择非线性函数进行映射;若侧重于对真实地形的还原,可选择线性函数进行映射。本文仅给出了非线性函数的变换形式与结果。

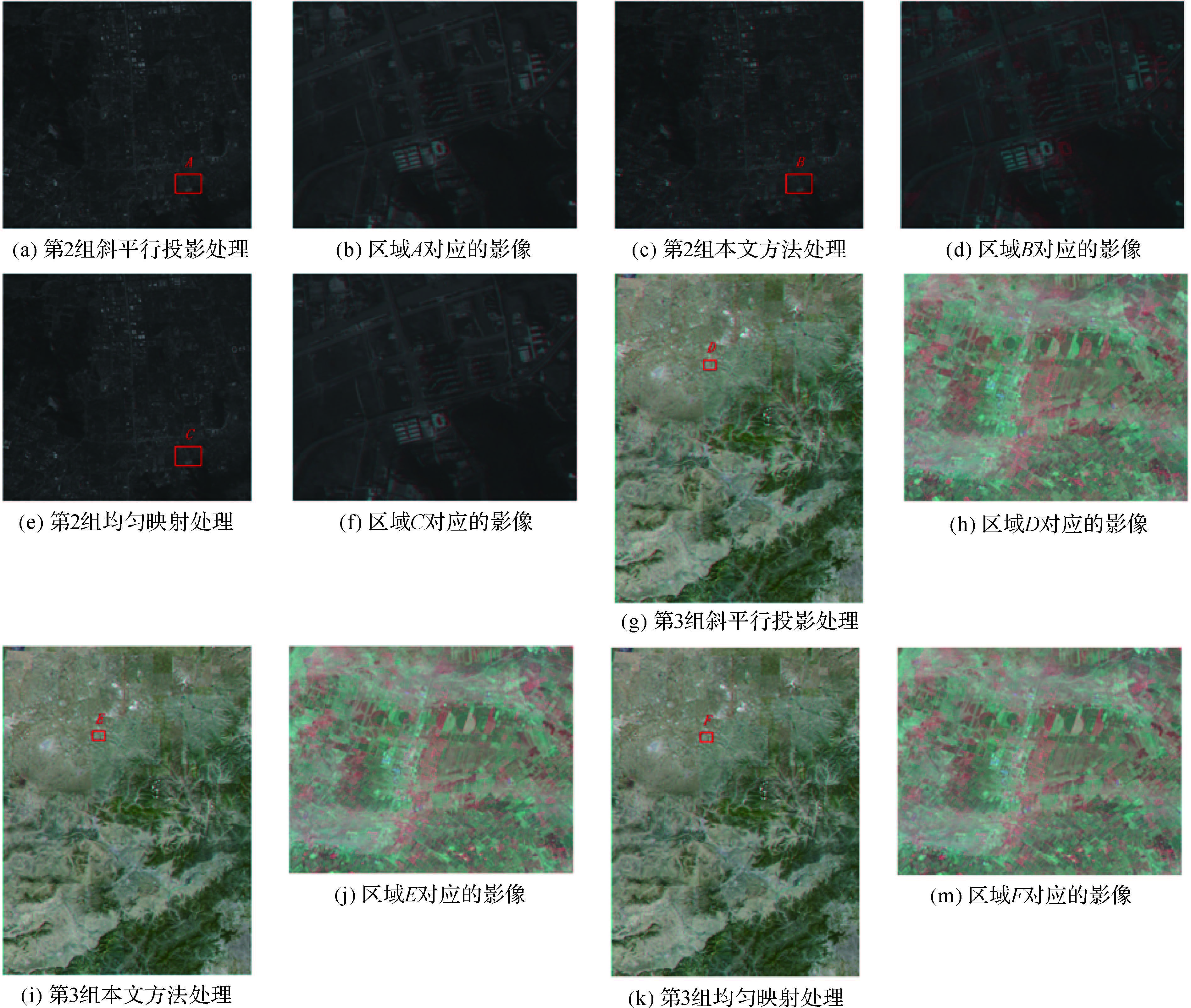

为了与其他算法进行比较,这里采用本文方法与均匀映射高程法、斜平行投影法分别对第2组和第3组数据进行处理,两种高程映射方法处理后,均采用斜平行投影法进行视差求解,3种方法中的k=1.0,结果如图 9所示。由图 9(a)-(f)可以看出,对于地形起伏不明显的区域,经过本文的高程映射之后,将视差非均匀变大,使得影像立体感更加强烈。均匀映射高程法将整体高程以固定比率压缩,损失了“低”高程处的细节部分,不能较好地突出“低”高程处的房屋细节。斜平行投影法未进行高程映射,不能突出表述细节部分,同时由于试验区域地形起伏不明显,立体效果与均匀映射法效果相似。由图 9(g)-(m)可以看出,对于大区域复杂地形下,整幅影像高差变化较大,已超出人眼感知范围,观看图 9(h)已产生明显的复视现象,经过本文的高程映射之后,将视差非均匀变小,复视消失,使得立体影像符合人眼视觉感受;均匀映射高程法由于进行了高程映射,同样消除了复视现象;而斜平行投影法未进行高程映射,部分区域复视现象明显。

|

| 图 9 对比试验 Fig. 9 Comparative experiment chart |

因此,从视觉质量上综合来看,本文方法制作出立体的深度感与舒适感都要优于斜平行投影法或均匀映射方法制作的立体。从效率上看,本文方法处理2、3组数据分别耗时7.6s、89.8s,斜平行投影分别耗时5.0s、77.5s,均匀映射方法分别耗时7.5s、90.1s,本文方法时间稍多于斜平行投影法,但总体耗时仍旧很短,能够达到快速重建的时间要求。从地形适应上而言,本文制作方法在地形简单或复杂区域都有着良好的表现,总体上优于斜平行投影法或均匀映射方法制作的立体。同时从理论上分析,依据DSM制作的立体影像对不会降低呈现复杂地形和现规则边界地物的立体效果,已经作过的大量试验的试验效果也证明了这一点,即利用本文方法、基于DSM生成的立体影像对具有较强的立体呈现效果。

3 总 结本文研究的区域立体自适应重建有其特殊的背景含义及应用。一方面,就便携性而言,本文方法生产的立体影像可打印成图,相对于正射影像和DEM(或DSM)直接构建透视三维,其携带相对方便,在设备相对简陋时仍能发挥较好的效用;另一方面,本文在改善目视效果的同时,将影像纠正为真北方向,更加利于用户的实际应用,这是目前卫星核线影像对所不能达到的效果。另外,虽然本文方法运用高程映射进行了视觉感官的调整,但在进行立体量测和立体测图时,实际应用数据仍是原始DEM(或DSM)的高程值,故理论上而言,并未丢失其原始高程精度。同时,由于改善了人眼观测环境,使其有利于人工量测误差的减小,从而有可能使立体量测的平面精度得到提升。

试验表明,本文方法能够自适应生成满足人眼视觉感受的立体影像,实现区域立体的快速重建。同时,本文在试验中给出了一种非线性的映射函数形式以及一种线性的视差函数形式,在实际应用中可根据具体情况对映射函数与视差函数进行重定义。

| [1] | 李德仁, 张良培, 夏桂松. 遥感大数据自动分析与数据挖掘[J]. 测绘学报 , 2014, 43 (12) : 1211–1216. LI Deren, ZHANG Liangpei, XIA Guisong. Automatic Analysis and Mining of Remote Sensing Big Data[J]. Acta Geodaetica et Cartographica Sinica , 2014, 43 (12) : 1211 –1216. DOI:10.13485/j.cnki.11-208.2014.0187 |

| [2] | 李德仁, 姚远, 邵振峰. 智慧城市中的大数据[J]. 武汉大学学报(信息科学版) , 2014, 39 (6) : 631–640. LI Deren, YAO Yuan, SHAO Zhengfeng. Big Data in Smart City[J]. Geomatics and Information Science of Wuhan University , 2014, 39 (6) : 631 –640. |

| [3] | COLLINS S H. The Stereo-Orthophoto Pair[J]. Photogrammetric Engineering , 1972, 38 (12) : 1195 –1202. |

| [4] | 刘凤德, 邱懿. 基于左右正射影像的三维量测方法的研究[J]. 测绘科学 , 2004, 29 (S) : 47–49. LIU Fengde, QIU Yi. Study on Three-Dimensional Measurement Method with Orthoimage[J]. Science of Surveying and Mapping , 2004, 29 (S) : 47 –49. |

| [5] | 李德仁, 王密. 一种基于航空影像的高精度可量测无缝正射影像立体模型生成方法及应用[J]. 铁道勘察 , 2004, 30 (1) : 1–6. LI Deren, WANG Mi. A Method for Generating Measurable Seamless Orthoimage Stereo Model with High Accuracy and Its Application Based on Aerial Images[J]. Railway Investigation and Surveying , 2004, 30 (1) : 1 –6. |

| [6] | 张祖勋, 郑顺义, 张剑清. 三维可视化工程设计的研究[J]. 武汉大学学报(信息科学版) , 2004, 27 (4) : 337–342. ZHANG Zuxun, ZHENG Shunyi, ZHANG Jianqing. Three-Dimensional Visualization Engineering Design[J]. Geomatics and Information Science of Wuhan University , 2004, 27 (4) : 337 –342. |

| [7] | PATTERSON R. Review Paper:Human Factors of Stereo Displays:An Update[J]. Journal of the Society for Information Display , 2009, 17 (12) : 987 –996. DOI:10.1889/JSID17.12.987 |

| [8] | SHIBATA T, KIM J, HOFFMAN D M, et al. The Zone of Comfort:Predicting Visual Discomfort with Stereo Displays[J]. Journal of Vision , 2011, 11 (8) : 11 . DOI:10.1167/11.8.11 |

| [9] | SPERANZA F, TAM W J, RENAUD R, et al. Effect of Disparity and Motion on Visual Comfort of Stereoscopic Images[C]//Proceedings of SPIE 6055, Stereoscopic Displays and Virtual Reality Systems XⅢ. San Jose, CA:SPIE, 2006 |

| [10] | REICHELT S, HAUSSLER R, FVTTERER G, et al. Depth Cues in Human Visual Perception and Their Realization in 3D Displays[C]//Proceedings of SPIE7690, Three-Dimensional Imaging, Visualization, and Display 2010 and Display Technologies and Applications for Defense, Security, and Avionics IV. Orlando, Florida:SPIE, 2010:281-290. |

| [11] | FREEDMAN B, SHPUNT A, MACHLINE M, et al. Depth Mapping Using Projected Patterns:US, WO/2008/120217[P]. 2008-10-09. |

| [12] | OLESEN S M, LYDER S, KRAFT D, et al. Real-time Extraction of Surface Patches with Associated Uncertainties by Means of Kinect Cameras[J]. Journal of Real-Time Image Processing , 2015, 10 (1) : 105 –118. DOI:10.1007/s11554-012-0261-x |

| [13] | HOLLIMAN N S. Smoothing Region Boundaries in Variable Depth Mapping for Real-Time Stereoscopic Images[C]//Proceedings of SPIE5664, Stereoscopic Displays and Virtual Reality Systems XⅡ. San Jose, CA:SPIE, 2005:281-992. |

| [14] | 李大锦, 白成杰. 实时立体视觉系统中的深度映射[J]. 中国图像图形学报 , 2015, 20 (3) : 366–373. LI Dajin, BAI Chengjie. Depth Mapping in Real-time Stereoscopic Systems[J]. Journal of Image and Graphics , 2015, 20 (3) : 366 –373. |

| [15] | XI Ming, WANG Lianghao, YANG Qingqing, et al. Depth-image-based Rendering with Spatial and Temporal Texture Synthesis for 3DTV[J]. EURASIP Journal on Image and Video Processing , 2013, 2013 (1) : 9 . DOI:10.1186/1687-5281-2013-9 |

| [16] | AFLAKI P, HANNUKSELA M M, GABBOUJ M. Subjective Quality Assessment of Asymmetric Stereoscopic 3D Video[J]. Signal, Image and Video Processing , 2015, 9 (2) : 331 –345. DOI:10.1007/s11760-013-0439-0 |

| [17] | HOLLIMAN N S. Mapping Perceived Depth to Regions of Interest in Stereoscopic Images[C]//Proceedings of SPIE 5291, Stereoscopic Displays and Virtual Reality Systems XI. San Jose, CA:SPIE, 2004:117-128. |

| [18] | SUN Geng, HOLLIMAN N. Evaluating Methods for Controlling Depth Perception in Stereoscopic Cinematography[C]//Proceedings of SPIE 7237, Stereoscopic Displays and Applications XX. San Jose, CA:SPIE, 2009:1-12. |

| [19] | 耿则勋, 张保明, 范大昭. 数字摄影测量学[M]. 北京: 测绘出版社, 2010 . GENG Zhexun, ZHANG Baoming, FAN Dazhao. Digital Photogrammetry[M]. Beijing: Surveying and Mapping Press, 2010 . |

| [20] | 周杨, 腾飞, 徐青, 等. 基于正射影像的地形双模立体景观构建方法[J]. 测绘科学技术学报 , 2013, 30 (2) : 162–167. ZHOU Yang, TENG Fei, XU Qing, et al. A Method of Building Dual Mode Stereo Terrain Scene Based on Orthophoto[J]. Journal of Geomatics Science and Technology , 2013, 30 (2) : 162 –167. |

| [21] | HOFFMAN D M, GIRSHICK A R, AKELEY K, et al. Vergence-accommodation Conflicts Hinder Visual Performance and Cause Visual Fatigue[J]. Journal of Vision , 2008, 8 (3) : 33 . DOI:10.1167/8.3.33 |

| [22] | JONES G R, LEE D, HOLLIMAN N S, et al. Controlling Perceived Depth in Stereoscopic Images[C]//Proceedings of SPIE 4297, Stereoscopic Displays and Virtual Reality Systems VⅢ. San Jose, CA:SPIE, 2001. |