2. 武汉大学时空数据智能获取技术与应用教育部工程研究中心, 湖北 武汉 430079

2. Engineering Research Center for Spatial-temporal Data Smart Acquisition and Application, Ministry of Education of China, Wuhan University, Wuhan 430079, China

1 引 言

车载激光扫描系统能够在高速移动状态下获取道路以及道路两侧建筑物、树木等地物表面的精确三维信息,已成为空间数据快速获取的一种重要手段,被广泛应用于数字城市、基础测绘、城市规划、交通、环保等领域。目前车载激光扫描数据获取与处理的研究主要为系统集成[1],点云数据组织管理[2],点云分割[3, 4],道路提取与建模[5],杆状目标提取[6, 7],建筑物提取及立面重建[8, 9, 10]等方面。车载激光扫描数据具有目标多样、点密度分布不均、存在缺失等特点,给车载激光扫描数据的目标提取带来了巨大的挑战。针对上述问题,学术界展开了广泛的研究。目前从激光扫描数据中提取目标的方法主要有4类。一是直接对散乱的激光扫描数据进行分割,然后根据不同目标的空间分布与几何特征进行目标提取的方法[11, 12]。该类方法直接对散乱的点进行分割和目标提取,避免了生成图像和划分体素时的精度损失;但计算量较大,且容易受到噪声的影响。二是利用激光脚点在扫描线上的分布特征进行分割和目标提取的方法[13, 14]。该类方法通过对每条扫描线上的点云分布进行分析,可以简单快速地实现不同目标的提取和分类,但难以处理散乱的激光扫描数据(特别是当激光扫描数据来自多个激光扫描头)。三是将激光扫描数据生成图像,借助图像处理技术进行分割和目标提取的方法[15, 16]。该类方法将散乱的点云生成规则的图像,然后利用图像分割、轮廓提取、形态学运算等图像处理手段进行分割和目标提取,加快了运算的速度,提高了效率,但是在点云生成图像的过程中会存在精度的损失,同时格网大小的选择也会对分割和目标提取结果产生较大的影响。四是将激光扫描数据生成三维体素,然后进行目标提取的方法[17, 18]。该类方法将点云过分割成体素,然后对体素进行分割和目标提取,减小了点云数据的冗余,加快了计算速度,但目前的体素生成方法大多只考虑了空间相邻关系,没有考虑体素内点的同质性,容易产生混合体素。

总体而言,车载激光扫描数据的目标提取仍然存在几个方面的问题:①数据处理耗时;②场景复杂、目标多样,基于单一实体和单一特征的分割及目标提取方法正确率和完整性较低;③多种目标距离相近时,容易导致目标提取错误。综上考虑,本文提出一种从车载激光扫描数据中层次化提取多类型目标的方法。

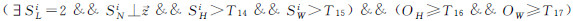

2 多类型目标层次化提取方法本文提出的多类型目标提取方法主要包括数据预处理、多尺度超级体素生成、基于多特征的点云分割和多类型目标提取等4个步骤 (如图1所示)。本方法对测量过程中的各种系统误差和随机误差导致的噪声点利用point cloud library 中的statistical outlier removal滤波器进行剔除,同时利用文献[13]的方法区分地面点和非地面点。

|

| 图 1 多类型目标层次化提取流程图 Fig. 1 Flow chart of multiple objects extraction |

车载激光扫描数据数据量大且密度分布不均匀,直接对其进行分割和目标提取计算量大而且耗时。本文方法受图像处理方法中“超级像素”[19]的启发,通过分析点云空间分布以及激光点颜色特征,发展了车载激光扫描数据的多尺度超级体素生成方法。超级体素生成算法的伪代码如下:

/*初始化*/

将激光扫描数据划分成尺寸为S的规则体素,将距离每个体素中心最近的激光点初始化为超级体素的中心

Rk、Gk、Bk、xk、yk、zk分别为第k个体素颜色值的R、G、B分量,以及x、y、z坐标值。对于每个点i,设置其超级体素的标识为l(i)=-1,点到体素中心的距离d(i)=∞。

repeat

/*赋值*/

for每个超级体素k,do

for以Ck为中心,以S为半径的球内的任意点i,计算点i到Ck的距离dik。

if dik < d(i) then

set d(i)=dik

set l(i)=k

end if

end for

end for

/*更新*/

for每个超级体素k,do

把l(i)=k的所有点的平均值作为超级体素k的新的中心Ck,并计算新体素中心和前一次迭代的体素中心的位置偏移量p。

end for

until p≤threshold

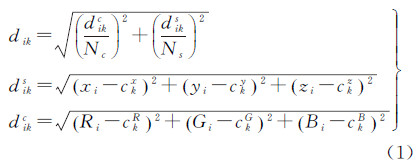

加权距离计算公式为

式中,dik、diks、dikc分别为点i到体素中心Ck的加权距离、空间距离和颜色距离;xi、yi、zi、Ri、Gi、Bi为点i的坐标值x、y、z以及颜色分量红、绿、蓝;ckx、cky、ckz、ckR、ckG、ckB为超级体素k的中心Ck的坐标值x、y、z以及颜色分量红、绿、蓝;Ns和Nc为权值因子,可以通过调整Nc和Ns的大小来权衡体素的紧凑性和边缘准确性。由于场景复杂性及目标多样性,单一尺度的体素无法准确表达目标的局部几何特征,如:尺度较小时,可以减少混合体素的出现,但不利于树干等较粗的杆状目标的特征识别;尺度较大时,有利于树干等较粗杆状目标的特征识别,但不利于细节特征识别。因此,本文提出多尺度的超级体素划分方法,首先使用大、小两个尺度进行超级体素划分,同时利用文献[20—21]的方法计算每个超级体素在不同尺度下的线状、面状和球状维数特征、法向量、主方向、颜色平均值、反射强度平均值和体素类别VL(VL=1体素呈线状分布,VL=2体素呈现面状分布,VL=3体素呈现球状分布)等特征,然后根据表1的优化策略确定最优的尺度及其对应的超级体素的特征。

| 情况 | 策略 | 说明 |

| VLS=VLL | 大尺度为最优尺度 | 该区域比较平滑,同质性好 |

| VLS=1,VLL=2 | 小尺度为最优尺度 | 尺度变大后,把其他目标中颜色相近的点包含进来 |

| VLS=1,VLL=3 | 小尺度为最优尺度 | 尺度变大后,把其他目标中颜色相近的点包含进来 |

| VLS=2,VLL=1 | 大尺度为最优尺度 | 较粗的粗杆目标,尺度较小时呈面状,尺变大后呈现杆状 |

| VLS=2,VLL=3 | 小尺度为最优尺度 | 颜色相近的不同地物相邻位置,尺度较小时包含同一地物上的点,尺度变大后把另外一个相邻地物点包含进来 |

| VLS=3,VLL≠3 | 大尺度为最优尺度 | 数据中有噪声存在,小尺度抗噪声能力差,误分类为球状 |

| 注:VLS表示小尺度划分体素时体素的类别;VLL对应大尺度时体素的类别。 | ||

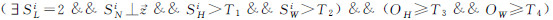

线状a1D、面状a2D和球状a3D维数特征和体素类别VL的计算公式如式(2)和式(3)所示

式(2)、式(3)中,λ1、λ2、λ3(λ1≥λ2≥λ3)为体素内的点构建的协方差矩阵的特征值;法向量VN为协方差矩阵的最小特征值λ3对应的特征向量;主方向VP为协方差矩阵的最大的特征值λ1对应的特征向量。颜色平均值VC、反射强度平均值VI为体素内点的颜色和反射强度的平均值。 2.2 基于多特征的点云分割利用单一特征(如颜色、强度、法向量等)的一致性进行点云分割存在一定的局限性,会导致片面的分割结果。为克服上述不足,本方法融合体素的颜色、反射强度、法向量、主方向等多种特征,利用基于图的分割方法[22]进行点云分割。同时提出了3种策略对传统的图分割方法进行改进,分别为:①利用超级体素在三维空间的相邻关系代替图像像素的二维相邻关系,更好地将目标和背景中特征相似的区域区分开;②对每条边定义了颜色差异、反射强度差异、法向量夹角、主方向夹角等4个权值,兼顾了各类地物的不同特点,克服了单一特征分割方法的不足;③采用不同的区域内部一致性和区域间差异性准则对类别不同的体素分别构图。例如,对于杆状分布的体素(VL=1)构建的图,区域内部一致性为区域内各体素主方向分布的标准差,差异性为相邻区域主方向的夹角;对于面状分布的体素(VL=2)构建的图,区域内部一致性为区域内各体素法向量分布的标准差,差异性为相邻区域法向量的夹角;对于球状分布的体素(VL=3)构建的图,区域内部一致性为区域内各体素颜色或者反射强度分布的标准差,差异性为相邻区域内各体素颜色或者反射强度平均值的差值。然后根据文献[22]的合并规则,对3幅图分别进行分割,最后把3幅图的分割结果叠加得到最终的分割结果。其中区域内部一致性和区域间差异性的计算见式(4)

式(4)和式(5)中,Cij为区域Ciq-1和Cjq-1合并后的区域;ni、nj分别为区域Ciq-1和Cjq-1的点数。avg(Ciq-1)、avg(Cjq-1)、avg(Cij)为对应区域特征的均值;ω(Eq)为区域之间的差异性;std(Ciq-1)、std(Cjq-1)、std(Cij)为对应区域特征的标准差,反映内部一致性。相邻区域Ciq-1和Cjq-1差异性ω(Eq)小于内部一致性std(Ciq-1)和std(Cjq-1)之和时,区域Ciq-1和Cjq-1合并。分割完成后,利用体素的特征计算方法计算每个区域维数特征(包括Sa1D、Sa2D、Sa3D)、区域类别SL(SL=1区域呈线状分布,SL=2区域呈面状分布,SL=3区域呈球状分布)、法向量SN、主方向SP、颜色平均值SC、反射强度平均值SI等特征。 2.3 多类型目标层次化提取现有的目标提取方法假设不同目标在空间中相对独立,但城区环境中多类型目标相互交错(如树木和标牌、树木和树木),不满足上述假设,因此导致错误提取结果。为克服上述不足,本文利用层次化提取策略,实现多目标提取。关键技术包括区域显著性指标、相邻区域聚类和目标分类。

显著性指标主要包括区域i最低点到地面的距离SHDGi、区域i的高度SHi、与区域i相邻的区域个数SNi、区域i的法向量与Z轴的夹角S∂i、区域i的主方向与Z轴的夹角Sβi等5项指标,指标说明见表2。

| 显著性指标 | 说明 |

| 区域i最低点到地面的距离SHDGi | 地物目标靠近地面,SHDGi越小,显著性SSai越大 |

| 区域i的高度SHi | 高度SHi越大,显著性SSai越大 |

| 与区域i相邻的区域个数SNi | SNi越小,说明该区域跟周围区域相对独立,显著性SSai越大 |

| 区域i的法向量与Z轴的夹角S∂i | S∂i越接近90°,说明该区域是立面的可能性越大,显著性SSai越大 |

| 区域i的主方向与Z轴的夹角Sβi | Sβi越接近0°,说明该区域是竖直杆的可能性越大,显著性SSai越大 |

对于任意区域i,显著性计算公式如式(5)。其中,n为区域的总个数。区域显著性计算实现了多类型目标显著度层次化排序(如建筑物的立面部分,电线杆、路灯、交通标牌的立杆部分,树干或者树冠部分,汽车、行人等较小的目标),为层次化的目标提取奠定基础,避免了空间邻近目标对提取结果的影响。

首先以显著性最大的区域为种子区域跟其相邻区域聚类得到目标;然后计算目标的高度OH、宽度OW、几何中心和重心高程差OΔh,多次回波点占总点数的百分比OPCT等特征,并利用表4的特征描述规则标识待识别的目标;然后根据识别目标的类别,融合相应的聚类约束条件(表3)重新聚类;最后利用表4的特征描述规则重新标识待识别的目标,并从分割结果中移除已识别的目标。重复上述过程,直到所有目标被标识。

| 目标 | 聚类约束条件 |

| 建筑物 | 聚类呈面状分布的相邻区域 |

| 电线杆 | 聚类呈竖直杆状和水平杆状的相邻区域 |

| 交通标牌 | 聚类呈杆状和竖直面状分布的相邻区域 |

| 树木 | 聚类呈杆状和球状分布的相邻区域 |

| 路灯 | 聚类呈杆状和面状分布的相邻区域 |

| 围墙 | 聚类呈竖直面状分布的相邻区域 |

| 汽车 | 聚类呈面状分布的相邻区域 |

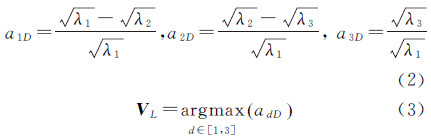

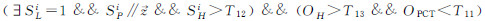

表4中SLi、SNi、SPi、SHi、SWi、Sci分别为分割区域i 的类别、法向量、主方向、高度、宽度、颜色等特征;STij为分割区域i和分割区域j之间的拓扑关系,STij=down表示区域i比区域j的高程低;OH、Ow、OL分别为目标的高度、宽度、长度等特征;OPTC表示目标中有多次回波的点占总点数的百分比。

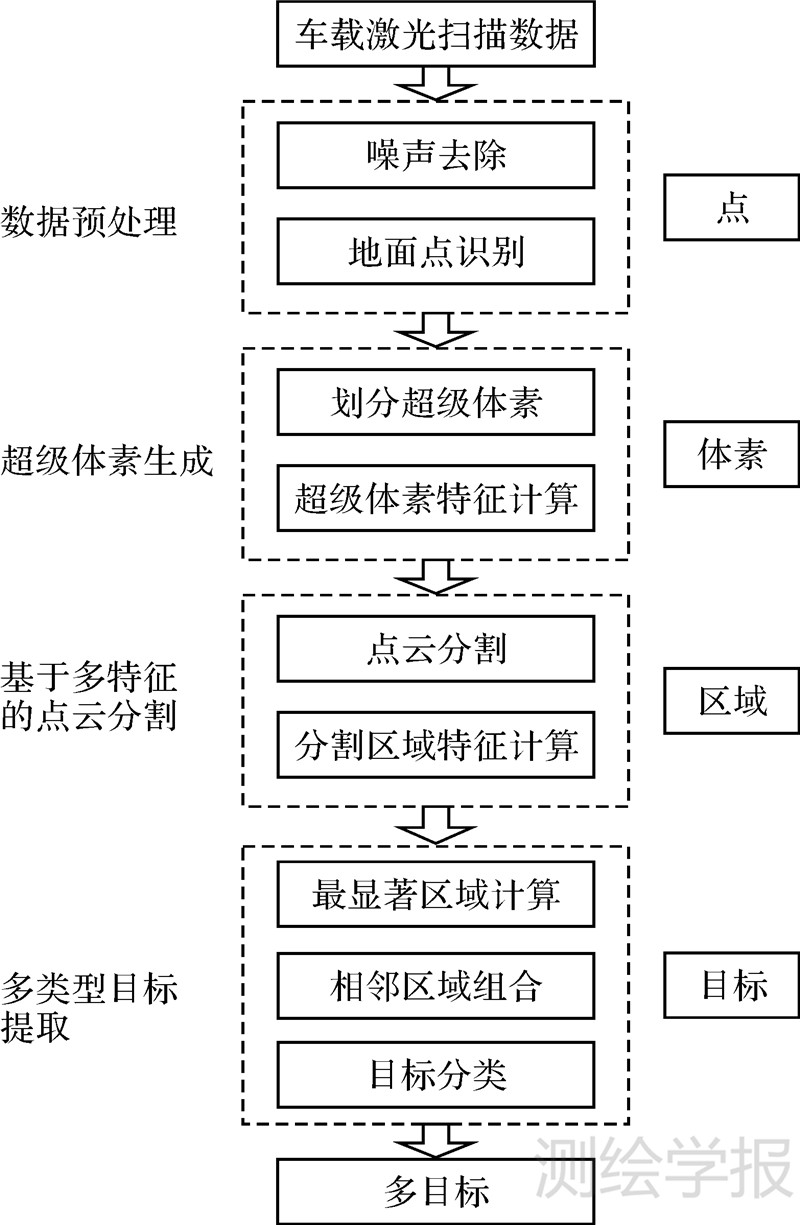

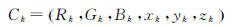

为提高目标分类和识别的准确性,笔者建立了城市场景中几类常见目标的特征描述规则,见表4。以树木提取为例进行说明,树木要满足区域实体的特征包括:  (存在树干);

(存在树干);  (存在树冠);STij=down(拓扑关系满足杆状区域低于球状区域,即树干低于树冠)。目标实体的特征包括:OH≥T(目标的高度大于某阈值);OΔh < 0(目标的几何中心比重心低);OPCT>T9(多次回波点占总点数的百分比大于阈值)。

(存在树冠);STij=down(拓扑关系满足杆状区域低于球状区域,即树干低于树冠)。目标实体的特征包括:OH≥T(目标的高度大于某阈值);OΔh < 0(目标的几何中心比重心低);OPCT>T9(多次回波点占总点数的百分比大于阈值)。

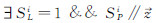

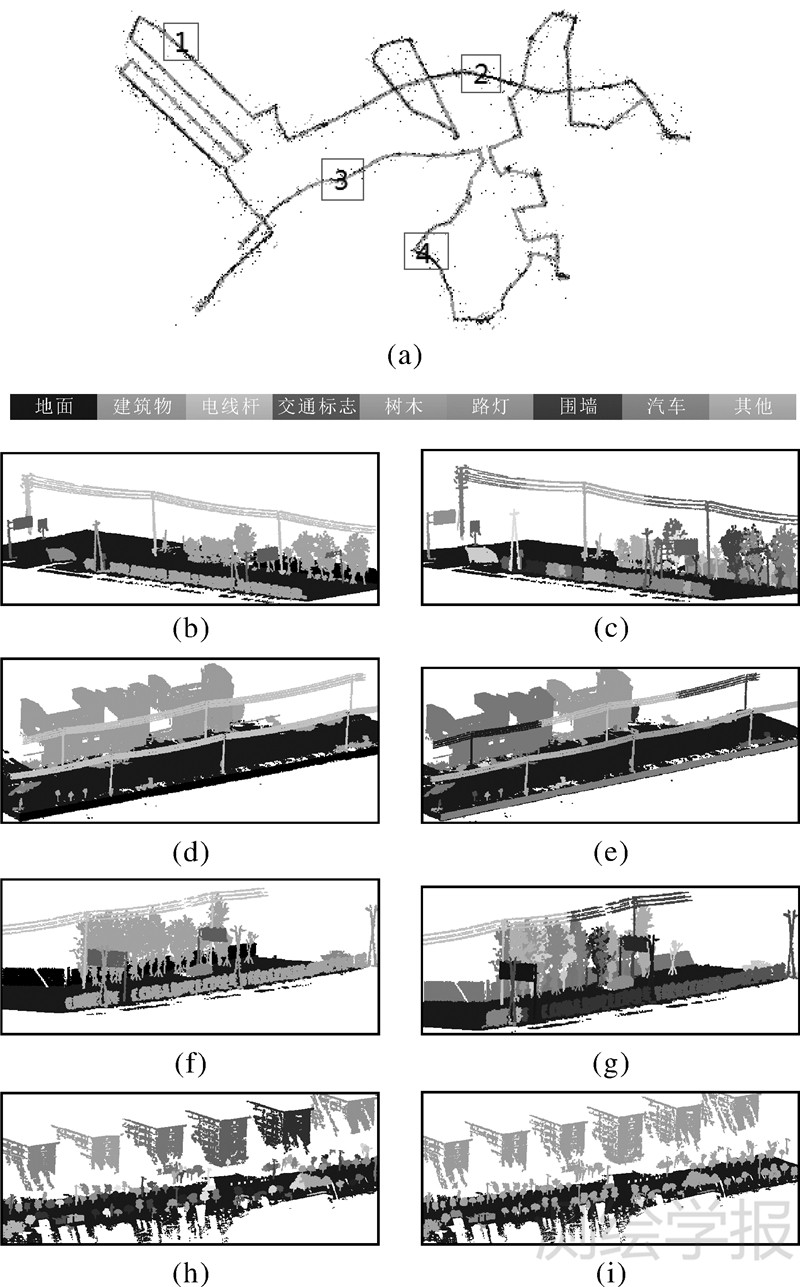

为验证方法的有效性,本文采用四维远见公司的车载激光建模测量系统(SSW-MMTS)采集的城区数据进行试验。SSW-MMTS由1个激光扫描器、导航定位系统(IMU、GPS、DMI)、6个面阵相机组成,其最大测距300 m,测距精度可达1 cm,点位精度优于5 cm。试验数据共有69.4亿个点,每个点包含扫描线、激光反射强度、颜色值(RGB)等信息,平均点密度为77 points/m2,数据覆盖范围为8.15 km×5.02 km(图2)。点云数据中包含常见的多种目标,如高层建筑物立面、电线杆、茂盛的行道树、路灯、汽车、行人、交通标牌、草坪以及栅栏等。

|

| 图 2 试验区域 Fig. 2 Overview of the test data sets |

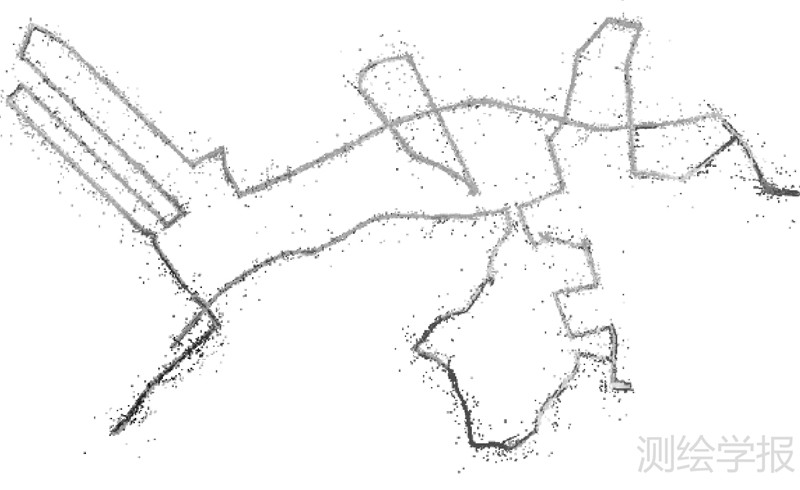

依据本文的方法分别在小尺度(10 cm)、大尺度(50 cm)下进行体素划分(图3),其中图3(a)、图3(b)和图3(c)分别是原始数据和两个尺度下的超级体素生成结果,并看出小尺度划分超级体素时,可以减少混合体素的出现,但此时会将较粗的杆状目标误分类为面状(图3(d));相反尺度较大时,有利于树干等较粗杆状目标的特征表达,但不利于细节特征的识别(图3(e))。利用本文的多尺度超级体素生成方法很好地解决了上述两个问题(图3(f))。

|

| 图 3 超级体素生成 Fig. 3 The result of supervoxel |

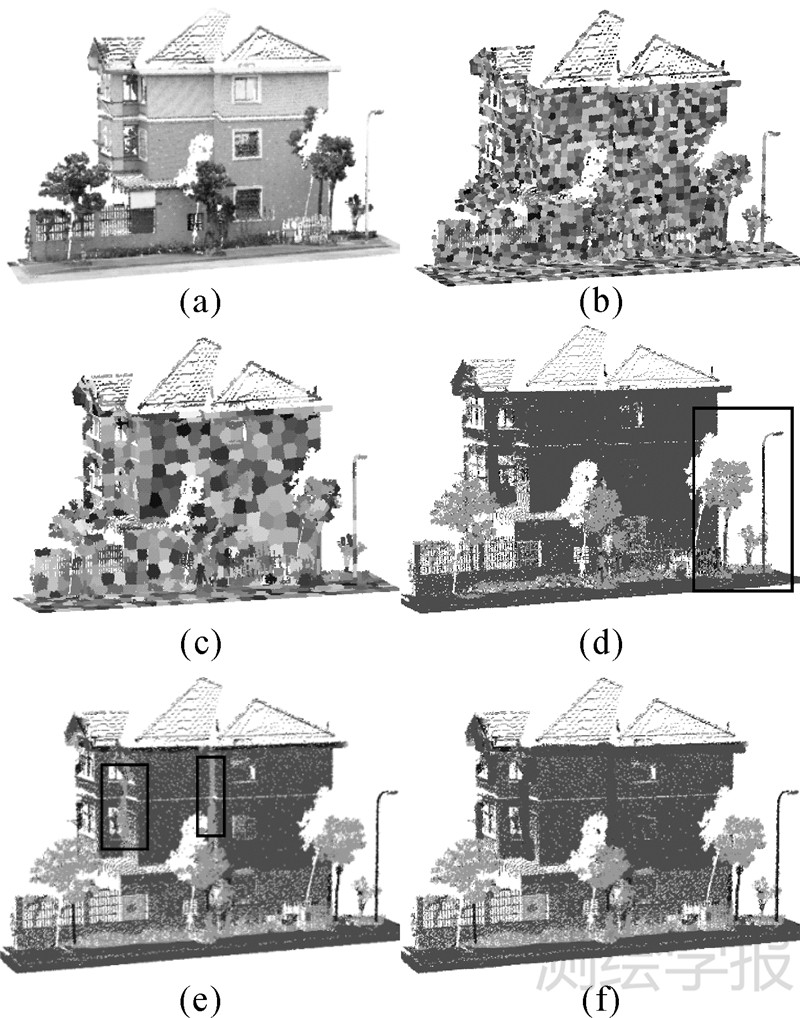

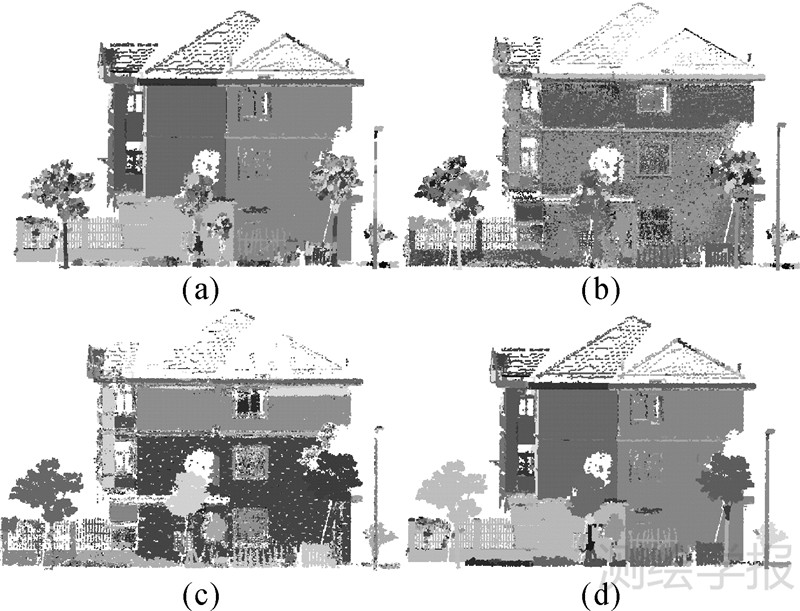

图4示例了相应的分割结果。从图4可以看出,利用法向量一致性分割时,建筑物的立面分割结果较好,路灯、树木等目标出现过分割,如图4(a);利用主方向一致性分割时,路灯、树干分割结果较好,建筑物、树冠等目标出现过分割,如图4(b);利用颜色一致性分割时树冠分割结果较好,其他目标分割结果较差,如图4(c)。本文方法综合上述3个特征对点云进行分割较好地解决了过分割和分割不足的情况,如图4(d)。

|

| 图 4 点云分割结果 Fig. 4 The result of segmentation |

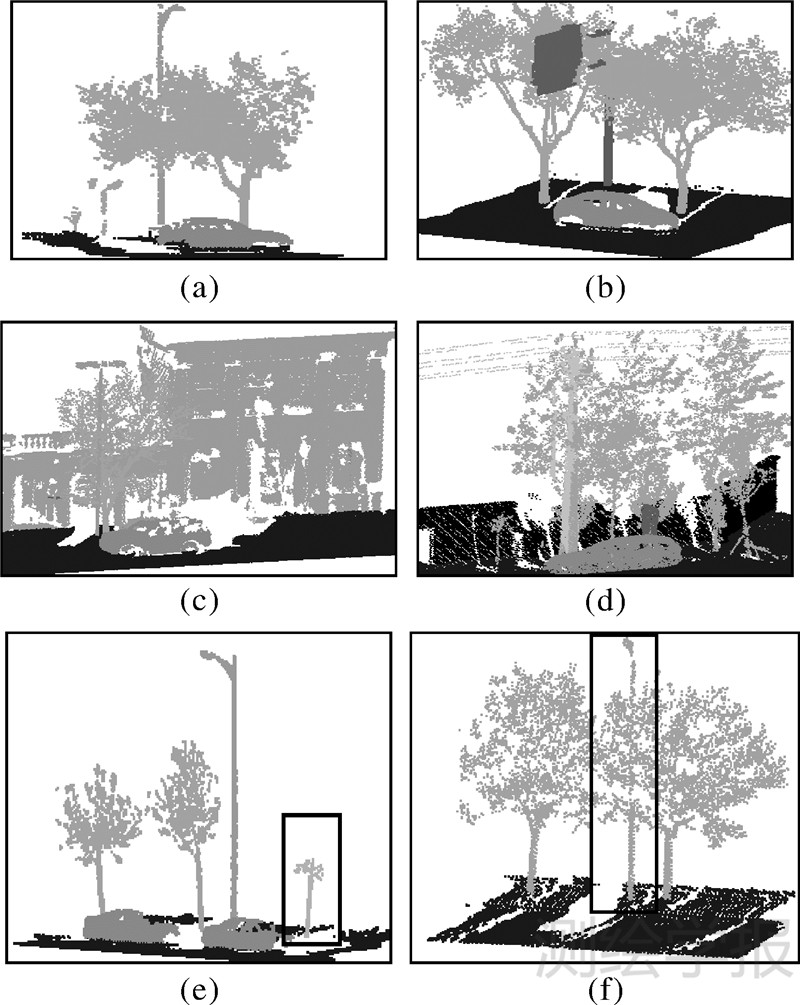

基于点云分割的多类型目标提取结果如图5和图6,其中目标提取中采用的参数阈值如表5,阈值根据物体的先验知识以及特征统计直方图的分析得到。图5(a)为整个区域的目标提取结果,图5 (b)、(d)、(f)、(h)和图5(c) 、(e)、(g)、(i)分别是区域1、2、3、4按照目标类别和目标ID赋色的结果。从图6可以看出,本文方法不仅能准确地提取相互独立的地物目标,而且当不同目标相互交错甚至被部分遮挡时,该方法仍然可以得到正确的提取结果,如图6(a)、(c)、(b)、(d)中相互交错并被树木遮挡的路灯、交通标志牌、建筑物、电线杆等目标被正确提取。但是该方法仍然存在一些提取错误,如图6(e)、(f),这些错误主要集中在枝叶稀少的树木分类为其他杆状目标(图6(e)),部分区域存在严重遮挡,难以分辨的路灯被错误分类为树木(图6(f))等。

|

| 图 5 多目标提取结果 Fig. 5 The result of multiple objects extraction |

|

| 图 6 目标提取结果细节 Fig. 6 The details of multiple objects extraction |

| 目标 | 参数 | 取值/m | 描述 |

| 建筑物 | T1 | 3 | 组成建筑物的最大立面的最小高度阈值 |

| T2 | 3 | 组成建筑物的最大立面的最小宽度阈值 | |

| T3 | 5 | 建筑物目标的最小高度阈值 | |

| T4 | 3 | 建筑物目标的最小宽度阈值 | |

| 电线杆 | T5 | 5 | 组成电线杆的立杆的最小高度阈值 |

| T6 | 10 | 电线杆目标的最小高度阈值 | |

| 交通标志 | T7 | 2 | 组成交通标志牌的立杆的最小高度阈值 |

| T8 | 0.5 | 组成交通标志牌的标志牌最小尺寸 | |

| T9 | 2.5 | 交通标志牌的最小高度阈值 | |

| 树 | T10 | 2 | 树木目标的最小高度阈值 |

| T11 | 0.3 | 多次回波点的比例阈值 | |

| 路灯 | T12 | 5 | 组成路灯的立杆的最小高度阈值 |

| T13 | 8 | 路灯目标的最小高度阈值 | |

| 围墙 | T14 | 2 | 组成围墙的最大立面的最小高度阈值 |

| T15 | 3 | 组成围墙的最大立面的最小宽度阈值 | |

| T16 | 2 | 围墙目标的最小高度阈值 | |

| T17 | 10 | 围墙目标的最小宽度阈值 | |

| 汽车 | T18 | 1.5 | 汽车目标的最小高度阈值 |

| T19 | 5.0 | 汽车目标的最大高度阈值 | |

| T20 | 1.5 | 汽车目标的最小宽度阈值 | |

| T21 | 3.0 | 汽车目标的最大宽度阈值 | |

| T22 | 2.7 | 汽车目标的最小长度阈值 | |

| T23 | 15.0 | 汽车目标的最大长度阈值 |

为检验本文方法多类型目标提取的正确性,基于手工标记试验数据为参考数据,对本文提出方法的正确率、召回率进行计算(表6)。从表6可以看出建筑物目标提取的正确率和召回率最高,超过了95.0%;树木提取的正确率和召回率相对较低,为91%左右。同时对本文方法与文献[4]方法的正确率、召回率、数据处理时间3个方面进行了对比,比较结果如表7。结果表明本文方法较文献[4]方法的正确率和召回率均有所提高,整体精度提高约1%,提取效率提高了近1倍。

| 目标 | 建筑物 | 电线杆 | 交通标牌 | 树木 | 路灯 | 围墙 | 汽车 | 其他 | 总计 | 精度/(%) | 召回率/(%) |

| 建筑物 | 4082 | 0 | 0 | 0 | 0 | 1 | 2 | 102 | 4187 | 97.5 | 98.0 |

| 电线杆 | 0 | 1634 | 2 | 0 | 1 | 0 | 0 | 91 | 1728 | 94.6 | 94.2 |

| 交通标志 | 0 | 2 | 497 | 1 | 2 | 0 | 0 | 22 | 524 | 94.8 | 95.6 |

| 树木 | 0 | 9 | 4 | 6281 | 12 | 0 | 0 | 581 | 6887 | 91.2 | 90.5 |

| 路灯 | 0 | 4 | 2 | 8 | 2290 | 0 | 0 | 154 | 2458 | 93.2 | 94.3 |

| 围墙 | 2 | 0 | 0 | 0 | 0 | 27 | 0 | 0 | 29 | 93.1 | 96.4 |

| 汽车 | 0 | 0 | 0 | 0 | 0 | 0 | 2285 | 167 | 2452 | 93.2 | 91.0 |

| 其他 | 80 | 86 | 15 | 650 | 124 | 0 | 224 | 11 266 | 12 445 | 90.5 | 90.9 |

| 总计 | 4164 | 1735 | 520 | 6940 | 2429 | 28 | 2511 | 12 383 | 30 710 | 整体精度:92.3% |

本文以车载激光扫描数据为研究对象,提出了一种适合复杂城市环境的多类型目标层次化提取方法。试验验证表明:该方法的主要贡献在于:①发展了基于超级体素的点云分割方法,减小了数据冗余并加快了运算速度;②融合点云的几何、纹理和反射强度等多种特征进行分割和分类,提高了复杂场景中点云分割和目标提取的质量;③提出了一种多类型目标层次化提取方法,解决了多个目标距离相近时提取错误的问题,提高了多目标提取的正确率。但是方法仍然存在一些问题,主要在于点云分割的结果依赖于超级体素分类的结果,当体素分类出错时,会导致错误的分割结果;目标提取规则无法提取不完整的汽车目标等。本文下一步的研究将对提取出的目标进行模型重建,主要包括单木参数(树高、胸径、树冠轮廓、生物量等)计算及树木模型重建,建筑物立面细节特征(窗户、门洞、台阶、突起、阳台、遮阳板)提取及精细模型重建等,相关的工作将从两个方面来提高严重遮挡情况下的分类精度:①综合利用区分性更强的局部特征描述子和全局特征描述子,融合两类特征描述子各自的优势;②进行多尺度的点云分割,在过分割和分割不足之间取得平衡,同时融合语义知识,降低错误分类。

| [1] | LU Xiushan, LI Qingquan, FENG Wenhao, et al. Vehicle-borne Urban Information Acquisition and 3D Modeling System [J]. Journal of Wuhan University of Hydraulic and Electric Engineering, 2003, 36(3): 76-80. (卢秀山, 李清泉, 冯文灏, 等. 车载式城市信息采集与三维建模系统[J]. 武汉大学学报:工学版, 2003, 36(3): 76-80.) |

| [2] | WANG Yanmin, GUO Ming. A Combined 2D and 3D Spatial Indexing of Very Large Point-cloud Data Sets [J]. Acta Geodaetica et Cartographica Sinica, 2012, 41(4): 605-612. (王晏民, 郭明. 大规模点云数据的二维与三维混合索引方法[J]. 测绘学报, 2012, 41(4): 605-612.) |

| [3] | WU Hangbin, LI Nan, LIU Chun, et al. Airborne LiDAR Data Segmentation Based on 3D Mathematical Morphology[J]. Journal of Remote Sensing, 2011, 15(6): 1189-1201. (吴杭彬, 李楠, 刘春,等. 机载激光扫描数据分割的三维数学形态学模型[J]. 遥感学报, 2011, 15(6): 1189-1201.) |

| [4] | YANG B S, DONG Z. A Shape-based Segmentation Method for Mobile Laser Scanning Point Clouds [J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2013, 81: 19-30. |

| [5] | LI Yijing, HU Xiangyun, ZHANG Jianqing, et al. Automatic Road Extraction in Complex Scenes Based on Information Fusion from LiDAR Data and Remote Sensing Imagery[J]. Acta Geodaetica et Cartographica Sinica, 2012, 41(6): 870-876. (李怡静, 胡翔云, 张剑清, 等. 影像与LiDAR数据信息融合复杂场景下的道路自动提取[J]. 测绘学报, 2012, 41(6): 870-876.) |

| [6] | LEHTOMÄKI M, JAAKKOLA A, HYYPPÄ J, et al. Detection of Vertical Pole-like Objects in a Road Environment Using Vehicle-based Laser Scanning Data[J]. Remote Sensing, 2010, 2(3): 641-664. |

| [7] | CABO C, ORDONEZ C, GARCÍA-CORTÍS S, et al. An Algorithm for Automatic Detection of Pole-like Street Furniture Objects from Mobile Laser Scanner Point Clouds [J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2014, 87: 47-56. |

| [8] | YANG Yun, SUI Lichun. Object-oriented Classification of LiDAR Data Based on Multi-feature Fusion [J]. Bulletin of Surveying and Mapping, 2010(8): 11-15. (杨耘, 隋立春. 面向对象的LiDAR数据多特征融合分类[J]. 测绘通报, 2010(8): 11-15.) |

| [9] | TAN Ben, ZHONG Ruofei, LI Qin. Objects Classification with Vehicle-borne Laser Scanning Data [J]. Journal of Remote Sensing, 2012, 16(1): 50-66. (谭贲, 钟若飞, 李芹. 一种车载激光扫描数据的地物分类方法[J]. 遥感学报, 2012, 16(1): 50-66.) |

| [10] | YANG Bisheng, DONG Zhen, WEI Zheng, et al. Extracting Complex Building Facades from Mobile Laser Scanning Data [J]. Acta Geodaetica et Cartographica Sinica, 2013, 42(3): 411-417. (杨必胜, 董震, 魏征, 等. 从车载激光扫描数据中提取复杂建筑物立面的方法[J]. 测绘学报, 42(3):411-417.) |

| [11] | PU S, RUTZINGER M, VOSSELMAN G, et al. Recognizing Basic Structures from Mobile Laser Scanning Data for Road Inventory Studies[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2011, 66(6): S28-S39. |

| [12] | XU S, VOSSELMAN G, ELBERINK S O. Multiple-entity Based Classification of Airborne Laser Scanning Data in Urban Areas [J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2014, 88: 1-15. |

| [13] | YANG B, FANG L, LI J. Semi-automated Extraction and Delineation of 3D Roads of Street Scene from Mobile Laser Scanning Point Clouds [J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2013, 79: 80-93. |

| [14] | MANANDHAR D, SHIBASAKI R.Auto-extraction of Urban Features from Vehicle-borne Laser Data[C] //The International Archives of Photogrammetry, Remote Sensing and Spatial Information Sciences, 2002, 34(4): 650-655. |

| [15] | YANG B S, WEI Z, LI Q, et al. Automated Extraction of Street-scene Objects from Mobile LiDAR Point Clouds[J]. International Journal of Remote Sensing, 2012, 33(18): 5839-5861. |

| [16] | YANG B, FANG L, LI Q, et al. Automated Extraction of Road Markings from Mobile LiDAR Point Clouds [J]. Photogrammetric Engineering & Remote Sensing, 2012, 78(4): 331-338. |

| [17] | LIM E H, SUTER D. 3D Terrestrial LiDAR Classifications with Super-voxels and Multi-scale Conditional Random Fields [J]. Computer-aided Design, 2009, 41(10): 701-710. |

| [18] | AIJAZI A K, CHECCHIN P, TRASSOUDAINE L. Segmentation Based Classification of 3D Urban Point Clouds: A Super-voxel Based Approach with Evaluation [J]. Remote Sensing, 2013, 5(4): 1624-1650. |

| [19] | ACHANTA R, SHAJI A, SMITH K, et al. SLIC Superpixels Compared to State-of-the-art Superpixel Methods[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2012, 34(11): 2274-2282. |

| [20] | LALONDE J F, VANDAPEL N, HUBER D F, et al. Natural Terrain Classification Using Three-dimensional LiDAR Data for Ground Robot Mobility [J]. Journal of Field Robotics, 2006, 23(10): 839-861. |

| [21] | DEMANTK J, MALLET C, DAVID N, et al. DimensionalityBased Scale Selection in 3D LiDAR Point Clouds [C]//International Archives of Photogrammetry, Remote Sensing and Spatial Information Sciences.Calgary, Canada: [s.n.], 2011. |

| [22] | FELZENSZWALB P F, HUTTENLOCHER D P. Efficient Graph-based Image Segmentation [J]. International Journal of Computer Vision, 2004, 59(2): 167-181. |