人们越来越依赖移动设备进行工作和娱乐,例如可以通过展开或闭合屏幕以改变屏幕尺寸的可折叠屏幕设备。因此,如何调整图像大小以适应具有不同大小和宽高比的显示设备屏幕,成为与用户体验相关的重要问题。

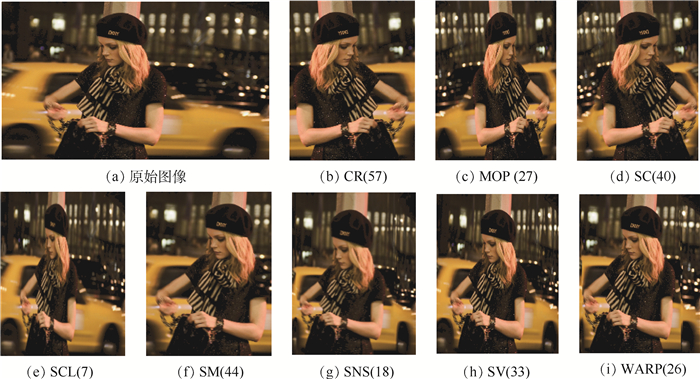

已经有许多成熟的图像重定向方法被提出。为了理解图像重定向方法,图 1展示了原始图像以及MIT数据库中应用8个重定向方法的结果图像,包括裁剪(CR)、多操作符(MOP)[1]、缝裁剪(SC)[2]、线性缩放(SCL)、移位映射(SM)[3]、拉伸和放缩(SNS)[4]、视频流(SV)[5]和变形(WARP)[6]。操作方法后的括号内是对应图像的主观投票数,数值越大表示该图像质量越好。每幅重定向图像保持原始图像的高度并将宽度减小到原始图像的一半。从图 1可以看出,不同的重定向方法具有不同的关注点,并且重定向图像的主观平均意见分数(Mean Opinion Scores,MOSs)也不同。主观地评估每幅重定向图像的质量成本太高。因此,有必要开发有效的客观重定向图像质量评估(Retargeted Image Quality Assessment, RIQA)方法。为了促进对客观RIQA方法的研究,Rubinstein[7]和Ma[8]等建立了2个包含重定向图像和相应的主观评分的数据库。

|

| 图 1 重定向操作方法示例 Fig. 1 Examples of retargeting operation method |

目前,许多RIQA方法被研究出来。早期的RIQA方法通常使用相似性度量。Simakov等[9]提出了一种基于优化视觉数据的双向相似性(Bidirectional Similarity,BDS)度量方法。Liu等[10]提出了一种逆序(自上而下)的方法来组织图像从全局到局部的特征,并通过基于颜色度量的相似性(Color metric-based Similarity,CSim)评估重定向图像。

近年来,已经出现了基于原始图像和重定向图像之间配准的RIQA度量。Zhang等[11]提出了局部块的宽高比相似性(Aspect Ratio Similarity,ARS)度量来描述图像的结构失真。Zhang等[12]提出了基于多级特征(Multiple-Level Feature,MLF)的RIQA方法。MLF考虑ARS、脸部块变形、边缘组相似性特征并使用回归学习来预测重定向图像的感知质量。

尽管现有的RIQA方法表现出很好的评估性能,但主观和客观RIQA之间的一致性仍有待提高。由于高级语义失真,如成分变化和显著对象丢失,以及初级细节失真,如局部内容丢失和局部形状变化可能出现在图像的不同尺度上,本文从多个尺度的图像块中提取失真感知特征。具体而言,本文提出了原始图像和重定向图像之间的ARS的改进度量。此外,本文使用融合的视觉注意力图,其结合了显著性图以及脸部和线条特征,以模拟人类视觉系统对图像的主观关注。

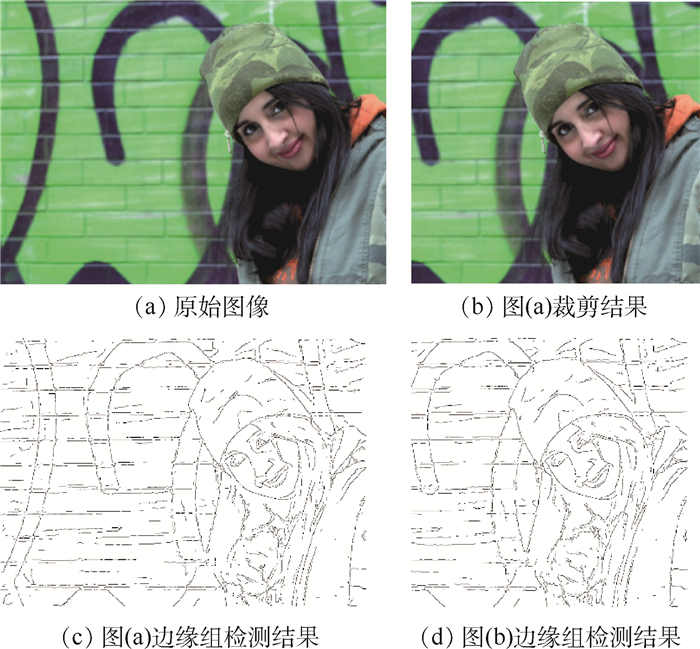

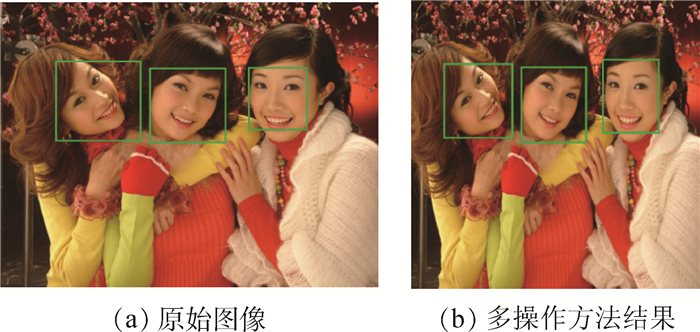

1 多尺度失真感知特征度量本文提出的多尺度失真感知特征(Multi-Scale Distortion-Aware, MSDA)度量可以分为3个阶段。第1阶段,计算视觉注意力融合图[13],通过后向配准方法[11]建立原始图像和重定向图像之间的像素级对应关系。第2阶段,图像重定向过程中的失真由建立的像素级对应关系进行模拟。改进的ARS[11]结合视觉注意力融合图可以更好地捕获每个局部块的信息丢失和视觉失真。本文还使用边缘组相似度[12]和脸部块相似性特征[12]来分别表示对边缘组和脸部块的失真度量。边缘组相似性度量边缘空间排列的变化。图 2展示了边缘组检测结果。脸部块相似性用于描述脸部变形程度。图 3展示了脸部块检测结果,脸部块用矩形框标出。最后,机器学习方法用于将特征映射到主观MOSs并获得训练模型以预测所测试重定向图像的客观质量分数。

|

| 图 2 边缘组检测结果 Fig. 2 Edge group detection results |

|

| 图 3 脸部块检测结果 Fig. 3 Face block detection results |

本文采用ARS[11]作为初级特征,并改进局部块的ARS度量。首先将原始图像划分成规则网格块(例如16像素×16像素)。使用后向配准方法[11]计算重定向图像中与原始图像相对应的变形块。图 4展示了后向配准示例,(a)为原始图像所划分的块,(b)为由原始图像经过多操作符方法得到的结果图像,为了便于展示后向配准结果,图像块划分为64×64。如图 4(b)所示,重定向后所对应的块不再是规则的网格块,通过块的形状变化来度量由重定向操作引入的变形。对于重定向前后的每一对图像块,原始ARS计算公式为

|

| 图 4 后向配准示例 Fig. 4 An example of backward registration |

|

(1) |

式中:rw和rh分别为重定向块的宽度和高度的变化率;rm=(rw+rh)/2为绝对尺度变化率;C=1×10-6和α= 0.3为2个参数;

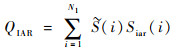

那么整张图像的ARS分数可以表示为QAR,计算公式为

|

(2) |

式中:N1为原始图像当中规则块的数量;w(i)为第i块所对应的权重;Sar(i)为第i块的ARS值。

考虑到式(1)无法在所有情况下正确度量形状畸变。例如,当原始图像的某个块在重定向图像中没有匹配到相应的块时,即rw=rh=0,式(1)计算的视觉失真等于1,这意味着该情况下,ARS没有考虑视觉失真。因此,当在重定向期间移除整个块时,本文引入参数λ作为视觉失真的惩罚因子。改进的ARS度量表示为Siar,计算公式为

|

(3) |

此外,式(2)中的权重w(i)在RIQA方法中起重要作用。通常通过视觉显著性检测方法来计算权重。文献[14]指出,RIQA方法结合不同的显著性检测算法通常表现出不同的性能。Zhang等[13]提出了一种视觉注意融合框架(VAF),该框架首先结合了不同显著性检测算法计算得到的显著性图,然后增强了图像中的脸部和线条特征,最终得到更加全面的显著性图。因此,本文将VAF计算得到的显著性图作为融合ARS块分数的权重。

对于整张图像,改进的ARS度量表示为QIAR,计算公式为

|

(4) |

式中:

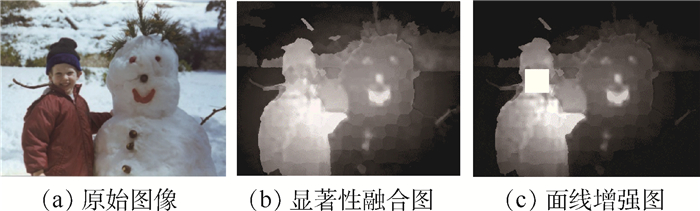

图 5为VAF示例。图 5(b)所示显著性融合图是通过分别对基于离散余弦变换(Discrete Cosine Transform, DCTS)[15]和基于元胞自动机(Background-based map optimized via Single-layer Cellular Automata, BSCA)[16]方法计算得到的显著性图进行均衡化处理,并将2幅结果图进行融合,即在相同位置像素点的显著性值取2幅结果图的平均值。图 5(c)所示面线增强图是通过对重定向图像进行面部检测,同时检测大于对图像角线三分之一的直线,并对这些检测结果位置的显著性进行增强。

|

| 图 5 VAF示例 Fig. 5 An example of VAF |

块是ARS度量的最小单位。不同尺度的块包含不同的信息。因此,ARS在不同尺度块上捕捉到的失真信息是不同的。为了获得最佳评估性能,需要确定最佳的图像块尺度。然而,每幅重定向图像的失真类型不同,与之对应的最佳块尺度也有差异。难以为每幅图像确定最佳尺度,因此使用多尺度方案来解决该问题。由不同尺度捕获的失真弥补单尺度捕获失真的不足,从而取得更好的评估性能。本文使用8×8和16×16两个尺度的块获取图像ARS特征。QIAR8和QIAR16分别表示由式(4)计算得到的块尺度为8和16的2个改进后的ARS度量。QEGS[12]和QFBS[12]分别表示边缘组相似性分数和脸部块相似性分数。对于每幅重定向图像,分别计算该图像的QIAR8、QIAR16、QFBS、QEGS这4个相似性分数,并将这4个特征作为训练特征,主观MOSs作为训练标签,利用支持向量机(SVM)进行回归学习,最后,向学习好的模型输入待评估图像的这4个特征,并输出该图像的客观重定向质量评估分数。

本文按照MLF方法进行实验, 在CUHK数据库[8]上采用基于径向基函数(RBF)内核的支持向量回归模型。由于MIT数据库[7]提供的是成对比较投票,投票表明来源于同一幅原始图像的重定向图像之间的排名,这与CUHK数据库提供的MOSs不同。因此,使用基于RBF内核的SVMrank[17]对MIT数据库图像进行排名回归而不是直接应用支持向量回归。

2 实验结果本节将介绍MIT[7]和CUHK[8]数据库及其性能评估指标,然后将提出的方法与这2个公共数据库上的客观RIQA方法进行比较,包括BDS[9]、SIFT(Scale-Invariant Feature Transform) flow[18]、EMD(Earth-Mover’s Distance)[19]、CSim[10]、PGDIL(Perceptual Geometric Distortion and Information Loss)[20]、ARS[11]和MLF[12]。实验结果表明,与其他方法相比,所提出的MSDA方法与人类主观感知更为一致。

2.1 数据库及评估标准1) MIT数据库

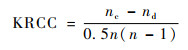

MIT数据库包含37幅原始图像。每幅图像由8种典型的重定向操作方法进行重定向,如图 1所示。经过8种重定向操作后,原始图像共生成296幅重定向图像。210名参与者参加了主观测试,该测试成对进行,受试者从2个并排的重定向图像中选择他们喜欢的图像。重定向图像被选择的次数用作客观质量评估的主观分数并用于数据库实验评估。本文使用肯德尔排名相关系数(Kendall Rank Correlation Coefficient,KRCC)[21]来衡量客观分数与主观排名之间的相关性。KRCC计算公式为

|

(5) |

式中:n为排名序列长度;nc和nd分别为与主观排序一致和不一致的图像对数量。

2) CUHK数据库

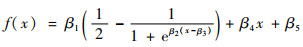

该数据库包含57幅原始图像和171幅重定向图像。除了MIT数据库中使用的8种图像重定向方法外,CUHK数据库还包括优化的缝雕刻和缩放(Seam Carving and Scaling,SCSC)[22]和基于能量变形(Energy-based deformation,ENER)[23]方法。CUHK数据库采用5级质量量化策略分别对每幅重定向图像进行评分,以获得主观意见得分。最后,通过平均获得每个重定向图像的MOSs。4个常用的性能评估指标,包括皮尔逊线性相关系数(Pearson Linear Correlation Coefficient,PLCC)、斯皮尔曼秩次相关系数(Spearman Rank-order Correlation Coefficient,SRCC)、均方根误差(Root Mean Squared Error,RMSE)和异常值比率(Outlier Ratio, OR)[24], 用于评估RIQA方法的性能。PLCC可以通过Sheikh等[25]提出的非线性回归映射函数获得,方程式为

|

(6) |

式中:β1, β2, …, β5为需要进行拟合的参数。SRCC用于测量RIQA度量预测的客观分数的单调性。通过计算非线性回归后主观MOSs与客观评估得分之间的均方根误差,即RMSE。OR为异常值的数量与客观评估得分总数的比率。异常值是在非线性回归之后落在区间[MOS-2σ,MOS+2σ]之外的分数,其中σ为客观评价分数的标准偏差。较大的PLCC值和SRCC值表明客观评估得分与主观MOSs值之间的相关性较高,而较小的RMSE和OR值表明RIQA方法的预测分数与主观分数越接近。

2.2 MIT数据库性能对比本文使用基于RBF内核的SVMrank[17]在MIT数据库上采用LOOCV(Left One-Out Cross-Validation)方式进行多尺度失真感知特征融合。对于每幅原始图像,使用原始图像作为查询,并将8幅重定向图像的主观投票作为排名顺序。将原始图像和8幅重定向图像归为一组,共计37组。对于每组,使用剩余的36组进行训练,然后对该组进行测试。最后,评估结果。将提出的MSDA方法与现有方法进行比较。给出每个RIQA度量的平均KRCC和标准偏差,以及具有特定属性的图像子集的平均KRCC。表 1给出MSDA方法在MIT各子集的KRCC指标,其中p-val是指在一个概率模型中,统计摘要(如两组样本均值差)与实际观测数据相同,或甚至更大这一事件发生的概率。实验结果显示,本文提出的MSDA方法性能是每个子集中所有对比方法的前两名,并且平均性能比MLF方法提高4.1%。

| 方法 | KRCC | KRCC均值 | KRCC标准差 | p-val | |||||

| 线条 | 人脸 | 前景物体 | 纹理 | 几何结构 | 对称结构 | ||||

| BDS | 0.040 | 0.190 | 0.167 | 0.060 | -0.004 | -0.012 | 0.083 | 0.268 | 0.017 |

| SIFTflow | 0.097 | 0.252 | 0.218 | 0.161 | 0.085 | 0.071 | 0.145 | 0.262 | 0.031 |

| EMD | 0.220 | 0.262 | 0.226 | 0.107 | 0.237 | 0.500 | 0.251 | 0.272 | 1×10-5 |

| CSim | 0.097 | 0.290 | 0.293 | 0.161 | 0.053 | 0.150 | 0.164 | 0.263 | 0.028 |

| PGDIL | 0.431 | 0.390 | 0.389 | 0.286 | 0.438 | 0.523 | 0.415 | 0.296 | 6×10-10 |

| ARS | 0.463 | 0.519 | 0.444 | 0.330 | 0.505 | 0.464 | 0.452 | 0.283 | 1×10-11 |

| MLF | 0.486 | 0.605 | 0.544 | 0.384 | 0.536 | 0.536 | 0.512 | 0.251 | 1×10-14 |

| MSDA | 0.511 | 0.633 | 0.539 | 0.455 | 0.571 | 0.535 | 0.533 | 0.265 | 9×10-21 |

为进一步研究所提方法的有效性,表 2给出在MIT数据库上的特征分析实验。边缘组相似性和脸部块相似性特征的有效性已在MLF[12]中得到验证,因此仅对多尺度特征进行实验,该实验使用VAF计算的显著性图。表 2第1组实验为不使用改进的ARS度量的情况下,仅将ARS方法的显著性检测方法更改为VAF方法进行实验。第2、3组为使用单一尺度的改进宽高比特征QIAR8和QIAR16进行实验,相比于MLF,性能均有提升,而使用MSDA方法,性能进一步提高,说明2个尺度的ARS特征具有互补的作用,可以更好地捕获重定向图像失真。此外,VAF对MLF性能的提高为2.5%,在VAF的基础上,QIAR16和多尺度特征分别提高1.1%和1.5%,说明显著性检测算法对评估结果影响较大。

| 方法 | 线条 | 人脸 | 前景物体 | 纹理 | 几何结构 | 对称结构 | KRCC均值 | KRCC标准差 |

| QARS+QEGS+QFBS | 0.503 | 0.614 | 0.532 | 0.420 | 0.554 | 0.500 | 0.525 | 0.260 |

| QIAR8+QEGS+QFBS | 0.506 | 0.610 | 0.456 | 0.528 | 0.571 | 0.512 | 0.527 | 0.269 |

| QIAR16+QEGS+QFBS | 0.503 | 0.643 | 0.455 | 0.552 | 0.558 | 0.512 | 0.531 | 0.267 |

| MSDA | 0.511 | 0.633 | 0.539 | 0.455 | 0.571 | 0.535 | 0.533 | 0.265 |

2.3 CUHK数据库性能对比

本文在CUHK数据库上采用SVR 5折交叉验证模型。数据库随机分为2个子集,80%作为训练集,20%作为测试集。训练集和测试集之间没有重叠。重复随机训练测试过程1 000次并记录1000次迭代的中值。从表 3可以看出,尽管RMSE和OR的指标低于MLF方法,但MSDA的PLCC和SRCC指标相对MLF方法分别提高1.8%和4.5%,总体具有更好的主观感知一致性和预测性能。

| 方法 | PLCC | SRCC | RMSE | OR |

| BDS | 0.289 6 | 0.288 7 | 12.922 | 0.216 4 |

| SIFTflow | 0.314 1 | 0.289 9 | 12.817 | 0.142 6 |

| EMD | 0.276 0 | 0.290 4 | 12.977 | 0.169 6 |

| CSim | 0.437 4 | 0.566 2 | 12.141 | 0.152 0 |

| PGDIL | 0.540 3 | 0.540 9 | 11.361 | 0.152 0 |

| ARS | 0.683 5 | 0.669 3 | 9.855 | 0.070 2 |

| MLF | 0.757 7 | 0.738 3 | 8.525 | 0.029 4 |

| MSDA | 0.771 3 | 0.771 7 | 8.593 | 0.035 0 |

与MIT数据库实验类似,本文同样给出在验CUHK数据库上的特征分析实验,实验采用的特征与MIT数据库的对比实验相同,实验过程与表 3相同。表 4给出CUHK数据库上的特征分析结果, 可以得到与MIT数据库上相同的结论,进一步说明MSDA方法的有效性。

| 方法 | PLCC | SRCC | RMSE | OR |

| QARS+QEGS+QFBS | 0.761 0 | 0.758 5 | 8.759 6 | 0.046 8 |

| QIAR8+QEGS+QFBS | 0.763 9 | 0.769 4 | 8.713 0 | 0.040 9 |

| QIAR16+QEGS+QFBS | 0.770 9 | 0.766 3 | 8.599 | 0.040 9 |

| MSDA | 0.771 3 | 0.771 7 | 8.593 | 0.035 0 |

2.4 讨论

为了研究不同尺度组合对评估性能的影响,本文对不同尺度块的改进ARS特征组合进行实验。表 5和表 6分别为MIT和CUHK数据库的不同特征组合的对比实验。本文在这个实验中提取的块尺度特征分别为QIAR8、QIAR16和QIAR32,由于块尺度过大会导致ARS度量忽略细节失真,另一方面,选择的块尺度变化过小,则对实验结果影响不明显。因此,块尺度取8、16、32。从实验结果可以看出,当块尺度组合为8和16时,RIQA方法结果具有最高的主观感知一致性。

| 组合 | KRCC均值 | KRCC标准差 |

| QIAR8+QIAR16 | 0.533 | 0.265 |

| QIAR8+QIAR32 | 0.529 | 0.260 |

| QIAR16+QIAR32 | 0.525 | 0.267 |

| 组合 | PLCC | SRCC | RMSE | OR |

| QIAR8+QIAR16 | 0.771 3 | 0.771 7 | 8.593 0 | 0.035 0 |

| QIAR8+QIAR32 | 0.754 1 | 0.753 7 | 8.865 8 | 0.040 9 |

| QIAR16+QIAR32 | 0.767 7 | 0.766 6 | 8.652 2 | 0.035 0 |

表 7和表 8给出MSDA方法分别在2个数据库上结合不同显著性检测算法的对比实验结果,采用当前最新的级联部分解码器(CPD)[26]以及ARS方法使用的DCTS[15]显著性检测算法。由表 7和表 8实验结果可以得出,VAF在3种不同显著性检测算法当中性能表现最好。并且最新的显著性检测算法并没有表现出好的性能,其原因在于CPD方法的检测结果虽然可以很好地检测显著性区域,但该方法并没有对显著性区域和次显著性区域进行区分,即显著性区域都赋予同样的显著性值。而VAF方法则对不同显著性区域赋予不同的显著性值,特别是对人脸和线条部分进行显著性增强,使得该显著性检测算法更符合重定向图像在质量评估上的需求。

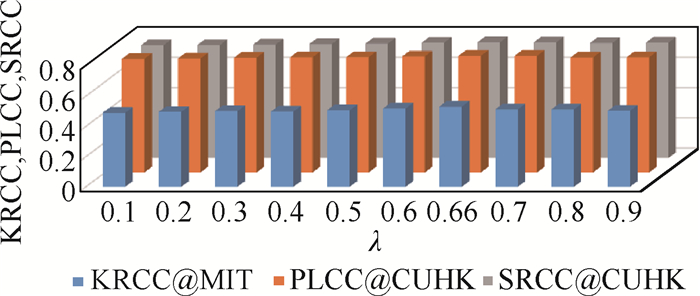

本文对ARS特征进行深入研究,λ的取值为0~1,λ取值越大表示对重定向图像中被移除块的视觉失真惩罚越小,而不同图像被移除块对重定向图像的影响不同,因此有必要对λ进行实验,寻找最佳的参数设置。图 6给出了不同λ取值对实验结果的影响,从柱状图可以看出,λ= 0.66时,MSDA方法性能最好。

|

| 图 6 不同λ值对实验结果的影响 Fig. 6 Influence of different λ values on experimental results |

本文提出了一个MSDA方法来预测客观重定向图像质量,并使用视觉注意力融合图结合4个有效特征来捕获图像重定向期间产生的失真。在2个公共数据库MIT和CUHK上,所提出的MSDA方法比对比方法具有更高的主观感知一致性。本文深入研究细节失真特征并通过实验可得以下结论:

1) 相比于改进的ARS度量以及多尺度方法,显著性检测算法对实验结果影响更大。

2) 改进的ARS度量原始图像中整块像素在重定向过程中全部被移除的情况,该度量与VAF计算的显著性图相结合可以更好地捕捉细节失真,从而提高MSDA方法性能。

3) 多尺度方法为RIQA度量提供更全面的失真信息,弥补单尺度捕获失真的不足,从而提高RIQA方法与人类主观感知一致性。

虽然所提出的MSDA方法表现出良好的性能,但无论是细节失真特征、语义失真特征以及显著性检测算法,都需要进一步研究以更好地进行客观RIQA。

| [1] |

RUBINSTEIN M, SHAMIR A, AVIDAN S. Multi-operator media retargeting[J]. ACM Transactions on Graphics, 2009, 28(3): 23. |

| [2] |

AVIDAN S, SHAMIR A. Seam carving for content-aware image resizing[J]. ACM Transactions on Graphics, 2007, 26(3): 10. DOI:10.1145/1276377.1276390 |

| [3] |

PRITCH Y, KAV-VENAKI E, PELEG S.Shift-map image editing[C]//IEEE 12th International Conference on Computer Vision.Piscataway, NJ: IEEE Press, 2009: 151-158.

|

| [4] |

WANG Y S, TAI C L, SORKINE O, et al. Optimized scale-and-stretch for image resizing[J]. ACM Transactions on Graphics, 2008, 27(5): 118. |

| [5] |

KRÄHENBVHL P, LANG M, HORNUNG A, et al. A system for retargeting of streaming video[J]. ACM Transactions on Graphics, 2008, 28(5): 126. |

| [6] |

WOLF L, GUTTMANN M, COHEN-OR D.Non-homogeneous content-driven video-retargeting[C]//IEEE 11th International Conference on Computer Vision.Piscataway, NJ: IEEE Press, 2007: 1-6.

|

| [7] |

RUBINSTEIN M, GUTIERREZ D, SORKINE O, et al. A comparative study of image retargeting[J]. ACM Transactions on Graphics, 2010, 29(6): 160. |

| [8] |

MA L, LIN W, DENG C, et al. Image retargeting quality assessment:A study of subjective scores and objective metrics[J]. IEEE Journal of Selected Topics in Signal Processing, 2012, 6(6): 626-639. DOI:10.1109/JSTSP.2012.2211996 |

| [9] |

SIMAKOV D, CASPI Y, SHECHTMAN E, et al.Summarizing visual data using bidirectional similarity[C]//IEEE Conference on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE Press, 2008: 1-8.

|

| [10] |

LIU Y J, LUO X, XUAN Y M, et al. Image retargeting quality assessment[J]. Computer Graphics Forum, 2011, 30(2): 583-592. DOI:10.1111/j.1467-8659.2011.01881.x |

| [11] |

ZHANG Y, FANG Y, LIN W, et al. Backward registration based aspect ratio similarity for image retargeting quality assessment[J]. IEEE Transactions on Image Processing, 2016, 25(9): 4286-4297. DOI:10.1109/TIP.2016.2585884 |

| [12] |

ZHANG Y, LIN W, LI Q, et al. Multiple-level feature-based measure for retargeted image quality[J]. IEEE Transactions on Image Processing, 2018, 27(1): 451-463. |

| [13] |

ZHANG S, NIU Y Z, LIN J W, et al. Visual attention fusion framework for image retargeting quality assessment[J]. IOP Conference Series:Earth and Environmental Science, 2019, 234(1): 12-64. |

| [14] |

CHEN Z, LIN J, LIAO N, et al. Full reference quality assessment for image retargeting based on natural scene statistics modeling and bi-directional saliency similarity[J]. IEEE Transactions on Image Processing, 2017, 26(11): 5138-5148. DOI:10.1109/TIP.2017.2736422 |

| [15] |

FANG Y, CHEN Z, LIN W, et al. Saliency detection in the compressed domain for adaptive image retargeting[J]. IEEE Transactions on Image Processing, 2012, 21(9): 3888-3901. DOI:10.1109/TIP.2012.2199126 |

| [16] |

QIN Y, LU H, XU Y, et al.Saliency detection via cellular automata[C]//IEEE Conference on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE Press, 2015: 110-119.

|

| [17] |

JOACHIMS T.Training linear SVMs in linear time[C]//ACM SIGKDD International Conference on Knowledge Discovery & Data Mining.New York: ACM, 2006: 217-226.

|

| [18] |

LIU C, YUEN J, TORRALBA A. SIFT flow:Dense correspondence across scenes and its applications[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2010, 33(5): 978-994. |

| [19] |

PELE O, WERMAN M.Fast and robust earth mover's distances[C]//IEEE 12th International Conference on Computer Vision.Piscataway, NJ: IEEE Press, 2009: 460-467.

|

| [20] |

HSU C C, LIN C W, FANG Y, et al. Objective quality assessment for image retargeting based on perceptual geometric distortion and information loss[J]. IEEE Journal of Selected Topics in Signal Processing, 2014, 8(3): 377-389. DOI:10.1109/JSTSP.2014.2311884 |

| [21] |

KENDALL M G. A new measure of rank correlation[J]. Biometrika, 1938, 30(1): 81-93. |

| [22] |

DONG W, ZHOU N, PAUL J C, et al. Optimized image resizing using seam carving and scaling[J]. ACM Transactions on Graphics, 2009, 28(5): 125. |

| [23] |

KARNI Z, FREEDMAN D, GOTSMAN C. Energy-based image deformation[J]. Computer Graphics Forum, 2009, 28(5): 1257-1268. DOI:10.1111/j.1467-8659.2009.01503.x |

| [24] |

WANG Z, LU L, BOVIK A C. Video quality assessment based on structural distortion measurement[J]. Signal Processing:Image Communication, 2004, 19(2): 121-132. DOI:10.1016/S0923-5965(03)00076-6 |

| [25] |

SHEIKH H R, SABIR M F, BOVIK A C. A statistical evaluation of recent full reference image quality assessment algorithms[J]. IEEE Transactions on Image Processing, 2006, 15(11): 3440-3451. DOI:10.1109/TIP.2006.881959 |

| [26] |

WU Z, SU L, HUANG Q M.Cascaded partial decoder for fast and accurate salient object detection[EB/OL].(2018-04-18)[2019-07-09].https://arxiv.org/abs/1904.08739?context=cs.CV.

|