2. 江西财经大学 软件与物联网工程学院, 南昌 330032

2. School of Software and Internet Things Engineering, Jiangxi University of Finance and Economics, Nanchang 330032, China

遥感的目的是通过获取卫星的光谱测量,提取有关地球表面结构和内容的信息[1]。由于传感器技术的限制,同时在空间域和光谱域上获取高分辨率难以实现,因此通常利用图像处理技术融合现有的2类遥感图像,即高空间分辨率、低光谱分辨率的全色(Panchromatic, PAN)图像和低空间分辨率、高光谱分辨率的多光谱(Multispectral, MS)图像。对于在同一区域同时获得的PAN图像和MS图像,通过适当的算法,将这些数据结合起来,生成具有高空间分辨率和高光谱分辨率的图像,这一过程也称为PAN锐化[2]。遥感图像融合广泛应用于地理、军事、农业、生态环境等领域。

现有的传统PAN锐化方法主要分为2类:一类是成分替代法(Component Substitute, CS),即将MS图像的成分替换成PAN图像成分,如亮度-色度-饱和度变换法(Intensity-Hue-Saturation, IHS)[3]、主成分分析法(Principle Component Analysis, PCA)[4]、基于施密特正交化方法(Gram-Schmidt, GS)[5]等。基于CS方法的融合结果具有较高的空间分辨率,但其光谱容易失真。另一类是多尺度分析法(Multi-Resolution Analysis, MRA),即对PAN图像进行多尺度分解后将提取的细节加入到MS图像中。基于MRA的方法和基于CS的方法的主要区别在于如何提取空间细节[6]。对于MRA方法,通过PAN图像与其低通滤波之后的图像之间的差异来获得空间结构信息。传统的MRA方法主要包括基于金字塔分解或者小波变换的方法,如离散小波变换[7]、àtrous小波变换[8]、非抽样的轮廓波变换[9]、非抽样的剪切波变换[10]等。MRA方法可以较好地保存光谱信息,但可能会损失部分空间信息,因此文献[11]提出了一种基于引导滤波多尺度分解的方法,效果有所改进。最新的理论研究提出了稀疏表示(Sparse Representation, SR)的方法[12-13],以及非线性的途径如卷积神经网络[14]等,取得了较好的效果。但是,这些算法需要大量的计算,运行时间较长,且需要大量的样本。由于遥感图像样本数量的限制,以及算法效率的要求,本文综合考虑了上述几种方法,对基于MRA方法的注入模型进行优化,以实现融合时对光谱信息与细节信息的双保真。

基于MRA方法中关键的一步在于如何提取PAN图像细节。一种较为先进的方法是利用线性时不变的滤波器去匹配MS传感器的点传播函数(Point Spread Function, PSF)。Aiazzi等[15]提出使用高斯滤波器去匹配MS传感器的调制传输函数,但需要使用MS传感器的出厂信息,而该信息不易获得。另一种较为可靠的方法是从现有图像中估计滤波器以模拟MS传感器的PSF。在此框架下,一幅低空间分辨率的MS(Low Resolution MS, LRMS)图像,可以通过滤波器对一幅高空间分辨率的MS(High Resolution MS, HRMS)图像进行空间滤波得到。该滤波器的冲击响应函数可模拟MS传感器的PSF,且该滤波器通常有与高斯模型相似的形状[2, 15]。使用该滤波器卷积PAN图像,所得的高频分量即为HRMS图像中缺失的细节成分,且与MS图像高线性相关。此外,综合考虑光谱的保真和细节的注入,本文提出了一种基于相关性分析的高斯滤波估计和自适应细节注入的遥感图像融合方法。首先,通过引导滤波多尺度分解的注入模型得到初始融合图像;其次,用高斯滤波模拟MS传感器的PSF,并用估计的高斯滤波器卷积PAN图像得到优化的注入细节;然后,递归计算自适应的注入系数,使光谱保真与细节注入达到联合最佳;最后,通过一种新的边缘保持策略,得到融合图像。

本文主要创新点如下:①提出了一种基于高斯滤波估计的细节提取方法,使注入的细节得到优化; ②提出了一种综合考虑光谱信息与细节信息的自适应注入系数模型,实现融合图像对光谱信息与细节信息的双保真; ③提出了一种减少光谱信息损失的边缘保持模型,在增强边缘信息的同时保留光谱信息。

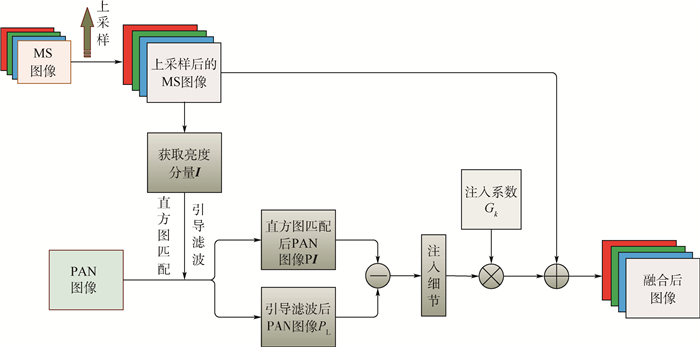

1 相关工作 1.1 注入模型的一般框架基于MRA方法的注入模型是指通过滤波提取PAN图像细节,再利用注入系数将其注入到MS图像中的一种融合方法。该方法可根据实际需要,组合不同的融合技术,以发挥不同融合技术的优点。基于传统的MRA方法注入模型框架如图 1所示,该注入模型的一般表示形式如下[16]:

|

| 图 1 注入模型一般框架 Fig. 1 Basic framework of injection model |

|

(1) |

式中:k={1, 2, …,N}表示N个通道中的第k个子通道;

对于注入系数Gk,文献[16]通过迭代算法,提出基于回归模型的通道间权重系数;文献[17]提出基于像素通道间比例的权重系数;文献[18]通过高通调制(High Pass Modulation, HPM)方法,用MS图像和PAN图像的乘法组合作为注入系数。其中,基于通道间比例的注入系数能更好地保持光谱信息,融合效果较好,通道间注入系数定义如下:

|

(2) |

由于注入细节的同时不希望改变色度与饱和度,因此图像融合过程中往往仅对图像的亮度分量进行处理。MS图像的亮度分量I可由如下公式计算:

|

(3) |

式中:αk为通道的组合系数。

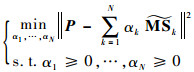

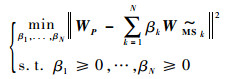

文献[19-20]提出I分量可自适应地由各通道线性组合表示,即通过求解以下优化问题得到组合系数:

|

(4) |

式中:P为PAN图像。

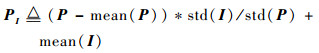

在得到MS图像的I分量之后,将P与式(3)的I进行直方图匹配,得到的PI可由如下公式计算:

|

(5) |

式中:mean(P)为P的均值;mean(I)为I分量的均值;std(I)为I分量的标准差;std(P)为P的标准差。

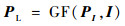

1.3 引导滤波引导滤波最早由文献[21]提出,其可以保存输入图像的主要信息,同时获得引导图像的变化趋势。将PI作为输入图像,I作为引导图像,PI通过I引导滤波产生PL,获得了与MS图像线性相关的细节信息。引导滤波可由如下简化公式而得:

|

(6) |

式中:GF(·)表示引导滤波函数。

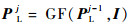

多尺度引导滤波[22]可表示为

|

(7) |

式中:j为引导滤波层数;PLj为PI经第j层引导滤波得到的图像。

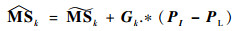

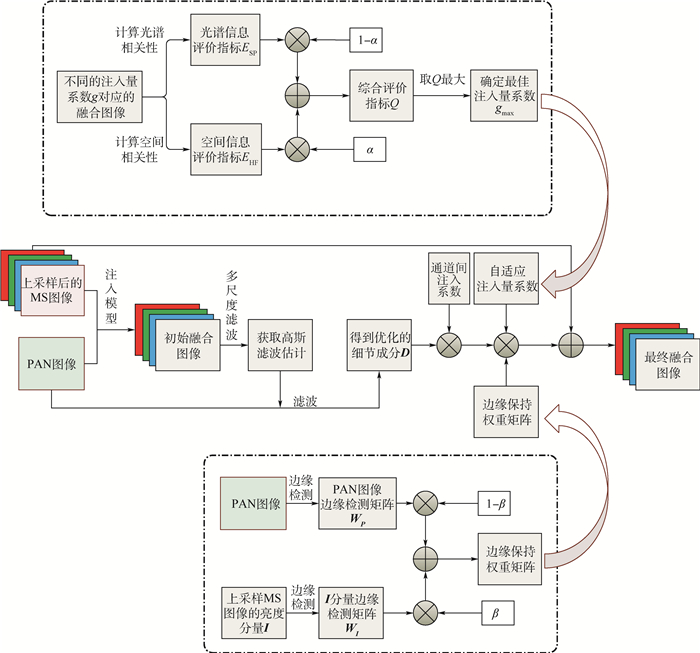

2 图像融合方法目前,遥感图像融合注入模型主要存在2类问题:因PAN图像与MS图像相关性不高导致的光谱失真;细节注入过多或者注入不足。针对上述问题,本文提出了一种基于高斯滤波估计的细节提取及自适应的注入系数优化方法。本文融合方法框架如图 2所示。

|

| 图 2 本文融合方法框架 Fig. 2 Framework of proposed fusion method |

首先,根据式(1),将上采样后的MS图像与PAN图像通过直方图匹配、引导滤波等传统注入模型得到初始融合图像F(1);其次,进行细节优化,即用多尺度高斯滤波器滤波该初始融合图像以模拟MS传感器的特性,将得到的高斯滤波估计滤波PAN图像,得到优化后的细节;然后,优化注入效益,即综合考虑光谱信息与细节信息计算自适应的注入量系数,具体流程如图 2上虚线框所示,详细算法见2.2节;最后,通过一种自适应的边缘保持权重矩阵保持边缘信息,具体流程如图 2下虚线框所示,详细算法见2.3节。将优化后的细节与注入系数及边缘权重系数相乘以后,注入到上采样后的MS图像中,得到最终的融合图像。

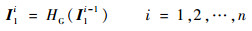

2.1 高斯滤波估计及细节提取文献[15]提出使用高斯滤波器匹配MS传感器的调制传输函数,即HRMS图像经过MS传感器之后成为LRMS图像,使用高斯滤波模拟该过程,所得的高斯滤波器即为符合MS传感器PSF的滤波估计。使用估计的滤波器卷积PAN图像,提取的细节成分即为低分辨率MS图像所缺失的细节。文献[15]通过实验证明了该滤波估计有较强的鲁棒性,即使在初始融合图像中加入白噪声,也不影响细节的提取。另外,文献[17]提出了二步骤多尺度分解的方法来精细化PAN锐化。受此启发,本文提出使用多尺度高斯滤波模拟MS传感器的PSF,即对初始融合图像F(1)提取亮度分量,记为I1,并迭代地进行高斯滤波,具体可表示为

|

(8) |

式中:I1i为第i次滤波后的图像;HG(·)表示高斯滤波。

为了获取最佳高斯滤波估计,计算式(8)所得的结果I1i与上采样后的MS图像的亮度分量I的相关系数,相关系数最高时,估计的高斯滤波最准确。相关系数计算如下:

|

(9) |

式中:cov(·)表示协方差函数。

随着滤波层次的增加,滤波后的图像与上采样的MS图像越来越接近,达到极大值之后,随着滤波层次继续增加,滤波后图像与上采样的MS图像偏离越来越大。通过迭代计算式(8)和式(9)的值,取得式(9)最大时的迭代次数m,即为所估计的高斯滤波器Hm,表示如下:

|

(10) |

Hm即表示一幅锐化图像经MS传感器模糊化的PSF最佳匹配,将滤波器Hm作用于PAN图像,所提取的细节成分也应符合MS传感器PSF,这样就减少了光谱失真。细节提取D定义如下:

|

(11) |

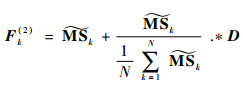

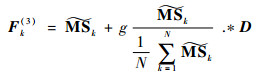

结合式(1)、式(7)和式(11),细节优化后,第k通道融合图像Fk(2)可更新为

|

(12) |

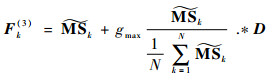

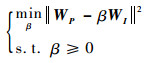

取得优化的注入细节之后,对注入量进行优化。不同的图像有不同的结构特征和光谱信息,从而对细节注入量有不同的要求,直接等比例注入细节容易导致注入过多从而引起光谱失真,或者注入不足导致图像模糊,因此需要通过一个注入量系数g来平衡光谱信息与细节信息。加入该系数后,结合式(12),新的融合图像Fk(3)可以定义为

|

(13) |

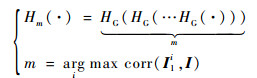

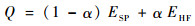

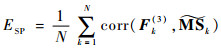

需要对不同结构特征的遥感图像确定不同的注入量系数g。文献[23]认为注入模型中光谱的保真与空间分辨率要求需要保持平衡,可以将两者的评价指标进行加权求和作为融合图像指标,权重表示重视程度。设定细节注入量系数g的初值g和步长r,对于g0≤g≤1,得到相应的融合后图像并计算加权评价指标,取得使该评价指标最高的gmax作为最终的注入量系数。对于评价指标,本文提出了一种基于相关性分析的光谱信息与空间信息综合评价体系,将光谱信息与空间信息的综合评价指标Q定义为

|

(14) |

式中:ESP和EHF分别为光谱信息评价指标和空间信息评价指标;α为两者的权重。

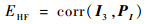

对于一幅由式(13)融合后的图像Fk(3),其亮度分量记为I3,则ESP用融合后的图像与上采样的MS图像各通道k之间相关系数的平均值来表示,EHF则用I3与PAN图像的线性相关性表示,定义为

|

(15) |

|

(16) |

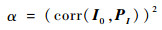

文献[6]表明,在注入成分与注入量系数g的优化确定上,遵循的前提是MS图像的亮度成分与PAN图像相关性越大,融合效果越好。即若两者相关性高,注入细节的同时能较好地保存光谱信息,此时可以适当增加空间信息的权重,减少光谱信息的权重;反之,若相关性低,则注入的细节容易引起光谱失真,应当增加光谱信息权重而减少空间信息权重。设初值g0产生的融合图像对应的亮度成分记为I0,则式(14)中的权重α可由下式确定:

|

(17) |

平方项的作用为:①避免I0与PI高相关时光谱权重过小;②放大不同图像空间信息之间的区别。

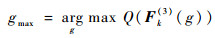

对于不同的注入量系数g,根据式(13)迭代计算Fk(3),并根据式(14)计算综合评价指标Q,取得使指标Q最高的gmax作为最终融合图像的注入量系数,并得到最后的融合结果。gmax可表示为

|

(18) |

结合式(13)和式(18),使用优化后的注入量系数,新的融合图像可更新为

|

(19) |

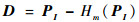

为保持边缘纹理信息,Leung等[20]提出利用边缘信息作为各通道融合权重,Yang等[11, 24]提出利用改进的边缘信息作为注入各像素的权重。其中,改进的边缘信息计算PAN图像的边缘检测矩阵WP,以及上采样后的MS图像各通道的边缘检测矩阵

|

(20) |

式中:βk为各通道的加权系数,可由式(21)计算得到[11];边缘检测矩阵[19]可由式(22)得到。

|

(21) |

|

(22) |

式中:A为某图像;▽A为图像A的梯度;λ和ε为调制参数。

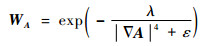

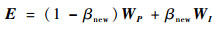

式(21)获取各通道的边缘信息权重,在细节上有更好的表现,但作为注入系数时改变了各通道间的比例,光谱信息略有损失。为了尽量保持原有光谱信息,同时实现边缘信息的保持,本文提出一种新的边缘保持权重矩阵。针对式(21),将求取各通道的边缘检测矩阵

|

(23) |

式中:WP和WI计算方法同式(22);自适应的权重因子βnew由式(24)计算,并由式(25)归一化得到。

|

(24) |

|

(25) |

根据式(23)得到的边缘保持权重矩阵E,再结合式(19),可得到最终融合图像Fk(4),表示如下:

|

(26) |

与式(20)的边缘保持权重矩阵相比,本文得到的边缘保持权重矩阵E仅对细节成分D产生权重变化,以尽可能增强边缘信息,并不改变通道间的比例,从而减少光谱损失。

3 实验结果分析 3.1 实验设置为评估本文方法的有效性,使用来自不同遥感卫星的四大数据集,包括QuickBird、IKONOS、WorldView-2及pleiades,这些遥感图像在空间分辨率、光谱波长等方面都有不同的特征,且都包括红、绿、蓝、近红外4个通道。

参数设置中,设置注入量系数初值g0=0.1,步长r=0.05,以综合考虑计算效率与计算精度;高斯滤波器窗口设置为5×5,参考文献[25]中的默认设置;式(22)中设置参数λ=10-9, ε=10-10,同样参考文献[19]中的默认设置。

本文进行了2种类型的实验。一种是对真实图像进行下采样之后的仿真图像,也称为有参考遥感图像融合实验,即遵循Wald协议[26],原图像作为参考图像,仿真图像包含四大数据集共计80组图片。另一种是真实图像的实验,也称为无参考遥感图像融合实验,真实图像包括四大数据集共计50组图片。

用于对比的方法包括最新的几种方法,其中基于MRA模型的方法有基于调制传递函数模型的多尺度分析方法(CBD)[15]、加性小波亮度比的方法(Additive Wavelet Luminance Proportion, AWLP)[27]、基于双边滤波亮度比的方法(Bilateral Filter Luminance Proportional, BFLP)[28];将MRA和CS两种模型相结合的方法有基于多尺度引导滤波和改进的成分替代法(Improved IHS and Multi-Scale Guided Filter, IMG)[11];将注入模型与其他算法相结合的方法有基于抠图模型和多尺度变换的方法(Matting Model and Multi-scale Transform, MMMT)[24]、基于自适应光谱与亮度调制的方法(Adaptive Spectral Intensity Modulation Pansharpening, ASIMP)[25]。对这些方法分别进行主观评价与客观评价,也即定性和定量评价。

3.2 质量评价评价包括肉眼视觉的主观评价和客观评价指标的定量评价。常用的有参考图像的客观评价指标如下:

1) 相关系数(Correlation Coefficient, CC)[12]。主要用于评价融合图像与参考图像的空间相似度,其值区间为[0, 1],越接近1表示2幅图像越相近,融合效果越好。

2) 通用图像质量指数(Universal Image Quality Indexes, UIQI)[29]。UIQI联合相关度损耗、亮度失真和对比度失真3个因子来评价融合图像的效果,值区间为[0, 1]。UIQI的值越接近1,说明结构失真越小。

3) 均方根误差(Root Mean Square Error,RMSE)[30]。RMSE计算融合图像与参考图像各像素之间均方根误差,用于表示两者的差异,其理想值为0。

4) 相对平均光谱误差(Relative Average Spectral Error, RASE)[31]。RASE反映融合图像在光谱方面的误差,其理想值为0。

5) 光谱角映射(Spectral Angle Mapper, SAM)[32]。SAM用于度量2幅图像之间的光谱信息接近程度,其值越小,光谱失真越小,理想值为0。

6) 全局相对光谱损失(ERGAS)[33]。ERGAS用于评估融合图像的空间和光谱质量,其值越小说明总体性能越好,理想值为0。

常用的无参考图像的客观评价指标包括Ds、Dλ和QNR[34]。其中,QNR值由Ds和Dλ共同计算而得,并基于UIQI测度评价融合图像和参考图像间的局部相关性、亮度和对比度。Ds和Dλ越小越好,理想值为0,而QNR值越大越好,理想值为1。

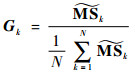

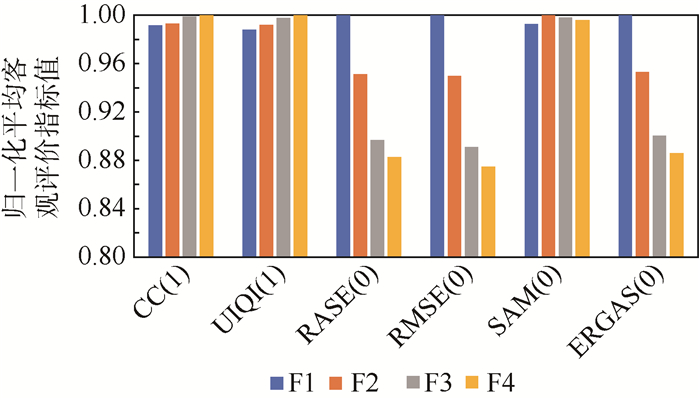

3.3 算法性能分析为了验证2.1节~2.3节提出的优化方法的有效性,定量说明本文方法所带来的性能提升,分别计算各优化步骤的平均客观评价指标。4个优化步骤对应的融合图像表示为:F1表示初始融合图像;F2表示经高斯滤波优化细节后图像;F3表示经自适应优化注入量系数后的图像;F4表示加入自适应边缘保持后的图像。并分别计算80组图像融合结果的平均客观评价指标。这4个步骤是依次递进的过程。为了更直观地展示各指标的相对变化,各客观评价指标分别进行最大值归一化处理,结果如图 3所示。可知,对于初始融合图像F1,注入细节是通过PAN图像与MS图像的I分量进行直方图匹配再由引导滤波得到,细节存在与MS图像线性非相关的问题,且未考虑注入量,从而导致融合结果与参考图像的光谱相关度和空间相关度较低;通过估计的高斯滤波器优化细节后,所得的细节与MS图像有更高的相关性,各项指标明显提升;而优化注入量系数后,有效防止了注入过多或注入不足,所有的指标进一步提升;进行边缘保护后,改进的边缘保持方法在保护边缘信息的同时,减少了光谱失真。随着F2、F3、F4优化步骤的依次进行,总体指标也越来越优。其中SAM指标基本保持平稳,随着优化的进行,SAM指标先小幅上升再小幅降低,说明本文方法对光谱信息损失的影响很小。

|

| 图 3 优化过程平均客观评价指标对比 Fig. 3 Average objective evaluation indicator comparison of optimization steps |

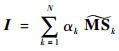

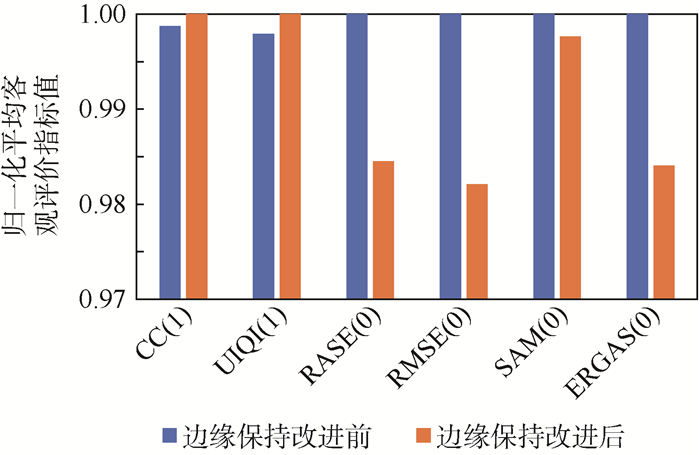

如2.3节所述,本文提出的一种新的自适应边缘保持方法是对文献[11]的改进。为了验证本文方法的有效性,在保持前3个步骤不变的前提下,对改进前[11]与改进后的方法在80组遥感图像上进行平均客观评价指标对比,指标同样进行最大值归一化处理,结果如图 4所示。可知,改进后的边缘保持方法在所有指标上都有所提升,其中,在RASE、RMSE及ERGAS等指标上提升效果明显,可知本文方法能有效地提升图像融合的质量,减少光谱损失。

|

| 图 4 边缘保持方法改进前后平均客观评价指标对比 Fig. 4 Comparison of average objective evaluation indicators before and after improvement of edge preserving method |

本文采用3组来自不同卫星的遥感图像作为展示,分别进行主观效果和客观评价指标的评价,然后对80组图像测量平均客观评价指标。

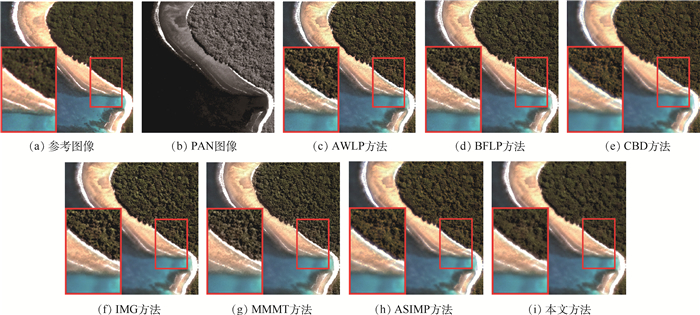

第1组图像来自QuickBird数据集,参考图像大小为256×256,经不同方法融合后主观效果如图 5所示。小红色矩形框区域经放大后在大矩形框中显示。可知,AWLP方法、CBD方法、IMG方法森林区域存在明显光谱失真,与参考图像相比,颜色偏亮;BFLP方法、MMMT方法有稍微的光谱失真,且存在过度注入问题,引入了不必要的噪声。ASIMP方法与本文方法在海滩细节与森林的光谱信息上与参考图像较为接近,难以用肉眼区别,用表 1所示的客观评价指标加以区分。表中:黑体数据表示最优值,下划线数据表示次优值。可知,本文方法除了在SAM指标上比BFLP方法略低以外,在所有其他指标上都达到最优。

|

| 图 5 QuickBird数据集遥感图像融合结果 Fig. 5 Fusion results of remote sensing images from QuickBird dataset |

| 方法 | CC(1) | UIQI(1) | RASE(0) | RMSE(0) | SAM(0) | ERGAS(0) |

| AWLP | 0.954 3 | 0.842 5 | 24.337 7 | 19.664 9 | 4.835 5 | 7.141 5 |

| BFLP | 0.961 5 | 0.848 1 | 21.473 9 | 17.350 9 | 2.944 6 | 6.763 3 |

| CBD | 0.974 0 | 0.861 9 | 18.325 4 | 14.806 9 | 5.320 4 | 5.191 5 |

| IMG | 0.946 8 | 0.842 5 | 26.540 4 | 21.444 7 | 3.506 1 | 8.677 0 |

| MMMT | 0.962 9 | 0.844 2 | 21.438 4 | 17.322 2 | 5.585 2 | 5.609 1 |

| ASIMP | 0.977 3 | 0.862 4 | 17.356 5 | 14.024 1 | 5.107 4 | 4.722 1 |

| 本文 | 0.982 9 | 0.884 3 | 14.008 4 | 11.318 8 | 2.951 5 | 3.964 6 |

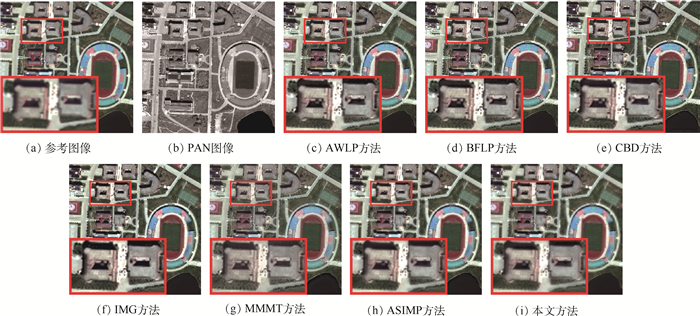

第2组图像来自WorldView-2数据集,参考图像大小为256×256,经不同方法融合后主观效果如图 6所示,客观评价指标如表 2所示。由图中红色放大矩形框可知,IMG方法有较为明显的光谱真失,亮度偏亮;AWLP方法、BFLP方法和CBD方法有轻微的光谱失真,表现为屋顶区域颜色更浅,且在屋顶、中间白色地面有较为明显的噪声;MMMT方法、ASIMP方法与本文方法能较好地保持光谱信息,但MMMT方法在边缘上更加模糊,而本文方法与参考图像不论在空间信息上还是光谱信息上都更为接近。为更好地区分融合效果,可通过表 2查看融合结果客观评价指标,可知,本文方法在所有指标上都达到最优。

|

| 图 6 WorldView-2数据集遥感图像融合结果 Fig. 6 Fusion results of remote sensing images from WorldView-2 dataset |

| 方法 | CC(1) | UIQI(1) | RASE(0) | RMSE(0) | SAM(0) | ERGAS(0) |

| AWLP | 0.908 7 | 0.846 3 | 23.071 4 | 25.239 6 | 5.531 1 | 5.629 8 |

| BFLP | 0.919 0 | 0.850 9 | 20.849 9 | 22.809 3 | 5.185 0 | 5.137 5 |

| CBD | 0.948 3 | 0.855 1 | 17.116 3 | 18.724 8 | 5.660 9 | 4.210 8 |

| IMG | 0.916 7 | 0.855 8 | 20.678 2 | 22.621 5 | 5.179 1 | 5.177 6 |

| MMMT | 0.936 8 | 0.840 1 | 17.873 8 | 19.553 6 | 6.018 0 | 4.468 8 |

| ASIMP | 0.957 6 | 0.861 9 | 14.912 1 | 16.313 6 | 4.966 9 | 3.712 6 |

| 本文 | 0.957 9 | 0.862 4 | 14.592 5 | 15.963 8 | 4.775 | 3.639 7 |

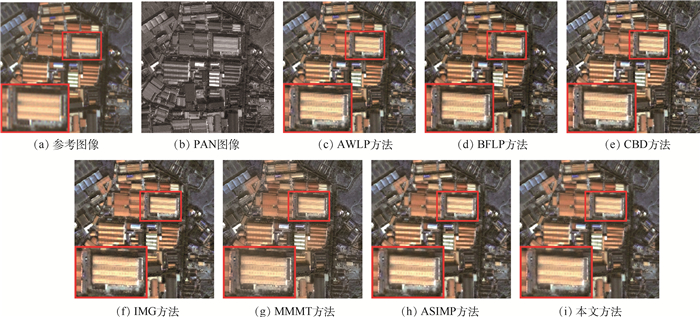

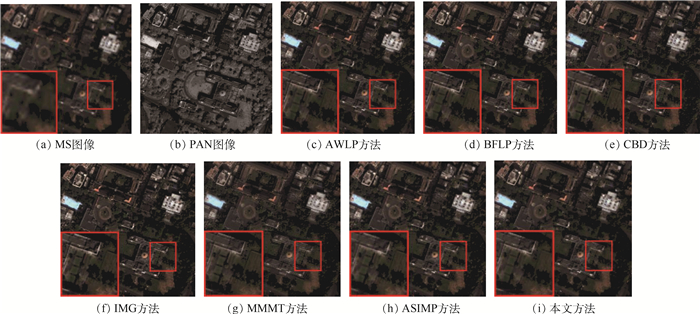

第3组图像来自pleiades数据集,经不同方法融合后主观效果如图 7所示,客观评价指标如表 3所示。从放大的红色矩形区域可知,AWLP方法、BFLP方法和CBD方法存在较为明显的光谱失真,且引入了较多的噪声;IMG方法、MMMT方法和ASIMP方法有较轻微的光谱失真,引入少量的噪声;而本文方法能在保持空间细节的同时,较好地保留光谱信息,色彩更加真实。对于难以用肉眼明显区分的方法,可通过表 3查看融合结果客观评价指标,可知,本文方法除了在UIQI指标上比ASIMP略低以外,在所有其他指标上都达到最优。

|

| 图 7 pleiades数据集遥感图像融合结果 Fig. 7 Fusion results of remote sensing images from pleiades dataset |

| 方法 | CC(1) | UIQI(1) | RASE(0) | RMSE(0) | SAM(0) | ERGAS(0) |

| AWLP | 0.922 7 | 0.907 3 | 19.585 9 | 20.150 3 | 4.060 0 | 4.847 1 |

| BFLP | 0.926 7 | 0.903 4 | 21.395 9 | 22.012 5 | 3.726 1 | 5.906 0 |

| CBD | 0.907 5 | 0.892 4 | 21.936 6 | 22.568 8 | 4.207 2 | 5.509 9 |

| IMG | 0.927 8 | 0.909 1 | 19.256 1 | 19.811 0 | 3.222 4 | 4.840 1 |

| MMMT | 0.923 2 | 0.909 2 | 17.370 1 | 17.870 6 | 4.153 9 | 4.347 1 |

| ASIMP | 0.939 0 | 0.918 1 | 16.884 7 | 17.371 3 | 3.573 3 | 4.251 1 |

| 本文 | 0.940 5 | 0.913 3 | 15.644 5 | 16.095 3 | 3.170 0 | 3.934 0 |

为了更客观地评价各方法的性能,对来自QuickBird、IKONOS、WorldView-2及pleiades四大数据集的共计80组有参考遥感图像融合后计算平均客观评价指标,结果如表 4所示。可知,本文方法在所有的平均客观评价指标上达到了最优。

| 方法 | CC(1) | UIQI(1) | RASE(0) | RMSE(0) | SAM(0) | ERGAS(0) |

| AWLP | 0.910 5 | 0.865 7 | 21.373 0 | 14.326 7 | 3.718 4 | 5.261 6 |

| BFLP | 0.905 4 | 0.827 9 | 29.250 6 | 18.965 0 | 3.900 0 | 6.973 7 |

| CBD | 0.903 3 | 0.858 1 | 21.788 5 | 14.848 6 | 4.289 0 | 5.579 6 |

| IMG | 0.904 9 | 0.853 8 | 22.586 3 | 15.437 3 | 3.394 0 | 5.667 3 |

| MMMT | 0.914 7 | 0.873 3 | 18.287 9 | 12.496 2 | 3.841 8 | 4.679 7 |

| ASIMP | 0.917 4 | 0.871 7 | 19.916 1 | 13.270 7 | 3.845 1 | 5.072 7 |

| 本文 | 0.921 5 | 0.881 5 | 18.244 7 | 12.333 0 | 3.303 5 | 4.638 0 |

| 注:“——”表示平均值。 | ||||||

3.5 真实图像实验

真实图像的实验采用2组图像进行主观和客观评价,并对所有来自四大数据集的50组真实图像计算平均客观评价指标。

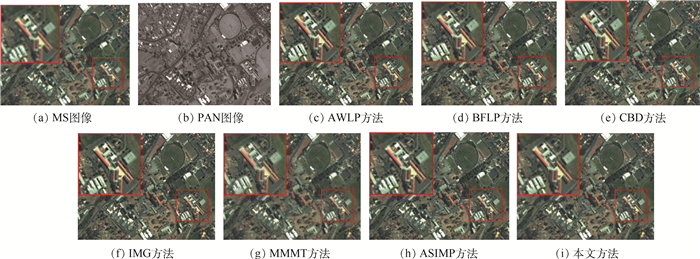

第1组图像来自IKONOS数据集,图像大小为780×608。不同方法融合后的主观效果如图 8所示,相应的客观评价指标如表 5所示。由图 8可知,BFLP方法和MMMT方法在橙色屋顶区域有明显光谱失真,其他方法与本文方法难以用肉眼直接判别,可通过表 5中图 8的客观评价指标来评价,可知,本文方法除了在Ds指标上略低于ASIMP方法以外,其他指标都达到最优。

|

| 图 8 IKONOS数据集真实图像融合结果 Fig. 8 Fusion results of real images from IKONOS dataset |

| 方法 | Dλ(0) | Ds(0) | QNR(1) |

| AWLP | 0.040 3 | 0.052 8 | 0.909 1 |

| BFLP | 0.039 4 | 0.055 8 | 0.906 9 |

| CBD | 0.039 6 | 0.051 3 | 0.911 1 |

| IMG | 0.050 5 | 0.056 2 | 0.896 1 |

| MMMT | 0.043 9 | 0.071 0 | 0.888 2 |

| ASIMP | 0.035 5 | 0.048 1 | 0.918 1 |

| 本文 | 0.028 1 | 0.049 0 | 0.924 3 |

第2组图像来自QuickBird数据集,图像大小为512×512,融合后视觉效果如图 9所示。可知,AWLP方法、CBD方法和IMG方法亮度偏亮,存在过度注入的问题,其他方法难以用肉眼直接观察,可由表 6中图 9的客观评价指标测量,可知,本文方法在所有客观评价指标上都达到最优。

|

| 图 9 QuickBird数据集真实图像融合结果 Fig. 9 Fusion results of real images from QuickBird dataset |

| 方法 | Dλ(0) | Ds(0) | QNR(1) |

| AWLP | 0.022 0 | 0.040 9 | 0.938 1 |

| BFLP | 0.013 9 | 0.042 4 | 0.944 3 |

| CBD | 0.026 0 | 0.043 9 | 0.931 2 |

| IMG | 0.020 4 | 0.046 6 | 0.934 0 |

| MMMT | 0.019 6 | 0.043 4 | 0.937 8 |

| ASIMP | 0.019 4 | 0.040 1 | 0.941 2 |

| 本文 | 0.011 7 | 0.038 8 | 0.949 9 |

为更加客观评价不同方法的有效性,本文对来自四大数据集的50组真实图像进行实验,并测算平均客观评价指标,如表 7所示。可知,本文方法所有指标都达到最优。

| 方法 |  |

|

QNR(1) |

| AWLP | 0.018 4 | 0.043 1 | 0.939 4 |

| BFLP | 0.018 0 | 0.042 1 | 0.940 8 |

| CBD | 0.020 9 | 0.043 0 | 0.937 1 |

| IMG | 0.024 5 | 0.048 4 | 0.928 4 |

| MMMT | 0.018 6 | 0.047 3 | 0.935 1 |

| ASIMP | 0.024 9 | 0.047 8 | 0.930 6 |

| 本文 | 0.013 8 | 0.040 8 | 0.946 0 |

| 注:“——”表示平均值。 | |||

4 结论

1) 本文方法在优化注入细节的过程中使用高斯滤波估计去匹配MS传感器的特性,并用该估计的高斯滤波器去卷积PAN图像,得到优化后的细节。

2) 对于注入效益的优化,本文方法综合考虑光谱信息和细节信息,并建立综合评价指标,以确定自适应的注入量系数。

3) 为加强边缘细节,本文方法提出一种光谱信息保真的自适应边缘提取方法,以对注入效益进一步优化。

4) 通过对来自QuickBird、IKONOS、WorldView-2及pleiades四大数据集的80组仿真图像与50组真实图像进行融合实验,并将本文方法与一些先进的融合方法进行对比,结果表明本文提出的方法在主观和平均客观评价指标上能达到最优。

在未来的工作中,可能需要精细化高斯滤波估计,以得到更准确的滤波器。这些工作将在以后的研究中进一步尝试。

| [1] |

GHASSEMIAN H. A review of remote sensing image fusion methods[J]. Information Fusion, 2016, 32: 75-89. DOI:10.1016/j.inffus.2016.03.003 |

| [2] |

GEMINE V, PAOLO A, ROCCO R, et al. Pansharpening based on deconvolution for multiband filter estimation[J]. IEEE Transactions on Geoscience and Remote Sensing, 2019, 57(1): 540-552. DOI:10.1109/TGRS.2018.2858288 |

| [3] |

MALPICA J A. Hue adjustment to IHS pan-sharpened IKONOS imagery for vegetation enhancement[J]. IEEE Geoscience and Remote Sensing Letters, 2007, 4(1): 27-31. DOI:10.1109/LGRS.2006.883523 |

| [4] |

PSJR C, SIDES S C, ANDERSON J A. Comparison of three different methods to merge multiresolution and multispectral data:Landsat TM and SPOT panchromatic[J]. Photogrammetric Engineering & Remote Sensing, 1991, 57(3): 265-303. |

| [5] |

LABEN C A, BROWER B V.Process for enhancing the spatial resolution of multispectral imagery using pan-sharpening: U.S.6011875 A[P].2000-01-04.

|

| [6] |

MENG X C, SHEN H F, LI H F, et al. Review of the pansharpening methods for remote sensing images based on the idea of meta-analysis:Practical discussion and challenges[J]. Information Fusion, 2019, 46: 102-113. DOI:10.1016/j.inffus.2018.05.006 |

| [7] |

LI S, KWOK J T, WANG Y. Using the discrete wavelet frame transform to merge Landsat TM and SPOT panchromatic images[J]. Information Fusion, 2002, 3(1): 17-23. DOI:10.1016/S1566-2535(01)00037-9 |

| [8] |

NUNEZ J, OTAZU X, FORS O, et al. Multiresolution-based image fusion with additive wavelet decomposition[J]. IEEE Transactions on Geoscience and Remote Sensing, 1999, 37(3): 1204-1211. DOI:10.1109/36.763274 |

| [9] |

CUNHA A L D, ZHOU J, DO M N. The nonsubsampled contourlet transform:Theory, design, and applications[J]. IEEE Transactions on Image Processing, 2006, 15(10): 3089-3101. DOI:10.1109/TIP.2006.877507 |

| [10] |

YIN M, LIU W, ZHAO X, et al. A novel image fusion algorithm based on nonsubsampled shearlet transform[J]. Optik-International Journal for Light and Electron Optics, 2014, 125(10): 2274-2282. DOI:10.1016/j.ijleo.2013.10.064 |

| [11] |

YANG Y, WAN W, HUANG S Y, et al. Remote sensing image fusion based on adaptive HIS and multiscale guided filter[J]. IEEE Access, 2016, 4: 4573-4582. DOI:10.1109/ACCESS.2016.2599403 |

| [12] |

YANG Y, WU L, HUANG S Y, et al. Compensation details-based injection model for remote sensing image fusion[J]. IEEE Geoscience and Remote Sensing Letters, 2018, 15(5): 734-738. DOI:10.1109/LGRS.2018.2810219 |

| [13] |

YANG Y, WU L, HUANG S Y, et al. Remote sensing image fusion based on adaptively weighted joint detail injection[J]. IEEE Access, 2018, 6: 6849-6864. DOI:10.1109/ACCESS.2018.2791574 |

| [14] |

GIUSEPPE M, DAVIDEC, LUISA V, et al. Pansharpening by convolutional neural networks[J]. Remote Sensing, 2016, 8(7): 594. DOI:10.3390/rs8070594 |

| [15] |

AIAZZI B, ALPARONE L, BARONTI S, et al. MTF-tailored multiscale fusion of high-resolution MS and pan imagery[J]. Photogrammetric Engineering and Remote Sensing, 2006, 72(5): 591-596. DOI:10.14358/PERS.72.5.591 |

| [16] |

VIVONE G, RESTAINO R, CHANUSSOT J. Full scale regression-based injection coefficients for panchromatic sharpening[J]. IEEE Transactions on Image Processing, 2018, 27(7): 3418-3431. DOI:10.1109/TIP.2018.2819501 |

| [17] |

YIN H, LI S. Pansharpening with multiscale normalized nonlocal means filter:A two-step approach[J]. IEEE Transactions on Geoscience and Remote Sensing, 2015, 53(10): 5734-5745. DOI:10.1109/TGRS.2015.2429691 |

| [18] |

VIVONE G, ALPARONE L, CHANUSSOT J, et al. A critical comparison among pansharpening algorithms[J]. IEEE Transactions on Geoscience and Remote Sensing, 2015, 53(5): 2565-2586. DOI:10.1109/TGRS.2014.2361734 |

| [19] |

RAHMANI S, STRAIT M, MERKURJEV D, et al. An adaptive IHS pan-sharpening method[J]. IEEE Geoscience and Remote Sensing Letters, 2010, 7(4): 746-750. DOI:10.1109/LGRS.2010.2046715 |

| [20] |

LEUNG Y, LIU J, ZHANG J. An improved adaptive intensity-hue-saturation method for the fusion of remote sensing images[J]. IEEE Geoscience and Remote Sensing Letters, 2013, 11(5): 985-989. |

| [21] |

HE K, SUN J, TANG X. Guided image filtering[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013, 35(6): 1397-1409. DOI:10.1109/TPAMI.2012.213 |

| [22] |

杨勇, 阙越, 黄淑英, 等. 多视觉特征和引导滤波的鲁棒多聚焦图像融合[J]. 计算机辅助设计与图形学学报, 2017, 29(7): 1324-1333. YANG Y, QUE Y, HUANG S Y, et al. Robust multifocus image fusion via multiple visual features and guided filtering[J]. Journal of Computer-Aided Design & Computer Graphics, 2017, 29(7): 1324-1333. DOI:10.3969/j.issn.1003-9775.2017.07.019 (in Chinese) |

| [23] |

敬忠良, 肖刚. 图像融合:理论与应用[M]. 北京: 高等教育出版社, 2007: 160-172. JING Z L, XIAO G. Image fusion:Principle and application[M]. Beijing: Higher Education Press, 2007: 160-172. (in Chinese) |

| [24] |

YANG Y, WANG W G, HUANG S H, et al. Anovel pan-sharpening framework based on matting model and multiscale transform[J]. Remote Sensing, 2017, 9(4): 391-750. DOI:10.3390/rs9040391 |

| [25] |

YANG Y, WU L, HUANG S Y, et al. Pansharpening for multiband images with adaptive spectral-intensity modulation[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2018, 11(9): 3196-3208. DOI:10.1109/JSTARS.2018.2849011 |

| [26] |

WALD L, RANCHIN T, MANGOLINI M. Fusion of satellite images of different spatial resolutions:Assessing the quality of resulting images[J]. Photogrammetric Engineering and Remote Sensing, 1997, 63(6): 691-699. |

| [27] |

OTAZU X, GONZÁLEZ-AUDÍCANA M, FORS O, et al. Introduction of sensor spectral response into image fusion methods.Application to wavelet-based methods[J]. IEEE Transactions on Geoscience and Remote Sensing, 2005, 43(10): 2376-2385. DOI:10.1109/TGRS.2005.856106 |

| [28] |

KAPLAN N H, ERER I. Bilateral filtering-based enhanced pansharpening of multispectral satellite images[J]. IEEE Geoscience and Remote Sensing Letters, 2014, 11(11): 1941-1945. DOI:10.1109/LGRS.2014.2314389 |

| [29] |

WANG Z, BOVIK A C. A universal image quality index[J]. IEEE Signal Processing Letters, 2002, 9(3): 81-84. DOI:10.1109/97.995823 |

| [30] |

YANG Y, TONG S, HUANG S Y, et al. Multifocus image fusion based on NSCT and focused area detection[J]. IEEE Sensors Journal, 2015, 15(5): 2824-2838. |

| [31] |

RANCHIN T, WALD L. Fusion of high spatial and spectral resolution images:The ARSIS concept and its implementation[J]. Photogrammetric Engineering and Remote Sensing, 2000, 66(1): 49-61. |

| [32] |

ALPARONE L, WALD L, CHANUSSOT J, et al. Comparison of pansharpening algorithms:Outcome of the 2006 GRSS data fusion contest[J]. IEEE Transactions on Geoscience and Remote Sensing, 2007, 45(10): 3012-3021. DOI:10.1109/TGRS.2007.904923 |

| [33] |

WALD L.Quality of high resolution synthesized images: Is there a simple criterion?[C]//Proceedings of the Third Conference on Fusion of Earth Data, 2000: 99-103.

|

| [34] |

ALPARONE L, AIAZZI B, BARONTI S, et al. Multispectral and panchromatic data fusion assessment without reference[J]. Photogrammetric Engineering and Remote Sensing, 2008, 74(2): 193-200. DOI:10.14358/PERS.74.2.193 |