图像分割指把图像中具有特殊涵义的不同区域区分开来.分割产生的每一个区域都是连通的,区域内像素满足特定的一致性准则,而不同的图像区域互不相交,彼此之间存在差异性[1].在分割概念基础上,可以将图像抽象为“前景”和“背景”两个类别.其中,图像“前景”的概念是相对于“背景”而言的,“前景”通常指图片场景中的人们感兴趣的区域.有效的前景分割是虚拟场景构建、智能视频监控和自然人机交互等高层次应用的前提和基础[2].

光场(light fields)是对空间中所有光线的描述.现实世界中的场景包含丰富的三维信息,单张二维图像不能完全描述物体之间的空间关系.1987年Bolles等提出用稠密的序列图像来刻画静态场景.他们指出在快速采样的序列图像中时间连续性大致等同于场景的空间连续性,同时采用了“对极平面图”(Epipolar Plane Image,EPI)这种描述方法来分析三维场景[3].1996年Levoy和Hanrahan提出“光板模型”(light slab representation),采用四维数组描述任意空间光线,有效恢复了场景中的三维信息[4].由于光场分析中通常需要处理大量图像数据,前期的研究常受限于计算机的处理能力,近年来硬件水平的显著提升使得光场分析成为计算机视觉和计算机图形学领域的研究热点.Wanner和Goldluecke[5]针对四维光场建立了深度估计的通用框架;Kim等[6]则通过构建三维光场有效处理了复杂场景中的深度估计和三维重建问题.

现有静态场景中的前景分割方法主要分为基于阈值、基于边缘、基于区域以及结合其他特定理论的方法等几个类别.其中,Vincent和Soille[7]提出的分水岭算法把图像看作拓扑地貌,以灰度的局部最小点为中心构建集水区,能够得到连续的分割边界,但在实际应用中常会出现过分割问题;Felzenszwalb和Huttenlocher[8]提出采用贪婪搜索策略的图分割方法,该方法能用成对区域比较方法获得全局最优解;Chan和Vese[9]基于水平集设计了几何主动轮廓模型,较好地实现了单目标轮廓提取,但在边缘定位仍然不够精确.皮志明和汪增福[10]结合场景中的颜色和深度信息,提出了一种基于深度不连续性选取种子区域的分割算法,初步实现了语义层面上的物体分割.范忠良等[11]通过提取极线平面图中的直线,恢复出了原始图像中的轮廓曲线,最后采取边缘连接的方法获得了前景物体的闭合轮廓曲线,实现了简单场景中的前景分割.本文从三维光场中的图像边缘检测出发,通过插值算法恢复空间深度信息,从新的视角提出了一种有效的前景分割方法.

1 三维光场原理

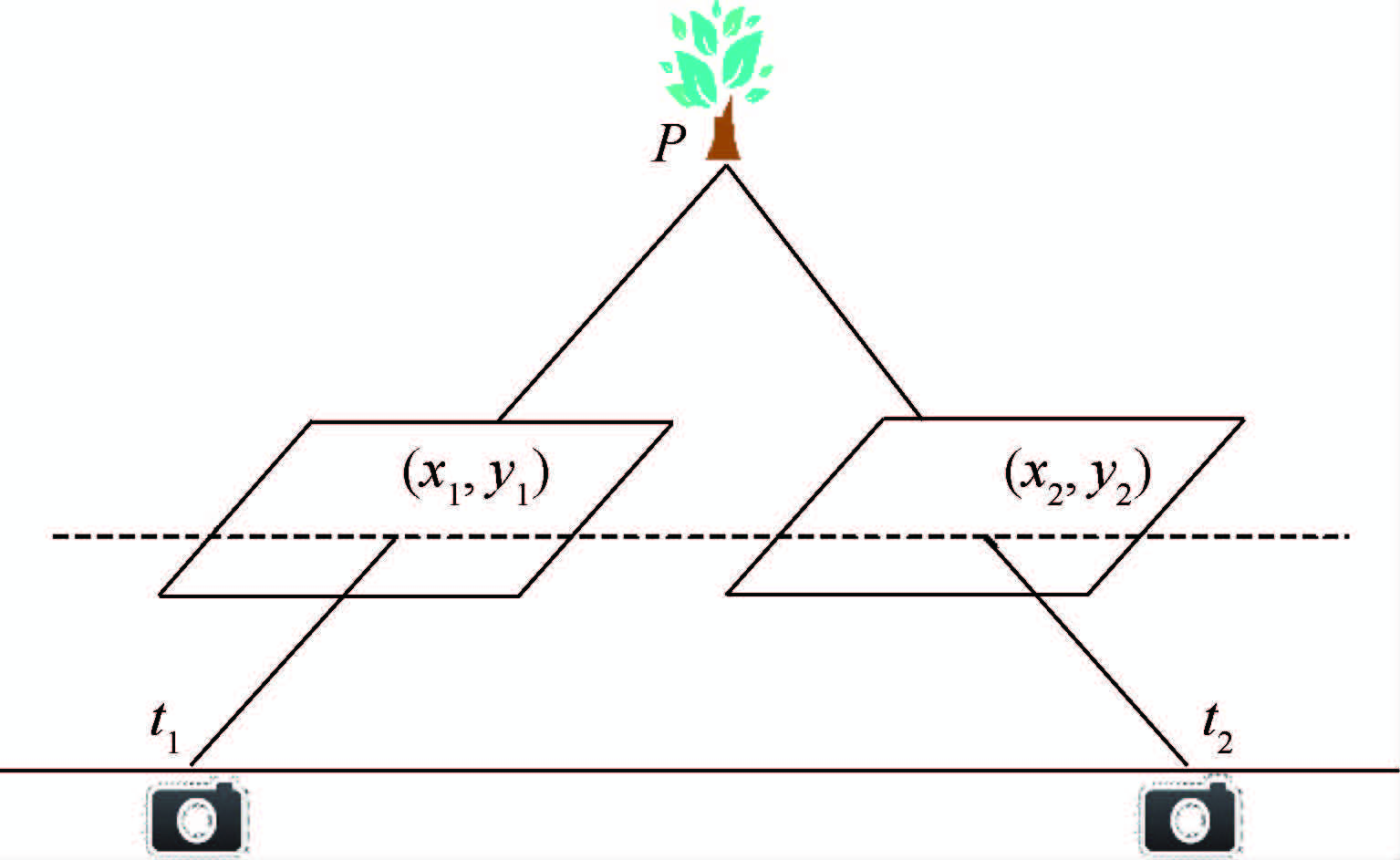

典型的光场构建过程通常需要对同一个场景在不同视角下拍摄大量图像,然后采用合适的几何模型描述光线在空间中的分布情况.针对本文场景前景分割的应用背景,研究考察图像序列的成像中心在一条水平直线上情形,即通过在一维直线上获取有序二维图像来建立三维光场.

图像的生成可以看作是光线在成像平面上的投射过程.对空间中的一条光线L描述如下:

|

| 图 1 三维光场描述示意图 Fig. 1 Representation of 3D light field |

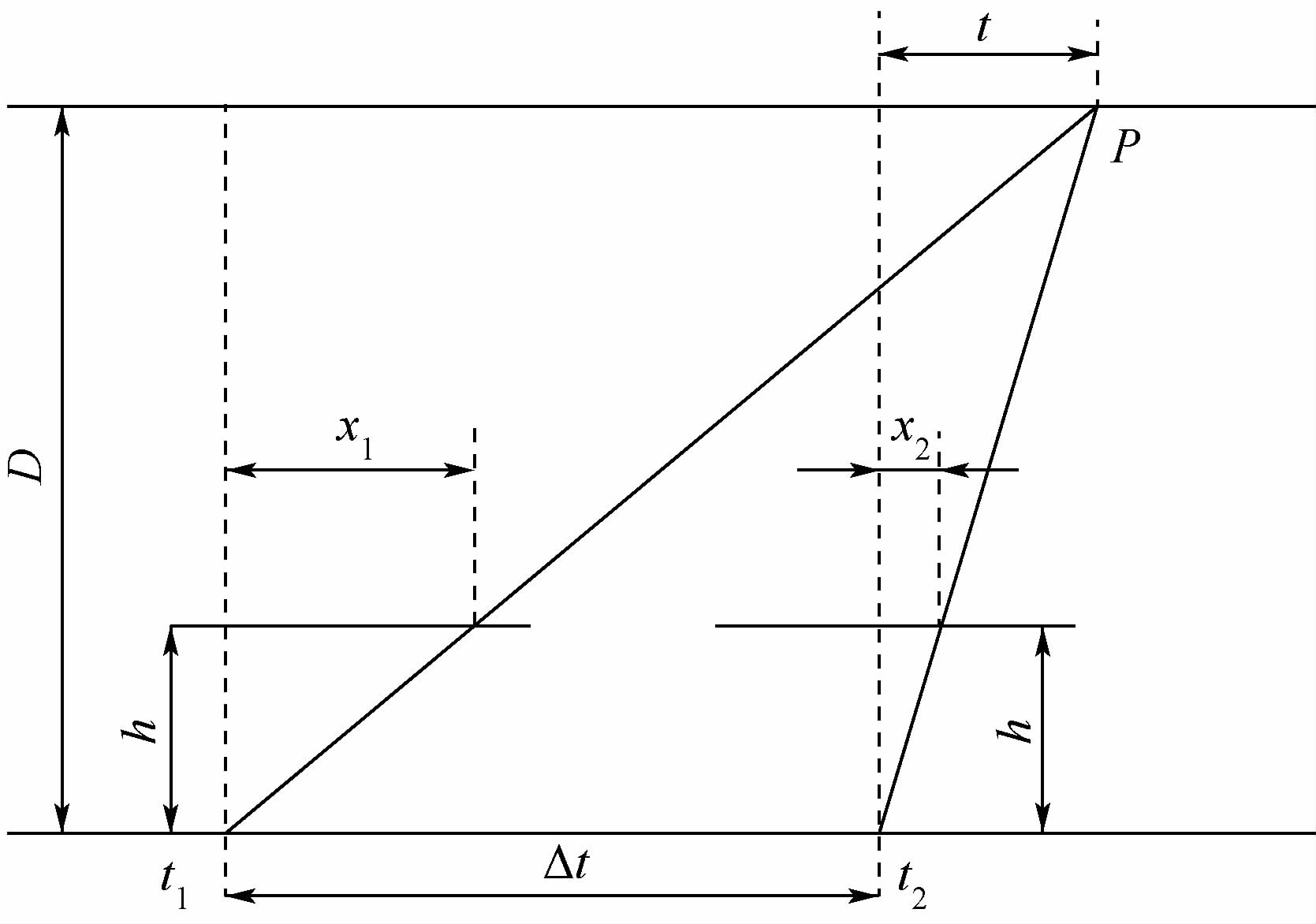

直观来看,EPI对应于序列图像在相同y值条件下横向像素的堆叠.为了后续处理的便捷性,本文假定任意相邻两幅序列图像光心间距Δt一致,即保证所形成的EPI中同一物体对应像素点的连续性.当采样图像数量足够多时,场景中同一物体像素点在EPI中形成一条直线轨迹.通过对直线的几何特征分析即可得到场景中物体的空间信息.如图 2所示,假定成像平面到成像中心距离为h,物体P到镜头中心路径的距离为D,x1、x2分别为P在图像中像素的横坐标,Δt为成像中心移动距离.

|

| 图 2 物体、成像平面、成像中心路径之间的几何关系 Fig. 2 Geometry relation among objects,imaging plane and path of imaging centers |

由三角形相似关系可得

在EPI中, 正比于直线斜率k,则可知物体与相机之间的空间距离D与EPI中直线斜率k也是正比例关系.在得到场景各像素对应斜率的基础上,可以进一步对其中的深度信息做出估计.

2 场景深度估计

正比于直线斜率k,则可知物体与相机之间的空间距离D与EPI中直线斜率k也是正比例关系.在得到场景各像素对应斜率的基础上,可以进一步对其中的深度信息做出估计.

2 场景深度估计

对场景深度信息的主动获取方式主要基于光线测距原理.其中有代表性的主要包括激光扫描和红外光测距.在户外复杂场景中,激光扫描的深度图像经常出现数量繁多的孔洞,这通常需要后期大量的人工处理[12];而以Kinect为代表的红外光深度估计方法更是因为受到阳光中红外线的强烈干扰,难以形成有效的深度图像.相比之下,被动的基于三维光场的深度估计方法,正是利用了户外复杂场景在EPI图像中反映出来的丰富细节,能够较准确而且稠密地估计出场景中的深度信息. 2.1 EPI直线检测

在EPI中直线检测的数目和质量是估计场景物体深度的关键.场景物体边界通常存在颜色的快速变化,在EPI中则表现为明显的直线特征.本文的直线检测采用LSD方法[13],并针对EPI图像的具体特征进行筛选和处理.

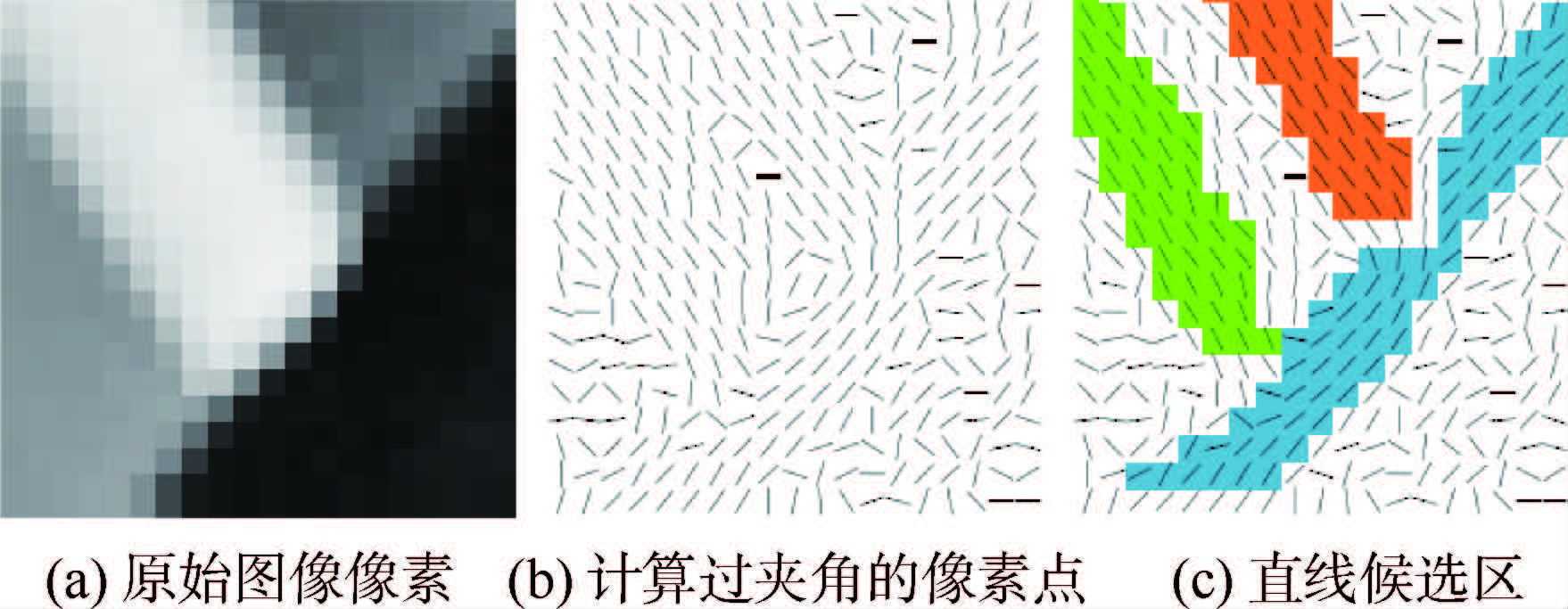

对于每一个像素点,本文计算其相对颜色一致的临近点方向和水平方向的夹角α.夹角α相近的像素点构成了直线候选区(line support regions),亦即可能的直线区域(如图 3所示).

|

| 图 3 直线候选区的生成 Fig. 3 Generation of line support regions |

对于每一个直线候选区,用近似的矩形覆盖此区域像素.选取矩形中像素水平夹角α的众数α′为矩形主方向,对每一个矩形执行直线验证过程.给定偏差容忍度τ(角度,取值0~π),与矩形主方向夹角β=|α-α′|小于τ的像素作为直线近似点.则对于矩形区域的任意一个像素点,其属于直线的概率为 .所有像素夹角β独立且满足二项分布[14]:

.所有像素夹角β独立且满足二项分布[14]:

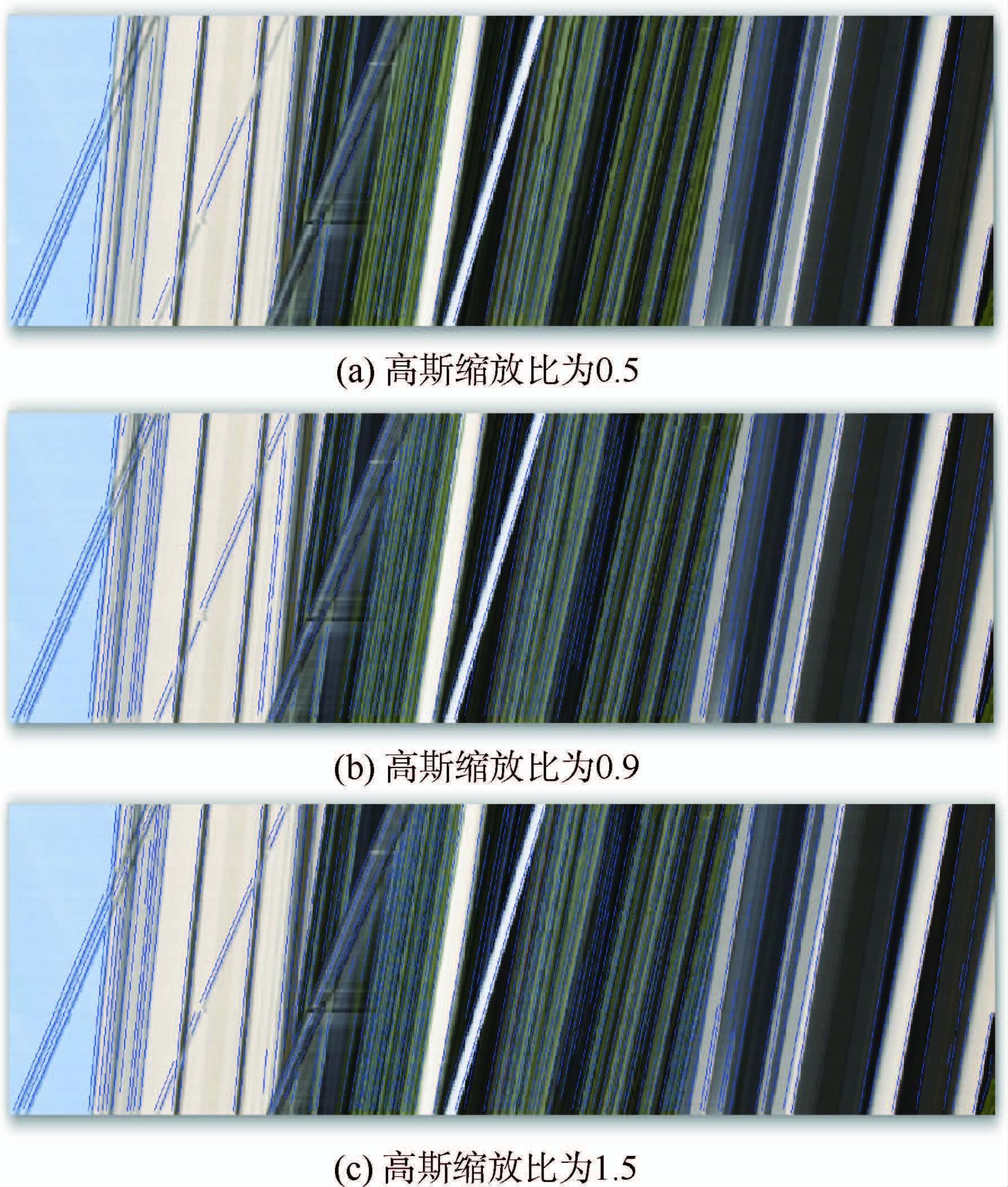

由于图像处理过程中的缩放比例能够显著影响EPI直线检测的效果,本文在不同的高斯缩放比例下做了测试和对比.从图 4中看出,高斯缩放比较低时直线检测结果较为稀疏,丢失了部分直线特征;缩放比较高时则出现较多的干扰直线.在实际试验中综合深度信息恢复效果考虑,本文选取的缩放比为0.9.

|

| 图 4 不同图像缩放比下EPI直线检测结果 Fig. 4 EPI line detection results under different image scales |

本文选取序列图像的第一幅作为深度恢复和前景分割的目标图像.EPI集合了所有图像序列的场景信息,由于视角改变,后续场景中可能不断出现新的物体;由于图像获取时间不一致,拍摄后续场景某帧中闪现的物体(如行人等)会在EPI中形成噪点.此外,LSD直线检测仍然存在局限性,如直线中断和无法提取的情形.针对上述问题,本文对直线提取结果做出进一步筛选和处理,执行以下步骤:

1) 为了消除后续场景中新出现物体的可能影响,划定有效直线边界:界定直线端点落在EPI前10行内的直线为考虑对象.

2) 为了弥补直线检测误差,将没有与EPI上边界直接相交的直线延长,计算推测交点.

3) 进一步筛选直线:剔除推测交点超出图像边界的直线,将由于延长而出现的两条重合直线合并为单条直线.

对于给定y值,对应的EPIy经过以上处理可以产生有序二元数组(u,k).其中,u为EPI直线与上边界交点坐标,即目标图像在纵坐标y下相应的横坐标值,k为在此横坐标上的相应斜率.遍历所有y值,即可获得目标图像在坐标(u,y)处的斜率值.

值得注意的是,此时的斜率值对于整个图像来说仍然较稀疏.为了获得稠密的深度信息,本文通过插值映射在x轴方向得到完整的斜率表示.采用插值方法的合理性缘于如下几点:

1) 原图像中深度变化较大的像素点颜色值变化显著,在EPI中可形成明显的直线特征.

2) EPI中的直线可以被LSD算法较完整地检出,对检出直线对应像素可以估算较为准确的深度信息.

3) 两条EPI直线在原图像对应点之间的深度值变化连续且平滑.

因此,插值方法的选择就应当满足:

1) 为了保证已经检测到的深度值的准确性,插值函数f必须经过给定的控制点,即满足f(u)=k.

2) 插值函数f能够得到所有像素点处的估计深度值,即f在[0,Xmax]的定义域上连续.

3) 插值函数在两个控制点之间平滑过渡,即对于给定的u1,u2,∀x1,x2∈[u1,u2],式(4)成立.

综合以上考虑,本文采用PCHIP(Piecewise Cubic Hermite Interpolating Polynomial)[15]作为插值方法,用以获取原图中任意像素点(x,y)处的斜率估计值k.

由于PCHIP插值方法本身的特点,在靠近[0,Xmax]两端的像素斜率估计值经常会出现过大或过小的情形,此时进一步设定[0,kmax]的区间作为界限规范化离群值.由式(2)知,可采用线性映射将斜率分布(x,y,k)变换为深度分布(x,y,d),再次线性映射到灰度区间上,最终得到深度图的直观输出.提取深度图的直观过程及其结果如图 5所示,图中红线标示了EPI在原图中的对应位置.

|

| 图 5 深度图获取过程 Fig. 5 Procedure of obtaining depth map |

前景分割主要分为动态场景和静态场景两个类别.当前静态场景的前景分割方法主要利用了图片的颜色信息或灰度特征,对于复杂场景分割的结果常会出现多度分割或者错误分割的情形,不易得到基于物体对象的分割结果.

现实场景中物体的区分常常表现为空间位置上的不连续性,本文中获取的场景深度信息为前景分割过程提供了第三维数据的支撑.在深度图基础上,对于不同空间层次的物体,设定相对应深度阈值即可实现对于物体对象的快速提取.

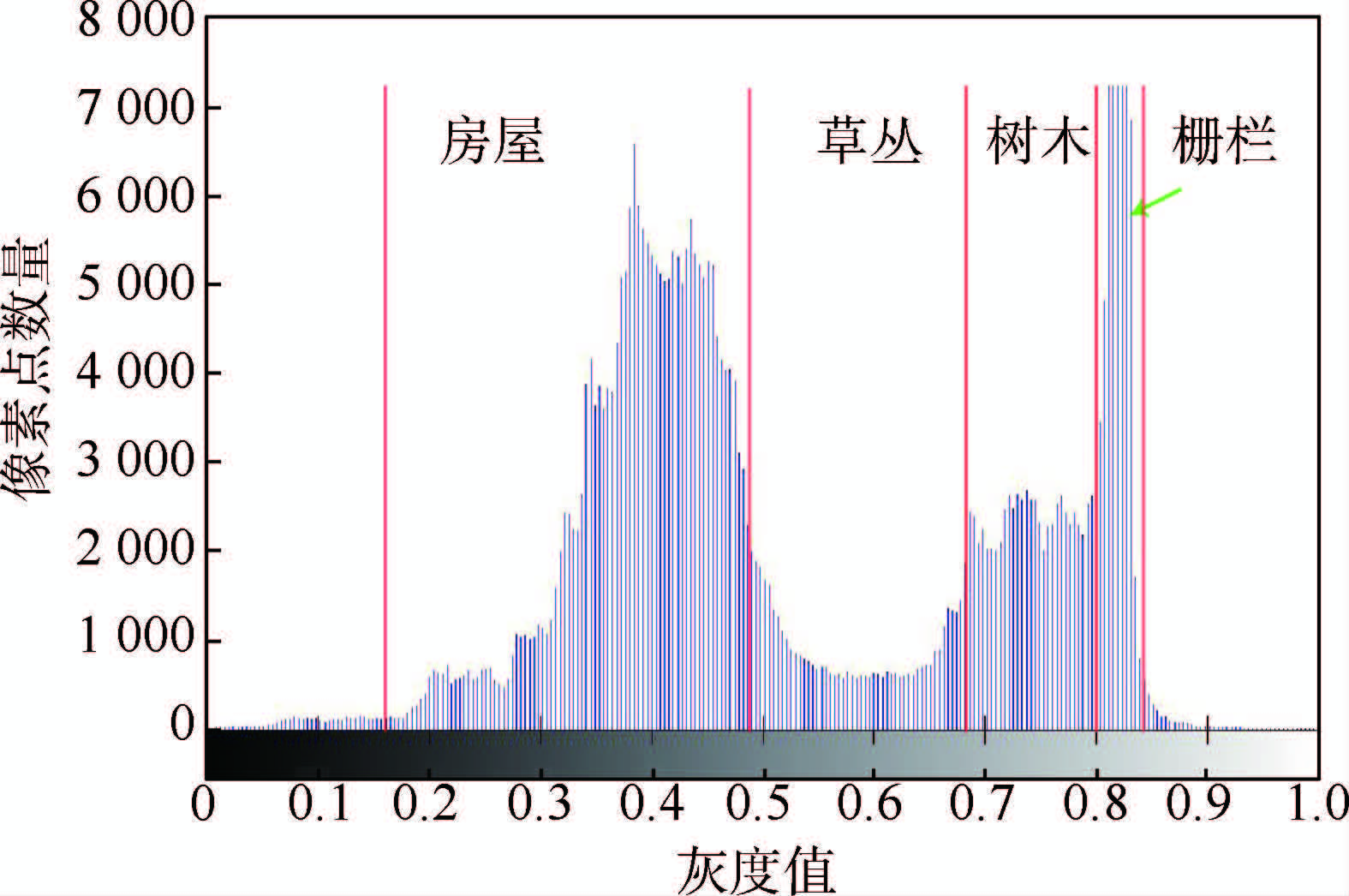

图 6为4.1节“Mansion”场景深度图统计得到的图像直方图.观察可知直方图显现出了较为明显的深度分布特征,在灰度值上选定恰当阈值点即可区分场景中的不同物体.

|

| 图 6 Mansion场景深度图像直方图统计 Fig. 6 Depth image histogram of Mansion scene |

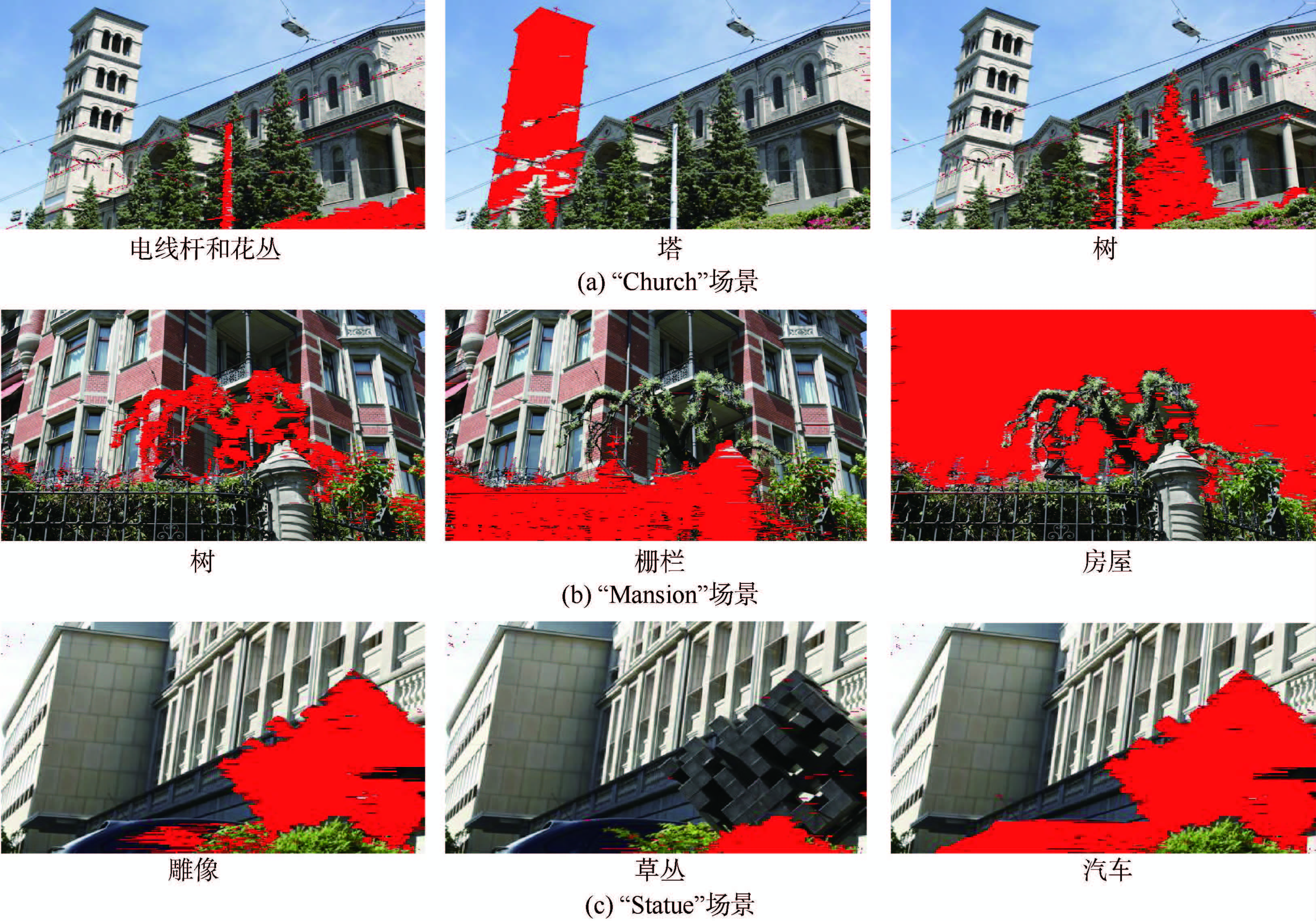

本文研究的适用情形是静态场景中基于物体的分割,数据要求使用在同一水平直线的不同角度拍摄的大量照片序列.实验采用Kim等[6]构造的数据集.本文主要选取了“Church”、“Mansion”、“Statue”3个场景作为实验对象,其中每个场景数据集包含了在由计算机控制的滑动平台上对同一静态场景在不同成像点处拍摄的101幅图像,图像均已经过矫正和对齐预处理. 4.1 对不同物体的分割结果

分别在3个数据集中进行前景分割测试.针对不同的目标物体设定相应的灰度阈值,绘制分割结果(如图 7所示).直观上看,本文方法对景物细节上有着较好的分割效果.且在Church数据集中,对场景里的树木、塔与房屋这类颜色特征相近的物体,也实现了较好地分割.

采用文献[16]定义的查全率和查准率两个量化指标分析分割结果.其中查全率表示分割正确的像素数与标准分割像素数的比值,查准率表示分割图像中分割正确像素数和分割总像素数的比值.其中,用于比对的标准分割图像由人工标定获得.分别对“Church”中的塔、“Mansion”中的树和“Statue”中的雕像分割情况计算,如表 1所示.

| 场景 | 查全率 | 查准率 |

| “Church” | 0.771 | 0.948 |

| “Mansion” | 0.922 | 0.903 |

| “Statue” | 0.896 | 0.885 |

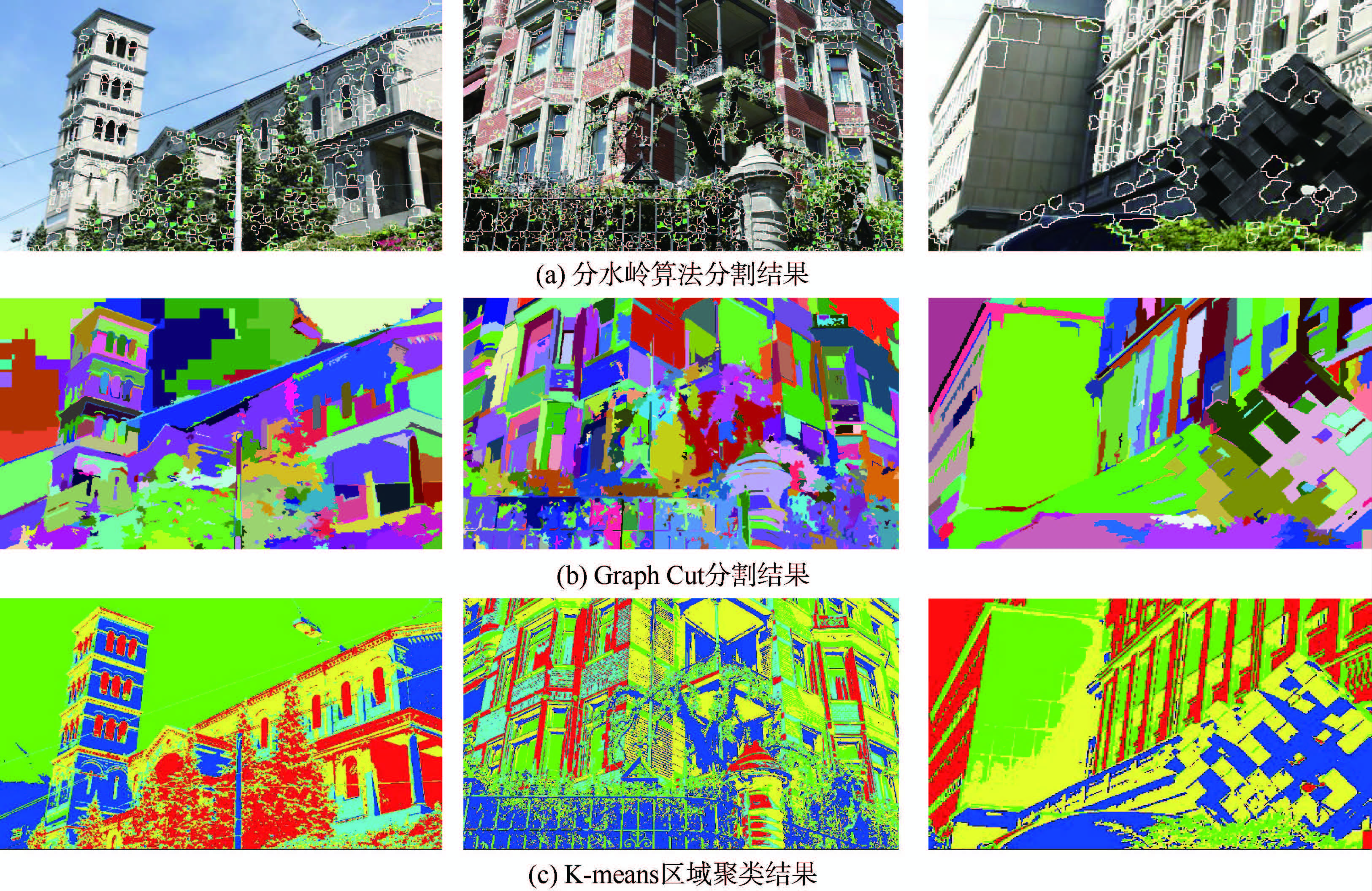

为了验证在复杂静态场景中本文方法前景分割的有效性,选取分水岭分割算法[7]、Graph Cut分割算法[8]和基于K-means聚类的分割算法[17]与本文方法作直观对比.

如图 8所示,由于复杂场景中颜色(灰度)特征复杂多变,同一物体可能有对比反差较大的几个颜色(如“Mansion”场景中的树木)、不同物体也可能有相近的颜色(如“Church”场景中的树木),上述几种常用方法会产生比较明显的过分割问题,通常需要后续的处理过程才能形成针对特定目标物体的分割结果.相比之下,本文的方法更为简便有效.

|

| 图 7 本文方法对不同场景中不同前景的分割结果 Fig. 7 Segmentation of different foreground in different scenes using our method |

|

| 图 8 其他方法初步分割结果 Fig. 8 Preliminary segmentation results using other methods |

本文基于三维光场原理,结合LSD直线检测和PCHIP插值方法提出了一种复杂场景中前景分割算法.实验结果表明:

1) 算法能够较为有效快速地恢复复杂场景中的深度信息.

2) 针对特定前景目标取得了较为理想的分割提取结果,克服了传统分割方法中存在的过分割问题.

3) 算法对输入图像数据要求较高,非等间隔拍摄的图像数据将对深度恢复和分割结果产生影响.

4) 对于场景中空间距离较近的物体不易得出满意结果.

为提升本文算法的鲁棒性和准确性,后续工作将结合图像边缘检测算法对前景提取过程加以改进.

| [1] | Bhattacharyya S. A brief survey of color image preprocessing and segmentation techniques[J].Journal of Pattern Recognition Research, 2011, 6(1): 120-129. |

| Click to display the text | |

| [2] | Arbelaez P, Maire M, Fowlkes C, et al.Contour detection and hierarchical image segmentation[J].IEEE Transactions on Pattern Analysis and Machine Intelligence, 2011, 33(5): 898-916. |

| Click to display the text | |

| [3] | Bolles R C, Baker H H, Marimont D V.Epipolar-plane image analysis: An approach to determining structure from motion[J].International Journal of Computer Vision, 1987, 1(1): 7-55. |

| Click to display the text | |

| [4] | Levoy M, Hanrahan P.Light field rendering[J].Annual Conference on Computer Graphics, 1996: 31-42. |

| [5] | Wanner S, Goldluecke B.Globally consistent depth labeling of 4D light fields[C]//Proceedings of 2012 IEEE Conference on Computer Vision and Pattern Recognition.Piscataway, NJ: IEEE Press, 2012: 41-48. |

| Click to display the text | |

| [6] | Kim C, Zimmer H, Pritch Y, et al.Scene reconstruction from high spatio-angular resolution light fields[J].ACM Transactions on Graphics, 2013, 32(4): 1-12. |

| Click to display the text | |

| [7] | Vincent L, Soille P.Watersheds in digital spaces: An efficient algorithm based on immersion simulations[J].IEEE Transactions on Pattern Analysis and Machine Intelligence, 1991, 13(6): 583-598. |

| Click to display the text | |

| [8] | Felzenszwalb P F, Huttenlocher D P.Efficient graph-based image segmentation[J].International Journal of Computer Vision, 2004, 59(2): 167-181. |

| Click to display the text | |

| [9] | Chan T F, Vese L A.Active contours without edges[J].IEEE Transactions on Image Processing, 2001, 10(2): 266-277. |

| Click to display the text | |

| [10] | 皮志明, 汪增福.融合深度和颜色信息的图像物体分割算法[J].模式识别与人工智能, 2013, 26(2): 151-158. Pi Z M, Wang Z F.Image object segmentation algorithm by combining depth discontinuities and color information[J].Pattern Recognition and Artificial Intelligence, 2013, 26(2): 151-158(in Chinese). |

| Cited By in Cnki (3) | |

| [11] | 范忠良, 蒋刚毅, 郁梅.多视点图像的前景对象自动分割方法[J].计算机辅助设计与图形学报, 2009, 21(9): 1316-1320. Fan Z L, Jiang G Y, Yu M.Automatic foreground object segmentation from multi-view images[J].Journal of Computer-aided Design & Computer Graphics, 2009, 21(9): 1316-1320(in Chinese). |

| Cited By in Cnki (2) | |

| [12] | Yu Y Z, Ferencz A, Malik J.Extracting objects from range and radiance images[J].IEEE Transactions on Visualization and Computer Graphics, 2001, 7(4): 351-364. |

| Click to display the text | |

| [13] | von Gioi R G, Jakubowicz J, Morel J M, et al.LSD: A fast line segment detector with a false detection control[J].IEEE Transactions on Pattern Analysis and Machine Intelligence, 2010, 32(4): 722-732. |

| Click to display the text | |

| [14] | Desolneux A, Moisan L, Morel J-M.Meaningful alignments[J].International Journal of Computer Vision, 2000, 40(1): 7-23. |

| Click to display the text | |

| [15] | Fritsch F N, Carlson R E.Monotone piecewise cubic interpolation[J].SIAM Journal on Numerical Analysis, 1980, 17(2): 238-246. |

| Click to display the text | |

| [16] | Maddalena L, Petrosino A.A self-organizing approach to background subtraction for visual surveillance applications[J].IEEE Transactions on Image Processing, 2008, 17(7): 1168-1177. |

| Click to display the text | |

| [17] | Hartigan J A, Wong M A.Algorithm AS 136: A K-means clustering algorithm[J].Journal of the Royal Statistical Society.Series C(Applied Statistics), 1979, 28(1): 100-108. |

| Click to display the text |